阿里:长文本大模型Qwen2.5-1M技术报告

大语言模型(LLM)在处理长上下文任务时的能力受限,无法有效执行需要大量信息处理的复杂任务。论文提出了一种新型的长上下文处理模型Qwen2.5-1M,并通过优化训练策略和推理方法,显著提高了模型在长上下文任务中的表现。

📖标题:Qwen2.5-1M Technical Report

🌐来源:arXiv, 2501.15383

🌟摘要

🔸在本报告中,我们介绍了Qwen2.5-1M,这是一系列将上下文长度扩展到100万个令牌的模型。与之前的128K版本相比,Qwen2.5-1M系列通过长上下文预训练和后训练显著增强了长上下文能力。采用长数据合成、渐进式预训练和多阶段监督微调等关键技术,可有效提高长上下文性能,同时降低训练成本。

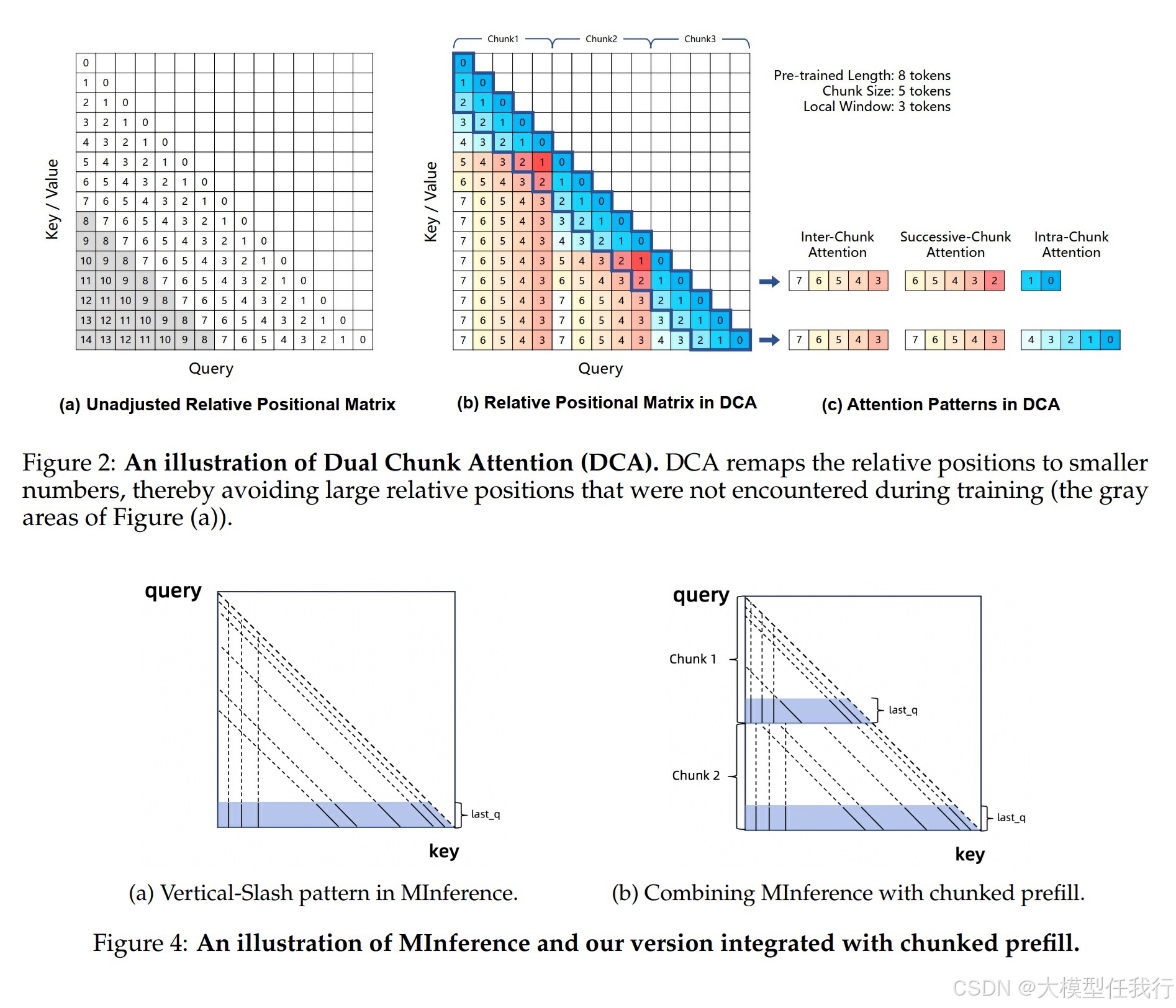

🔸为了在更广泛的用户群中推广长上下文模型的使用,我们提出并开源了我们的推理框架。该框架包括一种长度外推方法,可以将模型上下文长度扩展至少四倍,甚至更多,而无需额外的训练。为了降低推理成本,我们实现了一种稀疏注意力方法,以及用于部署场景的分块预填充优化和一种稀疏细化方法,以提高精度。

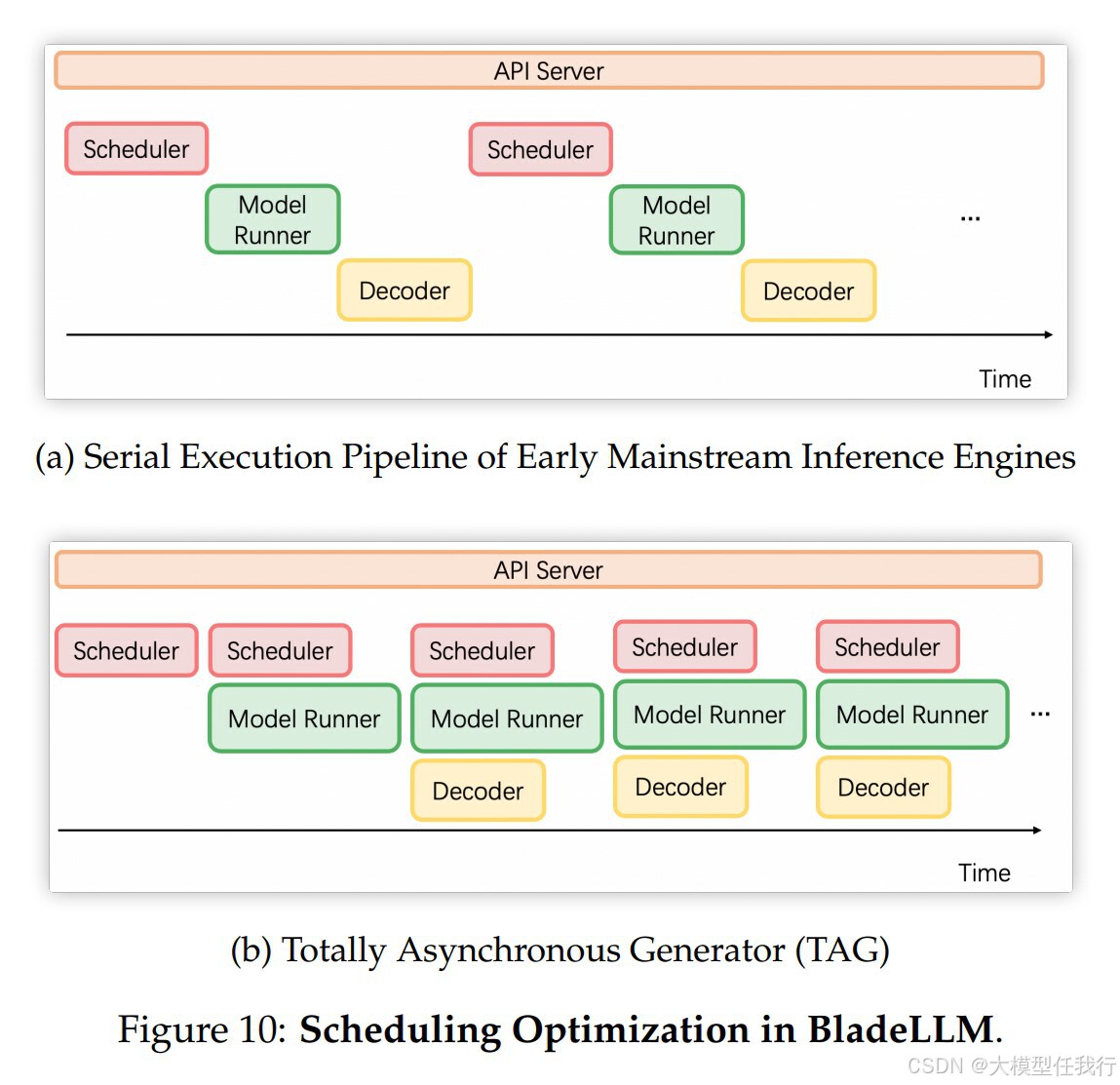

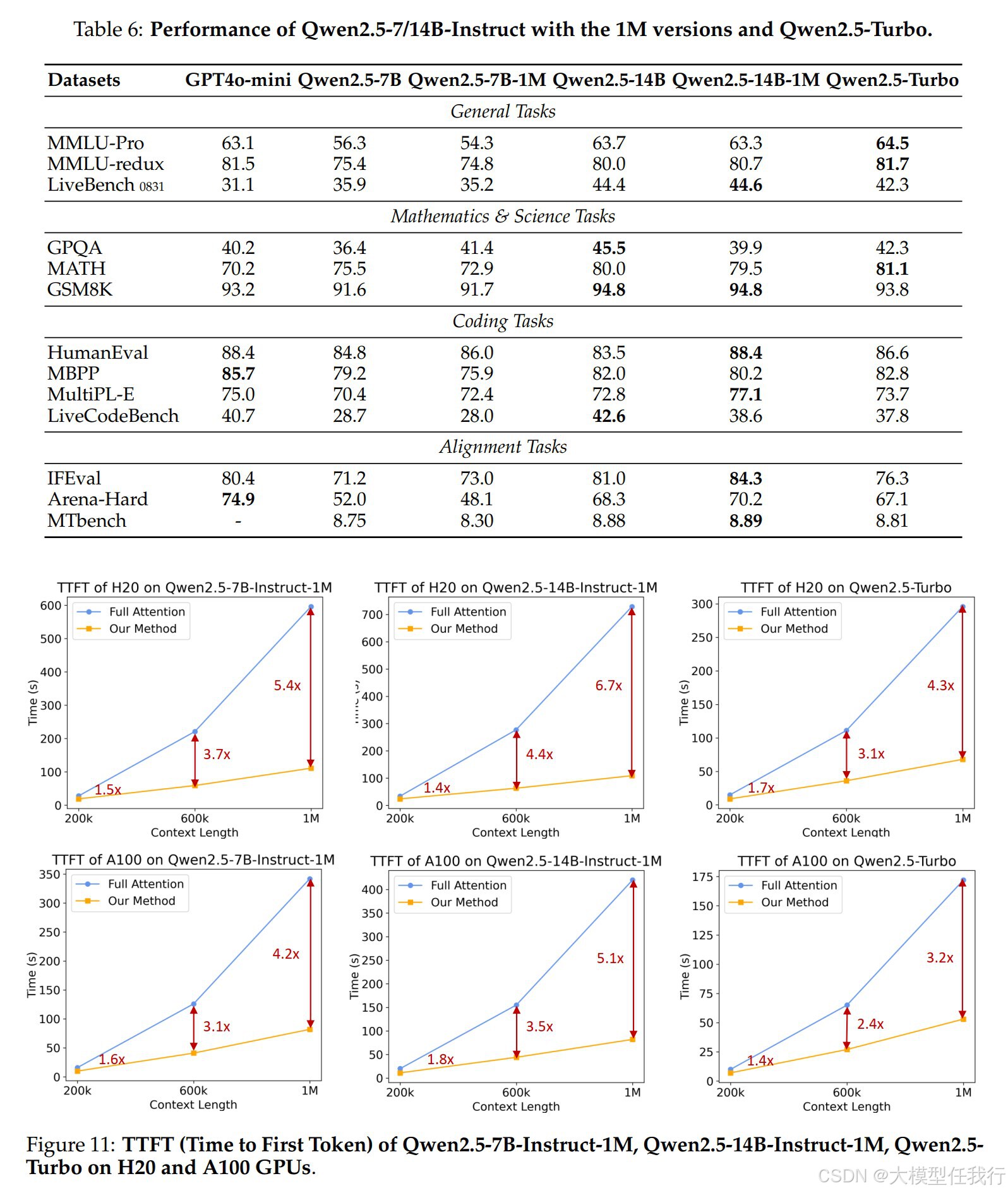

🔸此外,我们详细介绍了推理引擎中的优化,包括内核优化、流水线并行性和调度优化,这些优化显著提高了整体推理性能。通过利用我们的推理框架,Qwen2.5-1M模型在具有100万个上下文令牌的场景中实现了3到7倍的预填充加速。该框架为开发需要使用开源模型进行长时间上下文处理的应用程序提供了一种高效而强大的解决方案。Qwen2.5-1M系列目前包括开源型号Qwen2-5B-Instruction1M和Qwen2-51B-Instruction-1M,以及API处理型号Qwen2.5-Turbo。

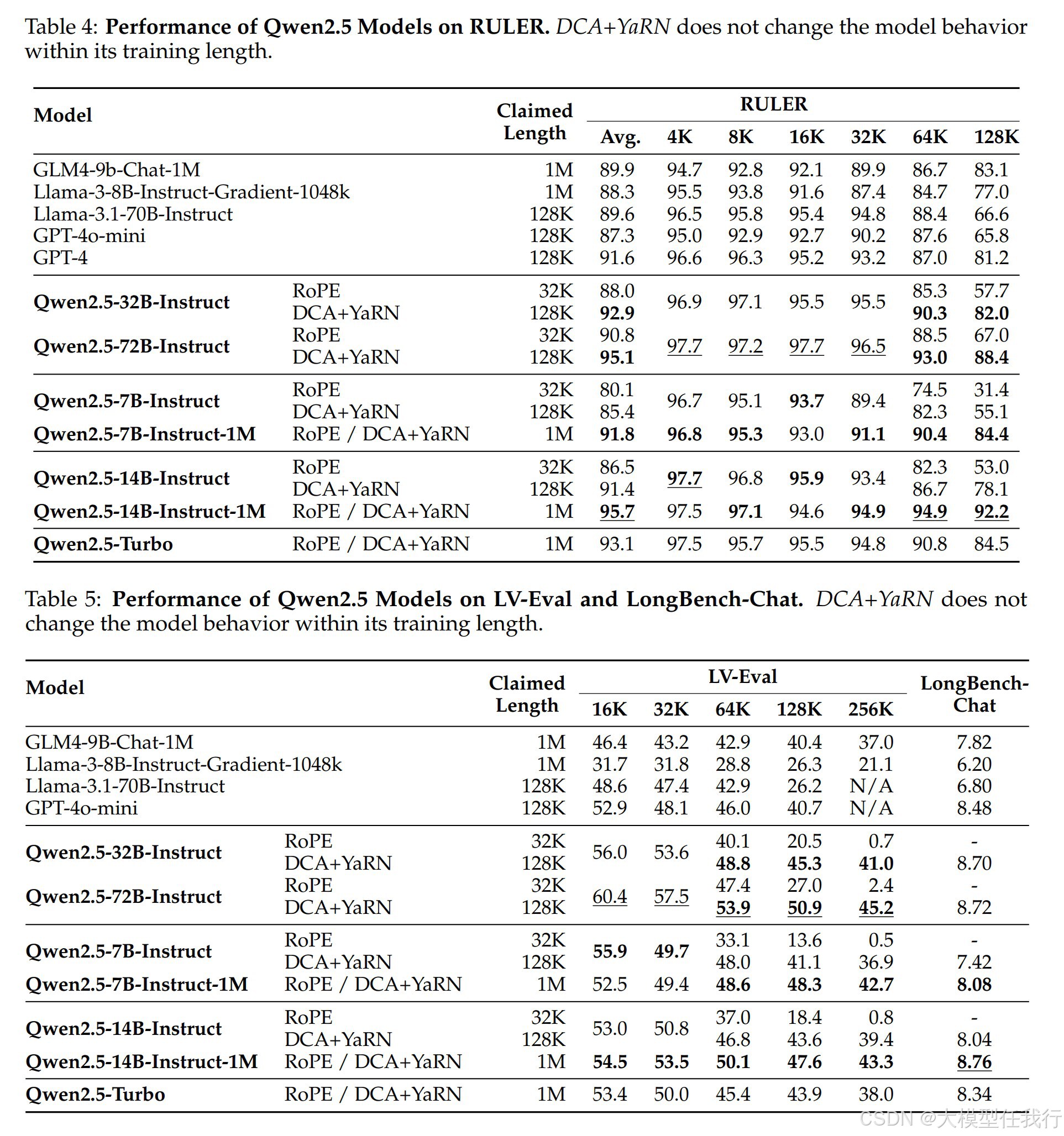

🔸评估表明,Qwen2.5-1M模型在长上下文任务中得到了极大的改进,而在短上下文场景中没有影响性能。具体来说,Qwen2.5-14B-Instruct-1M模型在长上下文任务中的表现明显优于GPT-4o-mini,支持的上下文时间是GPT-4o-mini的八倍。

🛎️文章简介

🔸研究问题:大语言模型(LLM)在处理长上下文任务时的能力受限,无法有效执行需要大量信息处理的复杂任务。

🔸主要贡献:论文提出了一种新型的长上下文处理模型Qwen2.5-1M,并通过优化训练策略和推理方法,显著提高了模型在长上下文任务中的表现。

📝重点思路

🔸模型架构:与Qwen2.5相同的Transformer体系结构。

🔸预训练:中优化数据效率和完善训练策略,包括整合了自然长篇文本数据,通过合成数据进一步增强,采用了五阶段的渐进式上下文长度扩展策略。

🔸后训练:综合了长指令数据,进行两阶段监督的微调,结合Qwen2.5的离线RL数据对进行增强学习。

🔸推理部署:提出了长度的外推法以大于推断期间的训练长度四次或更大,引入稀疏注意力来减少计算复杂度,在内核和系统级别上进行优化。

🔎分析总结

🔸经过长上下文训练后,Qwen2.5-1M系列模型在处理1百万tokens的长上下文任务上表现显著提升,尤其在Passkey Retrieval和RULER任务中表现优异。

🔸引入的稀疏注意力机制和长度外推方法,使得模型在推理时的速度提高了3.2至6.7倍,显著减少了用户等待时间。

🔸模型在短上下文任务上保持了与128K版本相似的性能,证明了长上下文能力的增强并未损害短任务的表现。

💡个人观点

论文的核心是结合了长上下文训练、合成数据生成、强化学习和稀疏注意力机制等多种方法,以系统性地提升大语言模型在长上下文任务中的处理能力和推理效率。

🧩附录

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献305条内容

已为社区贡献305条内容

所有评论(0)