DeepSeek为何选择MOE架构而非Decoder only架构?

在大语言模型(LLM)的发展浪潮中,架构的选择对于模型的性能、效率和应用场景起着至关重要的作用。DeepSeek没有随波逐流采用当下流行的Decoder only架构,而是另辟蹊径选择了混合专家(MOE)架构,这背后有何考量呢?今天,就来拆解下。

前言

在大语言模型(LLM)的发展浪潮中,架构的选择对于模型的性能、效率和应用场景起着至关重要的作用。DeepSeek没有随波逐流采用当下流行的Decoder only架构,而是另辟蹊径选择了混合专家(MOE)架构,这背后有何考量呢?今天,就来拆解下。

Decoder only架构与MOE架构概述

Decoder only架构

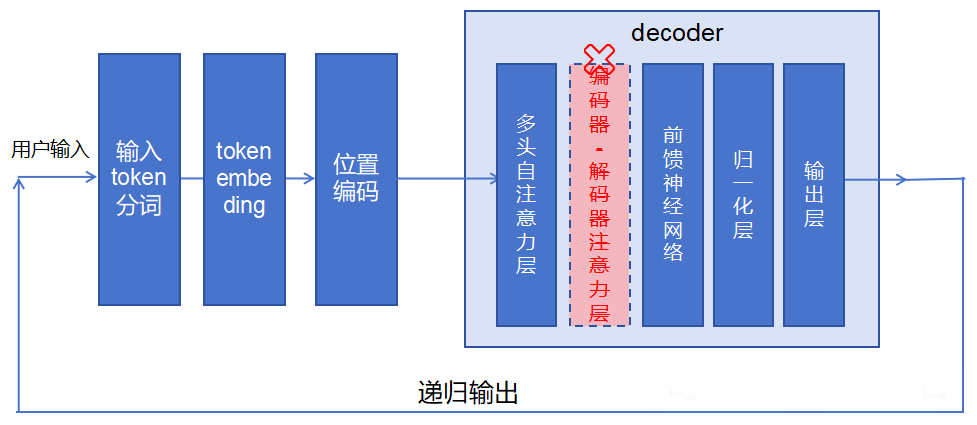

Decoder only架构专注于从一系列输入生成或预测输出,通常用于文本生成任务。以GPT系列为代表,其优点是具备强大的生成能力,能够生成连贯、有创造性的文本,且灵活性高,适用于各种生成型任务。但缺点是有限的理解能力,在面对复杂输入数据时,理解效果可能不如Encoder-Only或Encoder-Decoder架构。同时,它需要大量的训练数据来提高生成文本的质量和多样性。

MOE架构

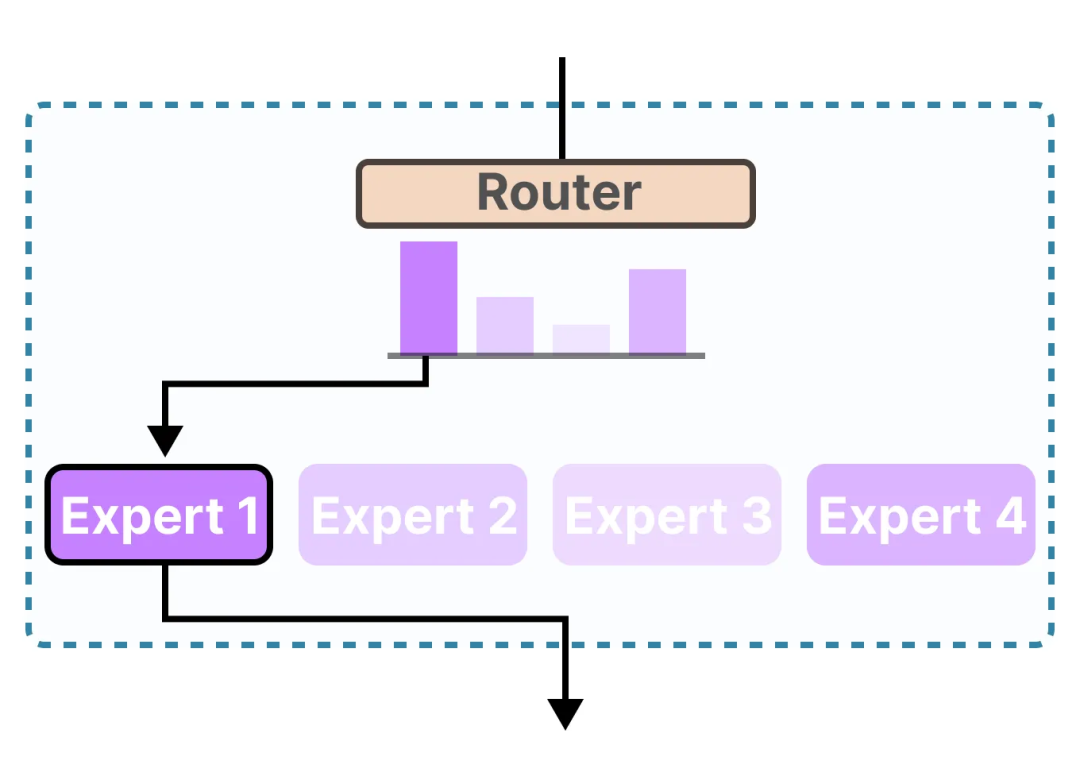

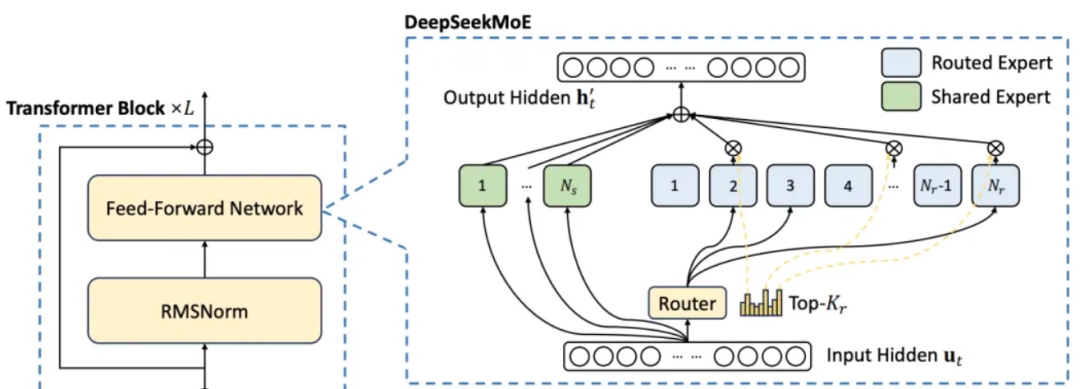

MOE架构由多个专业化的子模型即“专家”组合而成,每一个“专家”都处理其擅长的领域内的任务。核心组件包括负责判定输入样本该由哪个专家模型处理的GateNet,以及一组相对独立的专家模型Experts。其核心思想是通过选择性激活子模型来提高模型的计算效率和表达能力。

DeepSeek选择MOE架构的原因

-

计算资源与效率优势

-

降低计算成本:传统的Decoder only架构在每次前向传播时,所有层和节点都会参与计算,即便部分参数贡献小,也会浪费计算资源。而DeepSeek的MOE架构,以DeepSeek-V3版本为例,总参数量高达6710亿,但每次计算激活的参数量只有370亿,仅为总参数量的5.5%。相比之下,Decoder only架构的模型每次计算激活的参数量就是整个模型的参数量,没有“打折”。

-

提升训练与推理速度:MOE架构在预训练和推理方面都具有速度优势。由于在训练和推理过程中只激活部分专家,在相同的计算预算下,MOE可以显著扩大模型或数据集的规模,并且通常能够更快地达到与Decoder only架构模型相同的性能水平。

-

模型性能与扩展性考量

-

增强模型表达能力:MOE架构通过多个专家处理不同类型的输入数据或任务,使得模型能够更好地捕捉数据的复杂模式和细微差别。比如在处理多领域知识时,不同专家可以分别擅长不同领域,如科学、历史、文学等,从而提升模型在各种任务上的准确性和表现。在一些多领域的评测中,采用MOE架构的DeepSeek-V2在Align Bench上展现出了顶级性能,甚至超过了GPT-4,且与GPT-4 Turbo不相上下。

-

便于模型扩展:MOE架构允许模型在保持计算成本相对稳定的情况下增加参数数量,具有更好的扩展性。可以轻松扩展到非常大的模型规模,如万亿参数模型,这为模型处理更复杂、更庞大的任务提供了可能,也适应了大模型发展的趋势。

-

多任务处理能力需求

-

适应多领域任务:在实际应用中,语言模型需要处理多种类型的任务,如文本生成、知识问答、推理计算、翻译等。MOE架构在多任务学习中表现出色,不同的专家可以专门负责不同的任务类型,使得模型能够在多个任务上都取得较好的性能。例如SwitchTransformer在所有101种语言上都显示出了性能提升,证明了MOE在多任务学习中的有效性。

-

提升综合性能:相比之下,Decoder only架构虽然在文本生成任务上表现出色,但在其他一些需要综合理解和处理能力的任务上可能存在局限性。MOE架构能够通过整合不同专家的能力,提升模型的综合性能,更好地满足实际应用中的多样化需求。

-

创新与优化空间更大

-

独特的路由机制与训练策略:MOE架构的门控网络和路由机制为模型的创新和优化提供了更多空间。研究人员可以通过改进门控网络的设计、优化专家选择策略等方式,进一步提高模型的性能和效率。例如,DeepSeek-V2采用了设备受限路由和辅助损失来实现负载均衡,确保了高效扩展和专家专业化。

-

融合其他技术的潜力:MOE架构可以更容易地与其他先进技术进行融合,如多模态信息融合、强化学习等。这使得模型能够更好地处理复杂的现实世界问题,拓展应用场景。例如,可以将图像、音频等多模态信息与文本信息结合,通过不同的专家进行处理,实现更强大的多模态交互功能。

MOE架构面临的挑战及DeepSeek的应对策略

-

训练不稳定性:由于每个输入样本仅触发部分专家,导致不同专家的梯度更新频率不同,可能会导致模型参数更新不稳定,影响整体模型的收敛性。DeepSeek通过采用一些稳定训练的技术,如优化的梯度更新算法、增加辅助损失函数等,来平衡不同专家的训练,提高模型的稳定性。

-

负载均衡问题:路由机制的随机性和输入数据的特性,可能导致某些专家承载的计算负载远高于其他专家。DeepSeek-V2采用了设备受限路由和辅助损失来实现负载均衡,确保各个专家能够均衡地参与计算,提高计算效率和模型训练效果。

-

微调挑战:MOE模型在微调时可能会面临迁移学习效果不确定的问题,某些专家可能并未得到充分训练。DeepSeek在微调过程中,会根据具体任务的特点,对专家进行有针对性的训练和调整,同时优化门控网络,使得模型能够更好地适应新任务。

-

部署复杂性:MOE模型通常比传统的稠密模型更加复杂,在实际部署中需要针对不同硬件环境进行优化。DeepSeek的研发团队致力于开发高效的部署工具和优化策略,以降低部署难度,提高模型在不同硬件平台上的运行效率。

总之,DeepSeek选择MOE架构是基于对计算资源、模型性能、多任务处理能力以及创新潜力等多方面的综合考量。尽管MOE架构面临一些挑战,但DeepSeek通过一系列的创新和优化措施,充分发挥了MOE架构的优势,使其在语言模型领域取得了令人瞩目的成绩,为大语言模型的发展提供了新的思路和方向。

最后的最后

感谢你们的阅读和喜欢,作为一位在一线互联网行业奋斗多年的老兵,我深知在这个瞬息万变的技术领域中,持续学习和进步的重要性。

为了帮助更多热爱技术、渴望成长的朋友,我特别整理了一份涵盖大模型领域的宝贵资料集。

这些资料不仅是我多年积累的心血结晶,也是我在行业一线实战经验的总结。

这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。如果你愿意花时间沉下心来学习,相信它们一定能为你提供实质性的帮助。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献66条内容

已为社区贡献66条内容

所有评论(0)