DeepSeek-R1技术报告,使用强化学习进行自我演进;Kimi k1.5技术报告;长度协调微调,长推理链优化

已有研究表明,模型参数和数据规模的比例扩展能够持续提升智能水平,但缺乏有效的 RL 方法来实现这一目标。

DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

http://arxiv.org/abs/2501.12948v1

https://huggingface.co/papers/2501.12948

研究背景与意义

在近年来,大型语言模型(LLMs)经历了快速的迭代与演变,逐步缩小了与人工通用智能(AGI)之间的差距。随着后期训练(post-training)成为全训练流程中的重要组成部分,研究者们发现其在推理任务上的准确性、与社会价值观的一致性以及对用户偏好的适应性得到了显著提升。然而,如何有效地进行测试时的推理能力扩展仍然是一个未解的难题。

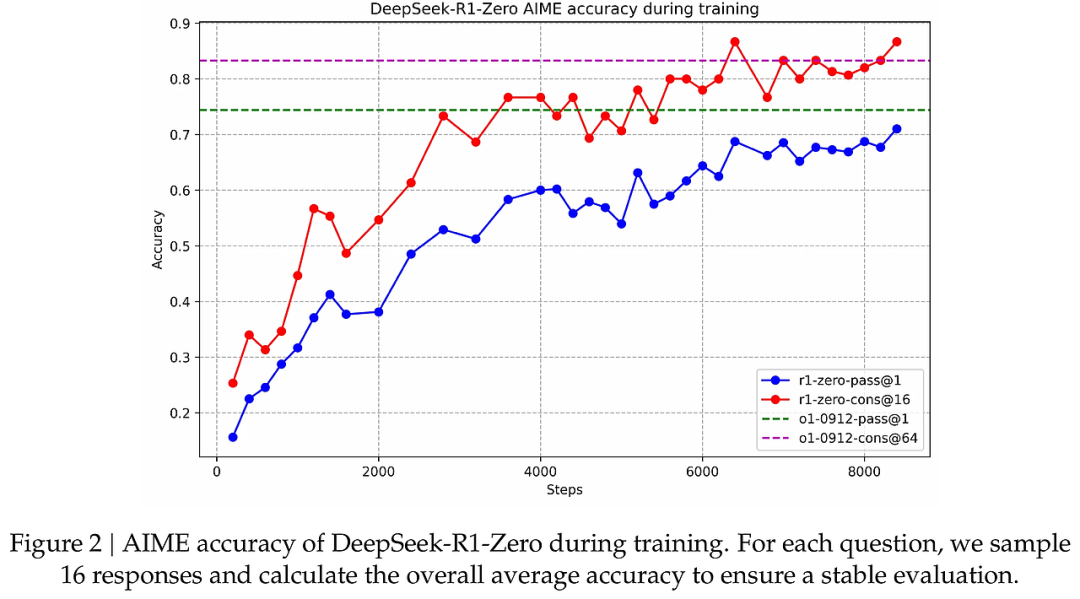

本论文的核心在于探索大型语言模型推理能力的提升,尤其是通过纯粹的强化学习(RL)而不依赖于监督数据。研究的目标是通过自我演化的方式,利用DeepSeek-V3-Base作为基础模型,采用GRPO(Group Relative Policy Optimization)框架来增强模型在推理任务上的表现。DeepSeek-R1-Zero的推出标志着这一方向的重大突破,其在推理基准测试中表现出色,尽管在可读性和语言混合等方面仍面临挑战。

研究方法与创新

本研究的创新之处在于引入了一种新的训练流程,分为多个阶段以优化推理能力,具体包括:

-

无监督的强化学习:DeepSeek-R1-Zero直接应用强化学习于基础模型,未依赖任何监督微调。这一方法使模型能够自我探索复杂问题的链式思维(CoT),最终形成了强大的推理能力。

-

冷启动数据的引入:为了解决DeepSeek-R1-Zero在可读性方面的不足,DeepSeek-R1模型引入了少量高质量的冷启动数据。这些数据经过精心设计,确保生成的内容既具可读性又符合用户需求。

-

多阶段训练管道:DeepSeek-R1结合了多阶段的强化学习和监督微调,旨在提升模型的推理能力和人类偏好的对齐。这种方法不仅增强了模型的推理能力,还提高了其在多种任务中的表现。

-

蒸馏技术:通过从DeepSeek-R1蒸馏出小型模型,研究表明较小的模型也能表现出强大的推理能力。这一发现为未来开发更高效的推理模型奠定了基础。

实验设计与结果分析

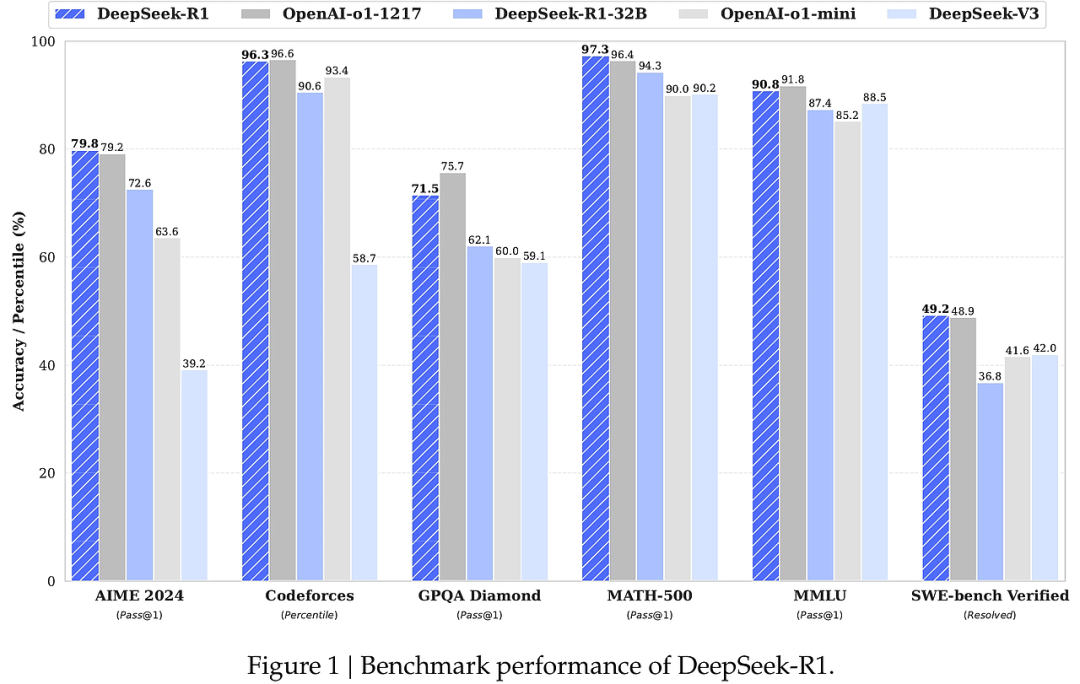

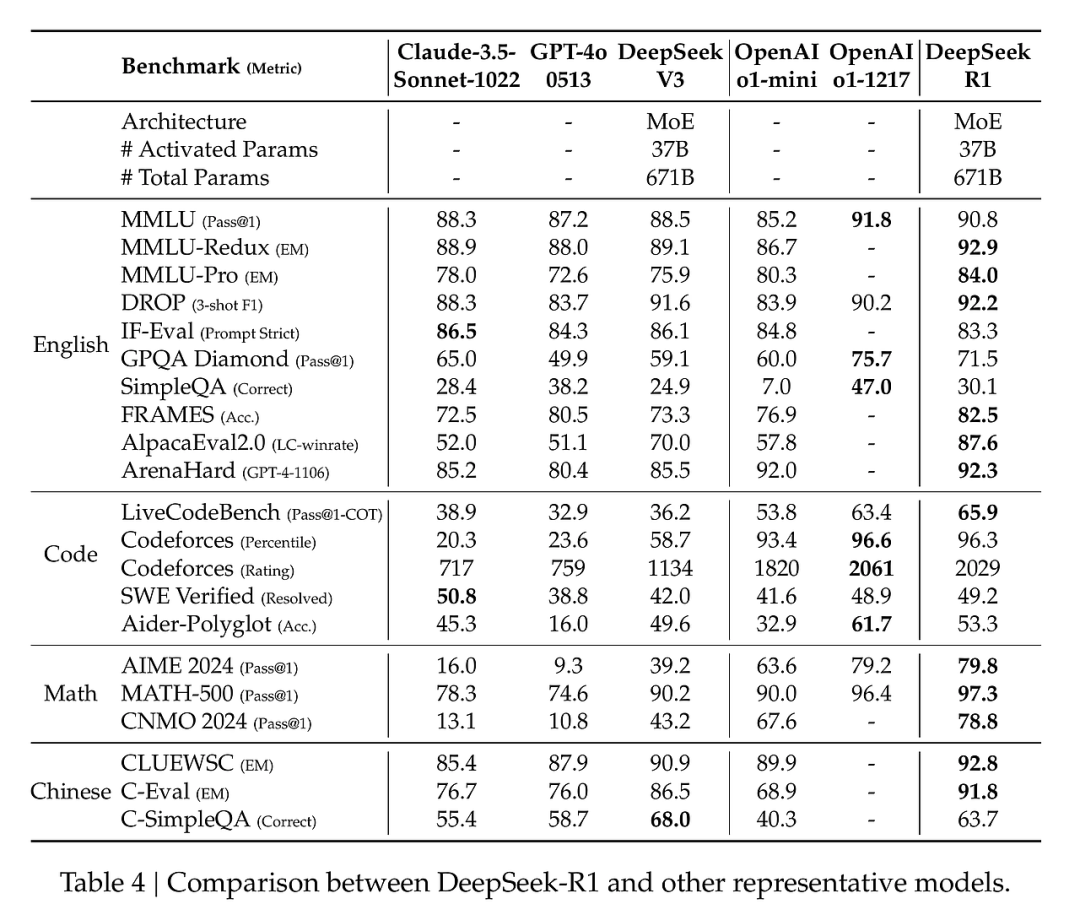

本研究在多个基准测试上对DeepSeek-R1进行了评估,结果显示:

-

在AIME 2024和MATH-500等推理任务中,DeepSeek-R1的表现超越了其他模型,尤其是在数学和编码相关任务中,显著提升了准确性。

-

通过引入冷启动数据,DeepSeek-R1在可读性和推理能力上均有显著改善,尤其是在长文本理解和多语言处理方面。

-

蒸馏模型(如DeepSeek-R1-Distill-Qwen-7B)在推理基准测试中表现出色,超过了许多非推理模型,证明了蒸馏技术的有效性。

结论与展望

本研究的主要贡献在于提出了一种通过强化学习提升大型语言模型推理能力的方法,展示了在无监督条件下实现自我演化的潜力。尽管DeepSeek-R1在可读性和语言一致性方面仍存在改进空间,但其在多项推理任务中的表现证明了这一方法的有效性。

未来的研究方向可以集中在进一步优化模型的可读性和对复杂任务的适应性上,同时探索更多的蒸馏技术以提升小型模型的推理能力。通过持续的研究与开发,期望能为大型语言模型的推理能力提升提供更为广泛的解决方案。

Kimi k1.5: Scaling Reinforcement Learning with LLMs

http://arxiv.org/abs/2501.12599v1

https://huggingface.co/papers/2501.12599

研究背景与意义

在当今人工智能领域,语言模型的预训练通常依赖于下一个标记预测,这种方法在计算资源的扩展上表现出色,但受到可用训练数据量的限制。Kimi k1.5 的研究旨在通过强化学习(RL)拓展这一局限,探索一种新的扩展路径。通过让大型语言模型(LLMs)学习在奖励的驱动下进行探索,Kimi k1.5 试图打破传统数据集的束缚,为人工智能的持续改进提供新的动力。

-

研究问题:当前的模型训练受限于高质量训练数据的可用性,如何在没有固定数据集的情况下提升模型能力成为关键问题。

-

现状概述:已有研究表明,模型参数和数据规模的比例扩展能够持续提升智能水平,但缺乏有效的 RL 方法来实现这一目标。

-

挑战:如何设计出有效的 RL 策略,使其在多模态数据上表现优异,并能与现有的模型竞争。

-

目标:提出一种新的 RL 训练框架,使得 Kimi k1.5 在多种基准测试中达到或超越现有最优性能。

研究方法与创新

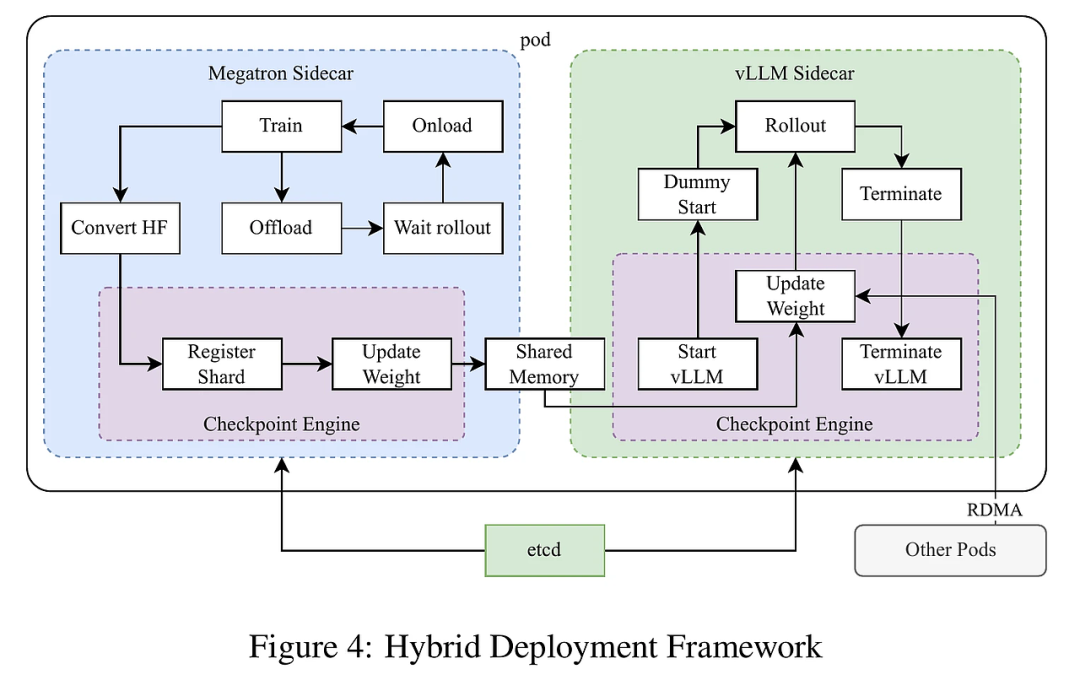

Kimi k1.5 的研究方法在于其独特的强化学习框架,结合了多模态数据训练和长上下文的利用。研究团队在以下几个方面进行了创新:

-

长上下文扩展:将 RL 的上下文窗口扩展至 128k,显著提升了模型的性能。通过部分回滚(partial rollout)技术,优化了训练效率,减少了从头生成新轨迹的成本。

-

优化策略改进:采用了一种新的 RL 方法,结合在线镜像下降(online mirror descent)技术,确保优化策略的稳健性。

-

简化框架:通过将长上下文扩展与改进的政策优化方法结合,建立了一个简化的 RL 框架,避免了更复杂技术的依赖,如蒙特卡罗树搜索和价值函数。

-

多模态联合训练:模型同时在文本和视觉数据上进行训练,具备跨模态推理能力。

这些创新不仅提升了 Kimi k1.5 的推理性能,还为强化学习与语言模型的结合提供了新的视角。

实验设计与结果分析

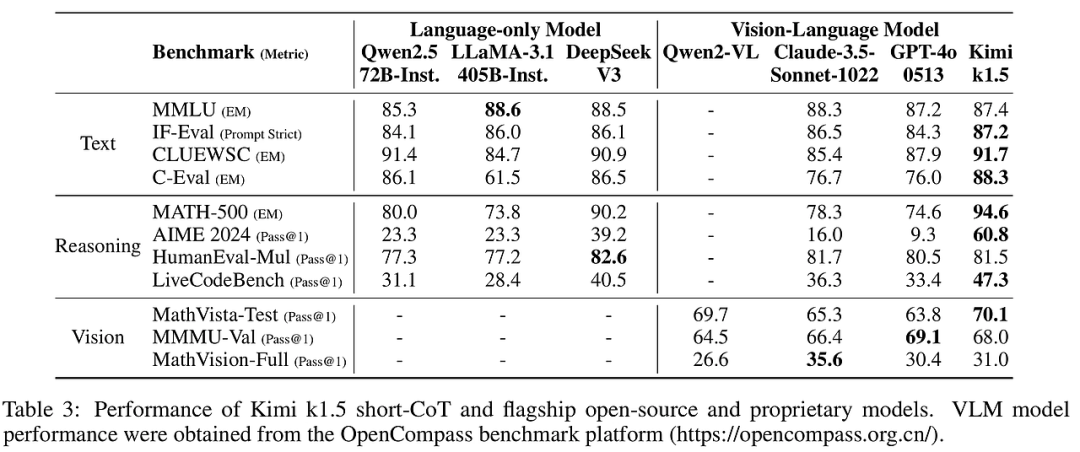

Kimi k1.5 的实验设计围绕其 RL 训练方法展开,重点分析了模型在不同基准测试中的表现:

-

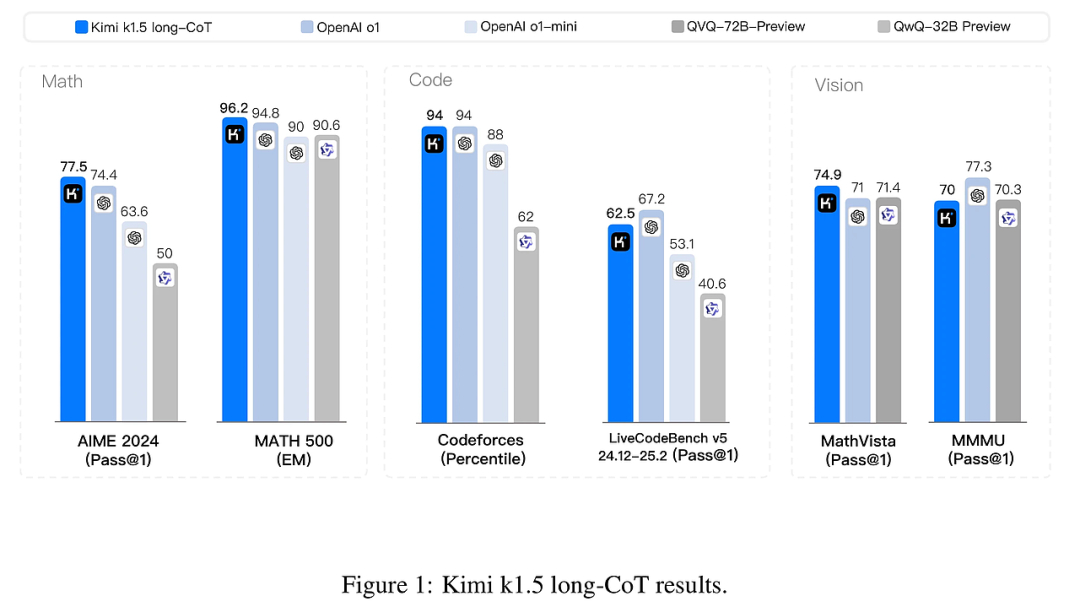

实验描述:通过多轮次的实验,评估 Kimi k1.5 在 AIME、MATH 500、Codeforces 和 MathVista 等多个基准上的表现。

-

结果对比:Kimi k1.5 在多个基准上达到了最先进的推理性能。例如,在 AIME 上取得了 77.5 的成绩,在 MATH 500 上达到了 96.2,表现出色。

-

统计显著性:通过与现有模型(如 OpenAI 的 o1)进行比较,Kimi k1.5 的表现显著优于其他短链模型,提升幅度可达 550%。

这些结果表明,Kimi k1.5 的设计和训练策略在推动模型性能上取得了显著成效。

结论与展望

Kimi k1.5 的研究为未来的多模态人工智能系统提供了重要的参考和启示:

-

贡献总结:该研究展示了通过强化学习扩展语言模型能力的有效性,尤其是在多模态数据处理上。

-

局限分析:尽管 Kimi k1.5 在多个基准测试中表现优异,但仍需进一步优化模型的训练效率和推理速度。

-

方法展望:未来的研究可考虑引入更复杂的奖励模型和多任务学习策略,以进一步提升模型的适用性和性能。

通过这些分析,Kimi k1.5 不仅为当前的人工智能研究提供了新的思路,也为未来的技术发展奠定了基础。

O1-Pruner: Length-Harmonizing Fine-Tuning for O1-Like Reasoning Pruning

http://arxiv.org/abs/2501.12570v1

https://huggingface.co/papers/2501.12570

https://github.com/StarDewXXX/O1-Pruner

研究背景与意义

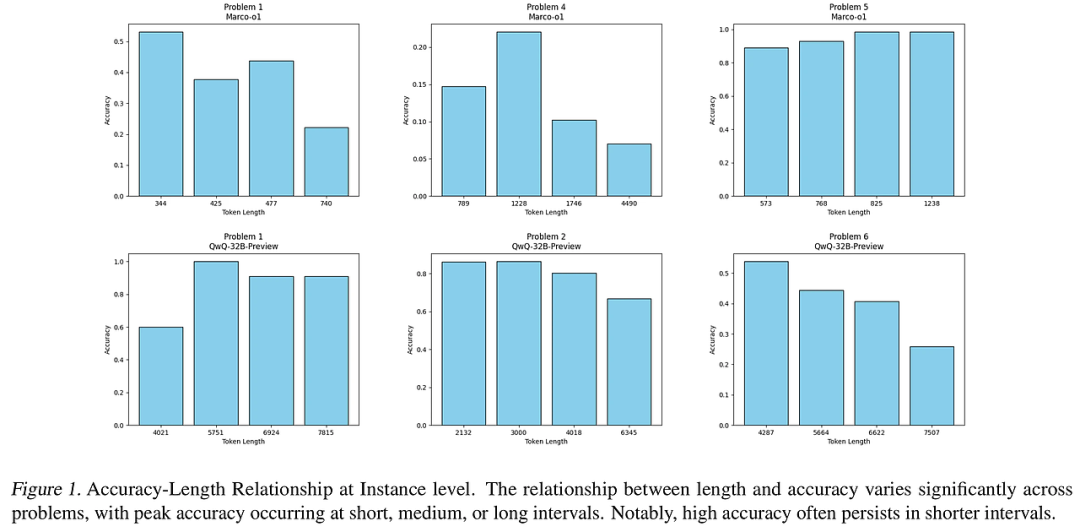

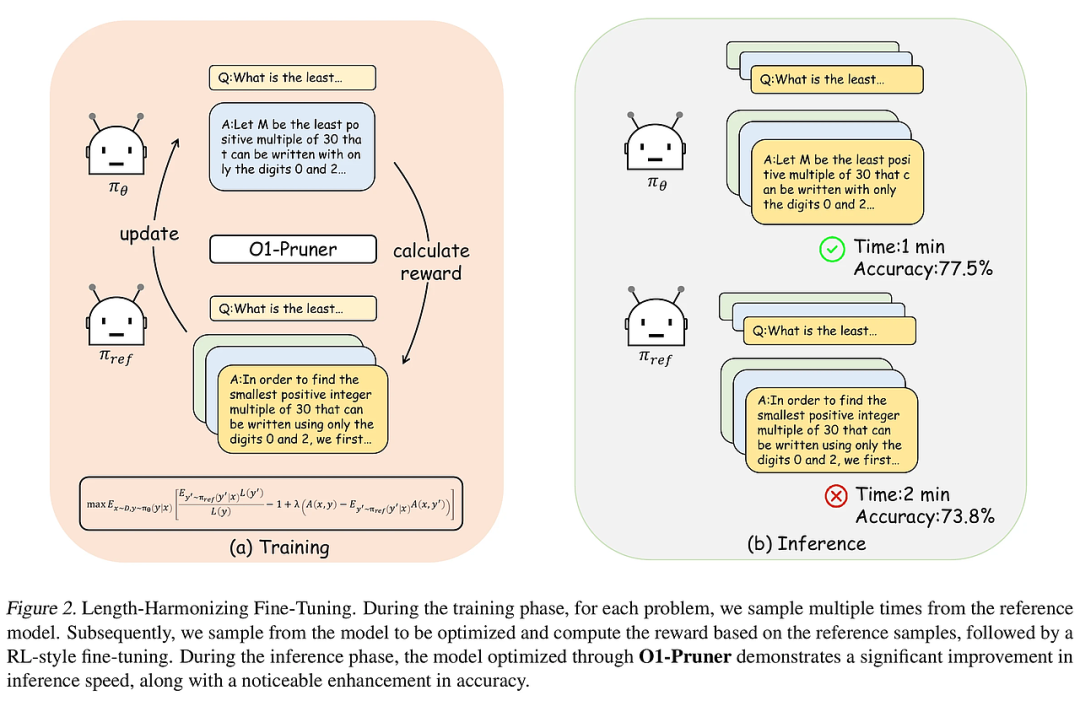

在当前的人工智能研究中,推理能力是大型语言模型(LLMs)的核心特性之一。尤其是长思维推理模型,如OpenAI的O1,展示了模拟人类解决复杂问题的过程。然而,尽管这些模型在推理能力上取得了显著的进展,但它们在推理过程中往往面临冗余计算和推理时间过长的问题。这不仅降低了模型的效率,也限制了其在多模态任务中的应用。因此,针对长思维推理的优化成为了一个亟待解决的挑战。本论文的目标是提出一种新的调优方法——长度协调微调(O1-Pruner),以在保持推理准确性的同时,降低推理过程中的冗余和计算开销。

研究方法与创新

本研究提出的O1-Pruner方法是一种基于强化学习的微调技术,其核心在于通过预采样评估模型的基线性能,并利用强化学习风格的微调机制,鼓励模型在准确性约束下生成更短的推理过程。具体而言,O1-Pruner通过以下几个步骤实现其创新性:

-

推理路径优化:针对长思维模型中存在的推理冗余现象,O1-Pruner通过优化推理路径,减少不必要的计算步骤。

-

动态调整推理长度:模型能够根据问题的复杂性动态调整推理的长度,使得在简单问题上输出较短的答案,而在复杂问题上则生成更为详细的推理过程。

-

实验验证:通过在多种数学推理基准上进行实验,O1-Pruner不仅显著降低了推理开销,还提高了模型的准确性,展示了其在处理复杂任务时的有效性。

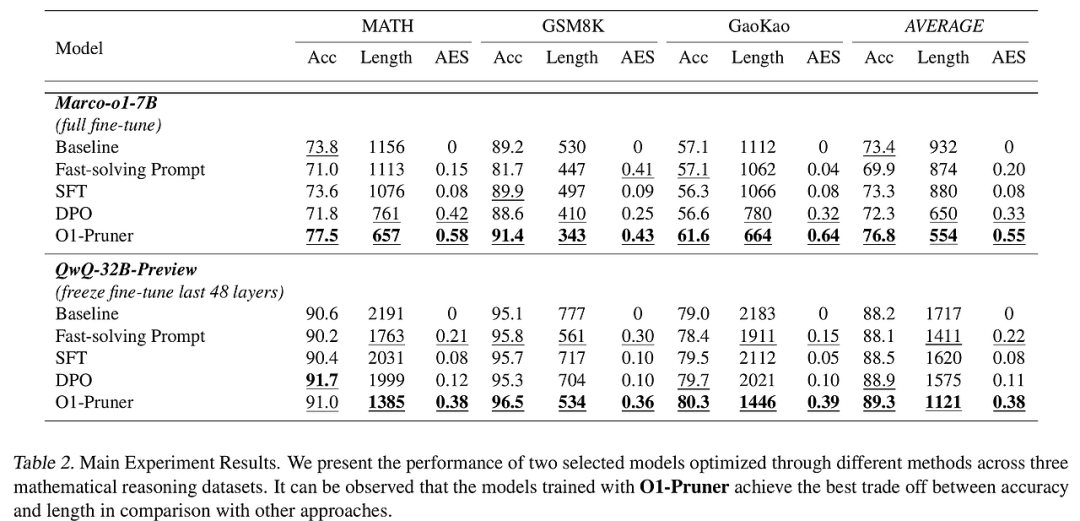

实验设计与结果分析

本研究的实验设计围绕O1-Pruner的有效性展开,主要包括以下几个方面:

-

数据集选择:使用MATH数据集进行训练和测试,该数据集包含高难度的数学问题及其解决方案。

-

比较基准:与多种现有方法(如SFT、DPO等)进行对比,评估O1-Pruner在推理准确性、推理长度及计算效率等方面的表现。

-

结果分析:实验结果表明,O1-Pruner在准确性和推理长度之间达到了最佳平衡,相较于其他方法,O1-Pruner在多个数据集上均表现出更高的准确性和更短的推理时间。

结论与展望

本研究提出的O1-Pruner在优化长思维推理方面具有显著的贡献,能够有效减少推理过程中的冗余计算,同时保持较高的推理准确性。未来的研究可以在以下几个方向进行拓展:

-

模型通用性:进一步验证O1-Pruner在其他类型的长思维推理任务中的适用性。

-

多模态应用:探索O1-Pruner在多模态任务中的应用潜力,如图像和文本结合的复杂推理。

-

算法优化:针对O1-Pruner的算法进行进一步优化,以提升其在大规模数据集上的训练效率与推理速度。

通过这些研究方向的探索,期望能够推动长思维推理模型的进一步发展,提升其在实际应用中的表现。

如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 2024行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献350条内容

已为社区贡献350条内容

所有评论(0)