【LLM】Towards Reasoning Era: A Survey of Long Chain-of-Thought for Reasoning Large Language Models

Long CoT 的出现现象:研究表明,上下文示例能够引导模型生成推理链,标准化推理链的生成过程。通过实验发现,仅保留逻辑结构的上下文示例也能实现与完整示例相似的性能,强调了 Long CoT 在推理中对逻辑结构的模仿能力。• 推理边界的限制:研究指出,RLMs 在推理任务中存在性能上限,当任务复杂度超过模型的推理边界时,性能会下降。例如,在代码生成任务中,模型在处理复杂逻辑时会遇到困难。此外,模

note

文章目录

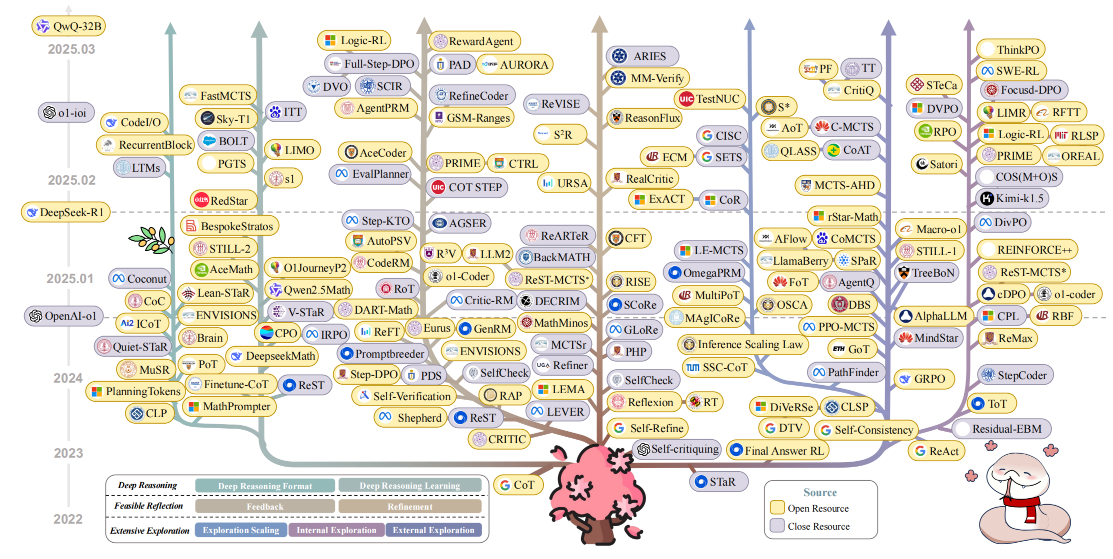

一、Long-cot的发展

论文:Towards Reasoning Era: A Survey of Long Chain-of-Thought for Reasoning Large Language Models

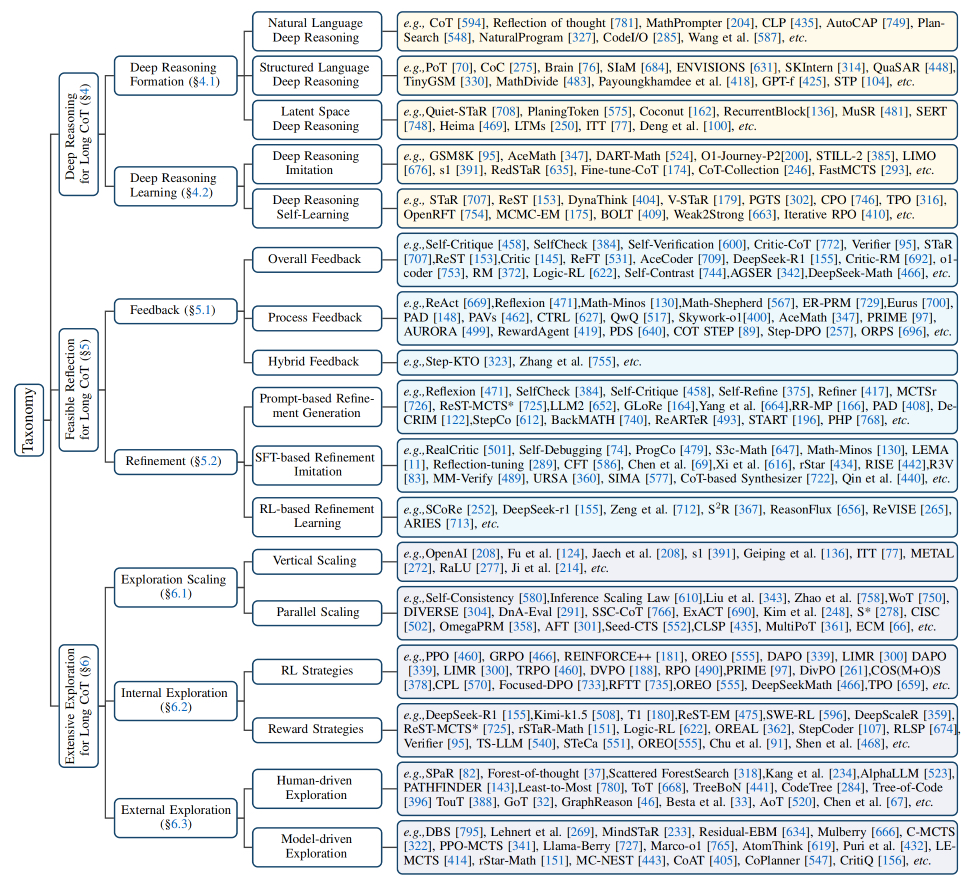

深度推理、可行反思和广泛探索。每个特征进一步细分为关键领域:

- 深度推理

- 可行反思:关注反思过程中的反馈和优化策略中的细化技术。

- 广泛探索:涉及长链推理的关键改进,包括规模扩展、内部探索和外部探索。

二、Long CoT分析

1. Long CoT的外部行为分析(External Behavior Analysis)

• Long CoT 的出现现象:研究表明,上下文示例能够引导模型生成推理链,标准化推理链的生成过程。

通过实验发现,仅保留逻辑结构的上下文示例也能实现与完整示例相似的性能,强调了 Long CoT 在推理中对逻辑结构的模仿能力。

• 推理边界的限制:研究指出,RLMs 在推理任务中存在性能上限,当任务复杂度超过模型的推理边界时,性能会下降。例如,在代码生成任务中,模型在处理复杂逻辑时会遇到困难。此外,模型的输入长度也会影响其推理能力。

• 过度思考现象(Overthinking Phenomenon):研究表明,随着推理链长度的增加,模型性能会先上升后下降。这表明,推理链长度与逻辑复杂性之间存在一个最优平衡点。当推理链超出模型的推理边界时,会导致性能下降,甚至可能出现“幻觉”或错误累积。

• 推理测试时扩展(Inference Test-Time Scaling Phenomenon):研究探讨了推理测试时扩展算法,包括垂直扩展(增加推理路径长度)和平行扩展(增加推理尝试次数)。虽然这些方法可以在一定程度上提高性能,但超出模型推理边界后,性能提升会受限。

• ORM与PRM现象:研究分析了结果奖励模型(Outcome Reward Model,ORM)和过程奖励模型(Process Reward Model,PRM)在推理中的应用。ORM 在数学和逻辑任务中表现出色,但 PRM 在某些情况下可能更有效。此外,研究还探讨了 ORM 和 PRM 之间的关系,以及如何通过奖励模型优化推理链路。

• “顿悟时刻”(Aha Moment Phenomenon):部分研究表明,通过强化学习训练的模型可能会出现“顿悟时刻”,即模型能够自然地进行自我反思和改进。然而,也有研究指出,在某些情况下,模型可能无法实现真正的自我反思,而是表现出表面的自我反思行为。

2. Long CoT的内部机制分析(Internal Mechanism Analysis)

• 注意力机制(Attention Mechanism):研究发现,Long CoT 的生成与模型的注意力机制密切相关。例如,System 2 Attention(S2A)能够通过选择性关注相关信息来生成 Long CoT。此外,研究还探讨了模型内部梯度分布对推理稳定性的影响。

• 知识整合机制(Knowledge Incorporation Mechanism):研究分析了如何将领域特定的知识整合到 Long CoT 中。例如,通过概率混合模型(Probabilistic Mixture Model,PMM)可以将模型输出分类为推理、记忆和猜测,并通过信息论一致性(Information-Theoretic Consistency,ITC)分析来量化模型置信度与策略选择之间的关系。

• 推理深度与知识深度(Concept Depth):研究探讨了模型在推理过程中对复杂概念的理解深度,发现不同模型在不同层次上整合知识的能力存在差异。此外,研究还通过知识循环演化分析了模型知识的内化过程。

三、分类和汇总

主流方法分为深度推理、可行反思、广泛探索三类。

深度推理分类:

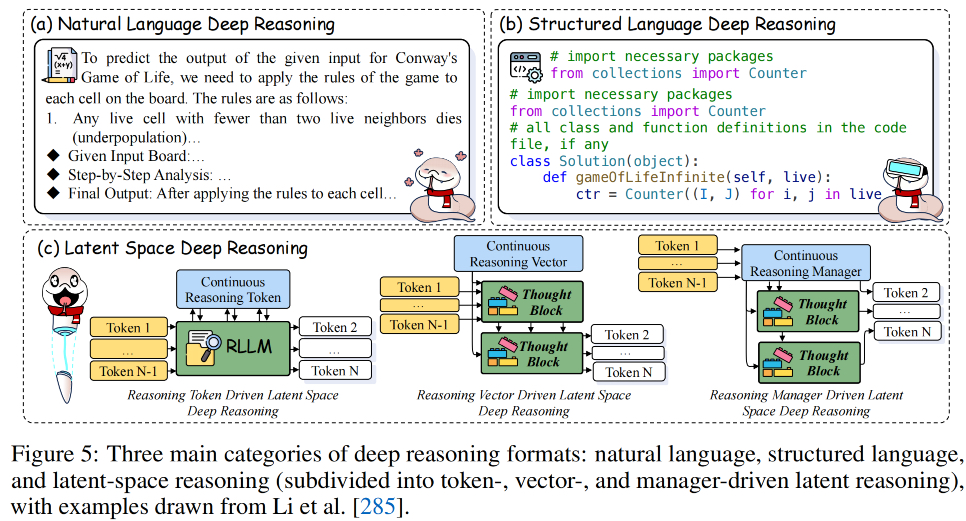

• 自然语言深度推理(Natural Language Deep Reasoning):早期研究者如Wei et al. [594] 发现,使用自然语言的长链推理(CoT)显著增强了 RLLMs 的推理能力。Code/O [285] 进一步将代码推理模式重组为自然语言格式,提升了模型的推理潜力。

• 结构化语言深度推理(Structured Language Deep Reasoning):包括程序语言或符号语言推理,如PoT [70] 和 Brain [76] 等,通过环境引导的神经符号自训练框架,解决了符号数据稀缺和符号处理限制的问题。

• 潜在空间深度推理(Latent Space Deep Reasoning):将推理过程嵌入到连续的潜在空间中,分为基于管理令牌(token-driven)、向量(vector-driven)和管理器(manager-driven)的推理方式。例如,Coconut [162] 通过维护多个推理路径,提高了推理效率。

Reference

[1] Towards Reasoning Era: A Survey of Long Chain-of-Thought for Reasoning Large Language Models

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献81条内容

已为社区贡献81条内容

所有评论(0)