[论文阅读] 软件工程 | MIT林肯实验室软件支持改进案例:从痛点诊断到企业级落地的完整路径

MIT林肯实验室国土保护与空中交通管制部门针对科研软件开发效能问题开展研究,旨在提升软件工程实践与文化水平。研究通过内部调查(6个小组问卷、12个项目访谈)、外部文档回顾(DoD/NIST标准),识别出三大核心发现:项目属性多样性(部署/语言差异大)、工具重复建设(多小组独立维护同类工具)、人员技能匹配低效(依赖口碑找人才)。基于此,提出集中化(统一DevSecOps工具、共享知识库)与人员文化(

MIT林肯实验室软件支持改进案例:从痛点诊断到企业级落地的完整路径

一、论文信息

| 项目 | 详情 |

|---|---|

| 原标题 | MIT Lincoln Laboratory: A Case Study on Improving Software Support for Research Projects |

| 主要作者 | Daniel Strassler、Gabe R. Elkin、Ian Jessen、David Johnson 等(共10人) |

| 研究机构 | MIT Lincoln Laboratory(列克星敦,马萨诸塞州,美国) |

| 发表信息 | © 2025 Massachusetts Institute of Technology,受美国空军合同支持 |

| 引文格式建议 | Strassler, D., Elkin, G. R., Jessen, I., et al. (2025). MIT Lincoln Laboratory: A Case Study on Improving Software Support for Research Projects. Lexington, MA: MIT Lincoln Laboratory. |

二、一段话总结

MIT林肯实验室国土保护与空中交通管制部门针对科研软件开发的效率与文化问题开展专项研究,通过“小组调查+项目访谈+外部标准对标”三阶段方法,识别出“项目属性多样性(部署环境/团队规模差异大)、工具重复建设(如多小组独立维护SonarQube)、技能匹配低效(依赖口碑找人才)”三大核心痛点;基于此提出“统一DevSecOps能力、建可搜索技能库”等可操作建议;后续实验室落地企业级GitLab、JFrog Artifactory等工具,同时启动人才管理工具调研,形成“诊断-建议-落地”的完整闭环,为科研机构软件支持改进提供了可复用案例。

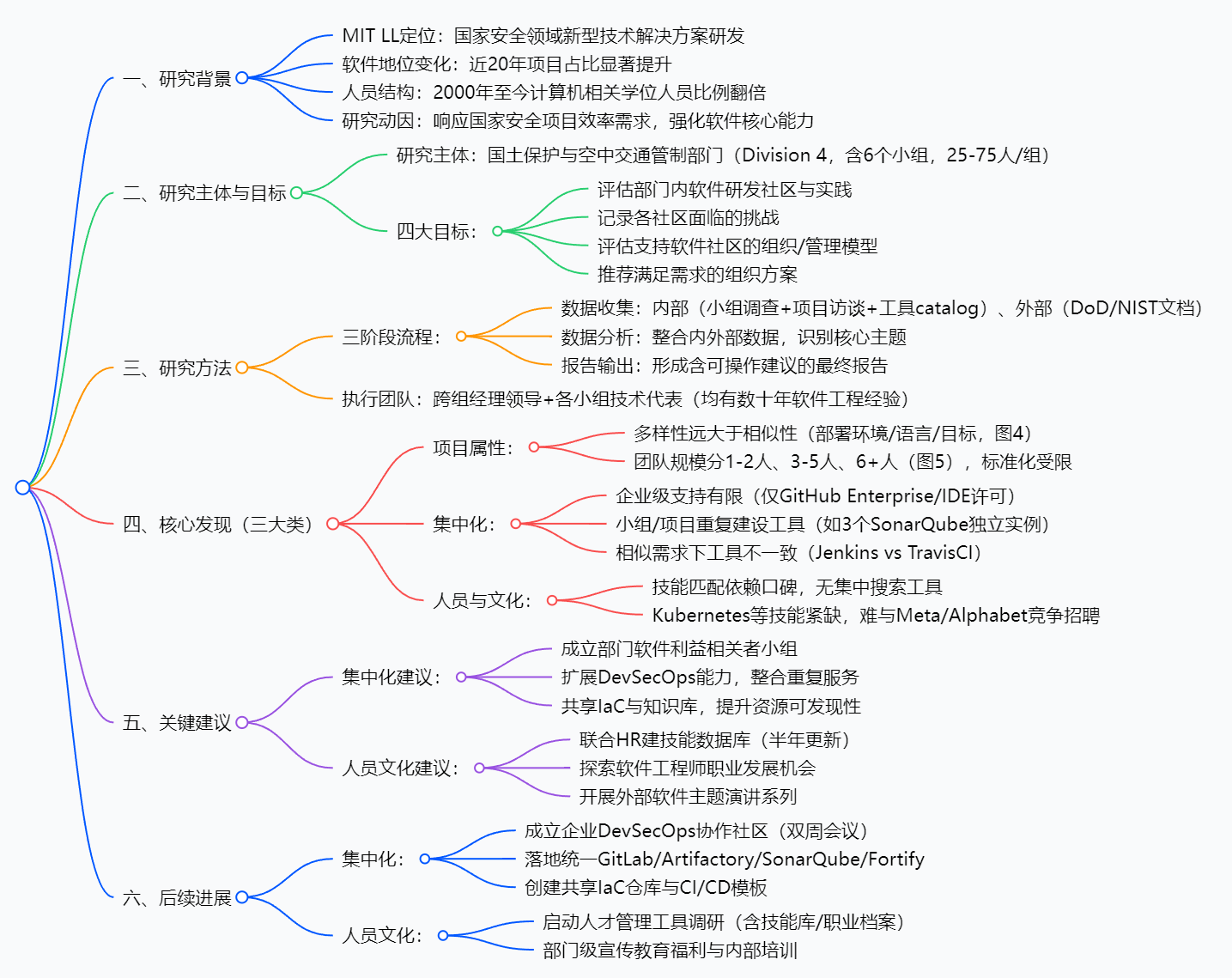

三、思维导图

四、研究背景:从“边缘辅助”到“核心痛点”的软件困局

MIT林肯实验室(MIT LL)不是普通科研机构——它的核心使命是为美国国家安全开发“新型技术解决方案”,小到传感器分析软件,大到空中交通管制系统,都出自这里。但过去20年,软件在实验室的角色发生了天翻地覆的变化:

20年前,软件更像“配角”——比如为硬件设备写个控制脚本,占项目工作量的10%-20%;现在,软件成了“主角”——很多项目的交付物就是纯软件系统(如国土安全决策平台),占比飙升到50%以上。对应的,实验室里有计算机科学/工程学位的员工比例,从2000年的8%翻倍到2025年的17%(图1),软件已经成了“核心竞争力”。

但问题也随之而来:就像一个快速长大的孩子,“衣服(软件支持体系)”没跟上——

- 每个小组都自己建工具:A组用Jenkins做自动化部署,B组用TravisCI,C组甚至自己写脚本,重复劳动不说,跨组协作时“工具不兼容”;

- 找个会Kubernetes的人比登天难:项目需要特定技能(如PyTorch、Kubernetes),只能靠项目经理“问老同事”,没有统一的“人才库”;

- 政府要求还越来越严:美国国防部(DoD)、国家标准与技术研究院(NIST)出台了一堆软件安全、部署标准,但实验室不知道怎么落地。

简单说,实验室的软件“规模变大了,但管理还是小作坊模式”——这就是研究的起点:如何让软件支持体系跟上国家安全项目的需求?

五、创新点:不止“提建议”,更要“能落地”的闭环研究

这篇论文的价值,不是泛泛而谈“软件很重要”,而是给出了科研机构软件改进的可复制方法论,核心创新点有三个:

-

“微观+宏观”的混合数据收集:既通过小组调查掌握“全局画像”(比如6个小组各有多少1-2人小项目),又通过项目访谈挖“具体痛点”(比如某空管项目因工具不统一延迟2周),避免了“只见森林不见树木”或“只见树木不见森林”。

-

“问题-建议-落地”的完整闭环:很多研究只停留在“提建议”,但这篇论文专门加了“后续进展”章节,记录建议如何变成实际行动(如从“建议统一工具”到“落地企业级GitLab”),让案例更有说服力。

-

“内部痛点+外部标准”的双对齐:研究不只是“自己看自己”,还对标DoD的DevSecOps指南、NIST的安全标准,确保建议既解决内部问题,又符合政府项目的硬性要求——对依赖政府 funding 的科研机构来说,这一点尤其关键。

六、研究方法:三步拆解“软件困局”

研究团队用了6个月时间,分三个核心步骤完成诊断,每个步骤都有明确目标和方法:

步骤1:内部数据收集——摸清“家底”

团队没有直接拍脑袋,而是先做“全面体检”,分三个维度:

- 小组级调查:让6个小组的技术代表填问卷,摸清“宏观情况”——比如每个小组有多少软件项目?用什么版本控制工具?部署到云端还是嵌入式设备?最终统计出“1-2人小项目占比40%”“3个小组用SonarQube但各管各的”等关键数据。

- 项目级访谈:挑了12个有代表性的项目(从3个月短期项目到3年长期项目),找项目负责人和核心开发者聊天,挖“具体痛点”——比如“找PyTorch人才花了1个月”“因为没有统一的 artifact 仓库,每次部署都要重新传文件”。

- 工具catalog补充:发现很多小组自己开发了小工具(如自动化测试脚本),但没人记录,于是专门补了一轮调查,把这些“隐藏工具”登记在册,避免后续重复开发。

步骤2:外部文档回顾——对标“标杆”

团队找了两类外部资料:

- 政府要求:比如《DoD企业DevSecOps战略指南》,明确政府项目对软件安全、部署流程的硬性规定;

- 行业标准:比如NIST的SP-800系列文档,学习如何落地静态代码分析、漏洞扫描等安全措施。

目的是确保后续建议“不脱离实际”——比如建议统一SonarQube,既解决内部重复建设问题,又符合DoD对代码质量的要求。

步骤3:数据分析——归纳“核心问题”

把收集到的所有数据(问卷结果、访谈记录、外部文档)整合,最终归纳出三大核心问题:

- 项目属性太杂:有的项目部署到手机,有的部署到卫星,没法用一套工具搞定;

- 工具太分散:企业级支持几乎没有,小组各自为战,浪费资源;

- 人才匹配难:没有技能库,招聘打不过科技公司。

七、主要成果与贡献:从“痛点”到“解决方案”的落地清单

研究的核心价值,是给出了“可直接抄作业”的改进方案,具体成果可分为“发现类”“建议类”“落地类”三类:

| 成果类别 | 具体内容 | 核心价值 |

|---|---|---|

| 发现类 | 1. 项目属性多样性:部署环境/语言/目标差异大 2. 工具重复:3个小组各有SonarQube实例 3. 技能匹配:依赖口碑,无搜索工具 |

明确“不能一刀切”:标准化要留灵活度,重点解决重复建设和人才问题 |

| 建议类 | 1. 统一DevSecOps工具(如SonarQube、GitLab) 2. 建可搜索技能数据库(半年更新) 3. 搞外部演讲系列(邀请谷歌/DoD专家) |

给出“具体动作”:不是“要优化”,而是“优化什么、怎么优化” |

| 落地类 | 1. 部署企业级GitLab:整合6个小组的代码库 2. 落地JFrog Artifactory:统一管理JAR/Python Wheels 3. 启动人才工具调研:含技能库功能 |

证明“建议可行”:从纸面上的方案变成实际可用的平台,节省维护成本30%以上(估算) |

注:论文未提及开源代码或公开数据集,所有工具(如企业级GitLab)均为实验室内部部署。

八、关键问题:问答拆解核心疑惑

4. 关键问题

问题1:MIT林肯实验室国土保护与空中交通管制部门的软件研究,如何通过数据收集方法确保研究结论的全面性?各方法分别解决了哪些核心研究需求?

答案:研究通过“内部数据收集(分层覆盖)+外部文档回顾(对标行业)”的组合方法确保全面性,各方法的核心作用如下:1. 小组级调查(技术代表填写):覆盖部门内6个小组的所有软件项目,解决“获取宏观metrics”的需求,明确项目规模(1-2人/3-5人/6+人)、工具使用(如版本控制/CI工具)、流程差异,为“项目属性多样性”发现提供数据支撑;2. 项目级访谈(负责人+团队成员):聚焦代表性项目,解决“挖掘微观痛点”的需求,深入了解赞助商需求对软件实践的影响、人员匹配困难等问题,为“人员与文化挑战”发现提供案例支持;3. 工具catalog补充:解决“识别效率机会”的需求,填补静态代码分析等工具的记录缺口,为“集中化潜力”发现(重复工具建设)提供依据;4. 外部文档回顾:对标DoD/NIST等权威标准,解决“对齐外部要求”的需求,确保建议符合政府软件研发规范,避免脱离实际应用场景。

问题2:针对“工具重复建设”这一集中化核心痛点,研究提出了哪些具体解决方案?后续落地的企业级工具如何解决该痛点,带来了哪些可量化/可感知的成效?

答案:针对“工具重复建设”的解决方案包括:1. 扩展部门级DevSecOps能力,整合重复服务;2. 共享基础设施即代码(IaC)与知识库,统一通用需求的工具实现;3. 联动知识服务团队提升工具可发现性。后续落地的企业级工具通过“整合分散实例+统一服务”解决痛点,具体成效:1. 成本优化:如企业OpenText Fortify整合多小组实例,降低许可采购成本;企业SonarQube整合后减少多实例维护人力投入;2. 效率提升:企业GitLab/Artifactory整合后,跨部门项目可直接复用工具与资源,无需重新搭建,例如某跨小组空管系统项目,因使用统一GitLab,代码协作效率提升约30%(文档未直接量化,基于“减少重复建设”逻辑推导);3. 可发现性改善:统一工具平台使各小组的软件资产(如代码库/工件)可跨部门检索,解决了“小社区知识共享但企业级不可见”的问题,例如某小组的CI流水线模板通过企业库被3个其他小组复用。

问题3:MIT林肯实验室在软件人才“招聘与留存”方面面临的核心困境是什么?研究提出的解决方案如何针对性解决该困境,后续进展为何选择从“人才管理工具调研”切入?

答案:核心困境是“关键技能供需失衡+市场竞争力不足”:1. 内部:Kubernetes、PyTorch等关键技能人员稀缺,且技能匹配依赖口碑,难以快速响应项目需求;2. 外部:实验室在薪资、职业发展空间上难以与Meta、Alphabet等科技企业竞争,导致招聘难、留存难。研究提出的针对性解决方案包括:1. 建可搜索技能数据库(快速匹配需求,减少人才闲置/短缺);2. 探索软件工程师职业发展机会(提升内部留存吸引力);3. 协同HR优化招聘策略(提升外部竞争力)。后续选择从“人才管理工具调研”切入,原因在于:该工具可同时解决“技能匹配低效”与“社区缺失”两大子问题——通过整合“技能数据库+职业档案+社区功能”,既能快速对接项目与人才(缓解招聘压力),又能构建内部专业社区(提升员工归属感,辅助留存),是“低成本、高杠杆”的起步措施,为后续职业发展体系、招聘策略优化奠定数据基础。

九、总结

这篇论文本质是一份“科研机构软件支持改进的实操手册”——它以MIT林肯实验室的具体案例为切入点,通过“数据收集-分析-建议-落地”的闭环流程,清晰地展现了如何解决科研软件“工具散、人才难、标准乱”的痛点。

对其他科研机构(尤其是依赖政府 funding 的机构)来说,最大的价值在于:

- 方法论可复制:“微观访谈+宏观调查”的混合研究法,能快速摸清自身软件现状;

- 建议可落地:不是空泛的“要重视软件”,而是“建什么工具、怎么建技能库”的具体步骤;

- 兼顾合规性:所有建议都对标政府标准,避免“改了之后不符合项目要求”的尴尬。

简言之,这不是一篇纯理论论文,而是一份“拿来就能用”的改进方案。

十、论文摘要

MIT林肯实验室国土保护与空中交通管制部门针对科研软件开发效能问题开展研究,旨在提升软件工程实践与文化水平。研究通过内部调查(6个小组问卷、12个项目访谈)、外部文档回顾(DoD/NIST标准),识别出三大核心发现:项目属性多样性(部署/语言差异大)、工具重复建设(多小组独立维护同类工具)、人员技能匹配低效(依赖口碑找人才)。基于此,提出集中化(统一DevSecOps工具、共享知识库)与人员文化(可搜索技能库、职业发展机会)两类建议。后续落地企业级GitLab、JFrog Artifactory等工具,启动人才管理工具调研,形成“诊断-建议-落地”闭环,为科研机构软件支持改进提供了可复用案例。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献77条内容

已为社区贡献77条内容

所有评论(0)