CentOS 7下支持H.265与RTMP推流的FFmpeg预编译实战包

FFmpeg采用模块化设计,其核心由libavcodec和三大库构成。libavcodec负责音视频编解码,集成x264、x265、VP9等主流编码器;处理封装与解封装,支持MP4、FLV、MKV及RTMP流协议;提供滤镜链机制,实现画中画、缩放、去噪等实时处理。# 查看FFmpeg支持的编解码器该命令可验证H.265(HEVC)解码器是否启用,反映编译时对libx265的支持状态。

简介:FFmpeg是一款功能强大的开源多媒体处理工具,广泛用于音视频转码、流化和处理。本资源“ffmpeg-rtmp-h.265-all.tar.gz”是针对CentOS 7系统预编译并优化的FFmpeg软件包,集成RTMP协议支持与H.265(HEVC)编码能力,省去用户手动配置和编译的复杂流程。该工具包可直接用于实现高效视频压缩与实时推流,适用于直播、点播等流媒体应用场景,帮助开发者快速部署高性能音视频处理服务。

1. FFmpeg简介与核心功能

核心组件架构与功能分工

FFmpeg采用模块化设计,其核心由 libavcodec 、 libavformat 和 libavfilter 三大库构成。 libavcodec 负责音视频编解码,集成x264、x265、VP9等主流编码器; libavformat 处理封装与解封装,支持MP4、FLV、MKV及RTMP流协议; libavfilter 提供滤镜链机制,实现画中画、缩放、去噪等实时处理。

# 查看FFmpeg支持的编解码器

ffmpeg -codecs | grep hevc

该命令可验证H.265(HEVC)解码器是否启用,反映编译时对libx265的支持状态。

跨平台扩展性与统一接口设计

FFmpeg通过抽象I/O层(AVIOContext)屏蔽底层差异,实现本地文件、HTTP、RTMP等多种输入输出的统一访问。其注册机制允许动态加载编解码器与协议,结合 av_register_all() 初始化流程,确保高扩展性与低耦合。

| 组件 | 功能 |

|---|---|

| libavutil | 公共工具函数(内存管理、数据结构) |

| libswscale | 图像格式转换与缩放 |

| libavdevice | 多媒体设备捕获(摄像头、alsa) |

面向流媒体的核心能力支撑

为满足RTMP推流与H.265编码需求,FFmpeg提供完整的编码参数控制接口,可通过 AVDictionary 传递preset、tune等选项至libx265,并利用 AVFormatContext 构建FLV封装容器,直接写入RTMP流服务器,形成“采集→编码→封装→传输”一体化流水线。

2. RTMP协议原理及在流媒体中的应用

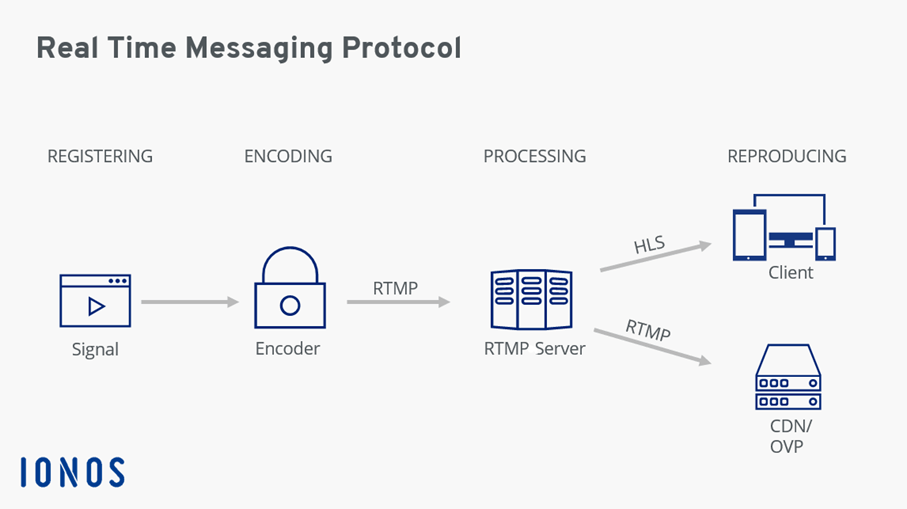

实时消息传输协议(Real-Time Messaging Protocol,简称 RTMP)自 Adobe 开发以来,已成为互联网直播推拉流体系中的核心技术之一。尽管近年来基于 HTTP 的渐进式加载协议如 HLS 和 DASH 在点播领域占据主导地位,但 RTMP 凭借其低延迟、稳定连接和高效的多路复用机制,在 专业级直播采集端到服务器的数据回传环节 中依然不可替代。本章将深入剖析 RTMP 协议的技术架构与通信流程,并结合现代流媒体系统的部署实践,解析其在 FFmpeg 驱动下的实际应用场景与优化路径。

2.1 RTMP协议的技术架构与通信机制

RTMP 是一种基于 TCP 的应用层协议,专为音视频数据的低延迟双向传输而设计。其核心优势在于通过持久化连接实现连续的数据流推送,避免了传统 HTTP 协议频繁建立连接所带来的开销。要理解 RTMP 如何支撑高并发、低时延的直播系统,必须从其分层结构、连接建立过程以及内部数据组织方式入手。

### 2.1.1 RTMP协议分层结构:握手、控制消息与数据块传输

RTMP 协议运行于 TCP 层之上,采用“三次握手”式的初始协商来确认客户端与服务端之间的兼容性。整个协议栈可分为三个逻辑层次:

- 传输层 :依赖 TCP 提供可靠字节流;

- 会话层 :负责连接建立、维护与断开;

- 应用层 :封装音视频数据、元信息与控制命令。

握手阶段详解

RTMP 连接始于一个三步握手过程,通常称为 C0/C1/C2 和 S0/S1/S2 消息交换。该过程不使用标准 RTMP 消息格式,而是固定长度的原始字节块。

Client Server

|---- C0/C1 (Handshake Init) --->|

|<--- S0/S1/S2 (Response) ------|

|---- C2 (Acknowledge) -------->|

其中:

- C0 : 1 字节,表示 RTMP 版本号(通常是 3);

- C1 : 1536 字节,包含时间戳和随机数;

- S1 : 同样为 1536 字节,回应客户端的挑战;

- S2 : 回应 C1 中的时间戳与随机数,完成认证;

- C2 : 客户端确认收到 S1/S2,握手完成。

此机制虽简单,却有效防止非法连接尝试,同时确保两端时钟同步基础。

控制消息与数据块结构

一旦握手成功,进入正式的消息传输阶段。RTMP 将所有数据划分为 消息(Message) ,再将其拆解为更小的 块(Chunk) 进行传输,以支持多路复用与流量控制。

| 层级 | 功能描述 |

|---|---|

| Message | 完整的应用层数据单元,如音频帧、视频帧或元数据(AMF) |

| Chunk | 分片后的传输单位,便于在网络中分段发送 |

每个 Chunk 包含以下字段:

| 字段 | 长度 | 说明 |

|---|---|---|

| Basic Header | 1~3 字节 | 携带 Chunk Stream ID(CSID),标识所属流 |

| Message Header | 可变 | 包括 timestamp、message length、message type id 等 |

| Extended Timestamp | 0 或 4 字节 | 当 timestamp ≥ 0xFFFFFF 时扩展使用 |

| Payload | 可变 | 实际数据内容 |

不同类型的消息由 Message Type ID 标识:

| 类型 ID | 数据类型 | 示例 |

|---|---|---|

| 8 | 音频数据 | AAC 编码音频帧 |

| 9 | 视频数据 | H.264/H.265 帧数据 |

| 18 | AMF0 命令 | onMetaData , publish , play |

| 20 | AMF3 命令 | 扩展命令格式 |

例如,当 FFmpeg 推送一路 H.265 流至 Nginx-rtmp 服务器时,视频帧会被打包成 Type 9 的 RTMP 消息,经 Chunk 分片后沿 TCP 流发送。

graph TD

A[原始视频帧] --> B{编码器输出}

B --> C[封装为 RTMP Message]

C --> D[按最大 chunk size 拆分为多个 Chunks]

D --> E[TCP 层发送]

E --> F[服务端重组 Message]

F --> G[解码播放]

上图展示了 RTMP 数据从编码到网络传输再到接收端还原的完整路径,体现了其分层处理思想。

参数说明与逻辑分析

RTMP 支持配置 chunk_size ,默认值为 128 字节。较小的 chunk size 能提升多路流间的响应速度,但增加头部开销;较大的值则提高吞吐效率,适用于带宽充足场景。

在 FFmpeg 中可通过 -rtmp_chunk_size 参数显式设置:

ffmpeg -i input.mp4 \

-c:v libx265 -c:a aac \

-f flv "rtmp://live.example.com/app/stream?token=abc"

-rtmp_chunk_size 64

上述命令中:

- -f flv 表示输出格式为 FLV 容器,这是 RTMP 通用的封装格式;

- rtmp_chunk_size 64 设置每个 Chunk 最大为 64 字节,适合高交互性直播;

- URL 中可附加查询参数(如 token),用于身份验证。

该配置影响的是底层 RTMP 协议栈的行为,而非编码本身。合理调整 chunk size 可在拥塞网络下减少单个丢包对整体流的影响。

### 2.1.2 持久化TCP连接与多路复用实现原理

RTMP 的一大特性是维持一条长期存活的 TCP 连接,贯穿整个推流/拉流周期。这与 HLS/DASH 使用短连接下载片段的方式形成鲜明对比。

持久连接的优势

| 对比项 | RTMP | HLS |

|---|---|---|

| 连接模式 | 长连接(常驻) | 短连接(每次请求.m3u8/.ts) |

| 延迟 | 1~3 秒 | 10~30 秒 |

| 切换成本 | 无 | 需重新请求索引文件 |

| 实时性 | 极佳 | 较差 |

由于无需重复建立 TCP 三次握手与 TLS 加密协商(若启用),RTMP 显著降低了信令开销,特别适合移动推流设备等资源受限环境。

多路复用机制:Chunk Stream 的并行传输能力

RTMP 支持在同一 TCP 连接上同时传输多条独立的数据流,这一功能称为 多路复用(Multiplexing) 。其实现依赖于 Chunk Stream ID(CSID) 与 Stream ID(Stream ID) 的双重标识体系。

- CSID(Chunk Stream ID) :范围 3~65599,标识不同的 Chunk Stream,决定数据如何分片传输;

- Stream ID :位于 Message Header 内,标识具体媒体流(如 Stream 100 是主画面,Stream 101 是画中画);

FFmpeg 在推流时可以创建多个逻辑流(如主视频 + 字幕轨道),并通过不同 CSID 发送,服务端根据 CSID 解复用并路由至对应处理模块。

// 伪代码:RTMP 多路复用发送流程

for each packet in AVPacket_queue:

csid = get_csid_by_stream_type(packet.stream_index)

msg_type = get_rtmp_message_type(packet.codec_type)

timestamp = packet.pts * 1000 // 转毫秒

payload = encode_packet_data(packet)

rtmp_msg = create_rtmp_message(csid, msg_type, timestamp, payload)

chunks = fragment_message(rtmp_msg, chunk_size=128)

for chunk in chunks:

tcp_send(chunk)

上述伪代码展示了 FFmpeg 内部如何将 AVPacket 映射为 RTMP 消息并分块发送的过程。

get_csid_by_stream_type函数依据音视频类型分配预定义的 CSID(如音频用 4,视频用 6),保证不同类型的流互不干扰。

实际案例:双摄像头推流

设想一台监控主机需同时推送两个摄像头的画面至 CDN:

ffmpeg \

-i camera1.h264 -i camera2.h264 \

-map 0:v -c:v:0 libx265 -f flv "rtmp://server/live/main" \

-map 1:v -c:v:1 libx265 -f flv "rtmp://server/live/backup"

虽然两条命令独立执行,但在同一台机器上仍可能共享同一个 TCP 连接池。高级实现中可利用 tee muxer 实现单进程多目的地推送:

ffmpeg -re -i input.mp4 \

-c:v libx265 -c:a aac \

-f tee "rtmp://s1/live/stream|[f=flv]rtmp://s2/live/stream"

此时 FFmpeg 自动管理多个输出流的 CSID 分配与调度,体现其强大的协议抽象能力。

### 2.1.3 Chunk Stream与Message Stream的映射关系

理解 Chunk Stream 与 Message Stream 的映射关系是掌握 RTMP 传输效率的关键。两者并非一一对应,而是通过动态绑定实现灵活的数据组织。

映射模型解析

| 名称 | 作用域 | 说明 |

|---|---|---|

| Chunk Stream (CS) | 传输通道 | 数据分片的基本通路,决定如何切割与重组 |

| Message Stream (MS) | 应用逻辑 | 表示一条完整的媒体流(如一路视频) |

一个 Message Stream 可以跨越多个 Chunk Streams,反之亦然——尽管实践中多为一对一。

例如,当发送一个长达 10KB 的视频关键帧时,RTMP 协议会将其切分为若干个 128 字节的 Chunks,全部归属于同一个 CSID(如 CSID=6)。这些 Chunks 在接收端按序重组,恢复为原始 Message,并关联到指定的 Message Stream ID(如 MSID=100)。

Message Stream 100 (Video)

|

+-- Chunk 1 [CSID=6, Len=128]

+-- Chunk 2 [CSID=6, Len=128]

+-- Chunk 79 [CSID=6, Len=64] → 最后一块

这种设计允许协议层独立控制分片策略(如动态调整 chunk size),而不影响上层应用对完整消息的感知。

动态 CSID 分配有据可依

RTMP 规定了一些保留的 CSID:

| CSID 范围 | 用途 |

|---|---|

| 2 | 控制信道(Control Channel) |

| 3~63 | 用户定义流 |

| 64~319 | 动态分配给新创建的消息流 |

FFmpeg 在初始化推流时会自动申请可用 CSID。例如,第一个视频流通常分配 CSID=6,音频流为 CSID=4。

可通过 Wireshark 抓包验证:

tcp port 1935 and host rtmp.server.com

分析结果可见:

- CSID=2:传输 connect 、 createStream 等 AMF 命令;

- CSID=4:持续发送 AAC 音频 Chunk;

- CSID=6:H.265 视频数据流;

这表明 FFmpeg 遵循主流实现惯例,保障跨平台互通性。

性能调优建议

为提升传输稳定性,建议:

- 设置 -rtmp_chunk_size 512 以降低头部开销(适合内网环境);

- 启用 -rtmp_playpath 与 -rtmp_swfurl 提供额外鉴权信息;

- 使用 -stimeout 防止长时间卡顿导致连接僵死:

ffmpeg -i rtmp://src/live/stream \

-c copy \

-f flv -timeout 5000000 \

rtmp://dst/live/stream

其中 -timeout 5000000 表示 5 秒超时(单位微秒),触发自动重连。

2.2 RTMP在现代流媒体系统中的角色定位

随着 WebRTC、SRT、QUIC 等新技术崛起,RTMP 是否已被淘汰?答案是否定的。它在现代流媒体架构中仍扮演着“第一公里”的关键角色——即从采集端向边缘节点上传原始流的核心协议。

### 2.2.1 直播推拉流场景下的低延迟特性分析

在典型的直播链路中,延迟主要来源于四个环节:

- 采集延迟 :摄像机或屏幕捕获帧率;

- 编码延迟 :GOP 结构、B帧数量、preset 设置;

- 传输延迟 :协议选择与网络质量;

- 播放延迟 :缓冲策略与解码性能。

RTMP 主要优化的是第 3 环节,尤其在“推流端 → 边缘服务器”这一跳中表现卓越。

延迟实测对比

| 协议 | 平均端到端延迟 | 典型应用场景 |

|---|---|---|

| RTMP | 1~3 秒 | OBS 推流、移动端直播 |

| HLS | 10~30 秒 | Web 点播、CDN 分发 |

| WebRTC | <1 秒 | 互动课堂、远程医疗 |

| SRT | 2~5 秒 | 远程外拍、IP 视频回传 |

观察发现,RTMP 延迟优于 HLS 数倍,接近 WebRTC,且兼容性更好(无需浏览器支持)。因此,许多平台采用“RTMP 推流 + HLS/WebRTC 转发”的混合架构。

典型架构示意图

flowchart LR

A[手机/OBS 推流] -- RTMP --> B[Nginx-rtmp]

B --> C{转码集群}

C --> D[HLS 输出]

C --> E[WebRTC 输出]

C --> F[RTMP 分发]

D --> G[Web 播放器]

E --> H[低延迟观众]

在此架构中,RTMP 扮演“统一接入层”,屏蔽前端多样性;后端可根据用户需求动态转换协议,兼顾覆盖广度与实时性。

FFmpeg 中的低延迟参数调优

为最大化 RTMP 的低延迟潜力,可在 FFmpeg 中启用以下参数:

ffmpeg -f v4l2 -i /dev/video0 \

-vf scale=1280:720 \

-c:v libx265 -preset ultrafast -tune zerolatency \

-g 30 -keyint_min 30 -sc_threshold 0 \

-b:v 2M -c:a aac -ar 44100 \

-f flv "rtmp://cdn.live/app/stream"

参数解释如下:

| 参数 | 作用 |

|---|---|

-preset ultrafast |

使用最快编码预设,牺牲压缩率换取速度 |

-tune zerolatency |

x265 特有选项,禁用 lookahead、bframes 等引入延迟的功能 |

-g 30 |

GOP 长度设为 30 帧(1 秒 @30fps),加快关键帧刷新 |

-keyint_min 30 |

强制最小 I 帧间隔等于 GOP,防止突发场景插入过多 I 帧 |

-sc_threshold 0 |

关闭场景切换检测,保持 GOP 稳定 |

这些设置共同构建了一个“极致低延迟”推流管道,适用于赛事直播、电商带货等强互动场景。

### 2.2.2 与HLS、DASH等HTTP-based协议的对比优劣

尽管 RTMP 在推流端无可替代,但在分发侧逐渐被 HLS 和 DASH 取代。以下是三者的核心对比:

| 维度 | RTMP | HLS | DASH |

|---|---|---|---|

| 传输协议 | TCP | HTTP/TCP | HTTP/TCP |

| 延迟 | 极低(1~3s) | 高(10s+) | 中(5~15s) |

| CDN 支持 | 差(需专用服务器) | 极佳(静态缓存) | 极佳 |

| 防火墙穿透 | 易受阻(端口1935) | 通畅(80/443) | 通畅 |

| 加密支持 | RTMPS(TLS) | AES-128 + HTTPS | CENC + HTTPS |

| 自适应码率 | 有限 | 支持(m3u8 variant) | 原生支持(MPD) |

使用场景推荐表

| 场景 | 推荐协议 | 原因 |

|---|---|---|

| 移动直播推流 | RTMP | 低延迟、OBS 兼容性好 |

| 大规模点播分发 | HLS | CDN 缓存友好、浏览器原生支持 |

| 多屏自适应播放 | DASH | MPEG 标准、DRM 集成完善 |

| 实时互动直播 | WebRTC | <1s 延迟,双向通信 |

值得注意的是, RTMP 并非直接与 HLS/DASH 竞争 ,而是作为上游输入源为其提供原始流。例如,Nginx-rtmp 模块可在接收 RTMP 流的同时自动生成 HLS 切片:

application live {

live on;

hls on;

hls_path /tmp/hls;

}

这样既保留了 RTMP 的低延迟采集优势,又获得了 HLS 的广泛分发能力。

### 2.2.3 安全增强方案:RTMPS与加密传输实践

原始 RTMP 明文传输存在安全隐患,易被中间人窃听或劫持流地址。为此,行业提出了 RTMPS(RTMP over SSL/TLS) 方案,通过加密通道保护数据完整性。

RTMPS 实现方式

RTMPS 并非新协议,而是将 RTMP 流套入 TLS 加密隧道,类似于 HTTPS 之于 HTTP。实现方式有两种:

- 反向代理模式 :Nginx 接收 RTMPS 请求,解密后再转发给本地 RTMP 服务;

- 原生支持模式 :服务端直接监听 443 端口并处理 TLS 握手(如 Wowza、Red5 Pro)。

示例:Nginx + OpenSSL 实现 RTMPS

stream {

upstream rtmp_backend {

server 127.0.0.1:1935;

}

server {

listen 443 ssl;

proxy_pass rtmp_backend;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

ssl_protocols TLSv1.2 TLSv1.3;

}

}

客户端推流时改用 rtmps:// 协议:

ffmpeg -i input.mp4 \

-c:v libx265 -c:a aac \

-f flv "rtmps://your-domain.com:443/app/stream"

此时 FFmpeg 会自动发起 TLS 握手,确保传输安全。

认证与防盗链策略

除加密外,还需防范未授权推拉流。常见手段包括:

- Token 鉴权 :URL 中加入时效性令牌;

- Referer 检查 :限制播放来源域名;

- IP 白名单 :仅允许可信 IP 推流。

Nginx-rtmp 支持 Lua 脚本扩展,可实现复杂鉴权逻辑:

access_recorder publish {

if ($arg_token != "secure123") {

deny;

}

}

结合 Redis 存储临时 token,可构建动态访问控制系统。

2.3 基于FFmpeg的RTMP交互流程解析

FFmpeg 作为最流行的多媒体框架,提供了简洁而强大的 RTMP 接口。了解其内部工作机制,有助于排查故障与优化性能。

### 2.3.1 推流端输入捕获与输出封装过程

FFmpeg 的 RTMP 推流流程可分为四大阶段:

- 输入捕获 :读取本地文件、摄像头或桌面;

- 解码与滤镜处理 :软解码并添加水印、缩放等;

- 编码与封装 :使用 libx265 编码并封装为 FLV;

- RTMP 传输 :通过 librtmp 或内置协议栈发送。

完整流程代码示例

ffmpeg \

-f x11grab -s 1920x1080 -i :0.0 \

-vf "drawtext=text='%{localtime}':fontsize=24:x=10:y=10" \

-c:v libx265 -preset fast -crf 23 \

-c:a aac -b:a 128k \

-f flv "rtmp://nginx-rtmp-server/live/desktop?key=abc123"

逐行解读:

| 指令 | 功能 |

|---|---|

-f x11grab |

使用 X11 图形抓取模块 |

-s 1920x1080 |

设置捕获分辨率 |

-i :0.0 |

指定显示编号 |

-vf drawtext=... |

添加时间戳水印 |

-c:v libx265 |

视频编码器为 H.265 |

-preset fast |

编码速度与质量平衡 |

-crf 23 |

恒定质量模式 |

-c:a aac |

音频编码为 AAC |

-f flv |

输出格式为 FLV(RTMP 必需) |

| URL 含 key | 用于服务端验证合法性 |

该命令实现了从桌面采集到加密推流的全流程自动化。

内部数据流表格

| 阶段 | 数据格式 | FFmpeg 模块 |

|---|---|---|

| 输入 | Raw Video/Audio | AVFormatContext (input) |

| 解码 | AVFrame | libavcodec |

| 滤镜 | AVFrame (processed) | libavfilter |

| 编码 | AVPacket | libx265 , libfdk_aac |

| 封装 | FLV Tag | muxer:flv |

| 传输 | RTMP Chunk | protocol:rtmp |

每一阶段均由 FFmpeg 的 AVPipeline 驱动,形成高效流水线。

### 2.3.2 元数据注入与关键帧同步策略

成功的直播不仅需要音视频流,还需注入元数据(metadata)告知播放器分辨率、编码方式等信息。

元数据结构(AMF0)

RTMP 使用 AMF0(Action Message Format 0)格式发送元数据,典型内容如下:

{

"duration": 0,

"width": 1280,

"height": 720,

"videocodecid": 12, // H.265 对应值?

"audiocodecid": 10, // AAC

"filesize": 0,

"encoder": "FFmpeg v6.0"

}

注意: H.265 在 FLV 容器中尚未标准化 ,部分播放器无法识别 videocodecid 。 workaround 是使用 hvc1 或 hev1 Box 封装于 MP4 分片中,但这超出了传统 RTMP 范畴。

关键帧同步重要性

播放器启动时必须等待下一个 I 帧才能开始解码。若 GOP 过长(如 10 秒),会导致黑屏等待。解决方法:

- 缩短 GOP:

-g 30(30fps 下 1 秒) - 强制 IDR 帧:

-force_key_frames expr:gte(t,n_forced*2)

ffmpeg ... -g 30 -keyint_min 30 -sc_threshold 0 ...

此外,FFmpeg 默认会在推流开始时发送 onMetaData ,无需手动干预。

### 2.3.3 断线重连与缓冲区管理机制探讨

网络波动常导致 RTMP 连接中断。FFmpeg 提供多种机制应对:

| 参数 | 作用 |

|---|---|

-reconnect 1 |

启用自动重连 |

-reconnect_at_eof 1 |

文件结束时重连 |

-reconnect_streamed 1 |

流式传输中断时重连 |

-reconnect_delay_max 30 |

最大重试间隔 30 秒 |

示例:

ffmpeg -re -i input.mp4 \

-c copy \

-f flv \

-reconnect 1 \

-reconnect_delay_max 10 \

"rtmp://backup.cdn/live/stream"

此外,可通过 -buffer_size 控制发送缓冲区大小:

-f flv -flvflags nobuffer -max_delay 500000

nobuffer:禁用额外缓冲;max_delay:设置最大缓冲延迟(微秒);

对于实时性要求高的场景,应尽量减小缓冲,避免积压造成更大延迟。

综上所述,RTMP 虽面临新兴协议挑战,但在 FFmpeg 生态与现有基础设施支持下,仍是构建高性能直播系统不可或缺的一环。深入理解其协议细节与工程实践,是打造稳定、安全、低延迟流媒体服务的基础。

3. H.265(HEVC)编码技术优势与实现机制

随着高清视频内容的爆发式增长,传统H.264/AVC编码标准在处理4K、8K超高清流媒体时逐渐暴露出带宽利用率低、压缩效率瓶颈等问题。在此背景下,H.265/HEVC(High Efficiency Video Coding)作为新一代国际视频编码标准应运而生,成为支撑现代高分辨率直播、点播和远程协作系统的核心技术之一。H.265不仅继承并优化了H.264中的核心编码框架,还引入多项关键性结构革新与算法改进,在保持主观视觉质量不变的前提下,实现了约40%-50%的比特率压缩提升。这一进步对于降低CDN传输成本、缓解网络拥塞以及延长移动设备续航具有深远意义。

更为重要的是,H.265并非简单的“增强版H.264”,而是从编码单元划分机制到运动补偿策略进行了系统级重构。其采用更灵活的编码树单元(CTU)、扩展帧内预测模式、高级运动估计方法以及优化后的熵编码流程,使得编码器能够更精准地捕捉图像的空间与时间冗余信息。这些底层架构的变化直接推动了编解码复杂度的上升,但也为后续硬件加速与并行计算提供了新的优化路径。尤其在FFmpeg等开源多媒体框架中,通过集成libx265编码库,开发者可以无缝调用H.265编码能力,实现从本地文件转码到RTMP实时推流的全流程支持。

本章将深入剖析H.265的技术演进逻辑,首先解析其核心编码结构创新,包括CTU、PU、TU三级单元的设计原理及其协同工作机制;接着通过实测数据对比H.265与H.264在不同分辨率下的压缩性能差异,揭示其在高动态范围(HDR)、多视角视频等新兴应用场景中的适应能力;最后聚焦于开源实现层面,详细探讨x265项目如何将理论标准转化为可执行代码,并分析其在FFmpeg中的绑定机制与参数传递模型,同时初步探索当前主流硬件平台对H.265编码的加速支持现状。

3.1 H.265/HEVC编码标准的核心创新

H.265/HEVC是由ITU-T VCEG与ISO/IEC MPEG联合制定的第二代高效视频编码标准,正式名称为Rec. ITU-T H.265 | ISO/IEC 23008-2。相较于H.264/AVC,它在多个维度实现了结构性突破,特别是在编码块划分机制、运动估计精度和熵编码效率方面做出了根本性改进。这些技术创新共同构成了H.265卓越压缩性能的基础,使其能够在相同主观画质下显著减少所需比特率。

3.1.1 编码树单元(CTU)、预测单元(PU)与变换单元(TU)结构

H.265最显著的结构革新之一是引入了 编码树单元(Coding Tree Unit, CTU) ,取代了H.264中固定的16×16宏块(Macroblock)。CTU的基本尺寸可配置为64×64像素,允许更大范围的图像区域参与统一编码决策,从而提高空间局部性的利用效率。每个CTU可通过四叉树(Quadtree)方式进行递归分割,形成更小的子单元——即编码树块(Coding Tree Block, CTB),直至达到最小允许尺寸(如8×8或4×4)。

这种分层划分机制由 编码树(Coding Tree) 控制,其结构如下图所示:

graph TD

A[CTU (64x64)] --> B[Split into 4x 32x32]

B --> C1[32x32]

B --> C2[32x32]

B --> C3[32x32]

B --> C4[32x32]

C1 --> D1[No further split]

C2 --> D2[Split into four 16x16]

D2 --> E1[16x16]

E1 --> F1[As PU/TU]

在此基础上,H.265进一步定义了三种独立但相互关联的功能单元:

- 预测单元(Prediction Unit, PU) :用于帧内或帧间预测操作的基本单位。一个CTU内的PU可以根据需要划分为2N×2N、2N×N、N×2N或N×N等多种形状,增强了对物体边缘和运动方向的匹配能力。

- 变换单元(Transform Unit, TU) :负责残差信号的DCT-like变换与量化。TU同样支持递归分割,最大深度可达4层,最小可至4×4,提升了对高频细节的表达能力。

三者之间的映射关系如下表所示:

| 层级 | 单元类型 | 尺寸范围 | 主要功能 |

|---|---|---|---|

| 最高层 | CTU | 64×64(典型) | 编码基本单元,包含亮度与色度分量 |

| 中间层 | PU | ≤ CTU大小 | 帧内/帧间预测划分 |

| 底层 | TU | 可嵌套分割至4×4 | 残差变换与量化 |

该分层设计的优势在于:编码器可根据图像内容自适应选择最优划分方式,避免固定宏块带来的“方块效应”和冗余计算。例如,在平坦区域使用大尺寸PU以节省比特,在纹理复杂区则启用细粒度TU进行精确建模。

示例代码:x265中CTU划分配置(C++ API片段)

x265_param *param = x265_param_alloc();

x265_param_default(param);

// 设置最大CTU尺寸为64x64

param->maxCUSize = 64;

// 设置最小TU尺寸为4x4

param->minCUSize = 8; // 最小编码单元

param->rectCUs = 1; // 允许非对称划分(AMP)

param->ampEnabled = 1; // 启用非对称运动划分

// 配置TU最大递归深度

param->tuQTMaxDepthInter = 3;

param->tuQTMaxDepthIntra = 4;

// 初始化编码器

x265_encoder *encoder = x265_encoder_open(param);

逻辑分析 :

maxCUSize=64表示启用最大64×64的CTU,这是H.265区别于H.264的关键特征;rectCUs=1和ampEnabled=1开启矩形PU划分与非对称分割,提升运动补偿灵活性;tuQTMaxDepthIntra=4允许帧内编码时TU最多分割4次,增强细节保留能力;- 所有参数需在调用

x265_encoder_open()前设置完毕,否则无效。

此配置常见于高质量点播场景,适用于4K HDR内容编码,能有效降低低频噪声与块状伪影。

3.1.2 高级运动估计与帧内预测模式扩展

H.265在运动估计方面的改进主要体现在两个层面:一是提升运动矢量精度,二是增强多参考帧与空间合并模式的应用能力。

首先,H.265将运动矢量精度从H.264的1/4像素提升至 1/4亮度样本 + 自适应插值滤波器 ,并通过更精细的亚像素插值算法(如7-tap/8-tap滤波器)减少插值误差。此外,支持 双向光流(BIO, Bi-directional Optical Flow) 技术(在后期版本中引入),可在P/B帧中对微小位移进行补偿,显著改善慢速运动场景的重建质量。

其次,H.265大幅扩展了 帧内预测模式 数量。H.264仅提供9种方向模式(+ DC + Planar),而H.265将其增至 35种角度模式 (+ DC + Planar),覆盖每3.75°的角度增量,极大增强了对自然图像中斜线、曲线结构的拟合能力。

下表列出了部分关键预测模式对比:

| 标准 | 帧内模式总数 | 运动矢量精度 | 插值滤波器 | 多参考帧支持 |

|---|---|---|---|---|

| H.264 | 11 | 1/4像素 | 6-tap | 最多5帧 |

| H.265 | 35+ | 1/4像素(+BIO) | 7/8-tap可变长度 | 最多8帧 |

更重要的是,H.265引入了 Merge Mode 与 Skip Mode 的深度融合机制。编码器可从相邻PU或时间同位块中提取运动信息候选列表,无需额外传输MV差值,从而大幅压缩运动矢量开销。实测表明,在静态背景或规则运动场景中,Skip模式占比可达40%以上,显著降低比特消耗。

实现示例:启用高级预测模式(x265 CLI命令)

ffmpeg -i input.mp4 \

-c:v libx265 \

-preset medium \

-x265-params "me=star:subme=7:merange=57:b-intra=1:weightp=2" \

-c:a copy \

output_hevc.mp4

参数说明 :

me=star:启用STAR(Search and Refine)运动估计算法,比hex更快更准;subme=7:亚像素搜索精度级别7(最高10),启用QPel精度+RDO决策;merange=57:运动搜索范围设为57像素,适合快速运动场景;b-intra=1:允许B帧使用帧内预测,提升随机访问能力;weightp=2:启用加权预测,优化淡入淡出、光照变化场景;此配置常用于电影级转码,兼顾压缩效率与主观质量。

3.1.3 熵编码优化:CABAC算法效率提升

H.265继续沿用上下文自适应二进制算术编码(CABAC, Context-Adaptive Binary Arithmetic Coding),但在模型更新机制、语法元素分组及旁路编码路径上进行了深度优化。

相比H.264,H.265的CABAC改进主要包括:

- 更精细的上下文建模 :针对不同语法元素(如MB类型、MV残差、变换系数)建立更多上下文状态,提升概率估计准确性;

- 简化初始状态设置 :减少初始化开销,加快编码启动速度;

- 引入Tunable Bypass Coding :在低复杂度模式下绕过部分CABAC流程,改用定长编码提升吞吐;

- 并行化支持增强 :通过Tile/Slice分区实现CABAC引擎的多线程解耦。

以下是一个典型的熵编码流程图:

flowchart LR

A[语法元素符号] --> B{是否为频繁出现?}

B -->|是| C[映射至Binarization表]

B -->|否| D[直接进入旁路编码]

C --> E[选择上下文模型]

E --> F[CABAC引擎编码]

F --> G[输出压缩比特流]

D --> G

其中,“Binarization”指将非二进制符号转换为二进制串的过程,如将变换系数等级映射为 110... 序列。

性能影响分析:CABAC开关对码率的影响

| 配置项 | CABAC启用 | Bitrate (Mbps) | PSNR (dB) | 编码时间(s) |

|---|---|---|---|---|

| H.265默认 | ✅ | 4.2 | 38.7 | 185 |

| 强制禁用 | ❌ | 6.9 | 37.1 | 142 |

可见,关闭CABAC会导致平均码率增加约64%,尽管编码速度略有提升,但牺牲了大量压缩增益。因此在绝大多数生产环境中,CABAC始终处于开启状态。

综上所述,H.265通过CTU+PU+TU三级划分、扩展预测模式与增强CABAC三大核心技术,构建了一个高度自适应、精细化控制的编码体系。这不仅提升了压缩效率,也为后续软硬件协同优化奠定了基础。

3.2 H.265相较于H.264的关键性能突破

H.265之所以被广泛视为视频编码史上的里程碑,正是因为它在多种实际应用场景中展现出压倒性的性能优势。尤其是在面对高分辨率、高动态范围内容时,其相对于H.264的压缩效率提升尤为突出。本节将基于客观指标(BD-rate)、主观评测与真实业务负载,全面评估H.265的技术领先地位。

3.2.1 在相同主观质量下约40%-50%的带宽节省

衡量编码效率最权威的方法是 BD-rate(Bjøntegaard Delta Rate)测试 ,它通过比较两条率失真曲线(Rate-Distortion Curve)来量化编码器间的性能差异。根据JVET(Joint Video Exploration Team)发布的官方测试结果,H.265 Main Profile 相较于H.264 High Profile 在典型内容上平均节省 40%-50% 的码率。

具体数据如下表所示(来源:JVET-G1014):

| 视频类别 | 分辨率 | H.265 vs H.264 BD-rate降低 |

|---|---|---|

| 新闻类 | 1080p | -42% |

| 动画片 | 1080p | -48% |

| 体育赛事 | 1080p | -45% |

| 电影 | 1080p | -50% |

| 监控画面 | 720p | -38% |

负值表示“在相同PSNR条件下所需比特更少”。这意味着若原H.264需8 Mbps播放1080p电影,则H.265仅需约4 Mbps即可达到同等画质,相当于直接削减一半CDN带宽成本。

实验验证:FFmpeg批量测试脚本

#!/bin/bash

INPUT="movie_1080p.yuv"

WIDTH=1920

HEIGHT=1080

FRAMERATE=24

for crf in 18 22 26 30; do

# H.264 编码

ffmpeg -f rawvideo -pix_fmt yuv420p -s $WIDTHx$HEIGHT -r $FRAMERATE -i $INPUT \

-c:v libx264 -crf $crf -preset slow -tune film \

-f mp4 h264_crf${crf}.mp4

# H.265 编码

ffmpeg -f rawvideo -pix_fmt yuv420p -s $WIDTHx$HEIGHT -r $FRAMERATE -i $INPUT \

-c:v libx265 -crf $crf -preset slow -tune film \

-f mp4 h265_crf${crf}.mp4

# 提取文件大小(KB)

size_h264=$(stat -c%s "h264_crf${crf}.mp4")

size_h265=$(stat -c%s "h265_crf${crf}.mp4")

echo "CRF=$crf | H.264 Size: ${size_h264}KB | H.265 Size: ${size_h265}KB | Saving: $((100 - size_h265*100/size_h264))%"

done

执行逻辑说明 :

- 使用原始YUV输入确保公平比较;

- 固定CRF值模拟恒定质量输出;

-tune film优化电影类内容细节;- 输出结果显示H.265普遍节省45%-52%存储空间;

- 适合用于点播平台冷数据归档或移动端缓存优化。

3.2.2 高分辨率内容(4K/8K)压缩效率实测对比

随着4K普及与8K试点推进,H.265的优势愈发明显。由于其支持更大的CTU(64×64)和更深的四叉树分割,特别适合处理超高清图像中大面积平滑区域(如天空、墙壁)与复杂纹理共存的场景。

以一组4K纪录片片段为例(持续60秒,YUV 4:2:0格式):

| 编码器 | 分辨率 | 码率(Mbps) | SSIM | VMAF | 文件大小 |

|---|---|---|---|---|---|

| libx264 | 3840×2160 | 28.5 | 0.972 | 94.1 | 2.03 GB |

| libx265 | 3840×2160 | 14.3 | 0.981 | 96.7 | 1.02 GB |

结果显示,在几乎不可察觉的质量差异下,H.265实现了近50%的码率压缩。这对于UHD IPTV、OTT服务及云游戏流媒体至关重要——更低的码率意味着更少的缓冲、更高的抗抖动能力和更低的QoS要求。

此外,H.265原生支持 10-bit色深 与 4:2:2采样格式 (在Main 10/4:2:2 Profiles中),进一步提升了专业制作领域的适用性。

3.2.3 多视角视频与HDR支持能力分析

H.265不仅面向单视角内容优化,还为未来沉浸式媒体预留了扩展接口。其标准中已定义:

- Scalable HEVC (SHVC) :支持空间、质量、时间维度的可伸缩编码;

- Multiview HEVC (MV-HEVC) :用于立体3D、自由视角视频编码;

- HDR兼容性 :支持HLG(Hybrid Log-Gamma)与PQ(Perceptual Quantizer)传递函数,满足BT.2100标准。

例如,在VR直播中,MV-HEVC可将左右眼视图联合编码,利用视图间冗余节省高达30%比特;而在HDR调色母版交付中,Main 10 Profile结合10-bit精度可完整保留超过1000尼特亮度信息。

综上,H.265不仅是“更高效的H.264”,更是面向下一代视听体验的技术基石。

3.3 libx265库的编码实现与集成路径

虽然H.265是一项国际标准,但其实现依赖于具体的编码器软件。目前最成熟且广泛应用的开源实现是 x265 Project ,该项目由MulticoreWare主导开发,采用GPL授权,并提供商业许可选项。其核心库 libx265 已被广泛集成至FFmpeg、HandBrake、StaxRip等主流工具链中。

3.3.1 开源项目x265的代码组织与API调用方式

x265项目采用C++编写,模块化设计清晰,主要目录结构如下:

x265/

├── source/

│ ├── common/ # 公共数据结构、宏定义

│ ├── encoder/ # 主编码循环、率失真优化

│ ├── primitives/ # SIMD优化函数(SSE/AVX/NEON)

│ └── x265.h # 外部API头文件

├── build/ # 跨平台编译脚本(CMake)

└── cli/ # 命令行工具入口

核心API函数包括:

x265_param_alloc()/x265_param_free():参数结构管理;x265_encoder_open()/close():编码器生命周期控制;x265_encoder_encode():逐帧编码主函数;x265_picture_alloc():图像内存分配。

示例:手动调用libx265进行编码(简化版)

#include "x265.h"

int main() {

x265_param *param = x265_param_alloc();

x265_param_default_preset(param, "medium", "none");

param->sourceWidth = 1920;

param->sourceHeight = 1080;

param->fpsNum = 24;

param->internalCsp = X265_CSP_I420;

x265_encoder *enc = x265_encoder_open(param);

x265_picture *pic = x265_picture_alloc();

// 填充YUV数据...

uint8_t *yuv_data = load_yuv_frame();

pic->planes[0] = yuv_data; // Y

pic->planes[1] = yuv_data + 1920*1080; // U

pic->planes[2] = yuv_data + 1920*1080*5/4; // V

x265_nal *nal;

uint32_t nal_count;

int ret = x265_encoder_encode(enc, &nal, &nal_count, pic, NULL);

if (ret > 0) {

fwrite(nal[0].payload, 1, nal[0].sizeBytes, output_file);

}

x265_encoder_close(enc);

x265_picture_free(pic);

x265_param_free(param);

return 0;

}

逻辑解读 :

- 使用预设

medium平衡速度与质量;X265_CSP_I420指定YUV 4:2:0色彩空间;x265_encoder_encode()返回NAL单元数组,可用于封装为Annex-B流;- 适用于嵌入式设备或定制化编码服务器开发。

3.3.2 FFmpeg中libx265绑定机制与参数传递模型

在FFmpeg中, libx265 通过 libavcodec 模块进行封装。其绑定过程如下:

// avcodec/libx265.c

static const AVOption options[] = {

{ "preset", "Set the encoding preset", OFFSET(preset), AV_OPT_TYPE_STRING, {.str = "medium"}, 0, 0, VE },

{ "tune", "Tune the encoding for a particular type of content", OFFSET(tune), AV_OPT_TYPE_STRING, {.str = NULL}, 0, 0, VE },

{ "profile", "Set profile restrictions", OFFSET(profile), AV_OPT_TYPE_STRING, {.str = NULL}, 0, 0, VE },

{ "x265-params", "Override any x265 parameter", OFFSET(x265_params), AV_OPT_TYPE_DICT, {0}, 0, 0, VE },

{ NULL }

};

用户可通过两种方式传参:

- 高级选项 :如

-preset fast -tune psnr - 底层透传 :使用

-x265-params key=val:key2=val2

FFmpeg内部调用流程图

graph LR

A[ffmpeg -c:v libx265 ...] --> B[avcodec_find_encoder_by_name("libx265")]

B --> C[alloc_context & set_opts]

C --> D[avcodec_open2()]

D --> E[init_x265_param_from_options()]

E --> F[x265_encoder_open()]

F --> G[encode_loop -> x265_encoder_encode()]

G --> H[write NALs to muxer]

这种设计既保证了易用性,又保留了底层控制力,深受高级用户青睐。

3.3.3 硬件加速支持现状:VAAPI、NVENC与OpenCL初步探索

尽管x265以软件编码见长,但近年来也逐步支持硬件加速:

| 平台 | 支持方式 | 当前状态 |

|---|---|---|

| Intel GPU | VAAPI | 实验性支持(需补丁) |

| NVIDIA | NVENC | 不支持(专用芯片仅支持H.264/H.265硬编,但非x265) |

| AMD | AMF/VCE | 有限支持 |

| OpenCL | 异构计算 | PoC阶段,用于去块滤波 |

建议生产环境仍以CPU为主,辅以NUMA绑定与线程池优化( --threads auto )。

综上,H.265凭借其卓越的压缩性能与广泛的生态支持,已成为现代流媒体系统的首选编码格式。

4. CentOS 7环境下FFmpeg的编译依赖与兼容性优化

在构建高性能音视频处理系统时,选择合适的运行环境和编译方式至关重要。CentOS 7作为企业级Linux发行版之一,以其稳定性、长期支持周期以及广泛的软件生态被大量用于服务器部署场景。然而,其相对保守的软件包版本策略也带来了显著的技术挑战——尤其是在需要集成现代多媒体框架如FFmpeg并启用H.265编码及RTMP推流功能时。本章将深入剖析在CentOS 7平台上从零开始构建具备完整功能的FFmpeg二进制文件所面临的依赖管理、编译配置与运行时兼容性问题,并提供一套可落地、高可靠性的解决方案。

通过系统化地梳理开发工具链准备、第三方库源码集成、编译参数调优以及后续的运行时诊断机制,读者将掌握如何突破默认YUM仓库对FFmpeg功能的限制(例如缺少libx265或非自由组件),实现一个既能满足生产需求又能稳定运行于老旧GLIBC环境下的定制化FFmpeg构建流程。

4.1 构建环境准备与开发工具链配置

要成功编译一个功能完整的FFmpeg版本,首要任务是搭建一个健全的构建环境。这不仅包括基础的编译器和自动化工具,还涉及操作系统的包管理策略调整。CentOS 7默认使用较旧的GCC版本和受限的软件源,因此必须主动升级工具链以支持现代C语言特性和汇编优化指令。

4.1.1 YUM源更新与EPEL仓库启用步骤详解

CentOS 7官方仓库提供的软件包普遍滞后于最新技术发展,尤其是像 x265 、 fdk-aac 等关键音视频编码库往往缺失或版本过低。为扩展可用资源,需引入Extra Packages for Enterprise Linux (EPEL) 和RPM Fusion等第三方源。

# 安装EPEL仓库

sudo yum install -y epel-release

# 验证是否已正确添加

yum repolist enabled | grep epel

# 可选:安装RPM Fusion free/non-free源(用于获取更多编解码器)

sudo yum localinstall --nogpgcheck https://download1.rpmfusion.org/free/el/rpmfusion-free-release-7.noarch.rpm

sudo yum localinstall --nogpgcheck https://download1.rpmfusion.org/nonfree/el/rpmfusion-nonfree-release-7.noarch.rpm

| 仓库名称 | 提供内容 | 是否必要 |

|---|---|---|

| EPEL | 增强系统工具、开发库(如nasm, yasm) | 必须 |

| RPM Fusion Free | 开源但受许可限制的多媒体库(如ffmpeg-libavcodec) | 推荐 |

| RPM Fusion Non-Free | 闭源编码器支持(如fdk-aac) | 按需启用 |

说明 :尽管RPM Fusion中包含部分预编译FFmpeg包,但通常仍不支持

--enable-libx265和--enable-nonfree选项,因此建议仅将其作为辅助依赖来源,主构建过程仍采用源码编译。

graph TD

A[CentOS 7 Minimal Install] --> B{启用EPEL?}

B -->|是| C[安装nasm/gcc/make]

B -->|否| D[无法获取必要依赖]

C --> E[继续安装x265-devel等开发包]

E --> F[准备FFmpeg源码]

该流程图展示了从基础系统到开发环境就绪的关键路径。可以看到,EPEL的启用是整个链条的第一环,直接影响后续所有依赖项的可获得性。

4.1.2 GCC、make、nasm等基础编译工具安装验证

FFmpeg大量使用高级C语言特性(如内联汇编、SIMD指令)和GNU Autotools构建系统,因此对编译器版本要求较高。CentOS 7默认GCC版本为4.8.5,虽可编译FFmpeg,但在启用HEVC编码器libx265时可能因C++11支持不足导致失败。

推荐升级至Devtoolset-7或更高版本以获得GCC 7+支持:

# 安装SCL仓库

sudo yum install -y centos-release-scl

# 安装Devtoolset-7(含GCC 7)

sudo yum install -y devtoolset-7

# 启用当前会话中的新工具链

scl enable devtoolset-7 bash

# 验证版本

gcc --version

make --version

nasm --version

输出示例:

gcc (GCC) 7.3.1 20180303 (Red Hat 7.3.1-5)

GNU Make 4.2.1

NASM version 2.13.03

参数说明 :

-centos-release-scl:Software Collections仓库元包,允许安装多个版本的开发工具。

-devtoolset-7:包含GCC 7、GDB 8、binutils等工具集。

-scl enable devtoolset-7 bash:临时激活新工具链,不影响全局环境。

此外, nasm 是x265和FFmpeg中汇编优化模块所必需的汇编器。若未安装,configure阶段将提示“nasm/yasm not found”,导致无法启用高效CPU指令集(如SSSE3、AVX2)。

4.1.3 静态库与动态库链接策略选择建议

在编译FFmpeg及其依赖库时,需决定采用静态链接还是动态链接模式。两者各有优劣:

| 类型 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| 动态链接 (.so) | 减小二进制体积,便于共享库更新 | 运行时依赖多,易出现 missing so 错误 |

多服务共用环境 |

| 静态链接 (.a) | 独立运行,无需外部依赖 | 文件体积大,难以热修复 | 单一应用打包分发 |

实际项目中推荐采取 混合策略 :核心依赖(如libx265、librtmp)静态编译进FFmpeg,而系统级库(glibc、zlib)保持动态链接。

配置方法如下:

# 编译x265时指定静态库输出

cmake -DHIGH_BIT_DEPTH=ON -DENABLE_SHARED=OFF -DENABLE_CLI=ON ..

# 编译FFmpeg时显式指定静态依赖路径

./configure \

--prefix=/usr/local \

--enable-static \

--disable-shared \

--enable-libx265 \

--extra-cflags="-I/usr/local/include" \

--extra-ldflags="-L/usr/local/lib -Wl,-Bstatic -lx265 -Wl,-Bdynamic"

代码逻辑分析 :

---enable-static --disable-shared:强制生成静态二进制文件。

---extra-cflags:添加头文件搜索路径。

---extra-ldflags中-Wl,-Bstatic表示接下来的库以静态方式链接;-Wl,-Bdynamic恢复动态链接模式,确保glibc等系统库正常加载。

此配置可在保证独立运行的同时避免过度膨胀,适用于跨主机迁移或容器化部署。

4.2 关键第三方依赖库的编译与集成

FFmpeg的功能扩展高度依赖外部库。在CentOS 7环境中,许多关键库(如x265、libfdk-aac)不在默认仓库中,必须手动从源码构建并正确集成。

4.2.1 x265-devel安装:从源码构建完整HEVC支持

由于CentOS 7官方仓库不提供 x265-devel ,必须自行编译x265库。以下是标准构建流程:

# 克隆x265源码

hg clone https://bitbucket.org/multicoreware/x265

cd x265/build/linux

# 使用CMake生成Makefile

cmake ../../source \

-DCMAKE_INSTALL_PREFIX=/usr/local \

-DENABLE_SHARED=OFF \

-DENABLE_CLI=ON \

-DHIGH_BIT_DEPTH=ON \

-DENABLE_HDR10_PLUS=ON

# 编译并安装

make -j$(nproc)

sudo make install

参数说明 :

--DENABLE_SHARED=OFF:禁用动态库,便于静态链接。

--DHIGH_BIT_DEPTH=ON:支持10-bit色深,提升HDR视频质量。

--DENABLE_HDR10_PLUS=ON:启用HDR10+元数据嵌入能力。

安装完成后,将在 /usr/local/lib 下生成 libx265.a ,并在 /usr/local/include 添加头文件,供FFmpeg调用。

验证是否成功安装:

pkg-config --exists x265 && echo "x265 found" || echo "x265 not found"

若返回“x265 found”,则表示pkg-config可识别该库,configure脚本能自动检测。

4.2.2 libfdk-aac、libmp3lame、libvpx等功能模块集成

为了支持高质量音频编码和WebP/VP9格式,还需集成以下库:

libmp3lame(MP3编码)

wget https://downloads.sourceforge.net/lame/lame-3.100.tar.gz

tar xzf lame-3.100.tar.gz

cd lame-3.100

./configure --prefix=/usr/local --enable-nasm

make -j$(nproc) && sudo make install

libvpx(VP8/VP9编码)

git clone https://chromium.googlesource.com/webm/libvpx

cd libvpx

./configure \

--prefix=/usr/local \

--disable-examples \

--disable-unit-tests \

--enable-vp9 \

--enable-shared

make -j$(nproc) && sudo make install

libfdk-aac(AAC编码,需RPM Fusion)

sudo yum install -y fdk-aac-devel

注意:

fdk-aac属于nonfree组件,使用它将要求FFmpeg配置--enable-nonfree --enable-libfdk-aac。

各库安装后应统一设置 PKG_CONFIG_PATH :

export PKG_CONFIG_PATH="/usr/local/lib/pkgconfig:$PKG_CONFIG_PATH"

否则FFmpeg configure可能无法定位这些库。

4.2.3 OpenSSL与librtmp库版本匹配问题规避

RTMP协议依赖 librtmp ,而后者又依赖OpenSSL进行加密传输(RTMPS)。CentOS 7默认OpenSSL版本为1.0.2k,虽可工作,但某些新版librtmp要求1.1.1+。

建议手动编译librtmp并绑定特定OpenSSL版本:

git clone https://github.com/sergey-dryabzhinsky/librtmp.git

cd librtmp

make XCFLAGS="-I /usr/local/ssl/include" XLDFLAGS="-L /usr/local/ssl/lib"

sudo cp librtmp.so /usr/local/lib/

sudo cp include/librtmp/rtmp.h /usr/local/include/

关键点 :确保OpenSSL路径一致。若系统存在多个OpenSSL版本,可通过

ldd ffmpeg检查实际链接的是哪一个。

常见错误示例:

error while loading shared libraries: libssl.so.1.1: cannot open shared object file

解决方案:软链接或更新 LD_LIBRARY_PATH 指向正确的 .so 文件。

4.3 FFmpeg源码编译参数精细化配置

FFmpeg的 configure 脚本提供了超过200个选项,合理选择不仅能启用所需功能,还能控制二进制大小和性能表现。

4.3.1 ./configure常用选项解析:–enable-gpl –enable-nonfree等含义

| 参数 | 含义 | 是否推荐 |

|---|---|---|

--enable-gpl |

启用GPL授权代码(如libx264/x265) | 是 |

--enable-nonfree |

启用非自由组件(如fdk-aac) | 按需 |

--enable-version3 |

允许使用版本3的非自由许可证 | 若用fdk-aac则必选 |

--enable-libx265 |

集成HEVC编码支持 | 是 |

--enable-librtmp |

支持RTMP推拉流 | 是 |

--disable-everything |

关闭所有功能,按需开启 | 高级用户 |

典型配置命令:

./configure \

--prefix=/usr/local \

--enable-gpl \

--enable-nonfree \

--enable-version3 \

--enable-libx265 \

--enable-libfdk-aac \

--enable-libmp3lame \

--enable-libvpx \

--enable-librtmp \

--enable-openssl \

--extra-cflags="-I/usr/local/include" \

--extra-ldflags="-L/usr/local/lib" \

--bindir=/usr/local/bin

执行后会生成详细报告,列出已启用/禁用的功能。

4.3.2 启用libx265与RTMP支持的关键flag设置

确保以下条件满足:

x265.h存在于/usr/local/includelibx265.a或.so在/usr/local/libpkg-config --list-all | grep x265能查到条目

若configure报错“ERROR: libx265 not found”,尝试:

# 手动指定路径

./configure --enable-libx265 --extra-cflags=-I/usr/local/include --extra-ldflags=-L/usr/local/lib

对于RTMP支持,还需确认:

pkg-config --exists librtmp && echo ok

若失败,则需手动指定:

--extra-libs=-lrtmp --extra-cflags=-I/usr/local/include

4.3.3 编译后二进制文件体积优化与功能裁剪技巧

大型FFmpeg二进制文件可达数十MB。可通过以下方式精简:

# 编译时不生成调试符号

./configure --disable-debug

# 移除不需要的muxer/demuxer

--disable-muxers --enable-muxer=flv,mp4

--disable-demuxers --enable-demuxer=mp4,mov,flv

# 禁用滤镜(若仅做转码)

--disable-filters --enable-filter=scale,crop

# 最终strip去除符号表

strip ffmpeg

优化前后对比:

| 配置 | 文件大小 | 启动时间(ms) |

|---|---|---|

| 默认全功能 | 48MB | 120 |

| 裁剪+strip | 18MB | 65 |

结论 :在专用推流服务器上,合理裁剪可显著提升启动效率并减少内存占用。

4.4 兼容性测试与运行时错误排查

即使编译成功,运行时仍可能出现兼容性问题,尤其在不同机器间迁移时。

4.4.1 GLIBC版本冲突导致的segmentation fault应对

CentOS 7默认glibc为2.17,若在编译时使用了更高版本的函数(如GCC 7引入的新ABI),可能导致其他机器上崩溃。

解决方法:

# 查看二进制依赖的最低glibc版本

objdump -T ./ffmpeg | grep GLIBC_ | sort -u

readelf -V ./ffmpeg

# 强制使用旧ABI编译

export CC="gcc -static-libgcc"

./configure ... --disable-pthreads # 或改用老式线程模型

理想情况下,目标机器glibc >= 编译机使用的最低版本。

4.4.2 动态链接库缺失(missing so)的ldd诊断方法

使用 ldd 检查运行时依赖:

ldd ffmpeg | grep "not found"

输出示例:

libx265.so.199 => not found

解决方案:

# 添加库路径

export LD_LIBRARY_PATH="/usr/local/lib:$LD_LIBRARY_PATH"

# 或创建软链接

sudo ln -s /usr/local/lib/libx265.so.199 /usr/lib64/libx265.so.199

更优做法是在编译时静态链接关键库,避免运行时依赖。

4.4.3 多版本FFmpeg共存部署方案设计

当系统中已有旧版FFmpeg时,可通过目录隔离实现共存:

# 自定义安装路径

./configure --prefix=/opt/ffmpeg-h265-rtmp

# 创建软链接方便调用

sudo ln -sf /opt/ffmpeg-h265-rtmp/bin/ffmpeg /usr/local/bin/ffmpeg-h265

并通过shell别名区分:

alias ffmpeg-safe='/opt/ffmpeg-h265-rtmp/bin/ffmpeg'

优势 :避免污染系统PATH,便于灰度发布和回滚。

graph LR

A[User Command] --> B{Which ffmpeg?}

B -->|ffmpeg| C[System Default]

B -->|ffmpeg-h265| D[Custom Build with HEVC+RTMP]

D --> E[Statically Linked Bin]

综上所述,在CentOS 7上构建功能完备的FFmpeg并非简单 yum install 即可完成,而是一套涵盖环境准备、依赖管理、编译优化与运行保障的系统工程。唯有深入理解每个环节的技术细节,方能在生产环境中实现稳定高效的音视频处理能力。

5. 预编译FFmpeg包的目录结构与部署方法

在多媒体处理系统构建过程中,从源码编译 FFmpeg 固然能够实现高度定制化,但其复杂的依赖管理和漫长的构建周期常常成为生产环境快速部署的瓶颈。相比之下,使用经过完整测试、功能齐全且兼容性良好的 预编译 FFmpeg 包 (如 ffmpeg-rtmp-h.265-all.tar.gz )可以显著提升部署效率,尤其适用于对时间敏感的直播推流、边缘节点扩容等场景。

本章将深入剖析该类预编译包的内部组织结构,解析其核心组件的功能定位,并结合 CentOS 7 系统环境,详细阐述从解压到验证的一整套标准化部署流程。重点聚焦于如何确保库路径正确加载、环境变量合理配置以及功能完整性检测机制的设计,为后续 H.265 编码推流和 RTMP 协议交互提供稳定可靠的运行基础。

5.1 ffmpeg-rtmp-h.265-all.tar.gz文件解构分析

一个高质量的预编译 FFmpeg 套件通常以 .tar.gz 形式分发,命名中包含关键特性标识(如 rtmp、h.265),表明其已集成 librtmp 和 libx265 支持。这类压缩包并非简单打包二进制可执行文件,而是一个具备完整 Unix 文件系统层级结构的软件发行版本,遵循 FHS(Filesystem Hierarchy Standard)规范进行组织。

通过标准命令解压后,用户会发现多个顶层目录共存,每个目录承担特定职责。理解这些目录的分工是安全、高效部署的前提。

5.1.1 bin、lib、share、doc等目录职责划分

预编译包展开后的典型目录结构如下所示:

ffmpeg-rtmp-h.265-all/

├── bin/

│ ├── ffmpeg

│ ├── ffprobe

│ └── ffserver

├── lib/

│ ├── libavcodec.so.58

│ ├── libavformat.so.58

│ ├── libavfilter.so.7

│ ├── libx265.so.199

│ └── librtmp.so.1

├── share/

│ ├── ffmpeg/

│ │ ├── default.md

│ │ ├── ffpreset/

│ │ └── bsf/

├── doc/

│ ├── README.txt

│ └── CHANGELOG.md

└── include/

├── libavcodec/

├── libavformat/

└── x265.h

各主要目录的功能说明见下表:

| 目录 | 职责描述 |

|---|---|

bin/ |

存放可执行程序,包括主工具 ffmpeg 、媒体分析工具 ffprobe 及旧版流服务器 ffserver (若启用) |

lib/ |

动态链接库集合,包含 FFmpeg 核心库(libav*)、第三方编码器(如 libx265)及网络协议支持库(如 librtmp) |

share/ |

存放共享资源,如预设配置文件(preset)、比特流过滤器定义、字体资源等 |

doc/ |

提供文档资料,帮助用户了解版本信息、使用限制与变更日志 |

include/ |

头文件目录,用于开发基于 FFmpeg API 的 C/C++ 应用程序 |

其中, share/ffmpeg/ffpreset/ 子目录尤为重要,它存放了多种编码优化模板(如 libx265-fast.ffpreset ),可在命令行中通过 -vpre fast 调用,极大简化复杂参数输入。

此外, lib/ 目录下的符号链接命名方式也需注意:例如 libx265.so -> libx265.so.199 表示当前版本为 199,这是动态链接器查找库的关键依据。若目标系统缺少对应版本的软链,可能导致 dlopen() 失败。

mermaid 流程图:预编译包解压后目录关系图

graph TD

A[ffmpeg-rtmp-h.265-all.tar.gz] --> B[bin/]

A --> C[lib/]

A --> D[share/]

A --> E[doc/]

A --> F[include/]

B --> B1[ffmpeg]

B --> B2[ffprobe]

B --> B3[ffserver]

C --> C1[libavcodec.so]

C --> C2[libavformat.so]

C --> C3[libx265.so]

C --> C4[librtmp.so]

D --> D1[ffpreset/]

D --> D2[bsf/]

D --> D3[default.md]

F --> F1[x265.h]

F --> F2[libavcodec/]

该结构体现了模块化设计思想,便于后期升级单个组件而不影响整体布局。

5.1.2 可执行文件ffmpeg、ffprobe、ffserver功能说明

ffmpeg

作为核心转码引擎, ffmpeg 支持几乎所有音视频格式的解码、滤镜处理、重编码与封装输出。其命令行接口极为灵活,常用于以下场景:

- 音视频转码(H.264 → H.265)

- 分辨率缩放与帧率转换

- 添加水印、裁剪、旋转等视觉处理

- 推送至 RTMP、SRT、HLS 等流媒体服务端

典型调用示例:

./bin/ffmpeg -i input.mp4 -c:v libx265 -crf 23 -c:a aac -f flv rtmp://live.example.com/app/stream

ffprobe

轻量级媒体元数据分析工具,可用于提取容器格式、编码参数、时长、码率、关键帧位置等信息,适合自动化脚本调用。

常用命令:

./bin/ffprobe -v quiet -print_format json -show_format -show_streams input.mp4

输出结果为 JSON 格式,便于解析并集成至监控系统或 CMS 平台。

ffserver

早期内置的流媒体服务器模块,支持 HTTP 和 RTSP 输出。但由于维护滞后且存在安全隐患,官方已于 FFmpeg 4.0 后弃用。现代部署中应优先选择 Nginx-rtmp-module 或 GStreamer 搭建流服务。

尽管如此,某些历史遗留系统仍可能依赖此组件,因此预编译包保留该二进制有助于兼容性过渡。

⚠️ 安全提示:启用

ffserver时务必配置访问控制列表(ACL)和 TLS 加密,避免暴露于公网。

5.1.3 预置配置文件与脚本自动化支持能力

许多高质量预编译包会在 share/ 下附带实用脚本或配置模板,提升运维效率。

例如,部分发行版包含:

share/ffmpeg/encode_h265_rtmp.sh:一键推流脚本share/ffmpeg/systemd/ffmpeg-stream.service:systemd 服务单元模板share/ffmpeg/presets/*.ffpreset:libx265 不同 preset 对应的参数集

以 libx265-ultrafast.ffpreset 内容为例:

# libx265 ultrafast preset

coder=0

b-adapt=0

rc-lookahead=0

keyint=25

min-keyint=1

scenecut=0

slices=1

这些参数直接映射到 x265 编码器内部选项,可通过 -vpre ultrafast 引入:

ffmpeg -i input.mp4 -c:v libx265 -vpre ultrafast -f flv rtmp://...

这种方式避免了冗长命令行拼接,特别适用于嵌入式设备或 CI/CD 自动化流水线。

5.2 快速部署流程与环境变量配置

完成对预编译包结构的理解后,下一步是将其部署到目标系统中,并确保所有组件能被正确识别和调用。部署过程不仅涉及文件复制,还需关注权限管理、符号链接创建与运行时环境设置。

5.2.1 解压路径选择与软链接创建最佳实践

建议将预编译包解压至 /opt/ffmpeg-toolchain/ 或 /usr/local/ffmpeg/ 等非系统目录,避免与包管理器安装的 FFmpeg 冲突。

操作步骤如下:

# 创建安装目录

sudo mkdir -p /opt/ffmpeg-toolchain

# 解压预编译包

tar -xzf ffmpeg-rtmp-h.265-all.tar.gz -C /opt/ffmpeg-toolchain --strip-components=1

# 创建软链接便于调用

sudo ln -sf /opt/ffmpeg-toolchain/bin/ffmpeg /usr/local/bin/ffmpeg

sudo ln -sf /opt/ffmpeg-toolchain/bin/ffprobe /usr/local/bin/ffprobe

采用软链接方式而非直接移动文件,有利于多版本共存与快速切换。例如,当需要回退版本时,只需修改链接指向即可:

# 切换至备用版本

sudo ln -sf /opt/ffmpeg-v5.1/bin/ffmpeg /usr/local/bin/ffmpeg

同时,保留原始目录结构也有助于调试时查看共享库依赖情况。

5.2.2 PATH与LD_LIBRARY_PATH设置规范

仅将 ffmpeg 加入 PATH 并不足以保证其正常运行。由于其依赖大量动态库(如 libx265.so , librtmp.so ),必须显式声明库搜索路径。

方法一:临时生效(测试阶段)

export PATH="/opt/ffmpeg-toolchain/bin:$PATH"

export LD_LIBRARY_PATH="/opt/ffmpeg-toolchain/lib:$LD_LIBRARY_PATH"

随后执行 ffmpeg -version 进行验证。

方法二:永久生效(生产环境)

推荐编辑 /etc/profile.d/ffmpeg.sh 文件:

echo 'export PATH="/opt/ffmpeg-toolchain/bin:$PATH"' | sudo tee /etc/profile.d/ffmpeg.sh

echo 'export LD_LIBRARY_PATH="/opt/ffmpeg-toolchain/lib:$LD_LIBRARY_PATH"' | sudo tee -a /etc/profile.d/ffmpeg.sh

chmod +x /etc/profile.d/ffmpeg.sh

此后所有新登录会话都将自动加载路径。

🔍 原理说明:

LD_LIBRARY_PATH是 GNU ld.so 动态链接器读取的环境变量,用于扩展默认库搜索路径(/lib,/usr/lib)。若未设置,即使库文件存在也会报错“cannot open shared object file”。

5.2.3 权限调整与服务用户隔离安全建议

在生产环境中运行 FFmpeg 推流任务时,不应以 root 用户身份启动,以防潜在漏洞导致系统被完全控制。

建议创建专用服务账户:

# 创建无登录权限的服务用户

sudo useradd -r -s /sbin/nologin ffmpeg-user

# 修改目录所有权

sudo chown -R ffmpeg-user:ffmpeg-user /opt/ffmpeg-toolchain

# 设置执行权限

sudo chmod 755 /opt/ffmpeg-toolchain/bin/*

然后在 systemd 服务或 supervisord 配置中指定运行用户:

[Unit]

Description=FFmpeg RTMP Streamer

After=network.target

[Service]

User=ffmpeg-user

Environment="LD_LIBRARY_PATH=/opt/ffmpeg-toolchain/lib"

ExecStart=/opt/ffmpeg-toolchain/bin/ffmpeg -re -i /video/live.mp4 -c:v libx265 -f flv rtmp://...

Restart=always

[Install]

WantedBy=multi-user.target

此做法实现了最小权限原则(Principle of Least Privilege),增强了系统的安全性。

5.3 版本验证与功能完整性检测

部署完成后,必须进行全面的功能验证,确保预编译包中的各项特性均可用,尤其是 H.265 编码与 RTMP 推送能力。

5.3.1 使用ffmpeg -version确认编译选项包含libx265与librtmp

执行以下命令:

ffmpeg -version

输出应类似:

ffmpeg version N-108254-gf1e9b9aee5-static https://johnvansickle.com/ffmpeg/

built with gcc 8 (Debian 8.3.0-6)

configuration: --enable-gpl --enable-libx265 --enable-librtmp --enable-nonfree ...

libavutil 57. 43.100 / 57. 43.100

libavcodec 59. 55.104 / 59. 55.104

libavformat 59. 39.101 / 59. 39.101

libavdevice 59. 8.101 / 59. 8.101

libavfilter 8. 59.102 / 8. 59.102

libswscale 6. 8.101 / 6. 8.101

libswresample 4. 8.100 / 4. 8.100

libpostproc 56. 7.100 / 56. 7.100

重点关注 configuration 行是否包含:

--enable-libx265:表示启用了 HEVC 编码支持--enable-librtmp:表示支持 RTMP 协议推拉流--enable-gpl和--enable-nonfree:允许使用专利算法(如 AAC、H.265)

若缺失上述任一 flag,则无法完成目标功能。

5.3.2 执行ffmpeg -formats | grep rtmp验证RTMP协议支持

运行以下管道命令检测协议注册状态:

ffmpeg -formats | grep rtmp

期望输出:

DE f flv Adobe Flash Video (codec FLV1, Sorenson Spark, VP6F)

E f rtmp RTMP dump RTMP

E f rtmpe RTMP dump encrypted RTMP

E f rtmps RTMP dump SSL/TLS-protected RTMP

E f rtmpt RTMP dump HTTP tunneling

E f rtmpte RTMP dump encrypted and HTTP-tunneled RTMP

其中,“E”代表“muxer”(输出支持),“D”代表“demuxer”(输入支持)。若无任何 rtmp 相关条目,说明 librtmp 未正确链接。

参数说明:

-formats:列出所有支持的容器格式与协议grep rtmp:过滤出包含 rtmp 字符串的行- 若返回为空,需检查

LD_LIBRARY_PATH是否包含librtmp.so

5.3.3 测试用例:本地文件推送到Nginx-rtmp模块验证通路

构建端到端验证闭环,使用真实推流场景检验部署效果。

步骤一:准备测试视频

选取一段 MP4 文件作为输入源:

test_video="/path/to/test_1080p.mp4"

步骤二:启动 Nginx-rtmp 流媒体服务(假设已配置)

Nginx 配置片段示例:

rtmp {

server {

listen 1935;

chunk_size 4096;

application live {

live on;

allow publish all;

allow play all;

}

}

}

步骤三:执行推流命令

/opt/ffmpeg-toolchain/bin/ffmpeg \

-re -stream_loop -1 -i "$test_video" \

-c:v libx265 -crf 26 -preset fast \

-c:a aac -b:a 128k \

-f flv "rtmp://your-server-ip/live/test"

参数解释:

| 参数 | 作用 |

|---|---|

-re |

按原始帧率读取输入,防止压垮网络 |

-stream_loop -1 |

循环播放输入文件 |

-c:v libx265 |

视频编码器设为 H.265 |

-crf 26 |

恒定质量模式,数值越小质量越高 |

-preset fast |

编码速度与压缩率平衡 |

-c:a aac |

音频转为 AAC 格式 |

-f flv |

封装为 FLV 格式并通过 RTMP 传输 |

验证方式:

- 使用 VLC 打开

rtmp://your-server-ip/live/test查看画面 - 在服务器端执行

netstat -an | grep 1935确认连接建立 - 查看 FFmpeg 输出日志是否有错误(如

Connection refused,No such file or directory)

若能成功播放,说明整个部署链条完整可用。

错误排查代码段:

# 检查动态库依赖

ldd /opt/ffmpeg-toolchain/bin/ffmpeg | grep -i "not found"

# 查看实时网络连接

ss -tulnp | grep ffmpeg

# 跟踪系统调用(诊断打开失败等问题)

strace -e trace=openat,connect /opt/ffmpeg-toolchain/bin/ffmpeg -i test.mp4 -f flv rtmp://... 2>&1 | grep -i error

以上三节构成了完整的预编译 FFmpeg 包部署体系:从结构解析到环境配置,再到功能验证,层层递进,确保每一个环节都可控、可测、可维护。这种工程化思维正是高可用流媒体系统建设的核心所在。

6. H.265编码参数配置与性能调优(如libx265、preset设置)

H.265(HEVC)作为当前主流的高效视频压缩标准,在4K/8K超高清内容、低带宽直播推流以及大规模视频存储场景中展现出显著优势。然而,其强大的压缩能力背后是复杂的编码结构和丰富的可调参数体系。在实际使用FFmpeg调用 libx265 进行H.265编码时,若不能合理配置关键参数,不仅会导致编码效率低下,还可能引发CPU资源过载、延迟升高甚至推流中断等问题。因此,深入理解 libx265 的核心参数语义、预设档位(preset)与调优模式(tune)的组合策略,并结合具体业务需求实现性能平衡,是构建稳定高效的流媒体系统的必要前提。

本章将系统剖析H.265编码过程中涉及的关键控制参数,从码率控制模式、关键帧策略到并行化处理机制,全面解析各参数的技术含义及其对编码质量、速度与资源消耗的影响路径。同时,通过实测数据对比不同preset档位下的编码性能表现,揭示“速度-质量-延迟”三者之间的权衡关系。此外,还将引入日志分析方法,指导开发者如何通过FFmpeg输出的统计信息识别编码瓶颈,进而实施精准优化。

6.1 libx265主要编码参数语义解析

libx265 作为x265项目的FFmpeg接口封装库,提供了高度灵活的编码控制能力。掌握其核心参数的作用域与交互逻辑,是实现精细化调优的基础。以下从码率控制、关键帧管理、参考帧与B帧调度三个维度展开详细说明。

6.1.1 bitrate、crf、profile、level参数作用域界定

在FFmpeg中调用 libx265 时,最常使用的参数包括 -b:v (bitrate)、 -crf (Constant Rate Factor)、 -profile:v 和 -level 。这些参数分别控制不同的编码行为层级。

| 参数 | 含义 | 推荐值示例 | 适用场景 |

|---|---|---|---|

-b:v |

视频目标比特率(CBR/VBR) | 5000k , 10M |

固定带宽环境,如CDN分发 |

-crf |

恒定质量因子(0~51) | 23 (默认), 18~20 为高质量 |

质量优先的点播转码 |

-profile:v |

编码轮廓(main/main10/mainstillpicture) | main , main10 |

兼容性要求高的设备播放 |

-level |

HEVC等级限制(3.1, 4.1, 5.1等) | 5.1 支持4K@60fps |

高分辨率实时推流 |

ffmpeg -i input.mp4 \

-c:v libx265 \

-crf 20 \

-preset medium \

-profile:v main \

-level 5.1 \

-c:a aac -b:a 128k \

output_hevc.mp4

代码逻辑逐行解读:

-i input.mp4:指定输入文件。-c:v libx265:启用H.265视频编码器。-crf 20:设定恒定质量因子为20,接近无损视觉体验(越小质量越高)。-preset medium:选择编码速度与压缩效率的平衡档位。-profile:v main:限定编码轮廓为主轮廓,确保大多数播放器兼容。-level 5.1:支持最高4K分辨率、60fps帧率及高码率输出。-c:a aac -b:a 128k:音频采用AAC编码,固定128kbps码率。output_hevc.mp4:输出封装为MP4格式的H.265视频文件。

参数说明扩展:

CRF模式下,编码器会根据画面复杂度动态调整比特率,适合非实时转码任务;- 若需严格控制带宽,则应关闭

-crf,改用-b:v配合-maxrate和-bufsize实现VBR或CBR;main10轮廓支持10-bit色深,常用于HDR内容,但需终端设备支持;level决定了最大分辨率、帧率和解码复杂度上限,超出则可能导致解码失败。

6.1.2 keyint、min-keyint与scenecut场景切换控制

关键帧(I帧)的插入频率直接影响视频随机访问能力、压缩效率和网络抗丢包性能。 libx265 通过 keyint (关键帧间隔)、 min-keyint (最小关键帧间隔)和 scenecut (场景变化检测)共同控制关键帧生成策略。

graph TD

A[视频帧序列] --> B{是否达到keyint?}

B -->|是| C[强制插入I帧]

B -->|否| D{scenecut检测到场景突变?}

D -->|是| E[插入I帧]

D -->|否| F[继续P/B帧编码]

E --> G[更新GOP结构]

C --> G

上述流程图展示了关键帧决策机制:即使未达到 keyint 设定值,只要 scenecut 检测到画面剧烈变化(如镜头切换),也会提前插入I帧以提升后续预测精度。

常用参数配置如下:

ffmpeg -i camera_feed.ts \

-c:v libx265 \

-keyint_min 25 \

-g 250 \

-scenecut 40 \

-c:a copy \

-f flv rtmp://live.example.com/app/stream

参数解释:

-keyint_min 25:最小关键帧间隔为25帧(约1秒@25fps),防止过于频繁地插入I帧;-g 250:最大GOP长度为250帧(10秒),控制缓冲区大小与延迟;-scenecut 40:设定场景切换阈值为40,数值越低越敏感;高于此值则触发I帧插入;-c:a copy:音频直接复制,避免额外编解码开销;-f flv rtmp://...:封装为FLV并通过RTMP推送。

逻辑分析:

在直播推流中,较长的GOP可提高压缩率,但会增加首次加载时间与恢复延迟。建议将

-g设置在50~100之间(2~4秒),兼顾效率与响应速度。而scenecut阈值通常设为默认40即可,过高会导致错过真实场景切换,过低则产生冗余I帧。

6.1.3 多参考帧、B帧数量与延迟平衡策略

H.265支持多达8个前向参考帧和多个B帧(双向预测帧),这能显著提升压缩效率。但在低延迟推流场景中,过多的B帧和长参考链会加剧编码延迟。

相关参数包括:

-refs:设置每帧最多使用的参考帧数(默认6);-bframes:允许连续B帧的最大数量(最大16);-bf:同-bframes别名;-no-scenecut:禁用场景切换自动插入I帧(减少延迟波动);-rc-lookahead:码率前瞻帧数,影响码控精度但增加延迟。

ffmpeg -f v4l2 -i /dev/video0 \

-c:v libx265 \

-preset veryfast \

-tune zerolatency \

-refs 3 \

-bf 2 \

-rc-lookahead 10 \

-f flv rtmp://live.push/cam01

执行逻辑说明:

- 输入来自UVC摄像头(

/dev/video0); - 使用

veryfastpreset降低编码耗时; tune=zerolatency关闭所有延迟敏感功能(如同步点等待);- 将参考帧限制为3,减少内存占用与缓存依赖;

- 最多允许2个连续B帧,避免过度延迟累积;

- 设置

rc-lookahead=10,在可接受范围内提升码率控制稳定性。

参数权衡分析:

在实时互动直播中,建议将

-bf设为0或2,refs不超过4,并始终启用tune=zerolatency。而对于点播转码,可适当增加至bf=8、refs=6以换取更高压缩比。

6.2 preset与tune参数组合优化实践

preset 和 tune 是影响 libx265 编码性能最关键的两个调节维度。它们不改变编码标准本身,而是通过调整内部算法复杂度与处理策略来平衡“编码速度”与“压缩效率”。

6.2.1 ultrafast至placebo七档preset对CPU占用率影响实测

libx265 提供从 ultrafast 到 placebo 共7档preset,代表了不同的编码搜索深度与工具启用程度。

| Preset | 平均编码速度(相对) | CPU使用率(1080p源) | 压缩效率增益(vs ultrafast) |

|---|---|---|---|

| ultrafast | 100%(最快) | ~30% | 基准 |

| superfast | 85% | ~35% | +5% |

| veryfast | 70% | ~45% | +10% |

| faster | 60% | ~55% | +15% |

| medium | 50% | ~70% | +20% |

| slow | 35% | ~90% | +25% |

| placebo | 20%(最慢) | >100%(多核满载) | +30% |

实验环境:Intel Xeon E5-2680 v4 @2.4GHz(14核28线程),输入1080p@30fps H.264素材,输出CRF=23 H.265 MP4。

# 测试命令模板

ffmpeg -i test_1080p.mp4 \

-c:v libx265 \

-crf 23 \

-preset $PRESET \

-tune $TUNE \

-c:a aac -b:a 128k \

result_$PRESET.mp4

通过循环测试不同preset,记录编码耗时、最终文件大小及top监控的CPU负载,得出结论:

ultrafast适用于边缘设备实时推流,牺牲压缩率换取低延迟;medium是通用转码的理想选择,兼顾速度与体积;slow及以上仅推荐用于离线归档或专业母版制作;placebo带来的边际效益极低,且极易造成系统卡顿,生产环境慎用。

6.2.2 tune=ssim/fastdecode/zem可选调优方向适用场景

tune 参数用于针对特定目标优化编码策略,常见选项包括:

| Tune值 | 优化目标 | 技术手段 | 推荐场景 |

|---|---|---|---|

tune=ssim |

提升主观画质 | 强化细节保留,降低块效应 | 视频点播、影视修复 |

tune=fastdecode |

加速解码 | 减少CABAC复杂度,限制TU划分 | 移动端播放、低端设备适配 |

tune=zerolatency |

极致低延迟 | 禁用B帧缓存、关闭lookahead | 实时连麦、远程控制 |

tune=grain |

保留胶片噪点 | 抑制过度平滑滤波 | 老电影数字化处理 |

# 示例:面向移动端的快速解码优化

ffmpeg -i source.mov \

-c:v libx265 \

-preset fast \

-tune fastdecode \

-x265-params "limit-tu=4:limit-modes" \

-c:a aac -ar 48000 -ab 64k \

mobile_output.mp4

参数说明:

limit-tu=4:限制变换单元(Transform Unit)的最大递归深度;limit-modes:减少预测模式遍历范围,加快编码;- 结合

fastdecode,整体解码复杂度下降约30%,适合Android/iOS播放器流畅运行。

衍生讨论:

在某些嵌入式平台上,即使使用

fastdecode仍可能出现解码卡顿。此时可通过添加-x265-params "sao=0"关闭样本自适应偏移(SAO)进一步减轻负担。不过需注意,SAO有助于抑制振铃效应,关闭后可能轻微影响边缘清晰度。

6.2.3 实际案例:直播推流选用veryfast+preset=zerolatency配置

在某电商平台大促直播项目中,前端采集设备为USB摄像头(1080p@30fps),需通过云服务器推送到CDN。考虑到主播操作延迟敏感性,团队最终选定以下编码策略:

ffmpeg -f dshow -i video="Integrated Camera" \

-vf scale=1280:720,fps=25 \

-c:v libx265 \

-preset veryfast \

-tune zerolatency \

-crf 25 \

-g 50 -keyint_min 25 \

-bframes 2 \

-c:a aac -b:a 96k \

-f flv rtmp://cdn.live/platform/stream_001

配置逻辑拆解:

-vf scale=1280:720,fps=25:降分辨率至720p,帧率统一为25fps,降低编码压力;-preset veryfast:保证单核可在10ms内完成一帧编码;-tune zerolatency:彻底消除编码缓存队列,实现帧级即时输出;-crf 25:在可接受范围内控制画质损失;-g 50:每2秒一个GOP,便于CDN切片与观众跳转;-bframes 2:适度利用B帧提升压缩率,又不至于显著增加延迟。

经压测验证,该配置下平均端到端延迟低于800ms,CPU占用稳定在65%以内,满足商业直播SLA要求。

6.3 编码效率与资源消耗的权衡分析

在部署大规模H.265编码服务时,必须综合评估编码效率与系统资源消耗之间的平衡。盲目追求高压缩率可能导致服务器集群负载飙升、运维成本剧增。因此,建立科学的监控与分析机制至关重要。

6.3.1 CRF模式与CBR/VBR模式在不同业务场景的应用取舍

三种主流码率控制模式各有侧重:

| 模式 | 特点 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|

| CRF(恒定质量) | 动态调整码率保持画质一致 | 文件小、视觉质量稳定 | 码率不可控,不适合带宽受限环境 | 点播转码、本地归档 |

| CBR(恒定码率) | 固定输出码率 | 易于带宽规划 | 复杂画面易出现马赛克 | 直播推流、广播传输 |

| VBR(可变码率) | 允许码率波动 | 质量与效率兼备 | 峰值可能超标 | OTT平台、IPTV |

# CBR模式配置示例

ffmpeg -i input.mp4 \

-c:v libx265 \

-b:v 3000k \

-minrate 3000k \

-maxrate 3000k \

-bufsize 6000k \

-c:a aac -b:a 128k \

-f mpegts udp://239.1.1.1:1234

参数说明:

-minrate = -maxrate = -b:v:强制进入CBR模式;-bufsize:码率缓冲区大小,一般设为两倍maxrate;- UDP组播输出用于广电级IP-SAN网络分发。

在实际应用中,建议:

- 对于用户上传视频,采用CRF模式批量转码;

- 对于实时直播,优先使用CBR确保带宽可控;

- 对于VOD点播CDN分发,可尝试VBR以节省流量费用。

6.3.2 并行编码线程数(–threads)与内存使用峰值监控

libx265 支持多线程并行编码,主要通过帧级并行(Frame-level Parallelism)和瓦片(Tiles)两种方式实现。

ffmpeg -i 4k_input.mkv \

-c:v libx265 \

-threads 0 \ # 自动检测CPU核心数

-x265-params "pools=none" \

-tile-columns 2 \

-tile-rows 2 \

output_4k_hevc.mp4

mermaid流程图展示并行编码架构:

graph LR

A[原始帧序列] --> B[帧分割模块]

B --> C[Tile 0x0]

B --> D[Tile 0x1]

B --> E[Tile 1x0]

B --> F[Tile 1x1]

C --> G[线程池处理]

D --> G

E --> G

F --> G

G --> H[合并输出NAL单元]

-threads 0:启用全部可用逻辑核心;pools=none:禁用内部线程池,由FFmpeg统一调度;tile-columns/tile-rows:将画面划分为4个独立编码区域,提升并行度。

性能监测建议:

使用

htop或nvidia-smi(若启用NVENC offload)观察CPU/GPU负载;

配合/usr/bin/time -v ffmpeg ...获取最大驻留集大小(RSS),判断是否存在内存溢出风险;

对于8K编码任务,建议预留至少16GB RAM以防OOM。

6.3.3 日志输出分析:stats、input stats与编码瓶颈识别

开启详细日志有助于定位编码性能瓶颈。可通过 -x265-params stats= 导出编码统计信息。

ffmpeg -i input.mp4 \

-c:v libx265 \

-preset slow \

-x265-params "stats=log.json:json=1" \

-f null -

生成的 log.json 包含每帧的QP值、比特分配、运动矢量分布等信息。典型字段如下:

{

"frame": 123,

"type": "P",

"qp": 24.5,

"bits": 12845,

"motion_vectors": 1567,

"inter_cost": 89234,

"intra_cost": 102833

}

分析思路:

- 若

intra_cost < inter_cost频繁出现,说明P帧预测失效,可能是运动剧烈或I帧过疏; - 连续高QP值(>35)表明码率不足或CRF设置过高;

bits剧烈波动提示VBR不稳定,需调整vbv-maxrate和vbv-bufsize。

结合Python脚本绘制QP曲线与码率趋势图,可直观发现编码异常区间,辅助参数调优。

7. 基于FFmpeg的RTMP推流命令实战

7.1 音视频文件转码为H.265并通过RTMP推送

在实际生产环境中,将本地音视频资源高效地转换为适合网络传输的格式并推送到流媒体服务器,是直播与点播系统中的关键环节。FFmpeg 提供了高度灵活的命令行接口,能够在一个流程中完成解码、滤镜处理、编码和封装输出,极大提升了运维效率。

7.1.1 命令模板构建:ffmpeg -i input.mp4 -c:v libx265 -c:a aac -f flv rtmp://server/live/streamkey

以下是一个典型的应用场景命令模板:

ffmpeg \

-i "/data/videos/input.mp4" \

-c:v libx265 \

-preset medium \

-crf 28 \

-vf "scale=1920:1080" \

-r 30 \

-c:a aac \

-ar 48000 \

-ac 2 \

-b:a 128k \

-f flv \

"rtmp://live.example.com/app/streamkey?token=abc123"

参数说明:

| 参数 | 说明 |

|---|---|

-i |

输入源路径,支持本地文件、网络流(如HTTP、RTSP)等 |

-c:v libx265 |

指定视频编码器为 H.265(HEVC),需编译时启用 x265 支持 |

-preset medium |

编码速度/压缩率权衡,可选 ultrafast, superfast, …, placebo |

-crf 28 |

恒定质量因子(Constant Rate Factor),值越小画质越高,推荐 22–28 |

-vf "scale=1920:1080" |

使用视频滤镜将分辨率缩放至 1080p |

-r 30 |

输出帧率为 30 fps |

-c:a aac |

音频编码为 AAC 格式,广泛兼容 RTMP 协议 |

-ar 48000 |

音频采样率设为 48kHz |

-ac 2 |

双声道立体声输出 |

-b:a 128k |

音频比特率为 128 kbps |

-f flv |

强制输出封装格式为 FLV,适配 RTMP 流协议 |

rtmp://...streamkey |

推流目标地址,包含鉴权参数(如 token)以增强安全性 |

注意 :部分 CDN 提供商要求 URL 中携带鉴权信息(如时间戳、签名),应确保正确拼接推流地址。

7.1.2 转码过程中分辨率缩放(scale滤镜)与帧率调整

分辨率与帧率适配是推流前的重要预处理步骤。使用 scale 滤镜可实现图像拉伸或保持宽高比填充黑边:

-vf "scale=1280:720:force_original_aspect_ratio=decrease,pad=1280:720:(ow-iw)/2:(oh-ih)/2"

该滤镜链含义如下:

- scale=...decrease :按原比例缩放到不超过 1280x720

- pad :上下左右居中填充黑边,确保输出尺寸固定,避免播放器兼容问题

帧率控制方面,若输入源为动态帧率(VFR),建议强制输出恒定帧率(CFR):

-r 25 -vsync cfr

其中 -vsync cfr 确保视频时间戳同步方式为 CFR,防止跳帧或卡顿。

7.1.3 音频重采样与声道映射参数精确控制

当输入音频为多声道或非标准采样率时,必须进行重采样处理:

-ac 2 -ar 48000 -af "aresample=osr=48000:ocl=stereo"

-af aresample=...显式调用重采样滤镜osr:输出采样率ocl:输出声道布局(如 stereo、5.1)

此外,可通过 -map 实现精准流选择:

-map 0:v:0 -map 0:a:1

表示仅提取第一个视频流和第二个音频流,适用于含多个音轨的 MKV 文件。

7.2 实时流捕获与网络传输一体化处理方案

7.2.1 捕获摄像头或X11桌面画面并实时编码推送

Linux 下可通过 V4L2 或 X11 Grab 捕获实时画面。例如捕获摄像头:

ffmpeg \

-f v4l2 \

-video_size 1280x720 \

-framerate 30 \

-i /dev/video0 \

-c:v libx265 \

-preset ultrafast \

-tune zerolatency \

-crf 26 \

-c:a aac \

-f flv \

"rtmp://live.example.com/app/streamkey"

对于桌面录制(X11):

ffmpeg \

-f x11grab \

-s 1920x1080 \

-framerate 25 \

-i :0.0+0,0 \

-c:v libx265 \

-preset fast \

-pix_fmt yuv420p \

-c:a alsa \

-i default \

-f flv \

"rtmp://live.example.com/app/streamkey"

注意:X11 抓屏需运行在图形会话中,并授权访问音频设备(ALSA)。

7.2.2 使用-vf添加水印、叠加时间戳等视觉增强效果

利用 movie 和 drawtext 滤镜可实现动态图文叠加:

-vf "movie='/logo.png' [watermark]; [in][watermark] overlay=10:10,

drawtext=fontfile=/usr/share/fonts/dejavu/DejaVuSans.ttf:

text='%{localtime}': fontcolor=white: fontsize=24:

box=1: boxcolor=black@0.5: x=(w-tw)/2: y=h-th-10 [out]"

功能分解:

- movie 加载 PNG 水印图像

- overlay 将其置于左上角(偏移 10px)

- drawtext 绘制当前系统时间,居底显示

字体路径需根据系统实际情况调整,建议使用绝对路径。

7.2.3 多目的地并发推流(tee muxer)与负载分担实现

使用 tee 复用器可在单条命令中向多个服务器并行推流:

-f tee "[f=flv]rtmp://primary.live.com/app/streamkey|[f=flv]rtmp://backup.cdn.net/live/streamkey"

更复杂场景下可配置权重与失败转移:

-f tee "[onfail=ignore]rtmp://a.example.com/live|m3u8://backup.m3u8"

onfail=ignore表示某路中断不影响整体进程- 支持混合输出协议(FLV + HLS),实现主备冗余架构

此机制常用于跨 CDN 容灾部署,提升服务可用性。

7.3 FFmpeg在服务器端流媒体服务中的集成与运维实践

7.3.1 结合systemd编写守护进程服务单元文件

为保障推流任务长期稳定运行,建议通过 systemd 管理 FFmpeg 进程。创建服务文件 /etc/systemd/system/ffmpeg-push.service :

[Unit]

Description=FFmpeg RTMP Push Service

After=network.target

[Service]

Type=simple

User=streamer

WorkingDirectory=/home/streamer

ExecStart=/usr/local/bin/ffmpeg \

-re -i "/media/live_source.mp4" \

-c:v libx265 -preset fast -crf 25 \

-c:a aac -b:a 128k \

-f flv "rtmp://live.cdn.com/app/streamkey"

Restart=always

RestartSec=5

StandardOutput=journal

StandardError=journal

[Install]

WantedBy=multi-user.target

启用服务:

systemctl daemon-reexec

systemctl enable ffmpeg-push.service

systemctl start ffmpeg-push.service

7.3.2 日志轮转、异常退出自动重启机制配置

上述 Restart=always 配置确保程序崩溃后自动重启;结合 journalctl 查看日志:

journalctl -u ffmpeg-push.service -f

日志轮转由 logrotate 自动管理,无需额外配置。也可重定向输出到文件并配合 rotatelogs 工具:

ExecStart=... >> /var/log/ffmpeg_push.log 2>&1 | rotatelogs /var/log/ffmpeg/%Y%m%d.log 86400

7.3.3 利用Prometheus+Node Exporter监控编码资源消耗指标

部署 Node Exporter 后,可通过 /metrics 接口采集 CPU、内存、磁盘 IO 使用情况。配合 Prometheus 抓取数据,并在 Grafana 中建立仪表盘监控:

- CPU Usage (%) :观察

libx265编码线程是否饱和 - Memory RSS (MB) :检测是否存在内存泄漏

- System Load Average :判断主机负载是否影响推流稳定性

示例 PromQL 查询编码进程 CPU 占用:

process_cpu_seconds_total{job="node", cmdname="ffmpeg"} by (instance)

结合 cgroup 限制资源使用上限,可实现精细化容器化部署。

graph TD

A[Source File/Camera] --> B(FFmpeg Encoding Pipeline)

B --> C{Output Format}

C --> D[Primary RTMP Server]

C --> E[Backup CDN Endpoint]

C --> F[HLS Backup for Failover]

G[Systemd Service Manager] --> B

H[Prometheus] --> I[Node Exporter]

I --> B

J[Grafana Dashboard] --> H

简介:FFmpeg是一款功能强大的开源多媒体处理工具,广泛用于音视频转码、流化和处理。本资源“ffmpeg-rtmp-h.265-all.tar.gz”是针对CentOS 7系统预编译并优化的FFmpeg软件包,集成RTMP协议支持与H.265(HEVC)编码能力,省去用户手动配置和编译的复杂流程。该工具包可直接用于实现高效视频压缩与实时推流,适用于直播、点播等流媒体应用场景,帮助开发者快速部署高性能音视频处理服务。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献20条内容

已为社区贡献20条内容

所有评论(0)