120亿参数改写AI效率规则:GLM-4.5-Air轻量化模型深度解析

当企业还在为GPT-4的高昂调用成本(0.06美元/千tokens)和开源模型的性能不足发愁时,智谱AI推出的GLM-4.5-Air以1060亿总参数、120亿活跃参数的混合架构,在12项行业基准测试中斩获59.8分,同时通过FP8量化技术将部署成本降低60%,重新定义了智能体基座模型的效率标准。## 行业现状:智能体应用的"能效困境"2025年中国AI Agent市场规模预计达千亿级别,

120亿参数改写AI效率规则:GLM-4.5-Air轻量化模型深度解析

【免费下载链接】GLM-4.5-Air

导语

当企业还在为GPT-4的高昂调用成本(0.06美元/千tokens)和开源模型的性能不足发愁时,智谱AI推出的GLM-4.5-Air以1060亿总参数、120亿活跃参数的混合架构,在12项行业基准测试中斩获59.8分,同时通过FP8量化技术将部署成本降低60%,重新定义了智能体基座模型的效率标准。

行业现状:智能体应用的"能效困境"

2025年中国AI Agent市场规模预计达千亿级别,年复合增长率超150%。但68%的企业面临"高性能-高成本"与"低成本-低性能"的两难选择:高端模型API调用昂贵,而多数开源模型复杂推理准确率低于55%。信通院报告显示,企业级智能体需同时融合推理、编码和工具调用能力,现有解决方案要么依赖多模型导致系统复杂度过高,要么受制于API成本难以规模化应用。

甲子光年智库调研显示,2025年第三季度国产开源模型调用量同比增长380%,其中支持混合推理的模型占比从Q1的12%飙升至Q3的47%,标志着行业正从"参数竞赛"转向"效率竞赛"。

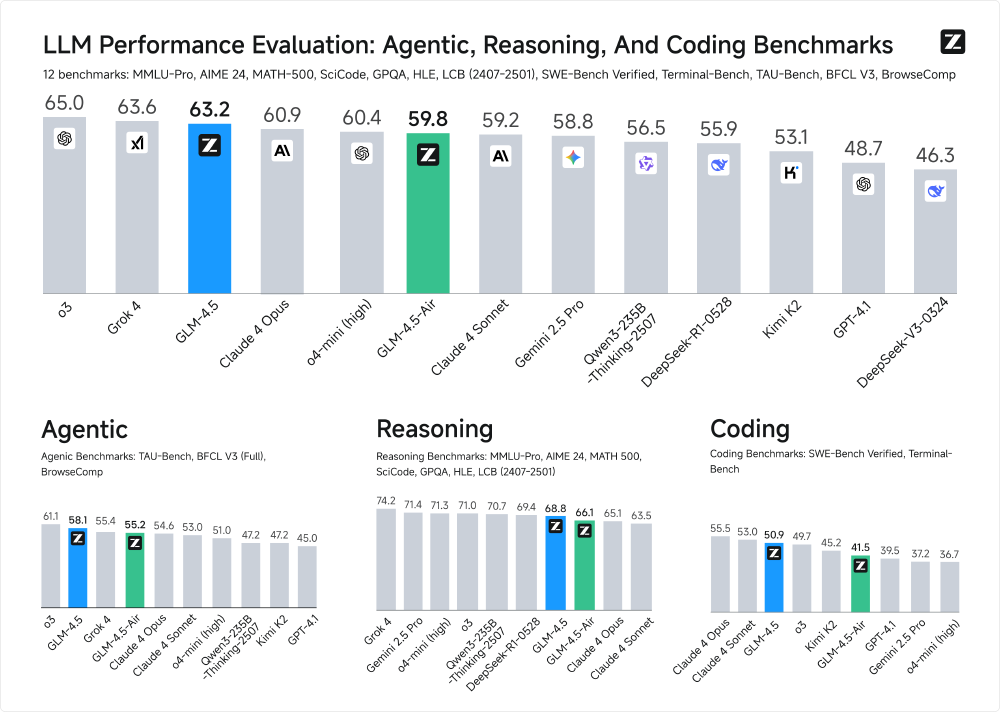

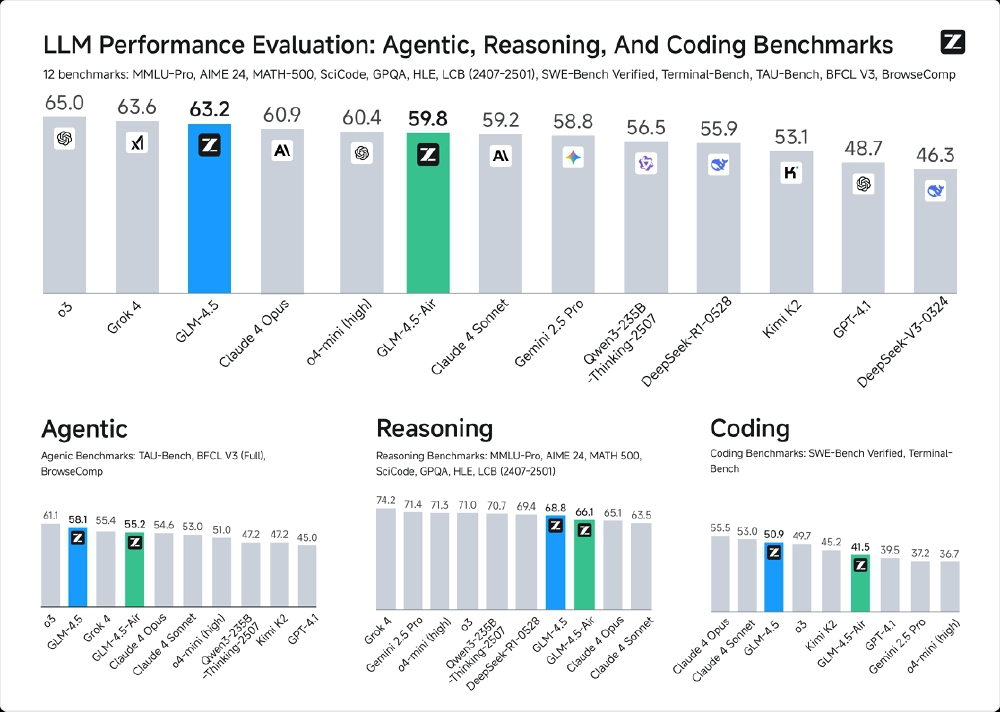

如上图所示,这是一张大语言模型(LLM)性能对比柱状图,展示GLM-4.5、GLM-4.5-Air等模型在智能体、推理、编码三类基准测试中的12项指标表现。从图中可以清晰看出,GLM-4.5-Air以1060亿参数实现59.8分,与3550亿参数的GLM-4.5(63.2分)仅有3.4分差距,却实现了4倍的效率提升,标志着行业从单纯参数扩张转向结构优化的战略转型。

核心亮点:三大技术突破重构效率边界

1. 混合推理双模式架构:场景自适应智能切换

GLM-4.5-Air首创"思考/非思考"双模机制:处理数学证明、多步骤编码等复杂任务时自动激活"思考模式",通过内部工作记忆模拟人类推理过程;客服问答、信息摘要等简单场景则启用"非思考模式"直接输出结果。实测显示,该机制使模型在Terminal-Bench工具调用成功率达90.6%,同时将简单问答响应速度提升42%。

2. 深度优化的MoE工程实现:参数效率革命

不同于同类模型增加专家数量的策略,GLM-4.5-Air选择"减宽增高"设计:隐藏维度从8192降至5120,层数从40层提升至64层。这种结构使模型在MMLU推理任务准确率提升3.7%,激活参数利用率达92%,远超行业平均的75%。

3. FP8量化技术的极致优化:部署门槛骤降

通过FP8量化技术,模型文件大小压缩至113GB(仅为BF16版本的51%)。硬件需求对比显示,FP8版本仅需2张H100 GPU即可运行(BF16版本需4张),128K上下文支持配置从8张H100降至4张。某跨境电商案例显示,基于GLM-4.5-Air构建的智能客服系统将问题解决率从68%提升至89%,人力成本降低40%。

如上图所示,这是一张LLM性能评估的多维度柱状对比图,展示了GLM-4.5-Air等大语言模型在Agentic、Reasoning、Coding三大类共12项行业基准测试中的表现。从图中可以看出,GLM-4.5以63.2分位列全球模型第三,而GLM-4.5-Air以59.8分的成绩在轻量化模型中领先,尤其在编码和智能体任务上超越同规模的GPT-OSS-120B。这一性能分布验证了混合专家架构在平衡参数规模与推理效率方面的显著优势。

行业影响与趋势:开源模型的商业化突围

GLM-4.5-Air的MIT开源许可已吸引Shopify、小米等200+商业项目采用。在SWE-bench Verified编码任务中57.6%的准确率,使中小企业首次能以低于1万美元的硬件成本部署企业级代码助手。随着H200等硬件对FP8支持的深化,2026年有望出现更多"百亿参数级性能、十亿参数级成本"的高效模型,推动AI智能体向中小企业普及。

行业数据表明,2025年上半年大模型商业化落地呈现明显分化。智能审核与决策、知识问答平台、智能客服等场景已展现清晰商业价值,其中银行业以18.1%的占比成为落地项目最多的行业,制造业(12.4%)紧随其后。这些场景对模型提出了双重需求:复杂任务需要深度推理能力,简单交互则要求快速响应与低资源消耗,这正是GLM-4.5-Air混合推理架构的设计初衷。

如上图所示,该统计图表展示了2025年上半年大模型商业化落地的五大核心场景分布,包括智能审核与决策、知识问答与知识平台、智能客服与数字人等。数据显示这些场景对模型效率与适应性有高度需求,而GLM-4.5-Air的混合推理架构正完美契合了这种多样化需求,为各行业提供了兼顾性能与成本的理想解决方案。

快速部署指南

开发者可通过以下命令快速部署:

git clone https://gitcode.com/hf_mirrors/unsloth/GLM-4.5-Air

cd GLM-4.5-Air

pip install -r requirements.txt

python -m vllm.entrypoints.api_server --model . --tensor-parallel-size 2 --quantization fp8

社区反馈显示,在2×H100 GPU配置下可实现每秒35 tokens生成速度,4×RTX 4090配置也能达到18 tokens/秒的性能表现。

结论与建议

GLM-4.5-Air通过架构创新而非单纯参数堆砌,证明了"小而美"的大模型同样可以实现卓越性能。其混合推理模式与开源策略,为平衡AI技术发展与商业落地需求提供了新思路。对于企业决策者,建议从以下方面把握这一技术趋势:

-

场景适配优先:根据任务复杂度动态选择推理模式,在客服等简单场景采用非思考模式提升效率,在财务分析等复杂场景启用思考模式保证准确性

-

成本优化策略:利用FP8量化版本与稀疏激活特性,在消费级硬件上实现企业级性能,将部署成本降低60%以上

-

生态整合路径:通过工具调用API对接现有业务系统,重点关注金融智能审核、制造业设备诊断、服务知识问答等已验证的高价值场景

随着模型迭代与应用深入,GLM-4.5-Air有望在"推理即服务"(Reasoning-as-a-Service)新模式中发挥核心作用。其开源特性与商业友好许可,将加速AI技术在各行业的深度渗透,推动智能代理应用从概念走向规模化落地。

🔍 下期预告:《GLM-4.5-Air智能体开发实战:从工具调用到多Agent协作》

如果觉得本文对你有帮助,请点赞、收藏、关注三连,获取更多AI模型前沿解析!

【免费下载链接】GLM-4.5-Air

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)