破局AI孤岛:MCP协议中的Client深度解析(第五章)

本文深入解析了MCP协议中的Client组件,该组件作为连接业务应用与模型服务的核心枢纽,通过抽象复杂分布式逻辑为上层提供统一接口。文章详细阐述了MCPClient的四大角色(协议网关、上下文管家、模型协调员、安全卫士)、核心工作流程及关键子流程(上下文管理、智能路由)。同时提供了Python/Java/Go等语言的实现示例,包括基础创建与高级定制方法,并给出分层部署、性能优化等最佳实践建议。MC

5、MCP协议中的Client深度解析

MCP协议中的Client组件是连接业务应用与模型服务的关键枢纽,它通过抽象复杂的分布式协作逻辑,为上层应用提供简洁统一的接口。本章将系统讲解MCP Client的设计理念、核心功能、实现方式及最佳实践,帮助技术人员全面掌握这一关键组件。

5.1、Client概念定位

MCP Client是运行在业务应用侧的智能代理,它作为协议体系的"翻译官"和"协调者",屏蔽了底层模型服务的复杂性,使应用开发者能够专注于业务逻辑而非分布式系统细节。从技术架构角度看,MCP Client可类比为微服务架构中的服务网格(Service Mesh),但专门针对AI模型协作场景优化。

MCP Client 是协议体系中的智能终端代理,核心承担三大角色:

- 协议网关

作为应用与模型服务之间的通信桥梁,协议网关负责:

- 多协议适配:同时支持HTTP/2、gRPC和WebSocket等多种通信协议,根据模型服务能力自动选择最优协议

- 协议协商:实现客户端与服务端之间的版本协商机制,支持平滑升级与降级

- API抽象:提供统一的高层API,隐藏协议细节,如自动处理gRPC的流式调用或WebSocket的连接维护

- 上下文管家

在多模型协作场景中,上下文信息是连接各环节的关键纽带,上下文管家负责:

- 上下文容器管理:为每个任务创建独立的上下文容器,存储中间结果和状态信息

- 版本控制:实现上下文的快照与回滚机制,支持协作过程中的状态恢复

- 多模态数据处理:提供文本、图像、音频等多模态数据的序列化与反序列化能力

- 模型协调员

作为模型服务的"调度中心",模型协调员的核心功能包括:

- 服务发现:通过注册中心动态感知可用模型服务节点

- 智能路由:基于负载、性能、成本等多维度因素选择最优模型节点

- 容错机制:实现自动重试、故障转移和服务降级策略

- 安全卫士

在企业级应用中,安全是不可或缺的环节,安全卫士负责:

- 身份认证:管理客户端证书与API密钥

- 传输加密:采用TLS 1.3实现端到端加密通信

- 审计日志:记录所有模型调用与数据访问行为,支持合规审计

5.2、核心流程设计

5.2.1、完整工作流

MCP Client的完整工作流程涉及多个组件协同,以下是详细分解:

流程关键节点说明:

- 任务提交阶段:应用系统通过Client API提交任务请求,包含输入数据和期望输出格式

- 服务发现阶段:Client向注册中心查询具备所需能力的模型服务列表

- 上下文初始化:创建专属上下文容器,生成唯一context_id用于跟踪整个协作过程

- 模型协作阶段:

- 多轮模型调用,每轮调用携带context_id以保持状态连续性

- 模型服务通过context_id读写共享上下文

- Client根据前一模型输出自动路由至下游模型

- 结果返回与上下文归档:整合所有模型输出,返回最终结果,并归档上下文供后续分析

5.2.2、关键子流程详解

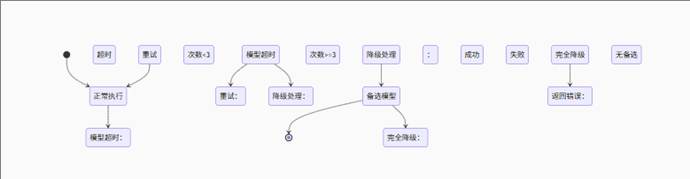

上下文管理流程

上下文管理是确保多模型协同一致性的核心机制:

流程解析:

- 上下文检查:接收请求时首先检查是否指定了现有上下文ID

- 是:加载最新快照并合并可能的增量更新

- 否:创建新上下文容器并生成唯一标识

- 执行与更新:模型调用后生成上下文变更集(仅包含修改部分)

- 持久化与通知:变更集保存到分布式存储,并通知所有订阅该上下文的服务

优化策略:采用写时复制(Copy-on-Write)机制减少快照存储开销。

智能路由流程

智能路由确保请求被分发到最优模型服务节点:

路由决策因素:

- 能力匹配:根据请求所需能力(如"图像识别"、"情感分析")筛选合适模型

- 健康状态:排除健康检查失败或负载过高的节点

- 性能指标:考虑历史响应时间、准确率等指标

- 成本因素:在满足需求的前提下选择成本较低的模型

算法实现:基于多属性决策理论(MADM)的加权评分模型,动态调整各因素权重。

5.3、Client创建方法与实现

5.3.1、基础创建模式

|

Python |

代码解析:

- basic_client方法提供默认配置的客户端实例

- 核心配置仅需注册中心和上下文服务地址

- execute方法为主要接口,接受任务描述、输入数据和输出格式

5.3.2、高级定制创建

对于复杂场景,可通过构建器模式进行深度定制:

|

Java |

高级特性:

- 注册中心定制:支持ZooKeeper、etcd或Consul等多种注册中心

- 上下文服务配置:设置数据副本数、存储后端等

- 安全策略:配置mTLS证书路径和自动刷新机制

- 路由策略:指定路由决策因素和降级模式

- 监控集成:对接Prometheus等监控系统

- 异步执行:支持非阻塞任务提交与回调

5.3.3、关键配置项说明

|

配置类别 |

关键参数 |

说明 |

默认值 |

|

注册中心 |

registry_type |

类型(zookeeper/etcd/consul) |

zookeeper |

|

registry_endpoints |

集群节点地址 |

localhost:2181 |

|

|

上下文服务 |

context_backend |

存储类型(S3/Cassandra/Redis) |

Cassandra |

|

context_ttl |

上下文存活时间(小时) |

72 |

|

|

路由策略 |

routing_algorithm |

路由算法(priority/random/cost) |

cost-based |

|

fallback_strategy |

故障转移策略 |

fast-failover |

|

|

安全认证 |

auth_mode |

认证方式(mTLS/OAuth) |

mTLS |

|

cert_refresh_interval |

证书刷新间隔(分钟) |

1440 |

|

|

性能优化 |

connection_pool_size |

连接池大小 |

20 |

|

max_retries |

最大重试次数 |

3 |

配置建议:

- 生产环境:推荐使用etcd作为注册中心,提供更好的一致性保证

- 低延迟场景:context_backend选择Redis,牺牲部分持久性换取性能

- 关键业务:fallback_strategy设置为GRADUAL_DEGRADATION,确保服务可用性

- 高并发场景:适当增大connection_pool_size至50-100,避免连接瓶颈

5.4、Client核心功能实现

5.4.1、上下文管理器实现

上下文管理器负责全生命周期的上下文数据管理:

|

Go |

实现要点:

- 缓存策略:采用LRU(最近最少使用)缓存淘汰策略,默认缓存1000个最近活跃上下文

- 存储抽象:定义ContextStorage接口,可适配不同存储后端

- 变更通知:基于发布-订阅模式,通知相关服务上下文变更

5.4.2、智能路由引擎

智能路由引擎是实现服务发现与负载均衡的核心:

|

Python |

路由决策流程:

- 能力匹配:从注册中心获取具备所需能力的模型列表

- 上下文过滤:根据当前上下文元数据(如是否需要GPU、数据格式等)进一步筛选

- 健康检查:排除不健康的模型节点

- 负载均衡:采用最小连接数算法选择最优节点

5.5、最佳实践建议

- 客户端部署模式

推荐采用分层部署架构,确保安全性与可维护性:

部署要点:

- 安全隔离:业务应用与MCP Client部署在安全隔离区,通过防火墙限制对外访问

- DMZ区域:上下文服务和注册中心部署在DMZ区域,仅开放必要端口

- 模型服务区:模型服务集群独立部署,通过上下文服务与外界交互

- 性能优化技巧

- 上下文预取机制

|

Python |

适用场景:已知即将使用的上下文ID,如对话系统中的连续交互

- 批处理模式

|

Java |

性能收益:减少网络往返次数,吞吐量提升30-50%

- 增量更新策略

|

JavaScript |

网络优化:平均减少60-80%的上下文传输数据量

- 分级缓存配置

|

YAML |

缓存策略:热点上下文内存缓存,次热点本地磁盘缓存,冷数据远程存储

- 错误处理策略

5.6、典型应用场景

- 跨模型流水线

构建多模型协作的处理流水线:

|

Python |

应用场景:产品图片分析报告自动生成

- 目标检测模型识别图片中的物体区域

- OCR模型提取区域内文本

- 翻译模型将文本转为目标语言

- 报告生成模型整合结果生成格式化报告

- 动态模型组合

根据输入特征动态选择模型组合:

|

JavaScript |

工作原理:

- 检测到输入包含图片,触发发票解析和政策检查模型

- 如无图片,则使用意图分类和问答系统直接回答

- 上下文感知服务

维护长期对话状态的智能服务:

|

Java |

上下文维护:

- 保留用户偏好设置(如语言、座位偏好等)

- 累计对话历史,实现上下文感知的响应生成

5.7、总结:MCP Client的设计哲学

MCP Client的设计体现了四大核心理念:

1. 智能抽象层

- 向上:提供简洁API,隐藏分布式系统复杂性

- 向下:封装异构模型服务,实现统一接入

2. 状态感知引擎

- 上下文作为一等公民,贯穿整个协作过程

- 自动维护跨模型会话状态,简化应用开发

3. 自适应神经系统

- 动态发现可用模型能力,实现"即插即用"

- 智能路由与弹性容错,提升系统可靠性

4. 安全执行沙箱

- 端到端加密通信,保护数据传输安全

- 细粒度访问控制,防范未授权访问

MCP Client本质上可视为**模型协作操作系统**,其设计理念类比Kubernetes之于容器:

- 注册中心 ≈ 服务发现机制

- 上下文服务 ≈ 共享存储卷

- 模型节点 ≈ 容器计算单元

- 路由引擎 ≈ Service负载均衡

通过这种设计,MCP Client成为连接物理模型世界与逻辑业务需求的智能枢纽,为构建企业级模型协作平台提供核心支撑。随着AI模型数量和复杂性的增长,MCP Client将发挥越来越重要的作用,帮助企业更高效地释放AI价值。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)