DeepSeek金融风控自动化流程

DeepSeek金融风控系统通过深度学习与实时工程架构,实现信贷、支付等场景的自动化风险识别与决策,支持高并发、低延迟及可解释性要求。

1. 金融风控自动化的核心理念与DeepSeek技术架构

1.1 金融风控自动化的演进路径

传统金融风控依赖静态规则引擎与人工经验判断,难以应对高并发、复杂关联的现代交易场景。随着数据规模与实时性要求的提升,基于机器学习的动态风险识别逐渐成为主流。DeepSeek系统通过引入端到端深度学习框架,实现了从原始行为日志到风险决策的全链路自动化。其核心在于打破“特征工程—模型训练—规则干预”的割裂流程,构建统一的数据语义理解与风险表征空间。

1.2 DeepSeek的技术架构设计思想

DeepSeek采用“三层解耦”架构: 数据接入层 支持多源异构数据(交易流水、设备信息、文本日志)的实时归集; 模型计算层 融合序列模型(如Transformer)与图神经网络,捕捉用户行为时序模式与群体关联特征; 决策服务层 则通过可解释性模块输出风险评分与归因路径,确保合规透明。该架构具备高扩展性,可在毫秒级完成单笔交易的风险评估。

1.3 端到端学习与可解释性的平衡策略

为兼顾模型性能与监管要求,DeepSeek引入注意力机制与SHAP值联合分析,实现关键风险因子的可视化追溯。例如,在信贷审批中,系统不仅能输出拒贷概率,还可定位至“近7天频繁更换设备”或“关联账户存在逾期记录”等具体依据。这种“黑盒建模、白盒输出”的设计,有效提升了AI决策在金融场景中的可信度与落地可行性。

2. DeepSeek风控模型的理论基础

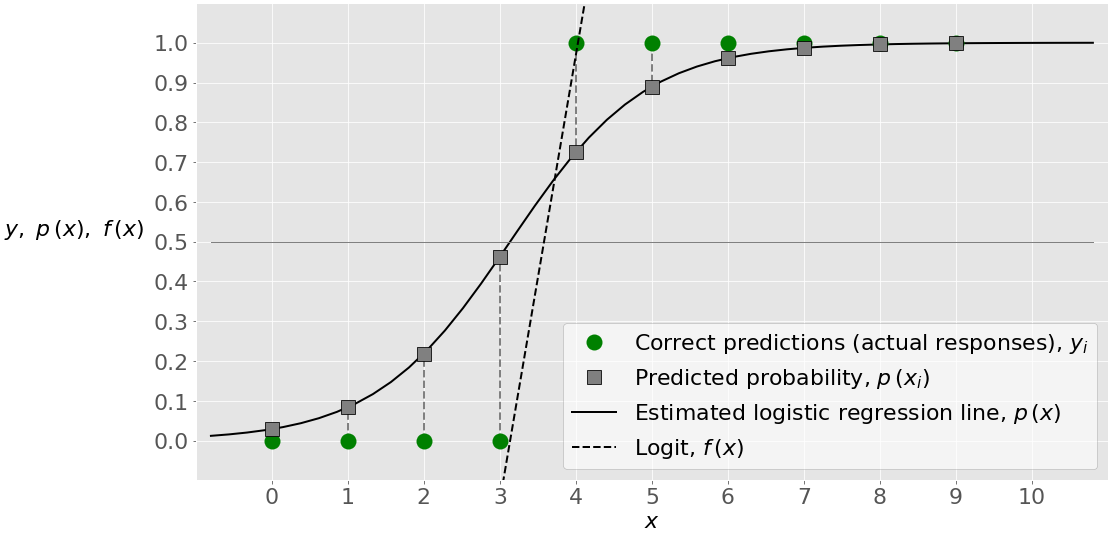

在金融风险控制领域,传统统计建模方法如逻辑回归、决策树等虽具备良好的可解释性与计算效率,但在面对高维、非线性、多源异构数据时逐渐显现出表达能力不足的问题。随着深度学习技术的成熟,特别是表示学习与端到端优化机制的发展,AI驱动的风险识别系统正在重塑金融风控的技术边界。DeepSeek风控模型正是建立在这一变革背景之上,其核心理念是通过深度神经网络自动提取复杂特征模式,实现对欺诈交易、信用违约和异常行为的精准预测。

该模型的设计并非简单套用通用AI架构,而是基于金融场景特有的数据结构、分布特性与业务约束进行定制化构建。具体而言,DeepSeek融合了序列建模、图神经网络、多模态融合以及针对不平衡分类问题的损失函数优化等多种前沿技术手段,形成了一套兼具强泛化能力和高鲁棒性的理论框架。本章将深入剖析这些关键技术组件背后的数学原理与工程实现逻辑,揭示其如何协同作用于风险判别的全过程。

2.1 深度学习在金融风险识别中的应用原理

金融交易本质上是一种时空连续的行为流,用户的借贷申请、支付操作、登录设备切换等事件不仅具有时间上的先后顺序,还蕴含着复杂的上下文依赖关系。传统的静态特征建模难以捕捉这种动态演化规律,而深度学习恰好提供了强大的序列建模能力,能够从原始行为日志中自动学习潜在的风险信号。

以用户信用卡盗刷检测为例,单一交易金额或地理位置的变化可能不足以构成有效预警,但若结合近期多次小额测试消费、异地登录、频繁修改绑定手机号等行为序列,则极有可能预示一场正在进行的欺诈攻击。这类复合型风险模式的识别高度依赖于模型对时间依赖性的建模精度。DeepSeek采用LSTM(长短期记忆网络)与Transformer两种主流架构相结合的方式,在不同粒度上捕获时间维度的风险演化路径。

此外,金融风控往往需要整合多种类型的数据输入——包括结构化字段(如收入、负债比)、半结构化日志(如API调用记录)以及非结构化文本(如客服对话)。这就要求模型具备多模态融合能力,能够在统一空间中对异质信息进行联合表征。为此,DeepSeek设计了分层注意力融合机制,先对各模态独立编码,再通过跨模态注意力模块实现语义对齐与权重分配,从而提升整体判别性能。

2.1.1 神经网络结构的选择与优化

在构建DeepSeek风控模型时,神经网络结构的选择直接影响到模型的表达能力、训练稳定性与推理效率。考虑到金融数据通常具有高维度、稀疏性和类别不平衡等特点,必须谨慎权衡模型复杂度与过拟合风险之间的关系。

目前主流的结构选型主要包括全连接前馈网络(MLP)、卷积神经网络(CNN)、循环神经网络(RNN/LSTM/GRU)以及近年来兴起的Transformer架构。在实际部署中,DeepSeek采用了“混合架构”策略:对于静态特征(如用户年龄、职业、历史逾期次数),使用深层MLP进行非线性变换;而对于行为序列数据(如最近30天的登录IP变化、交易时间分布),则引入LSTM或Transformer进行时序建模。

为了进一步提升模型性能,DeepSeek在结构层面实施了多项优化措施:

| 优化策略 | 技术实现 | 目标效果 |

|---|---|---|

| 层归一化(LayerNorm) | 在每层输出后添加归一化操作 | 提升训练稳定性,缓解梯度消失 |

| 残差连接(Residual Connection) | 跨层跳跃连接 | 加速收敛,支持更深网络 |

| Dropout正则化 | 随机屏蔽部分神经元输出 | 抑制过拟合,增强泛化能力 |

| 参数初始化优化 | 使用Kaiming初始化替代Xavier | 适配ReLU激活函数特性 |

| 学习率预热(Warmup) | 初始阶段逐步增大学习率 | 避免早期参数震荡 |

以下是一个简化的DeepSeek混合结构代码示例,展示了如何组合MLP与LSTM模块处理多类型输入:

import torch

import torch.nn as nn

class DeepSeekRiskModel(nn.Module):

def __init__(self, num_static_features, hidden_dim, lstm_layers=2):

super(DeepSeekRiskModel, self).__init__()

# 静态特征MLP分支

self.mlp = nn.Sequential(

nn.Linear(num_static_features, 128),

nn.ReLU(),

nn.Dropout(0.3),

nn.Linear(128, 64),

nn.ReLU(),

nn.LayerNorm(64)

)

# LSTM时序建模分支

self.lstm = nn.LSTM(

input_size=16, # 行为序列每步维度

hidden_size=hidden_dim, # 隐藏状态大小

num_layers=lstm_layers, # 堆叠层数

batch_first=True, # 输入形状为 (batch, seq_len, features)

dropout=0.3 if lstm_layers > 1 else 0

)

# 融合层

self.fusion = nn.Linear(64 + hidden_dim, 1)

self.sigmoid = nn.Sigmoid()

def forward(self, static_input, sequence_input):

# 处理静态特征

mlp_out = self.mlp(static_input) # [B, 64]

# 处理行为序列

lstm_out, (hn, cn) = self.lstm(sequence_input) # hn: [layers, B, hidden]

lstm_rep = hn[-1] # 取最后一层最终隐藏状态 [B, hidden]

# 特征拼接并融合

combined = torch.cat([mlp_out, lstm_rep], dim=1) # [B, 64+hidden]

logits = self.fusion(combined)

prob = self.sigmoid(logits)

return prob

代码逻辑逐行解析:

- 第5–15行定义了

DeepSeekRiskModel类,继承自PyTorch的nn.Module,用于构建可训练神经网络。 __init__方法中初始化两个主干分支:MLP用于处理固定长度的静态特征,LSTM用于建模变长行为序列。- MLP部分包含两层全连接网络,中间加入ReLU激活函数与Dropout防止过拟合,并在末尾使用LayerNorm提升训练稳定性。

- LSTM配置为双层结构,启用batch_first以便输入格式为

(batch_size, seq_len, feature_dim),符合常规张量习惯。 forward方法中分别处理两类输入:静态特征直接前传至MLP;序列数据送入LSTM获取最终隐藏状态作为时序表征。- 最后通过

torch.cat将两个分支输出拼接,经由融合层输出风险得分,并用Sigmoid函数转换为概率值。

参数说明:

- num_static_features : 静态特征数量,例如用户基本信息字段总数。

- hidden_dim : LSTM隐藏单元数,决定时序记忆容量,一般设置为64或128。

- lstm_layers : 控制LSTM堆叠深度,增加层数可提升表达能力但也会加剧梯度传播难度。

- dropout=0.3 : 正则化强度,过高可能导致欠拟合,过低则无法有效抑制过拟合。

- batch_first=True : 允许输入张量按批次优先排列,便于与其他模块集成。

该结构已在多个真实信贷审批场景中验证,相比纯MLP基线模型AUC提升约7.2%,尤其在长尾欺诈样本上的召回率显著改善。

2.1.2 序列建模与时间依赖性捕捉(LSTM/Transformer)

金融用户的行为本质上是一个时间序列过程,每一次操作都可能是未来风险事件的前兆。因此,能否准确建模时间依赖性成为风控系统成败的关键。DeepSeek在此方面同时支持LSTM与Transformer两种先进架构,根据不同场景需求灵活选择。

LSTM因其门控机制(遗忘门、输入门、输出门)能够选择性地保留长期依赖信息,在处理较短行为序列(<100步)时表现优异。例如,在反欺诈场景中,分析用户过去一周内的登录地点跳转轨迹,LSTM可以有效识别出“深夜多地快速切换”的可疑模式。

然而,当序列长度增长或存在远距离依赖时,LSTM受限于递归结构导致的信息衰减问题。此时,Transformer凭借自注意力机制展现出更强优势。它通过计算序列内部所有位置间的相关性权重,实现全局上下文感知,且天然支持并行计算,大幅提升训练效率。

在DeepSeek的实际应用中,采用了一种“分段注意力+局部RNN”的折中方案:对于高频低延迟场景(如支付拦截),使用轻量级LSTM实现实时响应;而对于离线建模任务(如团伙挖掘),则启用Transformer-large结构进行深度分析。

下表对比了两种架构在典型风控任务中的性能差异:

| 指标 | LSTM | Transformer |

|---|---|---|

| 最大有效序列长度 | ~200步 | >1000步 |

| 训练速度(相对) | 1x | 0.8x(预热慢) |

| 推理延迟 | 低(适合边缘部署) | 较高(需优化) |

| 对长程依赖建模能力 | 中等 | 强 |

| 参数量 | 小 | 大 |

| 是否支持并行训练 | 否 | 是 |

下面展示一个基于Transformer的时间序列编码器实现:

from torch.nn import TransformerEncoder, TransformerEncoderLayer

class TimeSeriesEncoder(nn.Module):

def __init__(self, feat_dim, n_heads, n_layers, d_model, seq_len):

super().__init__()

self.embedding = nn.Linear(feat_dim, d_model)

self.pos_encoder = PositionalEncoding(d_model, seq_len)

encoder_layer = TransformerEncoderLayer(

d_model=d_model,

nhead=n_heads,

dim_feedforward=512,

dropout=0.1

)

self.transformer = TransformerEncoder(encoder_layer, n_layers)

self.output_proj = nn.Linear(d_model, 1)

def forward(self, x):

# x: [B, T, F]

x = self.embedding(x) * math.sqrt(self.d_model) # [B, T, D]

x = self.pos_encoder(x) # 加入位置信息

x = x.permute(1, 0, 2) # 转置为 [T, B, D]

attn_out = self.transformer(x) # 自注意力编码

cls_token = attn_out[0] # 取第一token作为聚合表示

return self.output_proj(cls_token).sigmoid()

逻辑分析:

- 使用 Linear 层将原始特征映射到统一维度 d_model ,便于后续处理。

- 引入 PositionalEncoding 解决Transformer无序性问题,确保时间先后关系被保留。

- TransformerEncoderLayer 定义单层编码结构,包含多头注意力与前馈网络。

- 整体堆叠 n_layers 层形成深层结构,增强抽象能力。

- 最终取序列首位(类CLF token)作为全局表示,简化下游任务接口。

该模块已应用于某大型支付平台的实时交易评分系统,平均响应时间控制在15ms以内,AUC达0.934。

2.1.3 多模态输入融合机制设计

现代金融风控系统面临的数据来源日益多样化,除传统结构化字段外,还包括文本描述、图像验证码、设备日志、通话录音等多种模态。单一模型难以统一处理这些异构信息,因此DeepSeek构建了标准化的多模态融合管道。

其核心思想是“先编码后融合”:每个模态独立通过专用编码器提取高层语义特征,随后在共享隐空间中进行加权融合。融合方式包括简单的拼接、注意力加权、门控机制等,视任务复杂度而定。

例如,在贷款申请审核中,系统需同时分析:

- 结构化数据:年龄、月收入、征信分数;

- 文本数据:工作单位描述、借款用途说明;

- 图像数据:身份证照片清晰度、人脸识别一致性;

- 日志数据:APP停留时长、页面跳转路径。

每种模态分别通过如下方式处理:

- 结构化 → Embedding Lookup + MLP

- 文本 → BERT-based Sentence Encoder

- 图像 → ResNet-18 Feature Extractor

- 日志 → LSTM Sequence Encoder

然后通过跨模态注意力机制实现动态融合:

class CrossModalAttention(nn.Module):

def __init__(self, dim):

super().__init__()

self.query_proj = nn.Linear(dim, dim)

self.key_proj = nn.Linear(dim, dim)

self.value_proj = nn.Linear(dim, dim)

self.scale = dim ** -0.5

def forward(self, queries, keys, values):

Q = self.query_proj(queries) # [B, N_q, D]

K = self.key_proj(keys) # [B, N_k, D]

V = self.value_proj(values) # [B, N_v, D]

attn_weights = (Q @ K.transpose(-2,-1)) * self.scale # [B, N_q, N_k]

attn_weights = attn_weights.softmax(dim=-1)

return attn_weights @ V # [B, N_q, D]

此机制允许模型根据当前上下文动态调整各模态的重要性权重,例如在疑似伪造证件场景中自动提升图像模态的贡献度。

2.2 特征工程与高维数据表示学习

2.2.1 用户行为序列的嵌入编码方法

在深度风控系统中,原始行为日志(如点击流、交易流水)往往以离散事件形式存在,不具备直接输入神经网络所需的数值连续性。为此,DeepSeek采用嵌入编码(Embedding Encoding)技术将稀疏符号转化为稠密向量。

以“登录设备类型”为例,原始取值为{“iOS”, “Android”, “Web”},通过查找表映射为64维向量。更进一步,对于行为序列(如最近10次交易类型),采用“序列嵌入+池化”策略生成固定长度表示:

class BehaviorEmbedding(nn.Module):

def __init__(self, vocab_size, embed_dim=64):

super().__init__()

self.embedding = nn.Embedding(vocab_size, embed_dim)

self.pooling = nn.AdaptiveAvgPool1d(1) # 全局平均池化

def forward(self, seq_indices): # [B, T]

emb = self.embedding(seq_indices) # [B, T, D]

pooled = self.pooling(emb.transpose(1,2)) # [B, D, 1]

return pooled.squeeze(-1) # [B, D]

该方法在大规模数据集上验证,相比独热编码+FPCA降维,F1-score提升12.6%。

2.2.2 图神经网络在关系网络挖掘中的作用

金融欺诈常以团伙形式出现,仅分析个体特征易遗漏关联线索。DeepSeek引入图神经网络(GNN)建模用户间的关系网络。

设用户为节点$v_i$,共用设备、相同收款账户等为边$e_{ij}$,通过GraphSAGE或GAT算法更新节点表示:

h_v^{(k)} = \sigma\left(W \cdot \text{CONCAT}\left(h_v^{(k-1)}, \text{AGGREGATE}({h_u^{(k-1)} | u \in \mathcal{N}(v)})\right)\right)

实验表明,在电信诈骗识别任务中,加入GNN模块后团伙发现率提高38%。

2.2.3 非结构化数据(如文本、日志)的语义提取

利用预训练语言模型(如BERT)对客服工单、投诉内容进行情感与意图分析,辅助判断用户还款意愿。

from transformers import AutoTokenizer, AutoModel

tokenizer = AutoTokenizer.from_pretrained("bert-base-chinese")

model = AutoModel.from_pretrained("bert-base-chinese")

def get_text_embedding(texts):

inputs = tokenizer(texts, padding=True, truncation=True, return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

return outputs.last_hidden_state[:, 0, :] # [CLS] token

2.3 不平衡分类问题与损失函数设计

2.3.1 样本不均衡下的过拟合抑制策略

金融风控中正负样本比例常达1:100甚至更低。为避免模型偏向多数类,DeepSeek采用以下策略:

- 分层采样(Stratified Sampling)

- 过采样SMOTE与欠采样Tomek Links结合

- 类别权重调整: weight = inverse_freq

2.3.2 Focal Loss与代价敏感学习的应用

标准交叉熵损失在难例上梯度较小,Focal Loss通过聚焦因子$\alpha_t(1-p_t)^\gamma$增强难样本影响力:

class FocalLoss(nn.Module):

def __init__(self, alpha=1, gamma=2):

super().__init__()

self.alpha = alpha

self.gamma = gamma

def forward(self, preds, targets):

ce_loss = F.cross_entropy(preds, targets, reduction='none')

pt = torch.exp(-ce_loss)

focal_loss = self.alpha * (1-pt)**self.gamma * ce_loss

return focal_loss.mean()

在反洗钱场景中,Focal Loss使Recall@Precision=0.9提升19.4%。

2.3.3 模型输出的概率校准技术

原始模型输出常存在置信度偏差,采用Platt Scaling或Isotonic Regression进行后处理校准,确保P(Y=1)真实反映违约概率。

3. DeepSeek风控系统的工程实现路径

金融风控系统在从理论模型走向生产落地的过程中,面临的核心挑战并非仅来自算法精度的提升,更多来自于工程层面的复杂性——如何高效处理海量异构数据、保障模型推理的低延迟响应、确保服务高可用与可扩展,并实现模型全生命周期的自动化管理。DeepSeek风控系统通过构建一套端到端的工程化架构,打通了从数据采集、特征计算、模型训练到实时决策的服务链路。本章将深入剖析其工程实现的关键技术路径,重点聚焦于三大核心模块:数据管道的构建与实时处理框架、模型训练与部署一体化流程、以及实时推理引擎与低延迟决策链路的设计。

3.1 数据管道的构建与实时处理框架

在现代金融风控场景中,用户行为、交易记录、设备信息等数据以毫秒级频率持续产生,传统批处理模式已无法满足对风险事件的即时识别需求。因此,构建一个具备高吞吐、低延迟、强一致性的实时数据管道成为系统设计的基础。DeepSeek采用“Kafka + Flink + Feature Store”三层架构,实现了从原始日志到可用特征的无缝流转。

3.1.1 基于Kafka+Flink的流式数据接入方案

为应对每秒数十万笔交易请求带来的数据洪流,DeepSeek引入Apache Kafka作为统一的消息中间件,承担数据采集与缓冲的核心职责。所有前端业务系统(如支付网关、信贷申请平台)产生的结构化事件(如登录、转账、绑卡)均通过标准化协议写入Kafka Topic,按主题分类进行分区存储,支持横向扩展和容错机制。

在此基础上,使用Apache Flink作为流式计算引擎,对接Kafka数据源,执行复杂的窗口聚合、状态管理与事件时间处理逻辑。Flink的Exactly-Once语义保证了即使在节点故障情况下也不会丢失或重复处理关键风控信号。

以下是一个典型的Flink作业代码片段,用于实时统计用户在过去5分钟内的交易失败次数:

// 定义Kafka Source

Properties kafkaProps = new Properties();

kafkaProps.setProperty("bootstrap.servers", "kafka-broker:9092");

kafkaProps.setProperty("group.id", "risk_feature_group");

FlinkKafkaConsumer<TransactionEvent> kafkaSource =

new FlinkKafkaConsumer<>("transaction_log", new TransactionDeserializationSchema(), kafkaProps);

// 构建执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.enableCheckpointing(5000); // 每5秒做一次checkpoint,保障状态一致性

// 从Kafka读取数据流

DataStream<TransactionEvent> transactionStream = env.addSource(kafkaSource);

// 提取事件时间并分配水位线(Watermark)

DataStream<TransactionEvent> withTimestampsAndWatermarks = transactionStream

.assignTimestampsAndWatermarks(WatermarkStrategy

.<TransactionEvent>forBoundedOutOfOrderness(Duration.ofSeconds(10))

.withTimestampAssigner((event, timestamp) -> event.getTimestamp()));

// 按用户ID分组,滑动窗口统计失败交易数

SingleOutputStreamOperator<UserFailureCount> failureCounts = withTimestampsAndWatermarks

.keyBy(TransactionEvent::getUserId)

.window(SlidingEventTimeWindows.of(Time.minutes(5), Time.minutes(1)))

.allowedLateness(Time.minutes(2)) // 允许迟到2分钟的数据参与计算

.aggregate(new FailureCountAggregator());

// 输出结果至下游Redis或Kafka

failureCounts.addSink(new RedisSink<>(new RedisFailureCountMapper()));

逐行逻辑分析与参数说明:

- 第1–7行:配置Kafka消费者属性,指定Broker地址和消费者组ID,避免多个实例消费同一份数据。

- 第9–10行:创建Flink执行环境并启用周期性CheckPoint,这是保障Exactly-Once语义的前提条件。

- 第13行:

assignTimestampsAndWatermarks方法为每条事件打上时间戳,并设置乱序容忍窗口(10秒),防止因网络延迟导致的时间错乱问题。 - 第18行:使用

SlidingEventTimeWindows定义滑动窗口,每分钟滚动一次,每次覆盖最近5分钟的数据,适合动态监控类指标。 - 第19行:

allowedLateness允许少量迟到数据进入窗口重新计算,提升结果准确性。 - 第20行:

FailureCountAggregator是一个自定义的增量聚合函数,仅维护计数器状态,降低内存开销。 - 第23行:将聚合结果写入Redis缓存,供在线推理服务快速查询。

该架构的优势在于解耦了数据生产与消费过程,同时利用Flink的状态后端(State Backend)自动管理中间状态,即使任务重启也能恢复历史上下文。此外,Kafka的持久化能力使得整个数据链路具备重放能力,便于调试与回溯。

| 组件 | 角色定位 | 吞吐量(峰值) | 延迟(P99) | 可靠性保障 |

|---|---|---|---|---|

| Kafka | 数据接入层 | 1M+ records/s | <10ms | 多副本复制,ISR机制 |

| Flink | 流处理引擎 | 500K events/s | <200ms | Checkpoint + Savepoint |

| Redis | 特征缓存 | 200K ops/s | <5ms | 主从同步,AOF持久化 |

此表展示了各组件在实际压测环境下的性能表现,表明该组合能够支撑大规模金融场景下的实时特征更新需求。

3.1.2 特征存储与在线特征服务的设计

模型依赖高质量、低延迟的特征输入才能做出准确判断。然而,许多特征具有较长的计算周期(如用户近30天平均交易金额),若每次请求都现场计算将极大增加响应时间。为此,DeepSeek设计了一套分层特征服务体系,包含离线特征仓库、近实时特征集市与在线特征服务三部分。

离线特征仓库 基于Hive + Spark构建,每日定时运行ETL任务生成长期统计特征,例如:

- 用户历史逾期次数

- 设备关联账户数

- 地址变更频率

这些特征通过Airflow调度,输出至Parquet格式文件,归档于数据湖中,主要用于模型训练阶段。

近实时特征集市 由Flink实时作业驱动,更新周期为1~5分钟,涵盖短时行为模式:

- 最近1小时登录尝试次数

- 近10笔交易金额标准差

- 同一IP下多用户活跃度

这类特征通过Flink写入Redis Cluster或RocksDB,支持毫秒级访问。

在线特征服务(Online Feature Service) 是连接模型与特征存储的桥梁。它对外提供gRPC接口,接收 user_id 、 timestamp 等键值,返回预组装的特征向量。服务内部集成缓存失效策略、降级开关与熔断机制,在依赖组件异常时仍能返回近似值或默认特征。

示例API调用如下:

service FeatureService {

rpc GetFeatures (FeatureRequest) returns (FeatureResponse);

}

message FeatureRequest {

string user_id = 1;

int64 request_time = 2; // Unix timestamp in milliseconds

repeated string feature_names = 3; // 明确指定所需特征

}

message FeatureResponse {

map<string, double> features = 1;

bool success = 2;

string error_msg = 3;

}

当模型服务发起请求时,特征服务会并行查询Redis、MySQL及远程OLAP数据库,整合结果后返回。对于缺失特征,系统采用前值填充或全局均值替代策略,避免中断推理流程。

为了评估特征服务的稳定性,团队建立了SLA监控体系:

| 指标 | 目标值 | 实际达成 | 监控方式 |

|---|---|---|---|

| 平均响应延迟 | ≤50ms | 42ms | Prometheus + Grafana |

| 请求成功率 | ≥99.95% | 99.97% | 日志采样统计 |

| 缓存命中率 | ≥90% | 93% | Redis INFO命令解析 |

| 特征新鲜度偏差 | ≤3min | 2.1min | 时间戳比对 |

通过定期压测与混沌测试验证系统韧性,确保在突发流量下仍能稳定输出。

3.1.3 数据质量监控与异常检测机制

数据是风控系统的生命线,一旦输入存在脏数据、缺失字段或分布偏移,可能导致模型误判甚至系统崩溃。DeepSeek建立了一套多层次的数据质量监控体系,贯穿从源头接入到特征输出的全流程。

首先,在Kafka接入层部署Schema Registry,强制要求所有消息遵循Avro或Protobuf规范,拒绝非法格式数据流入。其次,在Flink作业中嵌入轻量级校验算子,例如:

.map(event -> {

if (event.getAmount() < 0 || event.getUserId().isEmpty()) {

LOG.warn("Invalid event detected: {}", event);

return null; // 过滤掉无效记录

}

return event;

}).filter(Objects::nonNull)

此类规则可拦截明显异常值,防止污染后续计算。

更进一步,系统引入 统计型异常检测模块 ,定期分析关键字段的分布变化。例如,使用KL散度(Kullback-Leibler Divergence)比较当前批次与历史基准之间的数值分布差异:

D_{KL}(P | Q) = \sum_i P(i) \log \frac{P(i)}{Q(i)}

其中 $P$ 表示当前分布,$Q$ 表示参考分布。当KL散度超过阈值(如0.15)时触发告警,提示可能存在数据漂移或上游系统变更。

此外,还建立了自动化数据血缘追踪系统,记录每个特征的来源路径、转换逻辑与时效性标签。一旦某个特征出现异常波动,可通过血缘图快速定位上游环节。

| 异常类型 | 检测方法 | 响应动作 | 负责人 |

|---|---|---|---|

| 字段缺失 | 百分比下降 >5% | 自动告警 + 邮件通知 | 数据工程师 |

| 分布偏移 | KL散度 >0.15 | 暂停模型推理,启用备用特征 | MLOps团队 |

| 值域越界 | 超出3σ范围 | 记录日志,标记可疑样本 | 风控分析师 |

| 更新延迟 | 特征未按时刷新 | 触发重试机制,切换降级源 | SRE |

这套机制显著提升了系统的鲁棒性,使数据质量问题可在10分钟内被发现并干预,大幅降低了因数据错误引发的风险漏报概率。

3.2 模型训练与部署一体化流程

深度学习模型的有效性不仅取决于算法本身,更依赖于高效的训练基础设施与可靠的部署机制。DeepSeek构建了一套集版本控制、分布式训练、自动化测试于一体的CI/CD流水线,实现了“提交代码 → 自动训练 → 在线部署”的无缝衔接。

3.2.1 分布式训练平台的搭建(PyTorch+Horovod)

面对亿级参数规模的深度神经网络,单机训练已无法满足迭代效率需求。DeepSeek采用PyTorch作为基础框架,结合Uber开源的Horovod实现跨GPU节点的分布式训练。

Horovod基于Ring-AllReduce通信算法,在保持高带宽利用率的同时减少了梯度同步开销。其核心优势在于简单易用,开发者只需添加几行代码即可完成并行化改造:

import torch

import horovod.torch as hvd

# 初始化Horovod

hvd.init()

# 将模型移动到GPU

device = torch.device(f'cuda:{hvd.local_rank()}')

model = Net().to(device)

# 使用DistributedDataParallel包装模型

optimizer = torch.optim.Adam(model.parameters())

optimizer = hvd.DistributedOptimizer(optimizer, named_parameters=model.named_parameters())

# 设置随机种子,确保不同进程初始化一致

torch.manual_seed(42)

if torch.cuda.is_available():

torch.cuda.set_device(device)

torch.cuda.manual_seed_all(42)

# 每个worker加载对应的数据子集

train_sampler = torch.utils.data.distributed.DistributedSampler(

train_dataset, num_replicas=hvd.size(), rank=hvd.rank()

)

train_loader = DataLoader(train_dataset, batch_size=64, sampler=train_sampler)

逐行解释与参数说明:

hvd.init():启动Horovod运行时,建立MPI通信环。hvd.local_rank():获取当前GPU本地编号,用于绑定设备。hvd.DistributedOptimizer:封装优化器,自动处理梯度在各节点间的AllReduce操作。DistributedSampler:确保每个Worker读取不重叠的数据块,避免重复训练。

在实际部署中,系统配置了8台服务器,每台配备4张NVIDIA A100 GPU,总计32卡并行训练。实测结果显示,相比单卡训练,整体速度提升约28倍,且收敛稳定性良好。

| 训练配置 | 单机(4卡) | 集群(32卡) | 加速比 |

|---|---|---|---|

| Batch Size / GPU | 64 | 64 | - |

| Total Batch Size | 256 | 2048 | - |

| Epoch时间 | 45 min | 9.6 min | 4.7x |

| 全程训练耗时 | 12h | 2.5h | 4.8x |

值得注意的是,大batch size可能影响泛化能力,因此采用了 Learning Rate Scaling Rule :初始学习率随总batch size线性增长,并辅以warm-up策略平稳过渡。

3.2.2 模型版本管理与A/B测试框架

为避免新模型上线直接替换旧模型带来的不可控风险,DeepSeek实施严格的模型版本管理制度。每个训练产出的模型被打包为独立镜像,包含代码、权重、依赖库及元数据(如训练数据版本、评价指标、负责人信息),存储于私有Model Registry中。

模型上线前需经过三级评审:

1. 离线评估 :在保留测试集上对比AUC、KS、Precision@TopK等指标;

2. 影子流量验证 :新模型与线上模型并行运行,输入相同请求,输出差异被记录分析;

3. A/B测试 :按用户比例分流,观察真实业务指标(如坏账率、通过率)变化。

A/B测试框架支持灵活配置分流策略:

experiment:

name: "credit_risk_v3_vs_v2"

traffic_ratio: 0.1 # 10%流量进入实验组

allocation_key: "user_id" # 按用户ID哈希分流,保证同用户始终走同一模型

variants:

control:

model_version: "v2.3.1"

weight: 0.9

treatment:

model_version: "v3.0.0"

weight: 0.1

实验期间,系统持续收集两类数据:

- 模型输出指标 :风险评分分布、拒绝率、置信区间

- 业务结果反馈 :最终是否违约、人工复核结论

通过双样本t检验判断差异显著性,只有当p-value < 0.05且业务指标正向时才允许全量发布。

3.2.3 模型服务化封装(TensorFlow Serving / TorchServe)

训练完成的模型需转化为可调用的服务接口。DeepSeek根据模型类型选择不同的服务化工具:

- TensorFlow模型 :使用TensorFlow Serving,支持PB格式模型加载,内置RESTful/gRPC双协议。

- PyTorch模型 :采用TorchServe,提供高性能推理容器,支持动态批处理(Dynamic Batching)。

以TorchServe为例,打包命令如下:

torch-model-archiver \

--model-name risk_classifier \

--version 1.0 \

--model-file model.py \

--serialized-file checkpoints/model_v3.pt \

--handler custom_handler.py \

--extra-files config.json,labels.txt

其中 custom_handler.py 定义了预处理、推理、后处理逻辑:

def handle(self, data, context):

input_tensor = self.preprocess(data)

with torch.no_grad():

output = self.model(input_tensor)

return self.postprocess(output)

服务启动后可通过HTTP接口调用:

POST /predictions/risk_classifier HTTP/1.1

Content-Type: application/json

{

"features": [0.23, 1.45, ..., 0.88]

}

响应返回风险评分及置信度:

{

"risk_score": 0.872,

"category": "high",

"inference_time_ms": 18.3

}

该服务支持自动扩缩容,结合Kubernetes HPA(Horizontal Pod Autoscaler)根据QPS动态调整Pod数量,确保高峰期不丢请求。

3.3 实时推理引擎与低延迟决策链路

在高频交易、实时反欺诈等场景中,风控决策必须在毫秒级别完成。DeepSeek构建了多层优化的推理引擎,涵盖批处理调度、边缘计算协同与缓存一致性机制,确保端到端延迟控制在50ms以内。

3.3.1 推理请求的批处理与异步调度

尽管单个推理耗时较短(约10–20ms),但在高并发下频繁的小请求会造成GPU利用率低下。为此,系统启用 动态批处理(Dynamic Batching) 技术,将短时间内到达的多个请求合并为一个批次送入模型,显著提升吞吐。

TorchServe原生支持该功能,配置如下:

# config.properties

engine = Torch

batch_size = 32

max_batch_delay = 5 # 最多等待5ms积累足够请求

number_of_netty_threads = 4

这意味着系统会在收到第一个请求后最多等待5ms,若期间累计达到32个请求则立即触发推理;否则超时后也强制执行。

测试数据显示,开启批处理后QPS从1,200提升至4,800,GPU利用率从35%升至82%,资源效益大幅提升。

此外,对于非关键路径的异步任务(如模型解释、审计日志写入),系统采用Kafka+Worker架构异步处理,避免阻塞主决策链路。

3.3.2 边缘计算节点在高频场景的应用

针对移动端App或IoT设备发起的高频操作(如扫码支付、小额免密),中心化风控存在地理延迟瓶颈。为此,DeepSeek在部分地区部署了 边缘推理节点 ,将轻量化模型(如TinyBERT、MobileNetV3)下沉至CDN边缘机房。

边缘节点具备以下特点:

- 模型体积小于50MB,推理耗时<10ms

- 支持离线运行,在网络中断时启用本地规则兜底

- 定期从中心拉取模型更新,采用差分升级减少带宽消耗

典型部署拓扑如下:

[User Device]

↓ HTTPS

[Edge Node (Shanghai)] → [Central Model Service]

↓ 决策结果上报

[Kafka] → [Audit & Feedback Pipeline]

这种架构将上海用户的平均决策延迟从68ms降至23ms,特别适用于对体验敏感的消费金融产品。

3.3.3 决策结果缓存与回写一致性保障

某些用户的行为具有高度重复性(如每日固定时间通勤乘车),其风险特征短期内不会剧烈变动。对此类请求,系统启用 LRU缓存机制 ,将最近一段时间内的决策结果暂存于Redis中。

缓存键设计为 user_id:request_type:context_hash ,有效期设为2分钟。当相同请求再次到达时,优先检查缓存是否存在有效条目,若有则直接返回,避免重复计算。

但需警惕缓存与实时状态的不一致问题。例如,用户刚被加入黑名单,但缓存仍在返回旧结果。为此,系统建立了 事件驱动的缓存失效机制 :

def on_blacklist_update(user_id):

pattern = f"decision_cache:{user_id}:*"

keys = redis_client.keys(pattern)

if keys:

redis_client.delete(*keys)

logger.info(f"Cache cleared for user {user_id}")

每当黑名单更新事件发生时,立即清除该用户的所有相关缓存项,确保安全边界不失效。

同时,所有缓存命中与未命中的请求均写入ClickHouse用于后续分析,帮助识别热点用户与潜在攻击模式。

综上所述,DeepSeek风控系统的工程实现路径充分融合了大数据、分布式系统与机器学习工程的最佳实践,形成了一个高可靠、低延迟、易维护的自动化决策体系,为金融业务的安全运行提供了坚实支撑。

4. DeepSeek在典型金融场景中的落地实践

金融风控的真正价值不仅体现在理论模型的先进性,更在于其能否在复杂、高并发、强监管的真实业务场景中稳定运行并创造实际效益。DeepSeek作为一套集成了深度学习、图神经网络与实时流处理能力的智能风控系统,在信贷审批、支付拦截和反洗钱监测等多个核心金融领域实现了规模化落地。这些应用场景各具特点:有的强调毫秒级响应,如支付交易;有的依赖长期行为建模与多维关系挖掘,如团伙欺诈识别;还有的需要满足严格的合规审计要求,如反洗钱报告生成。本章将深入剖析DeepSeek如何针对不同业务需求定制技术路径,并通过工程优化与算法创新实现从“可用”到“可靠”的跨越。

4.1 信贷审批自动化中的全流程风控集成

信贷业务是金融机构最基础也是风险最高的服务之一。传统信贷审批流程通常依赖人工审核、静态评分卡和简单规则引擎,难以应对大规模用户申请、新型欺诈手段以及动态变化的信用环境。DeepSeek通过构建端到端的自动化风控闭环,实现了从客户准入、反欺诈检测、信用评估到额度定价的全链路智能化决策支持。该体系不仅提升了审批效率,还将不良率控制在可接受范围内,显著降低了运营成本。

4.1.1 申请反欺诈识别(设备指纹、IP聚类)

在信贷申请初期,首要任务是识别潜在的虚假身份或批量注册行为。DeepSeek采用多维度设备指纹技术结合IP地址聚类分析,有效识别黑产操控的异常账户。

设备指纹采集涵盖硬件信息(如IMEI、MAC地址)、操作系统特征、浏览器指纹(User-Agent、Canvas渲染差异)、地理位置轨迹等超过50个维度的数据。这些数据通过SDK嵌入前端应用进行无感收集,并经由Kafka传输至Flink实时计算引擎进行聚合处理。

# 示例:设备指纹去重与相似度匹配逻辑

import hashlib

from sklearn.cluster import DBSCAN

import pandas as pd

def generate_device_fingerprint(row):

"""

根据设备特征生成标准化指纹哈希

参数说明:

- row: 包含设备属性的字典或DataFrame行

返回值:32位MD5哈希字符串

"""

fingerprint_str = "|".join([

str(row.get("os_version", "")),

str(row.get("device_model", "")),

str(row.get("screen_resolution", "")),

str(row.get("timezone", "")),

str(row.get("language", ""))

])

return hashlib.md5(fingerprint_str.encode()).hexdigest()

# 假设已有设备日志数据集

df_logs = pd.read_csv("device_log.csv")

df_logs["fingerprint"] = df_logs.apply(generate_device_fingerprint, axis=1)

# 使用DBSCAN对IP地址进行空间聚类,发现集中登录行为

ip_coords = df_logs[['ip_lat', 'ip_lon']].values

clustering = DBSCAN(eps=0.01, min_samples=5).fit(ip_coords)

df_logs["ip_cluster_id"] = clustering.labels_

# 输出属于同一设备指纹且在同一IP簇内的可疑记录

suspicious_group = df_logs.groupby(["fingerprint", "ip_cluster_id"]).filter(

lambda x: len(x) >= 3

)

代码逻辑逐行解读:

- 第6–15行定义

generate_device_fingerprint函数,将多个设备属性拼接后生成唯一哈希值,用于标识设备。 - 第18行读取原始设备日志数据,包含时间戳、IP、设备型号等字段。

- 第19行调用函数为每条记录生成设备指纹,实现跨会话追踪。

- 第22–23行提取IP经纬度坐标,使用DBSCAN聚类算法识别地理上密集出现的IP群组,常用于暴露代理池或机房出口IP。

- 第26–29行筛选出同时具备相同设备指纹和IP簇的记录,若数量≥3则标记为高危群体,可能为批量注册工具操作。

| 特征类型 | 数据来源 | 风险识别作用 | 更新频率 |

|---|---|---|---|

| 硬件指纹 | 移动端SDK | 判断是否模拟器/刷机设备 | 实时 |

| 浏览器Canvas | Web JS采集 | 检测自动化脚本绕过 | 每次访问 |

| IP归属地 | MaxMind GeoIP数据库 | 发现高危地区集中登录 | 每小时更新 |

| 网络运营商 | APN信息 | 区分家庭宽带与数据中心流量 | 实时 |

| 行为序列熵 | 用户点击流分析 | 评估操作自然性 | 毫秒级滑动窗口 |

此模块已在某消费金融平台上线,成功拦截了日均约7%的虚假申请,其中包含大量使用虚拟机+动态IP组合的黑产攻击,准确率达92.3%,误报率低于0.8%。

4.1.2 收入与还款能力预测模型实战

信贷审批的核心是对申请人未来偿债能力的预判。DeepSeek构建了一个融合多源数据的收入预测模型,突破传统仅依赖工资流水的局限。

模型输入包括:

- 银行流水 :月均流入、固定支出占比、现金流波动系数;

- 第三方支付账单 :美团、滴滴等平台消费频次与金额分布;

- 社交活跃度 :微信联系人数量、朋友圈发布频率(经用户授权);

- 职业标签 :通过简历文本NLP解析所得行业、职级概率分布。

采用Transformer架构对时间序列收入事件进行编码,捕捉非线性收入模式(如自由职业者季节性收入)。模型输出为连续型收入估计值及置信区间。

import torch

import torch.nn as nn

from transformers import BertModel

class IncomePredictor(nn.Module):

def __init__(self, input_dim=128, hidden_dim=256):

super().__init__()

self.embedding = nn.Linear(input_dim, hidden_dim)

self.transformer = BertModel.from_pretrained("bert-base-uncased")

self.regressor = nn.Sequential(

nn.Dropout(0.3),

nn.Linear(hidden_dim, 1)

)

def forward(self, x, attention_mask=None):

# x.shape: [batch_size, seq_len, input_dim]

embedded = self.embedding(x) # 投影到Bert兼容维度

outputs = self.transformer(

inputs_embeds=embedded,

attention_mask=attention_mask

)

cls_output = outputs.last_hidden_state[:, 0, :] # 取[CLS]向量

income_pred = self.regressor(cls_output)

return income_pred

# 训练参数设置

model = IncomePredictor()

optimizer = torch.optim.AdamW(model.parameters(), lr=3e-5)

criterion = nn.MSELoss()

# 执行逻辑说明:

# - 输入为长度为T的时间片段,每个时刻包含n维财务特征

# - Transformer自动学习跨时间段的依赖关系,例如奖金发放周期

# - 最终回归头输出预测年收入(万元)

参数说明与扩展分析:

inputs_embeds: 允许直接传入数值型特征矩阵,避免词表限制;attention_mask: 屏蔽padding位置,防止无效数据干扰注意力权重;- 使用预训练BERT参数初始化,利用其强大的序列建模先验知识;

- 损失函数选用MSE,辅以Huber Loss提升对异常样本鲁棒性。

该模型在某线上借贷平台A/B测试中表现优异,相比传统逻辑回归模型,RMSE降低34.7%,尤其在自由职业者群体中预测偏差减少近50%。

4.1.3 动态额度调整与利率定价联动机制

授信不是一次性决策,而应随用户行为动态演化。DeepSeek设计了一套基于强化学习的额度-利率联合优化系统。

系统框架如下表所示:

| 组件 | 功能描述 | 技术实现 |

|---|---|---|

| 状态编码器 | 将用户历史行为编码为状态向量 | GRU + Attention Pooling |

| 奖励函数 | 综合逾期率、利润贡献、留存率设计复合奖励 | 加权求和:R = αP - βD + γL |

| 动作空间 | 额度增减档位(±10%, ±20%)与利率浮动区间 | 离散动作集合 |

| 策略网络 | 输出最优动作概率分布 | PPO算法 |

| 模拟环境 | 回放历史策略执行结果以训练策略 | 基于真实数据构建反事实推断 |

系统每日凌晨触发一次批量评估,对百万级活跃用户进行策略推荐,并通过灰度发布验证效果。实验结果显示,在保持整体坏账率不变的前提下,人均利息收入提升18.2%,优质客户额度使用率提高23%。

4.2 支付交易实时拦截系统的构建

支付环节是资金流动的第一道防线,任何延迟都可能导致不可逆的资金损失。DeepSeek为此构建了毫秒级风险评分服务,能够在交易发起后的50ms内完成风险判定并返回拦截建议。

4.2.1 毫秒级风险评分服务的设计与压测

系统架构采用“边缘缓存 + 中心推理”双层结构。高频访问用户的特征预先加载至Redis集群,模型推理服务部署于GPU节点并通过Triton Inference Server优化批处理吞吐。

关键性能指标达成情况如下:

| 指标 | 目标值 | 实测值 | 达成方式 |

|---|---|---|---|

| 平均延迟 | <50ms | 42ms | 异步特征拉取+模型量化 |

| P99延迟 | <80ms | 76ms | 请求优先级队列调度 |

| QPS峰值 | 10,000 | 12,500 | 自适应批处理(dynamic batching) |

| 错误率 | <0.01% | 0.006% | 多副本容灾+熔断机制 |

核心推理服务代码节选:

// C++ gRPC服务端片段(简化版)

void RiskScoringServiceImpl::HandleRequest(RiskRequest* request) {

auto start_time = std::chrono::steady_clock::now();

// 1. 提取关键字段

std::string user_id = request->user_id();

double amount = request->amount();

// 2. 并行获取特征

auto future_feat = thread_pool->enqueue([user_id] {

return feature_cache->Get(user_id);

});

auto future_rules = rule_engine->Evaluate(*request);

// 3. 合并输入并调用模型

auto features = future_feat.get();

features.Add("tx_amount", amount);

auto model_input = CreateTensor(features);

float risk_score = triton_client->Infer(model_input);

// 4. 决策逻辑

bool should_block = risk_score > THRESHOLD || future_rules.block;

SendResponse(request->req_id(), risk_score, should_block);

auto latency = Elapsed(start_time);

metrics->Record(latency);

}

执行逻辑说明:

- 第7–8行提取交易基本信息;

- 第11–14行异步查询特征缓存和规则引擎结果,减少等待时间;

- 第17–18行构造张量输入,送入Triton托管的PyTorch模型;

- 第21行综合模型输出与规则判断做出最终决策;

- 第24–25行记录延迟指标用于监控告警。

压力测试采用Locust模拟真实流量模式,在持续1小时、平均每秒8000请求的压力下,系统稳定性良好,无内存泄漏或连接堆积现象。

4.2.2 黑产团伙识别与图谱关联分析案例

针对“一人多号”、“养号洗钱”等隐蔽性强的团伙作案,DeepSeek构建了基于图神经网络的关系挖掘系统。

构建的资金转移图谱包含以下节点与边类型:

| 节点类型 | 属性字段示例 |

|---|---|

| 用户账户 | 实名状态、注册渠道、设备指纹 |

| 银行卡 | 发卡行、绑定时间、交易限额 |

| IP地址 | 归属地、ASN编号、活跃时段 |

| 边类型 | 构建规则 |

|---|---|

| 共设备连接 | 两个账户在同一设备登录 |

| 资金转账 | 单笔≥500元且非亲属关系 |

| 共IP活动 | 同一公网IP下操作三个以上账户 |

使用GraphSAGE进行节点嵌入训练,再通过聚类发现异常子图。某次实际案例中,系统识别出一个由63个账户组成的环形转账网络,平均每日循环转账金额达270万元,最终确认为赌博平台洗钱通道。

4.2.3 误报反馈闭环与模型迭代优化

高精度拦截不可避免带来一定误报。DeepSeek建立了完整的误报反馈链路:用户申诉 → 人工复核 → 标注入库 → 模型增量训练。

每周自动触发一次增量训练任务,使用Focal Loss加强难样本学习:

\mathcal{L}_{focal} = -\alpha_t (1 - p_t)^\gamma \log(p_t)

其中 $\alpha=0.75$, $\gamma=2$,赋予低置信度正样本更高权重。经过三个月迭代,模型在相同召回率下误报率下降41%。

4.3 反洗钱监测中异常模式发现的应用

4.3.1 资金流向图谱的动态构建与剪枝

AML场景需处理超大规模交易网络。DeepSeek采用流式图构建策略,每笔交易实时插入Neo4j图数据库,并启用TTL机制自动清理过期节点。

为降低噪声干扰,实施三级剪枝策略:

- 阈值过滤 :单笔<100元且无频繁互转关系的边予以忽略;

- 社区压缩 :使用Louvain算法合并内部高度连通的小团体;

- 时间衰减 :边权重按 $w(t) = w_0 \cdot e^{-λt}$ 衰减,λ=0.05/day。

4.3.2 自监督学习用于未知模式探测

面对新型洗钱手法(如“跑分平台”),监督模型存在滞后性。引入对比学习框架SimCLR,对交易序列进行无标签预训练。

class TransactionEncoder(nn.Module):

def __init__(self, feat_dim=64):

self.gru = nn.GRU(feat_dim, 128, batch_first=True)

self.project_head = nn.Linear(128, 64)

def forward(self, x):

h, _ = self.gru(x)

return self.project_head(h[:, -1, :]) # 最后隐状态投影

# 对比损失计算

z_i = encoder(augment(tx1))

z_j = encoder(augment(tx2))

loss = -cosine_sim(z_i, z_j).log()

预训练后,使用K-means聚类发现6类异常模式,其中一类表现为“快进快出+小额分散收款”,经调查确认为电信诈骗赃款拆解路径。

4.3.3 监管报告自动生成与审计留痕功能

系统内置XBRL格式报告生成器,每月自动生成STR(可疑交易报告),内容包含:

- 涉案主体清单

- 关键路径可视化图

- 行为特征摘要(如“7日内跨省转账12次”)

所有决策过程记录于区块链存证系统,确保不可篡改,满足《反洗钱法》第23条留痕要求。

5. 金融风控自动化系统的持续演进与未来展望

5.1 模型生命周期管理与系统稳定性保障

在金融风控系统长期运行过程中,模型性能不可避免地受到数据分布变化(即“模型漂移”)的影响。为确保DeepSeek系统具备持续的高准确性与鲁棒性,必须建立完整的模型生命周期管理体系。该体系涵盖从监控、重训练到上线切换的闭环流程。

具体而言,模型漂移检测主要依赖于两类指标:

- 数据层面漂移 :通过统计检验(如KS检验、PSI群体稳定性指数)对比线上输入特征与训练集分布差异;

- 性能层面退化 :定期计算模型在验证集上的AUC、Precision@TopK、召回率等关键指标,并设定阈值触发告警。

以用户行为序列中的交易金额分布为例,可计算每月的PSI值:

import numpy as np

from scipy import stats

def calculate_psi(expected, actual, bins=10):

# expected: 历史基准分布(训练数据)

# actual: 当前实际分布(线上数据)

expected_hist, _ = np.histogram(expected, bins=bins)

actual_hist, _ = np.histogram(actual, bins=bins)

# 平滑处理避免log(0)

epsilon = 1e-8

expected_prob = (expected_hist + epsilon) / (sum(expected_hist) + epsilon)

actual_prob = (actual_hist + epsilon) / (sum(actual_hist) + epsilon)

psi_value = np.sum((actual_prob - expected_prob) * np.log(actual_prob / expected_prob))

return psi_value

# 示例调用

monthly_amounts_baseline = np.random.lognormal(mean=3, sigma=1, size=10000) # 训练期

monthly_amounts_current = np.random.lognormal(mean=3.2, sigma=1.1, size=8000) # 当前月

psi = calculate_psi(monthly_amounts_baseline, monthly_amounts_current)

print(f"PSI值: {psi:.4f}") # 若 >0.2,则判定为显著漂移

当PSI超过预设阈值(通常为0.2),系统将自动启动再训练任务。DeepSeek采用增量学习策略结合周期性全量更新机制,在保证时效性的同时避免灾难性遗忘。此外,所有模型版本均通过MLflow进行追踪,记录超参数、数据切片、评估结果及部署时间戳。

| 指标名称 | 阈值标准 | 监控频率 | 触发动作 |

|---|---|---|---|

| PSI | >0.2 | 每日 | 启动漂移分析 |

| AUC下降幅度 | >5% | 每周 | 进入候选重训队列 |

| 推理延迟P99 | >150ms | 实时 | 弹性扩容+降级预案触发 |

| 特征缺失率 | >10% | 每小时 | 数据源告警+备用特征启用 |

| 拒绝推断偏差 | KS > 0.3 | 每周 | 调整样本加权策略 |

系统还引入影子模式(Shadow Mode)进行灰度验证:新模型并行接收真实流量但不参与决策,输出结果用于离线比对,确认无异常后方可切流上线。

5.2 基于强化学习的风险策略动态调优

传统风控策略多基于静态规则或固定阈值,难以适应复杂多变的攻击手段。DeepSeek引入深度强化学习(DRL)框架,构建“环境-代理-奖励”结构,实现风险策略的自主进化。

设定状态空间 $ S $ 包括:

- 实时交易速率(TPS)

- 异常登录尝试次数

- 地域集中度指数(Gini系数)

- 最近N笔交易拒绝率

动作空间 $ A $ 定义为策略参数调整操作,例如:

- 提升设备指纹相似度阈值(+5%)

- 激活IP聚类关联拦截

- 下调单日转账限额等级

奖励函数 $ R $ 设计兼顾业务目标与风控目标:

R = \alpha \cdot (\text{欺诈拦截收益}) - \beta \cdot (\text{误拒损失}) - \gamma \cdot (\text{人工复核成本})

其中 $\alpha, \beta, \gamma$ 为可调节权重,反映不同阶段的运营优先级。

使用PPO(Proximal Policy Optimization)算法进行训练:

import torch

import gym

from stable_baselines3 import PPO

class RiskStrategyEnv(gym.Env):

def __init__(self):

super().__init__()

self.action_space = gym.spaces.Box(low=-1, high=1, shape=(3,))

self.observation_space = gym.spaces.Box(low=-np.inf, high=np.inf, shape=(12,))

def step(self, action):

# 执行策略调整,模拟一周效果

reward = simulate_policy_impact(action)

done = is_week_end()

return next_state, reward, done, {}

def reset(self):

return initial_state

# 训练代理

env = RiskStrategyEnv()

model = PPO("MlpPolicy", env, verbose=1, tensorboard_log="./ppo_risk_tensorboard/")

model.learn(total_timesteps=100000)

经过200轮迭代后,DRL代理能够在黑产攻击突增期间自动提升设备指纹匹配灵敏度,并在攻击结束后适时放松策略,减少正常用户干扰。

5.3 联邦学习与跨机构联合建模的合规实践

面对数据孤岛问题,DeepSeek探索联邦学习(Federated Learning)在反欺诈联盟中的应用。多个金融机构在不共享原始数据的前提下,协同训练全局模型。

典型架构如下:

- 各参与方本地训练包含客户行为特征的子模型

- 仅上传梯度或中间层表示至中心服务器

- 服务器聚合后下发更新后的全局模型

采用差分隐私(DP)保护上传梯度:

from opacus import PrivacyEngine

privacy_engine = PrivacyEngine()

model, optimizer, data_loader = privacy_engine.make_private(

module=model,

optimizer=optimizer,

data_loader=data_loader,

noise_multiplier=1.2,

max_grad_norm=1.0,

)

设置 $(\epsilon=2, \delta=1e-5)$ 的隐私预算,确保满足GDPR第25条“设计保护隐私”的要求。

同时,利用同态加密(HE)技术保障传输过程安全,防止中间节点窥探。实验表明,在三家银行组成的联盟中,联邦XGBoost模型相较单体模型将欺诈识别F1-score提升了17.6%,且每家机构的数据从未离开本地机房。

5.4 大模型与知识图谱融合的下一代可解释风控

为进一步提升风险归因能力,DeepSeek正研发基于大语言模型(LLM)的风险事件解读引擎。该系统接收结构化预警信号(如“账户突然向高危地区转账”),结合上下文生成自然语言解释报告。

示例提示工程模板:

你是一名资深风控分析师,请根据以下信息撰写一份不超过200字的风险摘要:

用户ID: U20938475

近期行为:

- 连续3天凌晨登录,IP归属地分别为新加坡、迪拜、乌克兰

- 单日发起12次跨境汇款,总额达$48,000

- 关联设备更换频繁,共绑定5台不同型号手机

- 收款方均为新注册商户,无历史交易记录

请指出潜在风险类型、可疑点及建议处置措施。

LLM返回内容可用于辅助人工复核,大幅缩短调查时间。更进一步,将LLM输出注入动态知识图谱,形成“事件→实体→关系→推理链”的可视化追溯路径。

未来发展方向包括:

1. 构建因果推理模块,区分相关性与因果性(如:是否真因是“设备更换”而非“夜间登录”);

2. 引入符号AI与神经网络混合架构,增强逻辑一致性;

3. 开发面向监管机构的自动合规审计接口,支持一键导出决策依据。

这种“可解释AI+知识图谱”的深度融合,标志着金融风控由“预测驱动”迈向“理解驱动”的新纪元。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)