多任务学习必读:超越Shared-Bottom,谷歌MMoE模型原理解析与实战优势

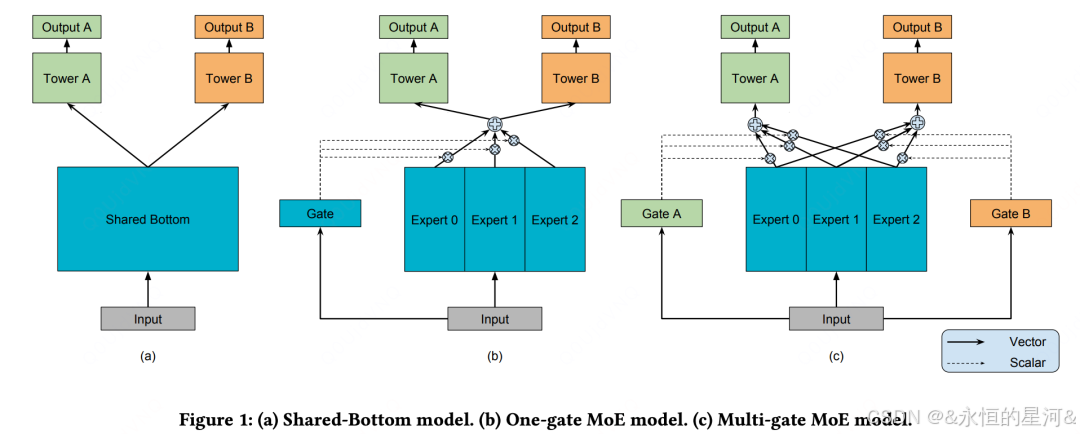

而Google在2018年提出的MMoE(Multi-gate Mixture-of-Experts)模型,通过引入多门控机制和专家网络,巧妙解决了这一难题。它不仅能够自动学习任务间的关联程度,还能根据输入特征动态调整参数共享策略,在保持计算效率的同时显著提升模型性能。接下来,我将深入对这篇论文展开全面解读。和以往一样,我会严格依照论文的结构框架,从研究背景、核心论点、实验设计到最终结论,逐一对文

论文地址:https://dl.acm.org/doi/pdf/10.1145/3219819.3220007

论文题目:Modeling Task Relationships in Multi-task Learning with Multi-gate Mixture-of-Experts

今天给大家分享一篇多任务学习模型架构MMoE。在推荐系统、用户画像等实际场景中,我们常常需要同时优化多个相关任务,比如在电商场景中既要预测点击率又要预测转化率。传统多任务学习采用硬参数共享的Shared-Bottom架构,但这类模型在任务间存在冲突或相关性较弱时往往表现不佳。而Google在2018年提出的MMoE(Multi-gate Mixture-of-Experts)模型,通过引入多门控机制和专家网络,巧妙解决了这一难题。它不仅能够自动学习任务间的关联程度,还能根据输入特征动态调整参数共享策略,在保持计算效率的同时显著提升模型性能。

接下来,我将深入对这篇论文展开全面解读。和以往一样,我会严格依照论文的结构框架,从研究背景、核心论点、实验设计到最终结论,逐一对文章的各个关键部分进行细致剖析 ,力求为大家呈现这篇时间序列预测论文的全貌,挖掘其中的研究价值与创新点。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)