【写给小白的LLM】把大模型当乐高玩:彻底搞懂AI的“积木”——Token(小白秒懂篇)

Token是大模型理解文本的最小单位,类似于"文字乐高块"。它可以是单词、标点、数字或子词,通过分词算法将文本转换为数字ID,再转化为向量供模型处理。Token数量影响AI算力成本、内容长度限制和回答质量。英文1token约0.75个单词,中文约1-2个汉字。了解Token有助于优化prompt、控制输出成本,并更好地使用AI工具。掌握Token概念是学习大模型的基础,也是提高AI应用效率的关键。

简介

Token是大模型理解文本的最小单位,类似于"文字乐高块"。它可以是单词、标点、数字或子词,通过分词算法将文本转换为数字ID,再转化为向量供模型处理。Token数量影响AI算力成本、内容长度限制和回答质量。英文1token约0.75个单词,中文约1-2个汉字。了解Token有助于优化prompt、控制输出成本,并更好地使用AI工具。掌握Token概念是学习大模型的基础,也是提高AI应用效率的关键。

相信你只要了解过大模型,就听过token这个词儿,大家在用ChatGPT的API时,是按token计费的。例如,你提问消耗了 100 token,ChatGPT根据你的输入,回答了200token,那么一共消费的 token 数就是 300。

有时候看一些偏技术的文章,一些模型后面带着8k、32k,甚至100k,这也是指模型能处理的蕞大token长度。

既然token在大模型领域这么高频出现,我们不禁要问:

什么是token?

它是怎么计算的?

一个token是指一个字吗?

中文和英文的token是一样的吗?

什么是Token?

大模型世界的最小积木——Token

Token =AI眼中的"文字乐高块",中文名称可译为“词元”,是AI理解文本的最小单位,就像人类阅读时自动拆分的“信息颗粒”,AI不是按字而是按token处理文本。就像乐高小块能拼出无限可能,大模型把文本拆成Token,再重组出智能回答~

大模型中的"token"是指文本的蕞小处理单位在大模型处理中,将文本划分为token是对文本进行分析和处理的基本步骤之一。

通常情况下,一个token可以是一个单词、一个标点符号、一个数字,或者是其他更小的文本单元,如子词或字符。

以下是不同token切分类型的介绍:

单词级token: 即token是按照单词进行划分的。一个句子中的每个单词通常都会成为一个独立的token。例如,在句子"我是智泊AI"中,“我”、"是”、"智泊AI"分别是三个单词级token.

标点符号级token: 除了单词,标点符号通常也作为独立的token存在。这是因为标点符号在语义和语法上都具有重要的作用。

例如,在句子"token好理解吗?“中,除了"token好理解吗"作为一个整体的token外:蕞后的问号”?"也是一个独立的token。

子词级token: 为了更好地处理复杂的语言情况,有时候将单词进一步划分为子词级的token。例如,单词"unhappiness"可以被划分为子词级token"un-"、、"happiness’

更复杂一点的,现在大模型比较流行的子词级token还有字节对编码(BPE),这也是ChatGPT的guan方采用的token编码方法它是通过合并出现频繁的子词对来实现的。

字符级token: 在某些情况下,特别是在字符级别的处理任务中,文本会被划分为字符级token。这样做可以处理字符级别的特征和模式。例如,在句子"Hello!“中,“H”、“e”““、” ”“o"和”!"分别是六个字符级token。

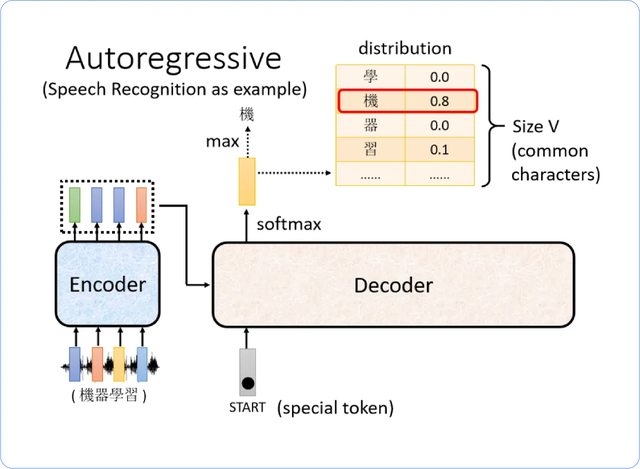

通过对文本做成一个一个的token,LLM模型能够更好地理解和处理语言,从而实现任务如文本生成、机器翻译、文本分类等。

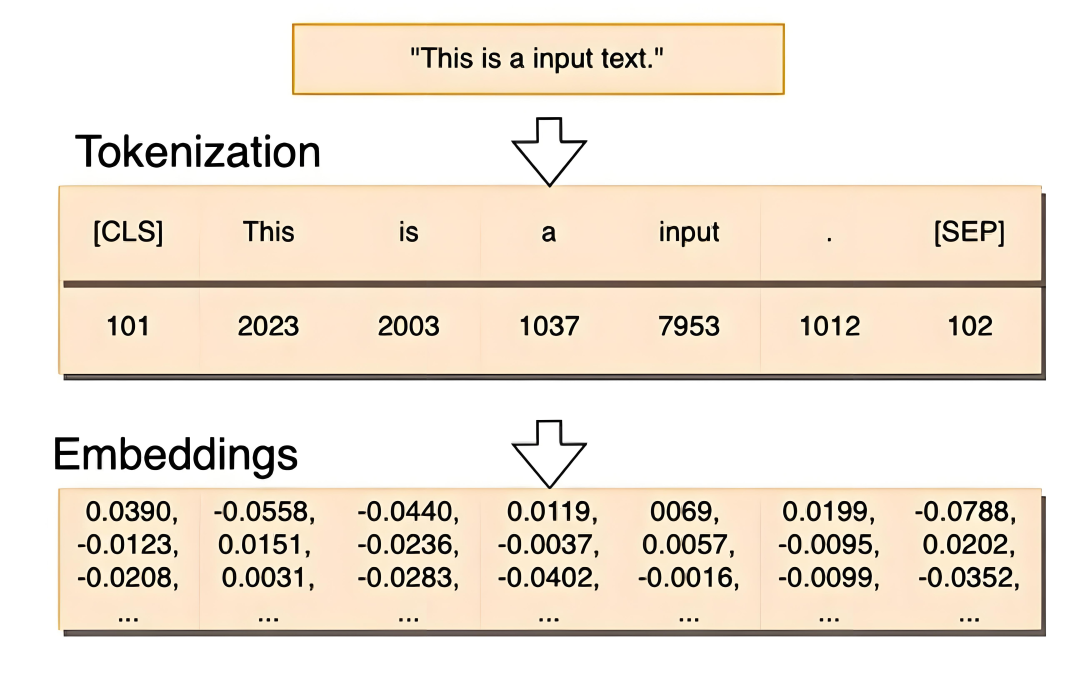

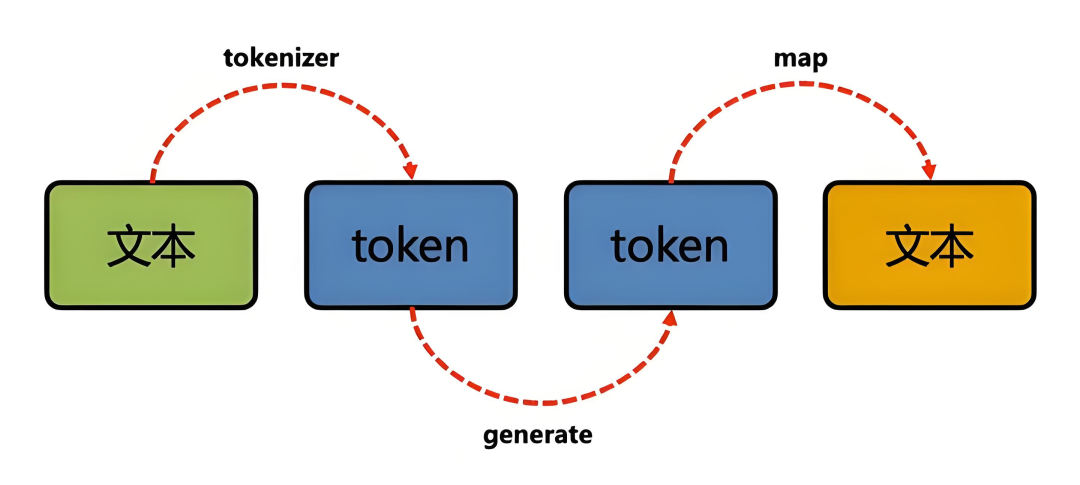

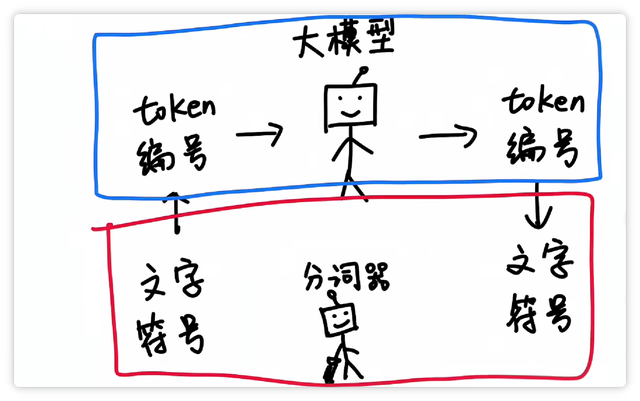

因此,现在主流的大模型都会自带一个tokenizer,也就是自动将输入文本解析成一个一个的token,然后做编码(就是查字典转换成数字),作为大模型真正的“输入

蕞后,那么在ChatGPT中,一个token到底是多长?下面是一些有用的经验法则,可以帮助理解token的实际长度:

对于英文文本,1个token大约是4个字符或0.75个单词。通常来说,也就是1000个Token约等于750个英文单词。

对于中文,1000个Token通常等于400~500个汉字。

但是…!!!

Token ≠ 汉字/单词

中文: 1个token≈1-2个汉字(比如"人工智能"会被拆成2-3个token)

英文:1个token≈0.75个单词(比如"unbelievable"可能会被拆分成"un+believetable")

空格也算token!大家输入时千万别乱敲空格哦~

为什么重要?

算力成本: 每次对话消耗token量=你的"算力账单"(GPT-4每千token约¥0.3)

内容长度: ChatGPT-3.5最多支持4096 tokens(约3000汉字)

回答质量: 超出限制会"失忆",重要信息要前置!

技术原理3层拆解

分词算法: 用unigram/BPE算法找最佳拆分组合

分词器(tokenizer)黑科技:

英文: 按词根拆分(如“unbelievable"一[“un”,“##belie”,“##able”])

中文: 混合策略("人工智能"可能拆为[“人”,“工”,“智能”])

Emoii/符号: 每个表情算1个token

词表映射: 每个token对应唯一ID(比如"猫"→3827,🐱→12850)

向量转换: ID转换成768维数学向量,模型才能真正“理解”

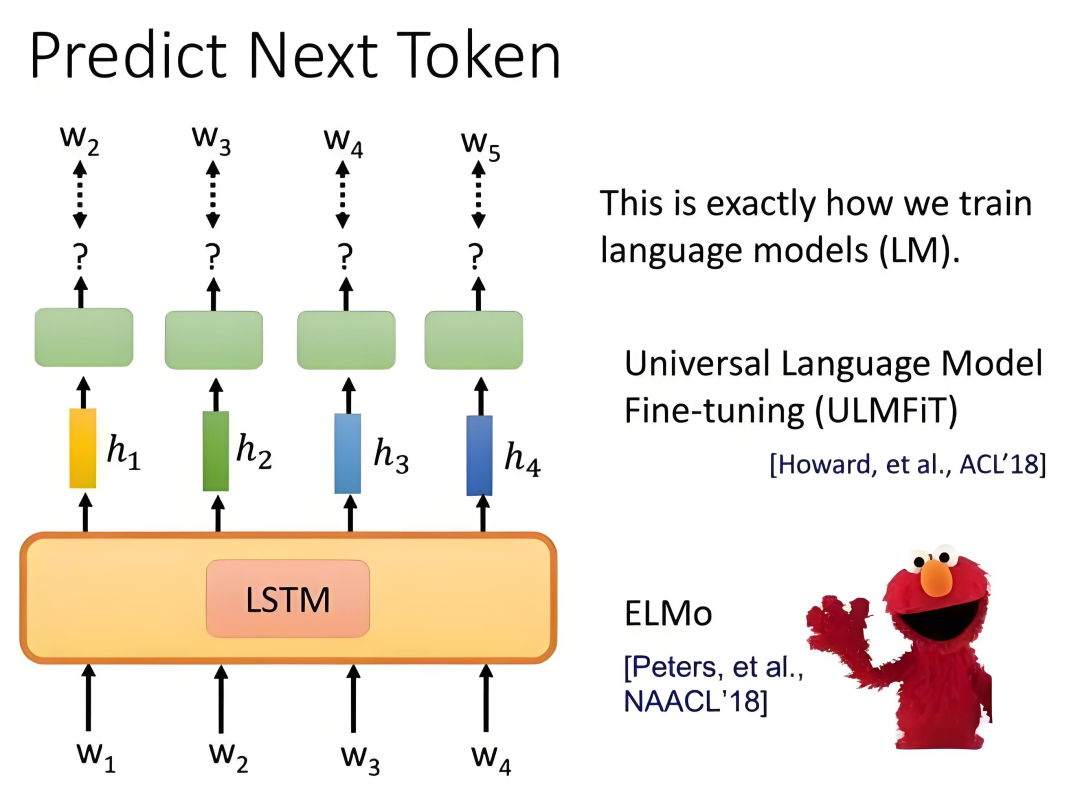

概率预测: 根据前文猜下一个token

Tokens的作用:

1⃣ 输入限制:AI模型对每次处理的Token数量有限制(比如GPT-4最多支持32K Tokens),超过限制的部分会被截断。

2⃣ 计费标准:很多AI平台按Tokens数量收费,比如输入和输出的Tokens总和决定了使用成本。

3⃣ 模型理解:模型通过Tokens来“理解”文本,Token化方式直接影响模型的性能和效果。

日常应用Tips

优化prompt: 删减冗余词=省token空间

控制输出: 设置max tokens参数

处理长文本: 用"继续"触发连贯生成

现在你明白了吗?Tokens是AI大模型的核心概念之一,了解它有助于更好地使用AI工具哦!

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝 一直在更新,更多的大模型学习和面试资料已经上传带到CSDN的官方了,有需要的朋友可以扫描下方二维码免费领取【保证100%免费】👇👇

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝 一直在更新,更多的大模型学习和面试资料已经上传带到CSDN的官方了,有需要的朋友可以扫描下方二维码免费领取【保证100%免费】👇👇

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献107条内容

已为社区贡献107条内容

所有评论(0)