【AI论文】视频大语言多模态模型(Video-LMM)后训练:深入探索基于大型多模态模型的视频推理

视频理解是计算机视觉的前沿方向,要求模型处理复杂的时空关系和多模态信息。近期出现的视频大语言多模态模型(Video-LMMs)将视觉编码器与语言模型结合,展现出强大能力。本文首次系统综述了Video-LMMs的后训练方法,包括三大支柱:基于思维链的监督微调(SFT)、基于可验证目标的强化学习(RL)以及测试时扩展(TTS)。研究提出了结构化分类体系,分析了这些技术在视频任务中的适配与挑战,如时间定

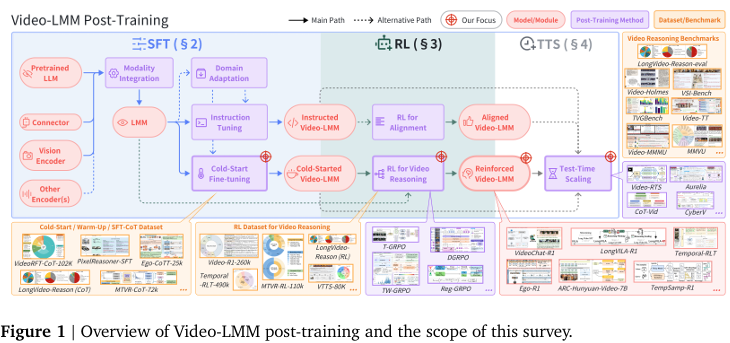

摘要:视频理解是计算机视觉领域最具挑战性的前沿方向,要求模型能够推理复杂的时空关系、长期依赖关系以及多模态证据。近期出现的视频大语言多模态模型(Video-Large Multimodal Models, Video-LMMs)将视觉编码器与强大的基于解码器的语言模型相结合,在视频理解任务中展现出卓越的能力。然而,将这些模型从基础感知系统转化为高级推理引擎的关键阶段——后训练,在现有文献中仍呈现零散状态。本综述首次对Video-LMMs的后训练方法进行了全面考察,涵盖三大核心支柱:基于思维链的有监督微调(Supervised Fine-Tuning, SFT)、基于可验证目标的强化学习(Reinforcement Learning, RL),以及通过增强推理计算的测试时扩展(Test-Time Scaling, TTS)。我们提出了一个结构化的分类体系,阐明了这些技术的角色、相互关联以及针对视频任务的特定适配,解决了时间定位、时空定位、长视频处理效率以及多模态证据整合等独特挑战。通过对代表性方法的系统分析,我们总结了关键设计原则、洞见和评估协议,同时指出了奖励设计、可扩展性以及成本-性能优化等关键开放挑战。我们还精选了必要的基准测试、数据集和评估指标,以促进对后训练效果进行严格评估。本综述旨在为研究人员和实践者提供一个推进Video-LMM能力的统一框架。更多资源与更新信息请访问:github。Huggingface链接:Paper page,论文链接:2510.05034

研究背景和目的

研究背景:

随着计算机视觉和自然语言处理技术的快速发展,视频理解已成为这两个领域中最具挑战性的前沿之一。

视频内容不仅包含复杂的时空关系、长期依赖性和多模态证据,还要求模型具备高度的推理能力以准确解析视频中的信息。近年来,大型多模态模型(LMMs),特别是视频大型多模态模型(Video-LMMs),通过集成视觉编码器和基于解码器的语言模型,在视频理解任务中展现出了显著的能力。然而,如何将这些模型从基本的感知系统转变为复杂的推理引擎,仍然是一个亟待解决的问题。

Video-LMMs的发展经历了从CNN+RNN架构到基于Transformer的模型,再到当前主流的视觉编码器+解码器架构的演变。

尽管这些模型在预训练阶段通过大规模的自监督学习获得了强大的初始化性能和泛化能力,但要将它们转化为高效的推理引擎,仍需通过后训练(post-training)阶段进行优化。后训练阶段不仅涉及模型权重的微调,更重要的是通过特定的训练策略提升模型的推理能力和任务适应性。

研究目的:

本研究旨在全面审视和总结Video-LMMs的后训练方法,提供一个系统的分类框架,涵盖监督微调(SFT)、强化学习(RL)和测试时扩展(TTS)三大核心技术。

具体目标包括:

- 梳理Video-LMMs后训练的关键技术:详细分析SFT、RL和TTS在Video-LMMs中的应用,包括它们的基本原理、技术细节和实现方式。

- 建立结构化的分类体系:通过明确的角色划分和功能连接,阐明这些技术之间的相互作用和互补性,为研究人员提供清晰的技术路线图。

- 提供实践指导:介绍评估Video-LMMs后训练效果的关键基准、数据集和评估指标,帮助研究人员选择合适的评估方法和工具。

- 识别开放挑战和未来方向:探讨当前研究中存在的关键问题,如奖励设计、可扩展性和成本效益优化,并提出未来研究的方向和建议。

研究方法

为了实现上述研究目的,本研究采用了以下研究方法:

1. 文献综述:

通过系统地收集和整理近年来关于Video-LMMs后训练的学术论文、技术报告和开源项目,本研究构建了一个全面的文献库。

通过对这些文献的深入分析,提炼出SFT、RL和TTS在Video-LMMs中的关键技术和应用实例。

2. 技术分类与比较:

基于文献综述的结果,本研究建立了一个结构化的分类体系,将Video-LMMs的后训练技术划分为SFT、RL和TTS三大类,并进一步细分为多个子类。

通过比较不同技术的原理、优缺点和适用场景,揭示了它们之间的内在联系和互补性。

3. 案例分析:

选取具有代表性的Video-LMMs后训练案例进行深入分析,包括模型架构、训练策略、数据集和评估指标等方面。

通过案例分析,展示了不同技术在实践中的应用效果和挑战。

4. 实验验证:

在可控的实验环境中,对选定的Video-LMMs后训练技术进行实验验证。

通过对比不同技术在相同数据集和评估指标下的表现,验证了分类体系的合理性和技术比较的准确性。

研究结果

1. 技术分类体系的建立:

本研究成功建立了一个结构化的分类体系,将Video-LMMs的后训练技术划分为SFT、RL和TTS三大类。

其中,SFT进一步细分为基本SFT、视频指令微调和链式思考微调(CoT-SFT);RL则包括从PPO到GRPO的多种强化学习算法;TTS则涵盖了多种测试时扩展策略,如束搜索、视频链式思考提示和置信度驱动的迭代推理等。

2. 关键技术的深入分析:

-

SFT:研究发现,CoT-SFT通过引入中间推理步骤显著提高了模型的最终答案准确性。

然而,固定的CoT格式缺乏灵活性,难以适应复杂多变的场景。因此,将CoT-SFT作为RL的冷启动阶段,为后续的RL训练提供稳定的初始化,成为了一种有效的策略。 -

RL:GRPO算法因其无需偏好数据和显式奖励模型的特点,在Video-LMMs的后训练中得到了广泛应用。

通过设计合理的奖励函数和优化策略,GRPO能够显著提升模型的推理能力和任务适应性。然而,奖励设计的质量和多样性仍然是制约RL性能的关键因素。 -

TTS:测试时扩展策略通过增加推理时的计算量来提高模型的可靠性。

例如,束搜索通过探索多个候选句子并选择最优解来提高生成文本的质量;视频链式思考提示则通过动态决定是否需要推理以及如何分解问题来提高推理的准确性。

3. 实践指导的提供:

本研究介绍了评估Video-LMMs后训练效果的关键基准、数据集和评估指标。

例如,MMVU和Video-MMMU等基准测试集涵盖了多种视频理解任务,能够全面评估模型的性能;ActivityNet-Grounding和Charades-STA等数据集则专注于时空定位和视频问答等特定任务。通过选择合适的评估方法和工具,研究人员可以更加准确地评估不同后训练技术的效果。

研究局限

尽管本研究在Video-LMMs后训练方法的梳理和分析方面取得了显著进展,但仍存在以下局限性:

1. 数据集的多样性和规模:

目前可用于Video-LMMs后训练的高质量数据集仍然有限,尤其是在长视频理解和多模态证据集成等方面。现有数据集的规模和多样性可能无法充分满足复杂推理任务的需求,限制了模型性能的进一步提升。

2. 奖励设计的复杂性和主观性:

在RL方法中,奖励函数的设计对模型性能具有决定性影响。

然而,设计合理的奖励函数往往需要深入的领域知识和复杂的工程实现。此外,不同任务对奖励函数的要求各不相同,增加了奖励设计的复杂性和主观性。

3. 跨任务和跨域的泛化能力:

尽管Video-LMMs在特定任务上取得了显著进展,但其在跨任务和跨域场景下的泛化能力仍然有限。

如何提高模型在未见过的任务和域上的适应性和鲁棒性,是当前研究面临的重要挑战。

未来研究方向

针对上述研究局限和Video-LMMs后训练领域的发展趋势,未来研究可从以下几个方面展开:

1. 构建更大规模和更多样化的数据集:

通过收集和整理更多长视频、多模态证据和复杂推理任务的数据集,提高模型的训练数据质量和多样性。

同时,探索数据增强和合成技术,以进一步扩大数据集的规模和覆盖范围。

2. 开发更智能和自适应的奖励函数:

研究如何利用自然语言处理、计算机视觉和强化学习等技术,开发能够自动适应不同任务和场景的奖励函数。

通过引入可解释性和可调节性机制,提高奖励函数的透明度和灵活性。

3. 提升模型的跨任务和跨域泛化能力:

探索迁移学习、元学习和多任务学习等技术,提高模型在未见过的任务和域上的适应性和鲁棒性。

通过设计更加通用和灵活的模型架构和训练策略,实现模型性能的全面提升。

4. 推动开源与社区协作:

鼓励研究人员共享代码、数据集和预训练模型等资源,促进社区协作与持续改进。

通过开源社区的力量,不断完善和优化Video-LMMs的后训练方法,形成开放、共享的研究生态。同时,加强与其他相关领域的交流和合作,共同推动视频理解和多模态推理技术的发展。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献228条内容

已为社区贡献228条内容

所有评论(0)