Qwen3-Coder-FP8模型参数量与计算量详解,建议收藏!

本文以Qwen3-Coder-FP8模型为例,详细分析了其参数量和计算量。模型由62层transformer组成,采用MoE架构,其中FFN部分参数占比高达97.5%。文章计算了Attention和FFN两部分的参数量与计算量,指出当序列长度超过8.7K时,Attention计算开销将超过FFN。此外,还介绍了GQA技术对KV Cache的优化作用。此分析有助于理解大模型的资源需求和性能瓶颈。

简介

本文以Qwen3-Coder-FP8模型为例,详细分析了其参数量和计算量。模型由62层transformer组成,采用MoE架构,其中FFN部分参数占比高达97.5%。文章计算了Attention和FFN两部分的参数量与计算量,指出当序列长度超过8.7K时,Attention计算开销将超过FFN。此外,还介绍了GQA技术对KV Cache的优化作用。此分析有助于理解大模型的资源需求和性能瓶颈。

模型介绍

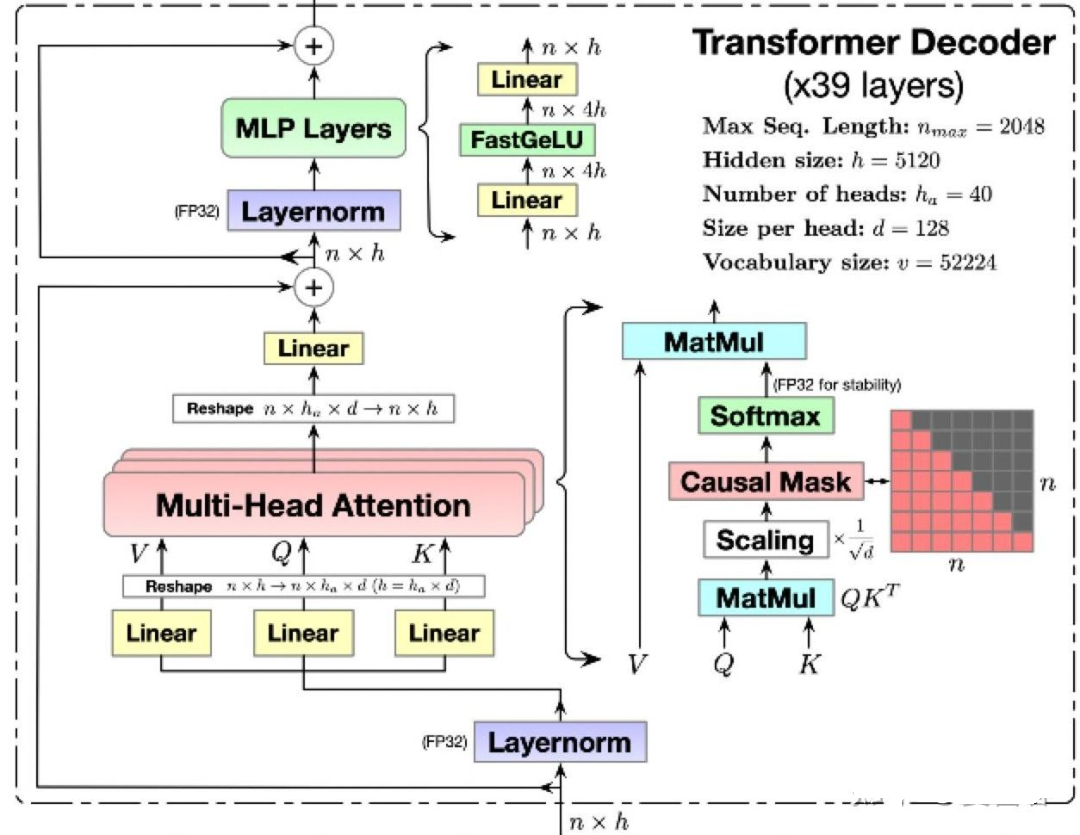

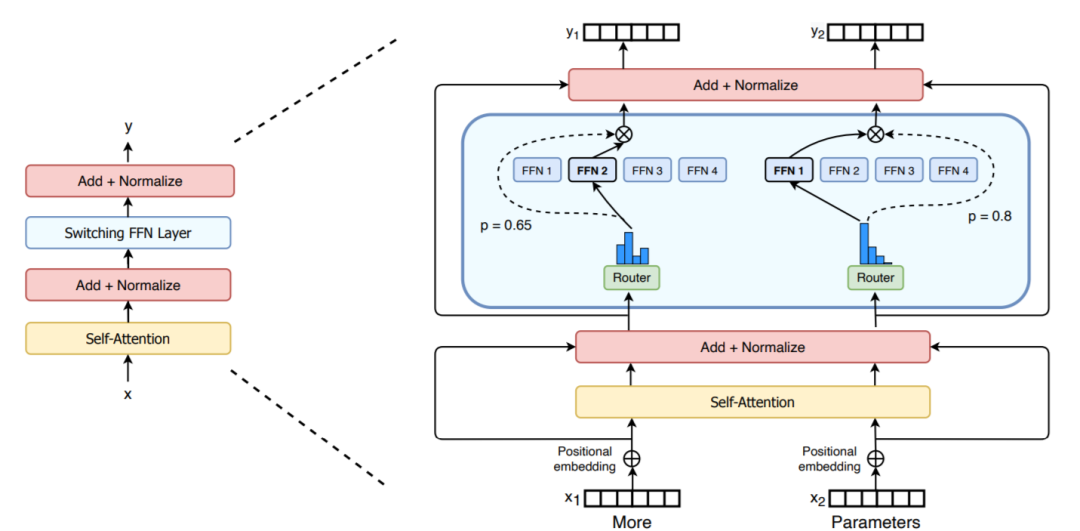

为具体说明,本文以 Qwen3-Coder-FP8 模型为例进行估算。模型主体由62层transformer decoder组成,每层有 Attention 与 FFN 两部分串行。因为Qwen3-Coder-FP8 是一个MoE模型,这里要将图1中 MLP Layers 替换为图2的 MoE-FFN 结构。(图1右上的超参数与Qwen3-Coder-FP8无关,Qwen3-Coder-FP8模型信息见https://www.modelscope.cn/models/Qwen/Qwen3-Coder-480B-A35B-Instruct-FP8/file/view/master/config.json?status=1)。

图1 transformer内部计算细节

图2 moe FFN layer由多个小矩阵(experts)组成

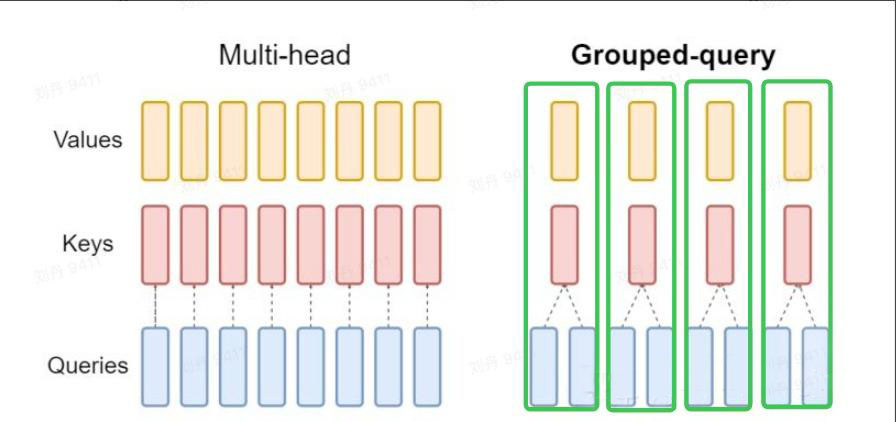

此外需要注意,Qwen3-Coder-FP8在Attention模块中采用了Grouped-query Attention(GQA),以优化KV Cache的显存占用。GQA与原始的多头注意力(MHA)的核心区别在于:GQA将查询头(q heads)分组并共享同一组键值头(kv heads),大大减少kv heads的数量。

图3 GQA通过共享KV优化KV cache大小

整个模型由62个Transformer层串行堆叠。因此,我们只需剖析清楚其中一层的结构即可。以下是Qwen-Coder-FP8的部分模型信息(model config),将为后续的定量计算提供依据。

"head_dim": 128,

"hidden_size": 6144,

"model_type": "qwen3_moe",

"moe_intermediate_size": 2560,

"norm_topk_prob": true,

"num_attention_heads": 96,

"num_experts": 160,

"num_experts_per_tok": 8,

"num_hidden_layers": 62,

"num_key_value_heads": 8,

我们在kv cache一文[1]中介绍过大模型推理分为prefill和decode的两个阶段,可作为背景知识进行阅读。

MoE模型参数量

首先进行参数量计算:Qwen3-Coder模型总参数量为480B(4.8×10¹¹),这些参数主要来自于Attention和FFN两大模块。

Attention部分

Attention部分的参数量来自Q、K、V、O四个矩阵(对应图1中左下的四个Linear块),四个矩阵所包含的参数量计算如下:

- Q:输入维度是hidden_size = 6144,输出维度是num_attention_heads × head_dim = 96 × 128 = 12288;

- K、V:输入维度是hidden_size = 6144,输出维度是num_key_value_heads × head_dim = 8 × 128 = 1024;

- O:输入维度是num_attention_heads × head_dim = 96 × 128 = 12288,输出维度是6144(进行维度还原)。

每层transformer中Q、K、V、O四个矩阵的参数量之和是6144 × 12288 + 6144 × 1024 × 2 + 12288 × 6144 = 163577856,总共62层layers,共计163577856 × 62 ≈ 10B。

FFN部分:专家参数量

每层Transformer包含160个专家,每个专家由两个矩阵构成,形状分别为(6144, 5120)和(2560, 6144)。其中,中间状态的维度从5120变为2560,是经过act\_and\_mul\_kernel激活函数处理的结果。由此,单个专家参数量为:(6144 × 5120) + (2560 × 6144) = 47185920。模型62层所有专家的总参数量则为:47185920 × 160 × 62 ≈ 468B。

Attention和FFN两部分参数量之和为478B,与模型公布的480B总参数量相吻合,验证了计算的准确性。计算参数量占比可知,Attention部分仅占约2%,而MoE-FFN部分则占比97.5%。因此,将模型多卡分布部署的关键之一在于高效实现FFN部分的专家并行(EP)或张量并行(TP),并行策略后续再结合当前开源框架进行讨论。

MoE模型推理计算量估算

在以下计算量分析中,简单起见,我们主要考虑占主导地位的矩阵运算,而忽略LayerNorm、Softmax等逐元素操作的计算量。以下只计算一层transformer中的计算量。

Attention部分的计算量

Attention部分计算量(假设当前正在处理第N个token,bs=1)如下:QKV投影计算量为 (6144×12288 + 6144×1024×2) × 2 = 176947200 FLOPs(最后乘以2是因为统计了乘法运算次数和加法运算次数总和)。

QK相关性计算量为 128×2×96×N = 24576N FLOPs,这里128是head的维度,每个q head和N个k head分别进行点积运算,每次点积运算的计算量是128×2 FLOPs,因为有96个key heads,序列长度为N,所以QK相关性计算量为128×2×96×N;加权求和计算量同样为 128×2×96×N = 24576N FLOPs。

最后输出投影还原维度的计算量为 12288×6144×2 = 150994944 FLOPs。

以上几部分计算量之和为327155712 + 49152N FLOPs。

FFN的计算开销

FFN的计算量主要来自两次GEMV:[1, 6144]×[6144, 5120] 与 [1, 2560]×[2560, 6144],对应 (6144×5120×2 + 2560×6144×2) FLOPs。因采用Top-8路由,故每层FFN总计算量需乘以8,即为 (6144×5120×2 + 2560×6144×2) × 8 = 754974720。

单层总计算量可近似为 (327155712 + 49152N) + 754974720 FLOPs。经计算,当序列长度N > 8.7K时,Attention的计算开销将超过FFN。以上分析仅聚焦于计算量,未考虑访存瓶颈。针对KV Cache的显存与计算优化(如MQA、GQA、MLA及Linear Attention等技术),我们将在后续文章中单独进行探讨。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝 一直在更新,更多的大模型学习和面试资料已经上传带到CSDN的官方了,有需要的朋友可以扫描下方二维码免费领取【保证100%免费】👇👇

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝 一直在更新,更多的大模型学习和面试资料已经上传带到CSDN的官方了,有需要的朋友可以扫描下方二维码免费领取【保证100%免费】👇👇

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献154条内容

已为社区贡献154条内容

所有评论(0)