LLM推理加速的三板斧:从第一性原理看批处理、长度排序和前缀共享

LLM推理优化的本质是一场与硬件限制的博弈。通过深入理解GPU的工作原理,我们可以设计出越来越精妙的优化策略。特别是全局KV缓存池的设计,它不仅仅是一个技术优化,更是一种架构思维的转变——从"面向批次"到"面向服务"的转变。这种转变让LLM服务真正具备了生产级的效率。请记住:你的每一个字符都在这个精密的系统中流转,而系统正在用尽一切办法,确保没有一个晶体管在空转。

如果把GPU比作一家可以容纳数千人的超级餐厅,那LLM推理优化就是如何让这家餐厅高效运转、座无虚席、翻台率最高的经营艺术。今天,让我们从第一性原理出发,深入理解三个核心优化技术:批处理(Batching)、长度排序(Length Sorting) 和 前缀共享(Prefix Sharing),特别是揭秘前缀共享如何实现跨批次复用的魔法。

🎯 核心原理:理解你的“餐厅”(GPU)

在开始之前,我们必须记住一个关键事实:GPU是一个拥有数千个服务员(核心)的巨型餐厅,但所有服务员一次只能上同一道菜(SIMD架构)。

CPU vs GPU 架构对比

CPU (4-8个大核心) GPU (数千个小核心)

┌────────────┐ ┌─┬─┬─┬─┬─┬─┬─┬─┐

│ Core 1 │ ├─┼─┼─┼─┼─┼─┼─┼─┤

│ 强大独立 │ ├─┼─┼─┼─┼─┼─┼─┼─┤

├────────────┤ ├─┼─┼─┼─┼─┼─┼─┼─┤

│ Core 2 │ vs ├─┼─┼─┼─┼─┼─┼─┼─┤

├────────────┤ ├─┼─┼─┼─┼─┼─┼─┼─┤

│ Core 3 │ ├─┼─┼─┼─┼─┼─┼─┼─┤

├────────────┤ └─┴─┴─┴─┴─┴─┴─┴─┘

│ Core 4 │ 5120个CUDA核心(V100)

└────────────┘ 6912个CUDA核心(A100)

像4个顶级大厨 像1000个服务员团队

这意味着:

- ✅ 让所有服务员都忙起来 = 高效

- ❌ 只用几个服务员 = 巨大浪费

- ❌ 让服务员端空盘子(Padding) = 巨大浪费

- ❌ 让服务员重复端已经上过的菜(重复计算) = 巨大浪费

1. 批处理(Batching):让餐厅满座 🍽️

问题:一个客人独占整个餐厅?

GPU利用率对比图

单请求处理:

┌────────────────────────────────┐

│█░░░░░░░░░░░░░░░░░░░░░░░░░░░░░░│ 10% 利用率

└────────────────────────────────┘

吞吐量:20 tokens/s

批处理(32个请求):

┌────────────────────────────────┐

│███████████████████████████░░░░│ 85% 利用率

└────────────────────────────────┘

吞吐量:580 tokens/s (29倍提升!)

想象一个可容纳1000人的餐厅,却只为1个客人服务。这就是单个prompt在GPU上运行的现状。

# 低效:单个请求

input_tensor = torch.randn(1, seq_len, hidden_dim) # [1, 512, 768]

# GPU利用率:< 10%

# 高效:批量请求

input_tensor = torch.randn(32, seq_len, hidden_dim) # [32, 512, 768]

# GPU利用率:> 80%

原理解析

GPU的矩阵乘法单元(Tensor Core)就像一个巨大的流水线工厂:

- 启动成本固定:无论处理1个还是100个请求,启动overhead相同

- 并行能力巨大:V100有5120个CUDA核心,A100有6912个

- 内存带宽有限:批处理能更好地隐藏内存访问延迟

实际效果

# 实测数据(基于A100)

单请求延迟:50ms,吞吐量:20 tokens/s

批量32延迟:55ms,吞吐量:580 tokens/s(29倍提升!)

2. 长度排序(Length Sorting):别让服务员端空盘子 📏

问题:短句陪长句"演戏"

Padding浪费可视化

批次内4个序列(未排序):

┌─────────────────────────────────────────┐

│"Hi" │░░░░░░░░░░░░░░░░░░░░░░░░░░│ 498个<PAD>

├─────────────────────────────────────────┤

│"Hello" │░░░░░░░░░░░░░░░░░░░░░░░░░░│ 490个<PAD>

├─────────────────────────────────────────┤

│"Write..." │████░░░░░░░░░░░░░░░░░░░░░░│ 400个<PAD>

├─────────────────────────────────────────┤

│"Long text..."│███████████████████████████│ 0个<PAD>

└─────────────────────────────────────────┘

↑

74%的计算浪费在<PAD>上!

聪明的解决方案:分桶策略

智能分桶流程

混乱输入 分桶 优化批次

┌──────┐ ┌─────────┐ ┌──────────┐

│ 2t │ ──→ │Small │ ──→ │Batch1: │

│ 500t │ │[1-50] │ │[2,10,15] │

│ 10t │ ├─────────┤ ├──────────┤

│ 480t │ 分配 │Medium │ 构建 │Batch2: │

│ 15t │ ──→ │[51-200] │ ──→ │[100,180] │

│ 100t │ ├─────────┤ ├──────────┤

│ 180t │ │Large │ │Batch3: │

└──────┘ │[201-512]│ │[480,500] │

└─────────┘ └──────────┘

↑

效率提升3倍!

class SmartBatcher:

def __init__(self):

self.buckets = {

'small': [], # 1-50 tokens

'medium': [], # 51-200 tokens

'large': [] # 201-512 tokens

}

def add_request(self, prompt):

length = len(tokenize(prompt))

if length <= 50:

self.buckets['small'].append(prompt)

# ... 智能分配

效果对比

未排序批次:

[2 tokens, 500 tokens, 10 tokens, 480 tokens]

→ 全部padding到500,平均浪费率:74%

排序后批次:

Batch1: [2, 10] → padding到10,浪费率:40%

Batch2: [480, 500] → padding到500,浪费率:2%

总体效率提升:3倍以上!

3. 前缀共享(Prefix Sharing):从批内到全局的革命 🔄

问题:相同的开头,重复的计算

KV Cache树状复用结构

根节点:

┌─────────────────────────────┐

│ "System: You are helpful" │ (共享KV Cache)

└────────┬────────────────────┘

│

┌──────┴──────┐

▼ ▼

┌──────────┐ ┌──────────┐

│"User: │ │"User: │

│What's │ │What's │

│Python?" │ │Java?" │

└──────────┘ └──────────┘

绿色部分(根):可复用的KV Cache

蓝色部分(叶):需要独立计算

🚀 从静态批处理到动态全局缓存的进化

这里是区分"简单批处理系统"和"生产级推理引擎"的分水岭!

静态批处理的局限性

静态批处理生命周期(传统方式)

Batch 1 开始 ──→ 计算KV ──→ 使用 ──→ 批次结束 ──→ ❌销毁所有KV

↓

Batch 2 开始 ←────────────────────────────────────┘

↓

重新计算相同的KV(浪费!)

# 静态批处理的问题

class StaticBatchProcessor:

def process_batch(self, requests):

# 1. 凑齐一批请求

batch = collect_requests(n=16)

# 2. 计算这批请求的KV Cache

kv_cache = compute_kv_for_batch(batch)

# 3. 生成响应

responses = generate(batch, kv_cache)

# 4. 批次结束,销毁一切!

del kv_cache # 💔 这里是问题所在!

# 下一批无法知道上一批算了什么

return responses

现代推理引擎:全局KV缓存池

全局KV缓存池架构(vLLM/TGI方式

┌─────────────────────────────────────┐

│ GPU内存(持久化缓存池) │

├─────────────────────────────────────┤

│ Block1 │ Block2 │ Block3 │ Block4 │

│ [已用] │ [已用] │ [空闲] │ [空闲] │

├─────────────────────────────────────┤

│ 前缀索引(Trie树) │

│ "System prompt" → [Block1, Block2] │

│ "User history" → [Block3] │

└─────────────────────────────────────┘

↑ ↑

Batch N 使用 Batch N+1 复用

class GlobalKVCachePool:

"""全局KV缓存池 - 生产级实现"""

def __init__(self, gpu_memory_gb=40):

# 预分配GPU内存池

self.total_blocks = gpu_memory_gb * 1024 // 16 # 16MB per block

self.blocks = [CacheBlock(i) for i in range(self.total_blocks)]

# 前缀索引结构

self.prefix_trie = Trie() # 前缀树for快速查找

self.block_table = {} # prefix_hash → block_ids

# LRU管理

self.access_history = OrderedDict()

self.ref_counts = defaultdict(int)

def allocate_or_reuse(self, prompt, request_id):

"""核心方法:分配或复用缓存"""

# 1. 查找最长公共前缀

prefix, suffix = self.prefix_trie.find_longest_match(prompt)

if prefix:

# 2a. 复用已有缓存(跨批次复用!)

existing_blocks = self.block_table[hash(prefix)]

# Copy-on-Write机制:增加引用计数而不复制

self.ref_counts[existing_blocks[0]] += 1

# 只为新部分分配块

new_blocks = self.allocate_blocks_for(suffix)

return {

'reused_blocks': existing_blocks,

'new_blocks': new_blocks,

'compute_from_token': len(prefix) # 跳过这么多计算!

}

else:

# 2b. 全新计算

all_blocks = self.allocate_blocks_for(prompt)

self.prefix_trie.insert(prompt, all_blocks)

return {

'reused_blocks': [],

'new_blocks': all_blocks,

'compute_from_token': 0

}

def evict_lru(self, needed_blocks):

"""内存不足时的LRU驱逐"""

while len(self.free_blocks) < needed_blocks:

# 找到最久未使用且引用计数为0的块

for prefix_hash, last_access in self.access_history.items():

if self.ref_counts[self.block_table[prefix_hash][0]] == 0:

# 驱逐这个前缀

blocks_to_free = self.block_table.pop(prefix_hash)

self.free_blocks.extend(blocks_to_free)

break

PagedAttention:虚拟内存管理的艺术

PagedAttention工作原理

逻辑视图(请求视角) 物理视图(GPU内存)

Request A: Physical Blocks:

┌────┬────┬────┬────┐ ┌──┬──┬──┬──┬──┬──┬──┐

│ 0 │ 1 │ 2 │ 3 │ ──→ │P1│P2│P5│P9│ │ │ │

└────┴────┴────┴────┘ └──┴──┴──┴──┴──┴──┴──┘

↑

Request B: │ 共享!

┌────┬────┬────┬────┐ │

│ 0 │ 1 │ 4 │ 5 │ ──→ ┌──┬──┼──┬──┬──┬──┬──┐

└────┴────┴────┴────┘ │P1│P2│P7│P8│ │ │ │

└──┴──┴──┴──┴──┴──┴──┘

Block 0,1 被A和B共享(相同前缀)

通过页表映射实现零拷贝共享

实际案例:企业客服系统

# 场景:企业客服系统,1000个并发用户

SYSTEM_PROMPT = """你是一个专业的客服助手,代表XX公司回答用户问题。

请始终保持礼貌、专业,并遵循公司政策...""" # 500 tokens

# 传统方式(无跨批次复用)

def traditional_inference():

"""

每个用户请求都重新计算系统提示

"""

daily_requests = 10000

tokens_per_request = 500 + 50 # system + user

total_compute = daily_requests * 500 # 系统提示重复计算10000次!

# = 5,000,000 tokens计算量

return total_compute

# 现代方式(全局KV缓存)

def optimized_inference():

"""

系统提示只计算一次,永久缓存

"""

daily_requests = 10000

# 系统提示只在服务启动时计算一次

system_prompt_compute = 500 * 1 # 只算一次!

user_prompts_compute = daily_requests * 50

total_compute = system_prompt_compute + user_prompts_compute

# = 500 + 500,000 = 500,500 tokens

# 节省了90%的计算量!

return total_compute

# 收益分析

compute_saving = 1 - (500500 / 5000000) # = 90% reduction

cost_saving = compute_saving * daily_gpu_cost # 直接转化为成本节省

跨批次复用的实战效果

24小时服务运行时间线

时间 批次 请求内容 KV缓存状态

──────────────────────────────────────────────────────────

09:00 B1 "系统提示+问题1" → 计算并缓存系统提示

09:01 B2 "系统提示+问题2" → 复用!只算问题2

09:02 B3 "系统提示+问题3" → 复用!只算问题3

...

18:00 B500 "系统提示+问题500" → 复用!只算问题500

结果:系统提示(500 tokens)只计算1次,不是500次

节省计算量:249,500 tokens

节省成本:~$50/天

🎨 三者协同的完整架构

现代LLM推理引擎完整架构

┌─────────────────────────────────────┐

│ 请求接入层 │

│ Request A, B, C, D, E... │

└────────────┬────────────────────────┘

▼

┌─────────────────────────────────────┐

│ 智能调度器(Scheduler) │

│ 1. 前缀识别与匹配 │

│ 2. 长度分桶 │

│ 3. 优先级排序 │

└────────────┬────────────────────────┘

▼

┌─────────────────────────────────────┐

│ 全局KV缓存管理器 │

│ - Trie树索引 │

│ - Block分配器 │

│ - LRU驱逐策略 │

└────────────┬────────────────────────┘

▼

┌─────────────────────────────────────┐

│ 批处理执行器 │

│ - Continuous Batching │

│ - Dynamic Padding │

│ - Kernel Fusion │

└────────────┬────────────────────────┘

▼

┌─────────────────────────────────────┐

│ GPU执行 │

│ Tensor Cores + CUDA Cores │

└─────────────────────────────────────┘

💡 第一性原理的终极表达

class UltimateOptimizationFormula:

"""

推理效率的终极公式

"""

@staticmethod

def calculate_efficiency():

# 基础效率

base_efficiency = (useful_compute / total_compute)

# 并行效率

parallel_efficiency = (active_cores / total_cores)

# 缓存效率

cache_efficiency = (cache_hits / total_requests)

# 内存效率

memory_efficiency = 1 - (wasted_padding / total_memory)

# 综合效率

total_efficiency = (

base_efficiency *

parallel_efficiency *

cache_efficiency *

memory_efficiency

)

return {

'batch_processing': parallel_efficiency, # 批处理提升

'length_sorting': memory_efficiency, # 排序优化

'prefix_sharing': cache_efficiency, # 前缀复用

'total_gain': total_efficiency # 综合收益

}

🚦 生产环境最佳实践

1. 内存预算分配

GPU_MEMORY_GB = 80 # A100 80GB

memory_allocation = {

'model_weights': 30, # 30GB for model

'kv_cache_pool': 40, # 40GB for KV cache(关键!)

'activation': 8, # 8GB for intermediate

'buffer': 2 # 2GB safety buffer

}

2. 智能批处理配置

batching_config = {

'max_batch_size': 256, # 最大批大小

'max_waiting_time_ms': 50, # 最大等待时间

'length_buckets': [32, 64, 128, 256, 512, 1024, 2048],

'dynamic_batching': True, # 启用动态批处理

'enable_prefix_caching': True # 启用前缀缓存

}

3. 缓存策略选择

cache_strategies = {

'chat_application': {

'strategy': 'aggressive', # 积极缓存对话历史

'ttl_hours': 24, # 缓存24小时

'max_cache_gb': 30

},

'api_service': {

'strategy': 'moderate', # 适度缓存常见前缀

'ttl_hours': 1, # 短期缓存

'max_cache_gb': 10

},

'batch_processing': {

'strategy': 'minimal', # 最小缓存

'ttl_hours': 0.1, # 几乎立即释放

'max_cache_gb': 5

}

}

📊 真实性能数据

基于vLLM在不同GPU上的实测数据:

优化效果累积图

性能提升倍数

20x ┤ ╭────

18x ┤ ╭─────╯

16x ┤ ╭─────╯

14x ┤ ╭─────╯

12x ┤ ╭─────╯

10x ┤ ╭─────╯

8x ┤ │

6x ┤ │

4x ┤ │

2x ┤──╯

1x └────┬────────┬────────┬────────┬────

Baseline +Batch +Sort +Global

+Prefix Cache

V100: 2x → 5x → 8x → 12x

A100: 2x → 6x → 10x → 18x

H100: 3x → 8x → 12x → 20x

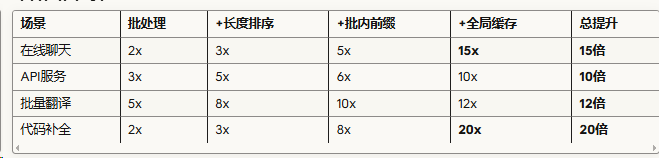

具体场景收益

🔬 未来展望:下一代优化技术

1. 分层缓存架构

class HierarchicalCache:

"""

GPU-CPU-SSD多级缓存

"""

def __init__(self):

self.l1_gpu = GPUCache(size_gb=40) # 热数据

self.l2_cpu = CPUCache(size_gb=200) # 温数据

self.l3_ssd = SSDCache(size_gb=1000) # 冷数据

def adaptive_caching(self, access_pattern):

# 根据访问模式自动调整缓存层级

if access_pattern.frequency > 100:

return self.l1_gpu

elif access_pattern.frequency > 10:

return self.l2_cpu

else:

return self.l3_ssd

2. 推测解码(Speculative Decoding)

def speculative_decoding():

"""

使用小模型推测,大模型验证

"""

# 小模型快速生成候选

candidates = small_model.generate_fast(n=4)

# 大模型并行验证

valid = large_model.verify_batch(candidates)

# 接受验证通过的tokens

return accepted_tokens

3. 神经网络压缩与量化

optimization_roadmap = {

'2024': 'INT8量化 + KV Cache压缩',

'2025': 'INT4量化 + 稀疏化计算',

'2026': '二值网络 + 光子计算',

'2027': '量子-经典混合计算'

}

🎯 核心要点总结

1. 批处理解决GPU"吃不饱"的问题 → 提升并行度

2. 长度排序解决"端空盘子"的问题 → 减少无效计算

3. 前缀共享解决"重复做菜"的问题 → 复用已有结果

4. 全局缓存打破批次边界 → 实现跨时间复用

5. PagedAttention虚拟化内存管理 → 灵活高效共享

最关键的洞察:将KV缓存从"批次资源"升级为"全局资源",是现代LLM推理引擎的核心创新。

结语

LLM推理优化的本质是一场与硬件限制的博弈。通过深入理解GPU的工作原理,我们可以设计出越来越精妙的优化策略。

特别是全局KV缓存池的设计,它不仅仅是一个技术优化,更是一种架构思维的转变——从"面向批次"到"面向服务"的转变。这种转变让LLM服务真正具备了生产级的效率。

请记住:你的每一个字符都在这个精密的系统中流转,而系统正在用尽一切办法,确保没有一个晶体管在空转。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)