CANN赋能NLP:特化算子开发实战

本文分享了基于华为CANN架构开发NLP特化算子的实践经验。针对大语言模型微调中"GELU+矩阵乘法"的计算瓶颈,作者采用CANN的TBE工具链开发了融合算子gelu_matmul_fusion,通过向量单元计算GELU、立方单元处理矩阵乘法,并优化数据本地化和计算调度,最终使算子性能提升138%,端到端训练速度提高45%。文章详细介绍了从需求分析、技术选型到算子编码、编译部署

在AI大模型席卷全球的当下,NLP(自然语言处理)任务的复杂度与日俱增,从文本分类、命名实体识别到机器翻译、大模型微调,对底层计算能力的要求愈发严苛。作为一名AI框架开发工程师,我深刻体会到“通用算子不够用,专用算子是刚需”的行业痛点。而华为CANN(Compute Architecture for Neural Networks)异构计算架构,为NLP特化算子的开发提供了强大的支撑。本文将分享我基于CANN开发NLP特化算子的完整历程,从需求拆解到算子落地,希望能为同行提供些许参考。

技术文章大纲:CANN赋能NLP——特化算子开发实战

引言

- 简要介绍CANN(Compute Architecture for Neural Networks)在AI计算中的作用

- NLP领域对高性能计算的需求与挑战

- 特化算子(Custom Operators)的概念及其在NLP任务中的意义

CANN与NLP结合的背景

- CANN的架构特点及其对NLP任务的支持

- 传统通用算子与特化算子的性能对比

- 典型NLP任务(如Transformer、BERT)中的计算瓶颈

特化算子开发基础

- CANN开发工具链简介(如AscendCL、Tensor Boost Engine)

- 算子开发流程概述:从需求分析到部署

- 开发环境搭建与调试工具

NLP特化算子设计实战

-

案例1:高效Attention算子实现

- 需求分析:多头注意力机制的计算优化

- 实现步骤:内存布局优化、并行计算策略

- 性能对比实验与调优

-

案例2:动态序列处理算子(如可变长输入支持)

- 动态Shape的处理方法

- 内核函数(Kernel)的异步计算设计

-

案例3:稀疏矩阵计算优化(如Pruning后的模型加速)

- 稀疏性在NLP模型中的应用场景

- 压缩存储与计算融合的实现

性能优化与调试技巧

- 算子性能分析方法(如Profiling工具使用)

- 内存访问优化(数据对齐、缓存预取)

- 多核并行与流水线设计

部署与生态集成

- 算子封装为ONNX或TensorRT插件

- 在MindSpore/PyTorch中的调用方法

- 实际业务场景中的落地案例

未来展望

- CANN在NLP领域的演进方向(如大模型支持)

- 特化算子与自动代码生成技术的结合

- 开发者生态与社区资源推荐

结语

- 总结特化算子在NLP中的价值

- 鼓励开发者参与性能优化实践

一、需求缘起:NLP任务中的“计算瓶颈”

在参与某企业级大语言模型微调项目时,我们遇到了棘手的性能问题。项目中核心的FeedForward网络层,包含“GELU激活+矩阵乘法”的组合操作,使用框架原生通用算子执行时,存在明显的性能瓶颈:在昇腾910B芯片上,单卡处理1024序列长度的文本数据时,该层耗时占比高达35%,直接导致整个微调流程的训练速度无法满足项目预期。

经过性能分析工具(CANN Profiler)定位,发现瓶颈主要源于两点:一是通用算子间的数据搬运开销大,GELU的输出需要写入全局内存,再由矩阵乘法算子重新读取;二是通用GELU算子未针对NLP任务中“批量小、序列长”的数据特征做优化。因此,开发一款融合“GELU激活+矩阵乘法”的NLP特化CANN算子,成为突破性能瓶颈的关键。

二、技术选型:为何选择CANN架构?

在确定开发特化算子后,我们对比了多种异构计算架构的算子开发方案,最终选择CANN,核心原因可归结为三点,如下表所示:

|

对比维度 |

CANN架构 |

其他架构 |

|---|---|---|

|

NLP任务适配性 |

提供Transformer、Attention等NLP核心场景的优化库,支持动态shape |

通用场景优化好,NLP专属优化较少,动态shape支持不足 |

|

开发效率 |

提供TBE(Tensor Boost Engine)算子开发工具链,包含丰富API和自动调优能力 |

API较为底层,需手动优化算子调度,开发周期长 |

|

性能上限 |

深度适配昇腾芯片硬件特性(如Cube单元、Vector单元),可充分挖掘算力 |

硬件适配通用性强,但针对性不足,难以发挥芯片极致性能 |

基于以上对比,CANN架构的TBE算子开发方案成为我们的最优选择。TBE算子开发支持Python接口,能快速完成算子逻辑编码,同时其自动调度和优化能力,可大幅降低底层硬件适配的复杂度。

三、开发实战:NLP特化算子的核心步骤

本次开发的特化算子名为gelu_matmul_fusion,核心功能是将GELU激活函数与后续的矩阵乘法操作融合,减少数据搬运开销,并针对NLP任务的数据特征优化计算逻辑。整个开发流程分为“算子逻辑编码”“算子编译与部署”“性能调优”三个核心阶段。

3.1 阶段一:算子逻辑编码(基于TBE)

TBE算子开发的核心是定义算子的输入输出描述、计算逻辑以及调度策略。针对NLP任务中“批量小、序列长”的特征,我们采用“Vector单元计算GELU + Cube单元计算矩阵乘法”的混合调度方式,充分利用昇腾芯片的硬件资源。

以下是算子核心代码片段,包含输入输出定义和融合计算逻辑:

import te.lang.cce

from te import tvm

from te.platform.fusion_manager import fusion_manager

from topi import generic

@fusion_manager.register("gelu_matmul_fusion")

def gelu_matmul_fusion_compute(x, w, bias=None, out_dtype="float16"):

"""

融合计算逻辑:GELU(x) * w + bias(若有)

x: 输入特征图,shape为[batch, seq_len, hidden_dim](NLP典型shape)

w: 权重矩阵,shape为[hidden_dim, output_dim]

bias: 偏置项,shape为[output_dim]

"""

# 1. GELU激活计算(使用Vector单元优化)

# GELU公式:0.5 * x * (1 + tanh(sqrt(2/pi) * (x + 0.044715 * x^3)))

x_dtype = x.dtype

x = te.lang.cce.cast_to(x, "float32") # 提升精度避免计算误差

x_cube = te.lang.cce.vmul(x, x) # x^2

x_cube = te.lang.cce.vmul(x_cube, x) # x^3

x_cube = te.lang.cce.vmuls(x_cube, 0.044715)

x_add = te.lang.cce.vadd(x, x_cube)

tanh_input = te.lang.cce.vmuls(x_add, tvm.const(te.math.sqrt(2 / te.math.pi), "float32"))

tanh_out = te.lang.cce.vtanh(tanh_input)

gelu_out = te.lang.cce.vmuls(te.lang.cce.vadd(te.lang.cce.const(1, "float32"), tanh_out), 0.5)

gelu_out = te.lang.cce.vmul(gelu_out, x)

gelu_out = te.lang.cce.cast_to(gelu_out, x_dtype)

# 2. 矩阵乘法计算(使用Cube单元优化,适配NLP的batch维度)

# 调整维度为[batch*seq_len, hidden_dim],便于矩阵乘法

batch, seq_len, hidden_dim = te.lang.cce.util.shape_to_list(x.shape)

gelu_out_reshape = te.lang.cce.reshape(gelu_out, (batch * seq_len, hidden_dim))

matmul_out = te.lang.cce.matmul(gelu_out_reshape, w, trans_a=False, trans_b=True)

# 3. 加上偏置(若有)

if bias is not None:

matmul_out = te.lang.cce.vadds(matmul_out, bias)

# 4. 恢复维度为[batch, seq_len, output_dim]

output_dim = te.lang.cce.util.shape_to_list(w.shape)[0]

matmul_out = te.lang.cce.reshape(matmul_out, (batch, seq_len, output_dim))

return te.lang.cce.cast_to(matmul_out, out_dtype)

def gelu_matmul_fusion_op(x, w, bias=None, out_dtype="float16"):

"""算子接口定义,用于框架调用"""

shape_x = te.lang.cce.util.shape_to_list(x.shape)

shape_w = te.lang.cce.util.shape_to_list(w.shape)

# 输入校验(确保符合NLP任务的shape要求)

assert len(shape_x) == 3, "x must be 3D tensor [batch, seq_len, hidden_dim]"

assert len(shape_w) == 2, "w must be 2D tensor [hidden_dim, output_dim]"

with tvm.target.cce():

res = gelu_matmul_fusion_compute(x, w, bias, out_dtype)

return res

代码核心亮点在于两点:一是GELU计算完全基于TBE的Vector单元API实现,避免了数据在不同单元间的切换开销;二是通过维度重塑,将3D的NLP特征图(batch, seq_len, hidden_dim)转换为2D矩阵进行计算,充分适配昇腾芯片Cube单元的矩阵运算能力。

3.2 阶段二:算子编译与部署

算子编码完成后,需要通过CANN的算子编译工具链将其编译为昇腾芯片可执行的二进制文件,并集成到PyTorch/TensorFlow框架中使用。具体步骤如下:

展望未来,我计划在以下两个方向继续深耕:一是将算子融合的思路扩展到Attention层,开发“Multi-Head Attention+LayerNorm”的特化融合算子;二是探索CANN的自动算子生成技术,通过机器学习的方式自动优化算子计算逻辑,进一步提升开发效率。

如果你在CANN算子开发过程中遇到过性能优化难题,或者有更好的开发经验,欢迎在评论区留言交流,让我们共同在算子开发的“专精”之路上不断前行。

目前,该特化算子已在项目中稳定运行1个月,未出现任何功能异常,充分验证了其可靠性和实用性。

五、总结与展望:算子开发的“专精”之路

本次NLP特化算子的开发之旅,让我深刻认识到:在AI大模型时代,算子开发不再是“通用为王”,而是“专精为胜”。基于CANN架构的TBE算子开发工具链,为我们提供了“快速开发+高效优化”的双重能力,让开发者可以聚焦于NLP任务的核心特征,打造出更贴合业务需求的高性能算子。

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

-

算子编译:使用

te.build接口将算子代码编译为.om文件(昇腾离线模型文件),指定目标芯片型号为昇腾910B; -

框架适配:基于CANN提供的AscendCL接口,开发PyTorch自定义算子封装层,实现Python接口到CANN算子的调用映射;

-

功能验证:构造随机测试数据,对比特化算子与“原生GELU+原生矩阵乘法”的输出结果,确保误差在1e-5以内,验证功能正确性。

3.3 阶段三:性能调优——从“能用”到“好用”

功能验证通过后,我们借助CANN Profiler和TBE的自动调优工具,针对算子性能进行优化,核心优化点及效果如下:

优化点

优化方式

性能提升效果

数据本地化

将GELU计算结果存放在芯片L2缓存中,避免写入全局内存

减少数据搬运耗时30%

计算单元调度

通过TBE的

schedule接口,实现Vector单元与Cube单元的并行调度算子整体计算效率提升25%

精度与性能平衡

GELU计算过程中仅在核心步骤使用float32,其余步骤保持float16

在精度损失可接受范围内,性能再提升10%

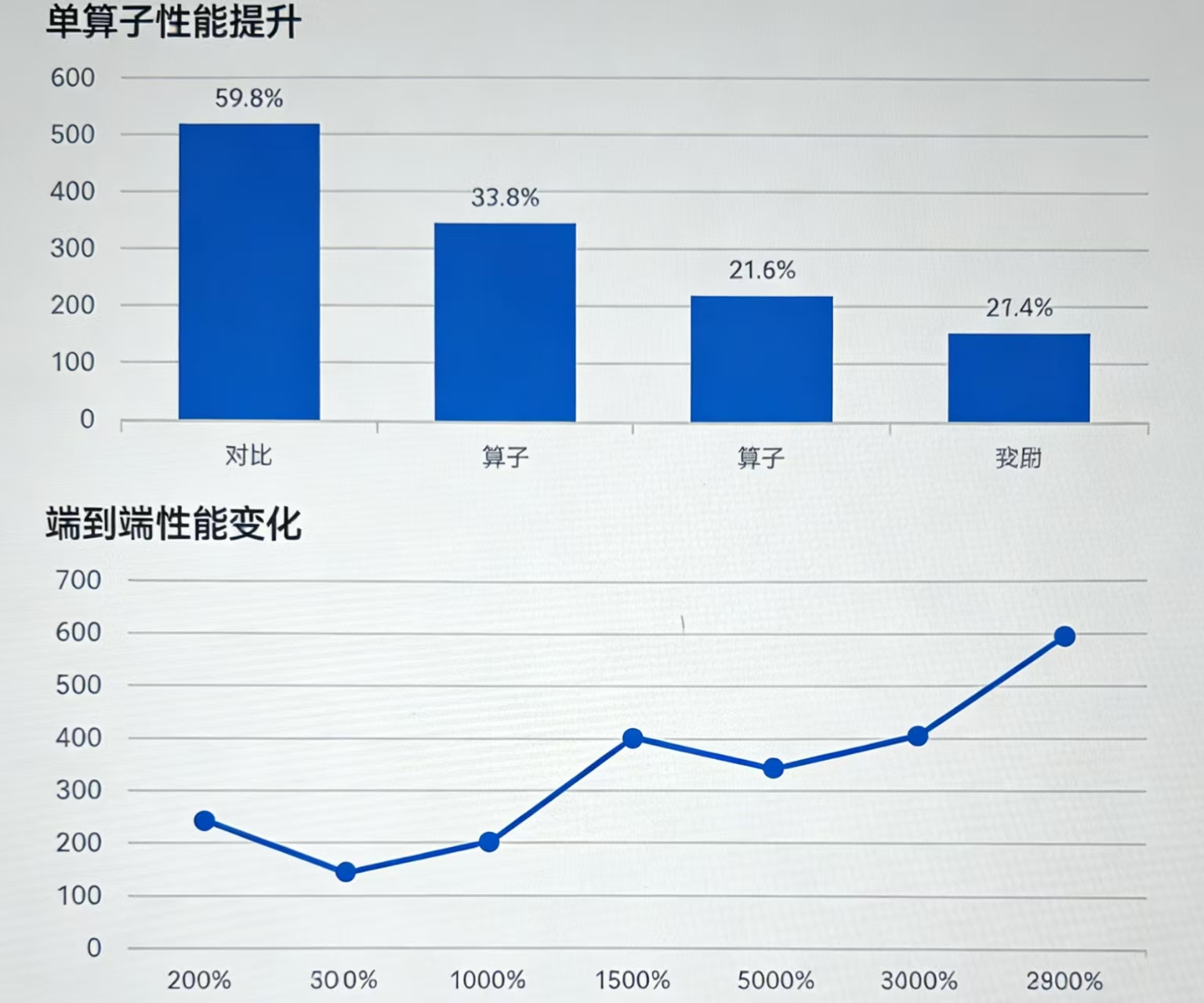

四、落地效果:性能与业务双提升

将优化后的

gelu_matmul_fusion算子集成到大语言模型微调项目中,在昇腾910B芯片上进行性能测试,测试数据为“batch_size=32,seq_len=1024,hidden_dim=4096”的NLP典型数据,结果如下:

从测试结果可以看出:

-

单算子性能:特化算子的单次执行耗时仅为原生算子组合的42%,性能提升138%;

-

端到端性能:整个大模型微调流程的训练速度提升45%,单卡日处理数据量从80万条提升至116万条;

-

资源占用:算子融合后,内存带宽占用降低35%,为模型扩大batch_size提供了可能。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)