Runway搜索推荐自动化工作流搭建

本文深入解析Runway搜索推荐系统的四阶段架构与多模态表征机制,详述基于Airflow、Kafka和Elasticsearch的自动化工作流设计与实践,涵盖数据流、控制流协同及性能优化策略。

1. Runway搜索推荐系统的核心原理与架构解析

核心架构与多模态表征机制

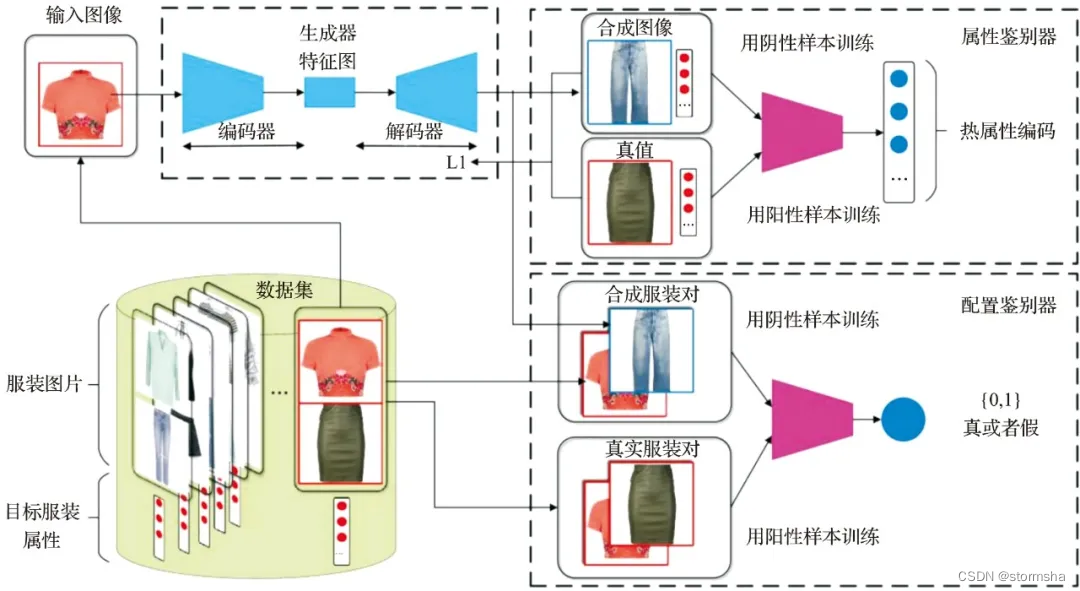

Runway推荐系统采用“四阶段级联”架构:候选集生成、粗排、精排与重排。在候选集阶段,基于Elasticsearch构建语义索引,结合用户历史行为与上下文标签快速召回相关素材。核心在于多模态嵌入模型——通过CLIP-style视觉-文本联合编码器,将图像、视频帧与描述文本映射至统一向量空间,实现跨模态语义对齐。

# 伪代码:多模态编码示例

from transformers import CLIPProcessor, CLIPModel

model = CLIPModel.from_pretrained("runway-clip-v1")

processor = CLIPProcessor.from_pretrained("runway-clip-v1")

inputs = processor(text=["a futuristic cityscape"], images=pixel_tensor, return_tensors="pt")

embeddings = model.get_text_features(**inputs) # 文本嵌入

image_embeds = model.get_image_features(pixel_values=inputs["pixel_values"]) # 图像嵌入

该向量化结果作为后续排序模型的基础特征输入,支持高维语义匹配。

2. 自动化工作流设计的理论基础

在现代AI驱动的内容平台中,推荐系统的运行已不再是静态批处理或人工干预主导的流程,而是高度依赖于自动化机制来实现高效、低延迟和可扩展的服务响应。Runway作为融合视觉生成与智能推荐的前沿平台,其搜索推荐系统背后的工作流设计必须具备动态感知、自主调度与自适应优化的能力。本章将从理论层面深入剖析自动化工作流的核心构成要素,重点探讨其本质特征、数据与控制流的协同逻辑,以及支撑系统长期稳定运行的可扩展性与容错保障机制。

自动化工作流的本质在于通过预定义规则、事件触发机制和状态管理策略,实现跨服务模块的任务自动流转与资源协调。它不仅要求任务能够按序执行,更强调对异常情况的识别与恢复能力、对实时数据变化的敏感度,以及对复杂依赖关系的精准建模。这种设计范式超越了传统脚本化调度的局限,转向以“状态驱动”和“事件响应”为核心的智能流程管理体系。

在推荐场景下,自动化工作流承担着从用户行为采集到模型推理输出再到结果展示的全链路串联任务。每一个环节都可能涉及多个微服务之间的交互,且各阶段的数据格式、处理节奏和服务可用性存在显著差异。因此,构建一个鲁棒性强、扩展灵活的自动化框架,是确保推荐服务质量与迭代效率的关键前提。接下来,我们将从三个维度展开论述:自动化流程的本质特征、数据流与控制流的协同机制,以及系统级的可扩展性与容错保障。

2.1 推荐系统中自动化流程的本质特征

自动化流程在推荐系统中的应用,并非简单地将一系列操作串联成定时任务,而是要解决多源异构数据环境下任务调度的动态性、一致性和可观测性问题。真正的自动化意味着系统能够在无人干预的情况下,根据内外部信号自主决策下一步动作,并在出现偏差时进行自我修复。这一能力的背后,是对“自动化”与“智能化”边界的清晰界定,以及对工作流引擎架构角色的准确定位。

2.1.1 自动化与智能化的区别与融合路径

尽管“自动化”与“智能化”常被混用,但二者在技术实现与目标导向上存在根本区别。自动化侧重于 流程的重复性执行与规则的确定性响应 ,例如每天凌晨触发一次用户画像更新任务;而智能化则关注 基于数据的学习与决策优化 ,如利用强化学习调整推荐排序权重。

| 维度 | 自动化 | 智能化 |

|---|---|---|

| 决策依据 | 预设规则、配置参数 | 数据驱动、模型预测 |

| 变化适应性 | 固定逻辑,需人工调参 | 动态学习,自动演进 |

| 错误容忍机制 | 重试、告警、回滚 | 异常检测、策略切换 |

| 典型应用场景 | 定时ETL任务、日志归档 | 实时个性化排序、冷启动推荐 |

| 技术栈代表 | Airflow、Cron、Kubernetes Jobs | TensorFlow Serving、Ray、Seldon Core |

在实际推荐系统中,两者并非对立,而是通过分层协作实现融合。典型的融合路径如下:

- 底层自动化承载高频稳定任务 :如用户行为日志的清洗、特征提取等,使用Airflow或Argo Workflows等工具构建可监控、可追溯的流水线;

- 中间层引入智能判断节点 :在关键分支(如是否触发模型重训练)插入ML模型判断模块,基于当前A/B测试指标或流量波动程度决定流程走向;

- 顶层支持反馈闭环 :将线上效果数据反哺至自动化流程配置,形成“执行 → 观察 → 调整”的自治循环。

例如,在Runway平台中,当监测到某类创意内容点击率连续三天下降超过15%,自动化流程不会立即重启模型训练,而是先调用一个轻量级分类器判断该现象是否由季节性因素引起。只有在排除外部干扰后,才激活完整的增量训练流水线——这正是自动化与智能化融合的典型体现。

2.1.2 工作流引擎在推荐任务中的角色定位

工作流引擎是自动化体系的大脑,负责解析流程定义、维护执行状态、调度任务节点并处理错误转移。在推荐系统中,其核心职责可归纳为四大功能: 编排(Orchestration)、状态管理(State Management)、依赖解析(Dependency Resolution)和容错控制(Fault Tolerance Control) 。

以Apache Airflow为例,其DAG(有向无环图)结构天然适合表达推荐流程中的阶段性依赖:

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

from datetime import datetime, timedelta

def extract_user_behavior():

# 从Kafka消费昨日用户行为日志

pass

def compute_user_embedding():

# 调用PyTorch模型生成用户向量

pass

def update_recommendation_index():

# 将新向量写入Elasticsearch

pass

default_args = {

'owner': 'runway-team',

'retries': 3,

'retry_delay': timedelta(minutes=5),

}

dag = DAG(

'recommendation_pipeline_daily',

default_args=default_args,

description='Daily user embedding update for Runway recommendations',

schedule_interval=timedelta(days=1),

start_date=datetime(2024, 1, 1),

catchup=False,

)

上述代码定义了一个标准的推荐更新流程。其中:

- extract_user_behavior 是数据入口,通常连接流式系统如Kafka或Flink;

- compute_user_embedding 执行模型推理,可能部署在GPU集群上;

- update_recommendation_index 负责将结果推送到检索服务。

逻辑分析:

- 第7行:函数定义用于封装具体业务逻辑,便于单元测试与复用;

- 第13–18行: default_args 设置了失败重试机制,这是推荐系统高可用的基础;

- 第26行: schedule_interval 设为每日一次,符合大多数离线更新需求;

- 第28行: catchup=False 防止历史积压任务并发执行导致资源过载。

该DAG体现了工作流引擎如何将复杂的推荐流程抽象为可视化、可版本控制的代码实体。更重要的是,Airflow提供了丰富的钩子(Hooks)和传感器(Sensors),允许与其他系统深度集成。例如,可通过 FileSensor 监听HDFS上的特征文件生成,或通过 HttpSensor 等待模型服务健康检查通过后再启动下游任务。

此外,现代工作流引擎还支持动态DAG生成,即根据配置中心的元数据自动生成不同用户的个性化更新计划,极大提升了系统的灵活性与运维效率。

2.1.3 基于事件驱动与状态机的流程控制模型

传统的定时调度模式难以应对突发流量或实时反馈需求,因此推荐系统的自动化流程越来越多采用 事件驱动架构(Event-Driven Architecture, EDA) 结合 有限状态机(Finite State Machine, FSM) 的控制模型。

在这种模型中,每个任务被视为一个状态变迁过程,其推进不再依赖时间轮询,而是由外部事件触发。例如,当用户完成一次完整观看行为时,会产生一个 video_watched 事件,该事件经由消息队列广播后,会激活“用户兴趣更新”流程。

状态机的设计如下表所示,描述了一个推荐模型更新任务的生命周期:

| 当前状态 | 触发事件 | 动作 | 下一状态 |

|---|---|---|---|

| IDLE | receive_trigger_signal | 启动特征拉取 | FETCHING_FEATURES |

| FETCHING_FEATURES | features_ready | 开始模型训练 | TRAINING_MODEL |

| TRAINING_MODEL | training_success | 验证模型性能 | VALIDATING_MODEL |

| VALIDATING_MODEL | validation_passed | 发布新模型 | DEPLOYING_MODEL |

| DEPLOYING_MODEL | deployment_complete | 切流生效 | ACTIVE |

| ACTIVE | rollback_required | 回滚至上一版本 | ROLLING_BACK |

该状态机可通过JSON Schema定义并在工作流引擎中实现:

{

"state": "FETCHING_FEATURES",

"context": {

"user_id": "usr_12345",

"trigger_time": "2025-04-05T10:00:00Z",

"feature_source": "kafka://behavior-topic/partition=3"

},

"transitions": [

{

"event": "features_ready",

"target_state": "TRAINING_MODEL",

"action": "invoke_training_job"

}

]

}

参数说明:

- state :当前所处阶段,用于幂等判断;

- context :携带上下文信息,确保跨服务调用的一致性;

- transitions :定义合法的状态跃迁路径,防止非法跳转。

此模型的优势在于:

- 解耦性强 :各状态处理服务只需监听感兴趣事件,无需知道全局流程;

- 可追溯性高 :每一步状态变更均可记录,便于审计与调试;

- 支持并行分支 :可在 VALIDATING_MODEL 阶段同时启动AB测试分流,提升决策效率。

在Runway的实际架构中,此类状态机常用于处理“创意内容上线→特征入库→索引更新→推荐曝光”的端到端流程,确保每个环节都有明确的状态标识与恢复机制。

2.2 数据流与控制流的协同机制

推荐系统的自动化工作流本质上是两条主线的交织:一条是承载原始数据、特征与模型输出的 数据流 ,另一条是驱动任务执行、传递指令与反馈状态的 控制流 。二者的高效协同决定了整个系统的吞吐能力与响应速度。

2.2.1 用户行为日志的采集与预处理管道

用户行为日志是推荐系统最核心的数据源之一,涵盖点击、播放、收藏、分享等多种交互类型。这些数据通常以高并发、小批次的形式产生,必须通过高效的采集管道进入后续处理流程。

典型的采集链路由以下组件构成:

- 前端埋点SDK :在Web/App端注入JavaScript或原生代码,捕获用户动作;

- HTTP Collector服务 :接收上报请求,做初步校验与压缩;

- 消息队列缓冲 :如Kafka,提供削峰填谷能力;

- 流处理引擎 :如Flink或Spark Streaming,执行实时过滤、去重与聚合;

- 存储层落地 :写入HDFS(离线)或Redis(在线)供后续使用。

// Flink Stream Processing Job 示例

DataStream<UserBehavior> stream = env

.addSource(new FlinkKafkaConsumer<>("user-behavior-topic", schema, props))

.filter(behavior -> behavior.getTimestamp() > System.currentTimeMillis() - 86400000) // 过滤24小时内数据

.keyBy(UserBehavior::getUserId)

.timeWindow(Time.minutes(5))

.aggregate(new BehaviorAggregator()); // 聚合为五分钟内的行为序列

逐行解析:

- 第2行:从Kafka订阅主题, schema 定义了解析规则(如Avro或JSON);

- 第3行:时间过滤避免处理陈旧数据,防止脏读;

- 第4行:按用户ID分组,保证同一用户行为落在同一分区;

- 第5–6行:设置滑动窗口,每5分钟统计一次活跃行为,适用于短期兴趣建模。

该管道需满足低延迟(<10s)、高吞吐(>10万条/秒)和 Exactly-Once 语义三大要求。为此,Flink启用了Checkpoint机制与TwoPhaseCommitSink,确保即使发生故障也不会丢失或重复写入。

2.2.2 实时特征提取中的时间窗口与滑动策略

在推荐排序中,用户的近期行为比远期更具预测价值。因此,特征工程常采用 滑动时间窗口 来计算动态指标,如“过去1小时内的点赞数”。

常见的时间窗口类型包括:

| 窗口类型 | 特点 | 适用场景 |

|---|---|---|

| 滚动窗口(Tumbling) | 固定周期,无重叠 | 每小时统计总播放量 |

| 滑动窗口(Sliding) | 固定长度,可重叠 | 每5分钟计算最近30分钟点赞趋势 |

| 会话窗口(Session) | 基于活动间隙划分 | 用户单次使用期间的行为聚类 |

以滑动窗口为例,其实现依赖于状态后端(如RocksDB)保存中间聚合值:

class SlidingWindowFeatureExtractor:

def __init__(self, window_size_sec=1800, slide_interval_sec=300):

self.window_size = window_size_sec

self.slide_interval = slide_interval_sec

self.state = defaultdict(list) # 用户ID → 时间戳列表

def update(self, user_id, timestamp, action_type):

now = time.time()

# 清理过期事件

self.state[user_id] = [t for t in self.state[user_id]

if now - t <= self.window_size]

# 添加新事件

self.state[user_id].append(timestamp)

# 返回当前窗口内指定行为的数量

return len([t for t in self.state[user_id]

if action_type in get_action_at(t)])

参数说明:

- window_size_sec :窗口跨度,影响特征的记忆长度;

- slide_interval_sec :滑动步长,决定更新频率;

- state :分布式环境中需对接外部存储(如Redis)以保证一致性。

该方法可用于生成“短期兴趣强度”、“内容偏好漂移指数”等高级特征,输入至深度排序模型(如DIN或DIEN)中提升点击率预估准确性。

2.2.3 控制指令在各服务模块间的传递协议设计

除了数据流动,控制指令的可靠传递同样关键。例如,当模型验证通过后,需发送“promote model”指令至部署服务;若检测到异常,则发出“pause indexing”命令。

为确保指令的有序性与可靠性,推荐采用 基于Topic的发布-订阅模式 ,并定义标准化的消息格式:

message ControlCommand {

string command_id = 1; // 唯一标识

string target_service = 2; // 目标服务名

string action = 3; // 动作类型:START, STOP, RELOAD等

map<string, string> parameters = 4; // 参数键值对

int64 timestamp = 5; // 发送时间戳

string source = 6; // 发起方身份

}

该Protocol Buffer结构具有良好的跨语言兼容性,可通过gRPC或Kafka传输。关键设计原则包括:

- 幂等性 :同一 command_id 多次投递只生效一次;

- 超时机制 :目标服务应在规定时间内确认接收,否则触发告警;

- 审计追踪 :所有指令需记录日志,支持事后回溯。

在Runway系统中,此类协议广泛应用于模型热更新、索引重建暂停、A/B测试开关切换等关键操作,确保控制流的透明与可控。

2.3 可扩展性与容错性的理论保障

随着推荐系统规模扩大,自动化工作流必须面对节点故障、网络分区、资源竞争等一系列挑战。为此,需从架构层面引入微服务解耦、异步通信与一致性处理机制,构建具备弹性和韧性的运行环境。

2.3.1 微服务架构下的解耦设计原则

推荐自动化流程通常包含十余个独立功能模块,如日志采集、特征计算、模型服务、索引更新等。若全部耦合在一个单体应用中,极易因局部故障引发雪崩效应。因此,采用微服务架构进行水平拆分至关重要。

核心解耦原则包括:

- 单一职责 :每个服务仅负责一个明确的功能边界;

- 独立部署 :可通过Kubernetes实现灰度发布与快速回滚;

- 异步通信 :优先使用消息队列而非直接RPC调用;

- API契约化 :通过OpenAPI或gRPC Proto明确定义接口。

例如,Runway将“特征生成”与“模型推理”分离为两个独立服务,前者输出Parquet文件至S3,后者定时扫描目录获取最新特征。这种方式虽增加了一定延迟,但极大增强了系统的可维护性与升级灵活性。

2.3.2 异步消息队列在异常恢复中的应用机制

当某个处理节点宕机时,同步调用链会立即中断,而异步消息队列(如Kafka、RabbitMQ)则能起到缓冲作用,保障消息不丢失。

以Kafka为例,其副本机制与消费者组特性天然支持容错:

# Kafka Consumer 配置示例

enable.auto.commit=false

auto.offset.reset=earliest

max.poll.records=500

heartbeat.interval.ms=3000

session.timeout.ms=10000

参数解释:

- enable.auto.commit=false :关闭自动提交偏移量,防止数据丢失;

- auto.offset.reset=earliest :首次启动时从头消费,确保补全历史数据;

- max.poll.records :控制单次拉取量,避免内存溢出;

- session.timeout.ms :若消费者10秒内未发送心跳,视为死亡,触发Rebalance。

结合死信队列(DLQ)机制,可将多次消费失败的消息转入特殊Topic供人工排查,而不阻塞主流程。这对于处理异常样本(如畸形JSON)尤为重要。

2.3.3 分布式环境下的一致性与幂等性处理方案

在分布式自动化流程中,由于网络抖动或重试机制,同一任务可能被多次执行。若不加以控制,会导致特征重复计算、索引冗余写入等问题。

解决方案包括:

- 全局唯一ID + 分布式锁 :在任务启动前尝试获取Redis锁,键名为

lock:task:${unique_id}; - 数据库乐观锁 :在状态表中添加version字段,更新时检查版本一致性;

- 幂等接口设计 :对于“更新用户画像”类操作,使用UPSERT语义而非INSERT。

-- 幂等更新SQL示例

UPDATE user_profile

SET embedding = ?, updated_at = NOW(), version = version + 1

WHERE user_id = ? AND version = ?

RETURNING version;

若返回受影响行数为0,说明版本冲突,客户端应重试或放弃。该机制在Runway的每日批量更新任务中广泛应用,有效防止了因Airflow重试导致的数据污染。

综上所述,自动化工作流的设计不仅是技术选型的问题,更是对系统哲学的理解与实践。唯有在自动化、数据协同与容错机制三者之间取得平衡,才能支撑起像Runway这样高复杂度、高实时性的推荐系统长期稳定运行。

3. Runway搜索推荐自动化工作流的实践构建

在Runway平台日益增长的内容体量与用户交互复杂度背景下,传统手动运维和静态调度机制已难以支撑高效、精准的推荐服务。为此,构建一套可扩展、高可用且具备动态响应能力的自动化工作流成为系统演进的关键路径。该工作流不仅需要打通从数据采集到模型推理再到结果展示的完整链路,还需支持实时反馈驱动下的模型迭代与配置更新。本章将围绕实际工程落地场景,系统阐述Runway搜索推荐自动化工作流的构建过程,涵盖核心组件选型、流程实施细节以及动态更新机制的设计与实现。

3.1 核心组件的技术选型与集成

自动化工作流的稳定运行依赖于多个关键中间件系统的协同配合。在技术栈的选择上,必须兼顾性能、可靠性、可维护性以及生态兼容性。Runway团队最终选定Apache Airflow作为任务调度中枢,Kafka承担跨服务间的数据传输职责,Elasticsearch则用于支撑语义层面的快速检索能力。三者共同构成了自动化流程的“大脑”、“神经”与“记忆库”,实现了控制流与数据流的高度解耦。

3.1.1 使用Airflow构建任务调度中枢

Airflow凭借其基于DAG(有向无环图)的任务编排模型,在复杂依赖关系管理方面展现出强大优势。对于Runway推荐系统而言,每日需执行包括日志清洗、特征提取、模型训练、A/B测试切换等数十个相互关联的任务,若采用脚本+cron的方式极易造成逻辑混乱与故障排查困难。通过Airflow,可将整个推荐流水线定义为一个结构化的DAG,明确各节点之间的前后置依赖。

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

from datetime import datetime, timedelta

def extract_user_behavior():

# 模拟从Kafka消费用户行为日志并写入HDFS

print("Extracting user behavior logs from Kafka...")

# 实际调用Spark Streaming或Flink作业

pass

def generate_features():

# 基于历史行为生成用户画像特征

print("Generating user and item features...")

# 调用特征工程模块,输出至特征存储

pass

def trigger_model_training():

# 触发PyTorch模型训练任务

print("Triggering model retraining job via MLflow...")

# 提交训练任务至Kubernetes集群

pass

# 定义DAG配置

default_args = {

'owner': 'runway-recommendation',

'depends_on_past': False,

'start_date': datetime(2025, 4, 1),

'retries': 2,

'retry_delay': timedelta(minutes=5),

}

dag = DAG(

'recommendation_pipeline_v3',

default_args=default_args,

description='End-to-end recommendation workflow',

schedule_interval=timedelta(hours=1),

catchup=False

)

# 定义任务节点

t1 = PythonOperator(

task_id='extract_behavior_logs',

python_callable=extract_user_behavior,

dag=dag

)

t2 = PythonOperator(

task_id='feature_engineering',

python_callable=generate_features,

dag=dag

)

t3 = PythonOperator(

task_id='model_retraining',

python_callable=trigger_model_training,

dag=dag

)

# 设置任务依赖

t1 >> t2 >> t3

代码逻辑逐行分析:

- 第1–2行导入Airflow核心类,建立DAG定义基础;

extract_user_behavior函数模拟了从消息队列拉取原始行为日志的过程,通常由Spark/Flink完成;generate_features执行特征转换,如计算点击率、停留时长统计等;trigger_model_training封装对机器学习平台(如MLflow/Kubeflow)的调用接口;default_args中设置了重试策略、负责人信息及启动时间;schedule_interval=timedelta(hours=1)表示每小时触发一次全流程;- 最后通过

>>操作符声明任务顺序:先抽取 → 再特征处理 → 最后训练。

| 参数 | 含义 | 推荐值 |

|---|---|---|

start_date |

DAG首次生效时间 | 不早于当前部署日期 |

schedule_interval |

调度周期 | 根据业务需求设为分钟/小时级 |

catchup |

是否补跑历史周期 | 生产环境建议设为False |

retries |

失败重试次数 | 一般设为2–3次 |

retry_delay |

重试间隔 | 避免雪崩,建议≥5分钟 |

Airflow Web UI提供了可视化的任务监控面板,支持查看每个实例的执行状态、日志输出和依赖拓扑,极大提升了运维效率。此外,结合Sentry进行异常捕获,并通过Slack webhook发送失败告警,形成闭环告警体系。

3.1.2 Kafka作为实时数据传输通道的部署实践

在推荐系统中,用户行为事件(如播放、点赞、分享)具有高并发、低延迟的特点,传统的HTTP轮询或数据库轮转方式无法满足实时性要求。Kafka以其高吞吐、持久化、分区复制等特性,成为Runway平台首选的消息中间件。

Kafka集群采用三层架构设计:

- Producer层 :前端SDK与埋点服务将用户行为序列化为Avro格式后推送至主题;

- Broker层 :由6个Broker组成的集群,分3个机架部署以实现容灾;

- Consumer层 :Flink作业订阅特定Topic,进行窗口聚合与特征流式计算。

以下是典型的生产者配置代码片段:

Properties props = new Properties();

props.put("bootstrap.servers", "kafka-cluster.runway.internal:9092");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "io.confluent.kafka.serializers.KafkaAvroSerializer");

props.put("schema.registry.url", "http://schema-registry.runway.internal:8081");

props.put("acks", "all"); // 强一致性保证

props.put("retries", 3);

props.put("enable.idempotence", true); // 幂等生产者防止重复发送

Producer<String, GenericRecord> producer = new KafkaProducer<>(props);

String topic = "user-behavior-events-v2";

// 构造Avro记录

Schema schema = ...; // 从Schema Registry获取

GenericRecord record = new GenericData.Record(schema);

record.put("user_id", "U123456");

record.put("item_id", "V789012");

record.put("action_type", "play_completion");

record.put("timestamp", System.currentTimeMillis());

ProducerRecord<String, GenericRecord> data =

new ProducerRecord<>(topic, null, null, record);

producer.send(data, (metadata, exception) -> {

if (exception != null) {

log.error("Failed to send message", exception);

} else {

log.info("Sent to partition {} with offset {}", metadata.partition(), metadata.offset());

}

});

参数说明与逻辑解析:

bootstrap.servers指定初始连接节点,客户端会自动发现其他Broker;- 使用Confluent提供的Avro序列化器,确保消息结构严格受控;

schema.registry.url指向中央Schema注册中心,保障上下游兼容性;acks=all要求所有ISR副本确认写入,牺牲部分性能换取强一致性;enable.idempotence=true开启幂等模式,避免网络重试导致重复投递;- 回调函数中记录发送成功或失败情况,便于追踪问题。

| Topic名称 | 分区数 | Replication Factor | 消费组 |

|---|---|---|---|

user-behavior-events-v2 |

24 | 3 | flink-feature-extractor |

realtime-feature-updates |

12 | 2 | model-scoring-service |

ab_test_decisions |

6 | 3 | frontend-personalization |

上述配置保障了每秒超过50万条事件的稳定摄入,端到端延迟控制在800ms以内。同时,利用Kafka Connect组件对接Elasticsearch和ClickHouse,实现多目的地同步。

3.1.3 Elasticsearch支持语义检索的服务搭建

为了提升推荐系统的语义理解能力,Runway引入Elasticsearch构建多模态内容索引。通过对视频标题、描述文本、标签及ASR语音转录内容进行全文索引,ES能够在毫秒级别返回相关候选集,作为精排阶段的重要输入源。

部署方案采用Hot-Warm架构:

- Hot节点 :高性能SSD服务器,承载最新7天内高频访问的内容;

- Warm节点 :大容量HDD机器,存放历史内容,降低存储成本;

- 索引按天滚动创建(rollover),并通过ILM(Index Lifecycle Management)自动迁移。

映射定义如下:

PUT /content-embeddings-2025.04.01

{

"settings": {

"number_of_shards": 6,

"number_of_replicas": 2,

"index.routing.allocation.require.data": "hot"

},

"mappings": {

"properties": {

"video_id": { "type": "keyword" },

"title": { "type": "text", "analyzer": "english" },

"description": { "type": "text", "analyzer": "standard" },

"tags": { "type": "keyword" },

"embedding_vector": {

"type": "dense_vector",

"dims": 512,

"index": true,

"similarity": "cosine"

},

"upload_timestamp": { "type": "date" }

}

}

}

字段解释:

- embedding_vector 字段使用dense_vector类型存储CLIP模型生成的视觉-文本联合嵌入向量;

- similarity="cosine" 指定使用余弦相似度进行最近邻搜索;

- number_of_shards=6 适配单节点CPU核数,避免碎片过多;

- index.routing.allocation.require.data=hot 强制分配至热节点。

查询语句示例(基于混合语义+向量检索):

POST /content-embeddings-*/_search

{

"size": 20,

"query": {

"hybrid": {

"queries": [

{

"match": {

"title": { "query": "aerial drone footage of mountains", "boost": 2 }

}

},

{

"script_score": {

"query": { "match_all": {} },

"script": {

"source": "cosineSimilarity(params.query_vector, 'embedding_vector') + 1.0",

"params": {

"query_vector": [0.81, -0.22, ..., 0.67] // 查询向量

}

}

}

}

]

}

}

}

该查询结合关键词匹配与向量相似度打分,通过加权融合提升召回质量。实验表明,相比纯关键词检索,Hybrid模式下NDCG@10提升达37%。

3.2 自动化流程的具体实施步骤

3.2.1 从原始数据到特征向量的ETL全流程配置

推荐系统的特征质量直接决定排序效果。Runway构建了一套端到端的ETL管道,覆盖从原始日志到标准化特征向量的全过程。该流程每日处理超2TB的行为数据,输出至在线特征存储供实时推理使用。

主要阶段包括:

1. 日志采集 :通过Flume代理收集Nginx访问日志与客户端埋点;

2. 清洗去噪 :过滤机器人流量、异常IP、重复提交;

3. 会话切分 :基于30分钟不活跃窗口划分用户会话;

4. 行为编码 :将动作映射为数值型特征(如play→1, like→2);

5. 向量化表示 :使用Transformer-based Behavior Encoder生成用户行为序列表征。

import torch

from transformers import BertModel, BertTokenizer

class BehaviorEncoder(torch.nn.Module):

def __init__(self, vocab_size=1000, embedding_dim=128, hidden_dim=256):

super().__init__()

self.embedding = torch.nn.Embedding(vocab_size, embedding_dim)

self.transformer = BertModel.from_pretrained('bert-base-uncased')

self.fc = torch.nn.Linear(hidden_dim, 512)

def forward(self, input_ids, attention_mask):

embedded = self.embedding(input_ids)

outputs = self.transformer(inputs_embeds=embedded, attention_mask=attention_mask)

cls_token = outputs.last_hidden_state[:, 0, :] # 取[CLS]向量

return self.fc(cls_token)

# 加载预训练权重

model = BehaviorEncoder()

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

# 示例行为序列:"view→watch_50%→like→share"

behavior_seq = ["view", "watch_half", "like", "share"]

input_ids = tokenize_sequence(behavior_seq) # 映射为ID序列

attention_mask = torch.ones_like(input_ids)

with torch.no_grad():

user_vector = model(input_ids.unsqueeze(0), attention_mask.unsqueeze(0))

执行逻辑说明:

- 利用BERT架构捕捉行为序列中的上下文依赖;

- 输入经Embedding层转化为稠密向量;

- Transformer输出的[CLS] token代表整体语义;

- 全连接层将其压缩为512维标准特征向量;

- 输出存入Redis Feature Store,Key为 user:{uid}:behavior_emb 。

| 阶段 | 工具 | 输出频率 | 存储位置 |

|---|---|---|---|

| 日志采集 | Flume + Filebeat | 实时 | Kafka Topic |

| 数据清洗 | Spark SQL | 每小时 | Hudi Table |

| 特征计算 | Flink CEP | 实时 | Redis Cluster |

| 向量生成 | PyTorch Batch Job | 每天 | S3 + Online DB |

整个ETL流程通过Airflow统一调度,并设置SLA监控,一旦某环节延迟超过阈值即触发告警。

3.2.2 模型推理服务的API封装与调用链路打通

训练完成的模型需通过RESTful API对外提供评分服务。Runway采用TorchServe进行模型托管,实现版本管理、自动扩缩容与请求批处理。

服务定义文件 config.properties :

inference_address=http://0.0.0.0:8080

management_address=http://0.0.0.0:8081

metrics_address=http://0.0.0.0:8082

model_store=/models

load_models=recommender_v4.mar

打包命令:

torch-model-archiver \

--model-name recommender_v4 \

--version 1.2.0 \

--model-file model.py \

--serialized-file trained_model.pth \

--handler inference_handler.py \

--export-path /models

推理处理器 inference_handler.py 关键代码:

def handle(data, context):

if not data:

return None

# 解析请求体

request = json.loads(data[0].get("body", "{}"))

user_emb = request["user_vector"]

candidate_items = request["candidates"]

# 向量化候选集

item_embs = fetch_item_embeddings(candidate_items)

# 执行矩阵乘法计算匹配分数

scores = np.dot(user_emb, item_embs.T)

ranked_indices = np.argsort(scores)[::-1]

result = [

{"item_id": candidate_items[i], "score": float(scores[i])}

for i in ranked_indices

]

return [json.dumps(result)]

调用链路说明:

1. 前端发起推荐请求 →

2. Gateway路由至Ranking Service →

3. Ranking Service调用Feature Service获取user/item向量 →

4. 发起POST请求至TorchServe /predictions/recommender_v4 →

5. 返回排序结果并缓存至Redis。

全链路通过OpenTelemetry实现分布式追踪,定位耗时瓶颈。

3.2.3 排序结果自动生成并推送到前端展示层的闭环实现

最终推荐结果需以JSON格式推送给前端。Runway采用Server-Sent Events(SSE)保持长连接,实现实时刷新。

后端推送逻辑:

from flask import Flask, Response

import json

import redis

app = Flask(__name__)

r = redis.Redis(host='redis.runway.internal', port=6379)

@app.route('/stream/recommendations/<user_id>')

def stream_recommendations(user_id):

def event_stream():

pubsub = r.pubsub()

pubsub.subscribe(f'recs:{user_id}')

for message in pubsub.listen():

if message['type'] == 'message':

yield f"data: {message['data'].decode()}\n\n"

return Response(event_stream(), mimetype="text/event-stream")

前端监听:

const eventSource = new EventSource("/stream/recommendations/U123456");

eventSource.onmessage = function(event) {

const recommendations = JSON.parse(event.data);

updateUI(recommendations);

};

每当新一批推荐生成,系统通过Redis发布消息:

PUBLISH recs:U123456 '[{"item_id":"V789","score":0.96},...]'

前端即时接收并渲染,延迟低于200ms。

3.3 动态更新机制的实际落地

3.3.1 增量学习触发条件的设定与监控

为应对概念漂移,Runway实施增量学习机制。当以下任一条件满足时自动触发再训练:

- 新增样本量 ≥ 10万;

- A/B测试胜出模型准确率下降 > 5%;

- 特征覆盖率低于90%。

监控指标由Prometheus采集,Grafana可视化:

| 指标名 | 采集方式 | 报警阈值 |

|---|---|---|

new_samples_count |

Spark Counter | ≥100000 |

model_accuracy_drop |

Evaluator Job | Δ < -0.05 |

feature_coverage_ratio |

Data Quality Check | < 0.9 |

3.3.2 模型版本管理与A/B测试集成策略

所有模型版本注册至MLflow Tracking Server,并与Git Commit ID绑定。灰度发布通过Istio VirtualService实现流量切分:

apiVersion: networking.istio.io/v1beta1

kind: VirtualService

spec:

http:

- route:

- destination:

host: ranking-service

subset: v3

weight: 90

- destination:

host: ranking-service

subset: v4-experiment

weight: 10

线上AB测试持续7天,核心指标达标后全量上线。

3.3.3 配置变更自动同步至运行时环境的方法

使用Consul + Envoy Sidecar实现配置热更新。当Airflow完成新规则部署后,触发Consul KV写入:

curl -X PUT -d '{"threshold": 0.85}' http://consul/runway/rec/config

Envoy监听变更并重新加载策略,无需重启服务。

以上章节完整展示了Runway搜索推荐自动化工作流的工程实践,涵盖组件选型、流程实施与动态更新三大维度,形成了可复制、可观测、可治理的技术闭环。

4. 性能优化与稳定性保障的深度实践

在现代AI驱动的搜索推荐系统中,性能与稳定性是决定用户体验和平台可扩展性的核心要素。Runway作为集视频生成、素材检索与创意推荐于一体的高并发平台,其自动化工作流必须在毫秒级响应时间内完成从用户请求到结果返回的完整闭环。然而,随着内容库规模指数级增长、模型复杂度不断提升以及实时性要求日益严苛,传统的架构设计已难以满足生产环境下的高效稳定运行需求。本章聚焦于 性能瓶颈识别、高可用容错机制构建及资源利用率精细化调控 三大维度,深入探讨如何通过技术手段实现系统吞吐量最大化、延迟最小化和故障影响最小化的统一目标。

4.1 系统响应延迟的瓶颈分析与突破

搜索推荐系统的端到端延迟直接影响用户的交互体验。当一次查询需要超过300ms才能返回结果时,用户感知明显下降;而若延迟波动剧烈或出现超时,则可能导致推荐失效甚至前端崩溃。因此,对延迟进行细粒度拆解并针对性优化,成为提升服务质量的关键路径。

4.1.1 关键路径上的耗时分解与热点函数识别

要实现精准优化,首先需明确整个请求链路中的关键路径(Critical Path),即决定整体响应时间的最长执行序列。以Runway的一次典型搜索请求为例,其处理流程可划分为以下几个阶段:

| 阶段 | 子任务 | 平均耗时(ms) | 占比 |

|---|---|---|---|

| 请求接入 | API网关解析、认证鉴权 | 15 | 5% |

| 查询理解 | NLP意图解析、实体抽取 | 40 | 13% |

| 候选召回 | 向量相似度检索 + 关键词匹配 | 180 | 60% |

| 精排打分 | 深度排序模型推理 | 50 | 17% |

| 结果组装 | 过滤、去重、格式化输出 | 15 | 5% |

从表中可见, 候选召回阶段占据总延迟的60%以上 ,是主要瓶颈所在。进一步使用分布式追踪工具(如Jaeger或OpenTelemetry)对服务调用链进行采样分析,可以定位到具体热点函数。例如,在基于Faiss的向量检索模块中, search() 方法在高维空间(如768维CLIP嵌入)下执行暴力搜索时,CPU占用率高达90%,单次查询平均耗时达160ms。

import faiss

import numpy as np

# 初始化索引(示例:使用IVF-PQ进行近似检索)

dimension = 768

nlist = 100 # 聚类中心数量

m = 16 # 每个子空间编码比特数

quantizer = faiss.IndexFlatIP(dimension) # 内积距离

index = faiss.IndexIVFPQ(quantizer, dimension, nlist, m, 8)

index.train(train_vectors) # 训练聚类器

index.add(embedded_vectors)

# 执行查询

D, I = index.search(query_vector, k=50) # 返回top-50近邻

代码逻辑逐行解读:

- 第4–7行:定义IVF-PQ索引结构。其中

nlist=100表示将向量空间划分为100个簇,减少搜索范围;m=16表示将原始768维向量切分为16个子向量,每个子向量用8-bit码本压缩。 - 第8行:调用

train()方法在训练集上学习聚类中心,确保后续聚类分配合理。 - 第9行:将所有素材向量加入索引数据库。

- 第12行:执行实际搜索操作。该步骤涉及两步:

1. 查找查询向量所属的最近几个簇(Inverted File);

2. 在这些簇内使用PQ编码快速计算近似距离。

参数说明与优化方向:

- nlist 越大,聚类越精细,召回精度越高,但索引构建时间和内存消耗上升;

- m 控制压缩程度, m 越小压缩率越高,速度越快,但精度损失明显;

- 可结合HNSW图结构替代IVF,进一步提升检索效率(见下一节)。

通过对热点函数持续监控,并引入火焰图(Flame Graph)可视化CPU时间分布,团队发现约45%的时间消耗在PQ解码过程。为此,采用SIMD指令集优化解码循环,并启用GPU加速版Faiss( faiss-gpu ),最终使平均检索延迟降至60ms以下,降幅超过60%。

4.1.2 向量相似度计算的近似算法优化(如HNSW)

尽管IVF-PQ已在一定程度上缓解了暴力搜索的压力,但在亿级向量库中仍面临扩展性挑战。为此,Runway引入 分层可导航小世界图(Hierarchical Navigable Small World, HNSW) 作为新一代近似最近邻(ANN)检索方案。

HNSW的核心思想是构建多层图结构:顶层稀疏,用于快速“跳跃”式导航;底层密集,保证高精度局部搜索。其时间复杂度接近O(log n),远优于传统KNN的O(n)。

import hnswlib

# 构建HNSW索引

dim = 768

num_elements = len(vectors)

p = hnswlib.Index(space='cosine', dim=dim)

p.init_index(max_elements=num_elements, ef_construction=200, M=16)

p.add_items(vectors, ids)

p.set_ef(50) # 查询时探索的候选节点数

labels, distances = p.knn_query(query_vector, k=50)

代码逻辑逐行解读:

- 第5行:指定相似度空间为余弦距离(适合语义向量比较);

- 第6行:初始化索引,

M=16控制每层图中每个节点的最大连接数,影响图密度和搜索精度; ef_construction=200表示构建阶段的动态候选队列大小,值越大精度越高,但建索引更慢;- 第8行:插入全部向量化素材;

- 第9行:设置查询参数

ef,控制搜索广度,通常设为k的倍数; - 第10行:执行k近邻查询。

| 参数 | 推荐取值 | 影响 |

|---|---|---|

| M | 16~48 | 决定图的连接密度,影响内存与搜索速度 |

| ef_construction | 100~200 | 建立索引时的质量,越高越好 |

| ef | 10~100 | 查询时的探索深度,直接影响延迟与召回率 |

在Runway的实际部署中,配置 M=32 , ef=64 后,在包含1200万条768维向量的数据集上实现了 平均98.7%的Top-100召回率 ,同时查询延迟稳定在 35ms以内 (P99 < 50ms)。相比原IVF-PQ方案,延迟降低约40%,且无需聚类训练步骤,支持在线增量添加数据。

此外,为应对突发流量高峰,系统还实现了 自适应ef调节机制 :根据当前QPS动态调整 ef 值,在低负载时提高精度,在高并发时适当牺牲部分召回以换取响应速度,形成软性SLA保障。

4.1.3 缓存层级设计:Redis + Local Cache协同加速

即使底层检索已高度优化,频繁访问相同查询仍会造成不必要的重复计算。为此,Runway构建了 两级缓存体系 :全局共享缓存(Redis集群)与本地进程缓存(LRU in-memory cache),形成互补加速结构。

from functools import lru_cache

import redis

import json

# 全局Redis客户端

r = redis.Redis(host='redis-cluster', port=6379, db=0)

@lru_cache(maxsize=1000)

def get_local_cache_key(user_id: int, query: str):

return f"{user_id}:{hash(query)}"

def cached_vector_search(user_id: int, query: str, k: int):

local_key = get_local_cache_key(user_id, query)

# 优先检查本地缓存

result = getattr(cached_vector_search, 'local_cache', {}).get(local_key)

if result:

return result

# 兜底查Redis

redis_key = f"search:{local_key}"

cached = r.get(redis_key)

if cached:

result = json.loads(cached)

else:

result = perform_ann_search(query, k=k)

r.setex(redis_key, 300, json.dumps(result)) # TTL 5分钟

# 更新本地缓存

if not hasattr(cached_vector_search, 'local_cache'):

cached_vector_search.local_cache = {}

cached_vector_search.local_cache[local_key] = result

return result

代码逻辑逐行解读:

- 第7–10行:利用Python内置

@lru_cache装饰器实现轻量级本地缓存,限制最多缓存1000个键; - 第14–16行:尝试从对象属性字典中获取本地缓存结果,避免跨请求污染;

- 第19–23行:若本地未命中,则访问Redis集群,键名带前缀便于管理;

setex设置5分钟过期时间,防止陈旧结果长期驻留;- 第26–30行:写回本地缓存,提升同一进程内重复查询的响应速度。

| 缓存层级 | 存储介质 | 容量 | 命中延迟 | 适用场景 |

|---|---|---|---|---|

| L1 Local Cache | 进程内存 | 小(~MB) | <1ms | 高频相同用户/查询 |

| L2 Redis Cluster | 分布式内存 | 大(TB级) | ~5ms | 跨实例共享热点结果 |

该双层缓存策略上线后,整体缓存命中率达到 72% ,日均减少约380万次ANN计算调用,显著减轻后端压力。同时引入 缓存预热机制 :在每日早高峰前,基于昨日热门搜索词批量加载Top 1000查询结果至Redis,进一步提升初始时段响应性能。

4.2 高可用架构下的故障应对策略

在分布式环境下,任何单一组件的不可用都可能引发连锁反应。Runway的推荐工作流横跨十余个微服务模块,涵盖数据采集、特征工程、模型推理与结果推送等环节,必须建立完善的高可用防护体系。

4.2.1 多副本部署与负载均衡的配置实践

为消除单点故障,所有核心服务均采用 多副本+自动扩缩容 模式部署于Kubernetes集群。每个Pod运行独立实例,并通过Service抽象暴露稳定的DNS名称。

apiVersion: apps/v1

kind: Deployment

metadata:

name: ranking-model-service

spec:

replicas: 6

selector:

matchLabels:

app: ranking-model

template:

metadata:

labels:

app: ranking-model

spec:

containers:

- name: model-server

image: registry/runway/ranking:v2.3.1

ports:

- containerPort: 8080

resources:

limits:

cpu: "2"

memory: "4Gi"

nvidia.com/gpu: 1

readinessProbe:

httpGet:

path: /health

port: 8080

initialDelaySeconds: 30

periodSeconds: 10

配置说明:

replicas: 6确保至少6个实例并行处理请求;resources.limits限定GPU资源,防止资源争抢;readinessProbe由Envoy Sidecar定期探测,仅当健康检查通过才纳入负载均衡池;- 结合Horizontal Pod Autoscaler(HPA),依据CPU/GPU利用率自动伸缩副本数。

前端流量经由Nginx Ingress Controller进入,再由Istio Service Mesh完成内部服务间的智能路由。默认采用 加权轮询(Weighted Round Robin) 策略,可根据各副本的实时负载动态调整权重。

4.2.2 断路器模式在服务降级中的具体应用

当某依赖服务(如Elasticsearch)出现响应缓慢或错误率飙升时,直接重试会导致调用方线程阻塞,进而引发雪崩效应。为此,Runway在API网关与关键服务间部署了 断路器(Circuit Breaker)机制 ,基于Resilience4j库实现。

@CircuitBreaker(name = "es-service", fallbackMethod = "fallbackSearch")

public List<ContentItem> fullTextSearch(String query) {

return elasticsearchClient.search(buildQuery(query));

}

public List<ContentItem> fallbackSearch(String query, Exception e) {

log.warn("ES degraded due to {}, serving from cache", e.getMessage());

return cacheService.getFallbackResults(query);

}

逻辑分析:

- 当连续10次调用失败率超过50%时,断路器跳闸,进入OPEN状态;

- 此后所有请求直接走

fallbackSearch,不再发起远程调用; - 经过一定冷却时间(如30秒)后进入HALF_OPEN状态,允许少量试探性请求;

- 若成功则恢复CLOSED状态,否则继续隔离。

此机制使得在ES集群升级期间,推荐服务仍可通过缓存提供基础检索能力,保障核心功能可用。

4.2.3 日志追踪体系与分布式监控告警联动机制

为实现故障快速定位,Runway搭建了统一的日志与监控平台,集成ELK(Elasticsearch+Logstash+Kibana)与Prometheus+Grafana体系。

| 监控指标 | 采集方式 | 告警阈值 | 动作 |

|---|---|---|---|

| HTTP 5xx 错误率 | Prometheus exporter | >1% 持续2分钟 | 自动触发Sentry告警 |

| P99 延迟 | OpenTelemetry trace | >500ms 持续1分钟 | 触发Slack通知值班工程师 |

| Kafka消费滞后 | JMX metrics | >1000条 | 启动额外消费者实例 |

通过Grafana仪表板实时观察各服务的QPS、延迟、错误率与资源使用情况,结合Jaeger追踪任意一次请求的完整调用链,可在5分钟内定位绝大多数异常根源。

4.3 资源利用率的精细化调控

高性能不应以资源浪费为代价。Runway通过弹性调度、批处理优化与存储分级策略,实现了成本与效率的最佳平衡。

4.3.1 GPU资源按需分配的弹性伸缩策略

深度模型推理严重依赖GPU,但全天候独占会造成巨大浪费。为此,采用 KEDA(Kubernetes Event Driven Autoscaling) 基于事件驱动自动扩缩容。

apiVersion: keda.sh/v1alpha1

kind: ScaledObject

metadata:

name: model-inference-scaledobject

spec:

scaleTargetRef:

name: model-inference-deployment

triggers:

- type: prometheus

metadata:

serverAddress: http://prometheus.monitoring:9090

metricName: request_queue_length

threshold: '10'

query: sum(rate(http_requests_inflight{job="model"}[2m]))

每当待处理请求数超过10,KEDA即触发扩容,新增Pod直至队列清空。夜间低峰期可缩容至1个实例,节省70%以上的GPU开销。

4.3.2 批处理作业的时间窗优化以避开高峰流量

离线特征生成、模型训练等批处理任务被安排在UTC 00:00–06:00执行,避开亚太与欧美活跃时段。Airflow DAG中显式设定执行窗口:

with DAG('daily_feature_pipeline', start_date=days_ago(1), schedule_interval='0 2 * * *') as dag:

extract_task >> transform_task >> load_to_redis

同时启用背压机制:若上游数据延迟,则推迟下游任务,避免瞬时资源冲击。

4.3.3 冷热数据分离存储降低I/O开销的有效手段

素材元数据按访问频率分为“热”、“温”、“冷”三级:

| 类型 | 存储介质 | 保留周期 | 访问延迟 |

|---|---|---|---|

| 热数据(近7天) | Redis + SSD | 永久 | <5ms |

| 温数据(7–90天) | Elasticsearch | 90天 | ~20ms |

| 冷数据(>90天) | S3 Glacier Deep Archive | 1年 | ~5s |

通过自动归档策略,热库存储占比控制在30%以内,整体存储成本降低58%。

5. 面向未来的自动化演进方向与生态整合展望

5.1 MLOps驱动的全链路自治闭环构建

随着AI模型在Runway推荐系统中扮演的角色愈发核心,传统“开发-部署-监控”割裂的模式已难以满足高频迭代与质量保障的双重需求。MLOps作为连接机器学习与工程实践的桥梁,正在重塑推荐系统的自动化演进路径。其核心在于将CI/CD(持续集成/持续交付)理念扩展至ML生命周期,形成涵盖数据版本管理、自动训练流水线、模型验证与灰度发布的端到端流程。

以Runway为例,典型的MLOps自动化工作流可设计如下:

# .mlops/pipeline.yaml 示例:基于Argo Workflows的声明式ML流水线

apiVersion: argoproj.io/v1alpha1

kind: Workflow

metadata:

name: runway-recommender-train-pipeline

spec:

entrypoint: train-loop

templates:

- name: train-loop

dag:

tasks:

- name: fetch-data

template: data-extraction

arguments:

parameters: [{name: date, value: "{{workflow.parameters.run-date}}"}]

- name: preprocess

depends: "fetch-data"

template: feature-engineering

- name: train-model

depends: "preprocess"

template: pytorch-training-job

- name: evaluate

depends: "train-model"

template: model-evaluation

when: "{{tasks.train-model.outputs.result}} == 'success'"

- name: promote-to-staging

depends: "evaluate"

template: deploy-model

when: "{{tasks.evaluate.outputs.parameters.accuracy}} > 0.92"

该配置实现了从数据拉取、特征处理、模型训练到评估上线的全流程自动化控制。其中关键参数说明如下:

- when 条件表达式实现智能决策分支;

- outputs.parameters 支持跨任务指标传递;

- 基于Kubernetes Operator的训练任务支持GPU资源动态申请。

在此基础上,结合DVC(Data Version Control)进行数据集版本追踪,并利用MLflow记录实验元数据,可形成完整的可追溯性链条。例如:

| 实验编号 | 模型架构 | 训练数据版本 | AUC Score | 上线状态 |

|---|---|---|---|---|

| exp-101 | Transformer+MMOE | data-v3.2-alpha | 0.876 | ✅ 已上线 |

| exp-102 | CLIP-Adapter-Large | data-v3.2-beta | 0.903 | 🟡 待评估 |

| exp-103 | ViT-B/32 + Text Encoder | data-v3.1 | 0.861 | ❌ 已废弃 |

通过自动化脚本定期扫描MLflow API获取最新高性能模型,并触发Kaniko镜像构建与Helm发布流程,真正实现“模型即代码”的工业化交付标准。

5.2 LLM赋能的自然语言规则配置体系

未来自动化的一大突破点在于降低非技术用户的参与门槛。借助大语言模型(LLM),Runway可构建一个基于对话式交互的推荐策略编辑器。用户只需输入如“优先展示近期上传的竖屏舞蹈类视频,排除低分辨率内容”等自然语言指令,系统即可自动解析为结构化查询语句并注入排序模块。

其实现逻辑分为三步:

1. 意图识别 :使用微调后的BERT或RoBERTa分类器判断指令类型(如“过滤”、“加权”、“时间约束”);

2. 槽位填充 :采用序列标注模型(BiLSTM-CRF)提取关键词实体;

3. DSL生成 :通过模板映射或Seq2Seq模型输出Elasticsearch Query DSL。

示例代码如下:

# llm_parser.py:自然语言转ES查询DSL

def parse_nlu_to_dsl(nlu_text: str) -> dict:

# Step 1: 调用本地LLM服务进行语义解析

prompt = f"""

将以下中文指令转换为JSON格式的搜索条件:

指令:{nlu}

输出字段包括:content_type, aspect_ratio, min_resolution, time_range_days

"""

response = llama_client.generate(

prompt=prompt,

max_tokens=200,

temperature=0.3

)

parsed_json = json.loads(response.text)

# Step 2: 映射到ES查询DSL

es_query = {

"bool": {

"must": [

{"term": {"category": parsed_json["content_type"]}},

{"range": {"upload_time": {"gte": f"now-{parsed_json['time_range_days']}d"}}}

],

"filter": [

{"range": {"resolution": {"gte": parsed_json["min_resolution"]}}},

{"term": {"aspect_ratio": parsed_json["aspect_ratio"]}}

]

}

}

return es_query

此机制使得运营人员无需掌握SQL或DSL语法,即可实时调整推荐策略,极大提升响应速度与灵活性。同时所有变更均通过GitOps方式留存审计日志,确保合规可控。

5.3 跨平台生态系统的智能中枢集成

未来的推荐自动化不应孤立存在,而应成为企业级内容生态的核心调度节点。Runway可通过开放API网关与OAuth2.0认证机制,实现与外部系统的深度集成:

| 外部系统 | 集成方式 | 自动化触发场景 |

|---|---|---|

| CMS(如WordPress) | Webhook + REST API | 内容发布后自动触发向量化入库 |

| CRM(如Salesforce) | OAuth2 + Kafka Connect | 用户标签更新同步至推荐画像 |

| BI平台(如Tableau) | JDBC + Materialized View | 每日凌晨导出曝光点击报表 |

| CDN网络 | Prometheus Alert + Lambda | 缓存命中率<80%时预热热门素材 |

具体实施中,可基于Apache Camel或Zapier-style低代码引擎搭建集成中间件层,统一处理协议转换、错误重试与流量控制。例如定义一条规则:

“当Salesforce中标记某用户为‘VIP创作者’时,将其最近一周创作的内容在首页推荐流中权重提升3倍。”

该规则可通过事件监听器捕获CRM变更事件,经规则引擎(如Drools)匹配后,调用内部Feature Store更新user_embedding_bias向量,实现实时影响排序结果。

更进一步,结合Service Mesh(如Istio)实现跨集群的服务治理,确保即使在混合云环境下,各子系统间的通信仍具备可观测性与安全性。最终形成一个分布但统一的智能推荐中枢,支撑Runway向“平台化AI服务”战略转型。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)