ACL 2025 | 北大提出动态焦点解码:让开放生成既“靠谱”又“好看”

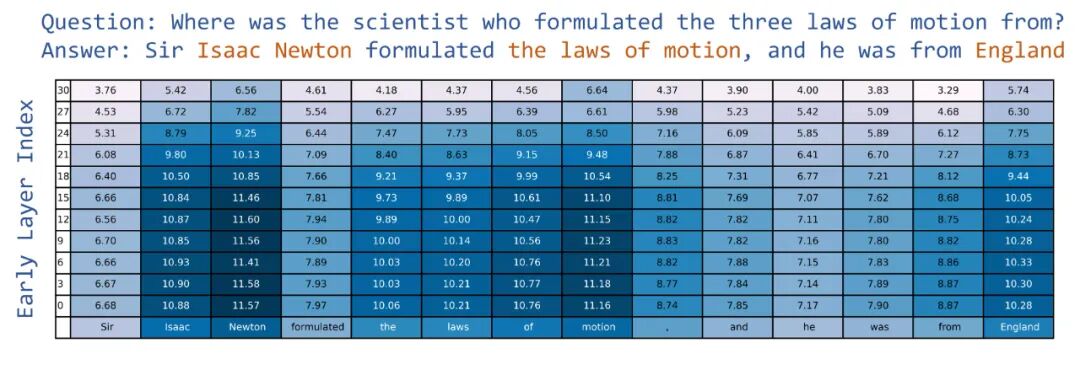

2. 虽然层间分布差异普遍随层深而减小,但依赖事实知识的生成步骤显示出独特的滞后模式,即在较靠后的层仍然保持较大的分布差异,而非知识感知步骤(如语法词“was”)则迅速收敛。DFD 的核心在于利用 LLM 内部的层级结构来识别与事实知识相关的生成步骤,并通过不同层与最后一层的层间 KL 散度来量化每个生成步骤的知识依赖度。在知识感知强度较高的步骤,DFD 降低温度以聚焦事实性;这解释了实验中观察到

近年来,大语言模型在开放式生成任务中大放异彩,但一个问题始终存在——生成的内容要么太死板,要么太离谱。固定的随机解码温度让模型陷入两难:温度高,输出多样但容易胡说八道;温度低,句句属实却千篇一律。

如何才能让模型既保持事实准确性,又不丢失表达多样性?

为了解决这个问题,北京大学计算语言所团队提出了全新方法——Dynamic Focus Decoding(DFD),一种可插拔的随机解码机制,通过动态调整解码焦点,在生成中实现对事实与创意的平衡。

论文题目:

Odysseus Navigates the Sirens' Song: Dynamic Focus Decoding for Factual and Diverse Open-Ended Text Generation

论文链接:

https://aclanthology.org/2025.acl-long.1320/

代码链接:

https://github.com/lllllw-222/Siren-DFD

收录会议:

ACL 2025 Main Conference

背景:固定温度的解码困境

传统随机解码方法(如 top-k sampling、nucleus sampling)采用固定温度来控制输出多样性。温度一高,模型“脑洞大开”;温度一低,模型“循规蹈矩”。

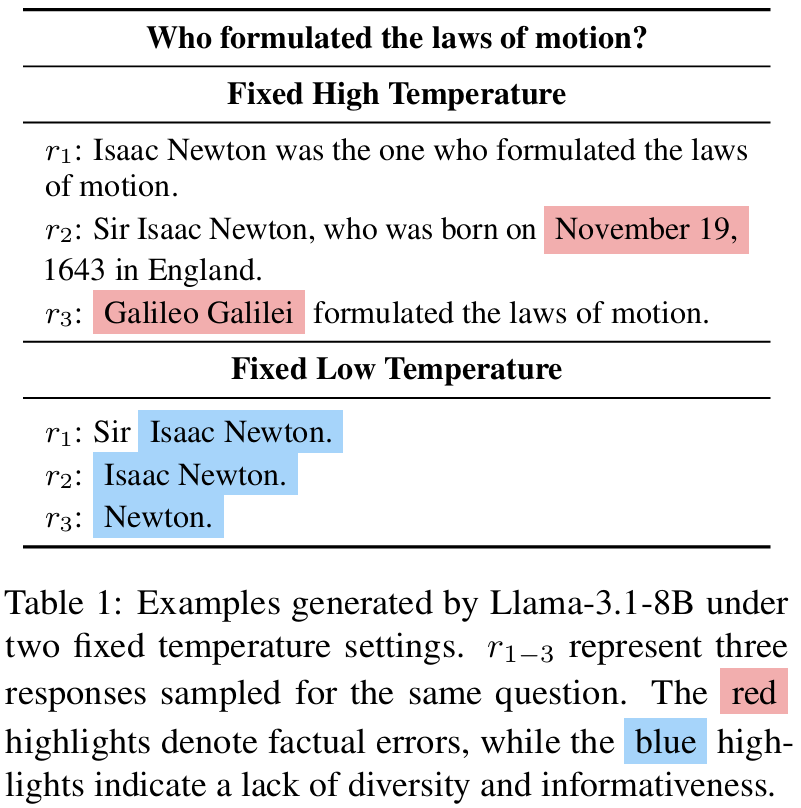

这种静态的随机性设置带来的解码焦点失衡问题,使模型在生成时难以兼得事实性与创造性。例如:

对于问题 “Who formulated the laws of motion?”

-

高温解码可能产生错误答案(如“Galileo Galilei”);

-

低温解码虽事实正确(“Isaac Newton”),但输出内容单一、缺乏信息量。

方法概述:让模型动态调焦

DFD 的核心思想是:在生成的每一步,判断当前是否需要更聚焦的事实推断或更开放的语言扩展。方法基于对模型内部层间分布差异的分析,定义每个生成步骤的知识感知强度,并据此动态调整解码随机性。

-

当模型生成依赖事实知识的内容(如事实陈述、实体名)时,DFD 降低随机性,使输出更集中、更准确;

-

当生成描述性或创造性内容时,DFD 提高随机性,以增强多样性与趣味性。

DFD 的实现无需额外数据、训练或外部检索,仅利用 LLM 内部状态信息,并可作为插件与多个现有随机解码方法直接结合。

核心:基于层间KL散度的知识强度感知

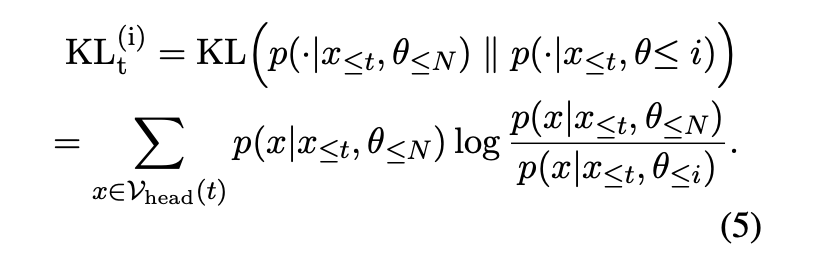

DFD 的核心在于利用 LLM 内部的层级结构来识别与事实知识相关的生成步骤,并通过不同层与最后一层的层间 KL 散度来量化每个生成步骤的知识依赖度。

通过实验分析,团队发现了两大关键现象:

1. 相比描述性或创造性的内容,依赖事实知识的生成步骤(如实体名“Isaac Newton”)在层间通常有更高的 KL 散度。

2. 虽然层间分布差异普遍随层深而减小,但依赖事实知识的生成步骤显示出独特的滞后模式,即在较靠后的层仍然保持较大的分布差异,而非知识感知步骤(如语法词“was”)则迅速收敛。

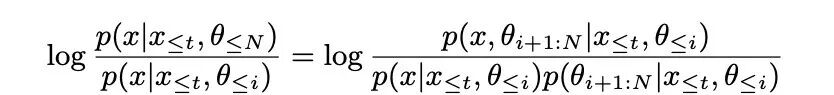

进一步,KL 散度可以被视为点互信息(PMI)的期望,度量当前生成步骤对深层参数知识的依赖。

具体来说,给定上下文 和 层模型的参数知识 ,第 层与最后一层的 KL 散度可以被表示为:

其中:

表示 token 与较靠后层的参数知识 的点互信息 。

基于此,层间KL散度可以视为点互信息在词表分布上的期望,较大的分布差异(期望PMI)表示当前解码步骤平均意义上与靠后层参数知识 的更强关联,反之亦然。

这解释了实验中观察到的现象,通常较靠后层参数将存储更多的事实知识,因此知识感知较强的生成步骤往往显示出更高且持续的分布差异。

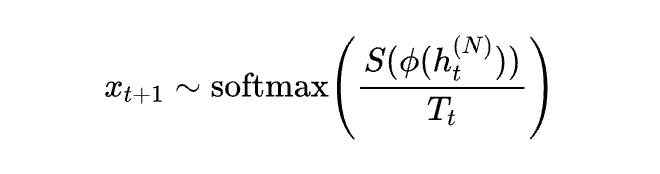

基于此,DFD 通过平均层间 KL 散度来衡量知识感知强度,并将其转化为解码过程中的动态温度。

在知识感知强度较高的步骤,DFD 降低温度以聚焦事实性;在知识感知强度较低的步骤,DFD 提高温度以增强多样性,以实现对事实性与多样性的平衡:

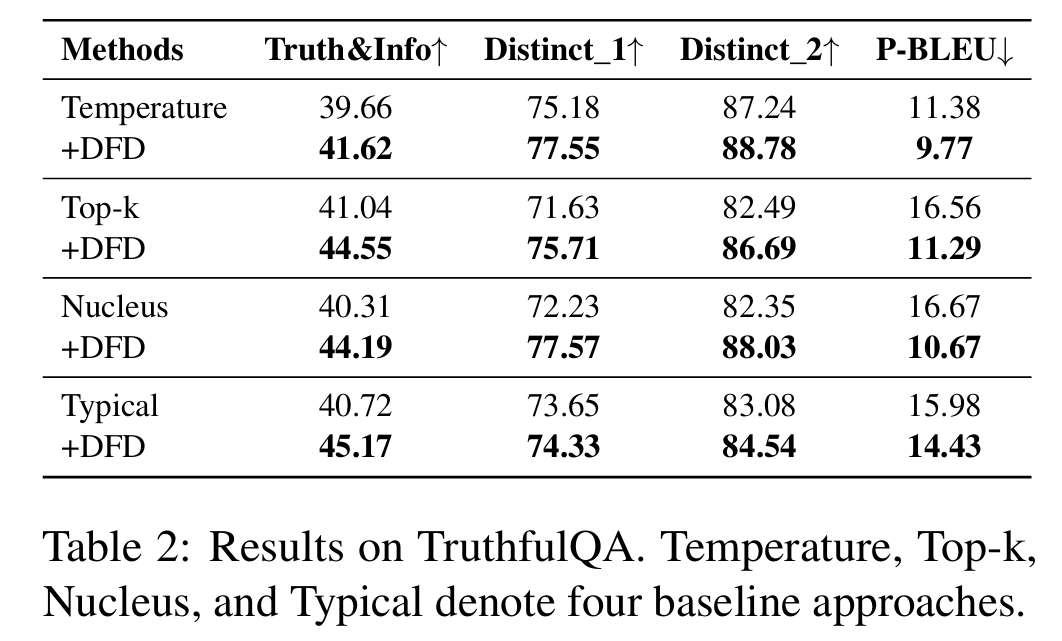

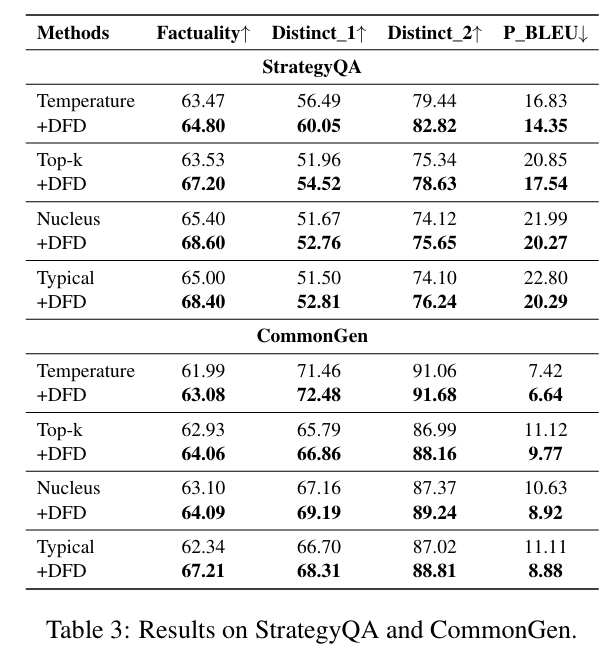

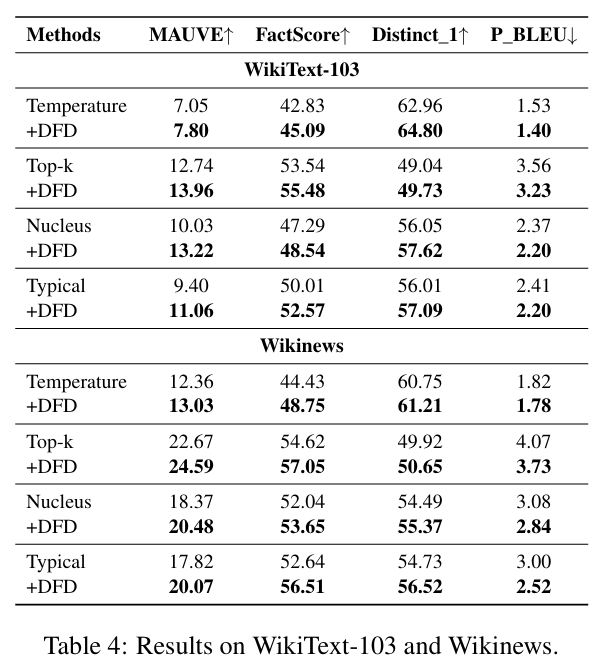

实验结果:在多任务上同时提升事实性与多样性

团队在多个开放式生成任务上验证了 DFD 的有效性。实验结果显示,DFD 在多种随机解码策略下均带来一致提升。

结论与展望

DFD 提供了一种轻量、通用、无需额外训练的方案,用于在开放式生成中平衡事实性与多样性。通过对模型内部层级分布的动态建模,DFD 实现了在不同生成阶段的自适应调焦机制,为更可信、更灵活的语言生成提供了新路径。

未来工作可以探索将该机制与外部知识检索结合,以进一步提升在事实更新和知识密集场景下的表现。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献229条内容

已为社区贡献229条内容

所有评论(0)