AI Agent开发生态的详细说明,涵盖核心框架、工具、基础设施及开发流程,最终以表格总结关键对比

AI Agent开发生态的详细说明,涵盖核心框架、工具、基础设施及开发流程,最终以表格总结关键对比

·

以下是AI Agent开发生态的详细说明,涵盖核心框架、工具、基础设施及开发流程,最终以表格总结关键对比:

1. 核心开发框架与工具

(1) 主流框架

| 框架名称 | 特点 | 适用场景 | 优势 |

|---|---|---|---|

| LangChain | 支持规划、工具调用、记忆等核心要素,提供模块化组件(如Chains、Agents) | 复杂任务流程(如多步骤推理) | 生态完善,与LLM和工具集成便捷 |

| AutoGen | 简化多Agent协作,支持代码生成和复杂对话场景 | 开发者工具、代码辅助 | 易用性高,适合快速原型开发 |

| Hugging Face | 集成大量预训练模型(如Transformers),支持NLP任务 | NLP应用(文本生成、分类) | 模型库丰富,社区活跃 |

| Ray | 分布式计算框架,支持大规模Agent集群管理 | 高并发、分布式任务 | 性能优化,适合企业级部署 |

| IBM Watson | 一站式AI服务(自然语言处理、视觉识别、对话系统) | 企业级应用集成 | 开箱即用,多模态能力 |

(2) 工具与库

- 模型管理:ModelScope(阿里)、Hugging Face Hub(模型仓库)、AWS SageMaker(托管服务)。

- 工具调用:LangChain的

AgentExecutor、AutoGen的Agent类。 - 记忆系统:Redis、Chroma(向量数据库)、Weaviate(知识图谱)。

- 监控与调试:MLflow(模型追踪)、TensorBoard(可视化)、Prometheus(指标监控)。

2. 开发生态关键组件

(1) 模型层

- 基础模型:LLM(如GPT系列、通义千问)、专用模型(如视觉模型、代码模型)。

- 微调工具:LoRA(低秩适配)、Hugging Face的

TrainerAPI。

(2) 开发框架层

- 核心功能支持:

- 规划:LangChain的

Plan-And-Execute、AutoGen的AutoPlan。 - 工具调用:LangChain的

Tool、Ray的分布式任务调度。 - 记忆:LangChain的

ConversationBufferMemory、Redis缓存。

- 规划:LangChain的

(3) 基础设施层

- 部署平台:

- 云服务:AWS SageMaker、阿里云ModelScope、Google Vertex AI。

- 容器化:Docker、Kubernetes(如Kubeflow)。

- 数据管理:

- 存储:MinIO、MongoDB(结构化数据)、Pinecone(向量存储)。

- 数据管道:Apache Airflow、Prefect(任务编排)。

(4) 监控与运维

- 日志与监控:ELK Stack(Elasticsearch + Logstash + Kibana)、Prometheus + Grafana。

- 性能优化:TensorRT(推理加速)、ONNX(模型转换)。

3. 开发流程与最佳实践

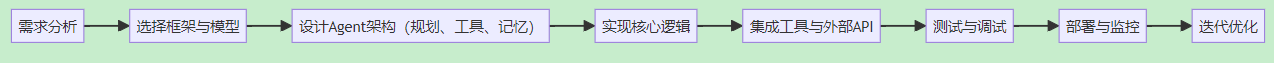

(1) 开发流程

graph LR

A[需求分析] --> B[选择框架与模型]

B --> C[设计Agent架构(规划、工具、记忆)]

C --> D[实现核心逻辑]

D --> E[集成工具与外部API]

E --> F[测试与调试]

F --> G[部署与监控]

G --> H[迭代优化]

(2) 关键步骤详解

- 需求分析:明确Agent的目标(如客服、数据分析)和所需能力(如多语言支持)。

- 框架选择:

- 快速原型:AutoGen、LangChain。

- 企业级部署:Ray、IBM Watson。

- 架构设计:

- 规划模块:定义任务分解逻辑。

- 工具集成:选择API或本地工具。

- 记忆系统:短期缓存(Redis)+长期存储(向量数据库)。

- 实现与测试:

- 使用单元测试验证工具调用。

- 模拟用户交互测试端到端流程。

- 部署与监控:

- 容器化部署(Docker + Kubernetes)。

- 实时监控资源消耗和错误日志。

4. 生态对比表格

| 组件类型 | 代表性工具/框架 | 核心优势 | 适用场景 |

|---|---|---|---|

| 开发框架 | LangChain、AutoGen | 模块化设计,快速集成工具 | 复杂任务流程、多Agent协作 |

| 模型托管 | Hugging Face Hub、AWS SageMaker | 预训练模型即用、企业级服务 | 快速原型、生产部署 |

| 工具调用 | LangChain的Tool、Ray Tasks | 标准化接口、分布式执行 | API调用、批量任务处理 |

| 记忆系统 | Redis、Chroma | 高性能缓存、向量检索 | 对话系统、知识库管理 |

| 部署与监控 | Kubernetes、Prometheus | 弹性扩缩容、实时监控 | 高并发场景、大规模集群 |

5. 选择建议

| 需求场景 | 推荐工具/框架 | 理由 |

|---|---|---|

| 快速开发NLP Agent | Hugging Face + LangChain | 预训练模型丰富,集成简单 |

| 分布式任务调度 | Ray + Kubernetes | 高性能、大规模Agent集群管理 |

| 对话系统开发 | LangChain + Redis | 支持记忆功能,对话连贯性高 |

| 企业级部署与监控 | AWS SageMaker + Prometheus | 云原生支持,全链路监控 |

总结

AI Agent开发生态由模型层、框架层、工具层、基础设施层构成,各组件需根据需求灵活组合:

- 研究场景:优先选择AutoGen、Hugging Face,快速验证想法。

- 生产部署:依赖LangChain、Ray、Kubernetes,确保稳定性与扩展性。

- 复杂任务:结合符号规划(如PDDL)与LLM推理,提升决策能力。

开发者需根据具体需求(如性能、易用性、成本)选择工具,并关注生态的兼容性与社区支持。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)