Agent进化论:直击知识库、工作流、Prompt工程三大痛点

知识更新:让知识库“自我进化”,永不过时一个真正聪明的Agent,离不开一个“会成长”的知识库。它不该是尘封的档案室,而应是一个持续新陈代谢的“活体系统”——能感知变化、自动补给、智能甄别,始终保持信息的新鲜度与准确性。为此,我们需要一套高效、可靠的知识更新机制,让它既能“自动运转”,又能“明辨是非”。我们常常失败的原因,是因为犯了三个认知误区真正的Prompt工程,不是写句子,而是设计一套让AI

进化之言:

一个优秀的 AI Agent 通常包含五大关键组件:

大语言模型(LLM)作为基础计算能力,正逐渐走向标准化;工具(Tools)作为能力扩展接口,借助 MCP 等协议也在不断标准化;知识库(RAG)关乎知识的深度与专业性,能有效减少模型的“幻觉”现象,是承载企业知识的核心;工作流(Workflow)关乎处理效率与逻辑,是实现复杂任务自动化的关键框架;提示词(Prompt)则直接决定了输出的精准度,需要紧密结合业务场景进行精心设计。而精准设计提示词、可靠编排工作流以及构建与维护高质量知识库,构成了设计 AI Agent 的三大核心挑战。

1:知识库的进化革命-知识库建立流程

1.1知识收集:让沉默的文档开口说话

你电脑里的PDF、Word、PPT,不只是静态文件,它们都是潜藏价值的“知识原料”。比如,你手头有一份眼镜行业的PDF报告,看似只是一页页文字和图表,但通过像 MinerU 这样的智能提取工具,就能一键“破壁”——把内容精准抓取出来,转化为结构清晰、机器可读的文本数据。

这就像把散落各处的纸质笔记扫描归档,变成随时可查的数字知识库,为AI的大脑注入真实、专业的行业智慧。

1.2知识整理:给信息“分块贴标”,打造高效检索的智能中枢

知识整理是让杂乱信息变得有序可用的核心环节。就像整理厨房里的食材,先切分、再归类,才能随取随用。我们将原始内容进行“语义切片”——可以按章节结构、主题逻辑,也可以按固定长度(如每500字一段)进行拆分,确保每个片段都独立完整、便于理解。

1.3 知识存储:从“死记硬背”到“理解记忆”的智能进化

传统的信息存储,只是把文字原封不动地塞进数据库——像抄书一样机械。而现代AI知识库的存储,早已进入“理解式记忆”时代:我们不再存“字面内容”,而是将知识转化为机器能“读懂”的形式,让系统不仅能“记得住”,更能“想得通”。

其中,最主流的方式就是**向量化存储**——把一段段文字转换成高维空间中的“数字向量”。这些向量不是随机数字,而是蕴含语义特征的“思想坐标”。比如,“眼镜行业趋势”和“视力矫正市场发展方向”虽然用词不同,但在向量空间中却彼此靠近。这样一来,你提问时哪怕不提“趋势”二字,系统也能精准理解你的意图。

三种检索方式,对应三种“记忆模式”

我推荐采用 **“双引擎混合架构”:向量 + 图谱**,实现“理解力”与“逻辑力”的双重加持。具体使用两个核心工具:

- Milvus:负责语义层面的“相似性检索”——构建向量数据库,存储知识的“数字指纹”

- Neo4j:负责结构层面的“关系推理”——搭建知识图谱,描绘实体之间的复杂网络

三步打造智能知识中枢

① 数据模型设计:构建“人物+关系+特征”的立体知识网

想象你要建立一个会思考的知识大脑,它不仅要记住“谁是谁”,还要知道“他们之间有什么联系”以及“长什么样”。

- Neo4j(图数据库)** 是这张知识网络的骨架:

把每一个关键实体(如“客户”“产品”“专利”)当作节点,它们之间的关系(如“属于”“影响”“涉及”)作为边,形成一张巨大的语义关系网。

例如:“某品牌”→【涉及】→“专利纠纷”→【影响】→“销售策略”。

- Milvus(向量数据库)** 是这个大脑的记忆皮层:

不直接存文字,而是将每段知识压缩为一个高维向量(即“数字指纹”),比如 `[0.25, 0.8, -0.1, ...]`。这个向量代表了它的语义本质,越相似的内容,向量距离越近。

> ✅ 双剑合璧:既能查“这件事相关什么?”(语义),又能问“它牵连了哪些人/事?”(关系)

② 向量化处理流程:给新知识生成“思想DNA”

当一份新文档(如PDF报告)进入系统,我们需要为它制作独一无二的“思想身份证”:

1. 预处理:清洗与切片**

将原文拆分为逻辑片段(句子或段落),去除停用词(如“的”“了”),标准化文本格式。就像做饭前的洗菜、切配,确保原料干净可用。

2. 语义编码:生成向量指纹

使用预训练语言模型(如 BERT、bge-large-zh)对每个文本块进行编码,输出固定长度的向量。这一过程相当于把“人类语言”翻译成“机器思维语言”。

3. 双库同步:结构化 + 向量化并行入库

- 向量部分 → 存入 **Milvus**,用于后续语义匹配

- 元数据(标题、作者、时间、标签等)→ 存入 **Neo4j**,并与对应向量建立链接

这样,每一次查询都能同时调动“语义感知”和“结构认知”两种能力。

③ 索引优化:给海量知识装上“高速导航仪”

数据越多,查找越慢?错!只要有了高效的索引机制,百万级知识也能毫秒响应。

- 在 Milvus 中:采用 **HNSW(层次化可导航小世界)算法** 构建近似最近邻索引。

相当于为所有“数字指纹”绘制一张多维地图,搜索时无需逐个比对,而是沿着最优路径快速逼近目标,效率提升百倍。

- 在 Neo4j 中:针对高频查询字段(如「姓名」「主题」「日期」)创建数据库索引。

好比给图书馆的书架贴上分类标签,找“2024年的眼镜行业报告”不再需要翻遍全部资料,一键直达。

1.4:知识排序流程和更新步骤:

14.1知识排序是确保用户获取最相关信息的关键环节,其策略主要包括以下三个方面:

a. 多阶段重排序

采用分阶段的排序方法,先利用简单高效的算法(例如BM25)进行初步筛选,快速确定候选结果集。随后,再运用复杂的深度学习模型(如交叉编码器)对这些候选结果进行精细化排序,以提升结果的相关性和准确性。

b. 上下文排序

充分考虑用户的过往行为和当前对话内容,据此动态调整排序权重。通过分析用户的搜索历史、偏好以及实时交互信息,系统能够更精准地理解用户需求,从而提供更贴合用户期望的结果排序。

c. 规则干预排序

在排序的最后阶段,依据既定的业务规则进行筛选和调整。这些规则可能包括安全性的考量(如拦截不安全或不合规的内容)、时效性要求(优先展示最新的信息)等,以确保最终呈现给用户的结果既符合业务规范,又能满足用户需求。

1.4.2 知识更新:让知识库“自我进化”,永不过时

一个真正聪明的Agent,离不开一个“会成长”的知识库。它不该是尘封的档案室,而应是一个持续新陈代谢的“活体系统”——能感知变化、自动补给、智能甄别,始终保持信息的新鲜度与准确性。

为此,我们需要一套高效、可靠的知识更新机制,让它既能“自动运转”,又能“明辨是非”。

① 智能监控:当“雷达”发现变化,自动启动更新

系统就像一位24小时在岗的智能管理员,持续监听所有知识来源——无论是本地文件夹、云端文档、数据库还是API接口。

一旦检测到新文件上传、旧内容修改或数据同步更新(比如一份行业报告从v1.0升级为v1.1),系统立即触发预设的处理流水线:解析 → 切片 → 向量化 → 存储。整个过程无需人工干预,真正做到“改了就生效”。

② 增量更新:只动“变的部分”,效率翻倍

每次全量重建知识库?太慢、太耗资源!

我们采用增量式更新策略:只处理新增或变更的内容,原有未改动的知识块原样保留。这不仅大幅节省计算成本,也让更新速度更快、对系统影响更小。

这种“精准手术式”更新,确保知识库始终在线可用,不影响正在运行的问答或推理任务。

③ 冲突治理:面对矛盾信息,如何“去伪存真”?

多个数据源、不同版本之间难免出现冲突。例如:

- A报告说“2024年眼镜市场规模达300亿”

- B文件却写“280亿”

这时候,不能简单覆盖或忽略,而要建立版本管理与可信判断机制

2:解密Agent的思维引擎——工作流自动化革命

工作流是Agent的“行动路线图”,规定了任务的执行顺序和步骤。以“查询明天北京天气”为例,工作流会自动按以下步骤执行:

1. 查询知识库缓存:首先检查知识库缓存,如果昨天刚更新过相关信息,则直接返回结果。

2. 调用天气API:如果没有缓存,调用天气API工具(如高德接口)获取实时数据。

3. 数据整理与呈现:使用LLM(大型语言模型)将获取的数据整理成易于理解的格式,例如“晴,25℃,适合出门”。

工作流的重要性在于,它能够将复杂任务分解为有序的步骤,避免Agent在执行任务时出现混乱。有了工作流,任务执行就像流水线一样高效,用户无需操心具体细节。在理想状态下,工作流会更加复杂,包括循环、反思和再行动的过程。例如,用户提问后,模型可能需要先搜索资料,发现资料不足后编写代码解析,遇到代码错误则修改并重试,直到最终生成答案。

以-HR助理-根据51job资料招聘为例,工作流的具体步骤如下:

1. 输入信息:HR输入包含姓名、邮箱的名单以及需要抓取的字段(如工作经历、技能)。

2. 生成查询词:使用预设模板指导LLM生成51job搜索词,避免模糊搜索。

3. 爬取数据:调用爬虫工具(如Playwright)在51job搜索并抓取目标个人资料页,自动过滤非目标用户,提取指定字段。

4. 数据处理与总结:调用另一个LLM将抓取到的碎片信息整理成简洁总结。

5. 生成个性化消息并发送:根据总结内容生成消息模板,插入用户特定信息,通过LinkedIn API或模拟点击工具自动发送消息。

在工作流方面,dify-Coze-n8n是一个比较成熟可靠开发工具!

3:Prompt工程:为AI打造精准的“思维操作系统”

如果说大模型是大脑,知识库是记忆,工作流是行动路径,那么 Prompt 工程就是AI的“操作系统” ——它决定了AI如何理解任务、如何思考、以及最终输出什么。

别再把提示词当成“随便写几句指令”。真正高效的Prompt,是一套精密设计的认知框架,告诉AI:

你是谁?你要做什么?在什么背景下做?按什么格式交作业?甚至——不要做什么。

这就像训练一位新员工:你不能只说“去写个文案”,而要明确表达逻辑模版方式来做。

下面,我们从三个核心维度拆解这套“AI操作系统”的构建逻辑。

3.1系统提示词:给AI一个清晰的身份与边界

① 角色设定:越具体,越可控

很多人喜欢写:“你是一个资深项目运营专家。”

结果AI开始滔滔不绝讲行业趋势、用户心理、转化率优化……完全偏离了你要的“产品文案”。

问题出在哪?——角色太泛,AI就会“自由发挥”。

正确做法:定义功能型角色,强调“执行者”而非“思考者”

核心原则:

AI 不像人会主动判断“我现在该做什么”,它只会匹配模式。所以你要让它变成一台高精度工具机,而不是一个爱发表意见的顾问

② 上下文注入:补全AI的“常识盲区”

AI没有记忆,也没有现实感知能力。它所有的“常识”都来自你提供的上下文。

其实内容信息早就在需要信息系统中存在,只是没有提供或者没有察觉到了

正确做法:在Prompt中嵌入实时上下文,使信息直接呈现在prompt提示的逻辑中直接表达信息并做友好提醒。

3.2 Examples(示例):教会AI“正确的思维方式”

光给指令不够,你还得让AI“看见标准答案长什么样”。这就是 Examples 的作用——它是AI学习规则的主要方式。

但很多人用错了:随便扔几个例子,以为AI自然就懂了。实际上,Example的设计质量,直接决定AI的表现上限。

高效Example设计四原则:

3.2.1 质量优先:只放“黄金样本”

3.2.2 乱序排列:打破顺序依赖

3.2.3覆盖全面:涵盖典型与边缘场景

3.2.4 只给结果,不给过程描述

3.3 Output Format:锁定输出形态,杜绝“自由发挥”

很多AI系统失败,不是因为模型不行,而是因为输出不可控。你想拿JSON做接口调用,结果AI返回一段散文。

为什么AI总不按格式输出?

因为它的“语言本能”是自然表达。就像实习生写周报,总会加一句“我今天做了XXX”,而不是直接列数据。

如何强制AI“老实交作业”?

用三重保险机制:

-

角色定位 + 明确指令

开头就定调:“你是JSON生成器,只输出纯JSON,不解释。” -

反复强调 + 格式封口

在Prompt结尾再次提醒:“必须输出纯JSON,禁止任何额外说明。” -

正误对比 + 样本强化

明确指出什么是错的,什么是对的!

总结:Prompt工程的本质是“认知工程”

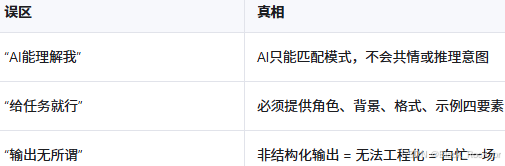

我们常常失败的原因,是因为犯了三个认知误区

真正的Prompt工程,不是写句子,而是设计一套让AI无法跑偏的控制协议。

它融合了心理学(引导思维)、语言学(表达精确)、软件工程(接口规范)于一体。

当你能把AI训练成一个听话、精准、稳定输出的数字员工时,才算真正掌握了这场AI革命的钥匙。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献62条内容

已为社区贡献62条内容

所有评论(0)