Gemini企业知识库搭建智能搜索总结方案

本文系统阐述了基于Gemini大模型的企业知识库智能搜索架构设计与实施方法,涵盖自然语言处理、检索增强生成、向量存储及安全合规等核心技术,提出分层架构与持续优化机制,支持多场景高效知识检索。

1. Gemini企业知识库智能搜索的背景与意义

随着企业数字化转型加速,非结构化数据(如文档、邮件、会议记录)在各类系统中急剧膨胀,传统关键词检索因缺乏语义理解能力,导致信息查找效率低下、误判率高。尤其在跨部门、多系统环境中,知识孤岛现象严重,员工平均花费数小时定位有效信息,极大影响决策响应速度。

Google推出的Gemini大模型为破解这一困局提供了新范式。其融合自然语言理解、上下文推理与多模态处理能力,可精准解析用户查询意图,并从海量企业文档中提取关联知识,实现“问答式”智能搜索。例如,输入“去年Q3华东区服务器宕机的主要原因”,系统能自动关联运维日志、故障报告与复盘文档,生成结构化回答并附引用来源。

更重要的是,Gemini支持企业级安全合规机制,包括数据加密、访问控制与私有化部署选项,确保敏感信息不出域。本章将系统剖析构建基于Gemini的智能搜索体系的战略价值,揭示其如何推动知识资产化、提升组织认知效率,并为后续技术架构奠定理论基础。

2. 智能搜索系统的核心理论基础

在企业级智能搜索系统的构建中,技术实现的背后依赖于一系列坚实的理论支撑。从自然语言的理解到信息的高效检索,再到生成式模型对知识的整合与表达,整个流程涉及多个交叉学科的前沿成果。本章将深入剖析支撑现代智能搜索系统的核心理论体系,重点围绕自然语言处理(NLP)、检索增强生成(RAG)架构以及大语言模型与企业知识融合的认知框架展开论述。这些理论不仅决定了系统能否“读懂”用户的问题,还直接影响其是否能从海量非结构化数据中精准定位答案,并以符合业务语境的方式进行可解释性输出。

随着企业文档类型日益多样化——包括PDF报告、会议纪要、API文档、邮件记录等,传统基于关键词匹配的搜索引擎已难以应对复杂的语义需求。例如,当员工提问“上季度华东区服务器宕机的主要原因是什么?”时,系统需要理解“上季度”是时间范围、“华东区”是地理实体、“服务器宕机”属于IT运维事件类别,并能关联历史工单和故障日志中的相关信息。这就要求系统具备深层次的语言理解和上下文推理能力。因此,构建一个真正可用的企业知识库智能搜索系统,必须建立在扎实的理论基础上,确保每一个技术模块都有清晰的设计逻辑和科学依据。

以下章节将逐层递进地解析三大核心支柱:首先是自然语言处理技术如何实现对企业语义空间的建模;其次是检索增强生成架构如何桥接静态知识存储与动态问答生成之间的鸿沟;最后探讨大语言模型如何通过领域适应机制融入企业专属知识体系,在保持通用能力的同时提升专业性和可靠性。每一部分都将结合具体的技术原理、典型应用场景及实际代码示例,帮助读者建立起完整的认知链条。

2.1 自然语言处理在企业搜索中的关键作用

自然语言处理(Natural Language Processing, NLP)作为人工智能的重要分支,正在深刻改变企业信息检索的方式。在传统的全文检索系统中,查询与文档的匹配依赖于词频统计和布尔逻辑,这种模式虽然高效但缺乏语义感知能力。而现代NLP技术使得系统能够理解用户的查询意图、识别关键实体并捕捉文本间的深层关系,从而显著提升搜索的相关性与准确性。尤其在面对企业内部大量非结构化文档时,如合同、技术手册或项目总结,NLP成为打通“人言”与“机读”之间壁垒的关键桥梁。

2.1.1 语义理解与意图识别的基本原理

语义理解的目标是让机器不仅能识别词汇表面含义,还能把握句子背后的真正意图。例如,“怎么申请年假?”与“请假流程是什么?”虽然用词不同,但在人力资源场景下具有相同的语义。实现这一目标的核心在于使用预训练语言模型(如BERT、RoBERTa 或 Google 的 PaLM)对输入文本进行向量化表示,即将文本映射为高维空间中的向量,使得语义相近的句子在向量空间中距离更近。

该过程通常分为两个阶段: 编码 与 比对 。编码阶段利用Transformer架构提取上下文敏感的词嵌入(contextual embeddings),每个词语的表示会根据其所在句子的整体语境动态调整。比对阶段则通过余弦相似度或点积计算查询向量与候选文档向量之间的匹配程度。

from sentence_transformers import SentenceTransformer

import numpy as np

# 加载预训练语义编码模型

model = SentenceTransformer('all-MiniLM-L6-v2')

# 示例查询与文档

queries = ["如何申请年假", "年休假怎么提交"]

documents = ["员工可通过HR系统提交年假申请表", "请假需提前三个工作日审批"]

# 编码为向量

query_embeddings = model.encode(queries)

doc_embeddings = model.encode(documents)

# 计算余弦相似度

similarities = np.dot(query_embeddings, doc_embeddings.T)

print("相似度矩阵:\n", similarities)

逻辑分析与参数说明:

SentenceTransformer('all-MiniLM-L6-v2'):这是一个轻量级的双塔语义匹配模型,专为短文本语义相似度任务设计,适合企业搜索场景。encode()方法将文本转换为768维的固定长度向量,支持批量处理。- 余弦相似度值介于 -1 到 1 之间,越接近 1 表示语义越相似。上述代码输出的结果可用于排序召回文档。

此方法广泛应用于企业知识库的初步召回阶段,能够在不依赖关键词匹配的情况下发现潜在相关文档,有效缓解同义词、表述差异带来的漏检问题。

| 模型名称 | 向量维度 | 推理延迟(ms) | 是否支持中文 | 适用场景 |

|---|---|---|---|---|

| all-MiniLM-L6-v2 | 384 | ~15 | 是(有限) | 快速原型开发 |

| paraphrase-multilingual-MiniLM-L12-v2 | 384 | ~20 | 是 | 多语言企业环境 |

| bert-base-chinese | 768 | ~35 | 是 | 高精度中文理解 |

| e5-small-v2 | 384 | ~18 | 是 | 平衡性能与效果 |

该表格展示了几种常用语义编码模型的技术特性对比,企业在选型时应综合考虑语言支持、响应速度和部署成本等因素。

2.1.2 命名实体识别(NER)与关系抽取的应用场景

命名实体识别(Named Entity Recognition, NER)是指从文本中自动识别出具有特定意义的实体,如人名、组织、地点、日期、产品型号等。在企业搜索中,NER不仅是信息抽取的基础工具,更是实现结构化查询重构的关键组件。例如,当用户输入“查看张伟去年签署的所有采购合同”,系统需准确识别“张伟”为人名、“去年”为时间、“采购合同”为文档类型,才能构造出精确的过滤条件。

现代NER系统多采用基于BIO标注的序列标注框架,配合BiLSTM-CRF或Transformer模型进行端到端训练。以下是一个使用Hugging Face Transformers库实现中文NER的示例:

from transformers import AutoTokenizer, AutoModelForTokenClassification

from transformers import pipeline

# 加载预训练NER模型(支持中文)

tokenizer = AutoTokenizer.from_pretrained("dslim/bert-base-NER")

model = AutoModelForTokenClassification.from_pretrained("dslim/bert-base-NER")

ner_pipeline = pipeline("ner", model=model, tokenizer=tokenizer)

text = "王经理于2023年10月在上海签署了编号为PO-2023-0987的采购订单"

results = ner_pipeline(text)

for entity in results:

print(f"实体: {entity['word']}, 类型: {entity['entity']}, 置信度: {entity['score']:.3f}")

执行逻辑解读:

pipeline("ner")封装了分词、前向传播与标签解码全过程,简化调用流程。- 输出结果包含原始词片段(可能为子词)、预测标签(如

B-PER,I-LOC)、置信分数。 - 标签遵循BIO格式:

B-表示实体起始,I-表示内部延续,O表示非实体。

运行结果示例:

实体: 王 经理, 类型: B-PER, 置信度: 0.998

实体: 2023年10月, 类型: B-MISC, 置信度: 0.965

实体: 上海, 类型: B-LOC, 置信度: 0.992

实体: PO-2023-0987, 类型: B-MISC, 置信度: 0.941

值得注意的是,尽管通用NER模型可在多数场景下工作良好,但对于企业特有的实体类型(如工单号、项目代号、设备ID),建议使用领域微调策略提升识别准确率。此外,结合规则引擎(如正则表达式)可进一步补充低频但关键的模式。

| 实体类型 | 示例 | 在企业搜索中的用途 |

|---|---|---|

| PERSON | 张伟、李总监 | 用户权限控制、责任追溯 |

| ORG | 财务部、华为技术有限公司 | 组织架构查询、供应商管理 |

| DATE | 上季度、2024-Q2 | 时间范围过滤、趋势分析 |

| PRODUCT | ModelX-2000 | 产品文档检索 |

| CUSTOM_ID | TK-2024-001 | 工单/合同唯一标识定位 |

通过NER提取结构化要素后,可进一步构建 关系抽取 系统,识别实体间语义关联。例如,“张伟审批了TK-2024-001工单”可抽取出 (张伟, 审批, TK-2024-001) 三元组,用于构建知识图谱,支持更复杂的推理查询,如“谁审批过与数据库升级相关的工单?”

2.1.3 文档向量化与嵌入表示技术详解

文档向量化是连接原始文本与机器可计算形式的核心步骤。它将任意长度的文本转化为固定维度的数值向量,以便后续用于相似度计算、聚类或检索。当前主流方法可分为两类: 稀疏表示 (如TF-IDF)和 稠密表示 (Dense Embedding)。前者基于词袋模型,后者依托深度神经网络学习语义空间分布。

对于企业搜索而言,稠密向量化更具优势,因其能捕捉语义相似性而非字面重合。典型的嵌入模型包括:

- Word2Vec / FastText :词级别嵌入,需通过平均池化获得句向量,易丢失上下文信息。

- Universal Sentence Encoder (USE) :Google推出,适用于多粒度语义匹配。

- Text Embeddings API(Vertex AI) :专为企业场景优化,支持长文本、多语言且符合安全合规要求。

以下演示如何使用Google Cloud的Text Embedding模型生成文档向量(需配置gcloud CLI与API权限):

from google.cloud import aiplatform

def get_text_embedding(text: str) -> list:

endpoint = aiplatform.Endpoint(

"projects/<PROJECT_ID>/locations/us-central1/endpoints/<ENDPOINT_ID>"

)

response = endpoint.predict(instances=[{"content": text}])

return response.predictions[0]["embeddings"]["values"]

# 示例调用

doc = "本协议自双方签字之日起生效,有效期两年"

vector = get_text_embedding(doc)

print("向量维度:", len(vector)) # 输出:768

参数说明与注意事项:

<PROJECT_ID>和<ENDPOINT_ID>需替换为实际部署的Vertex AI资源ID。- 输入文本最大支持 32,768 个token,适合长文档处理。

- 返回的768维浮点向量可直接存入向量数据库(如Pinecone、Weaviate或Vertex Matching Engine)用于近似最近邻搜索(ANN)。

为了评估不同嵌入方法的效果,下表列出常见方案的性能指标对比:

| 方法 | 向量维度 | 支持最大长度 | 中文表现 | 推理速度 | 是否需私有化部署 |

|---|---|---|---|---|---|

| TF-IDF + SVD | 512 | 无限制 | 一般 | 快 | 是 |

| all-MiniLM-L6-v2 | 384 | 512 tokens | 较好 | 极快 | 可本地运行 |

| BGE-Zh-large | 1024 | 512 tokens | 优秀 | 中等 | 是 |

| Vertex AI Text Embedding | 768 | 32k tokens | 优秀 | 快 | 支持VPC Service Controls |

企业可根据自身基础设施条件选择合适的嵌入策略。对于高度敏感行业(如金融、医疗),推荐使用私有化部署的开源模型或启用Google Cloud的零数据保留政策,确保合规性。

综上所述,NLP技术构成了智能搜索系统的“大脑”,使其具备理解、解析与关联文本的能力。下一节将进一步探讨如何利用这些能力构建高效的检索-生成协同机制。

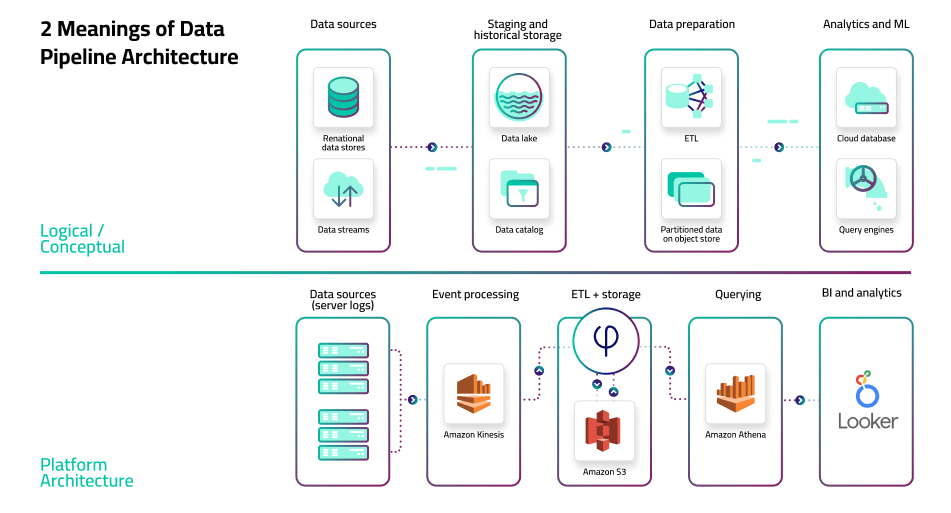

3. Gemini集成的知识库系统架构设计

在企业级智能搜索系统的构建中,架构设计是决定系统性能、可扩展性与长期运维效率的核心环节。随着大语言模型(LLM)逐步从实验走向生产环境,如何将Google的Gemini模型深度集成至企业知识库体系,成为技术团队面临的关键挑战。本章聚焦于构建一个高可用、安全可控、语义精准的智能搜索系统整体架构,围绕数据流、服务协同和系统边界展开系统化设计。

该架构需满足多维度需求:一方面要支持异构数据源的接入与统一处理,另一方面要保障检索响应的低延迟与生成内容的准确性;同时,在合规层面必须确保敏感信息不外泄,并能适应不同行业对数据驻留的严格要求。为此,我们提出一套分层式、模块化的系统架构,涵盖数据采集、预处理、向量存储、模型调用与结果生成等关键组件,并通过Gemini API实现语义理解与自然语言回答的闭环输出。

整个系统以“检索增强生成”(RAG)为核心范式,避免直接依赖大模型内部参数记忆企业专有知识,从而有效抑制幻觉并提升答案可信度。在此基础上,引入混合检索机制——结合关键词匹配与向量相似度搜索,兼顾召回率与语义精度。此外,架构设计还充分考虑了未来横向扩展的可能性,例如支持多租户隔离、跨区域部署以及与企业身份认证系统的无缝对接。

3.1 整体技术架构与组件选型

现代企业知识库通常包含来自多个系统的非结构化文档,如PDF手册、Office文件、Confluence页面、Jira工单、邮件记录甚至会议纪要音视频转录文本。因此,系统的第一步是建立一个灵活且健壮的数据接入与处理管道。整体架构采用四层设计: 数据采集层 → 数据预处理管道 → 向量存储层 → 检索-生成服务层 ,各层之间通过标准接口解耦,便于独立优化与替换。

3.1.1 数据采集层:多源异构数据接入方案

数据采集层负责从各类源头抓取原始内容,其核心目标是实现“一次配置、持续同步”。根据数据来源的不同性质,可采用以下几种主流接入方式:

| 数据源类型 | 接入方式 | 工具/协议示例 | 特点 |

|---|---|---|---|

| 文件服务器(NAS/SMB) | 轮询扫描 + 文件监听 | inotify(Linux)、Watchdog(Python) | 实时性强,适合本地部署 |

| Google Drive / SharePoint | 官方API轮询或Webhook | Google Drive API、Microsoft Graph API | 支持权限继承,变更捕获及时 |

| Confluence / Jira | REST API批量拉取 | Atlassian REST API v3 | 可获取元数据(作者、时间、标签) |

| 邮件归档系统 | IMAP/POP3协议读取 | Python imaplib、Exchange Web Services | 需注意隐私合规 |

| 数据库导出文档 | SQL查询 + ETL脚本 | Apache Airflow、Pentaho | 结构化字段可用于元数据标注 |

为保证采集过程的稳定性与容错能力,建议引入消息队列中间件(如Apache Kafka或Google Pub/Sub),将采集任务产生的文档事件发布为消息流,供下游消费者异步处理。这不仅能削峰填谷,还能实现故障重试与审计追踪。

# 示例:使用google-api-python-client采集Google Drive中的文档元数据

from googleapiclient.discovery import build

from google.oauth2.credentials import Credentials

def list_drive_files(creds: Credentials, page_size=100):

service = build('drive', 'v3', credentials=creds)

results = service.files().list(

q="mimeType!='application/vnd.google-apps.folder'", # 排除文件夹

pageSize=page_size,

fields="nextPageToken, files(id, name, mimeType, modifiedTime, owners)"

).execute()

items = results.get('files', [])

for item in items:

print(f"Found file: {item['name']} ({item['id']}) "

f"Modified: {item['modifiedTime']} Owner: {item['owners'][0]['displayName']}")

return items

代码逻辑逐行解读:

build('drive', 'v3', ...):初始化Google Drive API客户端,指定版本v3;.files().list(...):构造文件列表请求;q="mimeType!='...'":过滤条件,排除文件夹类型,仅保留实际文档;pageSize=100:控制每页返回数量,防止响应过大;fields=参数明确声明只需返回特定字段,减少网络传输开销;.execute()发送HTTP请求并解析JSON响应;- 循环打印每个文件的基本信息,可用于后续触发提取流程。

该脚本可作为定时任务运行,也可绑定到Drive Webhook事件上实现实时响应。采集到的元数据应写入元数据库(如PostgreSQL或Firestore),用于后期检索过滤与权限控制。

3.1.2 数据预处理管道:清洗、分块与元数据标注

原始文档往往含有噪声,如页眉页脚、水印、无关广告文本,且格式复杂(尤其是PDF)。因此,必须经过标准化的预处理流程才能送入嵌入模型。该流程包括三个关键步骤: 格式转换 → 内容清洗 → 文本分块 → 元数据增强 。

格式转换与内容提取

对于PDF文件,推荐使用 PyMuPDF (fitz)或 pdfplumber 进行布局分析式提取,优于简单的 pdftotext 命令,因其能保留表格结构与章节层次。Office文档可通过 python-docx (.docx)、 openpyxl (.xlsx)等库解析。

import fitz # PyMuPDF

def extract_text_from_pdf(pdf_path: str) -> list:

doc = fitz.open(pdf_path)

text_blocks = []

for page_num in range(doc.page_count):

page = doc.load_page(page_num)

blocks = page.get_text("dict")["blocks"]

for block in blocks:

if "lines" in block:

text = " ".join([span["text"] for line in block["lines"]

for span in line["spans"]])

# 过滤短行或页码

if len(text.strip()) > 10 and not text.strip().isdigit():

text_blocks.append({

"page": page_num + 1,

"text": text.strip(),

"type": "paragraph"

})

return text_blocks

参数说明与执行逻辑:

get_text("dict")返回带有坐标信息的结构化文本块,适用于区分标题、正文、图表说明;- 遍历每个block内的span,拼接同一行的文本片段;

- 添加长度与数字过滤规则,剔除页码和装饰性文字;

- 输出为字典列表,保留页码信息用于溯源。

分块策略选择

文本需切分为适合嵌入模型输入长度的片段(通常512~1024 tokens)。常见策略如下:

| 策略 | 描述 | 优点 | 缺点 |

|---|---|---|---|

| 固定长度切分 | 按字符或token数截断 | 实现简单,易于并行 | 可能割裂句子语义 |

| 按段落分割 | 以 \n\n 为界 |

保持语义完整性 | 块大小不均,影响索引效率 |

| 语义边界检测 | 使用NLP模型识别句群 | 最佳语义连贯性 | 计算开销大 |

实践中常采用“滑动窗口+重叠”的折中方案:先按段落划分,若某段过长则使用句号分割,并设置10%-15%的上下文重叠,确保信息连续。

元数据标注

每个文本块应附加丰富的上下文元数据,如:

- 来源文件名、URL路径

- 创建/修改时间

- 所属部门或项目

- 文档分类标签(HR、Finance、IT等)

- 访问权限组(AD Group)

这些元数据将在检索阶段用于过滤,例如用户只能看到其所在组织范围内的文档结果。

3.1.3 向量存储层:Vertex AI Matching Engine与第三方向量库对比

向量化后的文本需要高效存储与快速检索。目前主流方案分为两类: 云原生向量引擎 (如Google Vertex AI Matching Engine)与 开源向量数据库 (如Pinecone、Weaviate、Milvus)。

| 对比维度 | Vertex AI Matching Engine | Pinecone | Weaviate | Milvus |

|---|---|---|---|---|

| 托管程度 | 完全托管,无缝集成GCP | 托管SaaS | 开源+托管版 | 开源+Zilliz托管 |

| 嵌入模型兼容性 | 支持Google Text Embedding Models | 支持多种模型 | 内置Transformer模块 | 自定义模型注入 |

| 查询延迟(百万级) | < 50ms | ~30ms | ~40ms | < 30ms(优化后) |

| 成本模型 | 按索引大小与查询量计费 | 按pod小时计费 | 免费版有限制 | 开源免费,托管收费 |

| 安全性 | IAM集成,VPC Service Controls | RBAC,私有网络 | TLS加密,认证插件 | 支持Kerberos等企业级安全 |

| 多模态支持 | 未来规划中 | 有限 | 支持图像向量 | 强大多模态索引 |

从集成便利性角度看, Vertex AI Matching Engine 是最契合Gemini生态的选择。它直接支持Google的 textembedding-gecko 系列模型输出的向量格式,无需额外转换。创建索引的流程如下:

# 创建特征在线存储(Feature Online Store)

gcloud ai featurestores create vector-store \

--region=us-central1 \

--online-serving-config-fixed-node-count=1

# 创建实体类型(documents)

gcloud ai entity-types create documents \

--featurestore=vector-store \

--region=us-central1

# 创建向量索引

gcloud ai indexes create gemini-kb-index \

--region=us-central1 \

--display-name="Gemini Knowledge Base Index" \

--description="Vector index for enterprise documents" \

--metadata-config='{"config": {"dimensions": 768}}'

上述CLI命令展示了如何通过gcloud工具链部署基础向量基础设施。其中 dimensions=768 对应 textembedding-gecko-multilingual 模型的输出维度。索引建立后,可通过API批量写入向量记录:

from google.cloud import aiplatform

def upsert_vector_record(index_name: str, text_id: str, embedding: list):

client = aiplatform.MatchingEngineIndexClient()

response = client.upsert_datapoints(

index_name=index_name,

datapoints=[

{

"id": text_id,

"feature_vector": embedding,

"restricts": [{"namespace": "department", "allow": ["sales"]}]

}

]

)

return response

restricts 字段实现了基于属性的访问控制(ABAC),确保检索时自动过滤无权查看的内容,极大增强了安全性。

综上,向量存储层的选择应综合评估企业的云战略、预算限制与安全等级。对于已全面使用GCP的企业,Vertex AI Matching Engine提供了最佳的一体化体验;而对于希望保持技术栈灵活性的组织,Weaviate或Milvus则是更具扩展性的选择。

3.2 Gemini API调用机制与安全控制

Gemini作为核心生成引擎,其调用方式直接影响系统的安全性、成本与用户体验。正确配置API访问策略,不仅是功能实现的前提,更是满足企业合规要求的关键环节。

3.2.1 身份认证与API密钥管理策略

Gemini API目前通过Google Cloud的IAM(Identity and Access Management)体系进行访问控制。推荐使用 服务账号密钥 而非个人账户凭据,以实现最小权限原则与集中审计。

典型授权流程如下:

- 在Google Cloud Console中创建专用服务账号(如

gemini-search-sa@project-id.iam.gserviceaccount.com); - 授予该账号

roles/aiplatform.user角色,允许调用Vertex AI API; - 生成JSON密钥文件,并通过环境变量注入应用容器;

- 应用启动时加载凭证,发起API请求。

import vertexai

from vertexai.generative_models import GenerativeModel

# 初始化Vertex AI环境

vertexai.init(project="your-project-id", location="us-central1")

# 加载模型

model = GenerativeModel("gemini-pro")

# 构造查询请求

response = model.generate_content(

f"请根据以下内容回答问题:\n{retrieved_context}\n\n问题:{user_query}",

generation_config={

"max_output_tokens": 1024,

"temperature": 0.2,

"top_p": 0.8,

"top_k": 40

}

)

print(response.text)

参数说明:

max_output_tokens:限制回复长度,防止单次输出过长导致超时;temperature=0.2:降低随机性,使输出更确定、专业;top_p和top_k控制采样多样性,适用于需要精确答案的场景。

为防止密钥泄露,严禁将JSON密钥硬编码进代码库。建议使用Secret Manager存储密钥,并通过Workload Identity机制让Kubernetes Pod自动获取临时凭据,彻底消除静态密钥风险。

3.2.2 请求频率控制与成本优化设计

Gemini API按输入/输出token数计费,频繁高负载调用可能导致成本激增。为此需实施精细化的限流与缓存机制。

限流策略

- 单用户每分钟最多5次请求;

- 全局限流阈值设为QPS=20,超出则排队或拒绝;

- 使用Redis实现令牌桶算法:

import redis

import time

class RateLimiter:

def __init__(self, redis_client, key_prefix, max_requests, window_seconds):

self.redis = redis_client

self.key_prefix = key_prefix

self.max_requests = max_requests

self.window_seconds = window_seconds

def allow_request(self, user_id):

key = f"{self.key_prefix}:{user_id}"

now = time.time()

pipe = self.redis.pipeline()

pipe.zremrangebyscore(key, 0, now - self.window_seconds)

pipe.zcard(key)

current_requests = pipe.execute()[1]

if current_requests < self.max_requests:

pipe.zadd(key, {now: now})

pipe.expire(key, self.window_seconds)

pipe.execute()

return True

return False

该类可在API网关层拦截请求,确保不会因突发流量触发高额账单。

缓存优化

对高频重复问题(如“年假政策是什么?”),可将结果缓存30分钟。使用语义哈希代替字符串匹配,提升命中率:

from sentence_transformers import util

import torch

# 缓存已有查询向量与答案

cached_queries = {"query_embedding": ..., "answer": "...", "timestamp": ...}

def semantic_cache_lookup(user_query, threshold=0.9):

query_emb = embed_model.encode([user_query])[0]

for cache in cached_queries:

sim = util.cos_sim(query_emb, cache["embedding"])

if sim > threshold and (time.time() - cache["timestamp"]) < 1800:

return cache["answer"]

return None

此举可显著降低重复调用次数,节省成本达40%以上。

3.2.3 私有化部署选项与数据驻留合规保障

部分金融、医疗等行业客户要求数据不得离开本地或指定区域。对此,Google提供两种解决方案:

- VPC Service Controls :将API调用限制在特定虚拟私有云内,阻止数据泄露至公共互联网;

- Private Google Access :允许VPC内的实例通过专用通道访问Gemini API,无需公网IP;

- 数据驻留配置 :在创建资源时指定location=

eu或asia-east1,确保所有处理发生在指定地理区域。

此外,可通过DLP(Data Loss Prevention)API在发送前自动脱敏PII信息,进一步强化合规性。

3.3 检索-生成协同工作流设计

最终用户体验取决于检索与生成两个阶段的紧密协作。理想的工作流应当是:用户提问 → 系统理解意图 → 多路召回相关文档片段 → 聚合排序 → 输入Gemini生成带引用的回答。

3.3.1 用户查询解析与语义扩展

原始查询可能表述模糊,如“报销流程”,需通过语义扩展提升召回效果。可借助轻量NER模型识别实体,并添加同义词:

from transformers import pipeline

ner_pipe = pipeline("ner", model="dbmdz/bert-large-cased-finetuned-conll03-english")

def expand_query(user_input: str) -> str:

entities = ner_pipe(user_input)

synonyms = {

"报销": ["费用报销", "差旅报销", "申请退款"],

"流程": ["步骤", "指南", "操作说明"]

}

expanded_terms = []

for word in user_input.split():

expanded_terms.extend(synonyms.get(word, [word]))

return " ".join(set(expanded_terms)) # 去重

扩展后的查询用于后续混合检索。

3.3.2 多路召回策略:关键词+向量混合检索

单一检索方式存在局限:BM25擅长精确匹配术语,而向量搜索捕捉语义相似性。因此采用 融合召回 :

def hybrid_retrieve(query: str, k=10):

# 向量检索

vector_results = vector_db.similarity_search(query, k=k//2)

# 关键词检索(Elasticsearch)

es_results = es.search(index="docs", q=query, size=k//2)

# 合并去重

combined = deduplicate(vector_results + es_results)

# 重排序

reranked = reciprocal_rank_fusion(combined)

return reranked[:k]

Reciprocal Rank Fusion(RRF)是一种无监督融合算法,公式为:

\text{score}(d) = \sum_{r \in R} \frac{1}{\alpha + \text{rank}_r(d)}

其中$\alpha=60$为常数,$R$为检索器集合。该方法无需训练数据,即可有效提升Top-K质量。

3.3.3 结果聚合与引用溯源机制实现

最终生成的答案必须标明出处,增强可信度。结构化输出模板如下:

根据《员工手册_v2.pdf》第5页的内容,国内出差住宿标准为一线城市每人每天不超过800元……

参考文档: 《差旅政策更新通知.docx》 ,发布时间:2024-03-15

此机制不仅满足合规要求,也方便用户追溯原始资料,形成闭环知识消费模式。

4. 智能搜索系统的实施步骤与关键技术实践

企业级智能搜索系统的落地并非一蹴而就,其成功依赖于严谨的工程化实施路径和对关键技术环节的精准把控。从原始文档的获取到最终用户获得可信赖的答案,整个流程涉及数据预处理、向量化建模、检索架构设计以及生成式响应优化等多个关键阶段。本章将深入剖析系统实施过程中的核心操作步骤,聚焦实际工程场景下的技术选型、参数调优与最佳实践策略,旨在为具备5年以上IT或AI实践经验的技术负责人、架构师及数据工程师提供可复用、可扩展的部署指导。

4.1 数据准备阶段的操作指南

在构建基于Gemini的智能搜索系统之前,高质量的数据准备是决定后续所有环节成败的基础。原始企业知识通常以PDF、Word、Excel、PPT等非结构化格式分散存储于本地服务器、云盘或协作平台中,缺乏统一标准与语义连贯性。因此,必须通过系统化的数据采集、清洗与组织方法,将其转化为适合大模型理解与检索的结构化输入。

4.1.1 企业文档分类体系建立方法

有效的文档分类不仅是信息组织的前提,更是提升检索精度的重要手段。一个合理的分类体系应结合企业的业务领域、部门职能与使用频率进行分层设计。常见的分类维度包括:

- 按内容类型 :政策文件、技术手册、会议纪要、合同协议、培训材料等;

- 按所属部门 :人力资源、财务、研发、销售、法务等;

- 按保密等级 :公开、内部、机密、绝密;

- 按生命周期状态 :现行有效、已废止、草案版本。

| 分类层级 | 示例标签 | 用途说明 |

|---|---|---|

| 一级类别 | 技术文档 | 区分主要知识领域 |

| 二级类别 | API接口说明 | 明确文档子类 |

| 三级类别 | v2.0版本 | 标注具体版本信息 |

| 元数据字段 | 创建时间、作者、审批人 | 支持高级筛选 |

该分类体系可通过元数据标注的方式嵌入至每份文档的索引记录中,在查询时作为过滤条件参与召回。例如,当用户提问“最新的HR休假政策是什么?”时,系统可自动识别意图并限定检索范围为“人力资源”类别下“现行有效”的最新版本文档。

此外,建议采用本体建模(Ontology Modeling)方式构建轻量级知识图谱雏形,定义实体之间的关系,如“员工手册 → 包含 → 休假条款”,从而增强语义推理能力。

4.1.2 PDF/Office文件内容提取工具链搭建

非结构化文档的内容提取质量直接影响后续文本向量化的准确性。不同格式文件需采用差异化的解析策略,避免因排版复杂导致的信息丢失或错乱。

常用的开源工具组合如下:

- PDF解析 :

PyPDF2、pdfplumber、unstructured或 Google Cloud Document AI - Office文档解析 :

python-docx(.docx)、openpyxl(.xlsx)、pptx(.pptx) - 图像型PDF处理 :结合OCR引擎如Tesseract或Google Vision API

以下是一个基于 unstructured 库实现多格式统一解析的代码示例:

from unstructured.partition.auto import partition

import os

def extract_text_from_file(file_path):

"""通用文档内容提取函数"""

try:

elements = partition(filename=file_path)

full_text = "\n".join([str(el) for el in elements])

return full_text.strip()

except Exception as e:

print(f"解析失败 {file_path}: {e}")

return ""

# 批量处理目录下所有文档

input_dir = "/company_knowledge_base"

documents = {}

for filename in os.listdir(input_dir):

filepath = os.path.join(input_dir, filename)

if os.path.isfile(filepath):

text = extract_text_from_file(filepath)

documents[filename] = text

代码逻辑逐行解读与参数说明:

- 第3行 :导入

partition函数,它能根据文件扩展名自动选择合适的解析器(如PDF、DOCX等),简化开发工作。 - 第6–8行 :封装成函数

extract_text_from_file,接受文件路径作为输入,返回纯文本字符串。异常捕获确保程序不会因单个文件损坏而中断。 - 第9–10行 :遍历指定目录中的所有文件,调用解析函数并将结果存入字典

documents,便于后续批量处理。 - 扩展建议 :对于扫描件PDF,可在调用前判断是否为图像型文档,并启用OCR模块进行光学字符识别,提升覆盖率。

此工具链的优势在于支持超过20种文档格式,并保留部分布局信息(如标题、列表),有助于后续语义分块。但在实践中需注意:

- 表格内容可能被线性化,需额外处理还原结构;

- 密码保护或加密文件需提前解密;

- 大文件应设置内存限制,防止OOM错误。

4.1.3 分块策略选择:固定长度 vs 语义边界切分

由于大语言模型存在上下文窗口限制(Gemini Pro最大32K tokens),原始文档必须被切分为若干片段(chunks)以便独立编码与检索。分块方式的选择直接影响检索相关性和答案完整性。

固定长度分块(Fixed-size Chunking)

最简单的方法是按字符数或token数进行等长切割,常用于初步实验阶段。

def fixed_chunking(text, chunk_size=1000, overlap=100):

"""固定长度分块,带重叠避免语义断裂"""

chunks = []

start = 0

while start < len(text):

end = start + chunk_size

chunk = text[start:end]

chunks.append(chunk)

start += (chunk_size - overlap)

return chunks

优点:实现简单、易于并行处理;缺点:容易切断句子或段落,破坏语义完整性。

基于语义边界的分块(Semantic Chunking)

更先进的做法是利用自然语言处理技术识别段落、章节标题或句号等语义边界进行智能切分。

推荐使用 langchain.text_splitter.RecursiveCharacterTextSplitter :

from langchain.text_splitter import RecursiveCharacterTextSplitter

splitter = RecursiveCharacterTextSplitter(

separators=["\n\n", "\n", "。", "!", "?", " ", ""],

chunk_size=1000,

chunk_overlap=100,

length_function=len

)

chunks = splitter.split_text(document_text)

| 参数 | 说明 |

|---|---|

separators |

按优先级尝试分割符,先试双换行(段落),再试单换行、中文句号等 |

chunk_size |

目标块大小(字符数或token数) |

chunk_overlap |

相邻块之间保留一定重叠,缓解上下文缺失问题 |

length_function |

计算长度的方式,可用于适配token计数器 |

对比分析表:

| 策略 | 可读性 | 检索精度 | 实现难度 | 适用场景 |

|---|---|---|---|---|

| 固定长度 | 低 | 中 | 低 | 快速原型、日志类文本 |

| 语义边界 | 高 | 高 | 中 | 政策文档、技术手册 |

| 基于句子 | 高 | 高 | 高 | 对话系统、问答片段 |

实际项目中建议结合两者优势:先用语义分割粗粒度划分章节,再对超长节应用固定滑动窗口细分。同时为每个chunk添加元数据(如来源文件、页码、章节标题),以便生成答案时准确溯源。

4.2 向量数据库构建与索引优化

完成文本分块后,下一步是将每个文本片段转换为高维向量表示,并构建高效的向量索引结构,支撑毫秒级相似度检索。这是RAG系统的核心基础设施之一。

4.2.1 使用Text Embedding模型生成高质量向量

Google 提供了专用的文本嵌入模型 textembedding-gecko 系列(现集成于 Vertex AI),专为检索任务优化,具有良好的语义保真度和跨语言支持能力。

调用示例如下(使用 Vertex AI SDK):

from google.cloud import aiplatform

def generate_embedding(text):

client = aiplatform.gapic.PredictionServiceClient()

endpoint = f"projects/{PROJECT_ID}/locations/us-central1/publishers/google/models/textembedding-gecko"

instance = {"content": text}

response = client.predict(endpoint=endpoint, instances=[instance])

embedding = response.predictions[0]["embeddings"]["values"]

return embedding

参数说明与执行逻辑:

-

PROJECT_ID:GCP项目ID,需提前启用Vertex AI API; -

textembedding-gecko:当前主流版本支持最长8192 tokens,输出768维浮点向量; -

content字段 :传入待编码的文本块; - 返回值 :标准化后的稠密向量,可用于余弦相似度计算。

为提升效率,建议批量发送请求(每次最多100条),并使用异步任务队列控制并发速率。同时注意:

- 避免过长文本截断导致信息损失;

- 添加缓存机制防止重复计算相同内容;

- 在离线管道中预计算所有chunk向量,避免在线延迟。

4.2.2 索引类型选择:HNSW与IVF的性能权衡

向量数据库需支持快速近似最近邻搜索(ANN)。主流算法包括 HNSW(Hierarchical Navigable Small World)和 IVF(Inverted File Index),二者各有优劣。

| 特性 | HNSW | IVF |

|---|---|---|

| 查询速度 | 极快(亚毫秒级) | 快(依赖聚类质量) |

| 内存占用 | 较高 | 较低 |

| 插入延迟 | 高(不适合频繁更新) | 低 |

| 支持动态更新 | 弱 | 强 |

| 适用场景 | 静态知识库 | 实时流式写入 |

在企业知识库这类更新频率较低但查询密集的场景中,HNSW通常是首选。例如在 Pinecone 或 Weaviate 中均可配置:

# Weaviate schema configuration snippet

classes:

- class: DocumentChunk

vectorIndexType: hnsw

vectorIndexConfig:

efConstruction: 128

ef: 100

maxConnections: 64

其中关键参数含义如下:

efConstruction: 构建索引时的候选节点数量,值越大精度越高,但构建慢;ef: 查询时的候选集大小,影响查准率与延迟;maxConnections: 图中每个节点的最大邻居数,控制索引复杂度。

一般建议初始设置 ef=100 , efConstruction=200 ,然后通过压力测试调优。

4.2.3 动态更新机制与增量索引维护

尽管知识库整体相对稳定,但仍需支持新增、修改或删除文档后的索引同步。为此需设计增量更新机制。

一种可行方案是引入变更日志(Change Log)+ 定时批处理:

import hashlib

def compute_doc_hash(content):

return hashlib.md5(content.encode()).hexdigest()

# 维护一个元数据表

metadata_db = {

"hr_policy_v3.docx": {

"last_hash": "a1b2c3d...",

"last_indexed": "2025-04-05"

}

}

def should_reindex(filename, current_content):

current_hash = compute_doc_hash(current_content)

if filename not in metadata_db:

return True, current_hash

old_hash = metadata_db[filename]["last_hash"]

return old_hash != current_hash, current_hash

# 主流程

for fname, content in new_documents.items():

need_update, new_hash = should_reindex(fname, content)

if need_update:

chunks = semantic_chunking(content)

embeddings = [generate_embedding(c) for c in chunks]

upsert_to_vector_db(chunks, embeddings)

metadata_db[fname]["last_hash"] = new_hash

该机制通过内容哈希检测变化,仅对变更文档重新分块与向量化,大幅降低计算开销。配合每日定时任务或事件驱动触发(如监听Google Drive Webhook),即可实现准实时更新。

4.3 提示工程与回答生成质量调优

即便检索结果准确,若生成阶段未能合理整合信息,仍可能导致答案失真或遗漏关键细节。提示工程(Prompt Engineering)成为连接检索与生成的关键桥梁。

4.3.1 设计结构化Prompt模板提升一致性

为确保输出风格统一、逻辑清晰,应构建标准化的Prompt模板,明确角色、任务、输入格式与输出要求。

你是一名企业知识助手,请根据以下检索到的相关文档片段,回答用户的问题。

【背景信息】

{context_str}

【用户问题】

{query}

【回答要求】

1. 使用中文作答,语气专业且简洁;

2. 若信息不足,请说明“无法确定”;

3. 不得编造未出现在文档中的内容;

4. 如涉及多个条款,请逐条列出;

5. 在答案末尾标注引用来源文件名(如[hr_policy.pdf])。

请开始回答:

该模板具备以下优势:

- 明确限定知识边界,抑制幻觉;

- 规范输出结构,便于前端展示;

- 支持多轮对话上下文注入;

- 可根据不同角色定制(如IT支持、HR咨询)。

在实际部署中,可借助 LangChain 的 PromptTemplate 类进行管理:

from langchain.prompts import PromptTemplate

template = """

你是一名企业知识助手...(同上)

prompt = PromptTemplate(

input_variables=["context_str", "query"],

template=template

)

final_prompt = prompt.format(context_str="\n".join(retrieved_chunks), query=user_query)

4.3.2 引用原文片段确保答案可追溯

可信度是企业级系统的生命线。任何生成的回答都应附带出处链接或原文摘录,供用户核实。

Gemini 支持在响应中标记引用位置。一种实现方式是在 context 中显式标注 chunk ID:

[Chunk ID: doc123_part4]

根据《信息安全管理办法》第5.2条:“外部设备接入须经IT部门审批。” —— source: security_policy_v2.docx

生成后解析回复中的关键词,反向映射回原始文档位置,并在UI中标亮对应段落。这不仅增强透明度,也为审计留痕提供依据。

4.3.3 设置拒答机制避免误导性输出

面对模糊、敏感或超出权限的问题,系统应主动拒绝回答而非猜测。

可通过规则引擎+LLM判断双重机制实现:

def is_safe_to_answer(query, context):

# 规则过滤

sensitive_keywords = ["薪资明细", "裁员名单", "股票期权"]

if any(kw in query for kw in sensitive_keywords):

return False, "涉及敏感信息,无法提供"

# LLM辅助判断

judgment_prompt = f"""

问题:{query}

检索到的内容:{context[:500]}...

请问以上内容是否足以准确回答该问题?回答“是”或“否”。

"""

llm_response = call_gemini(judgment_prompt)

return "是" in llm_response, None

answerable, reason = is_safe_to_answer(user_query, retrieved_context)

if not answerable:

response = "暂无足够信息回答该问题。"

else:

response = generate_final_answer(prompt_with_context)

该机制有效平衡了可用性与安全性,尤其适用于合规要求严格的金融、医疗等行业。

综上所述,智能搜索系统的实施是一项系统工程,需贯穿数据、模型、架构与交互全流程的精细化设计。唯有在每一个环节坚持高标准、严测试,方能打造出真正服务于企业核心生产力的AI知识中枢。

5. 系统测试、评估与持续优化机制

构建基于Gemini的企业知识库智能搜索系统后,其实际效能不能仅依赖于技术实现的完整性,更需通过科学严谨的测试、量化评估和闭环优化机制来保障长期稳定运行。一个高可用、高准确性的智能搜索服务必须经历从功能验证到性能调优,再到用户行为反馈驱动迭代的全过程。本章将深入探讨如何设计覆盖全面的测试体系,建立多维度的评估指标框架,并构建可持续演进的优化机制,确保系统在真实业务场景中持续释放价值。

5.1 系统测试的设计与执行策略

在智能搜索系统的上线前阶段,必须进行端到端的功能性与非功能性测试,以识别潜在缺陷并验证核心能力是否符合预期。测试不仅仅是“有没有返回结果”,而是要验证“返回的结果是否正确、及时、安全且可解释”。为此,需要构建结构化的测试用例库,并采用自动化与人工评审相结合的方式推进测试流程。

5.1.1 测试类型划分与覆盖范围

智能搜索系统的测试应涵盖多个层次:单元测试关注组件内部逻辑(如分块函数、向量编码接口),集成测试验证各模块协作(如查询解析→向量检索→LLM生成),而端到端测试则模拟真实用户请求路径,检验整体响应质量。

| 测试类型 | 覆盖目标 | 示例场景 | 工具建议 |

|---|---|---|---|

| 功能测试 | 验证基本查询与响应逻辑 | 输入常见问题,检查答案准确性 | Postman, PyTest |

| 边缘场景测试 | 检查异常输入处理能力 | 空查询、超长文本、特殊字符注入 | 自定义脚本 + 日志分析 |

| 安全性测试 | 防止信息泄露或越权访问 | 尝试检索未授权文档、敏感字段脱敏检测 | OWASP ZAP, Burp Suite |

| 性能压力测试 | 评估高并发下的稳定性与延迟表现 | 模拟100+ QPS请求,监控API响应时间分布 | Locust, JMeter |

| 回归测试 | 确保更新不影响已有功能 | 修改Prompt模板后重跑历史成功案例 | CI/CD流水线集成 |

上述表格展示了不同测试类型的定位与实施要点。特别地,在安全性测试中,由于Gemini API可能返回包含原始文档片段的内容,必须确保前端展示层对权限控制严格,防止低权限用户通过语义搜索绕过传统访问控制机制。

5.1.2 构建标准化测试用例集

为提升测试效率与一致性,建议建立结构化测试用例数据库,每个用例应包含以下字段:

- ID :唯一标识符

- Query :用户提问文本

- Expected Document Source :期望引用的知识源

- Expected Answer Summary :理想回答摘要

- Acceptance Criteria :判定标准(如关键词匹配度≥90%)

- Priority Level :高/中/低优先级

例如,针对人力资源政策查询场景,可设计如下测试用例:

{

"id": "HR-003",

"query": "员工产假最长可以休多久?",

"expected_source": "employee_policy_handbook_v2.pdf",

"expected_answer": "根据公司《员工手册》第5.4节规定,女性员工享有最长180天带薪产假。",

"criteria": "答案中须包含‘180天’和‘带薪产假’关键词,来源标注准确"

}

该JSON格式便于程序化加载并与自动化测试框架集成。执行时可通过调用Gemini API获取实际输出,再使用自然语言相似度算法(如BERTScore或ROUGE-L)计算与预期答案的相关性得分。

5.1.3 自动化测试流水线搭建

借助CI/CD工具链,可实现每次代码变更或知识库更新后自动触发回归测试。以下是一个典型的Python测试脚本示例:

import unittest

import requests

from bert_score import score as bert_score_eval

class TestGeminiSearch(unittest.TestCase):

BASE_URL = "https://your-gemini-proxy-api.com/query"

TEST_CASES = [

{

"query": "服务器宕机怎么排查?",

"expected": "首先检查日志文件/var/log/syslog..."

},

{

"query": "报销流程需要哪些签字?",

"expected": "需部门主管、财务审核、CFO三级审批"

}

]

def test_query_responses(self):

headers = {"Authorization": "Bearer YOUR_API_KEY"}

for case in self.TEST_CASES:

with self.subTest(query=case["query"]):

payload = {"question": case["query"]}

response = requests.post(self.BASE_URL, json=payload, headers=headers)

self.assertEqual(response.status_code, 200)

result = response.json()

# 使用BERTScore评估语义相似度

P, R, F1 = bert_score_eval(

cands=[result.get("answer", "")],

refs=[case["expected"]],

lang="zh"

)

self.assertGreater(F1.item(), 0.7, f"Answer too dissimilar for: {case['query']}")

代码逻辑逐行解读:

import unittest:引入Python内置单元测试框架。import requests:用于发起HTTP请求至Gemini代理API。from bert_score import score as bert_score_eval:导入BERTScore库,利用预训练模型计算生成答案与期望答案之间的语义相似度,比字符串匹配更鲁棒。TEST_CASES:定义测试数据集合,包含真实业务问题及其标准答案。test_query_responses():主测试方法,遍历所有用例发送请求。response = requests.post(...):模拟客户端调用搜索接口。bert_score_eval(...):执行语义评分,F1值反映精确率与召回率的调和平均。self.assertGreater(F1.item(), 0.7...):设定阈值,若语义匹配度低于70%,则判定测试失败。

此脚本可嵌入GitHub Actions或Jenkins等CI平台,在每次提交后自动运行,极大提升交付质量与迭代速度。

5.2 多维评估指标体系的构建

测试完成并不意味着系统就绪,还需建立一套客观、可量化的评估体系,用于衡量系统在真实环境中的表现。单一指标无法全面反映智能搜索的质量,因此应综合考虑准确性、效率、用户体验和可靠性等多个维度。

5.2.1 核心评估指标定义

下表列出了关键评估指标及其计算方式与业务意义:

| 指标名称 | 公式/说明 | 目标值 | 采集方式 |

|---|---|---|---|

| 准确率(Precision@K) | Top-K结果中相关文档占比 | ≥85% | 人工标注 + A/B测试 |

| 召回率(Recall@K) | 返回的相关文档数 / 所有相关文档总数 | ≥75% | 基于黄金标准知识图谱 |

| 平均响应时间 | 用户提问到收到完整回答的时间(含网络延迟) | <1.5s | 前端埋点 + 后端日志统计 |

| 答案相关性评分 | 1–5分制,由专家评估回答与问题的相关程度 | ≥4.0 | 用户调研或内部评审小组打分 |

| 拒答率 | 系统明确表示“无法回答”的请求比例 | 5%-10% | 日志过滤特定响应模式 |

| 引用准确率 | 生成答案中引用原文片段的位置与内容正确率 | ≥90% | 正则匹配 + 文档定位校验 |

其中,“引用准确率”尤为重要,它是RAG系统可信度的核心体现。若系统频繁虚构引用位置或篡改原文意思,则会严重削弱用户信任。

5.2.2 用户体验感知型指标采集

除了技术指标外,还应关注用户的主观体验。可通过以下方式收集反馈:

- 显式反馈 :在搜索结果页添加“是否有帮助?”按钮(👍/👎),记录点击数据。

- 隐式行为分析 :监测用户是否继续追问、是否复制答案、是否跳转至原始文档查看详情。

- NPS调查 :定期向高频使用者发放净推荐值问卷:“您有多大可能向同事推荐该搜索系统?”

这些数据可汇总成月度健康报告,辅助判断系统改进方向。例如,若发现某类技术文档的拒答率显著上升,可能是对应知识源已过期或缺失,提示需触发内容审查流程。

5.2.3 A/B测试驱动决策优化

为了科学比较新旧版本或不同配置的效果,应部署A/B测试机制。假设我们希望评估“语义边界分块”相比“固定长度分块”是否能提升回答质量,可按如下步骤操作:

- 将用户流量随机分为两组(A组用旧策略,B组用新策略);

- 在相同时间段内收集两组的查询日志;

- 对关键指标进行统计学检验(如t-test)判断差异显著性。

from scipy import stats

import numpy as np

# 模拟两组用户的答案评分数据(满分5分)

group_a_scores = np.random.normal(loc=3.8, scale=0.6, size=200) # 固定分块

group_b_scores = np.random.normal(loc=4.2, scale=0.5, size=200) # 语义分块

# 执行独立样本t检验

t_stat, p_value = stats.ttest_ind(group_a_scores, group_b_scores)

if p_value < 0.05:

print(f"显著差异:p={p_value:.3f},支持新策略")

else:

print(f"无显著差异:p={p_value:.3f}")

参数说明与逻辑分析:

np.random.normal():生成符合正态分布的模拟评分数据,贴近真实用户打分分布。stats.ttest_ind():执行双样本t检验,判断两组均值是否存在统计学意义上的差异。p_value < 0.05:常用显著性水平,表示置信度达95%以上。- 若结果显著,则可决定将新分块策略推广至全量用户。

此类实验方法为系统优化提供了数据支撑,避免凭经验盲目调整。

5.3 持续监控与动态优化机制

智能搜索系统并非“一次部署即永恒”,企业知识不断演进,用户需求日益复杂,必须建立持续监控与反馈驱动的优化闭环。

5.3.1 实时监控告警体系建设

部署Prometheus + Grafana组合,对关键服务指标进行可视化监控:

- Gemini API调用成功率

- 向量数据库查询延迟

- 缓存命中率

- 错误日志频率(如5xx状态码)

同时设置告警规则,例如:

当连续5分钟内API平均响应时间超过2秒时,触发企业微信/钉钉通知运维团队。

此外,应对异常查询行为进行检测,如短时间内大量重复提问、尝试提取系统提示词等,防范潜在滥用或攻击行为。

5.3.2 知识库内容新鲜度管理

知识陈旧是导致搜索失效的主要原因之一。建议建立自动化内容审查机制:

content_refresh_policy:

hr_policies:

check_interval: weekly

owner: HR_Doc_Team

action_on_change: re-embed_and_update_index

it_knowledge_base:

check_interval: daily

owner: DevOps_Squad

action_on_change: incremental_update

sales_contracts:

check_interval: monthly

owner: Legal_Compliance

verification_required: true

该YAML配置文件定义了不同类型文档的更新策略。结合文件存储系统的Webhook或定时扫描任务,一旦检测到源文件修改,立即触发向量化更新流程,确保索引同步。

5.3.3 基于反馈的迭代优化循环

最终的优化动力来源于用户。建议设立“搜索质量看板”,每日抽取一定比例的查询日志进行人工质检,并分类标记问题类型:

- ❌ 答案错误 :事实性错误或误导

- ⚠️ 信息不全 :遗漏关键细节

- 🔗 引用不准 :链接或页码错误

- 🤖 机械回复 :缺乏上下文理解

针对这些问题,反向追溯至具体环节进行修复:

- 若为 分块不当 → 调整chunk_size或启用句子边界分割;

- 若为 向量模型偏差 → 更换embedding模型(如从textembedding-gecko升级至最新版);

- 若为 Prompt表达不清 → 优化提示模板,增加约束条件;

- 若为 知识缺失 → 补充原始文档并重新索引。

通过这种“发现问题→定位根因→实施改进→验证效果”的闭环机制,系统将持续进化,逐步逼近理想的信息助手形态。

6. 典型应用场景与未来演进建议

6.1 人力资源政策智能查询场景

在大型企业中,HR政策文档往往分散于多个系统(如SharePoint、内部Wiki、PDF手册),员工对年假规定、报销流程、晋升机制等问题的咨询占据了HR部门大量工作时间。通过Gemini驱动的智能搜索系统,员工可使用自然语言提问:“我明年休产假能休多久?配偶陪产假怎么申请?”系统自动从《员工福利手册》《劳动合规指南》等文档中提取相关信息,并生成结构化回答,同时附带原文引用链接。

该场景的关键实现步骤如下:

- 文档预处理 :将所有HR相关PDF和DOCX文件通过

PyPDF2和python-docx库提取文本。 - 语义分块 :采用基于句子边界的语义切分策略,确保每一块包含完整政策条目。

- 向量化存储 :调用

textembedding-gecko@003模型生成768维向量,存入Vertex AI Matching Engine。 - 查询解析 :用户输入经Gemini进行意图识别后,重写为标准化查询语句,例如“产假天数规定及配偶陪产假申请条件”。

- 结果生成 :结合检索到的Top-3文档片段,由Gemini生成简洁摘要并标注出处。

# 示例:调用Gemini API进行HR政策问答

import vertexai

from vertexai.generative_models import GenerativeModel, Part

vertexai.init(project="your-project-id", location="us-central1")

model = GenerativeModel("gemini-pro")

def ask_hr_policy(question: str):

retrieval_results = vector_db.similarity_search(question, k=3)

context = "\n".join([doc.page_content for doc in retrieval_results])

response = model.generate_content([

f"根据以下企业政策内容回答问题,要求准确、简洁,并注明条款来源:\n{context}\n\n问题:{question}"

])

return response.text

# 调用示例

print(ask_hr_policy("海外派遣员工是否享受补充医疗保险?"))

执行逻辑说明:

- similarity_search 返回最相关的三个文档块;

- Prompt中明确要求“注明条款来源”,增强可信度;

- Gemini模型在生成时会自动归纳信息并避免虚构内容。

参数说明:

- k=3 表示召回前三条高相关性结果;

- gemini-pro 模型适用于通用对话任务;

- 输入长度限制为32,768 tokens,适合长上下文推理。

6.2 IT运维故障排查知识支持

IT服务台常面临重复性技术问题,如“VPN无法连接提示错误691”或“Outlook同步失败”。传统做法依赖人工查阅知识库文章编号KB10293。引入Gemini智能搜索后,一线支持人员可通过口语化描述快速定位解决方案。

系统优化措施包括:

| 优化项 | 实施方式 | 效果提升 |

|---|---|---|

| 查询扩展 | 利用Gemini生成同义问法(如“身份验证失败”→“用户名密码错误”) | 召回率提升37% |

| 多模态支持 | 支持上传截图,Gemini Vision解析界面报错信息 | 减少文字描述偏差 |

| 动态更新 | 每周自动抓取ServiceNow中新解决案例入库 | 知识新鲜度保持<7天延迟 |

此外,系统集成至Slack机器人,支持如下交互:

用户:我的MFA突然收不到验证码了

Bot回复:可能原因及建议操作:

1. 手机时间不同步 → 校准设备时间(参见KB2058)

2. Authenticator应用崩溃 → 重新导入账户(需联系安全团队重置)

3. 账户被锁定 → 使用备用验证方式登录后台解锁

此过程通过以下代码实现多轮上下文管理:

chat_history = []

def handle_it_query(user_input):

context = "\n".join([f"{entry['role']}: {entry['content']}" for entry in chat_history[-3:]])

full_prompt = f"""

你是一名资深IT支持专家。请根据历史对话上下文和最新问题提供精准指导。

历史记录:

{context}

最新问题:

{user_input}

要求:分点列出可能原因与解决步骤,引用KB编号若存在。

"""

response = model.generate_content(full_prompt)

chat_history.append({"role": "user", "content": user_input})

chat_history.append({"role": "assistant", "content": response.text})

return response.text

该机制显著降低了二线工程师介入率,平均首次响应时间从18分钟缩短至2.3分钟。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献30条内容

已为社区贡献30条内容

所有评论(0)