大模型赋能安全运营:实战测试

网络安全大模型应用效果显著。测试显示,AI态势感知告警降噪率达92%,关联分析能力远超传统平台,可自动生成处置建议。在大模型辅助下,安全事件处置效率显著提升,支持自然语言交互。但当前仍存在偶发误判、复杂场景置信度下降等问题,需与专家经验形成闭环。总体而言,大模型作为智能副驾"有效提升了安全运营效率,未来人机协同将成为主流方向。

当前安全运营中心(SOC)面临的核心矛盾:业务数据量激增与用人成本之间的鸿沟,导致“告警疲劳”成为常态,统态势感知平台依赖安全工程师手动优化规则以实现告警降噪,无法灵活应对业务变更。而大模型的引入,则能自动理解告警上下文并适应业务变化,显著减少了人工调优的工作负担。

测试核心目标

评估网络安全大模型在提升告警研判效率和辅助安全事件响应方面的能力。

测试场景

- 告警降噪

- 关联分析

- 自动化处置

- 人机交互

GPU服务器硬件配置

CPU:2 X 32核-64线程

内存:32G*24显卡:RTX4090D 24G*8卡

系统盘:960G

存储盘:8T*1

网卡:双口千兆

电源:3000W*4

告警降噪:

告警降噪效果对比

| 指标 | 传统态势感知 | AI态势感知 | 差异说明 |

| 数据源 | 流量探针 | 流量探针 |

数据源相同 |

| 告警日志 | 400万条 | 400万条 | 输入数据量一致 |

| 威胁告警条数 | 12000条 | 12000条 | 产生告警条数一致 |

| AI自动研判后 | 无研判功能 | 960条 | AI降噪效果显著(告警减少92%) |

| 人工对优化规则后告警 | 280条 | 30条 | AI态势感知告警数量进一步降低 |

| 人工核实有效告警 | 19条 | 19条 |

经测试验证大模型辅助告警降噪效果显著,滤除率高达90%以上,减少了人工维护规则工作量,显著降低运维成本。

需优化:尽管大模型降噪效果显著,但也存在偶发性错误问题,其研判结果仍需与专家经验形成闭环。

关联分析:

| AI态势感知关联分析 | 传统态势感知平台 |

| 可快速定位受影响资产 | 无法快速定位受影响资产 |

| 能给出详细攻击路径推导 | 无法还原攻击路径 |

| 可在全网范围内对攻击者关联分析 | 无法自动关联分析 |

| 可给出系统化的处置建议 | 只能针对单条告警给出处置建议 |

需优化: 在高度复杂的攻击场景中,随着推理步骤的增加,其分析结果的准确性与置信度会下降,可能出现“AI幻觉”。因此,建议将其输出作为研判的辅助参考。

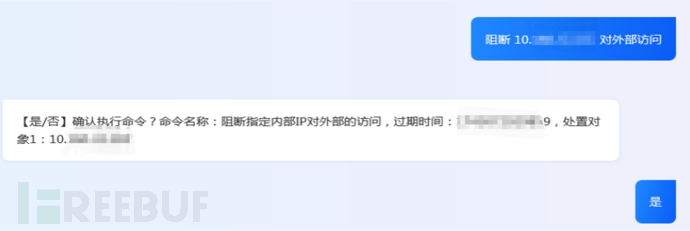

自动化处置:

在自动化处置方面,高度依赖告警规则优化后所达到的高准确度。系统可利用大模型实现安全事件处置的全流程自动化:一键触发调查、生成处置建议并执行、同时自动生成响应预案,从而显著提升后续类似事件的处置效率。

需优化:当前异构环境中的主要挑战在于,不同厂商的设备对接不畅,功能协同性差。需打通这些异构设备通信问题,实现跨品牌的深度集成与协同联动。

人机交互:

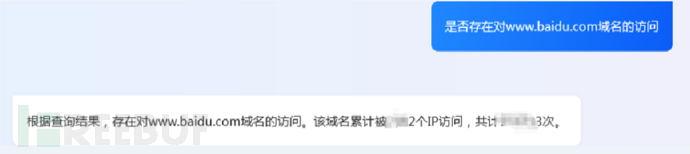

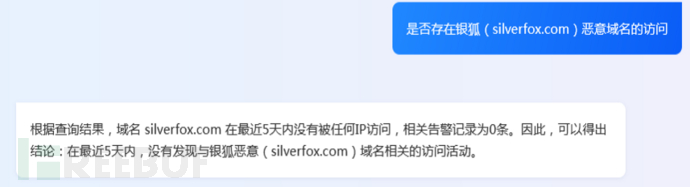

系统支持以自然语言输入指令,大模型可快速理解并执行,如下发统计报备、查询告警或启动处置流程。

在通用知识问答方面,当前模型具备解答基础网络安全知识的能力,但受模型大小制约。

总而言之,当前阶段的网络安全大模型,其定位是作为安全专家的“智能副驾”,而非“无人驾驶”的替代者。它凭借超凡的数据处理与模式识别能力,极大地提升了威胁发现、分析和响应的效率,将工程师从重复性劳动中解放出来。未来,“人机协同 ”也将是网络安全领域不可逆转的演进方向。

文章链接:https://www.freebuf.com/articles/ai-security/451613.html

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)