从 0 到 1,与 GLM-4.6 共创:打造你的首个 AI 原生应用

摘要:基于GLM-4.6的全栈AI应用开发实践 本文以"智识火花"个人知识库应用为例,展示了如何借助GLM-4.6大语言模型完成从构思到实现的全过程。主要内容包括: 项目构思阶段:GLM作为产品经理,帮助定义核心功能、差异化优势及产品愿景; 技术架构设计:GLM担任架构师,推荐技术栈并生成系统架构图; 后端开发:GLM生成包含CRUD接口的FastAPI生产级代码; 前端开发:

系列文章目录

人工智能

👉前言

你是否曾有过一个绝妙的想法,却因技术门槛、时间成本或资源限制而望而却却步?在人工智能浪潮席卷全球的今天,我们正迎来一场开发范式的深刻革命。以 GLM-4.6 为代表的大语言模型,已不再是简单的聊天机器人,它们正成为我们身边的全栈开发伙伴、产品经理和架构师。

本文将以一个真实的项目——“智识火花”(一个具备智能搜索和问答功能的个人知识库应用)为例,手把手带你体验如何借助 GLM-4.6,从一个模糊的概念出发,一步步完成一个功能完备的 AI 原生应用。你将看到,这不仅是效率的提升,更是创造力的解放。#GLM我的编程搭子 #GLM-4.6

博客将会介绍如何实现 。希望这篇博客对Unity的开发者有所帮助。

大家好,我是心疼你的一切,不定时更新开发技巧,觉得有用记得一键三连哦。

欢迎点赞评论哦.下面就让我们进入正文吧 !

提示:以下是本篇文章正文内容,下面案例可供参考

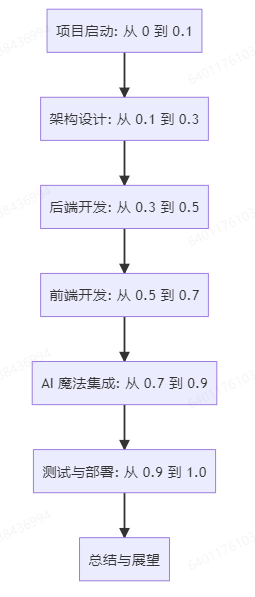

👉一、文章结构导图

👉1-1、第一步:项目启动与构思 (从 0 到 0.1) —— AI 是你的产品经理

一个好的项目始于一个清晰的想法。但如何让想法变得具体、可行?GLM-4.6 可以扮演一位经验丰富的产品经理,帮你进行头脑风暴和需求分析。

🎯 目标: 定义“智识火花”的核心功能、目标用户和独特价值。

✍️ 提示词示范:

“请你扮演一位资深的产品经理,我有一个想法,做一个名为‘智识火花’的个人知识库应用。目标用户是学生、研究人员和终身学习者。请你帮我:

进行头脑风暴,列出至少 5 个核心功能。

分析市面上的同类产品(如 Notion, Obsidian),找出它们的痛点和我们的差异化优势。

为这个项目设计一个简洁的产品愿景和口号。”

💡 GLM-4.6 的突破:

GLM-4.6 不会只给你零散的点子,它会提供结构化、有深度的分析。

核心功能清单:

笔记管理:支持 Markdown,标签,文件夹。

智能搜索:基于关键词和语义的全文搜索。

AI 问答:基于你的笔记内容,让 AI 为你解答问题(RAG)。

知识图谱:自动链接笔记间的关联,可视化知识网络。

多端同步:Web, 移动端实时同步。

差异化优势:

深度集成 AI:我们的核心是“AI 问答”,而非简单的搜索,让知识“活”起来。

隐私优先:所有数据均可本地化部署或选择可信云服务,保障数据安全。

极简体验:专注于记录与思考,界面干净,无干扰。

产品愿景: 让每个人的知识碎片,都能汇聚成智慧的火花。

口号: 智识火花,点亮你的思考宇宙。

通过这一步,我们从一个模糊的“知识库”想法,变成了一个有清晰定位和核心功能的“智识火花”项目。

👉1-2、第二步:技术选型与架构设计 (从 0.1 到 0.3) —— AI 是你的架构师

有了产品蓝图,接下来就是技术实现。选什么技术栈?系统怎么设计?对于非全栈开发者来说,这往往是第一道坎。

🎯 目标: 确定技术栈,并绘制系统架构图。

✍️ 提示词示范:

“现在你是一位全栈架构师。基于‘智识火花’这个项目,我们需要一个现代、高效且易于扩展的技术栈。请推荐:

前端、后端、数据库 的具体技术,并说明理由。

为了实现 AI 问答功能,我们需要引入哪些 AI 相关的技术或服务?

请使用 Mermaid 语法,绘制一个简单的系统架构图,展示用户、前端、后端、数据库和 AI 服务之间的关系。”

💡 GLM-4.6 的突破:

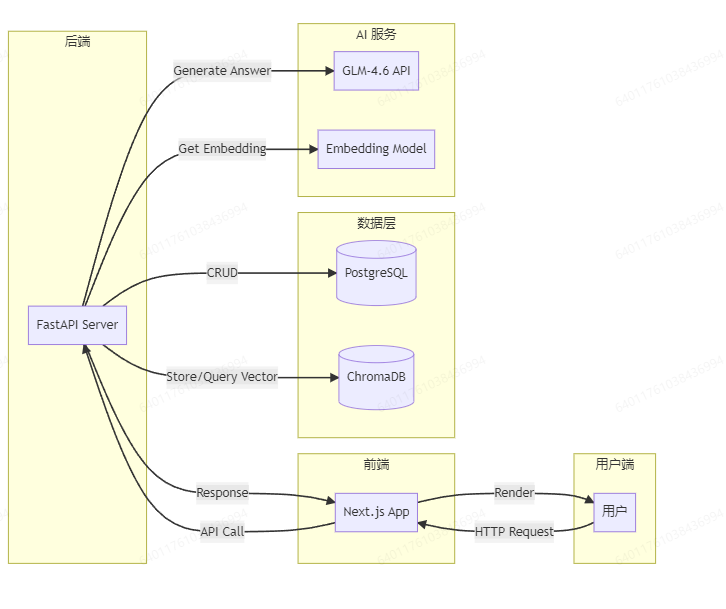

GLM-4.6 能基于项目需求(如“高效”、“AI集成”)给出经过权衡的建议,并直接生成可视化图表,将抽象概念具象化。

🖼️ 预期输出(代码块):

技术栈推荐:

前端: Next.js (React) + Tailwind CSS。理由:SSR/SSG 友好,利于 SEO;Tailwind 快速构建美观 UI。

后端: Python + FastAPI。理由:Python 是 AI 生态的绝对核心,FastAPI 性能高,自带交互式文档。

数据库: PostgreSQL (关系型) + ChromaDB (向量数据库)。理由:PG 处理结构化数据,ChromaDB 存储笔记的向量表示,用于语义搜索。

AI 服务: GLM-4.6 API 用于生成回答,Sentence-Transformers 模型用于文本向量化。

系统架构图 (Mermaid):

现在,我们有了清晰的“施工图纸”,可以开始动工了!

👉1-3、第三步:后端核心开发 (从 0.3 到 0.5) —— AI 是你的高级工程师

编码阶段是最耗时、最考验细节的环节。GLM-4.6 可以成为你的编码助手,快速生成高质量的样板代码和复杂逻辑。

🎯 目标: 使用 FastAPI 创建笔记的 CRUD (增删改查) API。

✍️ 提示词示范:

“你是 Python 后端开发专家。请使用 FastAPI 和 SQLAlchemy,为‘智识火花’项目生成以下代码:

笔记的 SQLAlchemy 模型,包含 id, title, content, created_at 字段。

创建一个新的笔记的 API 端点 POST /api/notes,接收 title 和 content,成功后返回创建的笔记对象。

获取所有笔记列表的 API 端点 GET /api/notes。 请确保代码包含必要的注释和错误处理。”

💡 GLM-4.6 的突破:

GLM-4.6 生成的是“生产就绪”的代码片段,而非玩具代码。它包含了 Pydantic 模型用于数据验证、依赖注入、异常处理等现代 Web 框架的最佳实践。

🖼️ 预期输出(代码块):

from sqlalchemy import Column, Integer, String, DateTime

from sqlalchemy.ext.declarative import declarative_base

from datetime import datetime

Base = declarative_base()

class Note(Base):

__tablename__ = "notes"

id = Column(Integer, primary_key=True, index=True)

title = Column(String, index=True)

content = Column(String)

created_at = Column(DateTime, default=datetime.utcnow)

# main.py

from fastapi import FastAPI, Depends, HTTPException

from sqlalchemy.orm import Session

from . import models, schemas, crud

from .database import SessionLocal, engine

models.Base.metadata.create_all(bind=engine)

app = FastAPI()

# Dependency

def get_db():

db = SessionLocal()

try:

yield db

finally:

db.close()

@app.post("/api/notes/", response_model=schemas.Note)

def create_note(note: schemas.NoteCreate, db: Session = Depends(get_db)):

return crud.create_note(db=db, note=note)

@app.get("/api/notes/", response_model=list[schemas.Note])

def read_notes(skip: int = 0, limit: int = 100, db: Session = Depends(get_db)):

notes = crud.get_notes(db, skip=skip, limit=limit)

return notes

👉1-4、第四步:前端界面开发 (从 0.5 到 0.7) —— AI 是你的前端专家

后端就绪,现在需要一个用户友好的界面。即使你对 React不熟悉,GLM-4.6 也能帮你快速搭建起来。

🎯 目标: 创建一个笔记列表页面,可以展示所有笔记,并有一个“新建笔记”的按钮。

✍️ 提示词示范:

“你是 React 和 Tailwind CSS 专家。请为‘智识火花’项目生成一个 React 组件:

组件名为 NoteList.tsx。

它需要在页面加载时,从 GET /api/notes 接口获取所有笔记数据。

使用 Tailwind CSS 设计一个简洁的卡片式布局来展示笔记列表,每张卡片显示标题和创建日期。

包含一个‘新建笔记’按钮。

处理加载状态和错误状态。”

💡 GLM-4.6 的突破:

GLM-4.6 能够理解 UI 框架和样式库的组合,生成符合现代设计风格的、功能性的组件代码,极大地降低了前端的入门门槛。

🖼️ 预期输出(代码块):

import { useState, useEffect } from 'react';

import axios from 'axios';

interface Note {

id: number;

title: string;

content: string;

created_at: string;

}

const NoteList = () => {

const [notes, setNotes] = useState<Note[]>([]);

const [loading, setLoading] = useState(true);

const [error, setError] = useState<string | null>(null);

useEffect(() => {

const fetchNotes = async () => {

try {

const response = await axios.get<Note[]>('/api/notes');

setNotes(response.data);

} catch (err) {

setError('Failed to fetch notes');

} finally {

setLoading(false);

}

};

fetchNotes();

}, []);

if (loading) return <div className="text-center p-4">Loading...</div>;

if (error) return <div className="text-center p-4 text-red-500">{error}</div>;

return (

<div className="container mx-auto p-4">

<div className="flex justify-between items-center mb-6">

<h1 className="text-3xl font-bold">智识火花</h1>

<button className="bg-blue-500 hover:bg-blue-700 text-white font-bold py-2 px-4 rounded">

新建笔记

</button>

</div>

<div className="grid grid-cols-1 md:grid-cols-2 lg:grid-cols-3 gap-4">

{notes.map(note => (

<div key={note.id} className="bg-white rounded-lg shadow-md p-6 hover:shadow-lg transition-shadow">

<h2 className="text-xl font-semibold mb-2">{note.title}</h2>

<p className="text-gray-500 text-sm">{new Date(note.created_at).toLocaleDateString()}</p>

</div>

))}

</div>

</div>

);

};

export default NoteList;

👉1-5、第五步:AI 魔法集成 (从 0.7 到 0.9) —— AI 指导 AI,实现核心突破

这是“智识火花”的灵魂所在——智能问答。我们将实现一个 RAG (Retrieval-Augmented Generation) 系统。GLM-4.6 在这里不仅扮演编码者,更是技术方案的指导者。

🎯 目标: 实现一个 API,接收用户问题,检索相关笔记,并生成回答。

✍️ 提示词示范:

“你是 AI 应用开发专家。我需要为‘智识火花’实现一个 AI 问答功能,基于 RAG 技术。

请用 Python 写一个函数 ask_question(question: str)。

该函数的流程是: a. 使用 sentence-transformers 模型将 question 转换为向量。 b. 在 ChromaDB 中搜索与问题向量最相似的 Top 3 笔记片段。 c. 将原始问题和检索到的笔记片段组合成一个 Prompt。 d. 调用 zhipuai (智谱AI) 的 SDK,将 Prompt 发送给 GLM-4.6 模型。 e. 返回 GLM-4.6 生成的答案。

请为关键步骤添加注释,并给出一个完整的 Prompt 示例。”

💡 GLM-4.6 的突破性价值:

GLM-4.6 能够指导你构建复杂的 AI 系统,它“知道”如何使用其他 AI 工具(如 Embedding 模型、向量数据库)和自己(GLM-4.6)协同工作。这是一种**“元编程”**能力,让开发者能够站在巨人的肩膀上,快速实现过去需要深厚 AI 背景才能做到的功能。

🖼️ 预期输出(代码块):

from sentence_transformers import SentenceTransformer

import chromadb

from zhipuai import ZhipuAI

# 初始化模型和客户端

embedding_model = SentenceTransformer('all-MiniLM-L6-v2')

chroma_client = chromadb.Client()

zhipu_client = ZhipuAI(api_key="YOUR_API_KEY")

# 假设已有一个名为 "notes_collection" 的集合

notes_collection = chroma_client.get_collection(name="notes_collection")

def ask_question(question: str):

# 1. 将问题转换为向量

query_embedding = embedding_model.encode(question).tolist()

# 2. 在向量数据库中搜索

results = notes_collection.query(

query_embeddings=[query_embedding],

n_results=3

)

# 3. 组合 Prompt

retrieved_context = "\n---\n".join(results['documents'][0])

prompt = f"""

你是一个知识助手,请根据以下用户提供的笔记内容来回答问题。

如果笔记内容不足以回答问题,请回答“根据现有笔记无法找到答案”。

=== 笔记内容 ===

{retrieved_context}

=== 笔记内容结束 ===

用户问题: {question}

"""

# 4. 调用 GLM-4.6

response = zhipu_client.chat.completions.create(

model="glm-4.6",

messages=[

{"role": "user", "content": prompt},

],

)

# 5. 返回答案

return response.choices[0].message.content

👉1-6、第六步:测试与部署 (从 0.9 到 1.0) —— AI 是你的 DevOps 工程师

项目开发完毕,如何保证质量并上线?GLM-4.6 同样能帮你搞定测试和部署脚本。

🎯 目标: 为后端 API 编写单元测试,并生成 Dockerfile 进行容器化部署。

✍️ 提示词示范:

“你是 DevOps 工程师。

请为 FastAPI 的 POST /api/notes 端点编写一个 pytest 测试用例,测试成功创建笔记和传入无效数据(如缺少 title)时的情况。

请为这个 Python FastAPI 项目生成一个 Dockerfile,使用多阶段构建来优化镜像大小。请在关键步骤添加注释。”

💡 GLM-4.6 的突破:

GLM-4.6 理解现代软件工程的最佳实践,包括单元测试框架和容器化技术。它能生成可直接运行、符合行业标准的配置文件,让“上线”这一步不再令人望而生畏。

🖼️ 预期输出(代码块):

FROM python:3.10-slim as builder

WORKDIR /app

# 复制依赖文件

COPY requirements.txt .

# 安装依赖

RUN pip install --no-cache-dir --user -r requirements.txt

# --- 阶段 2: 运行阶段 ---

FROM python:3.10-slim

WORKDIR /app

# 从构建阶段复制安装的依赖

COPY --from=builder /root/.local /root/.local

# 复制应用代码

COPY . .

# 将用户安装的包路径加入 PATH

ENV PATH=/root/.local/bin:$PATH

# 暴露端口

EXPOSE 8000

# 启动命令

CMD ["uvicorn", "main:app", "--host", "0.0.0.0", "--port", "8000"]

👉二、总结与展望:GLM-4.6 带来的三大突破

经过这六个步骤,我们成功地将一个想法变成了一个可运行的 AI 原生应用。回顾整个过程,GLM-4.6 带来的突破是根本性的:

角色突破:从“编码工”到“项目指挥家”

开发者不再需要逐行编写所有代码。我们的工作重心转移到了定义需求、设计架构、审查和整合 AI 生成的内容上。这是一种更高维度的创造,是“指挥家”而非“演奏员”。

能力突破:打破技术壁垒,实现全栈能力

无论你是前端还是后端,是产品经理还是测试工程师,GLM-4.6 都能帮你补齐短板。它让你有能力独自完成一个完整的项目,将想法变为现实,极大地降低了创新的门槛。

效率突破:从“线性开发”到“指数级创造”

过去需要数周甚至数月完成的工作,现在可能在几天内就完成雏形。更重要的是,AI 让我们敢于去尝试过去因复杂性而放弃的“AI 功能”本身。这种“加速创新”的能力,是 GLM-4.6 最具颠覆性的价值。

👉壁纸分享

👉总结

与 GLM-4.6 一同从 0 到 1 完成“智识火花”项目,我们看到的不仅仅是自动化编码,而是一种全新的、人机协作的创造范式。未来,最强大的开发者,将是最擅长与 AI 协作的开发者。

现在,轮到你了。拿起你的“AI 全栈伙伴”,去实现那个你心中酝酿已久的想法吧。整个世界,都在等待你的下一个“智识火花”。

本次总结的就是实现, 有需要会继续增加功能

如能帮助到你,就帮忙点个赞吧,三连更好哦,谢谢

你的点赞就是对博主的支持,有问题记得留言评论哦!

不定时更新开发技巧,觉得有用记得一键三连哦。么么哒!

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)