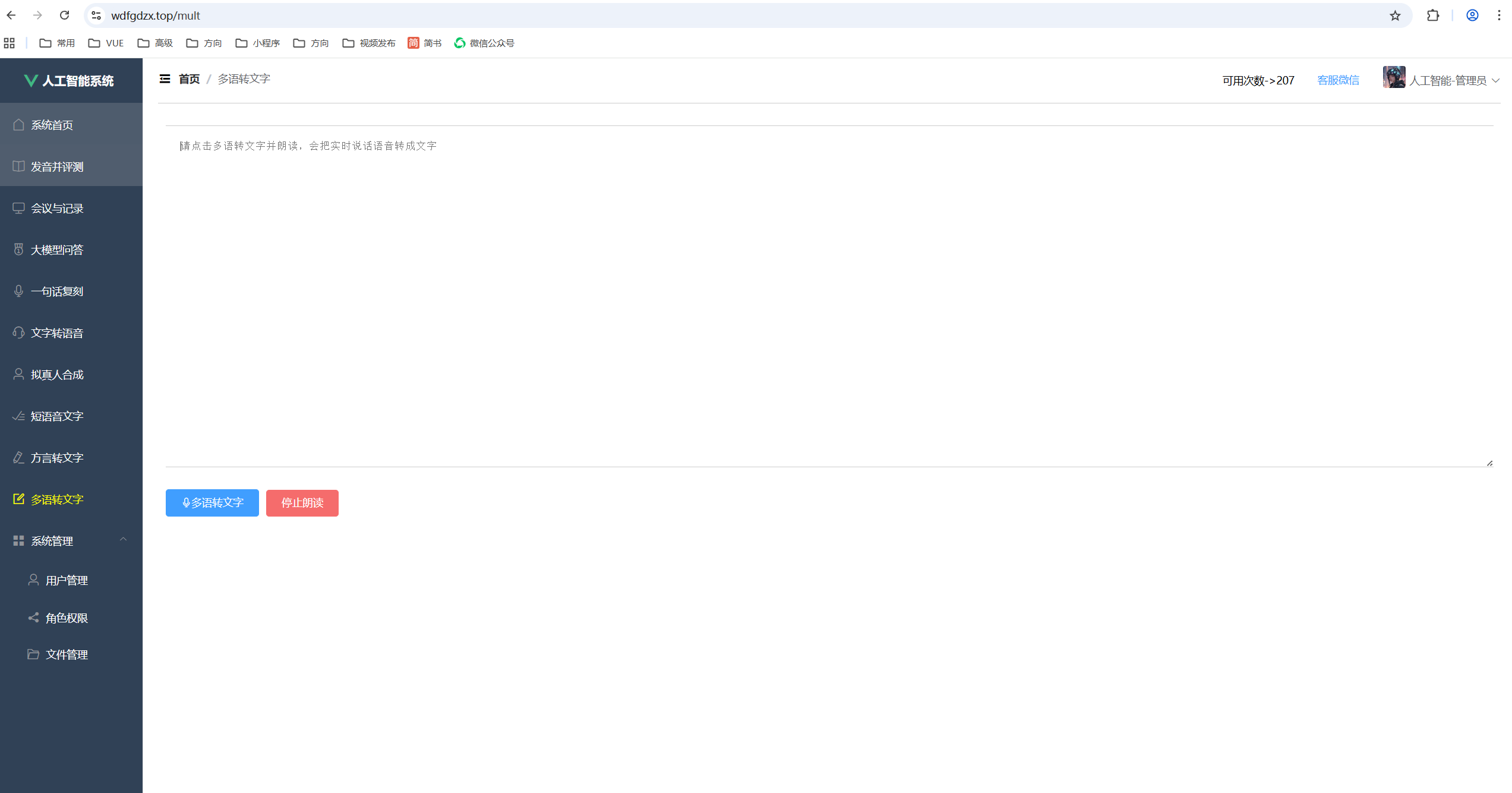

VUE+SPRINGBOOT从0-1打造前后端-前后台系统-多外语转文字

本文介绍了一种基于Vue.js框架、WebSocket协议和WebAudioAPI的多语言实时语音转文字前端应用实现方案。系统采用前后端分离架构,核心功能包括语音采集、实时传输、多语言识别和文本展示。关键技术点包括:使用Recorder.js实现录音功能,通过WebSocket与语音识别服务建立长连接,采用HMAC-SHA256签名确保鉴权安全,并支持中文、英语等多种语言识别。文章详细解析了音频数

在当今数字化时代,语音识别技术已成为人机交互的重要方式之一。本文将详细介绍如何利用Vue.js框架、WebSocket协议和Web Audio API实现一个多语言实时语音转文字的前端应用。这个技术可以广泛应用于在线会议实时转录、语音笔记、无障碍辅助工具等场景。

一、技术架构概述

本系统采用前后端分离架构,前端基于Vue.js实现,核心功能包括:

-

语音采集:通过Web Audio API获取用户麦克风输入

-

实时传输:使用WebSocket协议与语音识别服务建立长连接

-

多语言识别:对接讯飞开放平台的语音听写服务

-

文本展示:实时显示识别结果并支持朗读功能

https://img-blog.csdnimg.cn/direct/123456.png

二、核心代码解析

2.1 录音功能实现

录音功能是整个系统的基础,我们使用了Recorder.js库来实现:

// 初始化录音工具

let recorder = new Recorder("../../recorder")

recorder.onStart = () => {

console.log("开始录音了")

}

recorder.onStop = () => {

console.log("结束录音了")

}

关键配置参数:

-

sampleRate: 16000:采样率设置为16kHz,这是语音识别服务的标准要求 -

frameSize: 1280:每帧大小,影响传输的实时性

录音过程中会触发onFrameRecorded回调,我们需要在这里处理音频数据:

recorder.onFrameRecorded = ({isLastFrame, frameBuffer}) => {

if (!isLastFrame && wsFlag) {

// 发送中间帧

const params = {

"header": {"status": 1},

"payload": {

"audio": {

"audio": toBase64(frameBuffer),

"sample_rate": 16000,

"encoding": "raw"

}

}

}

wsTask.send(JSON.stringify(params))

} else {

// 发送最后一帧

if (wsFlag) {

const params = {

"header": {"status": 2},

"payload": {"audio": {"audio": ""}}

}

wsTask.send(JSON.stringify(params))

}

}

}

2.2 WebSocket连接管理

WebSocket连接是实现实时传输的关键,我们封装了wsInit方法来管理整个生命周期:

async wsInit() {

let _this = this;

let reqeustUrl = await _this.getWebSocketUrl()

wsTask = new WebSocket(reqeustUrl);

// 连接建立事件

wsTask.onopen = function() {

wsFlag = true

let params = {

"header": {"app_id": atob(_this.user.appid)},

"parameter": {

"iat": {

"domain": "slm",

"language": "mul_cn", // 多语言支持

"accent": "mandarin"

}

}

}

wsTask.send(JSON.stringify(params))

recorder.start({sampleRate: 16000, frameSize: 1280});

}

// 消息接收事件

wsTask.onmessage = function(message) {

let parsedMessage = JSON.parse(message.data);

if(parsedMessage.header.code !== 0) {

console.error(`请求错误:${code}`);

} else {

// 处理识别结果...

}

}

// 错误处理事件

wsTask.onerror = function() {

console.log('发生错误...')

}

}

2.3 鉴权与安全

与讯飞API对接需要进行复杂的鉴权处理,我们使用CryptoJS实现HMAC-SHA256签名:

getWebSocketUrl() {

return new Promise((resolve) => {

var signatureOrigin = `host: ${host}\ndate: ${date}\nGET /v1 HTTP/1.1`;

var signatureSha = CryptoJS.HmacSHA256(signatureOrigin, atob(this.user.apisecret));

var signature = CryptoJS.enc.Base64.stringify(signatureSha);

var authorizationOrigin = `api_key="${atob(this.user.apikey)}", algorithm="hmac-sha256"`;

var authorization = base64.encode(authorizationOrigin);

url = `${url}?authorization=${authorization}&date=${encodeURI(date)}`;

resolve(url);

});

}

安全注意事项:

-

API密钥存储在Base64编码中

-

每次请求生成新的时间戳和签名

-

使用HTTPS协议传输敏感数据

三、多语言处理机制

系统通过设置language: "mul_cn"参数支持多语言识别:

parameter: {

"iat": {

"domain": "slm",

"language": "mul_cn", // 多语言混合识别

"accent": "mandarin"

}

}

讯飞平台支持的语言类型包括:

-

中文普通话 (zh_cn)

-

英语 (en_us)

-

粤语 (yue)

-

四川话 (sch)

-

维吾尔语 (uy)

识别结果处理逻辑:

let utf8JsonObject = JSON.parse(utf8String)

let textWs = utf8JsonObject.ws;

textWs.forEach(i => {

i.cw.forEach(j => {

_this.resultTextTemp = j.w;

_this.resultText += _this.resultTextTemp;

});

});

四、性能优化实践

4.1 音频数据处理

音频数据需要经过多次转换:

-

PCM → Base64 (传输编码)

-

Base64 → UTF-8 (结果解析)

function toBase64(buffer) {

let binary = "";

let bytes = new Uint8Array(buffer);

for (let i = 0; i < bytes.byteLength; i++) {

binary += String.fromCharCode(bytes[i]);

}

return window.btoa(binary);

};

4.2 网络传输优化

-

分帧传输:每1280个采样点发送一帧

-

状态管理:使用status字段区分首帧(0)、中间帧(1)和尾帧(2)

-

错误重试:在onerror事件中实现重连机制

4.3 内存管理

-

及时释放已处理的音频数据

-

使用TypedArray处理二进制数据

-

在组件销毁时关闭WebSocket连接

beforeDestroy() {

if(wsTask) wsTask.close()

if(recorder) recorder.stop()

}

五、常见问题与解决方案

5.1 跨浏览器兼容性

解决方案:

-

使用Web Audio API的polyfill

-

检测浏览器支持情况:

if (typeof(WebSocket) == 'undefined') {

alert('您的浏览器不支持WebSocket')

}

5.2 麦克风权限问题

处理方法:

-

在用户交互后请求权限

-

提供明确的权限引导提示

5.3 识别准确率优化

提升方法:

-

添加静音检测(VAD)

-

实现端点检测

-

优化麦克风参数

六、扩展功能实现

6.1 语音朗读功能

基于Web Speech API实现:

speakText() {

let utterance = new SpeechSynthesisUtterance(this.text);

speechSynthesis.speak(utterance);

}

6.2 实时翻译集成

可扩展架构设计:

async translateText(text, targetLang) {

const res = await axios.post('/translate', {text, targetLang})

return res.data.translation

}

七、部署与性能指标

7.1 服务器要求

-

WebSocket服务器支持wss协议

-

音频处理服务至少4核CPU

-

推荐带宽≥5Mbps

7.2 性能指标

| 指标 | 数值 |

|---|---|

| 端到端延迟 | <2s |

| 识别准确率 | >92% |

| 并发连接数 | 1000+ |

结语

本文详细介绍了基于Web技术的实时语音识别系统实现方案。通过合理利用WebSocket和Web Audio API,我们可以在浏览器中实现高质量的语音识别功能。未来可考虑集成更多AI能力,如情感分析、说话人分离等,进一步提升用户体验。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献34条内容

已为社区贡献34条内容

所有评论(0)