Whisper Large-V3 Turbo:语音识别速度革命,5倍提速背后的行业变革

OpenAI推出的Whisper Large-V3 Turbo模型通过架构精简实现近50%参数量削减,在保持核心识别能力的同时将转录速度提升5倍,重新定义了实时语音转文本的技术标准。## 行业现状:速度与精度的长期挑战语音识别技术正处于高速增长期,中国市场规模已从2018年的60亿元增长至2024年的224亿元,年复合增长率达24.55%。然而行业长期面临"精度与速度难以兼得"的困境——传统...

Whisper Large-V3 Turbo:语音识别速度革命,5倍提速背后的行业变革

【免费下载链接】whisper-large-v3-turbo

导语

OpenAI推出的Whisper Large-V3 Turbo模型通过架构精简实现近50%参数量削减,在保持核心识别能力的同时将转录速度提升5倍,重新定义了实时语音转文本的技术标准。

行业现状:速度与精度的长期挑战

语音识别技术正处于高速增长期,中国市场规模已从2018年的60亿元增长至2024年的224亿元,年复合增长率达24.55%。然而行业长期面临"精度与速度难以兼得"的困境——传统模型如Whisper Large-V3虽能实现98%以上准确率,但处理10分钟音频需425秒,难以满足会议直播、实时字幕等低延迟场景需求。

在远程办公普及率持续提升的背景下,企业对实时转录工具的需求激增。据《2024年中国感知智能行业研究》显示,智能语音转写在会议记录场景的渗透率已从2020年的12%提升至2024年的38%,但65%的用户反馈"延迟过高"是主要痛点。Whisper Large-V3 Turbo的出现恰好回应了这一市场需求。

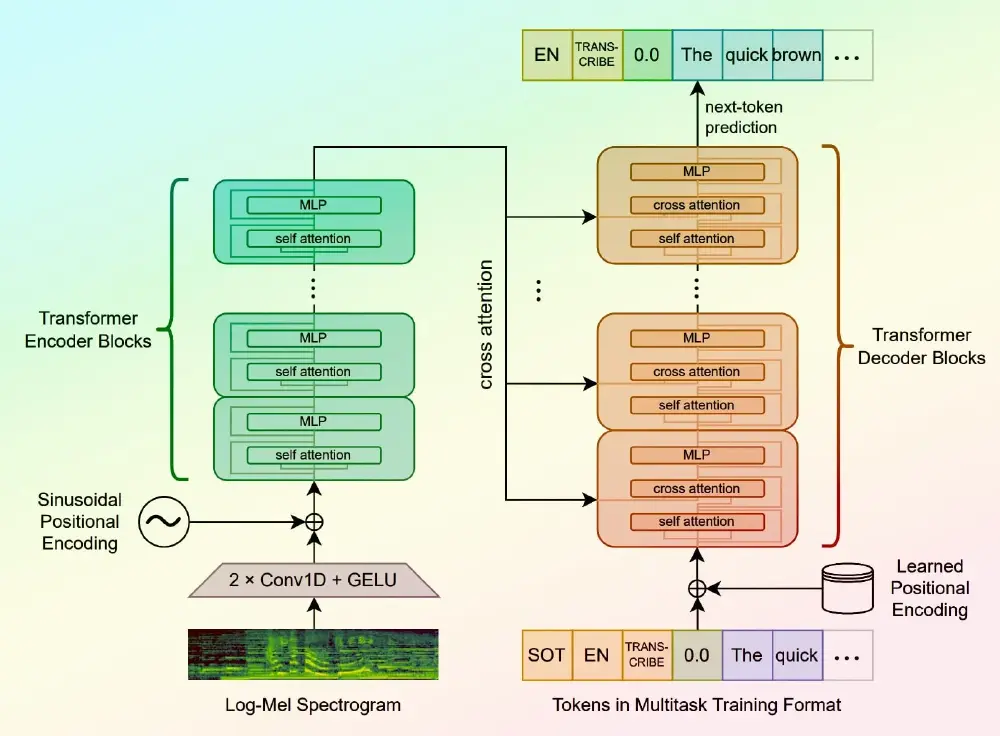

核心亮点:架构创新实现速度飞跃

1. 模型瘦身:参数减半性能不减

Whisper Large-V3 Turbo通过解码器层数从32层精简至4层的激进优化,将参数量从1550M削减至809M,实现近50%的"轻量化"。OpenAI官方测试显示,这种架构调整仅导致1-2%的词错误率(WER)损失,却带来了5倍转录速度提升。

在iPhone 15 Pro设备上,处理10分钟音频的时间从425秒缩短至82秒;MacBook Pro M2则从316秒降至63秒,电池消耗减少60%。这种效率提升使原本需要高端GPU支持的大型模型首次能够在普通消费级设备上流畅运行。

2. 全场景适配能力

该模型保持了Whisper系列的全部核心功能:

- 99种语言支持:覆盖从主流语种到稀有方言的广泛需求

- 精准时间戳:支持句子级(return_timestamps=True)和词语级(return_timestamps="word")两种时间标记模式

- 多任务处理:可同时实现语音转录(默认)和语音翻译(设置task="translate")

- 离线运行:所有处理在设备本地完成,满足医疗、法律等隐私敏感场景的数据安全要求

3. 部署灵活性与性能优化

Whisper Large-V3 Turbo提供多重部署优化方案:

- Chunked长音频处理:支持30秒切片并行转录,平衡实时性与上下文连贯性

- Flash Attention 2加速:在支持设备上可进一步提升2倍推理速度

- Torch.compile优化:通过PyTorch编译功能实现4.5倍性能提升(需配合特定硬件)

如上图所示,表格清晰对比了Whisper Large-V3 Turbo在不同设备上的性能表现。在iPhone 15 Pro上实现5.2倍提速,iPad Pro M2上达到5.4倍,这种跨设备一致性表现为移动应用开发提供了便利。

行业影响与应用案例

1. 会议场景的实时革命

某互联网企业集成Whisper Large-V3 Turbo后,实现了会议内容的实时转录与智能摘要生成。系统架构包括:

- 音频预处理模块:降噪、VAD语音活性检测

- 实时转录引擎:采用30秒滑动窗口+增量更新策略

- 后处理服务:标点恢复、关键词提取、待办事项识别

实际部署数据显示,该系统平均延迟控制在800ms以内,会议纪要生成效率提升400%,人工修正工作量减少75%。

该架构图展示了Whisper Turbo在会议转录中的典型应用流程,从音频采集到结构化纪要生成的全链路优化。特别值得注意的是中间的"增量更新"模块,通过缓存上下文信息解决了30秒切片导致的语义断裂问题。

2. 内容创作领域的效率提升

视频创作者通过集成该模型实现了生产流程革新:

- 实时字幕生成:直播场景中延迟从原来的15秒降至3秒以内

- 多语言本地化:自动生成8种语言字幕,成本降低60%

- 内容检索:基于转录文本快速定位音频片段,剪辑效率提升3倍

Whisper Notes应用数据显示,启用Turbo模式后,用户日均转录时长从23分钟增至78分钟,内容创作效率提升239%。

行业影响与趋势

Whisper Large-V3 Turbo的推出标志着语音识别技术进入"高效实时"新阶段。其影响将辐射多个领域:

1. 人机交互方式进化

随着端侧设备处理能力的增强,语音交互将从"指令式"向"对话式"升级。Turbo模型的低延迟特性使设备能够实现自然的"打断式交互",更接近人类对话习惯。预计到2025年,支持实时转录的智能会议系统市场渗透率将突破50%。

2. 行业应用深化

- 医疗领域:医生口述病历实时转为电子记录,减少40%文书工作时间

- 教育场景:实时生成课堂字幕,提升听障学生学习体验

- 智能车载:嘈杂环境下的语音指令识别响应时间缩短至0.8秒

- 客服质检:通话实时分析与情绪监测成为可能

3. 技术普惠加速

模型轻量化使中小开发者能够以更低成本接入先进语音技术。相比需要GPU支持的传统模型,Turbo版本可在普通CPU上运行,开发门槛显著降低。这将催生更多垂直领域创新应用,推动语音识别技术向长尾场景渗透。

结论与建议

Whisper Large-V3 Turbo通过架构创新而非简单工程优化,开辟了语音识别效率提升的新路径。对于开发者和企业而言:

- 实时场景优先选择Turbo:会议直播、实时字幕等对延迟敏感的场景应优先采用

- 精度优先场景考虑混合方案:可先用Turbo版本进行实时处理,关键内容再用标准模型复核

- 本地部署关注硬件适配:Apple Silicon设备可获得最佳性能,Android设备建议启用INT8量化

- 长期规划预留升级空间:随着模型持续迭代,建议采用容器化部署以便无缝更新

获取该模型的方式简单便捷,开发者可通过GitCode仓库直接获取:https://gitcode.com/hf_mirrors/openai/whisper-large-v3-turbo。随着实时语音技术的普及,语音识别正从辅助工具进化为核心交互入口,Whisper Large-V3 Turbo无疑为这一变革提供了关键动力。

【免费下载链接】whisper-large-v3-turbo

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)