大模型论文 | 中国团队研究证明AI已初具类人意识?!

人类认知科学已经研究了几十年,我们知道人类的大脑通过一些关键的“维度”(比如“动物 vs 非动物”、“有生命 vs 无生命”、“大的 vs 小的”)来组织和理解成千上万的物体。简单来说,作者想知道:如果我们把一个LLM或MLLM当作一个“数字被试”,让它完成和人类一样的认知任务,我们能否从它的行为中“反向工程”出一张它的“内心概念地图”,并看看这张地图和人类的以及人脑中的地图有多相似。这一步是技术

❝

一句话概括,本文用认知科学的“照妖镜”一照,发现大模型这“妖精”肚子里还真有几分像人的“道行”,而不是只会念经的空壳。(Published on Nature Machine Intelligence, by 中国科学院)

第一阶段:识别核心概念

论文的Motivation分析

随着ChatGPT、Gemini等大型语言模型(LLMs)和多模态大模型(MLLMs)的崛起,我们惊叹于它们强大的能力。但一个核心问题依然悬而未决:这些模型是真的“理解”世界,还是仅仅在模仿统计规律?它们内部对物体、对概念的“想法”和我们人类的思维方式到底有多像?

人类认知科学已经研究了几十年,我们知道人类的大脑通过一些关键的“维度”(比如“动物 vs 非动物”、“有生命 vs 无生命”、“大的 vs 小的”)来组织和理解成千上万的物体。这篇论文的动机就是想用认知科学的“探针”去探测AI的“心智”,看看AI是否也自发地学会了用类似的维度来组织世界。

简单来说,作者想知道:如果我们把一个LLM或MLLM当作一个“数字被试”,让它完成和人类一样的认知任务,我们能否从它的行为中“反向工程”出一张它的“内心概念地图”,并看看这张地图和人类的以及人脑中的地图有多相似。

论文主要贡献点分析

列出论文声称的主要创新点

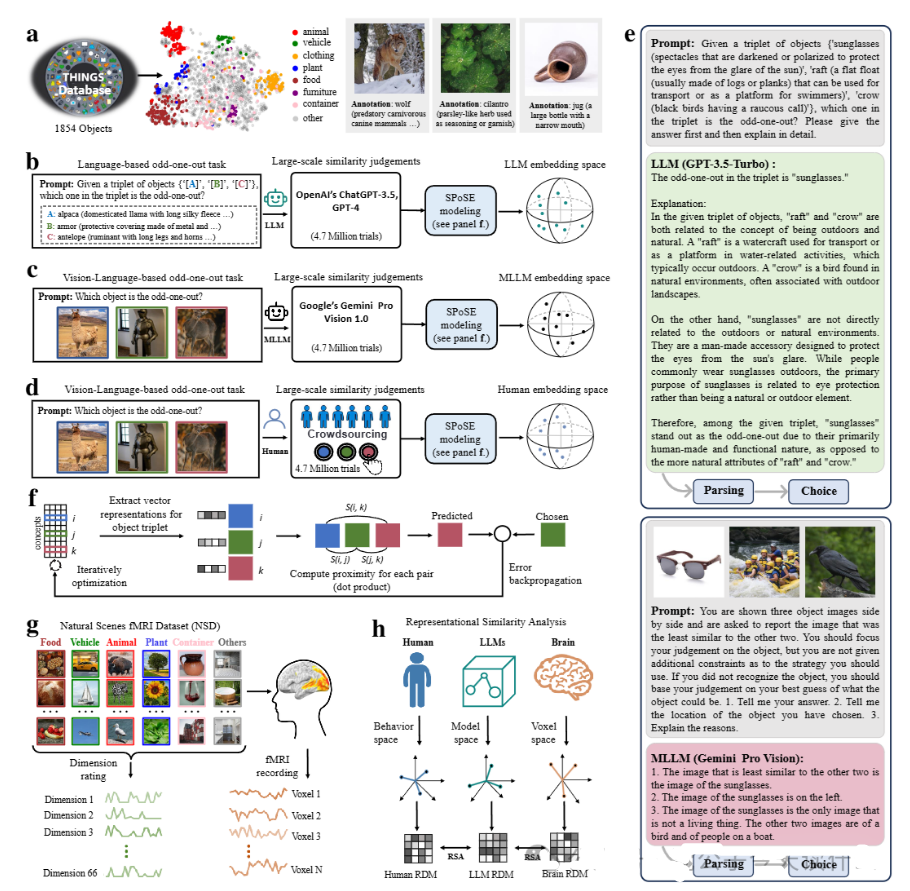

- 方法论创新:首次将经典的认知心理学任务(三元组“找不同”,triplet odd-one-out)与一种名为SPoSE(稀疏正向相似性嵌入)的学习方法相结合,系统性地探究了LLMs和MLLMs的内部概念结构。这相当于为我们提供了一套“撬开”AI黑箱的认知学工具。

- 涌现性的发现:论文证明了,这些AI模型在没有经过任何针对性训练的情况下,自然地涌现出了类似人类的、低维度的、可解释的物体概念表征。这意味着模型不仅仅是鹦鹉学舌,而是真的在内部形成了一套有组织的知识体系。

- 跨领域验证:论文的论证非常扎实,构建了一个从行为到神经的完整证据链。它不仅证明了模型的行为与人类相似,还进一步证明了模型学到的概念维度与人类的维度相似,最终还证明了这些模型的表征能够预测真实人脑的神经活动(fMRI数据)。

找出支撑这些创新的关键技术或方法

- 三元组“找不同”任务 (Triplet odd-one-out task):这是收集原始数据的核心手段。通过给模型(或人)三个物体,让其判断哪一个最不合群,研究者可以收集到大量关于物体间相对相似度的判断。

- SPoSE (Sparse Positive Similarity Embedding) 模型:这是论文的核心技术。它能够接收上一步收集到的数百万个“找不同”判断,然后通过优化算法,学习到一个低维度的“概念地图”(即嵌入向量)。这个地图的特点是“稀疏”和“正向”,这使得最终学到的维度非常容易被人类理解(例如,一个维度可能只代表“食物”,另一个只代表“动物”)。

论文有哪些显著性的结果

- 可解释的维度:模型学到的66个维度是可以被清晰命名的,例如“动物相关”、“食物相关”、“交通工具相关”等,这与人类理解世界的方式高度一致。

- 多模态更胜一筹:多模态大模型(MLLM,同时处理图像和文本)比纯语言模型(LLM)学到的表征与人类的更接近,并且与大脑活动的对齐程度也更高。这符合我们的直觉:同时“看”和“读”世界,能形成更完整的认知。

- 与大脑活动的强对应:模型的嵌入表征与人类大脑中特定功能区域(如处理场景的PPA、处理身体的EBA、处理面孔的FFA)的神经活动模式高度相关。这为“AI模型发展出类人表征”提供了强有力的神经科学证据。

理解难点识别

分析哪些概念/方法是理解论文的关键

- SPoSE (Sparse Positive Similarity Embedding) 模型:这是理解本文技术核心的关键。它不是一个标准的深度学习模型,而是一种用于从行为数据中推断潜在表征的认知建模方法。它的工作原理、数学公式以及“稀疏”和“正向”这两个约束为什么重要,是理解本文技术深度的关键。

- 表征相似性分析 (Representational Similarity Analysis, RSA):这是连接模型、人类行为和大脑活动的关键桥梁。理解RSA是如何通过比较“相似性矩阵”(RSMs)来衡量不同系统(AI、人、大脑)表征的相似性的,对于看懂论文的后半部分实验至关重要。

找出这些概念中最具挑战性的部分

SPoSE模型的工作原理。读者可能会困惑:它是如何仅凭“哪个不一样”这种简单的判断,就能学习出那么复杂且有意义的66个维度的?这背后的数学优化过程是什么?

确定需要重点解释的核心概念

SPoSE模型。我们将把它作为第二阶段的核心,深入解释它的原理和实现。

概念依赖关系

梳理核心概念之间的关系

要理解这篇论文,我们可以遵循这样的逻辑:

- 起点:我们想知道AI如何组织知识。

- 数据收集:我们通过三元组“找不同”任务来收集AI的行为数据。

- 核心建模:我们使用SPoSE模型来处理这些行为数据,从而构建出AI的“概念地图”(即低维嵌入)。

- 验证与比较:我们使用RSA等方法,将AI的这张地图与人类行为地图和大脑活动地图进行比较。

确定解释的最佳切入点

我们的最佳切入点就是SPoSE模型,它是从原始数据到最终结论的“引擎”。

第二阶段:深入解释核心概念

设计生活化比喻:“电影评论家的内心世界”

想象一下,有一位非常资深的电影评论家。我们想知道他脑子里到底是怎么给电影分类和评价的,但他从不直接告诉我们他的“评价标准”。我们能做的,就是不断地给他看三部电影,然后问他:“这三部里,哪一部最‘不合群’?”

- 比如,我们给他看《星球大战》、《指环王》和《教父》。他可能会说:“《教父》不合群,因为前两部都是史诗级奇幻/科幻片。”

- 如果我们给他看《教父》、《好家伙》和《泰坦尼克号》。他可能会说:“《泰坦尼克号》不合群,因为前两部都是顶级黑帮片。”

我们进行了数百万次这样的测试,收集了海量的“找不同”数据。现在我们的任务是,仅凭这些数据,反向推断出这位评论家心中到底有哪些隐藏的评价维度(比如:“奇幻史诗”、“黑帮犯罪”、“浪漫爱情”、“科幻巨制”、“视觉特效”等等)。

这个反向推断的过程,就是SPoSE模型在做的事情。

建立比喻与实际技术的对应关系

| 比喻中的元素 | 实际技术概念 | 解释 |

|---|---|---|

| 电影评论家 | LLM/MLLM模型 (或人类被试) | 它们是做出判断的主体。 |

| 所有电影的片库 | THINGS数据库 (1854个物体) | 这是我们研究的所有对象的集合。 |

| 一次“找不同”的判断 | 一个三元组试验 (Triplet Trial) | 这是收集到的一个基本数据点。 |

| 评论家心中隐藏的评价标准 | 模型的高维、不可直接访问的内部表征 | 这是我们想探究的“黑箱”。 |

| 我们想发现的评价维度 (如“奇幻”、“黑帮”) | SPoSE模型学到的66个稀疏、正向维度 | 这是最终得到的可解释的“概念地图”。 |

| 反向推断评价维度的过程 | SPoSE模型的优化算法 | 这是从数据到结论的核心技术。 |

深入技术细节

SPoSE的核心思想是:假设一个物体的概念是由少数几个基本、正向的维度构成的。例如,“苹果”这个概念可能由“食物”、“水果”、“圆形”、“红色”等维度加权构成。它在“汽车”这个维度上的权重就是0。这种假设使得结果非常易于解释。

SPoSE通过一个优化过程来学习这个概念地图(一个物体×维度的矩阵 )。它的目标是让这个地图能够最好地预测评论家(模型)的每一个“找不同”选择。其核心的损失函数如下:

原始数学形式 (公式1)

符号替换版本 (解释版)

最小化总损失每一次找不同判断我们预测正确的概率稀疏性惩罚

其中:

- 我们预测正确的概率 =模型认为最相似那对的相似度第一对的相似度第二对的相似度第三对的相似度

- 一对物品的相似度 =

物品A在地图上的向量•物品B在地图上的向量(向量点积) - 稀疏性惩罚 =

一个控制强度的常数λ×地图上所有数值的绝对值之和(这被称为L1范数)

关键步骤解释

-

初始化:随机创建一个“概念地图” (一个1854个物体 × 100个维度的矩阵),所有值都是小的正数。

-

预测:对于一个收集到的判断,比如模型认为在{i, j, k}中k是“不合群”的。我们就在我们当前的地图 上计算三对相似度:,,。

-

计算损失:我们用softmax函数把这三个相似度转换成概率,看看我们的地图预测“k不合群”的概率有多大。如果预测对了,损失就小;预测错了,损失就大。

-

更新地图:使用梯度下降法,根据损失的大小微调地图 ,使得地图的预测结果更接近模型的真实选择。

-

施加约束:

-

- 稀疏性 (惩罚):在更新时,这个惩罚项会“鼓励”地图中的大部分数值变为0。这就像告诉算法:“请用最少的维度来解释一个物体!”

- 正向性:始终确保地图中的所有值都大于等于0。这意味着一个维度要么存在(值),要么不存在(值=0),没有“负相关”这种模糊的概念。

-

重复:对数百万个判断重复这个过程,最终得到的地图 就稳定地反映了模型内部的概念结构。

将技术细节与比喻相互映射

解释每个技术步骤在比喻中的体现

- 更新地图的过程,就像我们不断修正对评论家内心标准的猜测。每当我们的猜测(地图的预测)与他的实际选择不符,我们就调整我们的猜测,让它更接近真相。

- 稀疏性惩罚,就像我们假设这位评论家不是一个混乱的人,他的评价体系是简洁的、有条理的。他评价一部电影,主要是看它属于哪几个关键的类型(维度),而不是同时考虑上百个无关紧要的因素。这使得我们最终得到的“评价维度”是干净、可解释的,比如“黑帮片”,而不是一个“70%黑帮+20%科幻-10%爱情”的混合物。

- 正向性约束,意味着我们认为一个评价维度是“有或无”的。一部电影要么属于“黑帮片”(权重),要么不属于(权重=0)。它不会有一个“负的黑帮片”属性。这让每个维度的意义都非常清晰。

指出比喻的局限性

电影评论家可能会疲劳,或者标准会随时间变化。而LLM在实验期间是稳定不变的。这个比喻主要是为了帮助理解“从行为反推内部准则”这个核心逻辑。

总结

重申比喻与实际技术的核心联系

SPoSE模型就像一个聪明的侦探,通过观察一个“嫌疑人”(LLM)成千上万次简单的选择,最终绘制出他内心的“动机地图”。

强调这种对应关系如何帮助理解整个概念

这个过程的关键在于,它假设这个动机地图是简洁的(稀疏性)和清晰的(正向性),从而使得最终绘制出的地图不仅准确,而且能被我们人类读懂。

用比喻来总结最关键的数学原理

这正是这篇论文能够声称其发现的维度是“可解释的”和“类人的”的底气所在。

第三阶段:详细说明流程步骤

现在我们来详细描述一下论文提出的完整方案,从输入数据到最终结论的每一步。这可以帮助读者理解整个研究是如何环环相扣、层层递进的。

目标:探究LLM/MLLM的物体概念表征,并与人类进行比较。

1. 准备“原材料”

- 物体库 (Stimuli)**:研究始于一个名为**THINGS的数据库。这个数据库包含了1,854个日常生活中常见的物体概念(如“狗”、“椅子”、“飞机”)。每个物体都配有高质量的图像和详细的文本描述(例如,“狗:一种被驯化的食肉哺乳动物,通常作为宠物或工作犬”)。这是整个研究的“宇宙”,所有比较和判断都在这个物体集合中进行。

2. 收集“行为数据” (进行“找不同”实验)

这一步的目标是收集不同主体(人类、LLM、MLLM)在面对相同任务时的行为反应。

-

生成任务:从1,854个物体中,随机抽取三个物体,形成一个“三元组”。例如:{狗, 猫, 汽车}。

-

执行任务与数据采集:

-

- 对于人类 (Human):这部分数据来自之前的研究。实验人员向大量在线参与者(通过亚马逊MTurk招募)展示三张物体图像,并询问“哪一张与其他两张最不相似?”。最终收集了约470万次有效的人类判断数据。

- 对于纯语言模型 (LLM, 如ChatGPT-3.5)**:由于LLM无法处理图像,研究人员将三元组中每个物体的**文本描述输入给模型。提示语大致是:“给出三个物体{‘狗的描述’, ‘猫的描述’, ‘汽车的描述’},请判断哪一个是‘不合群’的那个,并解释原因。” 模型会输出它的选择(如“汽车”)和理由。研究人员同样收集了470万次判断,以确保与人类数据的规模匹配。

- 对于多模态大模型 (MLLM, 如Gemini Pro Vision):研究人员直接将三个物体的 图像输入给MLLM。提示语大致是:“这里有三张图,请告诉我哪一张与其他两张最不相似,并解释为什么。” MLLM直接基于视觉信息做出判断。

输出:经过这一步,我们得到了三个大规模的行为数据集,分别记录了人类、LLM和MLLM在数百万次“找不同”任务中的选择。

3. 核心建模:使用SPoSE构建“概念地图”

这一步是技术核心,目标是将上一步收集到的离散的、海量的“找不同”判断,转化为一个连续的、低维的、可解释的“概念地图”。

-

输入:上一步收集到的“找不同”数据集。例如,一条数据是

(输入:{狗, 猫, 汽车}, 输出:汽车)。 -

模型初始化:创建一个

1854 × 100的矩阵 ,我们称之为“初始概念地图”。每一行代表一个物体,每一列代表一个潜在的抽象维度。矩阵中的值被随机初始化为小的正数。 -

优化过程:

-

- 计算三对物体间的相似度:

相似度(狗,猫),相似度(狗,汽车),相似度(猫,汽车)。这里的相似度是通过向量点积计算的。 - 通过Softmax函数,将这三个相似度转化为一个概率分布,表示模型预测“狗”、“猫”、“汽车”各自“不合群”的概率。

- 计算三对物体间的相似度:

-

- 将包含470万条判断的数据集分批(batch)送入SPoSE模型。

- 对于每一条判断,例如{狗, 猫, 汽车} -> 汽车,模型会根据当前的“概念地图” 计算出它自己的预测。计算方式是:

- 计算损失:将模型的预测概率与真实的判断(“汽车”是不合群的)进行比较,计算交叉熵损失。如果模型预测正确,损失小;反之,损失大。

- 更新地图:利用梯度下降算法,根据损失来微调整个地图矩阵 。同时,正则化项会确保更新后的地图尽可能稀疏,非负性约束则确保其正向。

-

后处理:优化完成后,得到一个

1854 × 100的稳定“概念地图”。研究人员对其进行排序和筛选,剔除冗余和不重要的维度,最终保留了66个核心维度。

输出:三个1854 × 66的嵌入矩阵,分别代表了人类、LLM和MLLM的最终“概念地图”。每一行是一个物体的66维向量表示。

4. 验证与分析:比较三张“地图”

现在我们有了三张精炼的“概念地图”,最后一步就是全方位地比较它们。

-

可解释性分析 (定性分析):

-

- 对于模型(LLM/MLLM)学到的66个维度中的每一个,找出在该维度上权重最高的物体。

- 例如,发现维度#3上权重最高的物体总是各种食物。于是,研究人员将这个维度命名为“食物相关”。

- 通过这种方式,他们发现这66个维度都对应着人类可以理解的、有意义的概念,从而证明了其可解释性。

-

行为与维度对齐分析 (定量分析):

-

- 行为对齐:在一些测试集上,比较由SPoSE地图预测出的“找不同”结果与真实的“找不同”结果,看准确率有多高。

- 维度对齐:计算人类地图的66个维度与模型地图的66个维度之间的相关性矩阵。结果发现,许多维度可以一一对应,例如人类的“动物”维度与模型的“动物”维度高度相关。

-

神经对齐分析 (与大脑的连接):

-

- 对于NSD中的每一对图像,利用我们训练好的SPoSE“概念地图”计算出它们在模型眼中的相似度。这样就构建了一个模型的RSM。

- 对于NSD中的每一对图像,比较它们引发的大脑活动模式的相似度。这样就构建了一个大脑的RSM。

-

- 引入新数据:使用一个大型的fMRI数据集NSD,其中包含了被试在观看数千张图像时的大脑活动数据。

- 构建模型和大脑的“相似性快照” (RSMs):

- 比较快照:使用表征相似性分析(RSA),计算模型的RSM和大脑的RSM之间的相关性。

- 结果:发现二者高度相关,尤其是在大脑的视觉高级皮层。这表明模型学到的概念结构与大脑组织视觉信息的方式存在深刻的相似性。

通过这四步,论文构建了一个从行为收集、到核心建模、再到多维度验证的完整闭环,有力地支持了其核心论点。

第四阶段:实验设计与验证分析

主实验设计解读:核心论点的验证

-

核心主张:LLMs/MLLMs能够自然涌现出类人的、可解释的、且与神经活动相关的物体概念表征。

-

实验设计:整个研究流程(第三阶段描述的)就是其主实验设计。它不是单一的实验,而是一个组合实验,分为三个核心部分来支撑主张:

-

- 行为层面:比较LLM/MLLM和人类在“找不同”任务上的行为一致性。

- 表征层面:比较通过SPoSE方法从各主体行为中提取出的低维概念维度的一致性。

- 神经层面:验证模型表征是否能预测人类大脑在观看物体时的神经活动。

-

选择的合理性分析:

-

- 人类 (Human):这是最重要的“基线”,也是本文追求的“黄金标准”。

- 纯语言模型 (LLM: ChatGPT-3.5) vs. 多模态大模型 (MLLM: Gemini Pro Vision):这是核心对比,用于验证多模态信息的重要性。

- 其他视觉模型 (如VGG, SimCLR, CLIP):在分类性能(图3b)和与人类行为一致性(图5a)的比较中,作者引入了这些经典的监督学习、自监督学习和图文对学习模型。这使得对比更加全面,突显了大型(多模态)语言模型的优越性。

-

- 预测准确率 (Odd-one-out accuracy):直接衡量模型在任务上的表现。

- 皮尔逊相关系数 (Pearson’s r):用于比较表征相似矩阵(RSMs)和不同维度之间的相关性,是RSA和维度比较的标准做法。

- 决定系数 (带噪声天花板矫正):在神经编码任务中,这是衡量模型预测神经活动方差解释比例的标准指标,考虑到了fMRI数据固有的噪声,使得评估更加公平。

-

- THINGS数据库:选择非常合理。这是一个为研究大规模物体表征而专门创建的基准数据集,包含了1854个物体概念和超过26000张自然图像,具有极高的多样性和代表性。

- Natural Scenes Dataset (NSD):同样是黄金标准。这是目前最大、最详尽的7T fMRI数据集,专门用于连接认知神经科学与人工智能,是验证模型与大脑对齐性的不二之选。

-

- 数据集:

- 评价指标:

- 基线方法 (Baselines):

-

主实验结论:实验结果有力地支撑了核心主张。图5a显示,LLM和MLLM与人类行为的相似度(0.5-0.6)远高于其他传统模型(0.3-0.4)。图6显示,MLLM的表征与大脑活动的对齐度在多个脑区都达到了人类自身表征的85%以上,这是非常惊人的结果。

消融实验分析:内部组件的贡献

-

消融模块1:维度的数量

-

- 目的:验证学到的表征是否真的是“低维”的,并确定需要多少维度是足够的。

- 设计:在图2a中,作者展示了随着保留的SPoSE维度数量从1增加到100,模型对行为数据的预测性能如何变化。

- 结论:性能曲线在约60个维度时趋于饱和。这证明了概念表征确实可以用一个相对较低的维度空间来有效描述,也证明了作者选择66个维度是合理的,而非越多越好。

-

消融模块2:SPoSE方法本身

-

- 目的:验证SPoSE学到的低维嵌入是否有效地保留了原始模型中的核心信息。

- 设计:在图2i中,作者对比了两种情况下的预测准确率:1) 使用开源模型(如CLIP)的原始高维特征进行预测;2) 使用通过SPoSE从这些模型的行为中学习到的低维嵌入进行预测。

- 结论:SPoSE嵌入的预测准确率达到了原始特征的90%左右。这定量地证明了SPoSE是一种高效且保真的信息压缩和表征提取方法,其本身是可靠的。

-

消融模块3:输入模态 (语言 vs. 视觉)

-

- 目的:验证视觉输入对于形成类人表征的重要性。

- 设计:贯穿全文的核心对比就是LLM(纯文本)vs. MLLM(图文)。

- 结论:在几乎所有指标上(与人类行为/维度/神经的对齐度),MLLM都显著优于LLM。这强有力地证明了,结合视觉信息的学习对于形成更完整、更类人的世界概念模型至关重要。

深度/创新性实验剖析:洞察方法的内在特性

-

巧妙实验1:维度的可视化与命名 (图4及扩展数据)

-

- 实验目的:直观地展示学到的维度是“可解释的”,而不仅仅是抽象的数学向量。

- 实验设计:对于学到的66个维度中的每一个,找出在该维度上权重最高的6个物体,并将它们的图像并列展示。然后让人类专家(和MLLM)来为这组图像起一个共同的名字。

- 实验结论:这些维度可以被清晰地命名为“动物相关”、“食物相关”、“车辆相关”等。这种可视化证据比单纯的数字更有说服力,它为“AI发展出类人概念”这一抽象论点提供了具体、直观的支撑,是本研究的一大亮点。

-

巧妙实验2:跨系统维度相关性矩阵 (图5d)

-

- 实验目的:不仅仅满足于得出一个“模型和人类表征相似”的笼统结论,而是要深入探究二者在结构上的具体异同。

- 实验设计:计算人类66个维度和模型66个维度两两之间的相关性,并将其可视化为一个热力图。

- 实验结论:这个矩阵揭示了深刻的洞见。例如,它显示了某些人类维度在模型中被细分(如人类的“流体”维度在MLLM中被分为“容器”和“液体”两个维度),而某些维度被合并。这揭示了模型与人类在概念组织粒度上的细微差别,提供了远超单一相关性数值的信息。

-

巧妙实验3:脑活动图谱的精细映射 (图6c, 6d)

-

- 实验目的:将模型与大脑的对齐性从一个单一的数字提升到一个空间分布图,从而与已知的神经科学知识进行关联。

- 实验设计:采用Searchlight RSA和Voxel-wise Encoding两种方法,逐个区域、甚至逐个体素地计算模型表征与大脑活动的对齐度,并将结果绘制在摊平的大脑皮层上。

- 实验结论:对齐性最强的区域恰好是已知的处理特定物体类别的高级视觉脑区(如PPA处理场景,EBA处理身体)。这一发现极大地增强了结论的可信度,因为它将AI模型的计算结果与大脑的功能解剖结构联系了起来,是连接AI与神经科学的典范。

-

巧妙实验4:失败案例分析 (图5c)

-

- 实验目的:通过分析模型与人类判断不一致的案例,理解当前模型的局限性。

- 实验设计:挑选出典型的“分歧”三元组,并分析模型和人类做出不同选择时,分别依赖了哪些关键维度。

- 实验结论:案例显示,人类可能依赖颜色(“红色”)这样的感知维度,而LLM可能更倾向于功能(“保护性”)这样的语义维度。这清晰地指出了当前模型(尤其是纯语言模型)在感知信息整合上的不足,为未来的改进指明了方向。

本文题目:Human-like object concept representations emerge naturally in multimodal large language models

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献349条内容

已为社区贡献349条内容

所有评论(0)