三步搞定Deepseek本地化部署

deepseek r1+ollama+chatboxai 快速构建本地化部署

为什么需要本地化部署

1.数据安全,私秘性

2.网络稳定性

3.长远来看费用成本低

Deepseek本地化部署是企业应对安全威胁、合规压力及业务定制化需求的战略性选择。不仅提供对数据和系统的完全控制权,还能通过性能优化和成本管理提升长期竞争力,尤其适合中大型企业、特定行业及高敏感业务场景

部署方案

方案:deepseek r1+ollama+chatboxai

Ollama 是一个开源工具,旨在帮助用户在本地计算机上快速部署和运行大型语言模型(LLM),例如 Meta 的 Llama 系列(如 Llama 2、Llama 3)、Mistral、Gemma 等。它通过简化的命令行和 API 接口,让用户无需复杂的配置即可在本地运行、微调和管理 AI 模型,尤其适合开发者和研究人员。

本地运行大模型

-

在个人电脑(支持 macOS、Linux、Windows)上离线运行 LLM,无需依赖云服务,保障数据隐私。

-

支持多平台,提供 Docker 容器化部署选项。

一句话:Ollama是大语言模型(不限于Llama模型)便捷的管理和运维工具

部署步骤

第一步 Ollama 操作

下载Ollama

Ollama 下载网址:Ollama

选择相应的操作系统,下载Ollama安装包。

下载ollama 网速较慢,建议通过迅雷工具下载,速度超快。

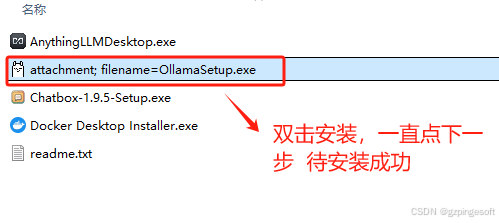

安装Ollama

下载Ollama 后,双击执行安装程序

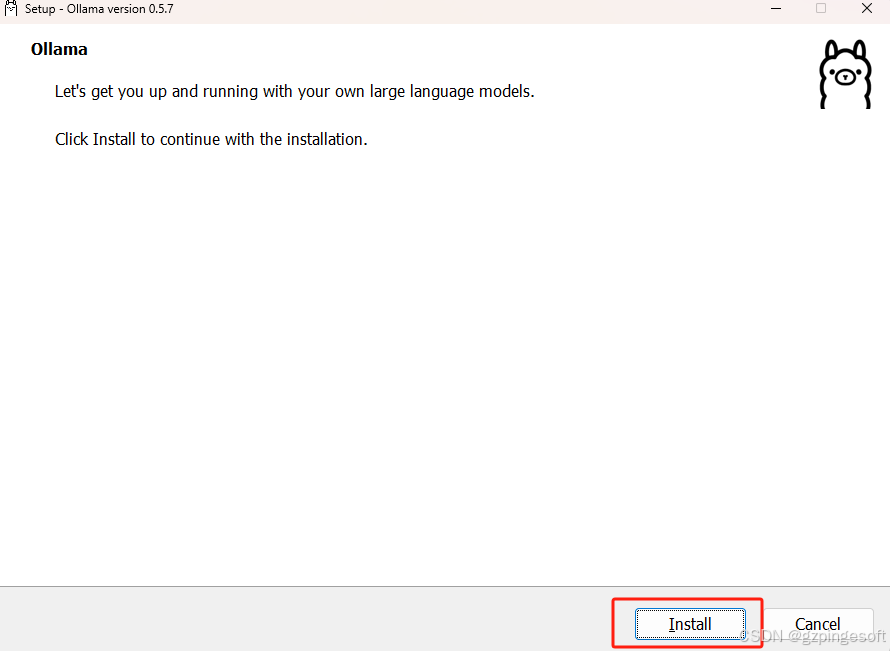

点击 install

检验Ollama安装成功

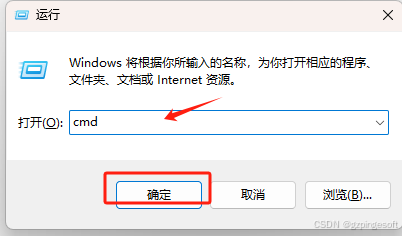

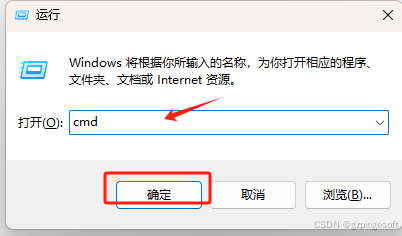

按快捷键win+R,然后在命令框输入cmd,随后点击确定

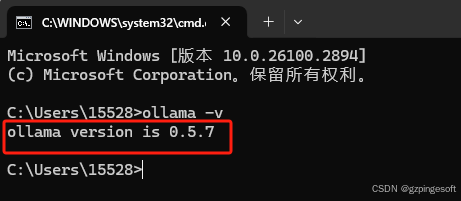

输入 ollama -v 后按回车确认如下图

看到输出ollama 版本信息,则表示ollama 安装成功。

第二步下载DeepSeek-R1模型

下载DeepSeek R1模型

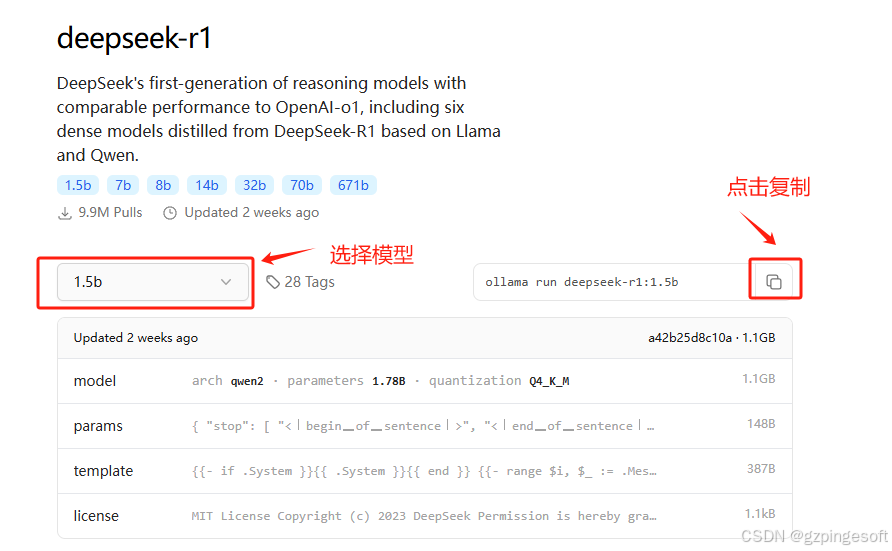

在Ollama 网站 点击Models,找到deepseek-r1,如下图:

点击deepseek-r1 后台,下载所需要的模型,deepseek 通过模型蒸馏,提供了1.5b,7b,14b,32b,70b,671b 几个小模型,按实际需求下载模型。

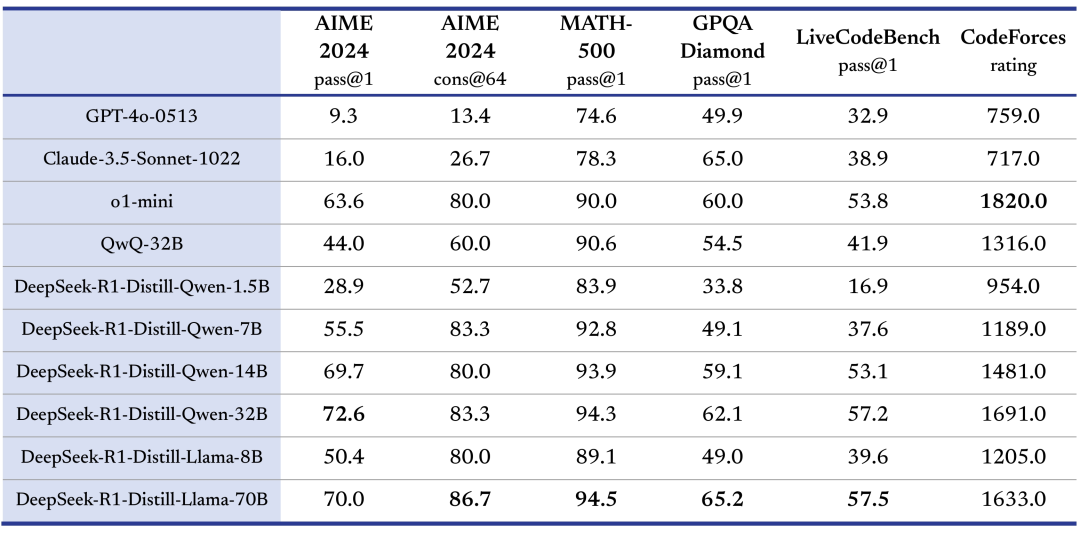

各模型性能对比如下图:

通过如上图,32b 模型已完爆o1-mini ,赶紧下载吧^_^

执行DeepSeek-R1模型

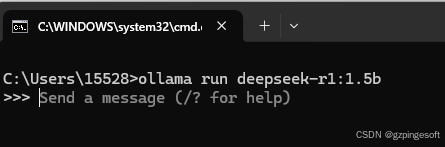

按快捷键win+R,然后在命令框输入cmd,随后点击确定

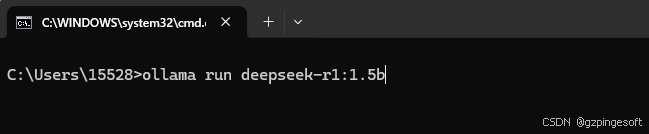

把上一步复制的ollama run deepseek-r1:1.5b 粘贴到光标后,接着按回车确认执行

注意:如果未指定小模型版本,则会下载所有小模型,将导致电脑存储空间不够。

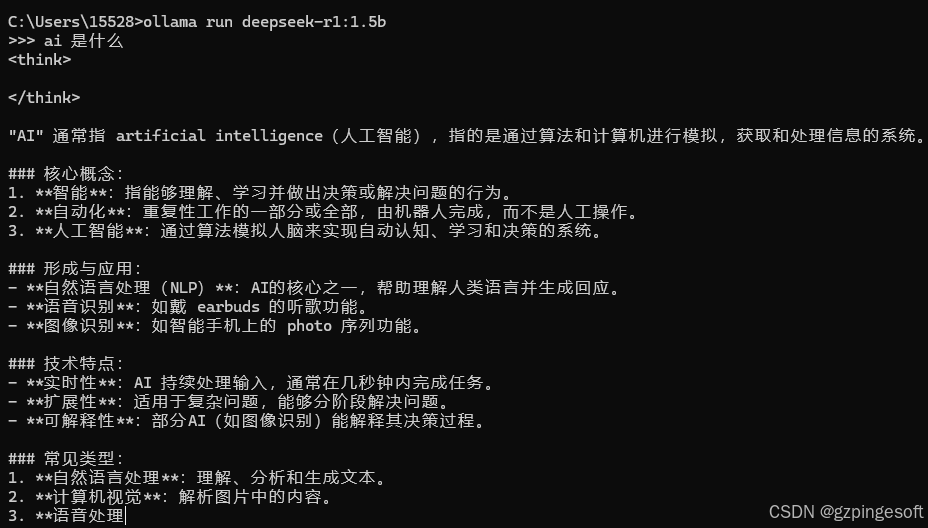

下载完成后,则可通过终端窗口 进行提问

输入 ai是什么 按回确认,得到如下回复

第三步 下载chatboxai 实现可视化聊天界面

下载chatbox

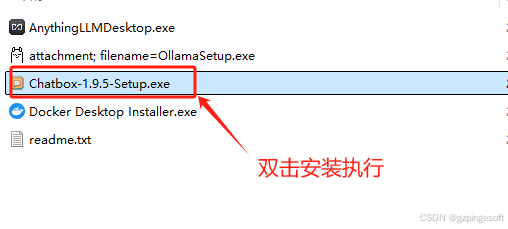

如上在终端界面操作聊天不太方便,借助chatboxai 实现可视化界面,如下图: 打开google浏览器输入Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

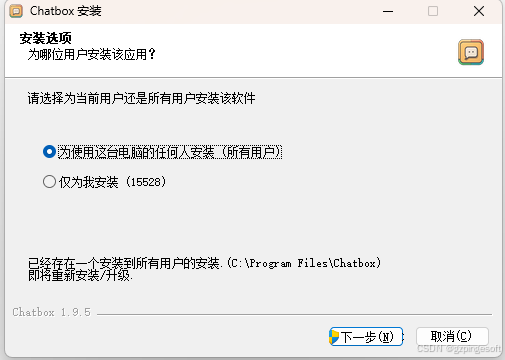

安装chatbox

下载chatboxai后,双击chatbox进行安装

一直点击 下一步就行

配置chatbox

如上图安装chatbox成功后,在桌面上有一个chatbox应用程序,如下图,双击打开

chatbox 打开后,点击设置,如下图选择模型

至此 chatbox 配置完成。

本地测试DeepSeek

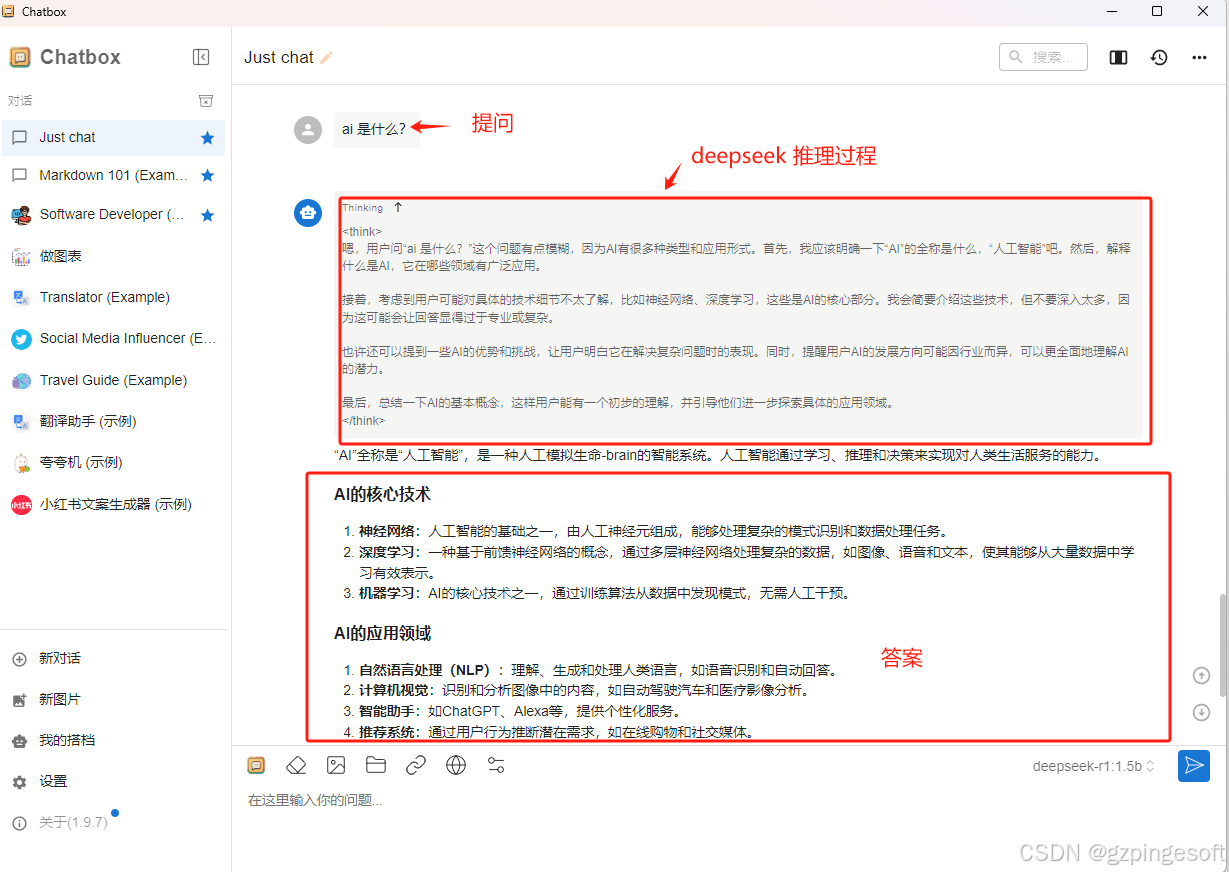

打开chatbox 输入ai是什么,点击发送,如下图:

deepseek 本地化部署就这么简简单单,如您觉得写得不错,烦请关注博客,谢谢。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)