【解耦tracking】End-to-end 3D Tracking with Decoupled Queries

解耦跟踪

3D Tracking with Decoupled Queries

1. 材料

End-to-end 3D Tracking with Decoupled Queries

https://github.com/NVlabs/DQTrack?tab=readme-ov-file

2. 概述

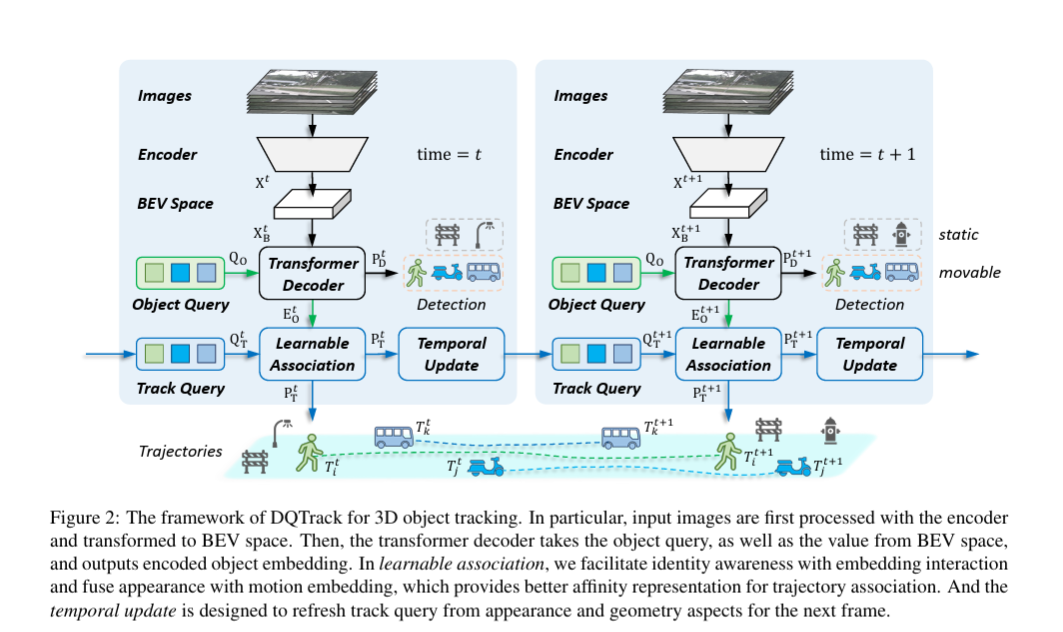

这篇文章的核心在于,将detection保留成为DETR那种检测方式,也就是说,检测模块是检测所有的结果,而不像MOTR系列那样,只检测新生的物体。然后Tracking部分会去和检测模块的输出的所有物体的embedding之间去做association,这个association是通过可学习的方式来得到的,其最终的输出是一个MxN(det2track_mat)的矩阵,这就和我们传统的tracking by detection的方式类似:把所有的track和所有当前帧的检测结果进行关联,只不过传统的方法是使用bounding box的方式去关联,算是一种强人工的特征,而这里用embedding去做可学习的关联。它学习的是detection出的N个结果和trackingM结果的对应的矩阵概率关系, N*M;

for each frame:

1. 编码当前帧得到物体embedding

2. 更新上一帧轨迹embedding

3. 通过Learnable Association计算关联矩阵(N*M)

4. Hungarian匹配确定物体-轨迹对应

5. 更新center pts 与velocity query

6. 输出检测

Return N * M (矩阵关系, N是detection query number, M为track query numer; )

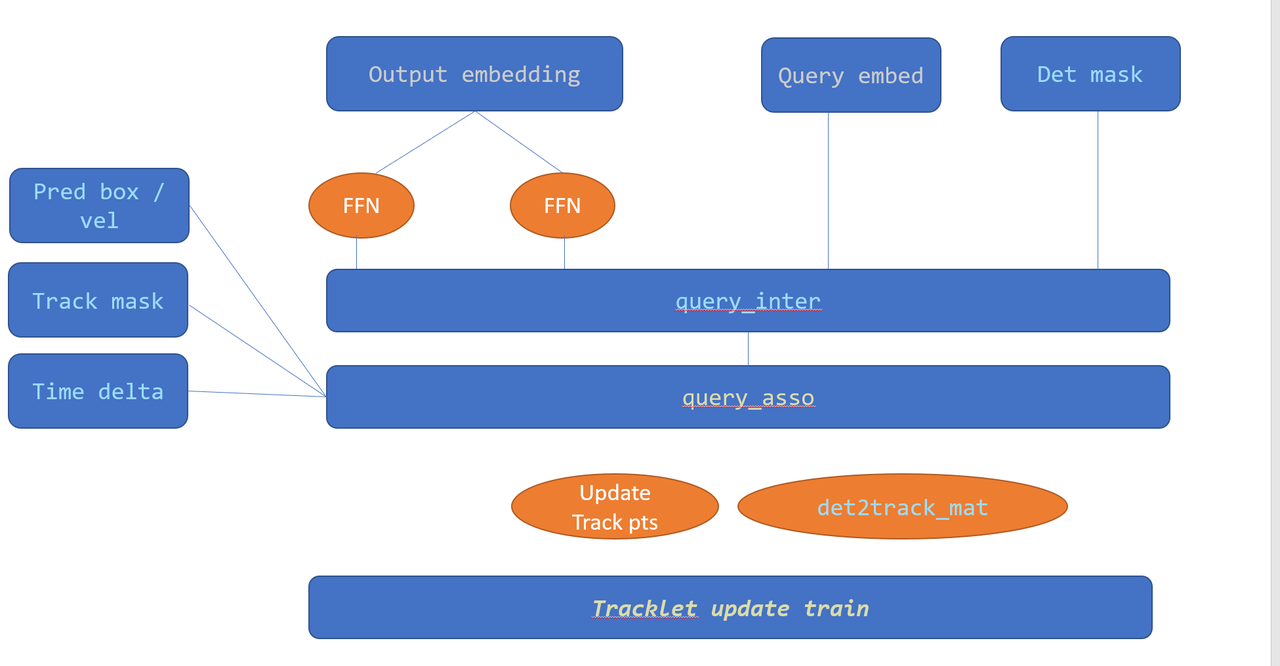

Track Model part Track input

{

detection得输出:

Output embeding

Query embeding

Ref points

Detection result (boxes, cls)

Update part:

Detection valid mask # update by detection

track valid mask # update by each frame end

}

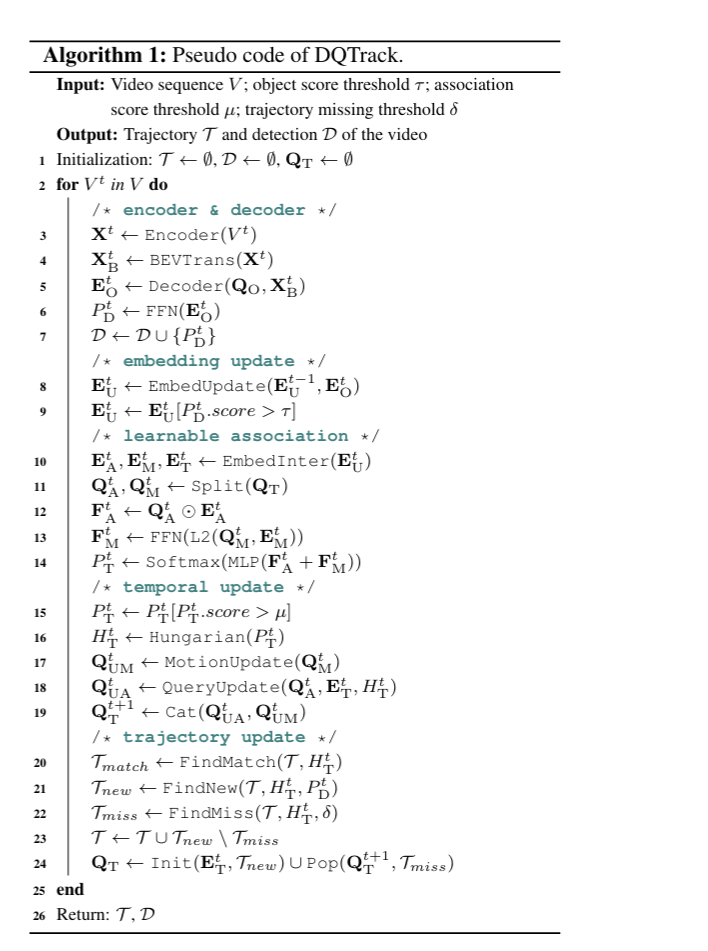

persudo code

/*encoder & decoder*/

/*embedding update*/

/*learnable association*/

Return det2track_mat N * M (矩阵关系, N是detection query number, M为track query numer; )

Update temporal data

# update query_embed, track mask, obj index

/*temporal update*/

/*trajectory update*/

个人试验证明:

比MUTR3D指标高

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)