Python手势识别系统:结合mediapipe和opencv的实战源码

Mediapipe是一个由Google推出的跨平台的框架,旨在帮助开发者实现各种机器学习应用,特别是在实时视频和音频处理上。安装Mediapipe库相对简单,对于Python用户来说,可以通过以下步骤进行安装:安装完成后,需要对环境进行简单的配置。对于Python用户,通常需要设置环境变量,以便程序能够在运行时找到Mediapipe的模块路径。Mediapipe提供了一系列预先训练好的模型,支持多

简介:本项目构建了一个利用Python语言以及Mediapipe和OpenCV库的手势识别系统。系统能够识别预定义的手势并执行相应的操作,适用于多个应用场景。文中详细介绍了系统的知识点,包括Python 3.6的使用、Mediapipe的实时手势检测能力、OpenCV的图像处理功能,以及手势识别技术的应用。此外,还分析了系统源码的结构和实时性、性能考虑,最后探讨了系统可能的扩展方向和应用领域。

1. Python 3.6版本的应用

Python作为编程语言中的“瑞士军刀”,它的广泛应用为开发者带来了极大便利。Python 3.6版本引入了诸多新特性,如格式化字符串字面值(f-string)和变量注解,这些改进显著提升了编码效率和可读性。

1.1 Python 3.6新特性的优势

f-string通过将变量或表达式嵌入到字符串中,极大地简化了字符串拼接操作,这使得调试更快速、代码更清晰。例如:

name = "IT Blog"

print(f"Hello, {name}!")

1.2 格式化字符串的演进

在Python 3.6之前,字符串格式化的方法包括传统的 % 操作符、 str.format 方法等。Python 3.6的f-string不仅语法简洁,而且执行效率更高。

# 传统方法

greeting = "Hello, %s!" % (name)

# 使用str.format

greeting = "Hello, {}!".format(name)

# 使用f-string

greeting = f"Hello, {name}!"

1.3 对IT行业的具体应用

Python 3.6的改进不仅提高了开发速度,还增强了代码的可维护性。IT行业在日志记录、数据处理和自动化脚本编写中广泛应用Python,这些新特性使得代码更为紧凑和高效。

上述内容仅涉及了Python 3.6版本应用的冰山一角,接下来章节将深入探讨Mediapipe库以及其在手势检测中的应用。

2. Mediapipe库的实时手势检测功能

2.1 Mediapipe库概述

2.1.1 库的安装与环境配置

Mediapipe是一个由Google推出的跨平台的框架,旨在帮助开发者实现各种机器学习应用,特别是在实时视频和音频处理上。安装Mediapipe库相对简单,对于Python用户来说,可以通过以下步骤进行安装:

pip install mediapipe

安装完成后,需要对环境进行简单的配置。对于Python用户,通常需要设置环境变量,以便程序能够在运行时找到Mediapipe的模块路径。

2.1.2 库的基本功能介绍

Mediapipe提供了一系列预先训练好的模型,支持多种任务,如手势识别、面部识别等。该库支持多种编程语言,包括Python和C++。在Python环境中,Mediapipe允许开发者非常便捷地通过API接口,访问和利用这些模型。

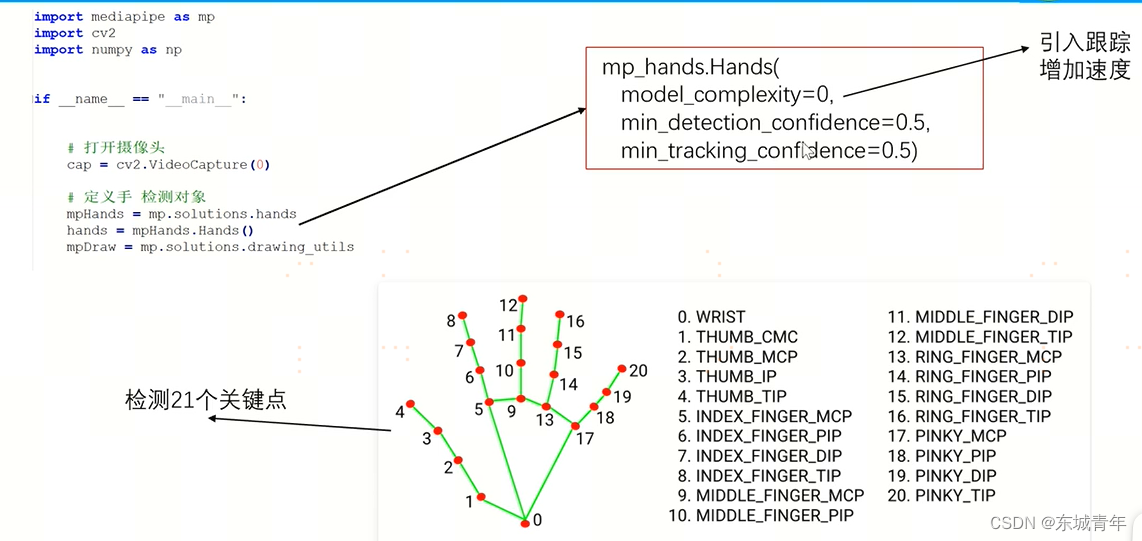

2.2 Mediapipe的手势检测原理

2.2.1 手势识别的算法基础

Mediapipe的手势识别依赖于深度学习模型,特别是卷积神经网络(CNN)。这些模型能够在视频流中识别出手部的关键点,进而根据这些关键点的位置和变化检测手势。

CNN模型通常由多个卷积层、池化层和全连接层构成,每一层都对输入图像进行特定的变换以提取特征。当输入一张包含手部的图像时,CNN能够输出一系列坐标点,这些点对应于手部的关键部位。

2.2.2 关键点的检测流程

Mediapipe检测关键点主要通过以下几个步骤:

- 图像预处理 :首先对输入的视频帧进行必要的预处理,比如调整大小、归一化等。

- 特征提取 :使用深度学习模型提取图像中的手部特征。

- 关键点检测 :通过模型输出,得到手部关键点的坐标。

- 手势解析 :根据关键点坐标和它们之间的关系进行手势识别和解析。

2.3 Mediapipe在Python中的集成应用

2.3.1 Python接口的使用方法

在Python中使用Mediapipe进行手势检测,需要首先导入必要的模块:

import cv2

import mediapipe as mp

# 初始化手部检测模块

mp_hands = mp.solutions.hands

hands = mp_hands.Hands()

# 初始化绘图模块

mp_drawing = mp.solutions.drawing_utils

# 通过OpenCV捕获视频

cap = cv2.VideoCapture(0)

while cap.isOpened():

ret, frame = cap.read()

if not ret:

continue

# 将BGR图像转换为RGB图像

rgb_frame = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

# 处理图像并获取手部关键点

results = hands.process(rgb_frame)

# 将图像颜色空间转换回BGR以显示

result_frame = cv2.cvtColor(rgb_frame, cv2.COLOR_RGB2BGR)

# 绘制检测到的手部关键点

if results.multi_hand_landmarks:

for hand_landmarks in results.multi_hand_landmarks:

mp_drawing.draw_landmarks(result_frame, hand_landmarks, mp_hands.HAND_CONNECTIONS)

# 显示结果图像

cv2.imshow('Hand Tracking', result_frame)

if cv2.waitKey(5) & 0xFF == 27:

break

cap.release()

cv2.destroyAllWindows()

2.3.2 实时数据流的处理与反馈

在上述代码中,每一帧图像首先被转换为RGB颜色空间,然后由Mediapipe处理以检测手部关键点。检测结果通过绘图模块可视化,最后将结果图像显示在屏幕上。

为了能够实时处理视频流并提供反馈,使用了OpenCV库来捕获摄像头的视频流。Mediapipe处理每一帧图像,并实时绘制关键点,展示了集成应用的简单案例。

在实时数据流的处理中,性能优化非常重要。由于手势识别的实时性要求高,因此需要确保算法的运行速度足够快,以便能够实时更新检测结果。这通常涉及到优化模型算法、减少不必要的计算步骤、选择更高效的硬件等策略。

以上所述章节展示了Mediapipe在手势检测方面的应用流程,并通过代码实现了一个简单的实时手势检测系统。接下来的章节将深入探讨OpenCV库在图像处理方面的功能,以及如何与Mediapipe协同工作以实现更高级的视觉应用。

3. OpenCV库的图像处理功能

3.1 OpenCV库简介

3.1.1 库的安装与基本概念

OpenCV,全称为Open Source Computer Vision Library,是一个开源的计算机视觉和机器学习软件库。它提供了丰富的图像处理和计算机视觉功能,被广泛应用于学术研究和工业应用中。OpenCV库支持多种编程语言,包括C/C++、Python和Java等。因其高效、灵活和开源的特性,它成为业界和学界进行图像处理和视觉应用开发的首选工具。

在Python中安装OpenCV库,通常使用pip包管理器进行安装:

pip install opencv-python

对于更高级的图形处理需求,可能需要安装额外的库模块,如 opencv-python-headless 。

OpenCV的基本概念包括以下几个方面:

- 图像矩阵 :OpenCV中使用二维矩阵来表示图像,其中每个像素点的值用整数或浮点数来表示。

- 颜色空间 :OpenCV支持多种颜色空间,如BGR(默认)、HSV、YCrCb等。

- 数据类型 :OpenCV的矩阵可以是8位(8U)、16位(16U或16S)、32位(32S)、浮点(32F)或双精度(64F)。

3.1.2 图像处理功能概览

OpenCV库提供的图像处理功能非常丰富,涵盖了从简单的像素操作到复杂的图像分析的所有方面。主要功能包括但不限于:

- 图像读写 :支持从多种格式的文件中读取图像数据,如JPEG、PNG、BMP、TIFF等,并可以将处理后的图像保存到文件中。

- 图像变换 :包括图像的缩放、旋转、裁剪等基础操作。

- 颜色空间转换 :能够将图像从一个颜色空间转换到另一个颜色空间,如从BGR到灰度,或从BGR到HSV。

- 图像滤波 :提供多种滤波器来处理图像中的噪声,如均值滤波、高斯滤波、中值滤波等。

- 特征检测与描述 :包括角点检测(如Harris角点检测)、边缘检测(如Canny边缘检测)、SIFT、SURF和ORB特征点检测等。

- 几何变换 :实现图像的仿射变换和透视变换等。

- 形态学操作 :包括膨胀、腐蚀、开运算和闭运算等,用于图像的形状处理。

- 轮廓查找 :可以找到图像中的轮廓线,并对这些轮廓线进行分析。

- 视频分析 :提供视频读取、写入以及帧间操作等功能。

3.2 OpenCV图像处理技巧

3.2.1 颜色空间转换与滤波

颜色空间转换是图像处理中常见的操作之一,它可以更好地适应特定应用的需求。例如,在机器学习和计算机视觉应用中,将彩色图像转换为灰度图像是一种常见的预处理步骤。在Python中,可以使用OpenCV库来实现颜色空间的转换,下面是相应的代码示例及其解释:

import cv2

import numpy as np

# 读取彩色图像

img_color = cv2.imread('image.jpg')

# 将彩色图像转换为灰度图像

img_gray = cv2.cvtColor(img_color, cv2.COLOR_BGR2GRAY)

# 将彩色图像转换为HSV颜色空间

img_hsv = cv2.cvtColor(img_color, cv2.COLOR_BGR2HSV)

# 显示图像

cv2.imshow('Color Image', img_color)

cv2.imshow('Grayscale Image', img_gray)

cv2.imshow('HSV Image', img_hsv)

# 等待按键后退出

cv2.waitKey(0)

cv2.destroyAllWindows()

参数说明:

- cv2.imread() :用于读取图片,返回一个numpy的数组。

- cv2.cvtColor() :用于进行颜色空间的转换,其中 cv2.COLOR_BGR2GRAY 将BGR颜色空间转换为灰度空间, cv2.COLOR_BGR2HSV 将BGR转换为HSV颜色空间。

在上述代码中,通过 cv2.cvtColor() 函数实现了从BGR到灰度空间以及到HSV空间的转换。

滤波是图像处理中用于去除噪声和进行平滑处理的技术,常见的滤波器包括均值滤波器、高斯滤波器和中值滤波器。OpenCV提供了相应的函数来实现这些滤波操作。

# 读取图像

img = cv2.imread('noisy_image.jpg')

# 应用均值滤波器

blur = cv2.blur(img, (5, 5))

# 应用高斯滤波器

gaussian_blur = cv2.GaussianBlur(img, (5, 5), 0)

# 应用中值滤波器

median_blur = cv2.medianBlur(img, 5)

# 显示图像

cv2.imshow('Original', img)

cv2.imshow('Blur', blur)

cv2.imshow('Gaussian Blur', gaussian_blur)

cv2.imshow('Median Blur', median_blur)

# 等待按键后退出

cv2.waitKey(0)

cv2.destroyAllWindows()

3.2.2 特征检测与形态学操作

在计算机视觉中,特征检测旨在识别和描述图像中的重要点,以进行图像分析和理解。OpenCV提供了多种特征检测器,例如使用SIFT(尺度不变特征变换)进行关键点检测和描述。由于SIFT是专利算法,OpenCV还提供了类似的非专利算法如ORB(Oriented FAST and Rotated BRIEF)。

以下是使用ORB特征检测器进行特征提取的代码示例:

import cv2

# 读取图像

img = cv2.imread('image.jpg', 0) # 0 表示以灰度模式读取

# 初始化ORB检测器

orb = cv2.ORB_create()

# 找到关键点和描述符

kp, des = orb.detectAndCompute(img, None)

# 绘制关键点

img_kp = cv2.drawKeypoints(img, kp, None, color=(0, 255, 0), flags=0)

# 显示图像

cv2.imshow('Keypoints', img_kp)

cv2.waitKey(0)

cv2.destroyAllWindows()

参数说明:

- cv2.ORB_create() :创建ORB检测器实例。

- detectAndCompute() :检测关键点并计算描述符。

在图像处理中,形态学操作是一种处理图像形状的技术,它主要用于二值图像。形态学操作主要包括腐蚀、膨胀、开运算和闭运算。形态学操作可以用于去除小的噪声点、断开物体间的连接和填充物体内的空洞等。

下面是一个使用形态学操作来处理图像的代码示例:

import cv2

# 读取二值图像

img = cv2.imread('binary_image.jpg', 0)

# 定义结构元素

kernel = np.ones((5,5), np.uint8)

# 腐蚀操作

erosion = cv2.erode(img, kernel, iterations = 1)

# 膨胀操作

dilation = cv2.dilate(img, kernel, iterations = 1)

# 开运算操作

opening = cv2.morphologyEx(img, cv2.MORPH_OPEN, kernel)

# 闭运算操作

closing = cv2.morphologyEx(img, cv2.MORPH_CLOSE, kernel)

# 显示图像

cv2.imshow('Original', img)

cv2.imshow('Erosion', erosion)

cv2.imshow('Dilation', dilation)

cv2.imshow('Opening', opening)

cv2.imshow('Closing', closing)

# 等待按键后退出

cv2.waitKey(0)

cv2.destroyAllWindows()

参数说明:

- cv2.erode() :进行腐蚀操作。

- cv2.dilate() :进行膨胀操作。

- cv2.morphologyEx() :进行开运算或闭运算操作,其中 cv2.MORPH_OPEN 代表开运算, cv2.MORPH_CLOSE 代表闭运算。

通过这些操作,可以实现不同的图像处理效果,如减少噪声、改善物体边缘等。

3.3 OpenCV与Mediapipe的协同工作

3.3.1 图像预处理与优化

在将Mediapipe集成到我们的图像处理流程中时,进行适当的图像预处理是非常重要的。预处理通常包括缩放图像、调整颜色空间、滤波以及其他必要的转换,以保证Mediapipe的实时手势检测模块能够更准确地工作。

以下是将OpenCV应用于Mediapipe进行图像预处理的代码示例:

import cv2

from mediapipe.python.solutions import hands as mp_hands

# 初始化Mediapipe手势检测器

hands = mp_hands.Hands(static_image_mode=False, max_num_hands=2)

# 打开摄像头

cap = cv2.VideoCapture(0)

while cap.isOpened():

success, image = cap.read()

if not success:

continue

# 将BGR图像转换为RGB图像,因为Mediapipe需要RGB格式

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

# 手势检测

results = hands.process(image)

# 将图像转换回BGR以便显示

image = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)

# 在此处添加其他图像处理操作,例如滤波、缩放等

# 显示图像

cv2.imshow('Image', image)

if cv2.waitKey(5) & 0xFF == 27:

break

cap.release()

cv2.destroyAllWindows()

3.3.2 实时视频流的捕获与显示

OpenCV是一个强大的工具,不仅可以用作图像处理,还能实时捕获和显示视频流。这在创建交互式应用或进行实时图像分析时非常重要。Mediapipe的实时手势检测功能结合OpenCV的视频捕获功能,可以开发出非常强大的应用。

下面是利用OpenCV捕获摄像头的实时视频流,并与Mediapipe手势检测功能结合的代码示例:

import cv2

from mediapipe.python.solutions import hands as mp_hands

# 初始化Mediapipe手势检测器

hands = mp_hands.Hands(min_detection_confidence=0.7, min_tracking_confidence=0.5)

# 打开摄像头

cap = cv2.VideoCapture(0)

while cap.isOpened():

success, image = cap.read()

if not success:

print("Ignoring empty camera frame.")

continue

# 将BGR图像转换为RGB图像,因为Mediapipe需要RGB格式

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

# 手势检测

results = hands.process(image)

# 将图像转换回BGR以便显示

image = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)

# 在此处添加其他图像处理操作,例如滤波、缩放等

# 显示图像

cv2.imshow('MediaPipe Hands', image)

if cv2.waitKey(5) & 0xFF == 27:

break

cap.release()

cv2.destroyAllWindows()

通过上述代码,我们可以实现使用OpenCV捕获实时视频流,并在每一帧上应用Mediapipe的手势检测功能。这使得开发手势控制的交互式应用程序成为可能,例如游戏控制、虚拟现实(VR)界面或人机交互界面等。

4. 手势识别技术的应用与实现

手势识别技术作为计算机视觉领域的一个热门分支,在过去的几年里迅速发展,并广泛应用于多种实际场景。手势识别技术主要依赖于图像处理和模式识别算法,这些算法能够通过分析视频流中的运动图像来识别和解释手势动作。该技术的广泛应用可以大大提高人机交互的效率和用户体验。

4.1 手势识别技术概述

4.1.1 手势识别的意义与挑战

手势识别技术的意义在于它能够提供一种自然、直观和非接触式的人机交互方式。与传统的鼠标和键盘相比,手势识别不仅减少了对物理设备的依赖,还能够提供更丰富的交互体验。然而,在实现过程中,手势识别技术面临着一些挑战,包括准确度、速度、易用性以及适应不同光照和背景条件的能力。

为了克服这些挑战,研究人员和工程师们不断在算法优化、硬件发展和用户体验等方面进行创新。例如,通过使用深度学习技术,系统可以更好地学习和理解手势特征,从而提高识别准确率。

4.1.2 系统需求分析

在构建一个手势识别系统时,需要对以下几个方面进行详细的需求分析:

- 用户界面的友好性 :用户交互界面需要直观易懂,且响应速度要快。

- 实时性能 :为了保证良好的用户体验,系统需要实时处理视频流并快速响应手势命令。

- 准确性 :系统需要具有高准确率以正确识别各种手势。

- 适用性 :系统应能在不同的环境和条件下稳定工作,包括不同光照强度、背景干扰等。

4.2 手势识别系统的构建步骤

4.2.1 系统设计思路

构建一个手势识别系统需要经过以下设计思路的步骤:

- 需求分析 :根据应用场景确定系统需求。

- 算法选择 :选择适合的图像处理和模式识别算法。

- 硬件选择 :根据需求选择合适的摄像头和其他硬件设备。

- 软件开发 :编程实现手势识别的算法,并开发用户界面。

- 系统集成 :将算法与硬件设备结合,并进行系统测试和优化。

- 用户反馈 :收集用户反馈并根据反馈进行进一步的系统优化。

4.2.2 关键技术点的详细实现

在关键技术点的实现上,涉及以下几个重要步骤:

- 手势检测 :使用如Mediapipe库等工具进行实时手势检测。

- 特征提取 :提取手势的关键点和特征向量。

- 手势分类 :利用机器学习算法,如支持向量机(SVM)或深度学习网络对手势进行分类识别。

- 反馈机制 :将识别结果转换为具体命令或控制信号反馈给应用系统。

4.3 手势识别的应用实例与效果展示

4.3.1 实际应用场景介绍

手势识别技术已经被应用到多个领域,包括但不限于:

- 智能交互 :在教育和商业演示中,手势识别技术允许用户通过手势与多媒体内容进行交互。

- 游戏娱乐 :手势识别被用于视频游戏中,为玩家提供新的交互方式。

- 辅助技术 :对于行动不便的人士,手势识别可以作为一种辅助技术帮助他们更好地控制环境和设备。

4.3.2 手势识别的效果评估与反馈

为了确保手势识别系统的有效性和用户体验,进行效果评估和用户反馈收集至关重要。可以通过用户调查、测试场景模拟以及长时间的现场测试来收集数据。测试结果将揭示系统的优点和不足,为后续的优化工作提供依据。

为了提高手势识别的准确性,可能需要在不同的光照条件下进行测试,或者在实际应用场景中收集更多样化的手势数据进行训练,从而提高系统的适应性和鲁棒性。此外,用户反馈可以揭示系统设计上的不足,帮助开发者更好地理解用户需求,并据此改进系统的设计。

通过不断迭代和优化,手势识别系统将能够更好地满足用户需求,并在实际应用中发挥更大的作用。

5. 源码结构及功能介绍

5.1 源码整体结构分析

5.1.1 模块划分与功能定位

在软件开发中,一个清晰的模块划分可以大大提升代码的可维护性和可扩展性。本项目在源码结构上采用了模块化的划分方法,将不同的功能封装在不同的模块中。核心模块包括但不限于:

- DetectionModule :负责手势检测的功能,整合了Mediapipe库提供的手势识别API。

- ImageProcessingModule :负责图像处理,包括图像预处理、特征提取、边缘检测等。

- UIController :负责用户交互界面的控制,响应用户操作,展示处理结果。

以下是源码结构的简单图示:

graph TD

A[手势识别系统] --> B[DetectionModule]

A --> C[ImageProcessingModule]

A --> D[UIController]

5.1.2 关键文件和类的介绍

在项目的关键文件和类方面,以下是一些主要的文件和类及其职责:

main.py:程序的入口文件,负责启动应用,初始化各个模块。detection.py:封装了Mediapipe的手势识别功能,处理实时视频流并进行手势检测。image_processing.py:实现了图像的预处理、增强、特征提取等功能。ui_controller.py:控制用户界面,将检测结果和处理后的图像呈现给用户。

# main.py 示例代码

import detection

import image_processing

import ui_controller

if __name__ == "__main__":

# 初始化模块

detector = detection.GestureDetector()

processor = image_processing.ImageProcessor()

ui = ui_controller.UserInterface()

# 应用程序主循环

while True:

# 获取图像帧

frame = ui.get_frame_from_camera()

# 处理图像帧

processed_frame = processor.process(frame)

# 检测手势

gestures = detector.detect_gestures(processed_frame)

# 更新用户界面

ui.update(gestures)

5.2 核心功能代码解析

5.2.1 手势检测核心算法的实现

手势检测的核心算法主要依赖于Mediapipe库,其后端基于深度学习模型实现了高效的手势识别。在 detection.py 中, GestureDetector 类封装了Mediapipe的手势识别功能,负责初始化和帧处理。

以下是核心算法的代码示例和逻辑解释:

# detection.py 示例代码

from mediapipe.python.solutions import hands

import cv2

class GestureDetector:

def __init__(self):

# 初始化MediaPipe手势识别解决方案

self.hands_solution = hands.Hands(static_image_mode=False,

max_num_hands=1,

min_detection_confidence=0.7,

min_tracking_confidence=0.5)

def detect_gestures(self, image):

# 处理图像,并返回手势识别结果

image = cv2.flip(image, 1)

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

results = self.hands_solution.process(image)

# 转换为BGR格式,用于展示

image = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)

return image, results

该代码首先导入必要的库,并定义一个 GestureDetector 类。类的构造函数中初始化了Mediapipe的手势识别模块。 detect_gestures 方法接受一个图像帧作为输入,使用 hands.Hands 处理图像,并返回处理后的图像帧以及识别结果。

5.2.2 图像处理与优化的策略

图像处理和优化部分在 image_processing.py 中实现。这部分代码负责图像的预处理,以提高手势检测的准确性。关键的处理步骤包括图像的缩放、颜色转换、滤波等。

以下是一个图像处理函数的代码示例:

# image_processing.py 示例代码

import cv2

import numpy as np

def process_image(image):

# 将图像转换为灰度图

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 使用高斯模糊去除噪声

blurred_image = cv2.GaussianBlur(gray_image, (5, 5), 0)

# 应用Canny边缘检测

edges = cv2.Canny(blurred_image, 50, 150)

return edges

该函数首先将输入的彩色图像转换为灰度图像,然后使用高斯模糊去除噪声。之后,通过Canny边缘检测算法检测图像中的边缘,以此来准备进行进一步的手势识别处理。

5.3 用户交互界面设计

5.3.1 界面布局与功能展示

用户交互界面(UI)采用简洁直观的设计,旨在提供良好的用户体验和高效的手势反馈。主界面分为几个主要部分:

- 视频流显示区域:实时展示来自摄像头的视频流。

- 手势指示区域:显示当前检测到的手势及其含义。

- 控制按钮:允许用户开始和停止视频流,以及退出程序。

5.3.2 用户体验优化的思考

为了优化用户体验,界面设计考虑了易用性和即时性。例如,在手势检测结果出现时,UI会立即显示相应的提示信息,同时通过颜色高亮或动画效果来吸引用户的注意。

以下是一个简单的UI界面布局代码示例:

# ui_controller.py 示例代码

from tkinter import *

class UserInterface:

def __init__(self):

self.root = Tk()

self.root.title("手势识别系统")

# 视频流显示区域

self.video_frame = Frame(self.root, width=640, height=480)

self.video_frame.pack()

# 手势指示区域

self.gesture_label = Label(self.root, text="等待手势识别...")

self.gesture_label.pack()

# 控制按钮

start_button = Button(self.root, text="开始", command=self.start_video)

start_button.pack(side=LEFT)

stop_button = Button(self.root, text="停止", command=self.stop_video)

stop_button.pack(side=LEFT)

exit_button = Button(self.root, text="退出", command=self.exit_app)

exit_button.pack(side=LEFT)

def start_video(self):

# 启动视频流...

pass

def stop_video(self):

# 停止视频流...

pass

def exit_app(self):

# 退出应用...

self.root.quit()

def update(self, gestures):

# 更新手势识别结果

self.gesture_label.config(text=str(gestures))

def get_frame_from_camera(self):

# 从摄像头获取视频帧...

return None

def run(self):

self.root.mainloop()

这个简单的UI控制器代码使用了Python的Tkinter库,创建了一个窗口界面,包含视频流显示区域和控制按钮。 update 方法用于更新手势识别结果的显示,当有新结果时调用该方法更新标签文本。

6. 系统实时性与性能优化

随着技术的飞速发展,实时性与性能优化已成为软件开发中不可或缺的一环。尤其是在手势识别等对响应速度要求极高的应用中,优化系统以减少延迟和提高准确性显得尤为重要。

6.1 系统实时性分析

6.1.1 实时性的重要性与衡量标准

实时性指的是系统对外界输入做出响应的速度,是衡量一个系统是否能够满足实时应用需求的关键指标。在手势识别应用中,实时性直接关系到用户体验。衡量实时性的标准主要有:

- 响应时间:系统从接收输入到产生输出的时间。

- 处理速度:系统处理数据的速率。

- 帧率:系统每秒处理图像的帧数。

6.1.2 性能瓶颈的识别与分析

要优化实时性,首先需要识别性能瓶颈。性能瓶颈通常发生在处理速度最慢的部分。分析方法可能包括:

- CPU使用率:监控CPU资源消耗,查看是否存在峰值。

- 内存使用:检查内存泄漏或过度分配。

- I/O操作:分析读写操作的频率和效率。

6.2 系统性能优化策略

6.2.1 优化算法的选择与实施

优化算法是提高实时性的关键。例如:

# 伪代码:使用多尺度的图像处理方法提高检测速度

def optimize_detection(image, scales):

fast_detections = []

for scale in scales:

resized_image = resize_image(image, scale)

detections = perform_detection(resized_image)

fast_detections.extend(detections)

return fast_detections

6.2.2 多线程与并发处理的应用

多线程和并发处理可以并行执行多个任务,提高系统效率。例如:

import threading

def process_frame(frame):

# 处理单帧图像

pass

def worker(frame_queue):

while True:

frame = frame_queue.get()

process_frame(frame)

frame_queue.task_done()

frame_queue = queue.Queue()

threads = []

for i in range(4):

t = threading.Thread(target=worker, args=(frame_queue,))

t.start()

threads.append(t)

# 主线程推送帧到队列

for frame in video_stream:

frame_queue.put(frame)

# 等待所有帧被处理

frame_queue.join()

for t in threads:

t.join()

6.3 系统的可扩展性提升

6.3.1 模块化设计的优势

模块化设计有助于提高系统的可扩展性,使得系统更加灵活,易于维护和升级。每个模块应该专注于一个具体的功能,例如:

graph TD

A[系统入口] --> B[图像采集模块]

B --> C[预处理模块]

C --> D[手势检测模块]

D --> E[结果输出模块]

6.3.2 系统架构的升级与维护

随着业务的发展和技术的更新,系统架构需要适时进行升级和维护。采用微服务架构或服务导向架构(SOA)可以在不影响现有系统的情况下,逐步实现新功能的集成和旧模块的替换。

graph LR

A[用户界面] -->|请求| B(服务网关)

B -->|转发请求| C[图像处理服务]

B -->|转发请求| D[手势识别服务]

B -->|转发请求| E[数据存储服务]

C -->|处理结果| B

D -->|识别结果| B

E -->|存储数据| B

B -->|响应数据| A

通过模块化和微服务化的设计,可以大大提升系统整体的实时性和性能,同时为未来的扩展和维护提供了坚实的基础。

简介:本项目构建了一个利用Python语言以及Mediapipe和OpenCV库的手势识别系统。系统能够识别预定义的手势并执行相应的操作,适用于多个应用场景。文中详细介绍了系统的知识点,包括Python 3.6的使用、Mediapipe的实时手势检测能力、OpenCV的图像处理功能,以及手势识别技术的应用。此外,还分析了系统源码的结构和实时性、性能考虑,最后探讨了系统可能的扩展方向和应用领域。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献19条内容

已为社区贡献19条内容

所有评论(0)