docker本地部署文本嵌入模型nomic-embed-text

nomic-embed-text模型,之前是使用ollama工具在自己电脑本地部署的,换电脑之后再使用的话又要重新部署 ,在公司和家里面电脑来回调试代码的话比较麻烦,因此就想着在服务器上部署一个,到时候都统一远程调用,这样就省得来回切换了。上图是在windows本地部署过的模型,那么在docker上的部署思路也是先安装一个ollama的镜像,然后再通过这个ollama的镜像去部署模型。下载 nom

之前在学习AI课程的时候,用到了nomic-embed-text模型,之前是使用ollama工具在自己电脑本地部署的,换电脑之后再使用的话又要重新部署 ,在公司和家里面电脑来回调试代码的话比较麻烦,因此就想着在服务器上部署一个,到时候都统一远程调用,这样就省得来回切换了。

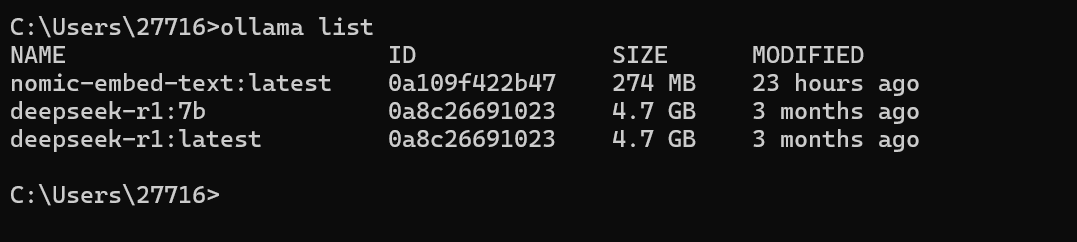

上图是在windows本地部署过的模型,那么在docker上的部署思路也是先安装一个ollama的镜像,然后再通过这个ollama的镜像去部署模型。

如果大家有还没接触过ollama的,可以先看一下之前写过的文章:

以下是使用 Docker 部署 nomic-embed-text:latest 的步骤:

拉取 Ollama 镜像

docker pull ollama/ollama:latest启动 Ollama 容器

docker run -d --name ollama -p 11434:11434 ollama/ollama:latest下载 nomic-embed-text 模型

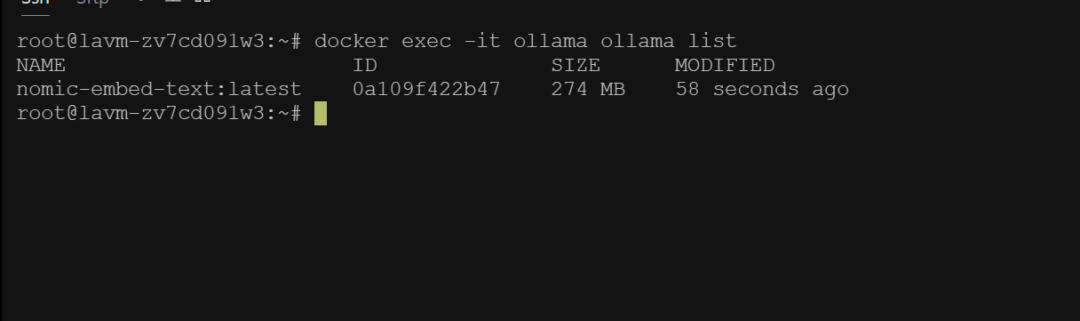

docker exec -it ollama ollama pull nomic-embed-text:latest验证模型是否下载成功

运行以下命令查看已下载的模型:

docker exec -it ollama ollama list如果看到 nomic-embed-text:latest 出现在列表中,说明模型下载成功。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)