ICLR2024论文解读|DP-OPT: MAKE LARGE LANGUAGE MODEL YOUR PRIVACY-PRESERVING PROMPT ENGINEER差分隐私离线提示微调

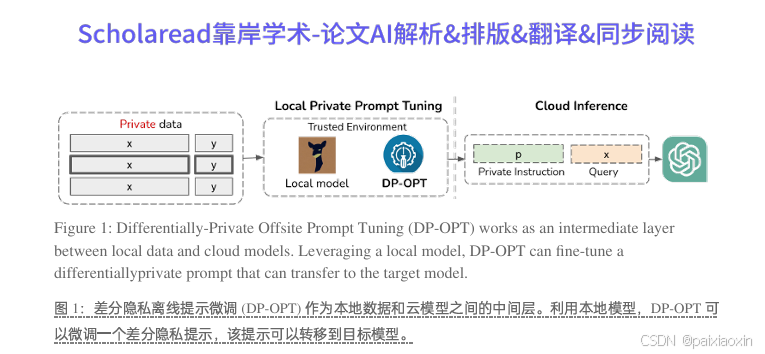

本文提出了一种名为Differentially-Private Offsite Prompt Tuning(DP-OPT)的新方法,旨在解决大型语言模型(LLM)提示微调中的数据隐私问题。DP-OPT通过在客户端调整离散提示,并将其应用于云端模型,确保了数据的保密性和隐私性。该方法利用差分隐私技术,生成可在不同模型间迁移的提示,同时保护了提示不泄露私人信息。实验表明,DP-OPT在多种语言任务上表

论文标题

DP-OPT: MAKE LARGE LANGUAGE MODEL YOUR PRIVACY-PRESERVING PROMPT ENGINEER

差分隐私离线提示微调:让大型语言模型成为你的隐私保护提示工程师

论文链接

DP-OPT: MAKE LARGE LANGUAGE MODEL YOUR PRIVACY-PRESERVING PROMPT ENGINEER论文下载

论文作者

Junyuan Hong, Jiachen T. Wang, Chenhui Zhang, Zhangheng Li, Bo Li, Zhangyang Wang

内容简介

本文提出了一种名为Differentially-Private Offsite Prompt Tuning(DP-OPT)的新方法,旨在解决大型语言模型(LLM)提示微调中的数据隐私问题。DP-OPT通过在客户端调整离散提示,并将其应用于云端模型,确保了数据的保密性和隐私性。该方法利用差分隐私技术,生成可在不同模型间迁移的提示,同时保护了提示不泄露私人信息。实验表明,DP-OPT在多种语言任务上表现出色,与非私有方法相比具有竞争力。

分点关键点

1.隐私保护的提示微调

DP-OPT在客户端进行提示微调,避免了将敏感数据发送给云模型供应商,保护了数据的保密性和隐私性。

2.模型迁移性

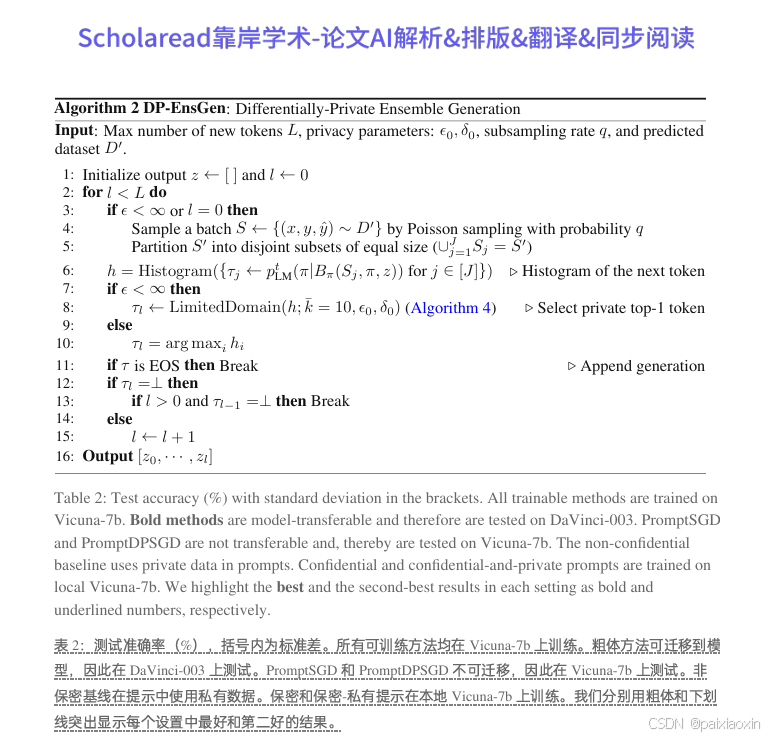

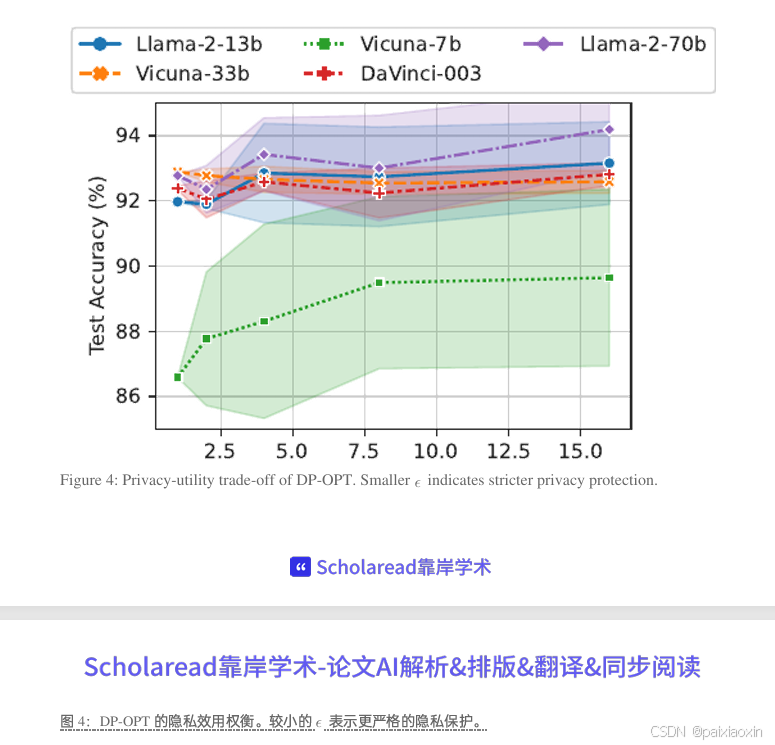

通过差分隐私集成上下文学习,DP-OPT生成的提示可以在不同架构的LLM之间迁移,如从Vicuna-7b迁移到GPT3.5或Llama-2,且性能表现优异。

3.差分隐私机制

引入了首个差分隐私提示生成机制,通过私有演示子集进行上下文学习,严格限制了隐私成本,确保了提示的隐私性。

4.实验验证

在多个情感分类任务上,DP-OPT生成的提示在迁移到闭源和开源模型后,均取得了显著的性能提升,证明了其有效性和实用性。

论文代码

代码链接:https://github.com/VITA-Group/DP-OPT

ICLR2024论文合集:

希望这些论文能帮到你!如果觉得有用,记得点赞关注哦~ 后续还会更新更多论文合集!!

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)