手把手教你使用 MaxKB 和 Ollama 搭建本地专业知识库

另外MaxKB和Ollama的工作原理,我觉得大家可以稍微了解一下啊,不建议延伸太多,如果有兴趣想深入了解的,我建议自己去Google或bing上查相关的资料(最懒的去百度一下也行),我这里主要是记录如何操作的过程,而不是对使用工具的研究和工具背后的技术细节进行研究,我就是拿来主义,工具只要原理符合我们的需求,结合我们自己的机构化思维或结构布局,直接组合选择的一堆工具,它们集成到一起能运行就行了。

我想搭建本地专业知识库,虽然我对技术操作的细节有一定了解,但是搭建过程磕磕绊绊,为此我回忆操作过程,整理总结了一个清晰的操作过程文档。这个操作记录文档几乎是从零开始,一步步操作整个流程,是一个具体且可执行的操作方案,每一步都很清晰,降低了具体执行的操作门槛。方便初级玩家操作,一个使用开源工具搭建的详细步骤记录,讲如何一步步搭建本地专业知识库的

搭建本地专业知识库的核心需求是什么。是需要一个可以存储和检索知识的系统,同时这个系统应该能够利用AI模型提供智能化的功能,比如语义搜索、问答支持等。基于这个需求,我选择了MaxKB和Ollama这两个工具。MaxKB是一个开源的智能知识库平台,而Ollama是一个便于本地部署和运行大语言模型的工具。它们的结合正好可以满足知识库的核心需求:MaxKB负责知识库的管理和检索,Ollama负责提供AI模型的支持。

这里特别声明一下,大家基本上不需要了解Docker的细节,因为Docker只是一个工具,大家只需要知道如何安装和运行它即可。另外MaxKB和Ollama的工作原理,我觉得大家可以稍微了解一下啊,不建议延伸太多,如果有兴趣想深入了解的,我建议自己去Google或bing上查相关的资料(最懒的去百度一下也行),我这里主要是记录如何操作的过程,而不是对使用工具的研究和工具背后的技术细节进行研究,我就是拿来主义,工具只要原理符合我们的需求,结合我们自己的机构化思维或结构布局,直接组合选择的一堆工具,它们集成到一起能运行就行了。

废话说了很多,下面直接开始干活。

工具选择

1. MaxKB:一个开源的智能知识库平台,支持多模态知识库的创建和管理。

2. Ollama:一个便于本地部署和运行大型语言模型的工具。

3. Docker:用于容器化部署,简化环境配置。

步骤指南

1. 安装 Docker

下载 Docker:访问 [Docker 官网](https://www.docker.com/),下载匹配你操作系统的 Docker Desktop。

安装 Docker:按照安装向导完成安装。

2. 安装 MaxKB

1. 拉取 MaxKB 镜像:

bash命令:docker pull maxkb

2. 运行 MaxKB 容器:

bash

docker run -d -p 8080:8080 --name maxkb maxkb

-d:后台运行。

-p 8080:8080:将容器的 8080 端口映射到主机的 8080 端口。

--name maxkb:为容器命名为 maxkb。

3. 访问 MaxKB:

打开浏览器,访问 http://localhost:8080。

使用默认用户名和密码登录(通常为 admin 和 admin)。

3. 创建知识库

1. 登录 MaxKB:

打开 http://localhost:8080,使用管理员账号登录。

2. 创建知识库:

点击 知识库 ->创建知识库。

填写知识库名称和描述。

选择知识库类型(如 Markdown、PDF 等)。

点击 创建。

3. 上传文档:

在知识库管理页面,点击 上传文档。

选择需要上传的文档(如 Markdown 文件、PDF 文件等)。

点击 上传 按钮,等待文档上传完成。

4. 安装和配置 Ollama

1. 下载 Ollama:

访问 [Ollama 官网](https://ollama.ai/),下载适合你操作系统的 Ollama 安装包。

2. 安装 Ollama:

按照安装指南完成安装。

3. 运行 Ollama:

bash

ollama run

4. 配置本地私有模型:

在 MaxKB 的 系统管理 -> 模型设置 中,选择 Ollama。

设置 API 域名和端口(默认为 `http://localhost:11434`)。

5. 创建应用

1. 创建应用:

在 MaxKB 的 **应用管理** -> **创建应用** 中,填写应用名称和描述。

选择刚创建的知识库和本地模型。

点击 创建。

2. 访问 应用:

应用创建完成后,会生成一个本地访问链接。

打开浏览器,访问该链接。

6. 测试应用

1. 输入问题:

在应用页面,输入问题,查看回答。

确保回答中引用了知识库中的内容。

2. 调整和优化:

根据测试结果,调整知识库内容和模型参数。

优化查询逻辑和回答格式。

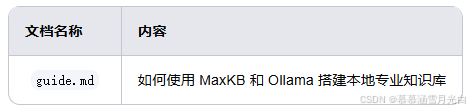

假设你已经上传了以下文档到知识库:

在应用页面,输入问题:

如何使用 MaxKB 和 Ollama 搭建本地专业知识库?

应用会返回:

要使用 MaxKB 和 Ollama 搭建本地专业知识库,可以按照以下步骤进行:

1. 安装 Docker。

2. 拉取 MaxKB 镜像并运行容器。

3. 访问 MaxKB 并创建知识库。

4. 上传文档到知识库。

5. 安装和配置 Ollama。

6. 创建应用并测试。

注意事项

确保网络连接:MaxKB 和 Ollama 需要网络连接来下载和更新模型。

定期备份:定期备份知识库和模型数据,防止数据丢失。

更新工具:定期更新 MaxKB 和 Ollama,以获取最新的功能和修复。

至此 搭建一个本地专业知识库就完成了,接下来我们就可以利用 MaxKB 和 Ollama 的强大功能可以开始进行知识管理和查询了

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~ 文章结束了

留个彩蛋,暂时先到这里,搭建后在使用中可能会发现,本地大模型在加上本地知识库后,可能会一本正经的乱说,这里先埋伏一下啊,欢迎碰到同样问题的同学们来留言

知识库搭建后,如何让大模型更精准的结合本地知识库来回答问题呢?这个是需要精加工的,后续再讲

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)