图文详解:如何设计一套高并发、强一致的电商订单系统?

在功能层面,从订单创建时的「防超卖、防重复下单」,到支付环节的 「安全传输、状态一致」,再到取消时的 「库存精准释放」,每个功能点的设计都直面高并发下的核心痛点,且方案并非一成不变,比如库存控制会根据 "日常销售" "秒杀活动" 场景差异适配不同方案,兼顾性能与可靠性;只有 「待支付」 的订单能取消,要是已经付了钱,就得走售后流程。最后是库存锁定,为了防止 "用户下单了,库存被别人抢走" 的尴尬,

订单系统到底在电商体系里扮演什么角色?

它不仅仅是简单记录买卖关系的工具,而是串联商品、支付、物流、用户的核心连接器 — 用户通过它完成交易,商家通过它履约,平台通过它实现营收。

今天牛哥就来拆解下,一套高并发、强一致的电商订单系统,到底是怎么搭建出来的。

1

核心流程拆解

要搞懂订单系统的核心流程,先想清楚三个问题:

1. 正常情况下,一笔订单从下单到交易完成,怎么实现?

2. 要是遇到用户取消订单、收到货想退货这类意外情况,该怎么处理?

3. 订单的状态能怎么变、不能怎么变?

其实这三个问题,刚好对应订单系统的三大核心逻辑:

第一个问题关联 "正向流程",第二个对应 "逆向流程",第三个则是 "状态流转规则"

搞明白这三点,订单系统的核心脉络就通了,下面我们就详细拆解这三部分的具体流程。

正向流程

电商订单的正向流程,本质是"用户下单→支付→商家发货→用户收货→交易成功"的完整履约链条

1. 下单环节

用户选完商品点击「提交订单」,系统需要完成一系列看不见的工作。

首先要做商品校验,系统会立刻调用商品服务,查商品是不是还在售、选的颜色尺寸有没有货。

其次是进行价格计算,最终付款金额不是拍脑袋定的,得精准算清楚 「基础价 + 活动价(满减 / 折扣)- 优惠券 - 积分抵扣」,毕竟涉及钱的事,一分钱都不能差。

最后是库存锁定,为了防止 "用户下单了,库存被别人抢走" 的尴尬,系统会先 「预扣库存」,同时给订单设个 15-30 分钟的支付有效期,超时自动释放,绝不浪费资源。

最终整个下单链路清晰可溯:

用户选品 → 确认地址 / 优惠券 → 提交订单(商品校验、价格计算)→库存锁定→生成待支付订单

2. 支付环节

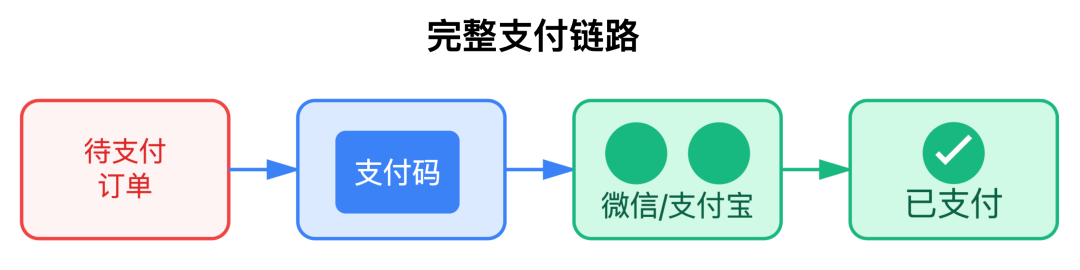

支付环节是 "钱货两清" 的关键,正常的支付流程需要经过三步衔接:

-

订单生成后,系统调用支付服务生成支付单,给用户抛个支付链接或二维码

-

用户通过第三方支付渠道(微信/支付宝)支付后,第三方支付会 “异步通知” 系统

-

系统收到通知后,先核对信息,再把订单状态改成 “已支付”,同时把之前预扣的库存 “正式扣掉”,避免库存算错。

这里有个经典问题:

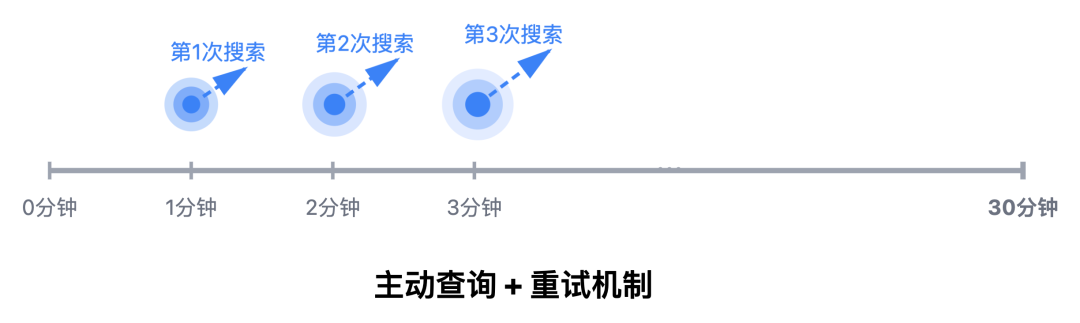

如果支付回调丢失了怎么办?总不能让用户付了钱,订单还显示 “待支付” 吧?

行业内通用的解决方案是设计主动查询 + 重试机制 — 支付服务每隔1分钟查询未支付订单的支付状态,如果第一次查询没结果,会继续重试,持续查询 30 分钟。确保不错过任何一笔支付结果。

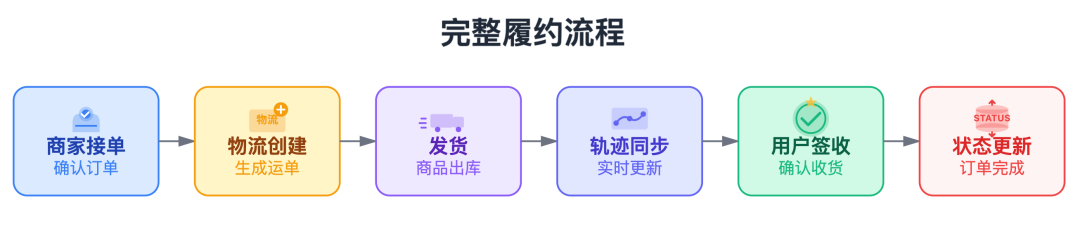

3. 履约环节

订单支付后,就进入商家履约阶段。这个环节的核心是状态透明化 — 用户需要知道订单到哪了,商家需要跟踪物流进度,平台需要确保履约时效。

完整的流程如下:

商家接单→物流创建→发货→物流轨迹同步→用户签收→订单状态更新

这里最关键的是 「状态同步的实时性」,尤其是生鲜等时效性要求高的商品,用户对物流进度的敏感度远高于普通商品。

履约完成,整个正向流程才算真正结束。

逆向流程

没有任何系统能保证 100% 正向流转,用户下单后突然不想买了、收到货不满意想退,这些都是常态。设计逆向流程,就是解决这些问题。

逆向流程主要分 「取消流程」 和 「售后流程」 两类。

取消流程

订单取消的核心目标很简单:释放锁定的库存,把订单状态改成 “已取消”,别占着资源不放手。

主要有两种场景:

-

用户主动取消:前端发起请求后,后端会先验订单状态。只有 「待支付」 的订单能取消,要是已经付了钱,就得走售后流程。确认能取消后,调用库存服务释放预扣库存,再更新订单状态。

-

超时自动取消:系统会跑定时任务,筛选出 「待支付」 且超过时效的订单,批量执行 「释放库存 + 改状态」 的操作。

售后流程

售后是电商纠纷的高发区,设计时要兼顾用户体验和商家权益。典型的售后流程包括:

-

用户发起售后申请(退货/退款/换货),提交原因和凭证

2. 商家审核(通常24小时内),审核通过后生成退货地址

3. 用户寄回商品,填写物流单号

4. 商家签收验货,确认无误后触发退款(调用支付渠道退款接口)

5. 退款到账后,订单状态更新为「售后完成」

这里的技术难点是退款状态的一致性 — 如果退款接口调用失败怎么办?

一般会设计重试机制,同时记录退款日志,要是重试失败,还能人工介入处理,绝不让用户 "退个款等三天"。

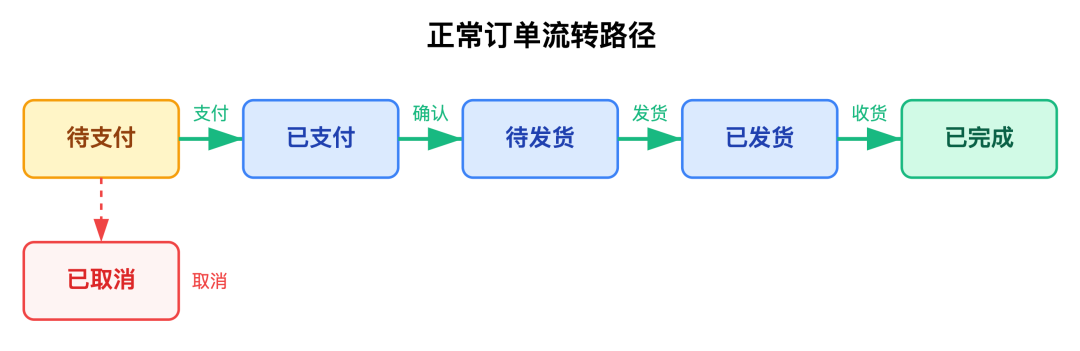

关键状态流转

订单的核心状态可归纳为八大类,分别是待支付、已支付、待发货、已发货、已完成、已取消、售后中、售后完成。

无论是取消还是售后,都会涉及订单状态的变更。如果状态变更没有规则约束,很容易出现 「已取消订单又变已支付」、「已完成订单回退待发货」 的混乱,因此必须明确状态流转规则。

待支付只能转为已支付或已取消,不能直接跳转到已发货 ,已发货只能转为已完成或售后中,不能回退到待发货

为什么要这么严格?举个例子:如果允许「已取消」订单转为「已支付」,可能导致用户重复支付;如果「已完成」订单直接取消,会造成财务对账混乱。

通过以上梳理,我们已经清楚了 "订单该怎么走、状态该怎么变"。接下来就聚焦技术层面,看看支撑这套流程运转的核心功能实现。

2

核心功能实现

订单系统的核心功能紧扣 "订单全生命周期",覆盖了从创建到完成的每个环节。每个功能都有其独特的技术挑战,解决这些问题才能构建出稳定可靠的订单系统。

1. 订单创建功能

订单创建是交易的起点,看似只是用户点一下按钮,实则是系统最复杂的环节 — 要在毫秒级内完成多系统协同,还得防住 “超卖”“重复下单” 这些坑。

难点1:库存竞争与超卖问题

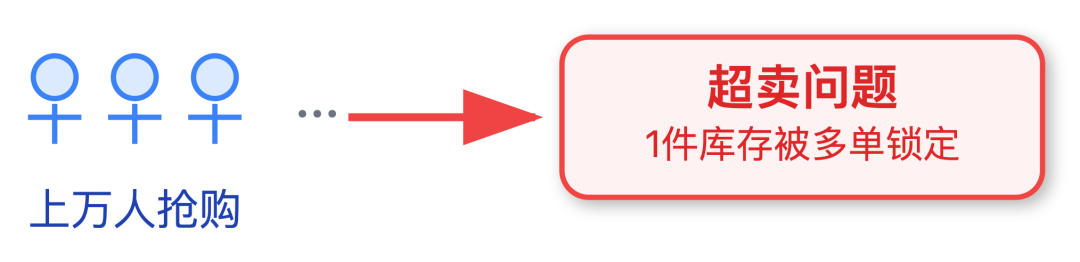

秒杀、促销时,经常出现上万人抢几百件库存的情况,要是库存控制没做好,很容易出现 「1 件库存被多单锁定」 的超卖问题。

早期很多系统靠 「数据库事务 + 行锁」 来防超卖,虽然能保证数据一致,但到了 10 万级并发,这种方式会导致大量请求阻塞,甚至引发数据库死锁。现在更优的方案是分场景适配:

日常销售用 Redis 预扣 + 数据库兜底

用户下单时,先调用 Redis 的 DECR 原子操作快速扣减库存 — Redis 是单线程模型,天然能防并发冲突;扣减成功后,再通过异步任务把库存变动同步到数据库里存好。要是 Redis 突发故障,立即切换回数据库行锁,保证库存不超卖。

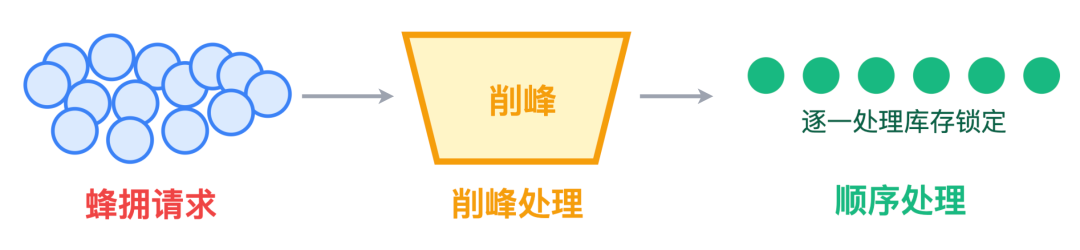

秒杀活动得额外加消息队列削峰

活动开始前,先把商品库存同步到消息队列里,用户的下单请求过来后先排队,系统按顺序逐一处理库存锁定,避免 “蜂拥式” 请求冲垮数据库。

而且活动开始前 10 分钟还会把库存数据预热到本地缓存,减少数据库查询压力。

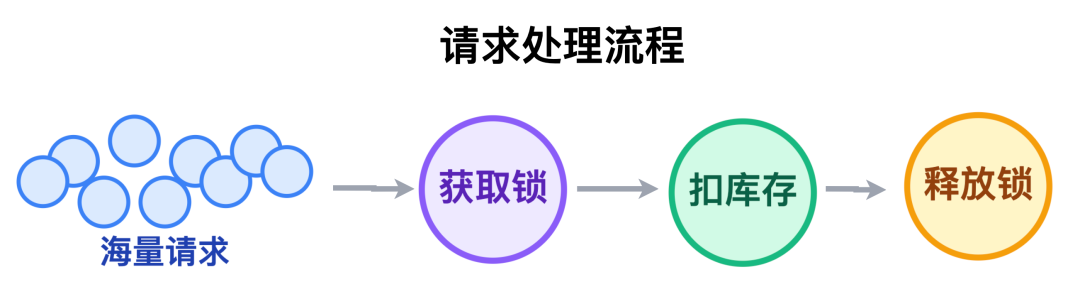

要是遇到双十一零点这种极致并发场景,还会用 Redisson 做分布式锁

给每个商品 ID 配一把锁,请求要先拿到锁才能扣库存,确保同一时间只有一个请求操作该商品库存。

难点2:重复下单问题

分布式环境里,重复下单特别常见,比如用户快速点两次 “提交订单”、网络延迟导致请求重试,甚至支付回调重复触发,都可能造出多笔相同订单。现在成熟的方案是三层防护:

-

前端先做基础拦截:按钮点完后置灰 3 秒,不让用户重复点;同时生成一个唯一的 UUID 跟着请求去后端,后端遇到相同 UUID 的请求直接拦掉。

-

后端再加幂等校验:把 「用户 ID + 商品 ID + 下单时间戳」 拼成一个唯一的 "防重键",请求到了先查 Redis 里有没有这把键,有就是重复请求,直接返回已有的订单 ID;没有就把键存进 Redis,设 5 分钟过期,再继续走订单创建流程。

-

最后数据库做底层兜底:在订单表上,给 「用户 ID + 商品 ID + 下单时间(精确到秒)」 建个联合唯一索引。就算前面两层没拦住,数据库也会因为唯一约束,拒绝插入重复的订单数据,从根源上堵死重复下单的可能。

难点3:多服务协调的数据一致性挑战

订单创建涉及商品、用户、优惠券、库存等多个服务,任何一个环节失败都可能导致数据不一致。例如商品校验通过了,但库存锁定失败,此时需要回滚所有已完成操作。

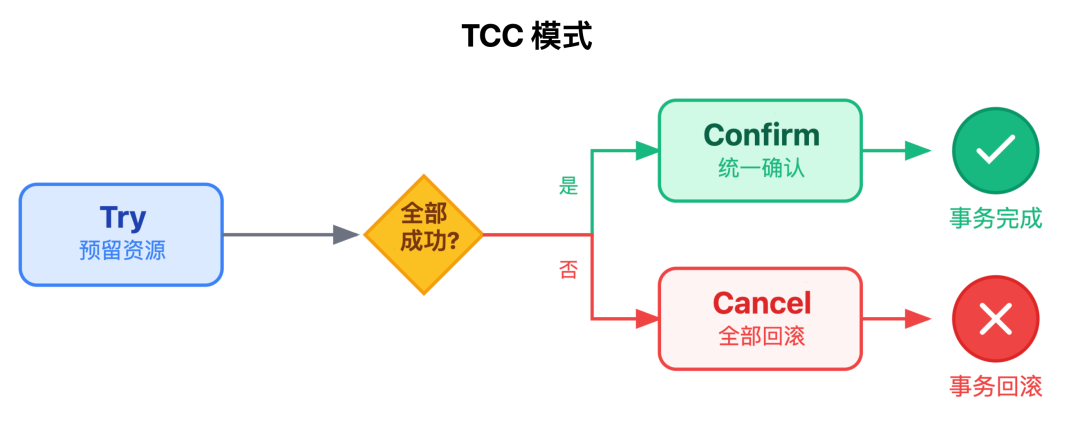

现在都用 TCC 模式解决:每个服务都有 Try、Confirm、Cancel 三步。

只有所有服务的 Try 都成功了,才会统一执行 Confirm;只要有一个 Try 失败,就触发所有服务的 Cancel,全量回滚。

比如库存服务,Try 就是「先把库存预扣下来」,如果所有服务 Try 都成功,Confirm 就是「确认扣减库存」,要是有其他服务 Try 失败,Cancel 就是「把预扣的库存放回去」。

2. 订单支付功能

订单支付功能是连接用户资金与平台交易的关键枢纽,核心要求是「安全、及时、准确」。

安全层面,必须用 HTTPS 加密传输,同时做签名验证 — 每笔支付请求都带个签名,系统收到后先验签名,防止支付信息被篡改

再讲及时与准确层面,这俩问题往往绑在一起。支付流程里最头疼的就是两种异常:

1. 用户付了钱,订单却还显示 「待支付」,这大多是第三方支付的回调丢了;

2. 用户没付钱,订单却误标 「已支付」,通常是重复回调导致的。

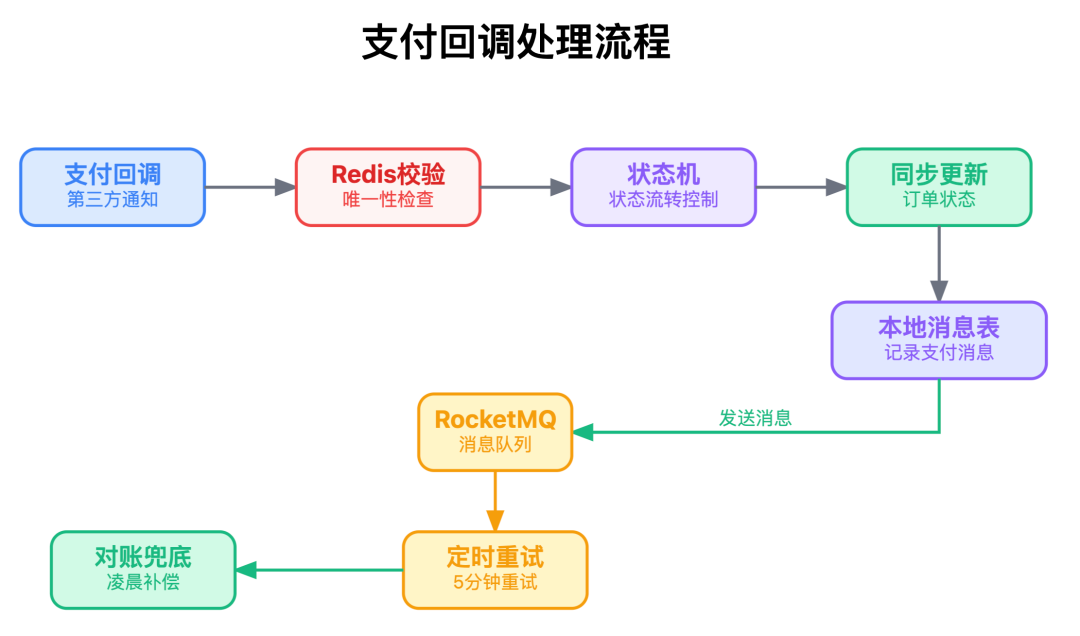

早期这些问题的解决大多靠回调通知,但是遇到网络波动就容易出问题,现在 「状态机 + 本地消息表」 的方案已经很成熟。

首先,当支付回调(第三方通知)抵达后,做 Redis 回调唯一性校验 — 支付渠道发回调时,先查 Redis 里有没有 「订单号 + 支付流水号」 的记录,有就说明是重复回调,直接拦掉;没有才继续处理;

接着,用状态机划定订单状态的 "流转边界" — 「待支付」 只能改成 「已支付」 或 「已取消」,不能跨状态乱变;

然后,校验通过后,同步更新订单状态并记录消息 — 先把订单状态更改为 「已支付」,再往本地消息表里存一条 「支付成功」的记录,包含订单号、金额这些关键信息;

之后把消息发到 RocketMQ,通知库存扣减、用户积分增加;要是消息没发出去,本地消息表的定时任务会每 5 分钟重试一次;

最后通过对账做 "兜底补漏" — 每天凌晨还会做订单表和支付表的对账,要是发现「已支付」的支付记录对应着「待支付」的订单,就触发补偿任务更新订单状态,确保钱和订单状态能对上。

3. 订单查询功能

订单查询功能看似简单,实则是性能优化的 "重灾区"。用户和客服都会频繁查询订单,查询性能直接影响体验。优化可从三个方向入手:

-

缓存热点订单,比如用户最近30天的订单,采用Redis存储,Key设计为"user:{userId}:orders";

-

分库分表后确保查询路由精准,例如按用户ID哈希分库,查询用户订单时可直接定位到目标库;

-

复杂查询走只读库,减轻主库压力。

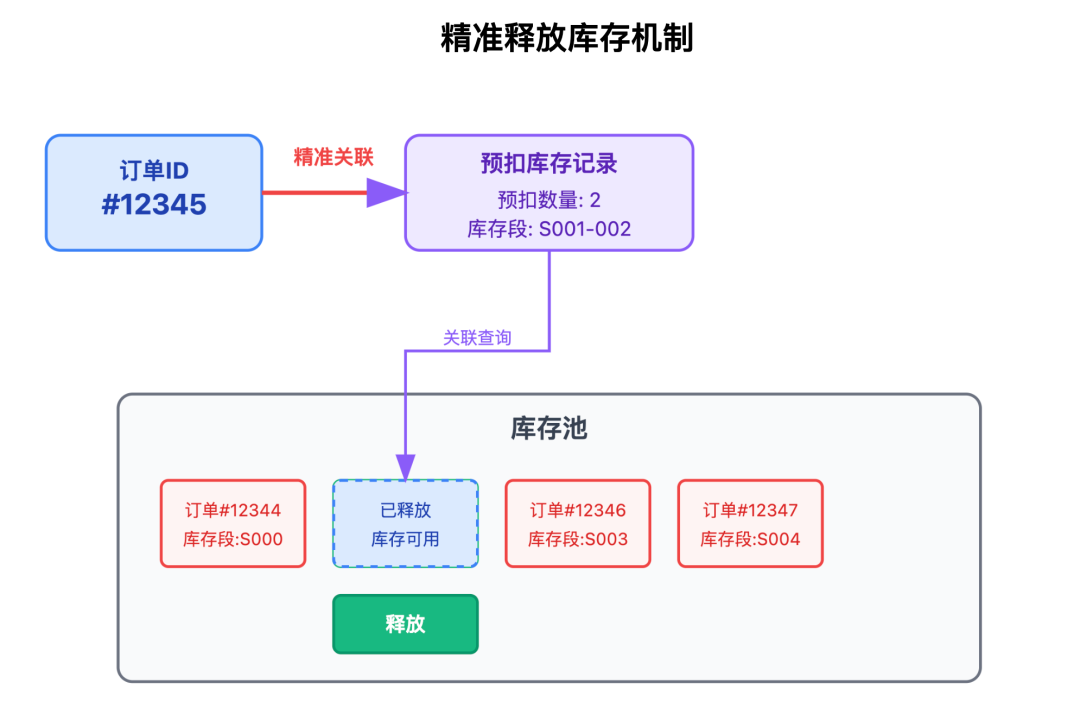

4. 订单取消功能

订单取消功能不只是改个状态那么简单,关键是要把预扣的库存、冻结的优惠券准确释放。

尤其是「超时关闭」场景,高并发下很容易出现 「库存没释放占着资源」「优惠券冻结后没法用」 的问题。

现在业内通常用 「延迟消息 + 定时校验」双机制解决:

生成待支付订单时,会同步发一条延迟消息到 RocketMQ,延迟时间就设为订单超时时间,消息里带着订单号;

等延迟消息到期后,系统会先查订单状态,要是还没支付,就执行关闭逻辑 — 把订单状态改成 「已取消」,调用库存服务释放预扣库存,同时给用户发取消通知;要是已经支付,就直接忽略这条消息。

光靠延迟消息还不够,怕消息队列故障丢消息,还会额外加个定时任务,每 10 分钟执行一次:专门扫描 「待支付」 且超过时效的订单,重复执行关闭和库存释放逻辑,相当于加了道双重保险。

另外,释放库存时也有讲究,通过订单 ID 精准关联到当初预扣的库存段,确保释放的是这个订单对应的库存,不会误放其他订单锁定的库存,避免出现新的库存混乱问题。

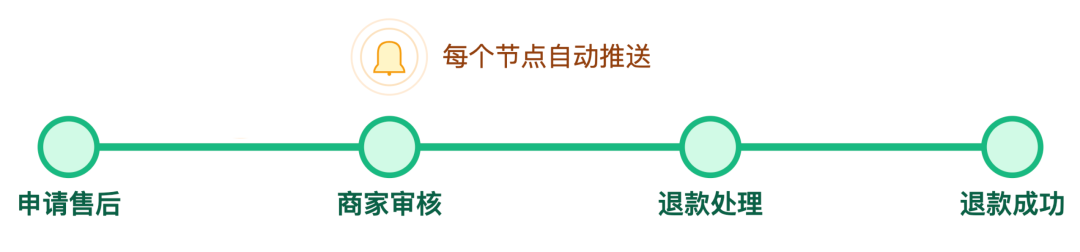

5. 售后处理功能

售后功能的核心是不让用户猜进度,同时减少客服的人工操作。

用户申请售后,要能清晰看到 “商家审核中 → 退款处理中 → 退款成功” 的进度,每个节点都自动发通知,不用用户反复问客服。

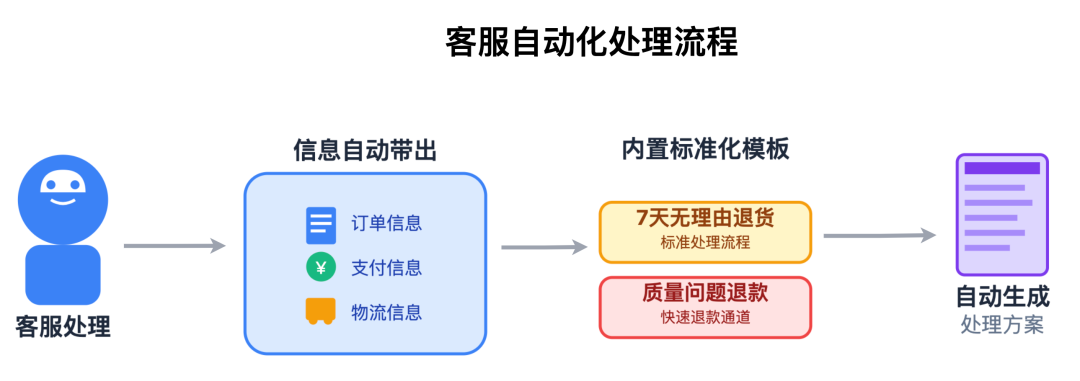

客服处理时,系统要自动带出订单、支付、物流信息,不用手动查;对 “7 天无理由退货”“质量问题退款” 这些常见场景,内置标准化模板,客服选个场景就能自动生成处理方案,不用每次都从头写。

另外,还要解决 「退款状态一致性」 的问题 — 调用退款接口超时,但实际钱已经退了,这种情况很常见。

现在靠 「退款流水记录 + 定时对账」 解决:

发起退款时先记流水,状态为 「处理中」,接口返回后更新状态;要是超时,每 3 分钟查一次支付渠道的结果,直到拿到明确状态;每天凌晨对比平台流水和支付渠道账单,发现不一致立刻补偿,确保用户能收到退款。

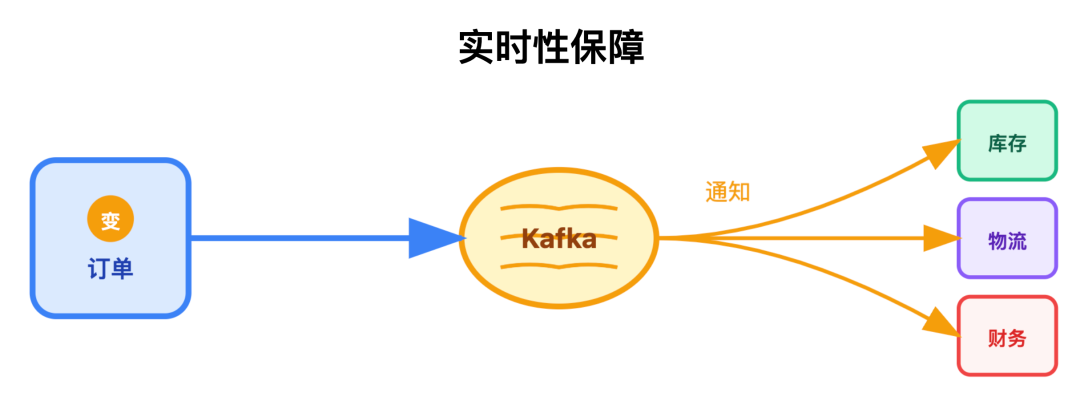

6. 订单状态同步功能

订单状态变了,库存、物流、财务系统得同步知道,不然就会出现 「订单显示已发货,物流系统还没创建运单」 的情况。核心要解决实时性和可靠性:

-

实时性:订单状态变更时,用 Kafka 异步通知关联系统,避免同步调用导致的性能瓶颈;

-

可靠性:Kafka 开启消息持久化,防止消息丢失;订单服务发完消息后,往状态同步日志表插一条记录;消费失败的消息先重试 3 次,还失败就移入死信队列,同时触发告警,让开发及时处理。

7. 订单数据统计功能

订单数据统计是连接技术和业务的关键,运营要知道 "当前订单量" "支付转化率",财务要 "日 / 月订单报表",这些数据不准,决策就会跑偏。实现时要区分实时统计和离线统计:

-

实时统计:用 Flink 从变更日志中计算,延迟控制在秒级,比如大促时实时显示 「当前下单量 10 万单」;

-

离线统计:用 Spark 每日批量计算,确保数据准确,比如生成 “上月订单报表”,供财务对账、运营分析。

3

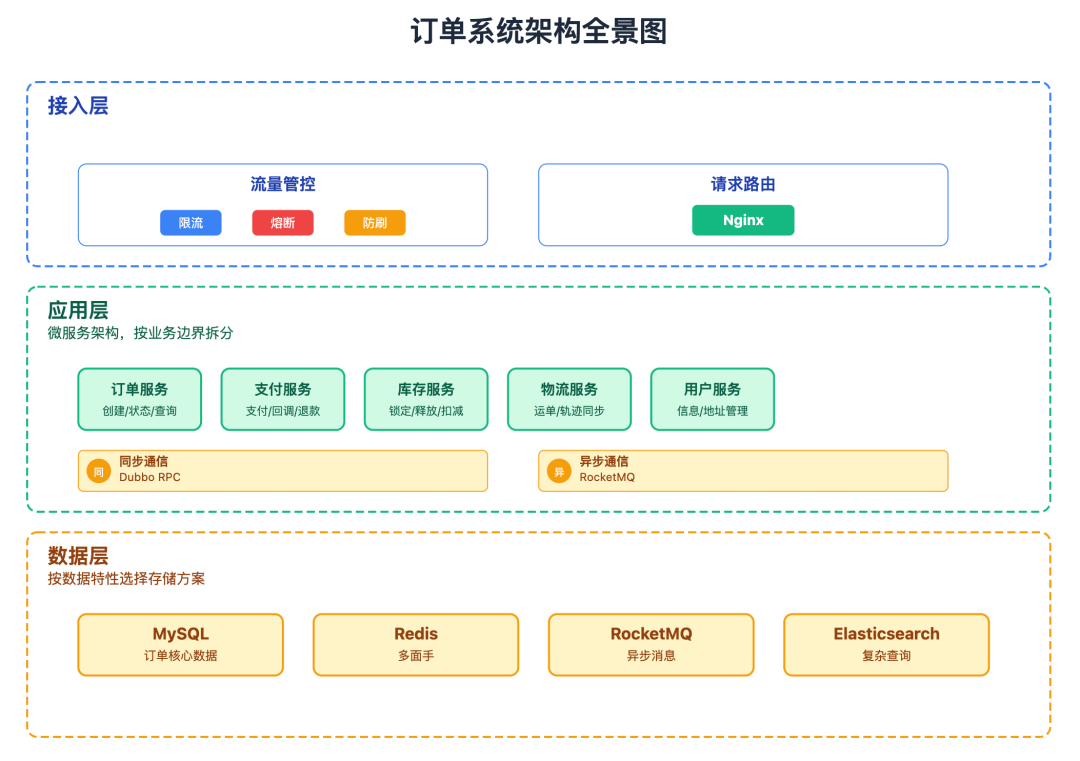

系统架构

架构设计的核心是分层解耦,订单系统的架构可以分为接入层、应用层、数据层,每层职责单一,协同工作。

接下来我们详细介绍这几层

接入层

接入层是用户请求的第一道关卡,核心职责是保护后端服务不被流量冲垮,主要做两件事:

1. 流量管控

1. 限流:用令牌桶算法,给不同接口设差异化阈值 — 下单接口每秒 10000 QPS,查询接口每秒 50000 QPS,避免单一接口过载;

2. 熔断:对接应用层服务健康状态,要是支付服务异常率超过 5%,立刻触发熔断,返回 "支付繁忙,请稍后再试",防止故障扩散;

3. 防刷:识别恶意请求特征,比如同一 IP 1 分钟内下 20 单、无用户信息的匿名请求,用 Redis 记录黑名单,直接拦掉恶意流量,别让刷子把库存刷光。

2. 请求路由

基于 Nginx 实现负载均衡,用 「round-robin + 权重」 策略分发请求。

大促时给订单服务分配更高权重,优先承载下单请求;要是某台应用服务器故障,自动把请求转发到其他健康节点,避免 "一个节点挂了,订单没法创建"。

应用层

应用层采用微服务架构,按业务边界拆分为独立服务,每个服务职责单一:

-

订单服务:核心服务,负责订单创建、状态更新、查询等

-

支付服务:对接第三方支付,处理支付回调、退款

-

库存服务:管理商品库存,提供锁定、释放、扣减接口

-

物流服务:对接物流公司,创建运单、同步物流轨迹

-

用户服务:提供用户信息、收货地址等基础数据

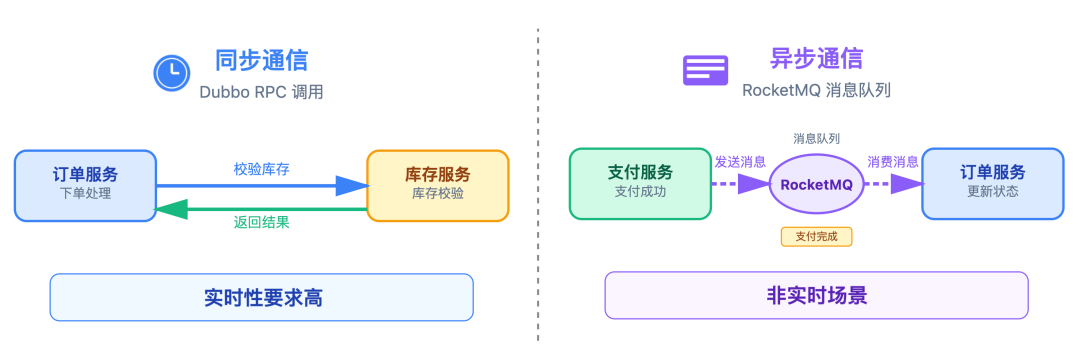

服务间通过两种方式协同:

-

同步通信:采用 Dubbo RPC 调用,适用于实时性要求高的场景,如下单时订单服务同步调用库存服务校验并锁定库存,确保 “库存不足时立即提示用户”;

-

异步通信:依赖 RocketMQ 消息队列,适用于非实时场景,比如支付成功后,支付服务发送 “支付完成” 消息

数据层

数据层的设计原则很简单:别把所有鸡蛋放一个篮子里,按数据特性选存储方案:

-

MySQL:存订单核心数据,例如订单表、订单项表,支持事务和复杂查询;同时按用户 ID 哈希分库分表,解决 「千万级订单查询卡顿」 问题

-

Redis:多面手,存热点订单、做分布式锁、记录幂等键,支撑高并发场景;

-

RocketMQ:存异步消息,比如订单创建、支付完成的事件,解耦服务;

-

Elasticsearch:专门解决复杂订单查询,比如按时间、金额、状态多维度筛选,比数据库查得快。

4

总结

最后,我们能清晰看到:一套稳定的电商订单系统,是流程、功能、架构 三者环环相扣。

在流程层面,正向链路需守住 「下单 - 支付 - 履约」 的闭环,逆向链路要解决 「取消 - 售后」 的异常兜底,尤其是严格的状态流转规则,避免了 "已取消订单误支付" "已完成订单回退" 等混乱场景;

在功能层面,从订单创建时的「防超卖、防重复下单」,到支付环节的 「安全传输、状态一致」,再到取消时的 「库存精准释放」,每个功能点的设计都直面高并发下的核心痛点,且方案并非一成不变,比如库存控制会根据 "日常销售" "秒杀活动" 场景差异适配不同方案,兼顾性能与可靠性;

在架构层面,接入层的流量管控挡住了恶意请求与流量洪峰,应用层的微服务拆分让订单、支付、库存等服务可独立扩容,数据层的多存储适配则让 核心数据存 MySQL、热点数据放 Redis、复杂查询靠 Elasticsearch,各取所长。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)