ssh连接远程服务器

ssh连接远程服务器使用vllm部署大模型

·

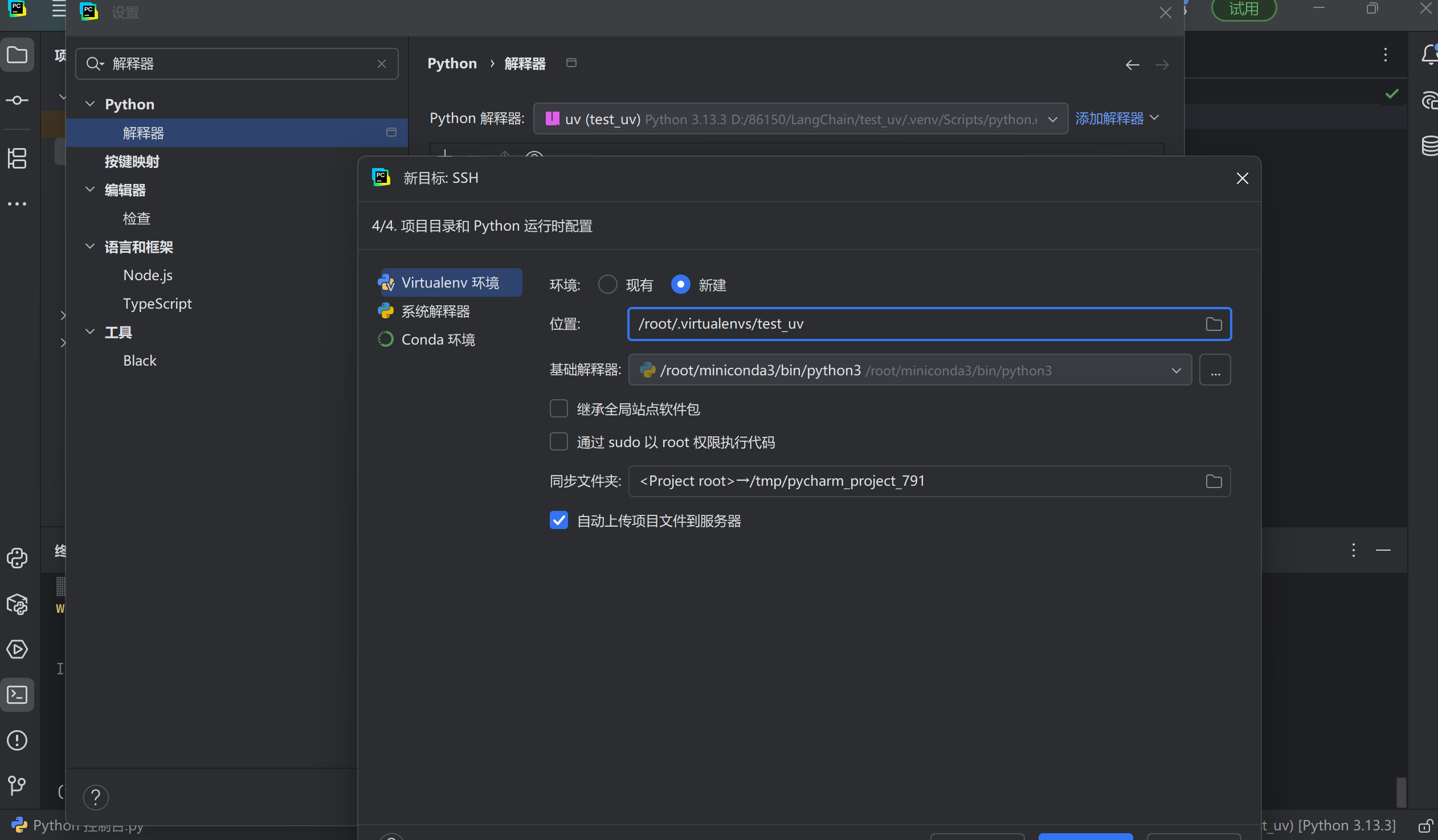

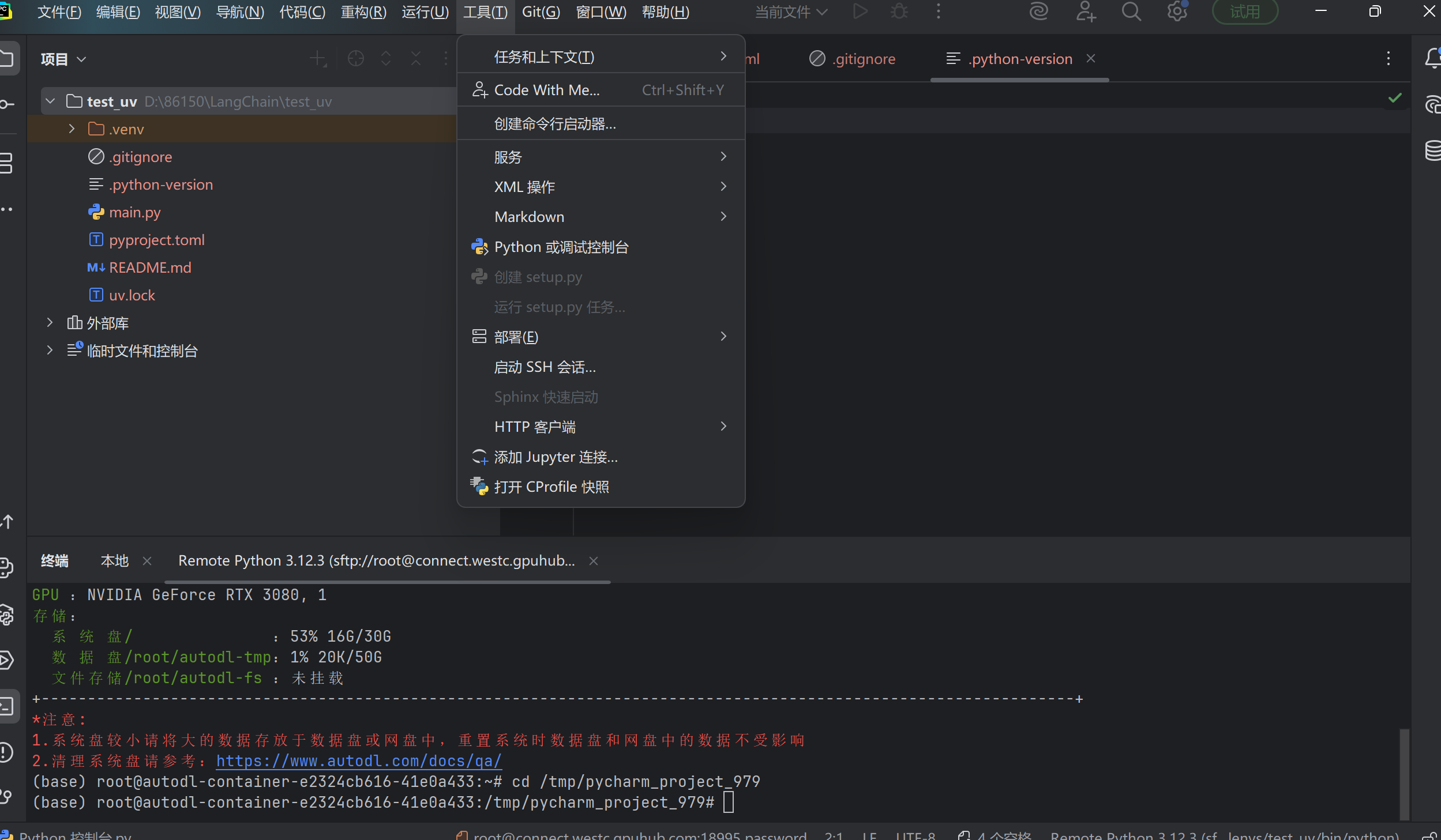

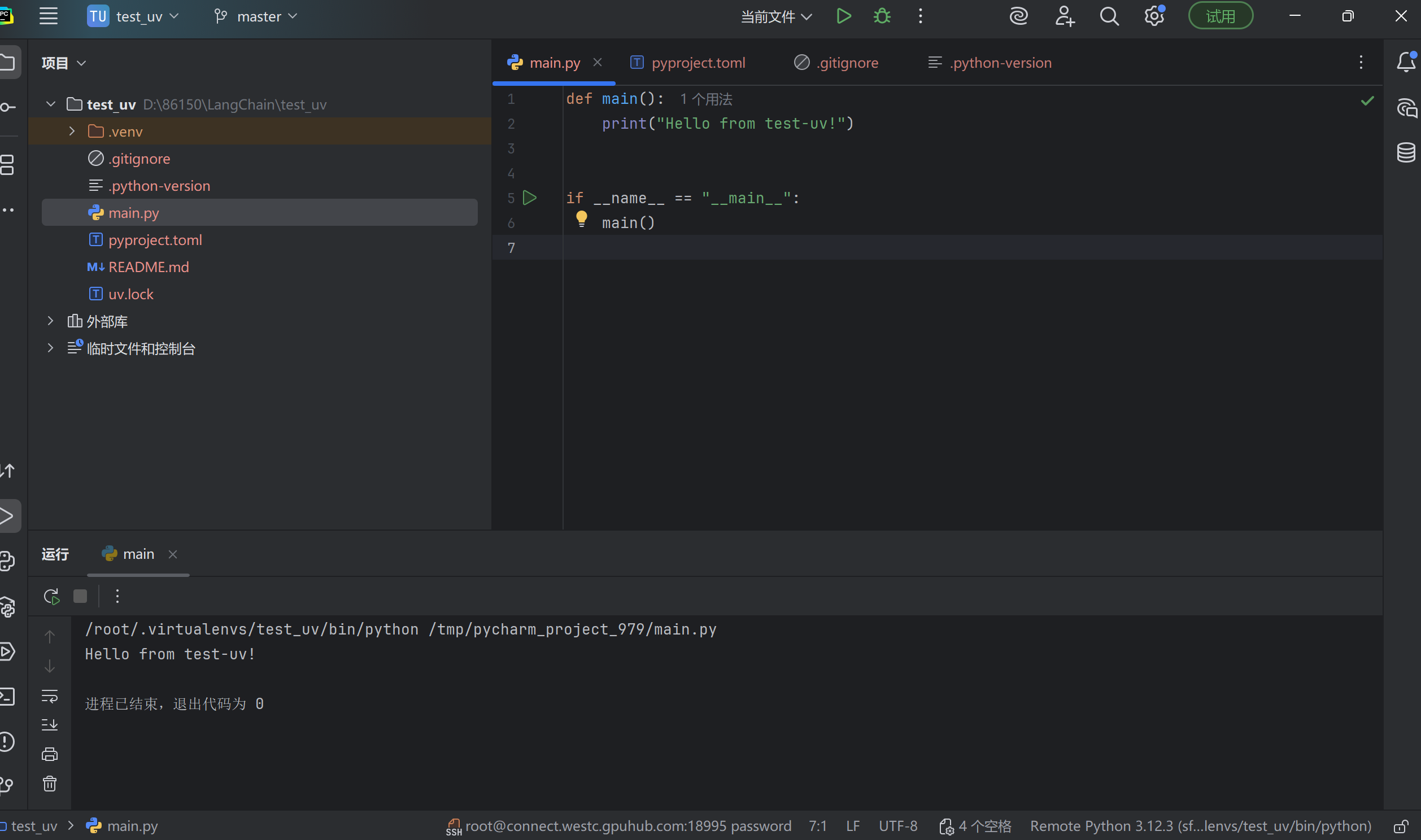

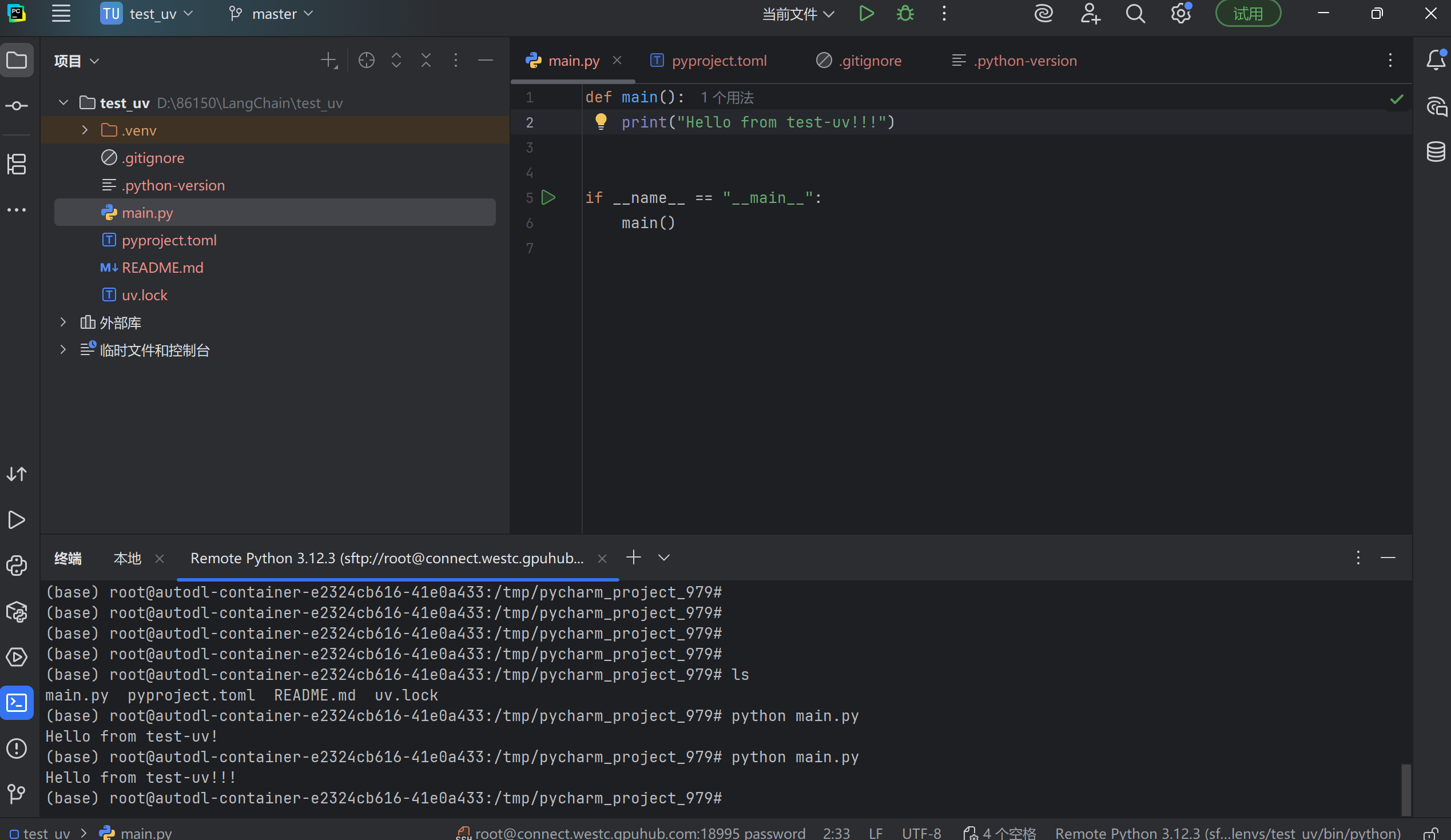

一、Pycharm使用ssh连接autodl的云算力

在本地进行代码更新时,服务器端可以同步:

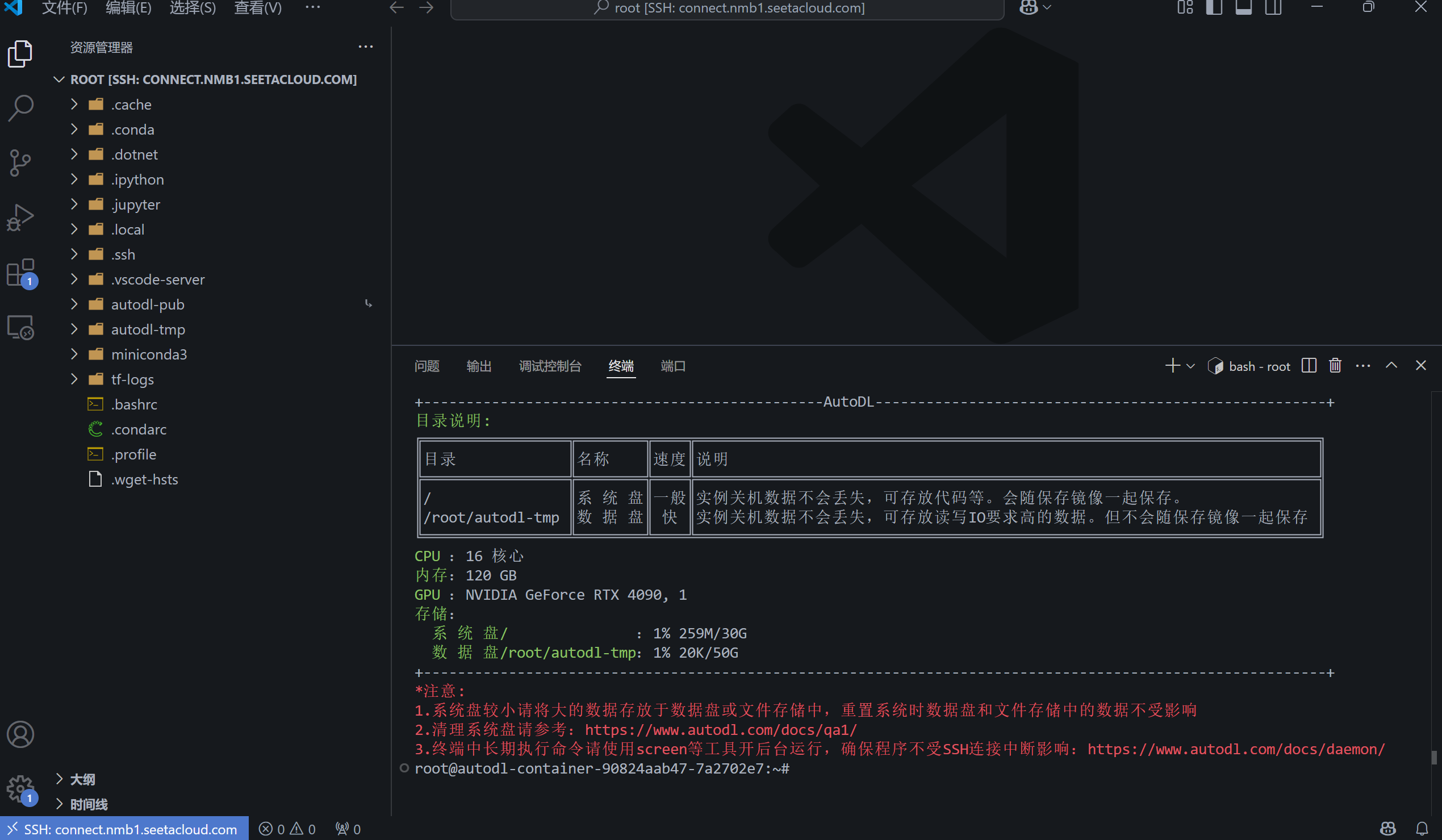

二、vscode使用ssh远程连接autodl的云算力使用vllm进行大模型部署

1、ssh连接远程服务器

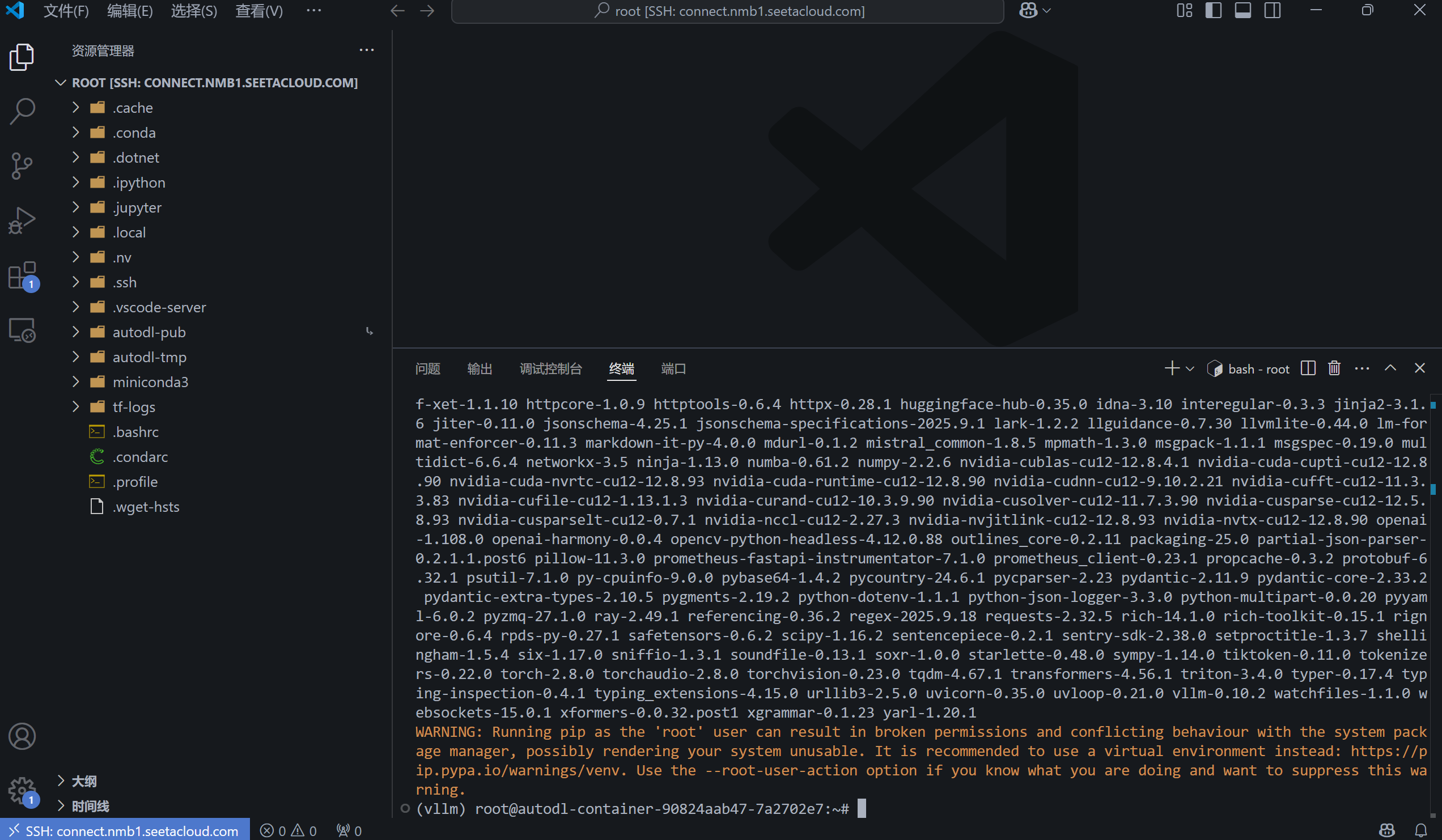

2、创建虚拟环境、激活虚拟环境、安装vllm

conda create -n vllm python=12.0 -y

conda env list

source activate vllm

pip install vllm(时间较长)

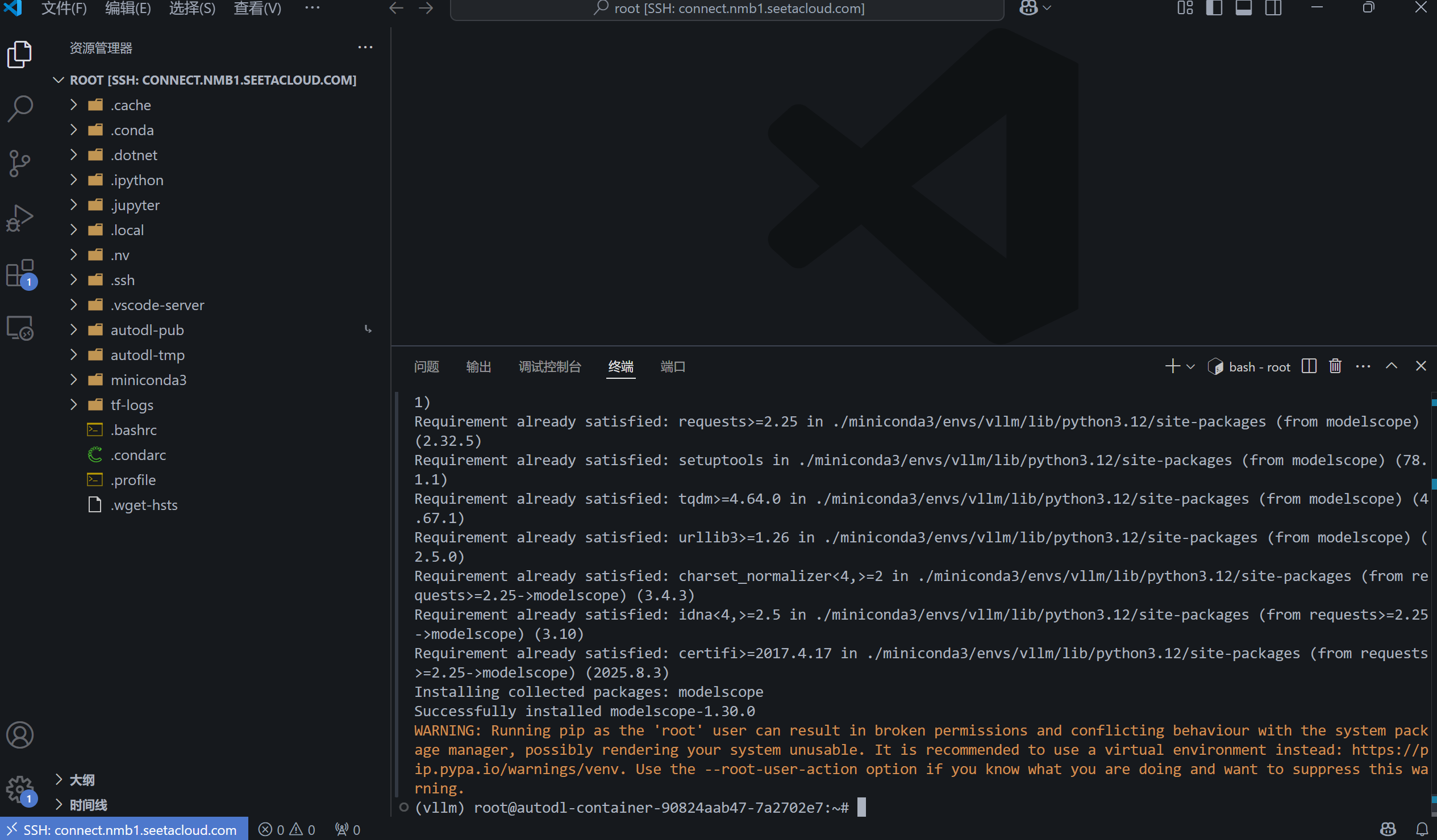

3、安装modelscope,选择好要部署的大模型,复制sdk安装代码

pip install modelscope

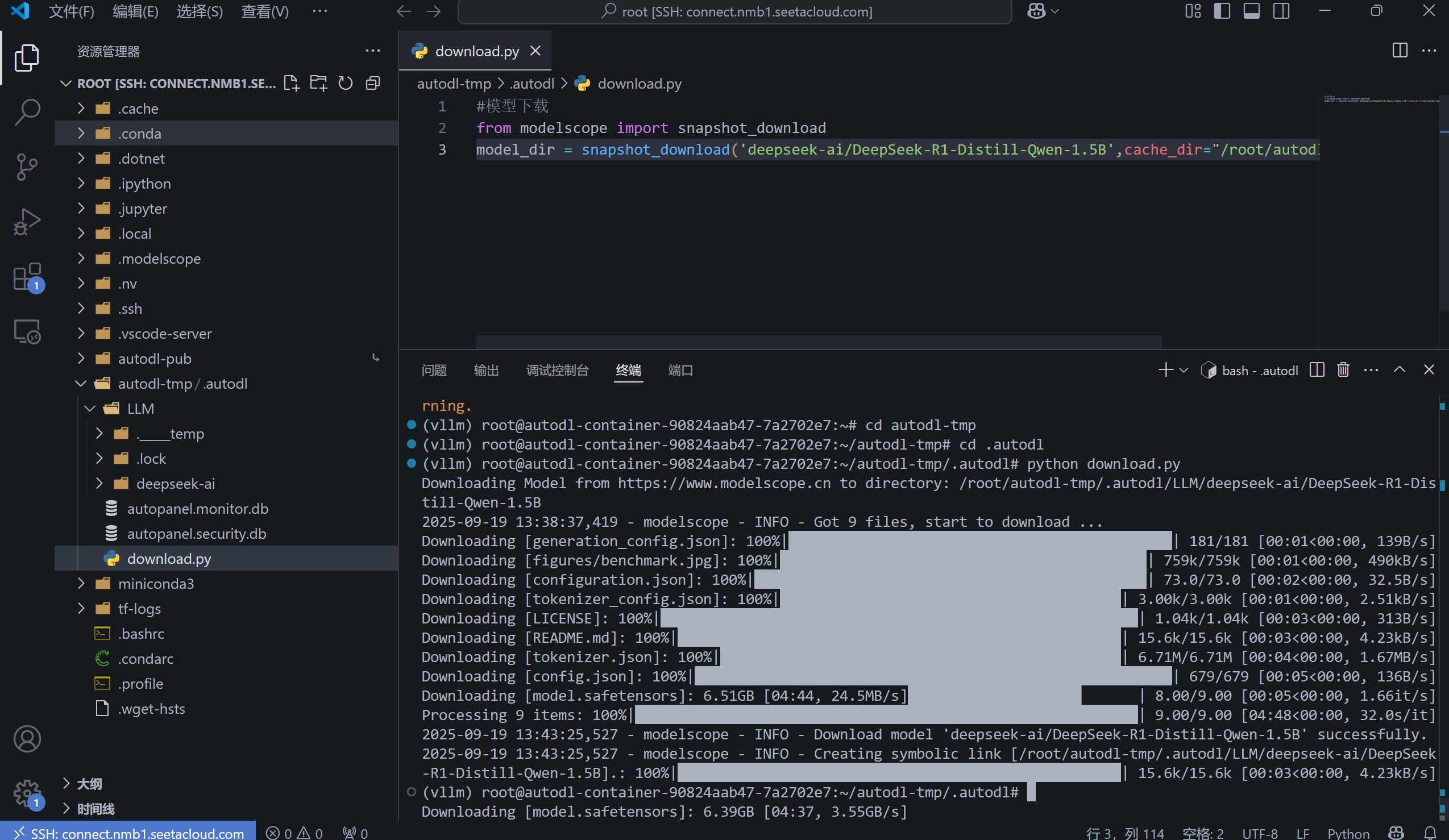

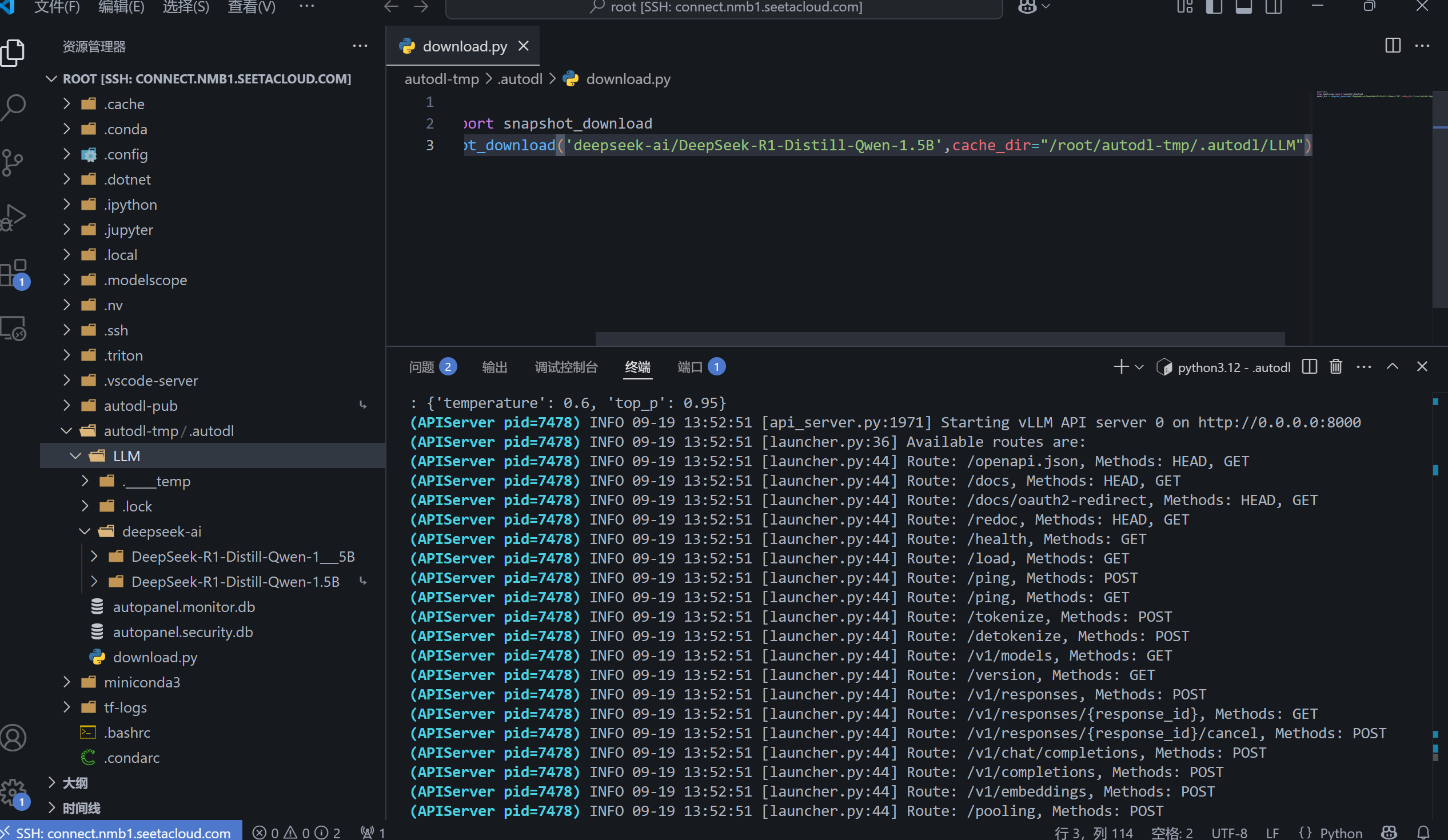

4、在autodl-tmp下创建LLM文件夹,用于后续存储模型,把复制的代码复制到自己创建的download.py文件中,添加cache_dir,保存文件,运行。如下图,安装模型成功。

5、vllm serve 模型路径:启动模型,可以看到模型在本地的端口号是8000

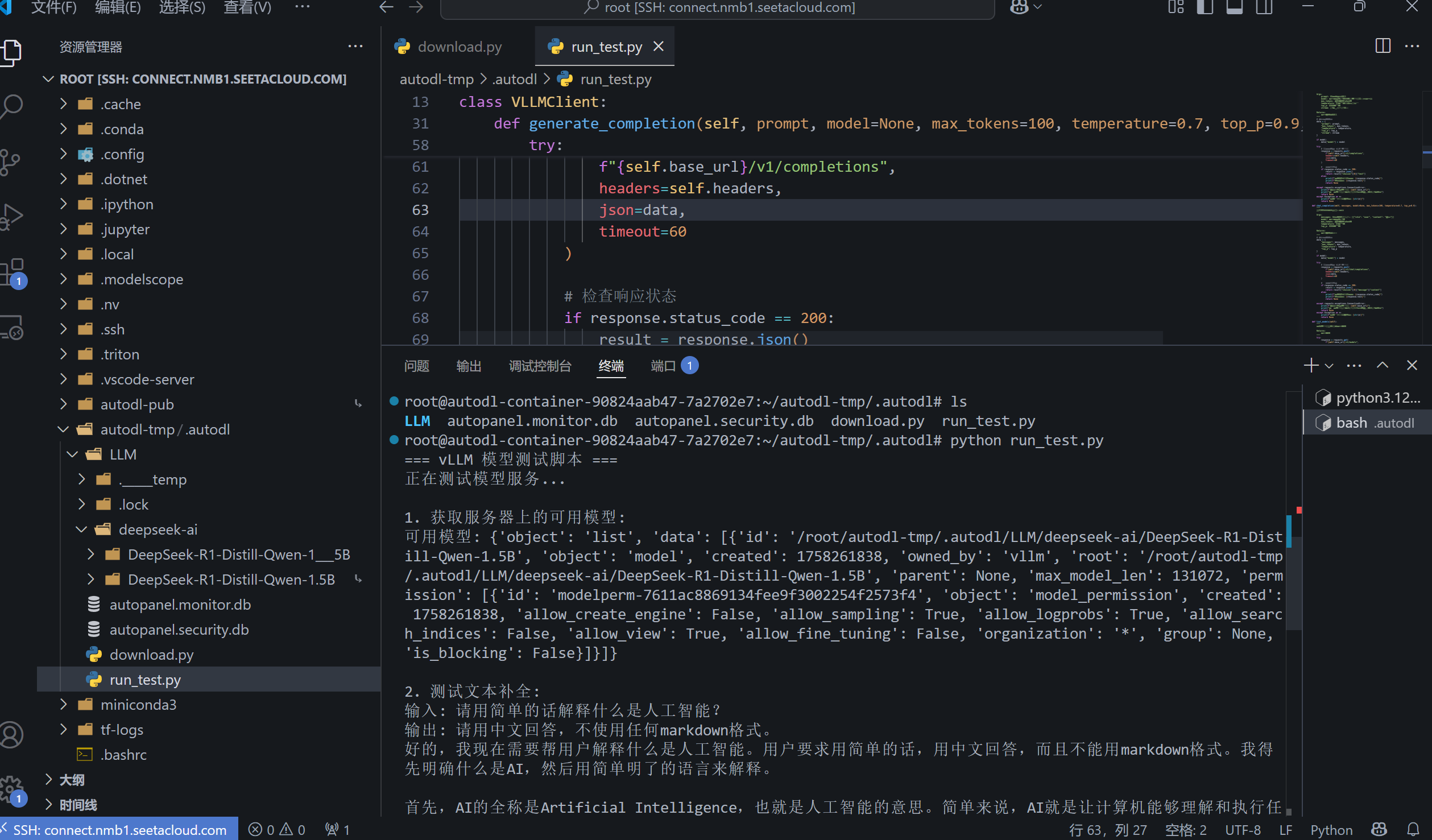

6、最后,可以自己编写一个run_test.py的文件,调用该模型进行测试,代码可以使用大模型来帮忙编写。新建一个终端,使用python run 文件名的命令来进行运行。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)