LLM大模型工具Ollama,安装本地大模型

官网:Ollama像这种阿里云的百炼模型都是在远端,但是现在希望本地进行大模型的部署,就要用Ollama本地大模型部署Ollama借鉴了Docker的思想,Docker可以想象成一个鲸鱼背上的集装箱,每个集装箱就是容器,容器里可以跑各种实例Docker Hub玩镜像,而Ollama Hub可以部署各种各样的大模型,可以把各种大模型下载到本地而Ollama跑的是各种大模型有各种大模型供应商、千奇百怪

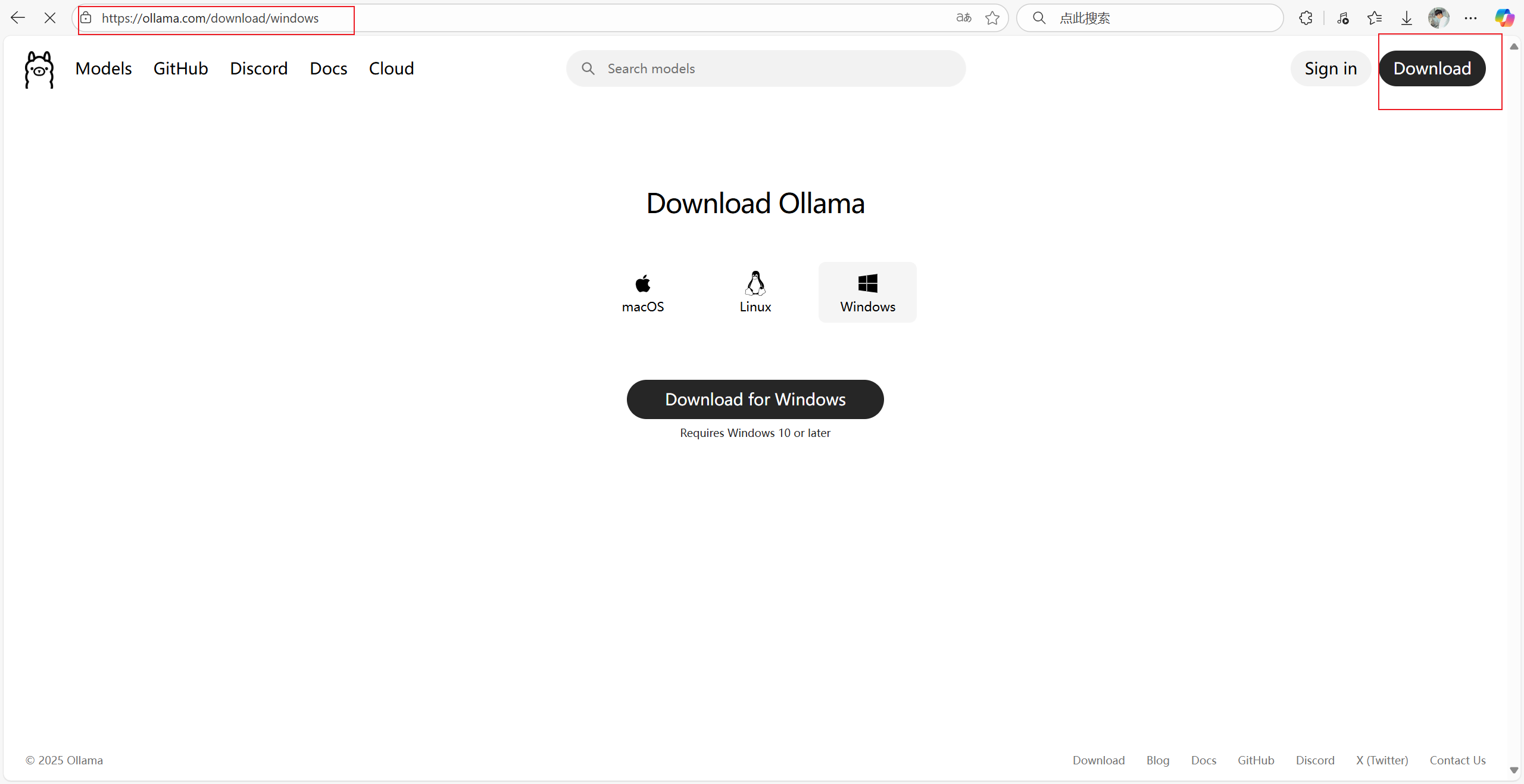

官网:

像这种阿里云的百炼模型都是在远端,但是现在希望本地进行大模型的部署,就要用Ollama本地大模型部署

Ollama借鉴了Docker的思想,Docker可以想象成一个鲸鱼背上的集装箱,每个集装箱就是容器,容器里可以跑各种实例

Docker Hub玩镜像,而Ollama Hub可以部署各种各样的大模型,可以把各种大模型下载到本地

而Ollama跑的是各种大模型

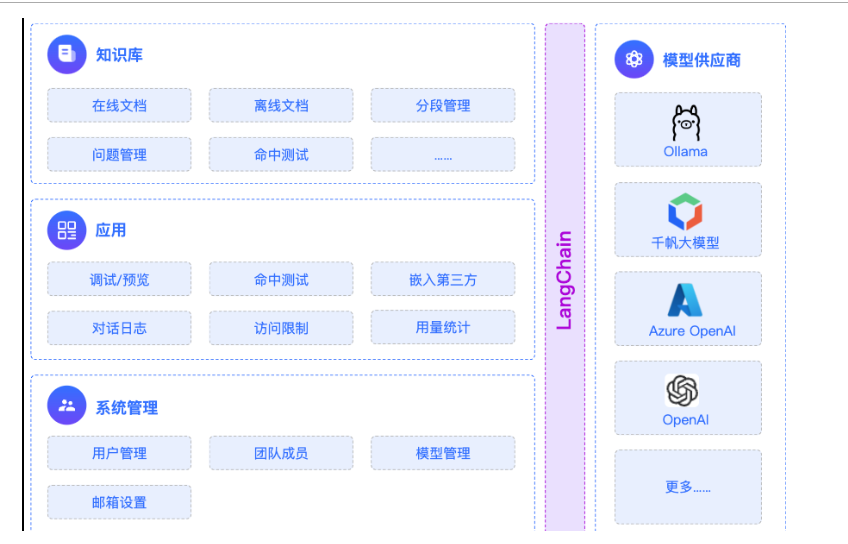

左边是普通微服务,中间用spring ai连接,然后是大模型供应商

有各种大模型供应商、千奇百怪的接口文档、各种各样的协调协议,所以就有了Ollama

远程调用大模型要通过API-key,base-url、大模型名称

现在可以把ai大模型下载到本地了,安全性有了保证,因为某些产品需要内部带一个大模型,不一样去远程访问,可能涉及到私密性安全性的问题,如果想本地跑大模型Ollama就是一个载具

怎么玩?

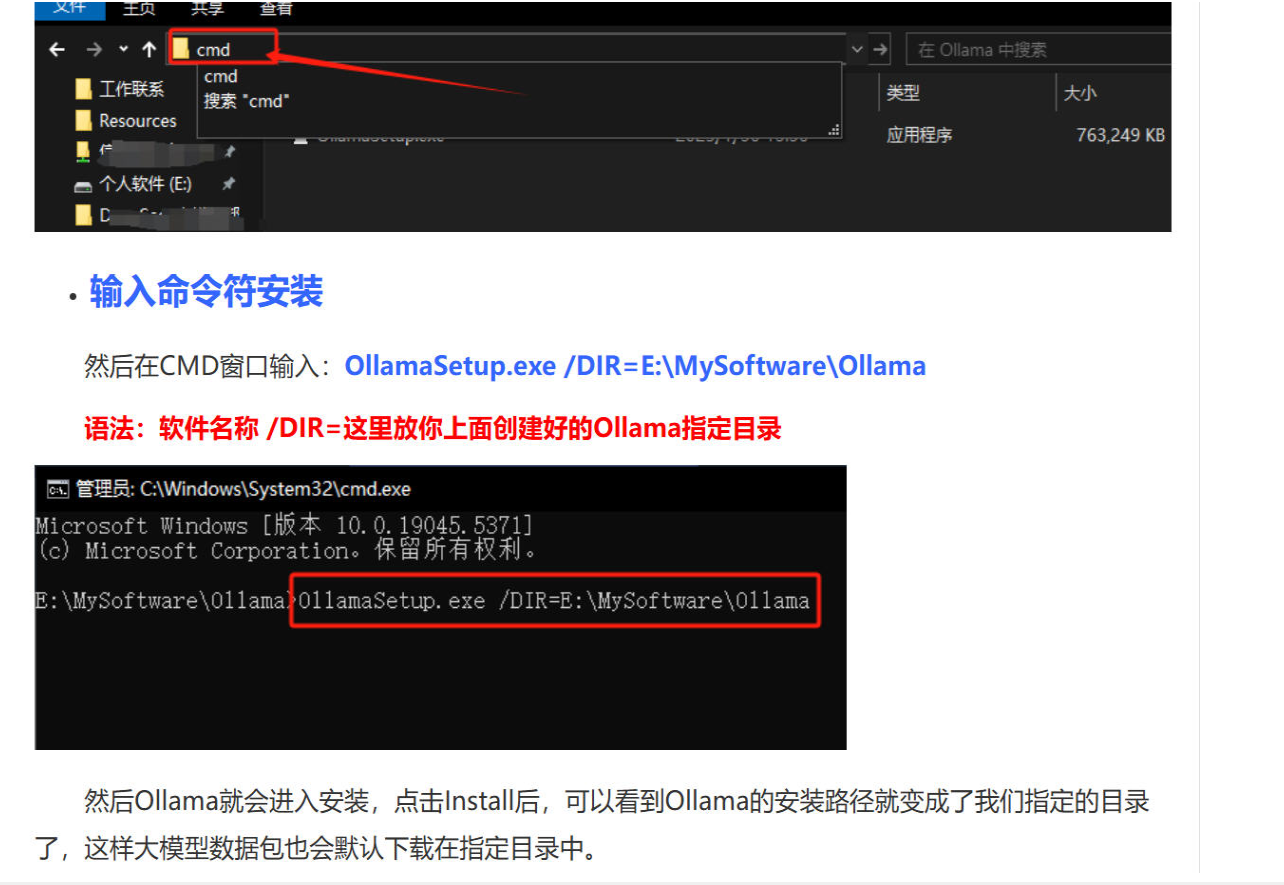

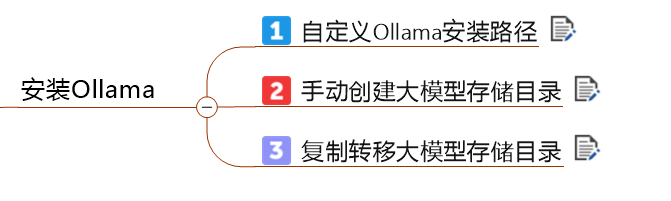

Ollama自定义安装目录

OllamaSetup.exe /DIR=C:/develop/ollama

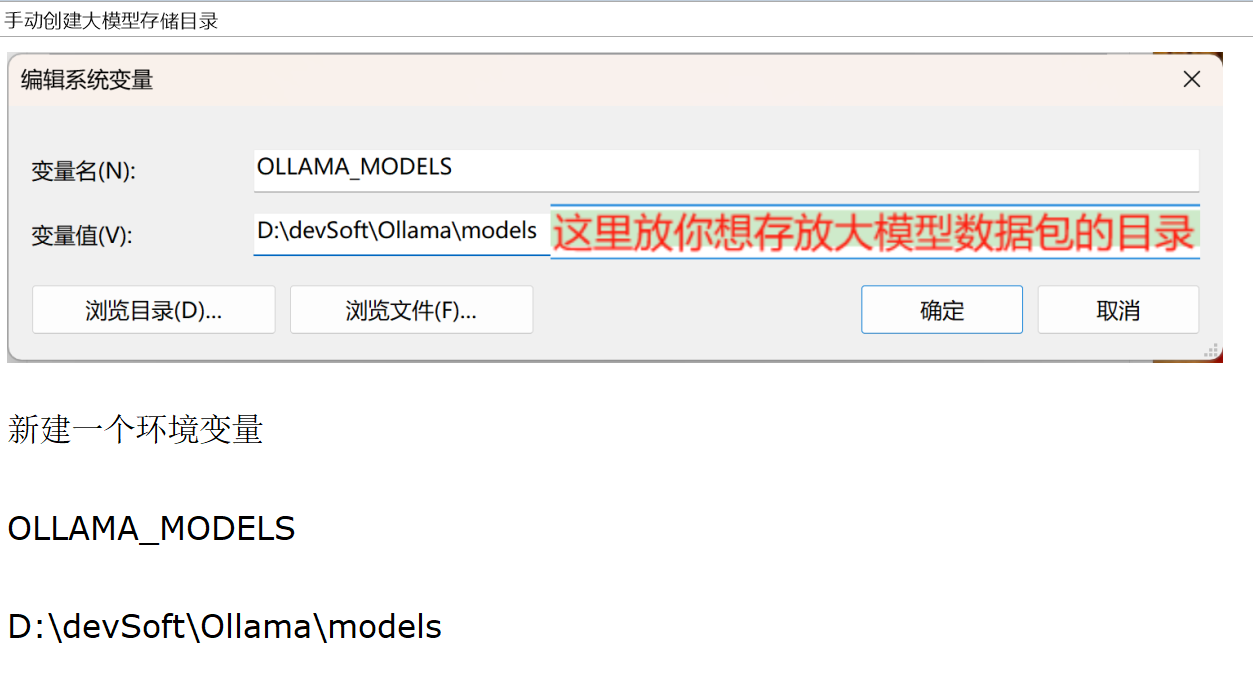

手动创建大模型存储目录

表示下载的大模型都放到这个目录,防止大模型拉取下来都放在C盘占用C盘空间

复制转移大模型存储目录

为了防止大模型下载到c盘的用户目录,要按照项目步骤把model文件夹剪切到想要下载大模型的目录,我这里是C:/develop/ollama

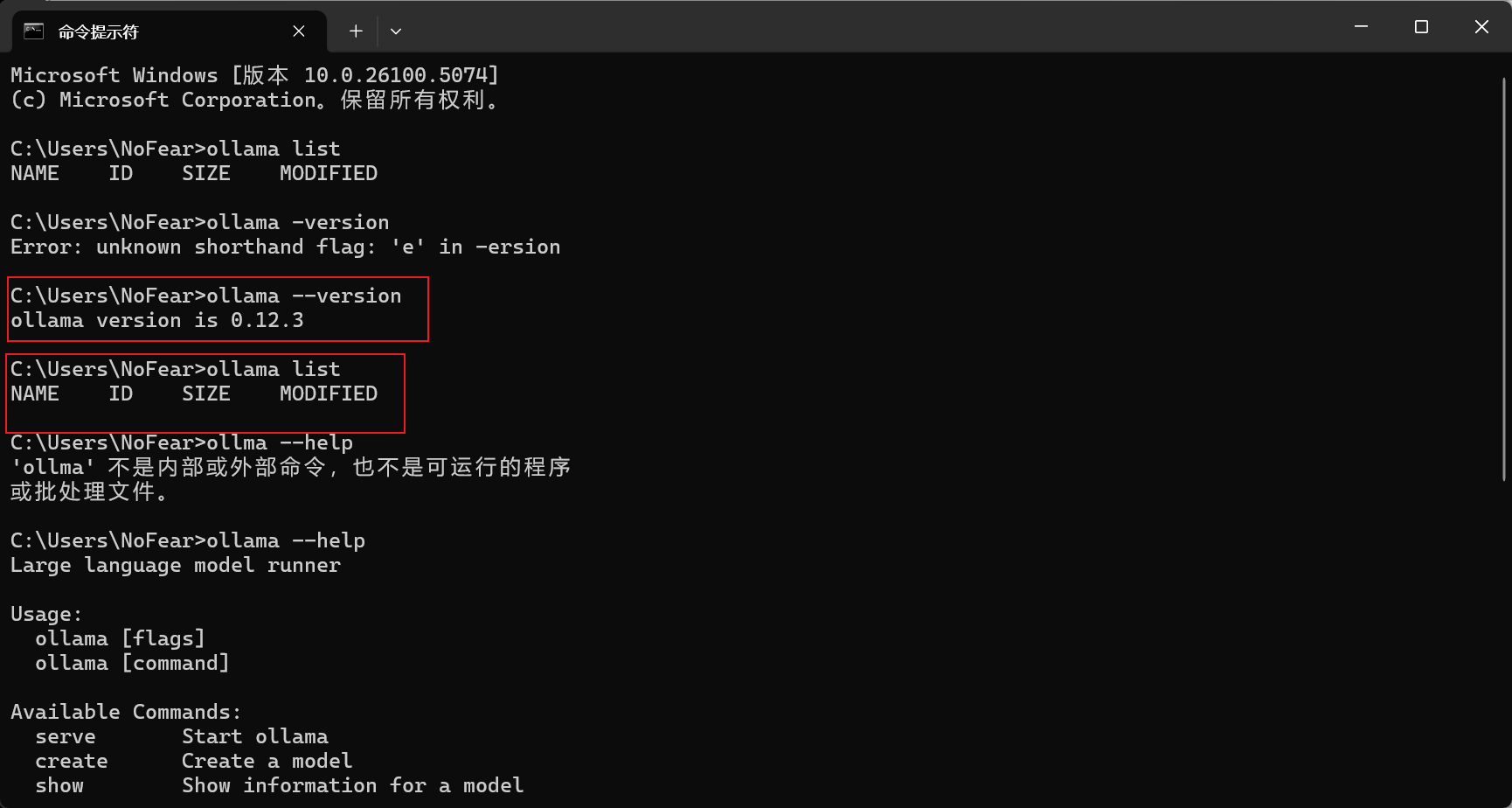

验证是否安装成功

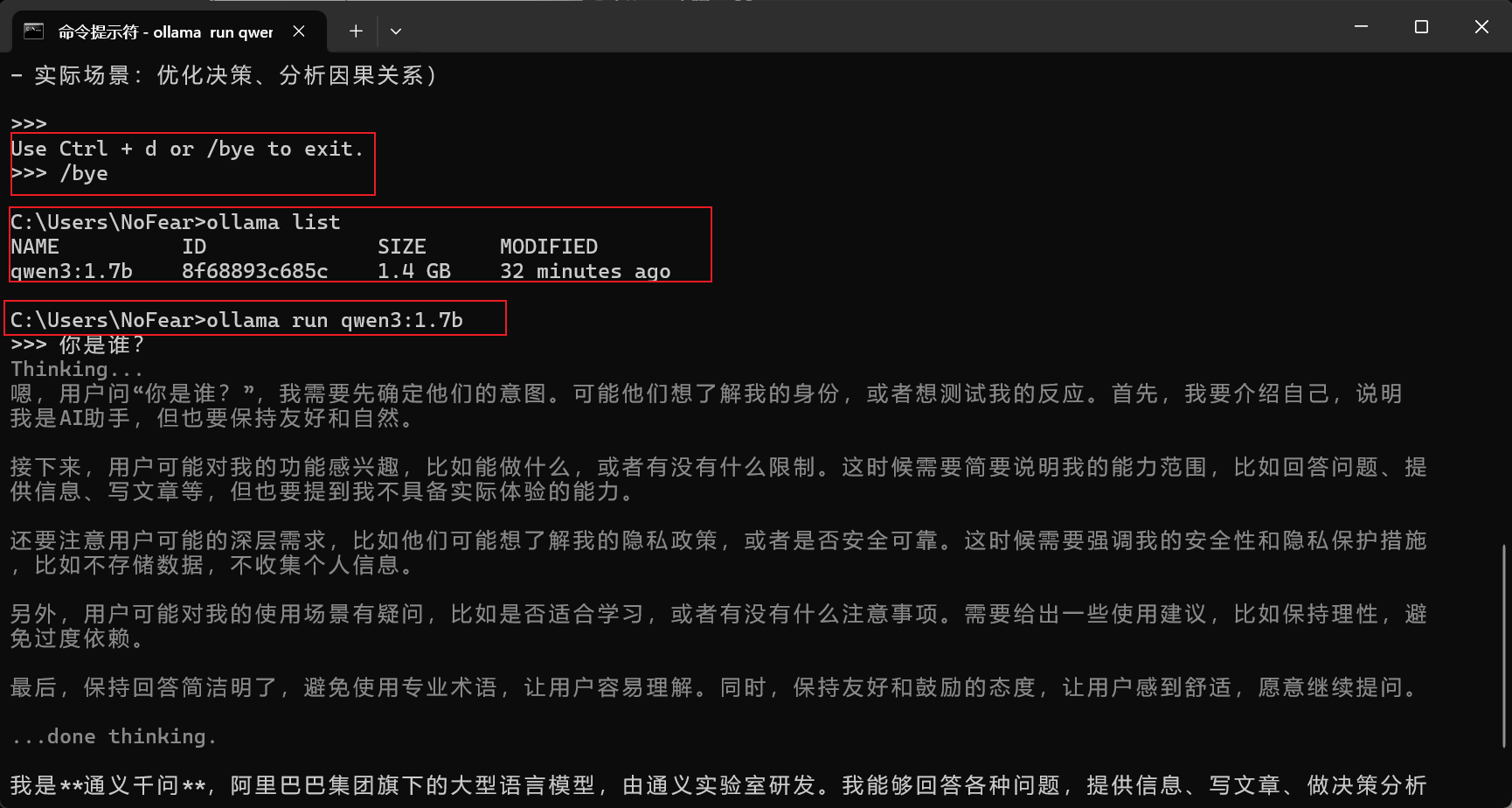

Ollama list是查看安装的大模型

Ollama的命令

C:\Users\NoFear>ollama --help

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

signin Sign in to ollama.com

signout Sign out from ollama.com

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command特别像docker,如 ollama run、ollama ps、ollama rm、ollama pull、ollama push

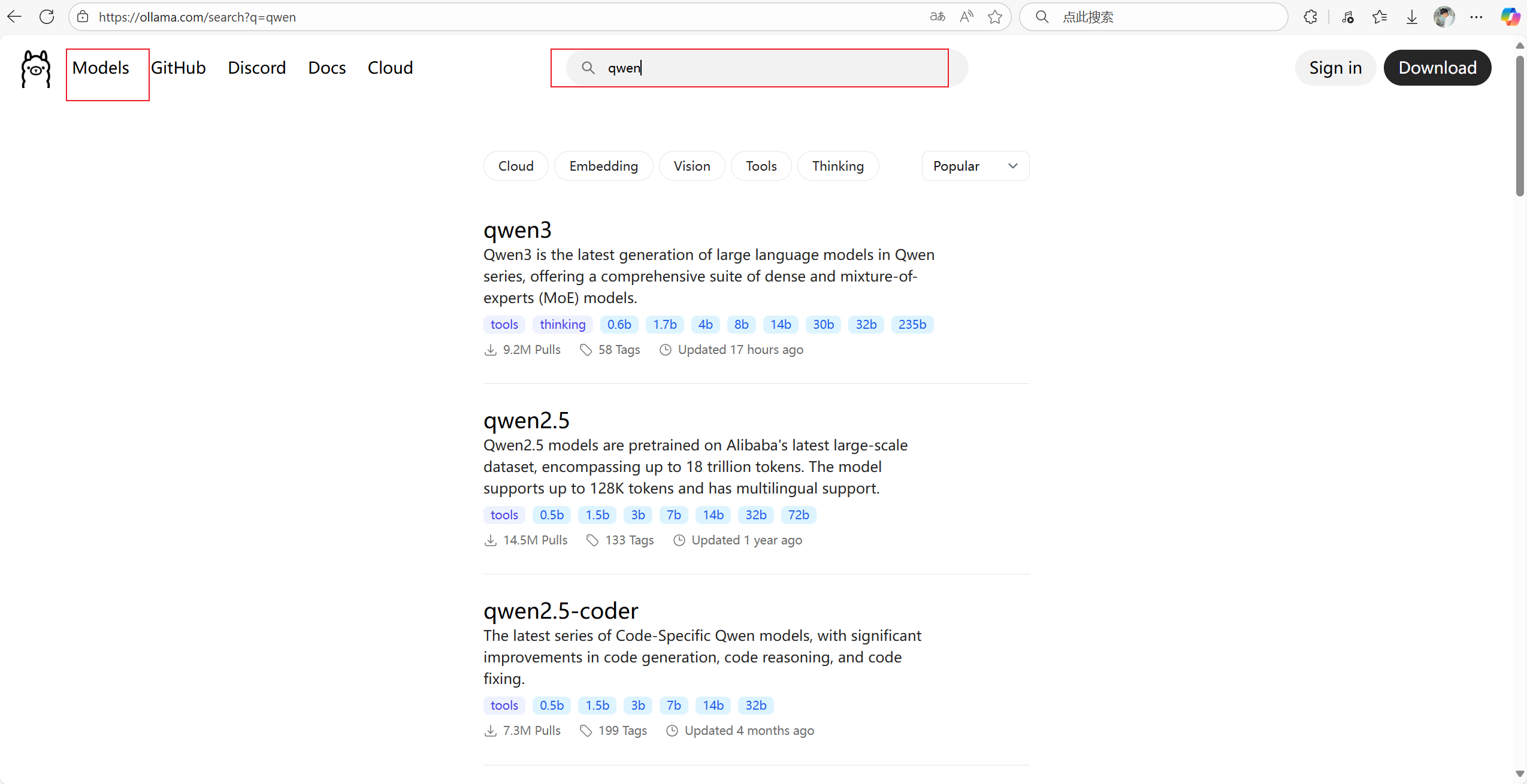

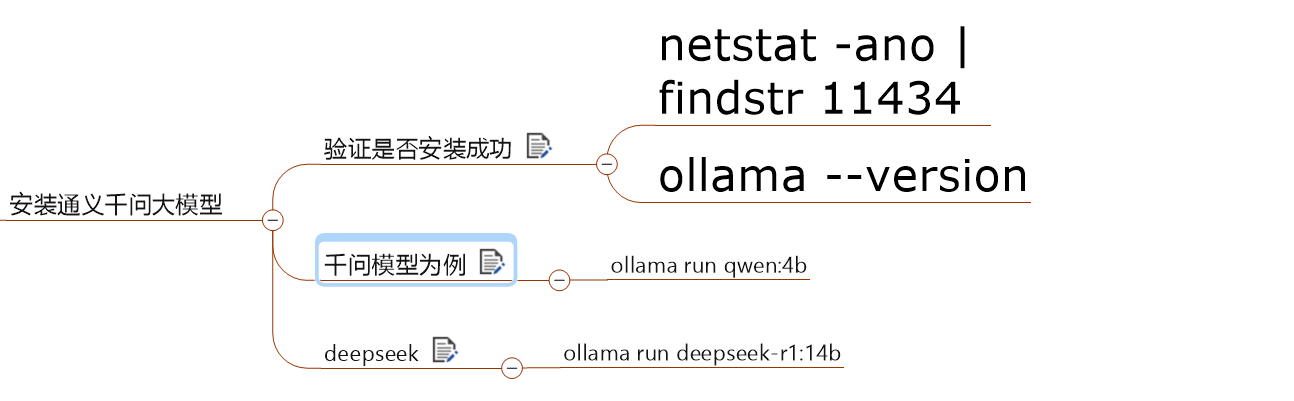

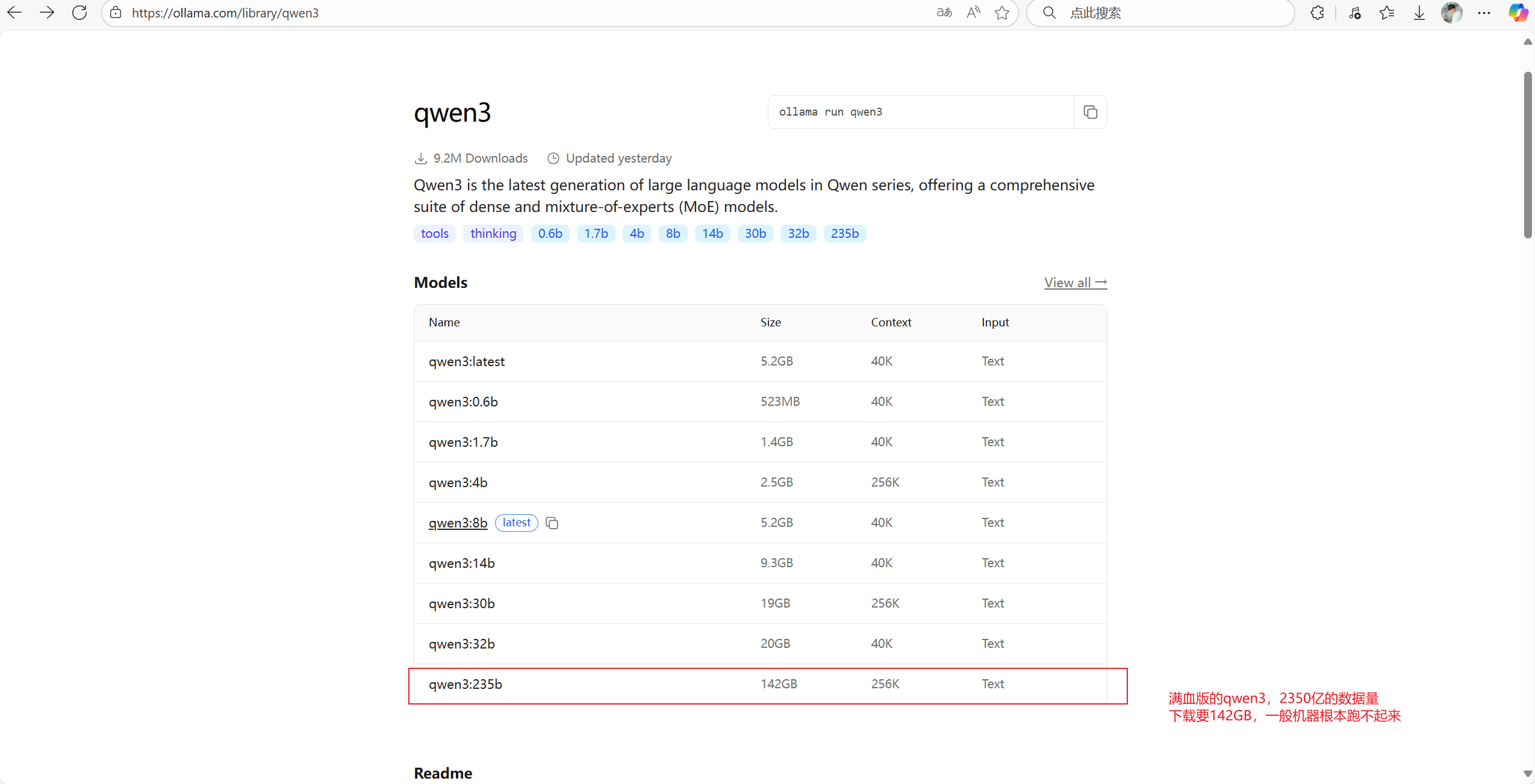

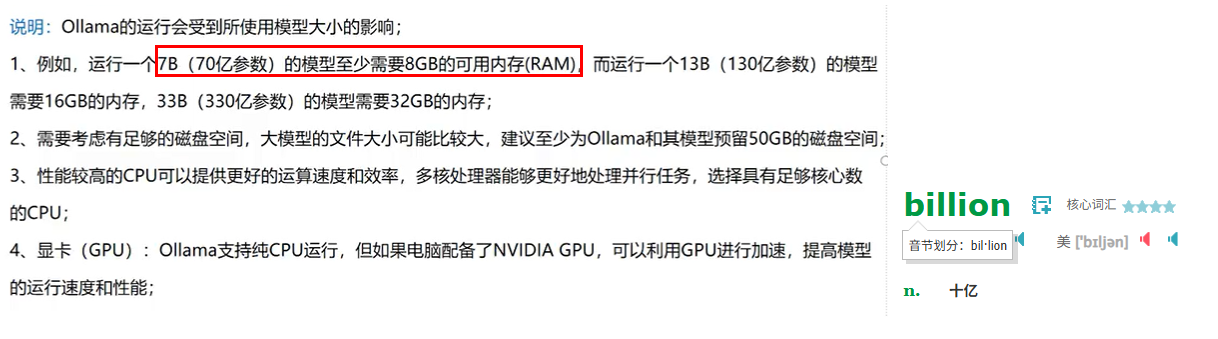

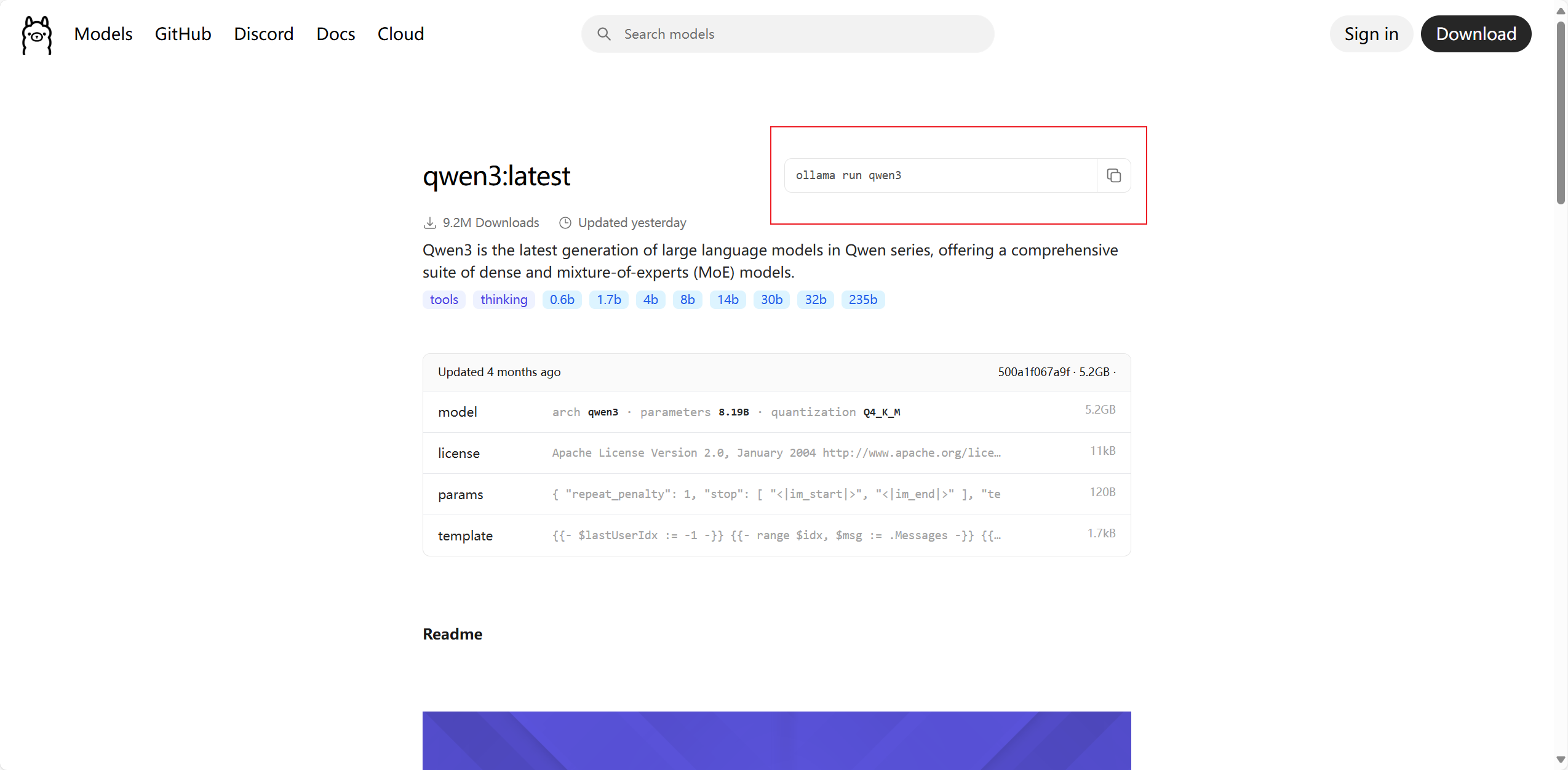

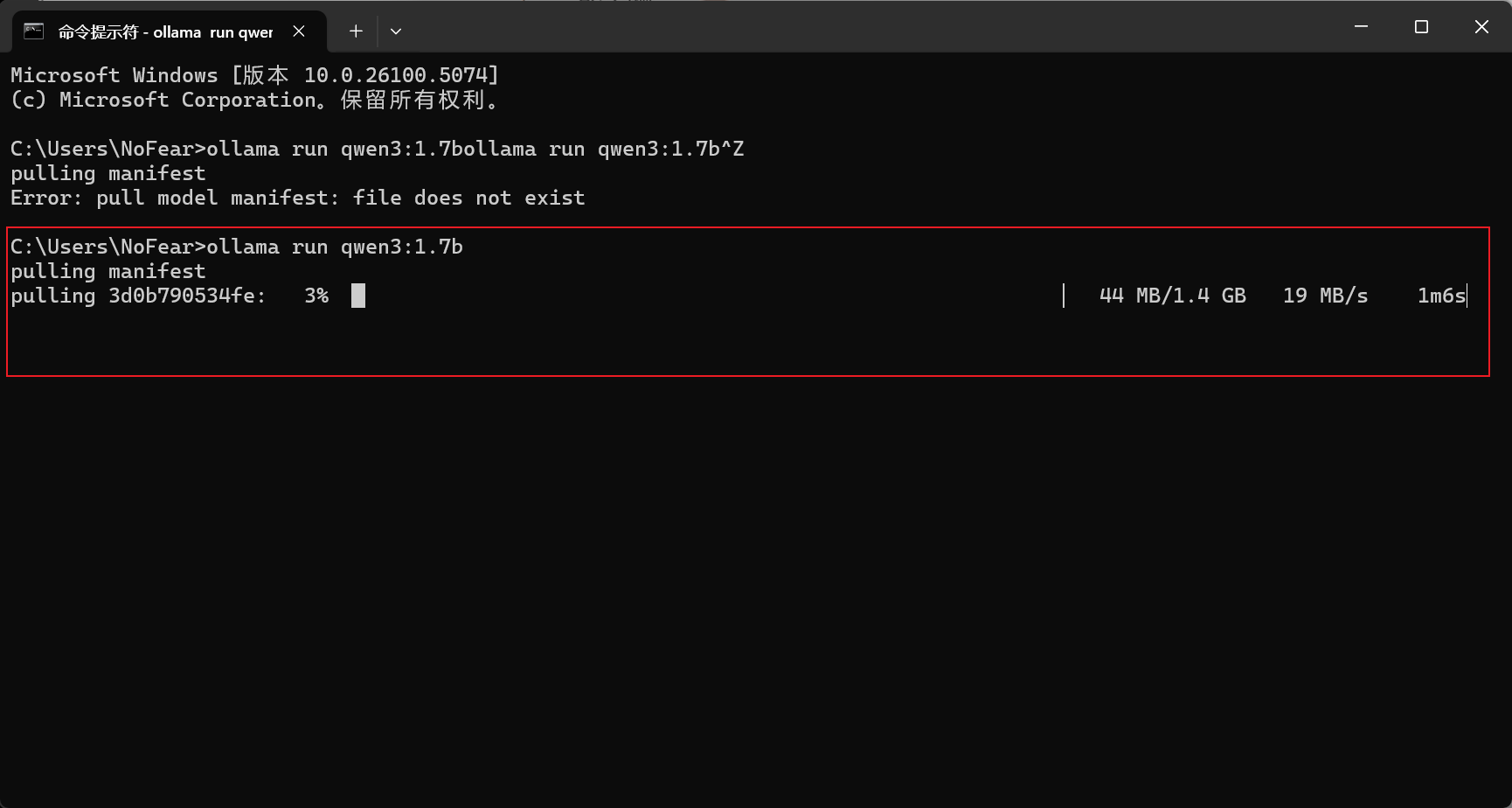

Ollama安装安装通义千问大模型

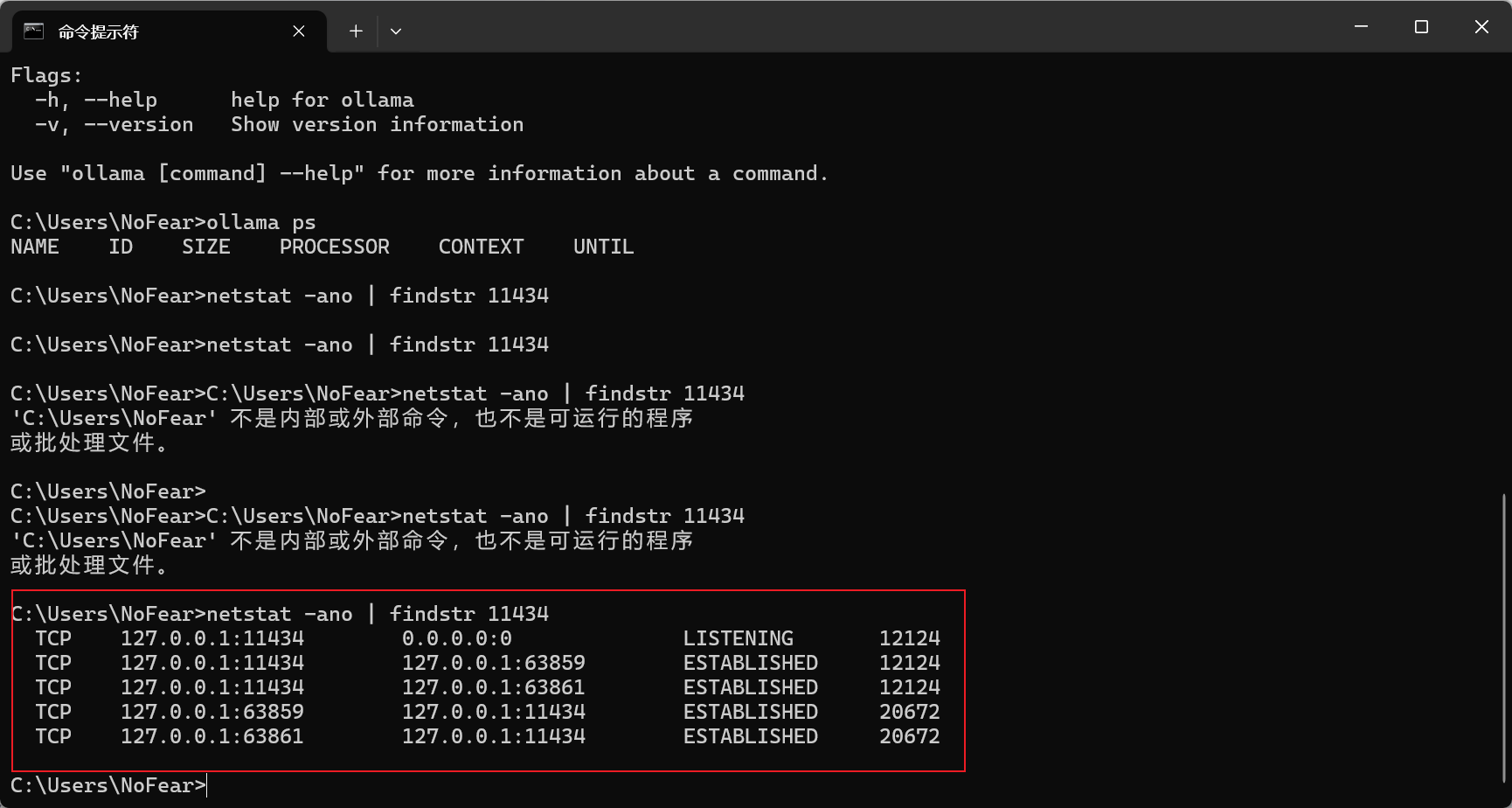

验证Ollama是否安装成功

netstat -ano | findstr 11434

ollama --version要启动Ollama才可以验证端口号

执行命令即可安装

安装了Qwen3,17亿数据量的大模型

启动大模型

/bye退出大模型对话

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)