【教程】本地部署大语言模型-接入deepseek

本地部署deepseek,构建个人知识库

·

本地部署大语言模型-接入deepseek

出于以下不同的考虑,想本地部署大语言模型,并接入deepseek呢

-

为了数据隐私和安全,对敏感信息进行保护,数据存储在本地可以减少数据泄露的风险。

-

本地部署减少了网络传输时间,提高了系统的响应速度。

基于Ollama部署DeepSeek模型,你可以按照以下步骤进行:

1-创建虚拟环境:

使用conda create命令来创建一个新的虚拟环境。例如,创建一个名为myenv的Python 3.9环境:

conda create --name myenv python=3.9

激活刚刚创建的虚拟环境:

conda activate myenv

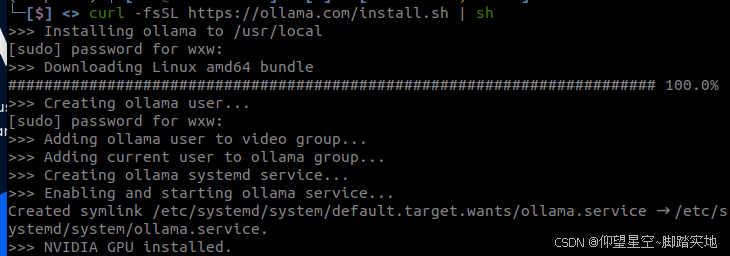

2-安装ollama依赖包:

2.1 进入ollama官网下载ollama:

https://ollama.com/download

下载中…

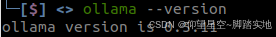

2.2 验证安装是否成功

安装完成后,在终端输入 ollama --version 进行验证。

ollama --version

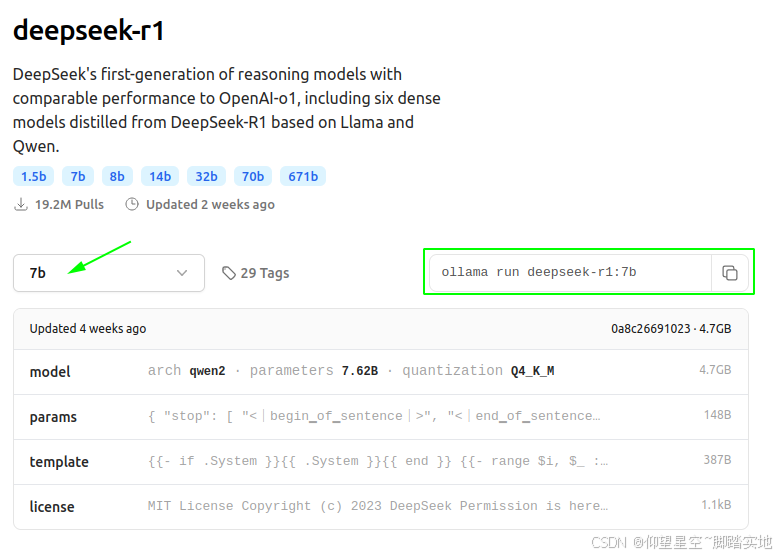

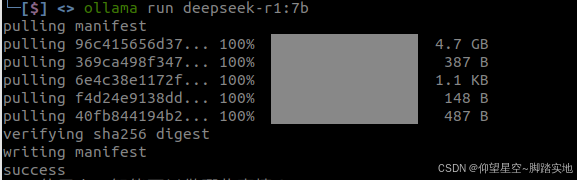

3-下载DeepSeek模型

选择合适的模型,图示为deepseek-r1的7b模型,选择后,复制右侧的代码到终端中,下载该deepseek模型

ollama run deepseek-r1:7b

该命令会自动下载并运行 deepseek-r1:7b 模型。

如果你想下载其他版本,如 1.5b 、 8b 、 14b 等 ,只需选择对应的版本,运行不同的命名 。

deepseek-r1:7b 模型大概4.7G,下载起来还是挺快的。

下载成功界面:

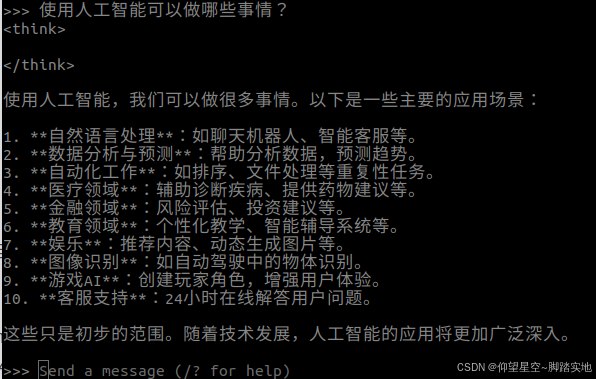

4-验证模型是否可用

当模型下载完成后,命令行界面会提示

>>> Send a message (/? for help)

此时你可以在命令行中输入问题或指令与DeepSeek模型进行交互。

例如,输入“使用人工智能可以做哪些事情?”,模型会根据其训练数据生成相应的回答。

到这里deepseek本地部署完成!

快来试一试吧~

可能我们会觉得命令行交互不够直观,想通过UI界面更好的交互,将在下一篇为大家介绍~

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)