超简单! ollama+cherry studio部署本地deepseek r1详细指南 附带安装包

链接: https://pan.baidu.com/s/1UopBbrDbxqY30vICe8GGZw?这是一个ai的集合,上面可以有很多模型,也是一个在国外的软件,所以我们国内下载不是很方便,所以我建议挂一个加速器,可以网速快一点下载下来。我推荐先下载1.5b最小的试试看,命令就是右边的代码 1.5b的代码下面,可以直接复制进去。然后下载好,cmd之后,打开命令提示符,我们输入ollama可以看

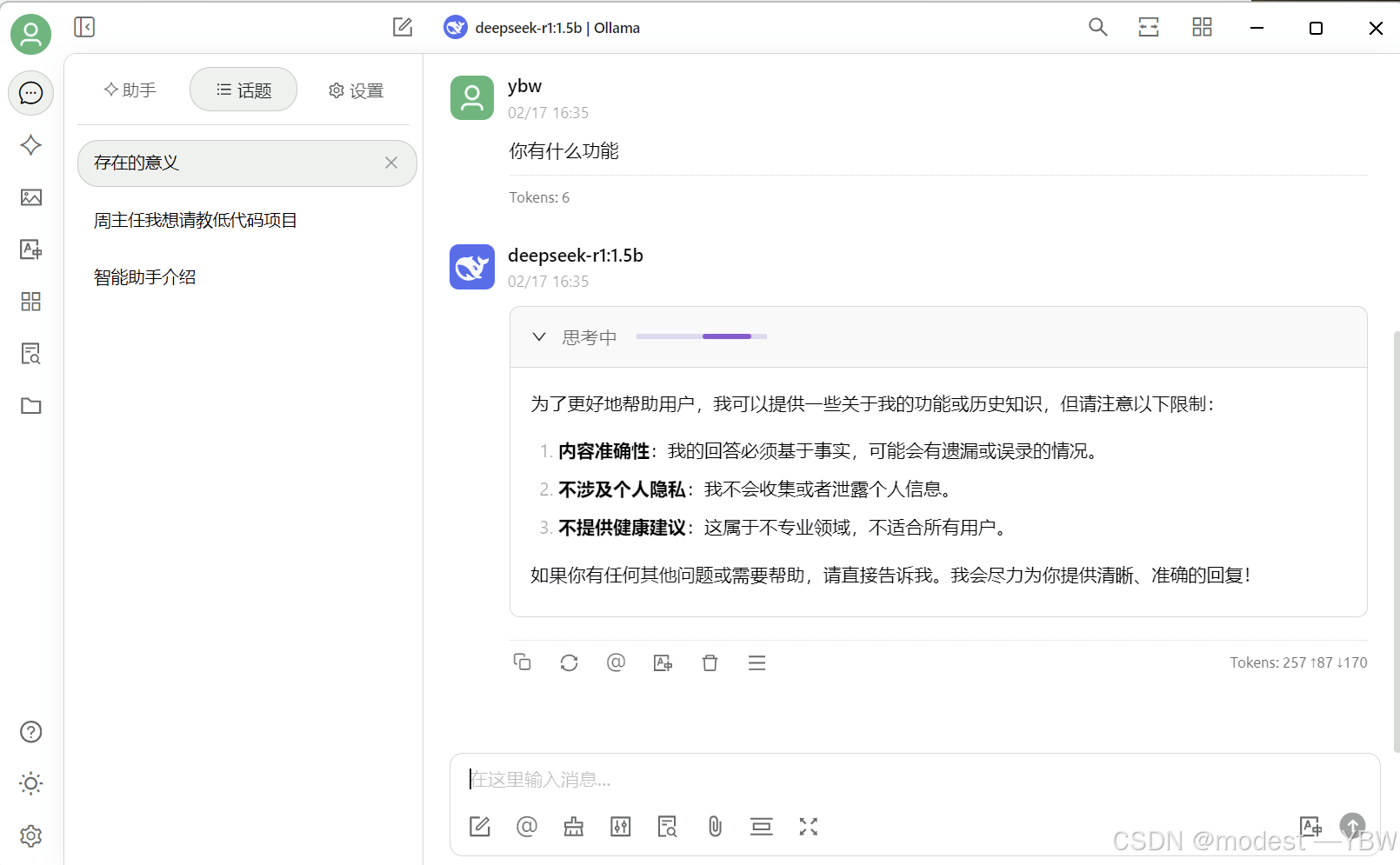

看了网上一些教程,有很多种部署方法,包括docker,虚拟机等等。大佬都有比较好的方法,我自己选择部署了最简单的方案,就是ollama+deepseek r1本地+charrystudio的方案,我个人觉得可视化看起来比较好看,效果是如下一个界面:

下面写一下我的部署过程:

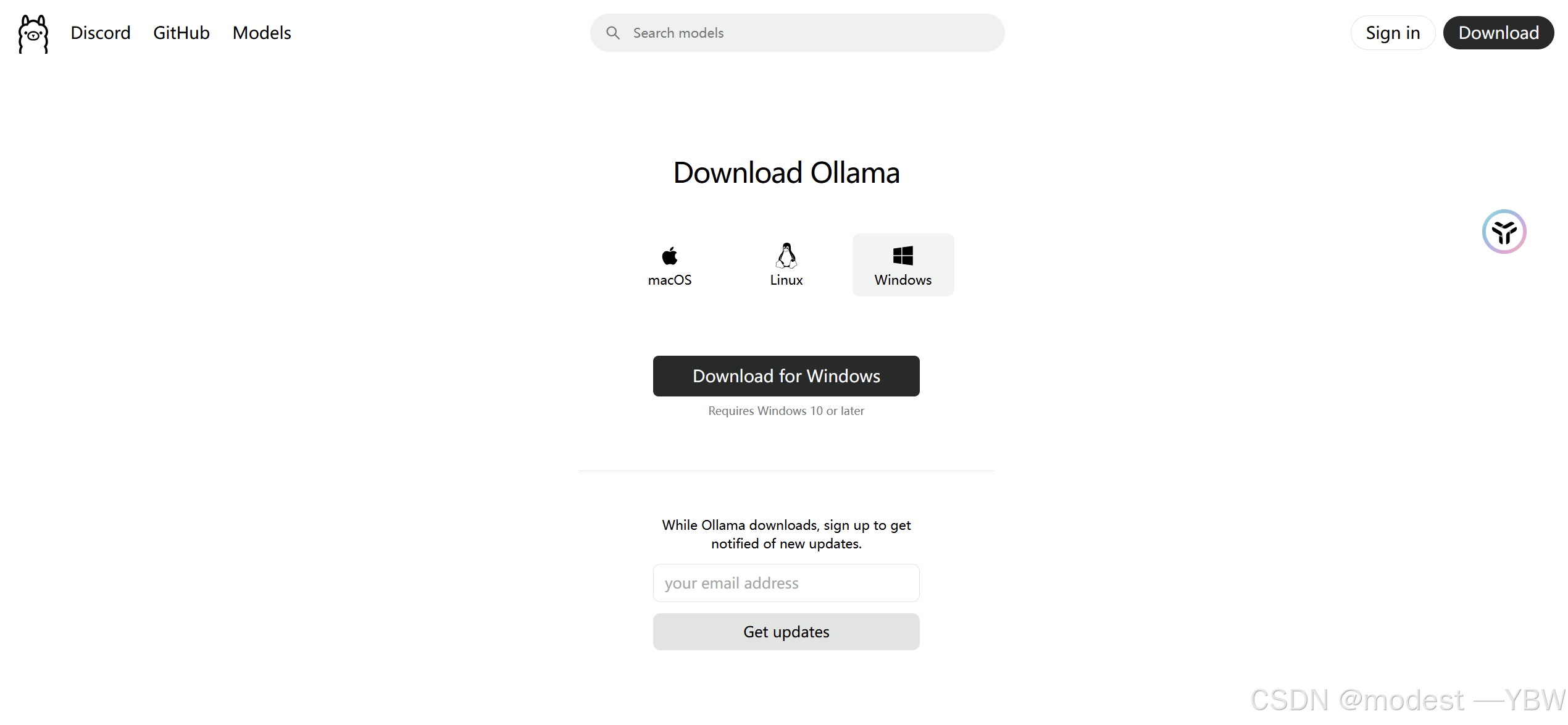

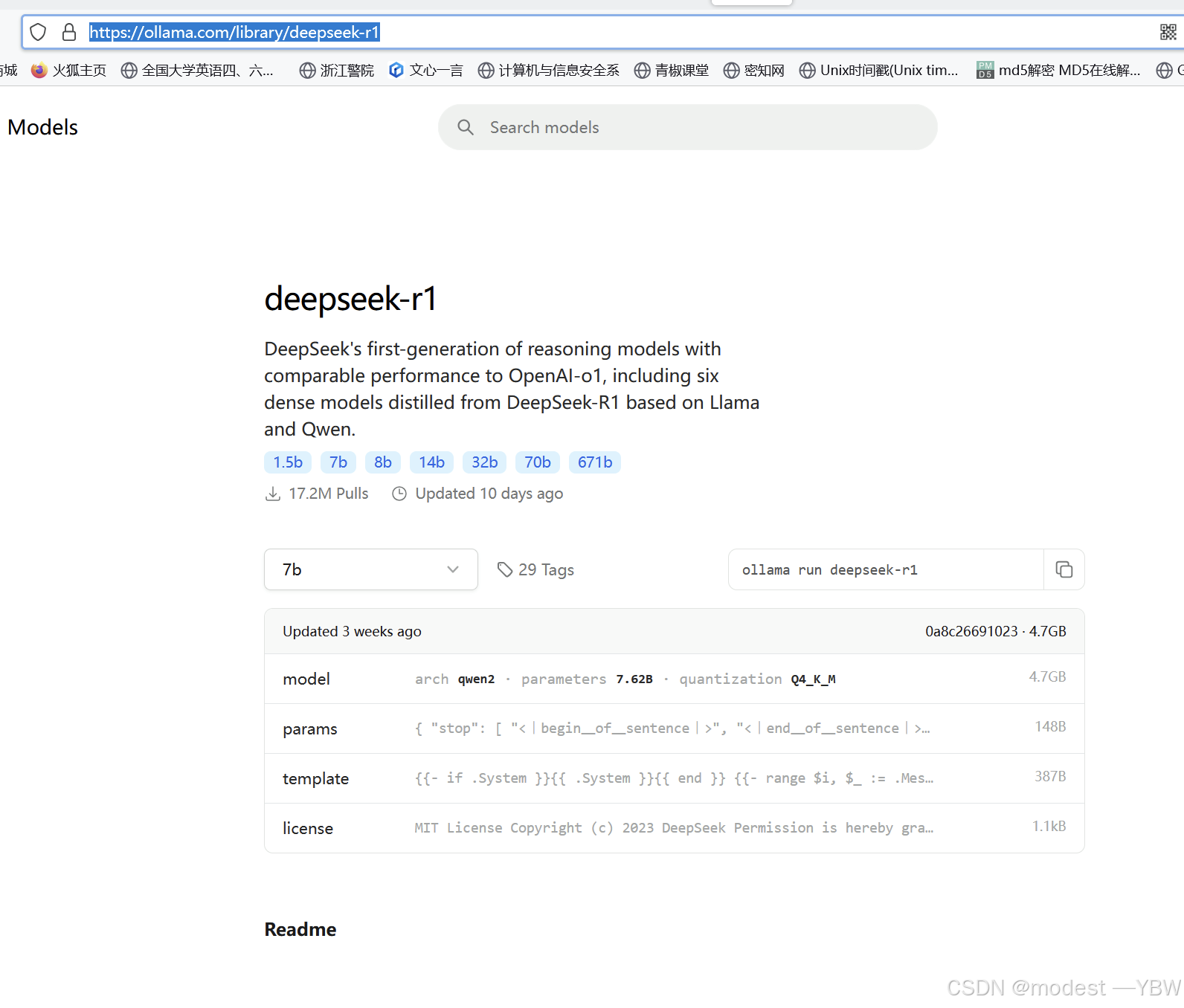

首先是下载ollama Ollama 网址就是这个,点进去可以下载

这是一个ai的集合,上面可以有很多模型,也是一个在国外的软件,所以我们国内下载不是很方便,所以我建议挂一个加速器,可以网速快一点下载下来。

OllamaGet up and running with large language models.![]() https://ollama.com/

https://ollama.com/

为了大家方便,我这里给一个ollama的百度网盘链接,大家可以直接下载。

通过网盘分享的文件:ollama安装包

链接: https://pan.baidu.com/s/1UopBbrDbxqY30vICe8GGZw?pwd=thrp 提取码: thrp

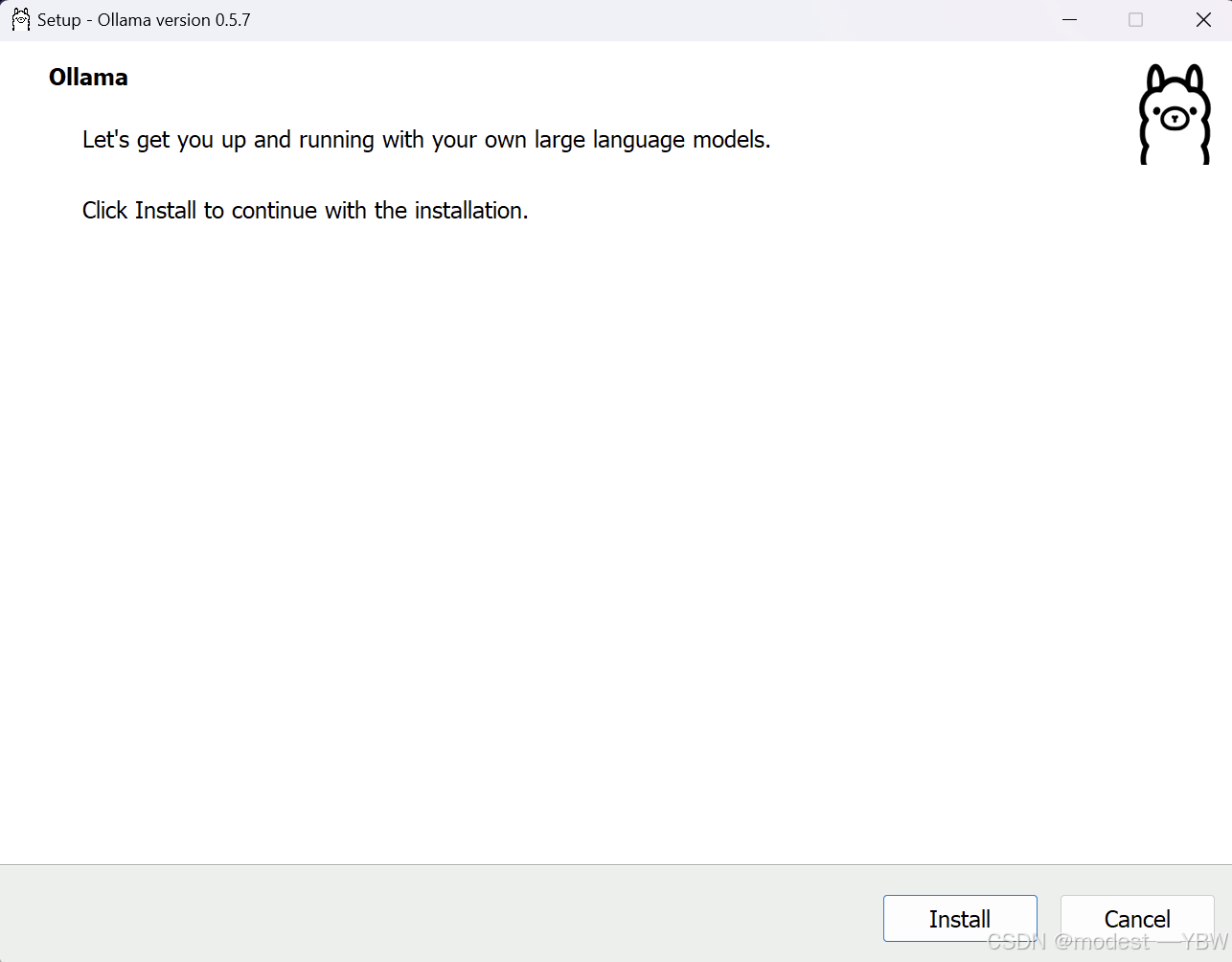

我这个为了简单起见,直接点击安装在c盘,不更改位置 直接install

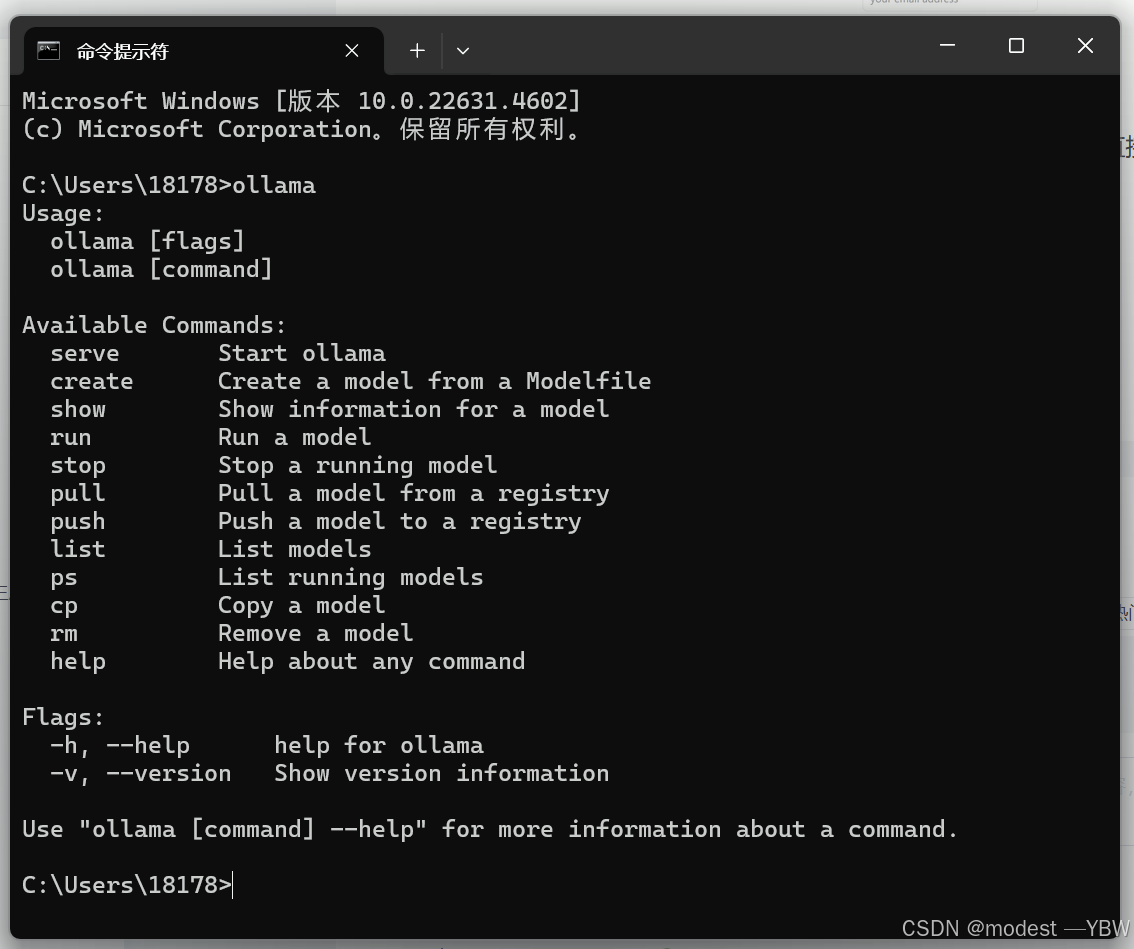

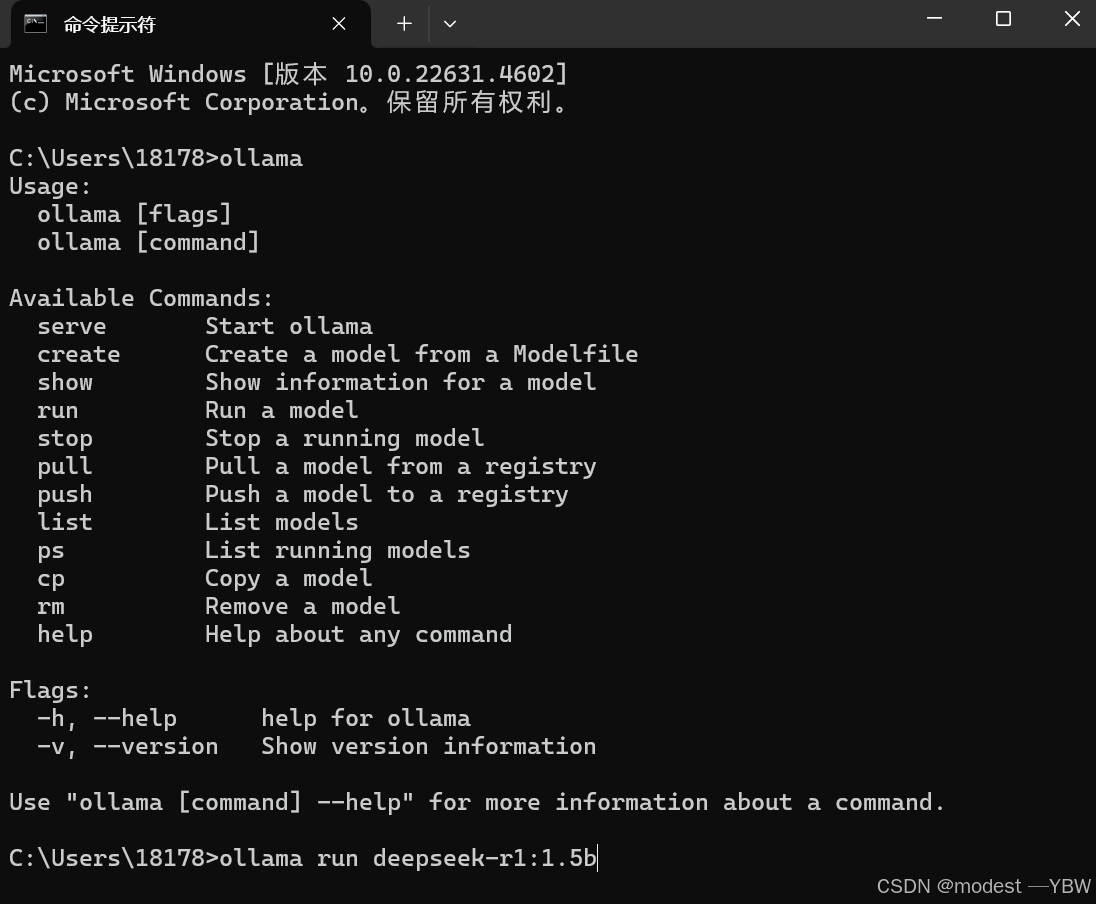

然后下载好,cmd打开命令提示符之后,我们输入ollama可以看到已经安装好了。

然后进入下一步,我们要下载相关模型。

点击上面网址,就是deepseek模型,然后7b 8b都可以自由选择。

我推荐先下载1.5b最小的试试看,命令就是右边的代码 1.5b的代码下面,可以直接复制进去

ollama run deepseek-r1:1.5b

下载模型的代码直接输入到cmd命令框里面没任何enter

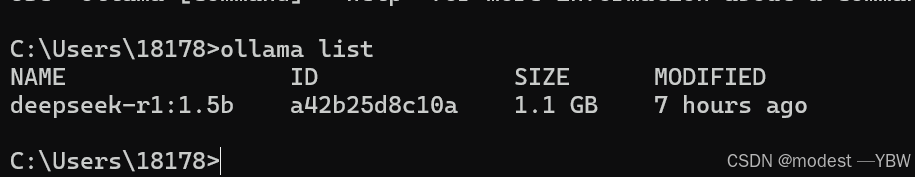

运行之后,直到下载完成,我们就拥有了第一个模型,我们可以查看模型情况

查看模型情况:ollama list 就会显示你现在有什么模型(我们这里是一个1.5b的)

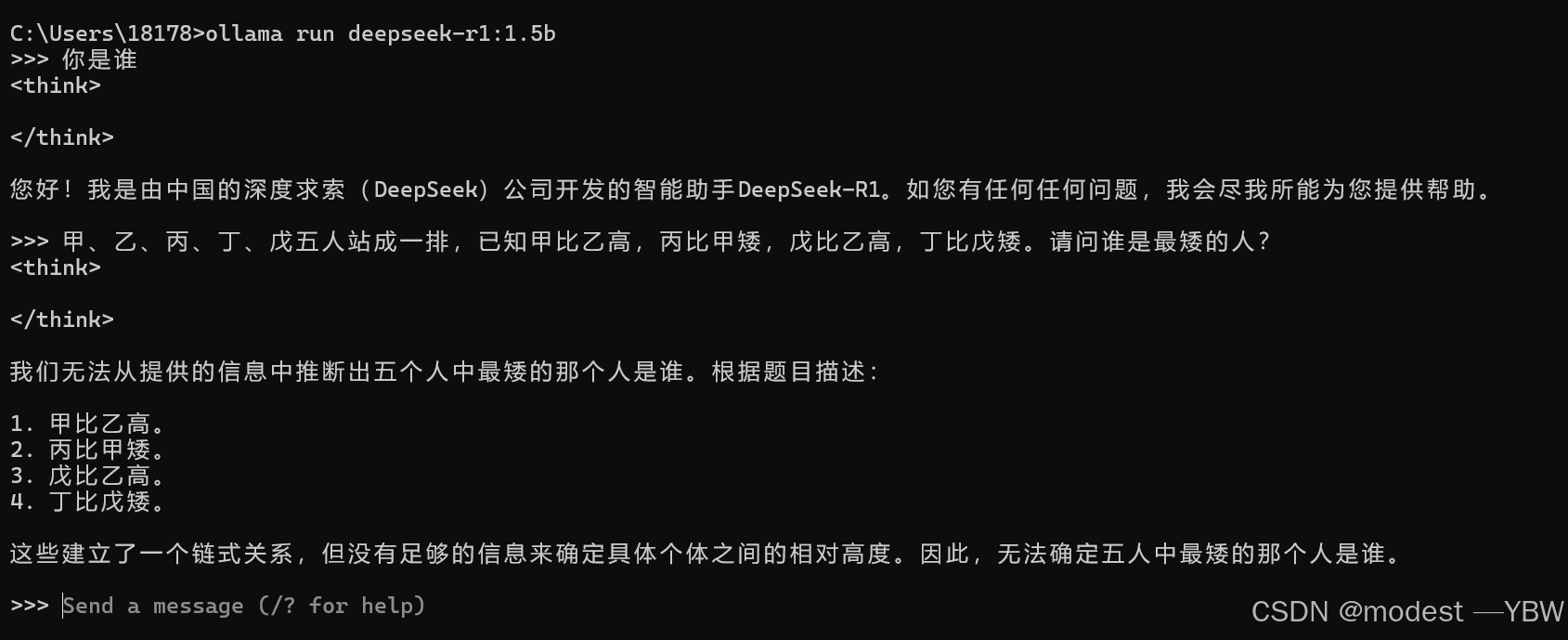

然后我们先才命令框里面运行deepseek,查看效果

命令:ollama run deepseek-r1:1.5b

如果是不同的大小的,就按7b 8b自己的参数来,我这里下载1.5b

接下来的步骤就是给deepseek套一个好看一点的壳,我们这里选用的cherrystudio

然后因为本地的ui有点难看,所以我们选择cherrystudio软件ui好看一点,软件的链接我放在下面自取:

通过网盘分享的文件:cherrystudio安装包

链接: https://pan.baidu.com/s/1ln4Q77SFh2sLWUFGFZJaxw?pwd=wdxu 提取码: wdxu

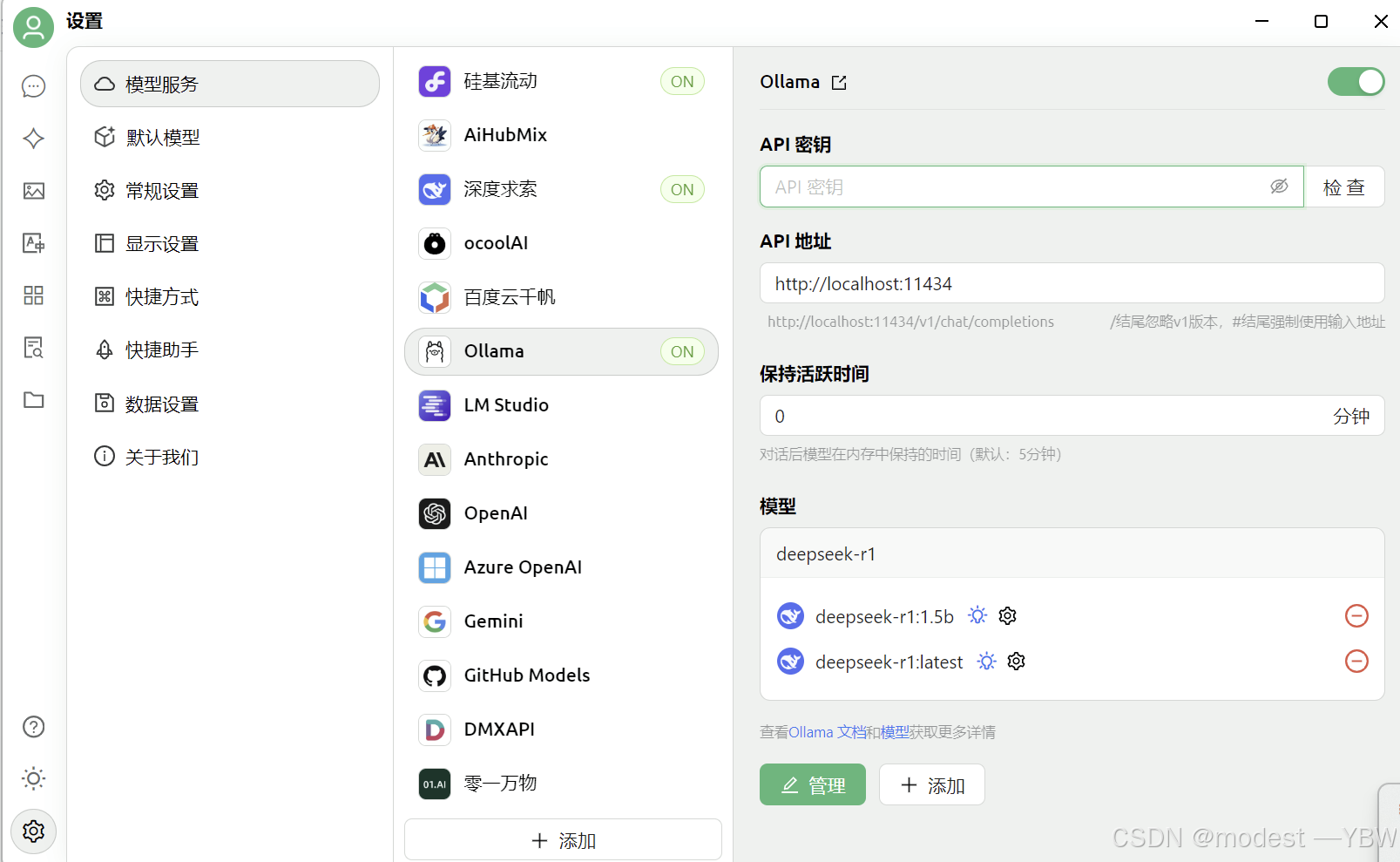

安装完之后,点击设置——ollama——管理——添加本地的模型

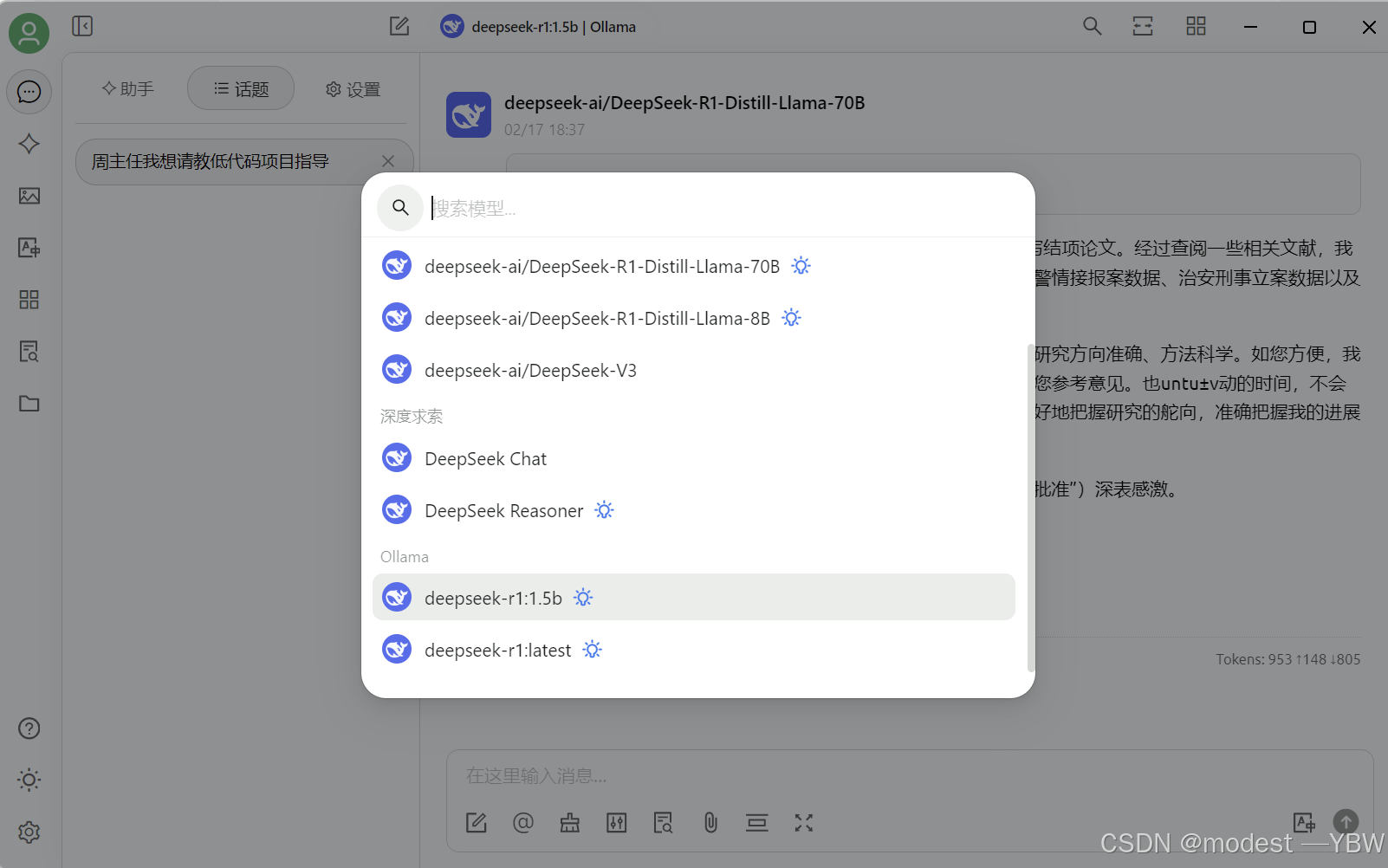

然后选择模型,选中我们下载的那个,就可以用了

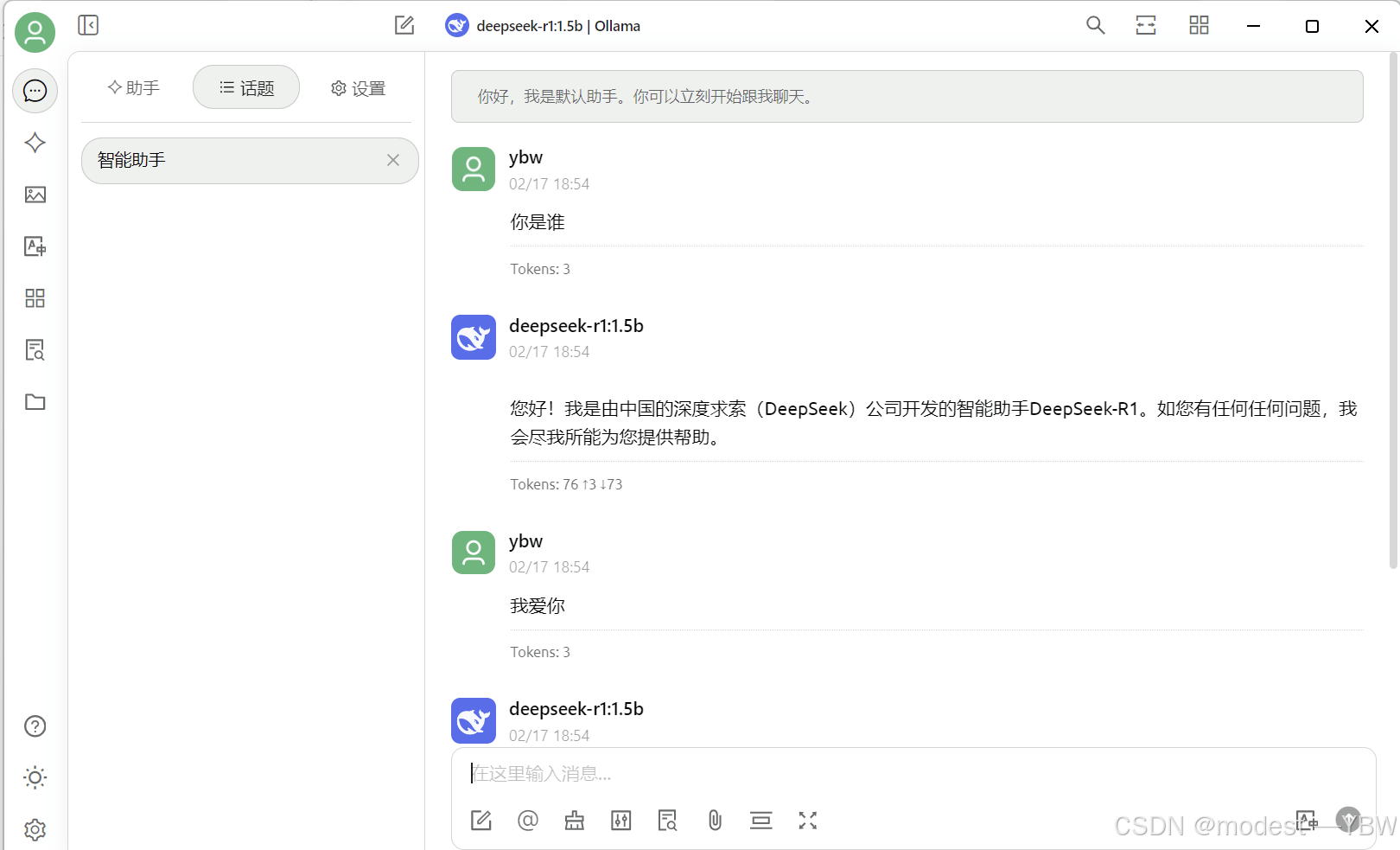

效果如下:

如果教程有问题,可以私信我,我会尽快回复的,谢谢

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)