NeurIPS 2025最新突破:多尺度微调框架MSFT,让时序模型性能飙升的实战指南!

本文提出MSFT多尺度微调框架,首次将多尺度建模融入时序基础模型(TSFM)微调过程。该框架通过尺度特异性知识激活、解耦token依赖建模和多尺度预测融合三部分,解决传统微调未考虑时序数据多尺度特性的问题。实验表明,MSFT在长序列预测和概率预测任务中均超越现有方法,性能提升显著,为TSFM的下游适配提供了高效通用解决方案。

论文名称:Multi-Scale Finetuning for Encoder-based Time Series Foundation Models

论文作者:Zhongzheng Qiao,Chenghao Liu,Yiming Zhang,Ming Jin,Quang Pham,Qingsong Wen,P. N. Suganthan,Xudong Jiang,Savitha Ramasamy

一、研究背景

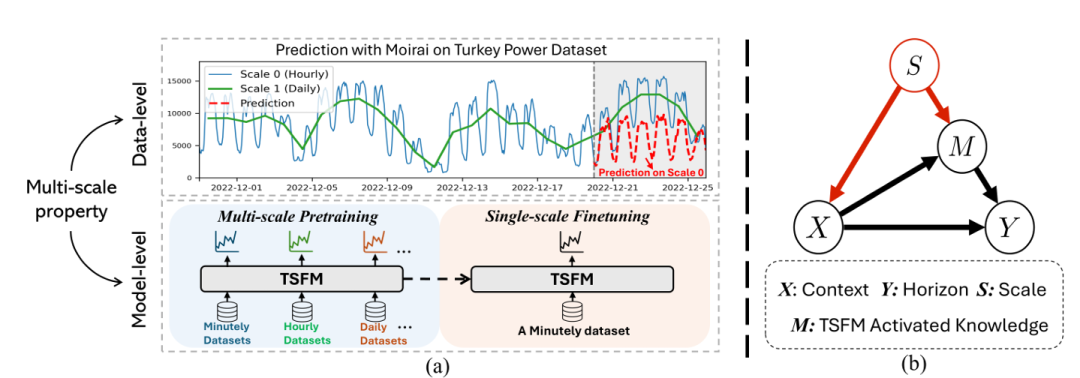

时间序列基础模型(TSFMs) 通过大规模预训练获得了出色的零样本时间序列预测性能,但当前研究多聚焦于预训练与零样本评估,对 “如何针对下游任务有效微调 TSFMs” 这一关键问题探索不足。

传统微调(如全参数微调、线性探测、LoRA 等)未考虑时间序列数据的多尺度特性(同一数据在不同采样尺度下呈现不同时序模式,如小时级能耗数据显微观使用模式,日级数据显宏观趋势)与 TSFMs 本身的多尺度预测能力,易导致过拟合、未充分利用预训练知识,最终性能欠佳。

在因果视角下的核心问题:尺度(S)是 “输入上下文(X)- 模型激活知识(M)- 预测结果(Y)” 关系中的混杂因子,会引发虚假关联(如 X 与 M 因 S 产生非因果相关性)。传统微调直接建模,无法排除s的干扰,导致模型依赖非因果关联进行预测。

因此提出了一个新的多尺度微调框架-MSFT,以解决上述问题。

二、模型框架

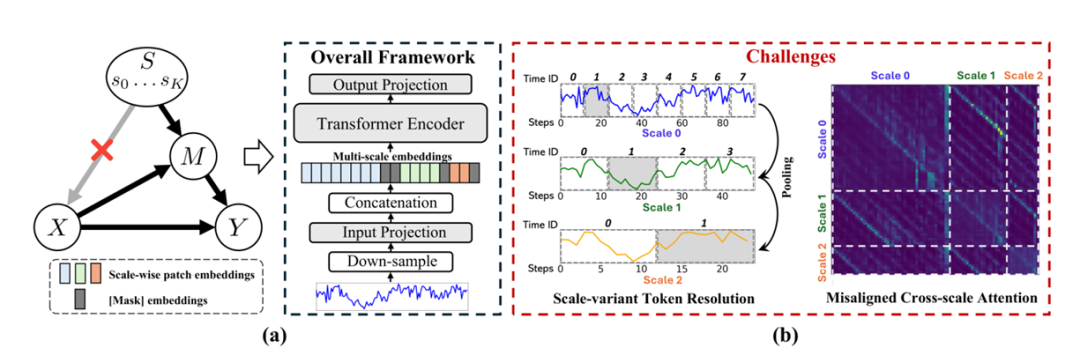

MSFT 针对编码器类 TSFMs(如 MOIRAI、MOMENT、UNITS)设计,通过显式融入多尺度建模解决传统微调缺陷,核心分为三部分:

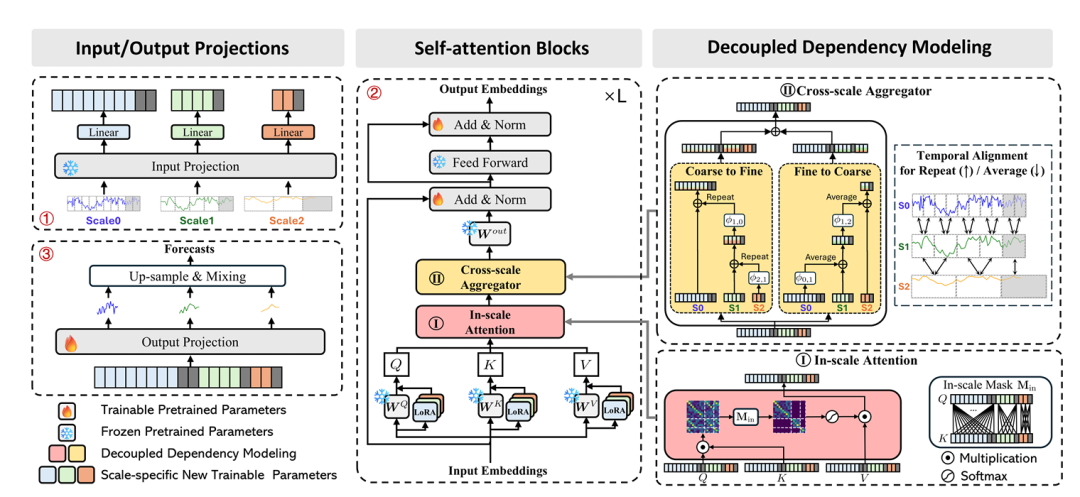

1.尺度特异性知识激活

输入投影层:冻结预训练输入投影参数,为每个尺度添加独立线性适配器(Linear_i),计算该尺度输入嵌入 ,避免不同尺度间的表征干扰。

注意力层:冻结预训练注意力权重,为每个尺度引入独立 LoRA 模块,激活尺度专属知识,匹配因果公式中 “” 的尺度 - 知识映射关系。

2. 解耦的 token 依赖建模

解决 “多尺度 token 时间索引错位导致注意力偏误” 问题,分两步建模依赖:

- 尺度内注意力:通过掩码限制 token 仅关注同一尺度内的 token,确保捕获尺度内时序依赖。

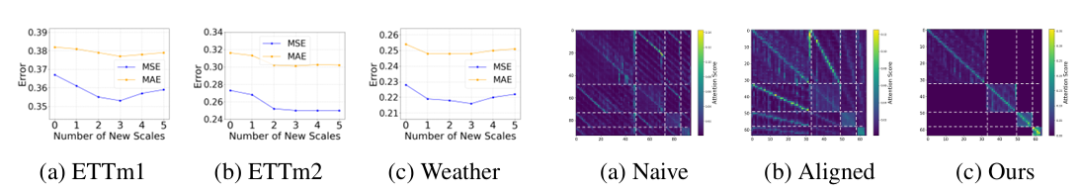

- 跨尺度聚合器:设计 “粗到细(C2F)” 和 “细到粗(F2C)” 双分支,先通过线性映射将不同尺度 token 投影到统一空间,再通过重复/ 平均池化对齐时序分辨率,实现跨尺度信息融合。

3. 多尺度预测融合

训练阶段:每个尺度独立输出预测,总损失为各尺度损失的加权和(权重通过 Softmax 学习,对应因果公式中的),即。

推理阶段:将各尺度预测上采样至原始分辨率,通过学习到的加权求和得到最终预测,缓解单一尺度过拟合。

三、实验数据

任务:长序列预测(LSF,预测长度 96/192/336/720)、概率预测(PF)。

数据集:LSF 使用 ETT(小时 / 15 分钟级温度)、电力、天气数据集;PF 使用电力、太阳能、交通等 5 个分布外数据集。

对比方法:

- 传统微调:全参数微调、线性探测、Prompt Tuning、LoRA、AdaLoRA;

- 深度学习基线:DLinear、PatchTST、iTransformer、TimeMixer 等。

重点实验数据

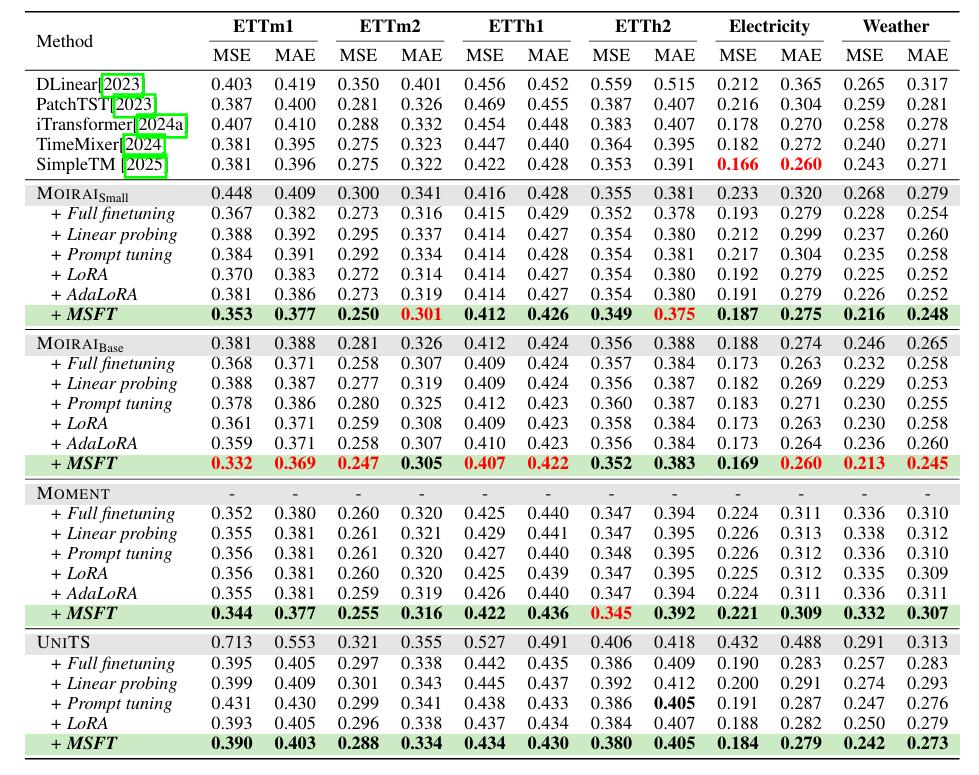

长序列预测(LSF)

- MSFT 在所有 TSFM 骨干(MOIRAI Small/Base、MOMENT、UNITS)上均优于传统微调方法,且超越从零训练的 SOTA 模型。

- 例:MOIRAI Base+MSFT 在 ETTm1(15 分钟级温度)的 MSE 较全微调降低 6.8%,在 Weather 数据集 MSE 降低 6.7%;对多尺度模式更丰富的分钟级数据提升更显著。

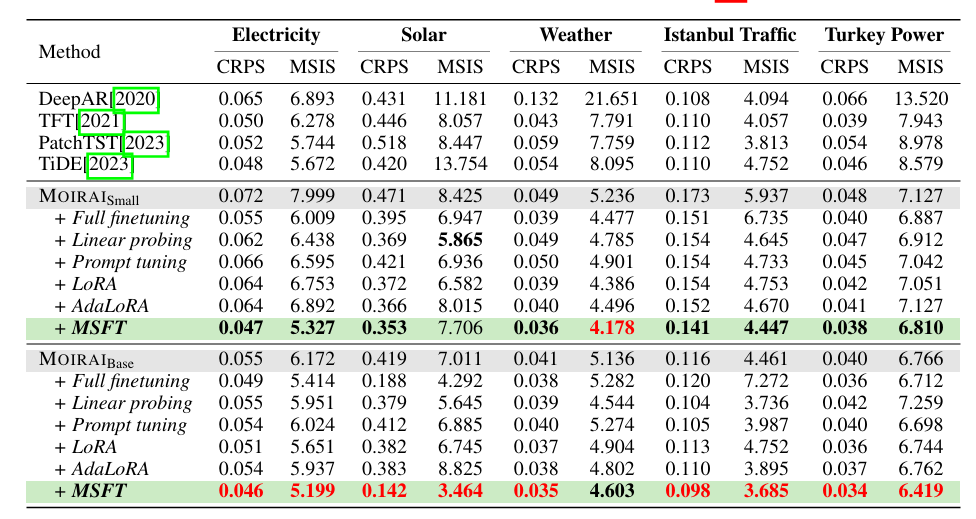

概率预测(PF)

MSFT 显著降低 CRPS(连续排序概率得分)和 MSIS(平均缩放区间得分),MOIRAI Base+MSFT 在 Solar 数据集 CRPS 较全微调降低 24.4%,在 Istanbul Traffic 数据集降低 18.3%。

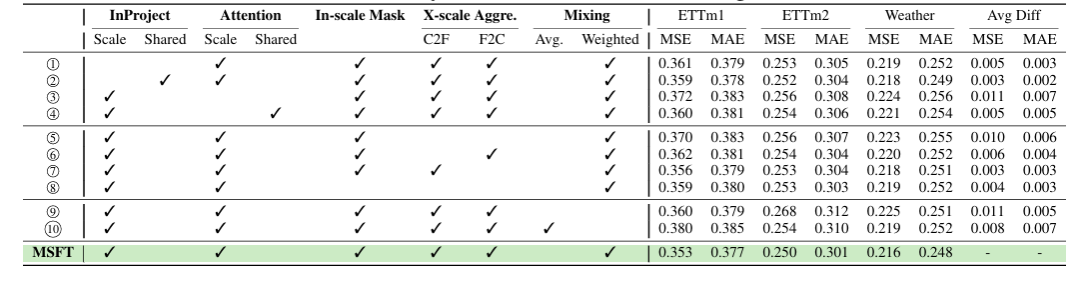

消融实验: 尺度特异性模块、跨尺度聚合器、加权融合均为关键组件:移除任一组件会导致性能下降,如仅保留尺度内注意力(无跨尺度聚合)时,ETTm1 的 MSE 上升 10%。

四、小小总结

文章首次从因果角度分析 TSFM 微调问题,指出尺度混杂因子的影响,提出通过多尺度建模实现 “后门调整” 以消除虚假关联。

提出的MSFT框架 是首个将多尺度建模融入 TSFM 微调的框架,兼容不同编码器类 TSFM,且实现简单。

针对编码器类 TSFM 的微调问题,MSFT 通过显式多尺度建模(尺度特异性激活、解耦依赖建模、加权融合),有效利用 TSFM 预训练的多尺度能力,消除尺度混杂因子引发的虚假关联,在长序列与概率预测任务中均实现 SOTA 性能,为 TSFM 的下游适配提供了通用且高效的解决方案。

五、如何学习AI大模型?

如果你对AI大模型入门感兴趣,那么你需要的话可以点击这里大模型重磅福利:入门进阶全套104G学习资源包免费分享!

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

这是一份大模型从零基础到进阶的学习路线大纲全览,小伙伴们记得点个收藏!

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

100套AI大模型商业化落地方案

大模型全套视频教程

200本大模型PDF书籍

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

LLM面试题合集

大模型产品经理资源合集

大模型项目实战合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献355条内容

已为社区贡献355条内容

所有评论(0)