如何用 OpenWebUI 界面对接 ollama 进行 AI 对话?

如何用 OpenWebUI 界面对接 ollama 进行 AI 对话?

·

上一篇文章,已经在docker《运用docker容器,把开源AI大模型部署在本地主机上》中安装了ollama和和Gemma 2B;但是在命令行中输入不太方便,现在用OpenWebUi进行对接ollama;

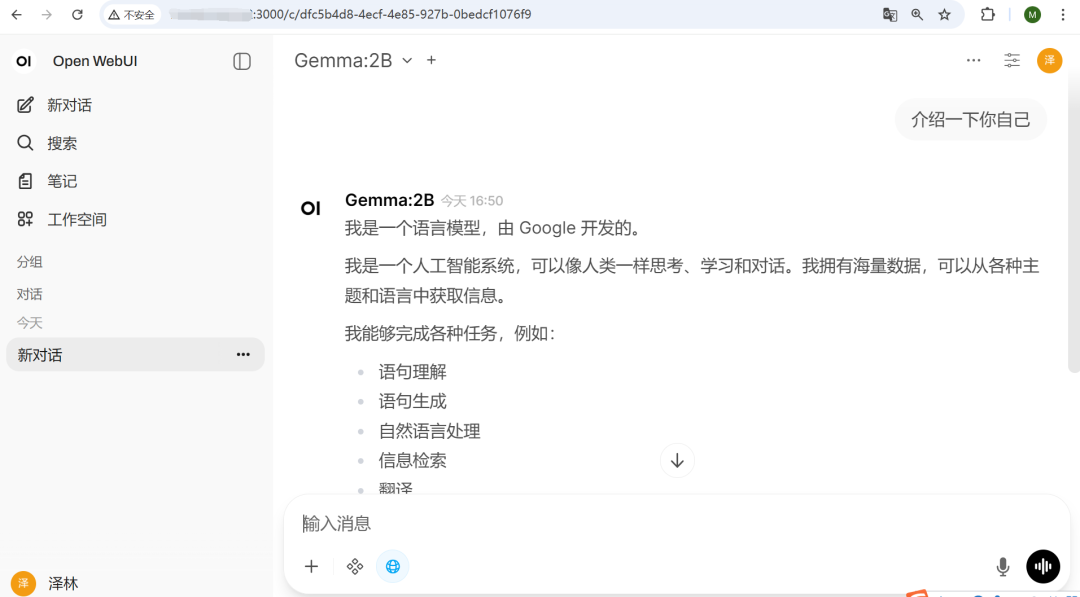

Open-WebUI:AI 模型 Web 交互界面,可对接 Ollama、genmma 等后端。提供聊天对话、提示词管理、知识库、模型切换等功能,无需命令行操作,普通用户也能轻松上手使用,界面简洁易上手。

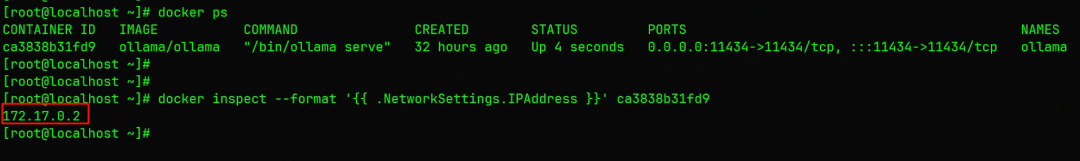

通过OpenWebUi对接,首先查看linux主机上部署的ollama的IP地址:

[root@localhost ~]# docker ps[root@localhost ~]# docker inspect --format '{{ .NetworkSettings.IPAddress }}' ca3838b31fd9

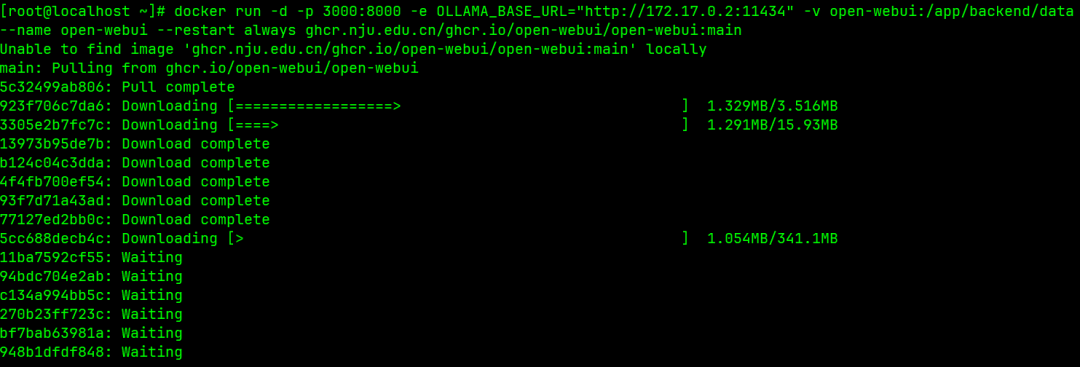

在linux主机中安装OpenWebUi,默认端口为8080,需要做好端口映射。截图默认是8000,后面进行了端口调整。

[root@localhost ~]# docker run -d -p 3000:8080 -e OLLAMA_BASE_URL="http://172.17.0.2:11434" -v open-webui:/app/backend/data--name open-webui --restart always ghcr.nju.edu.cn/ghcr.io/open-webui/open-webui:main

通过宿主机IP+端口就可打开Open-WebUI开展对话:

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)