Dify-2:项目介绍

Dify 是一款开源的大语言模型(LLM)应用开发平台,旨在弥合 AI 应用原型设计与生产部署之间的鸿沟。本文档为希望了解或扩展平台的开发者及技术用户提供 Dify 架构、组件与功能的技术概览。

·

Dify 介绍

Dify 是一款开源的大语言模型(LLM)应用开发平台,旨在弥合 AI 应用原型设计与生产部署之间的鸿沟。本文档为希望了解或扩展平台的开发者及技术用户提供 Dify 架构、组件与功能的技术概览。

平台概览

Dify 通过可视化工具与 API 的组合,提供构建 LLM 应用的端到端解决方案。其架构支持 AI 应用开发的全生命周期,包括模型集成、提示工程、知识管理、工作流编排及部署。

核心功能

Dify 在 LLM 应用开发生态中具备以下差异化能力:

- 可视化工作流构建器:在画布上搭建和测试 AI 应用流程

- 多模型支持:集成主流闭源与开源 LLM

- 提示词管理:提供编写、测试与优化提示词的 IDE

- RAG 管道:端到端检索增强生成能力

- 智能体(Agent)支持:支持基于工具调用的 LLM 智能体

- 可观测性:AI 应用监控与分析

- API 优先架构:所有功能通过 REST API 开放

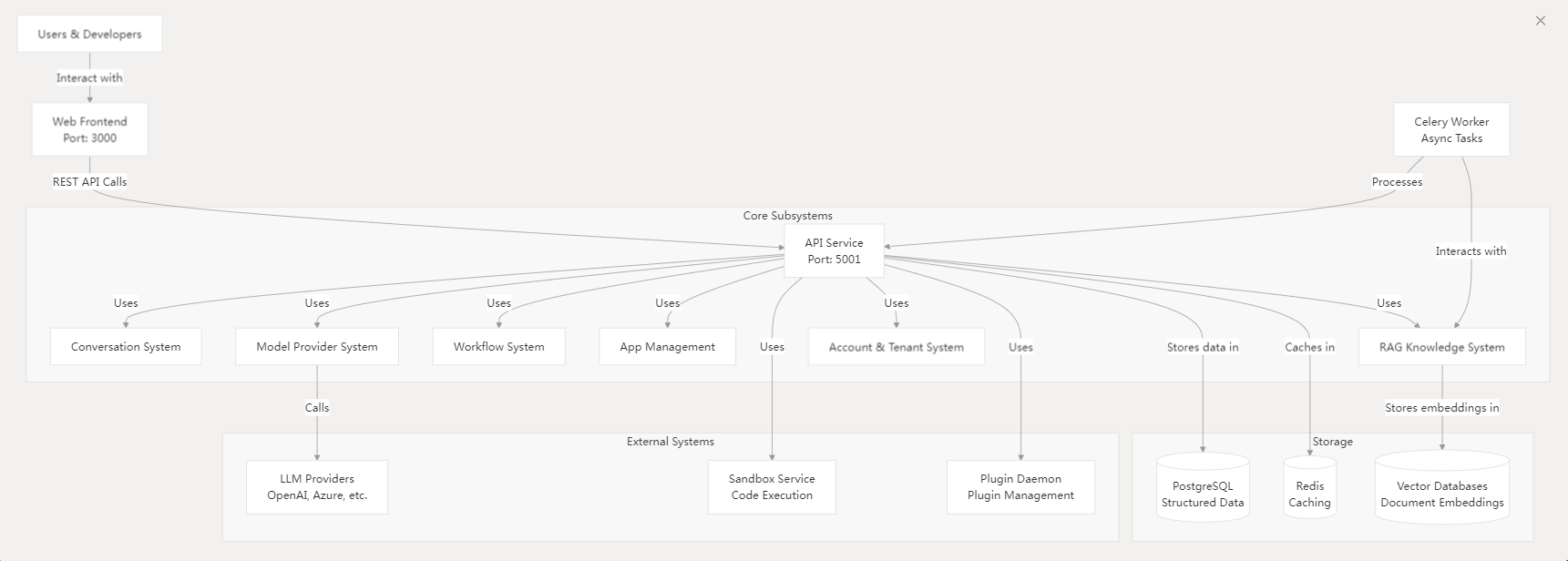

系统架构

Dify 采用前后端分离的现代 Web 应用架构。

- 核心子系统:

- 会话系统

- RAG 知识系统

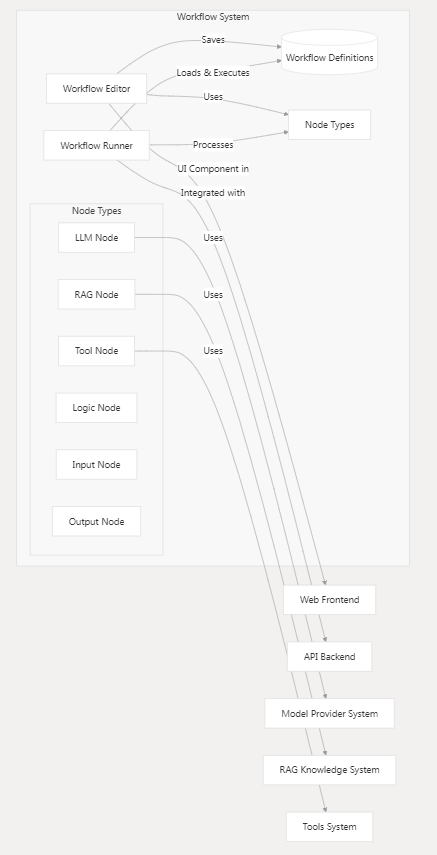

- 工作流系统

- 应用管理系统

- 模型提供商系统

- 账户与租户系统

- 存储:

- PostgreSQL(结构化数据)

- Redis(缓存)

- 向量数据库(文档嵌入)

- 服务交互:

- LLM 提供商(如 OpenAI、Azure)

- 沙箱服务(代码执行)

- 插件守护进程

核心组件

-

Web 前端

- 为开发者与终端用户提供界面,包含工作流构建器、提示词编辑器、数据集管理等功能。

-

API 后端

- 核心服务模块,通过 REST API 驱动前端并支持外部集成,管理会话、知识检索、工作流与模型交互。

-

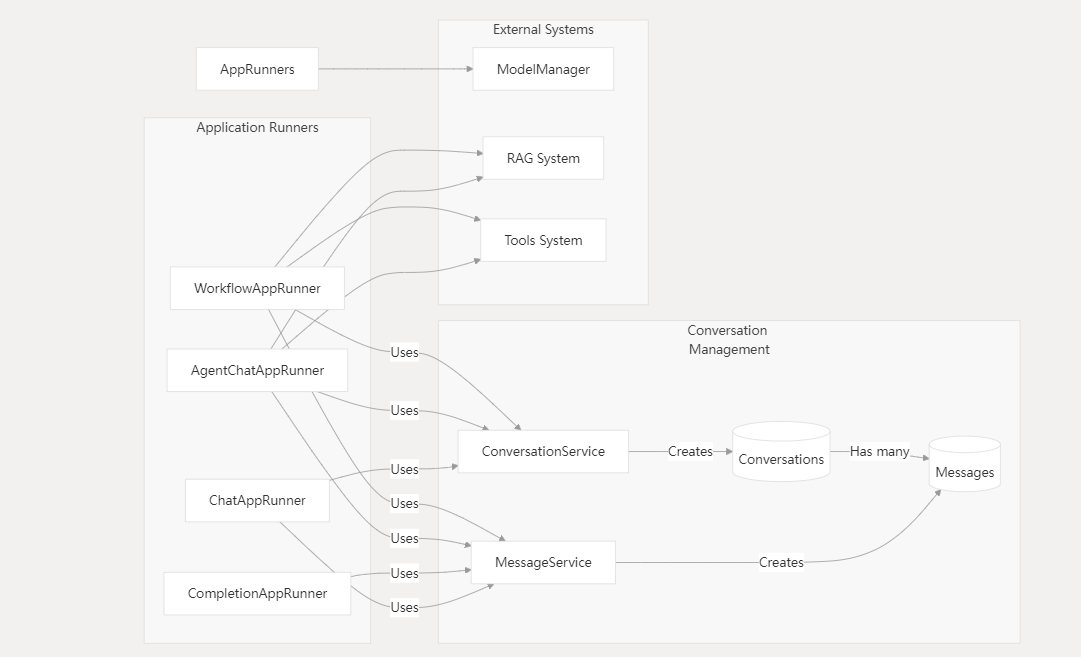

会话系统

- 处理聊天会话与消息,支持多种应用运行器(如聊天应用、代理智能体、工作流应用)。

-

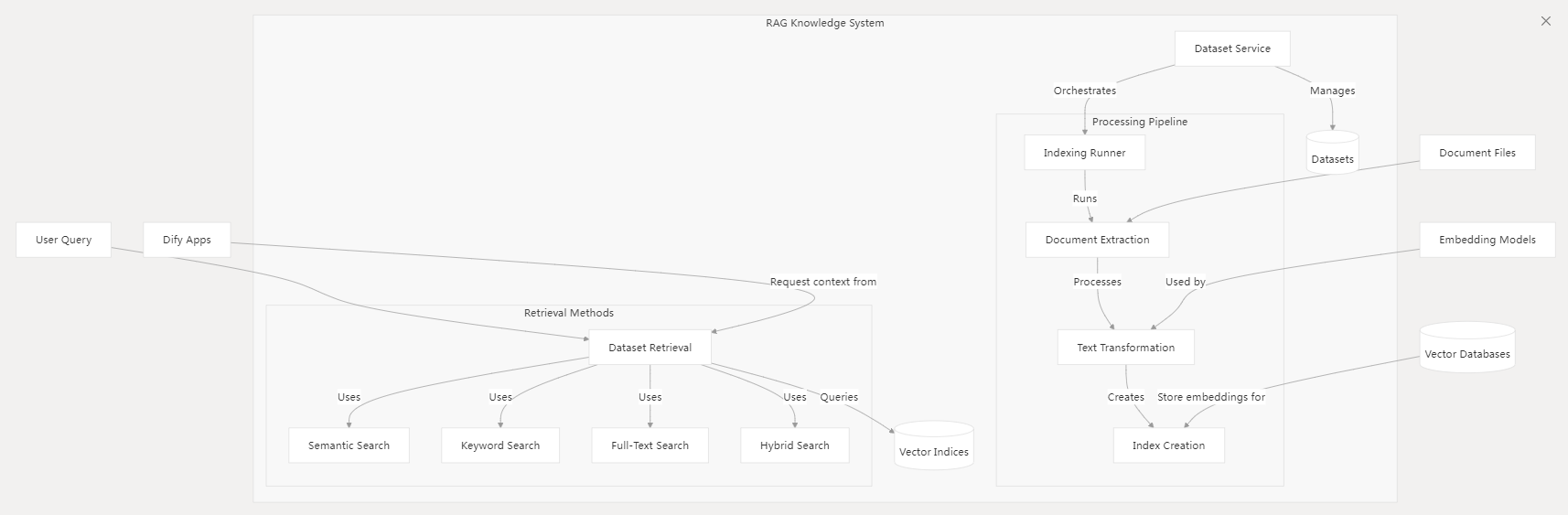

RAG 知识系统

- 实现文档知识增强生成,流程包括:

- 文档解析与分块

- 向量嵌入与存储

- 多模式检索(语义/关键词/混合搜索)

- 实现文档知识增强生成,流程包括:

-

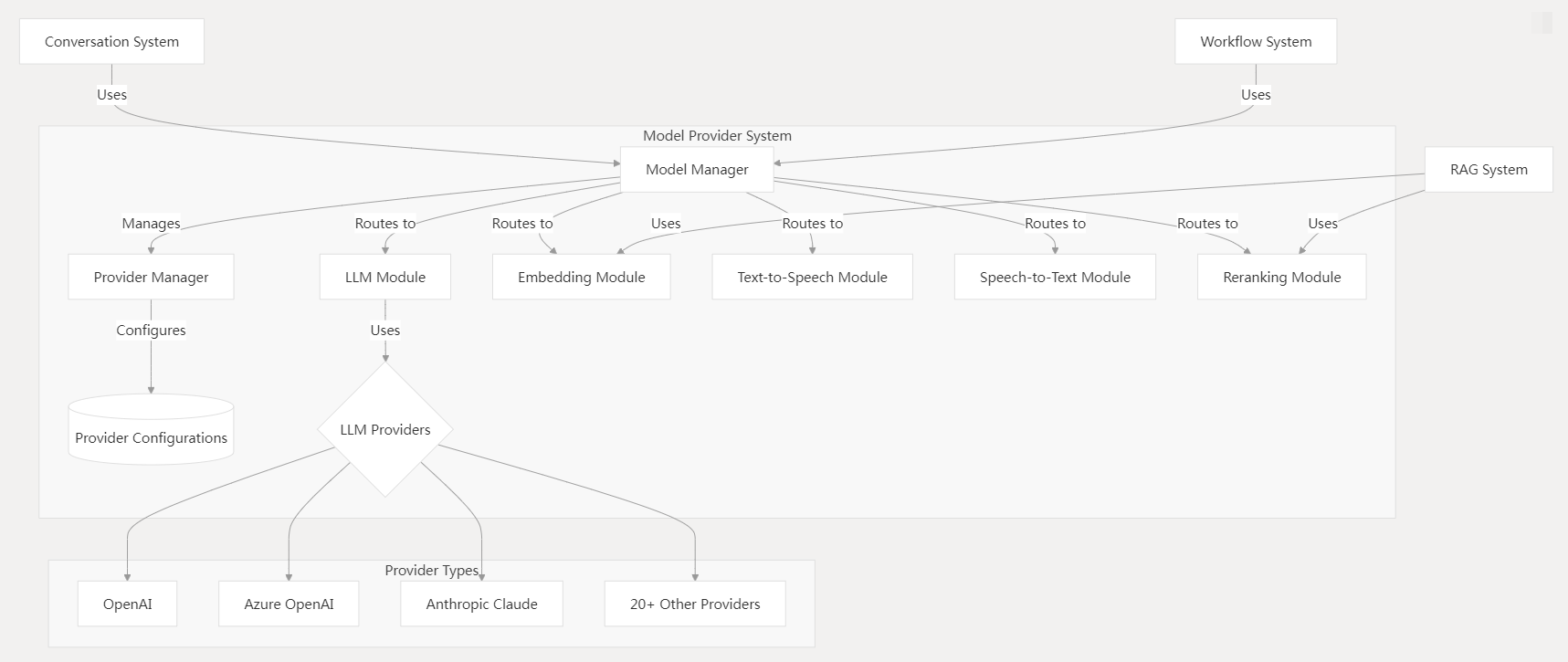

模型提供商系统

- 抽象化 LLM 交互,统一接口支持文本生成、嵌入、语音转换及重排序功能,兼容 20+ 提供商。

-

工作流系统

- 可视化编排复杂 AI 应用流程,支持 LLM 节点、RAG 节点、工具节点等组件连接。

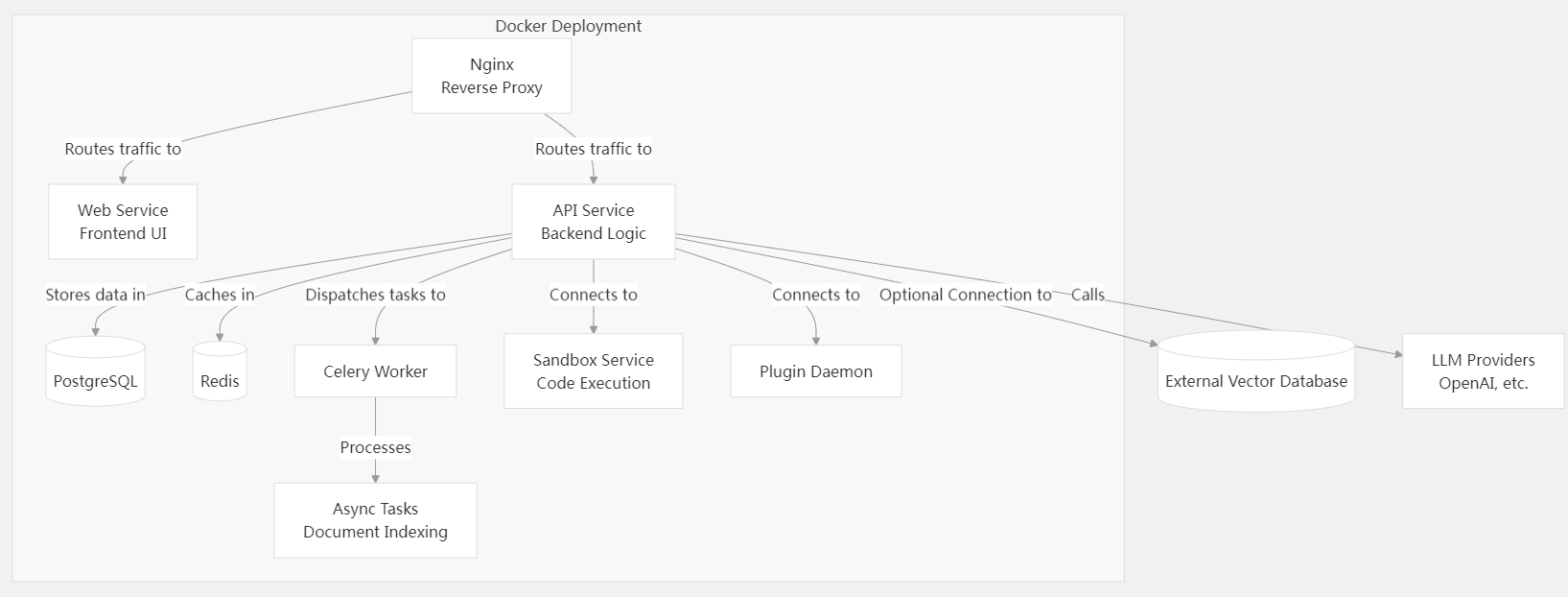

部署选项

- Dify Cloud:免运维托管服务

- 社区版自托管:基于 Docker 部署

- 企业版:增强组织级功能

标准 Docker 部署包含服务:

- Nginx 反向代理

- 前端 Web 服务

- API 后端服务

- PostgreSQL / Redis

- Celery 异步任务队列

- 沙箱服务与插件守护进程

代码结构

关键目录:

/api:后端 API 服务代码/web:前端 React 应用/docker:部署配置文件/sandbox:代码执行服务

后端采用面向服务的架构,不同模块之间的关注点明确分离。

与其他方案对比

与大语言模型应用开发领域的其他工具相比,Dify 提供了一种全面的方法:

| 功能 | Dify.AI | LangChain | Flowise | OpenAI Assistants API |

|---|---|---|---|---|

| 开发方式 | API+应用 | Python | 应用 | API |

| 支持模型多样性 | ✅ | ✅ | ✅ | ❌ (仅 OpenAI) |

| RAG 引擎 | ✅ | ✅ | ✅ | ✅ |

| 智能体支持 | ✅ | ✅ | ❌ | ✅ |

| 工作流 | ✅ | ❌ | ✅ | ❌ |

| 可观测性 | ✅ | ✅ | ❌ | ❌ |

| 企业级功能 | ✅ | ❌ | ❌ | ❌ |

| 本地部署 | ✅ | ✅ | ✅ | ❌ |

结论

Dify 为 LLM 应用开发提供全面平台,涵盖从简单聊天机器人到复杂智能体系统。其架构支持可视化开发与 API 集成,适用于广泛场景。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献37条内容

已为社区贡献37条内容

所有评论(0)