一分钟看完DeepSeek开源周发布了些啥

上周国内外AI科技圈又发生了啥新鲜事?

上周国内外AI科技圈又发生了啥新鲜事?

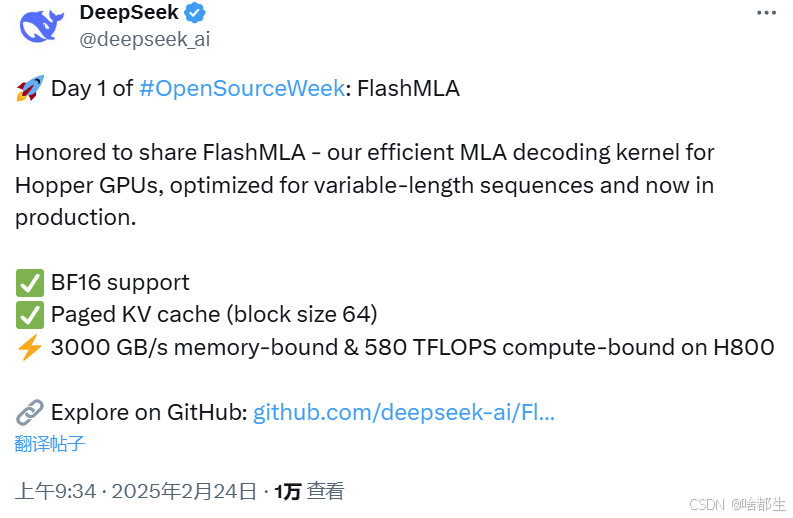

DeepSeek开源FlashMLA,推理加速技术获市场高度关注

DeepSeek在开源周的第一天推出了FlashMLA,一款针对Hopper GPU优化的高效MLA解码内核,旨在降低推理成本并提升效率。该项目上线仅45分钟便收获超过400个Star,且数量仍在快速攀升。FlashMLA支持BF16和64块大小的分页kvcache,可在H800 SXM5 GPU上实现高达3000 GB/s的内存速度和580 TFLOPS的计算性能

https://github.com/deepseek-ai/FlashMLA

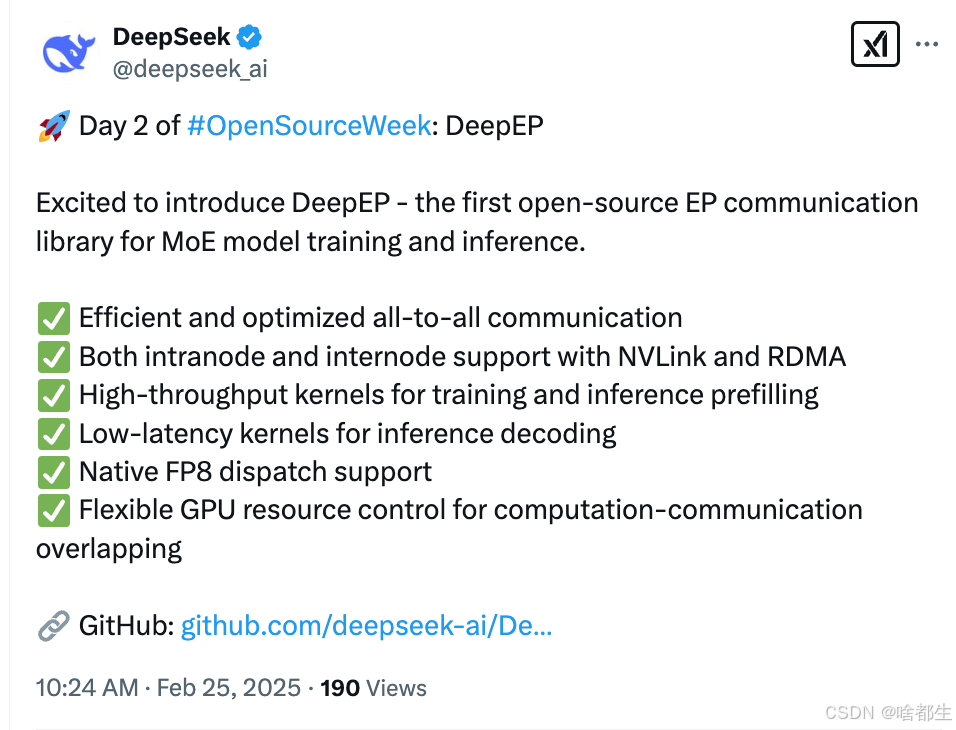

DeepSeek开源MoE训练推理EP通信库DeepEP,展现高效通信与优化能力

DeepSeek在开源周第二天发布了用于MoE模型训练和推理的EP通信库DeepEP。该库针对分布式系统中的数据传输瓶颈进行了优化,支持NVLink和RDMA的节点内/跨节点通信,具备高效优化的All-to-All通信能力。DeepEP还支持FP8数据分发,灵活控制GPU资源,实现计算与通信的高效重叠。在性能测试中,DeepEP展现了高吞吐量和低延迟的特点,其开源后迅速获得超过1000的Star量,受到社区的高度评价

https://github.com/deepseek-ai/DeepEP

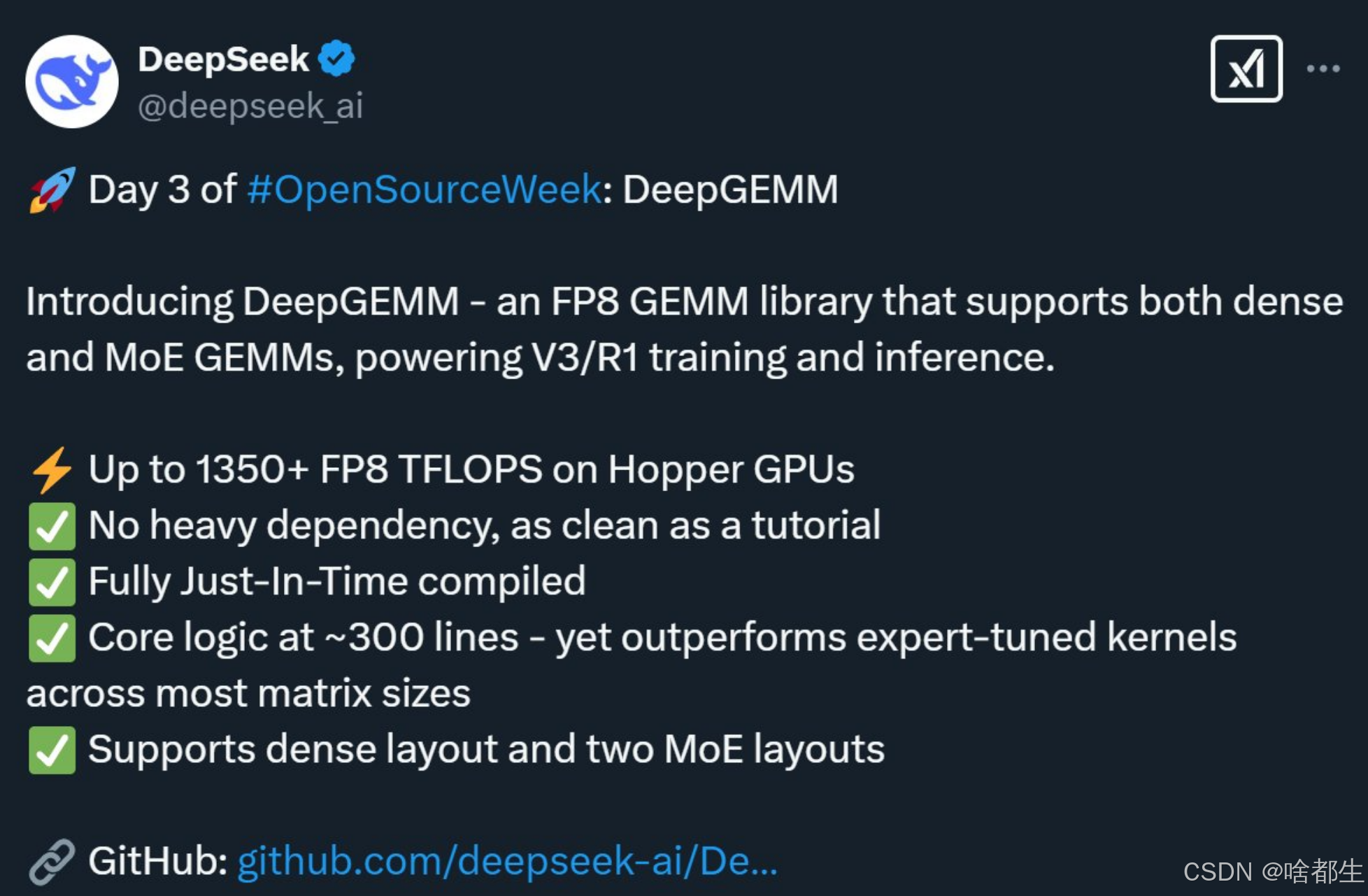

DeepSeek开源300行代码的通用矩阵乘法库,助力V3/R1加速,R2模型或提前发布

DeepSeek在开源周第三天,开源了一个名为DeepGEMM的通用矩阵乘法库,仅用300行代码实现了高效的FP8 GEMM计算,支持密集型和专家混合(MoE)模型,专为Hopper GPU设计,可达到1350+ FP8 TFLOPS的计算性能。该库采用CUDA编写,通过Just-In-Time(JIT)模块实现运行时编译,避免了复杂模板依赖,性能在某些矩阵形状上超越专家调优库。此外,路透社爆料DeepSeek下一代R2大模型可能在5月前发布,较原计划提前,旨在提升代码生成能力和多语言推理能力

https://github.com/deepseek-ai/DeepGEMM

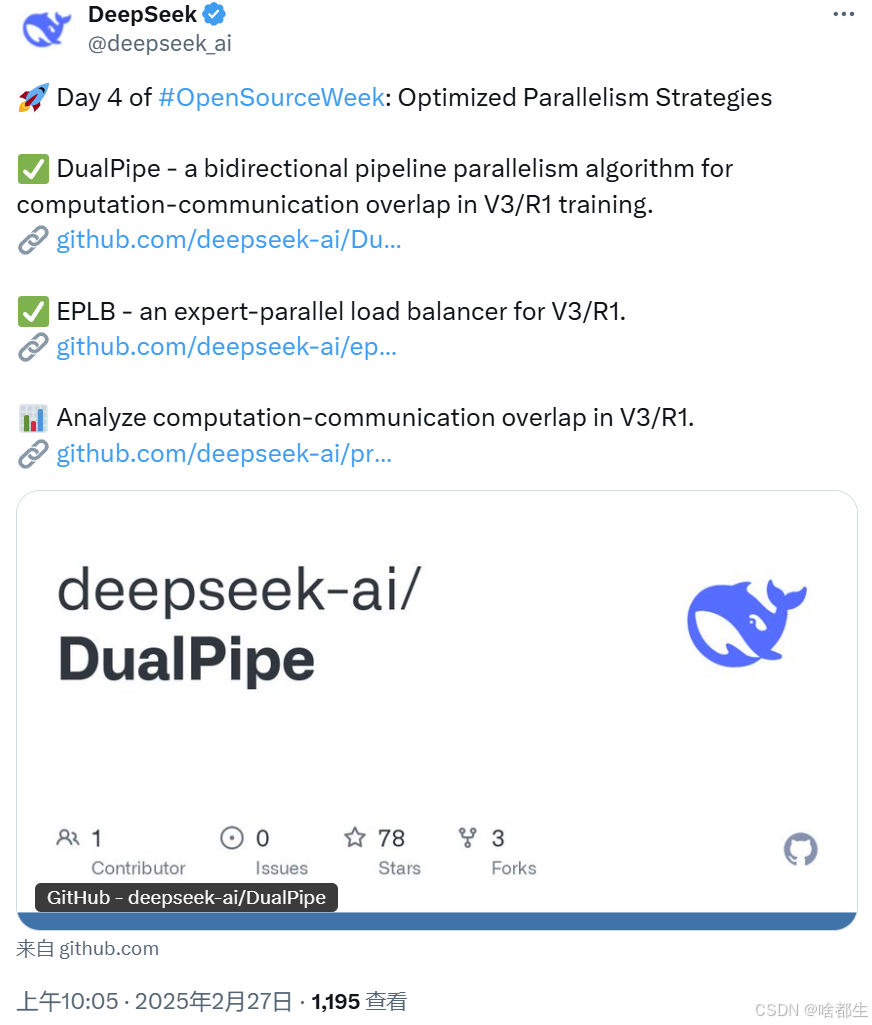

DeepSeek开源三项技术,梁文锋亲自参与,API夜间降价

DeepSeek在开源周第四天一口气发布了两项工具和一个数据集:DualPipe、EPLB以及训练和推理框架的分析数据。DualPipe是一种双向pipeline并行算法,可实现计算-通信重叠,减少流水线气泡;EPLB是专家并行负载均衡器,可智能分配专家负载,提高GPU利用率。此外,DeepSeek还公布了训练和推理框架的分析数据,帮助社区更好地理解通信计算重叠策略。同时,DeepSeek宣布API夜间错峰优惠,DeepSeek-V3和R1在夜间00:30至08:30的调用价格分别降至原价的50%和25%

https://mp.weixin.qq.com/s/aeK5eJMwqNuqJaZczKrhgQ

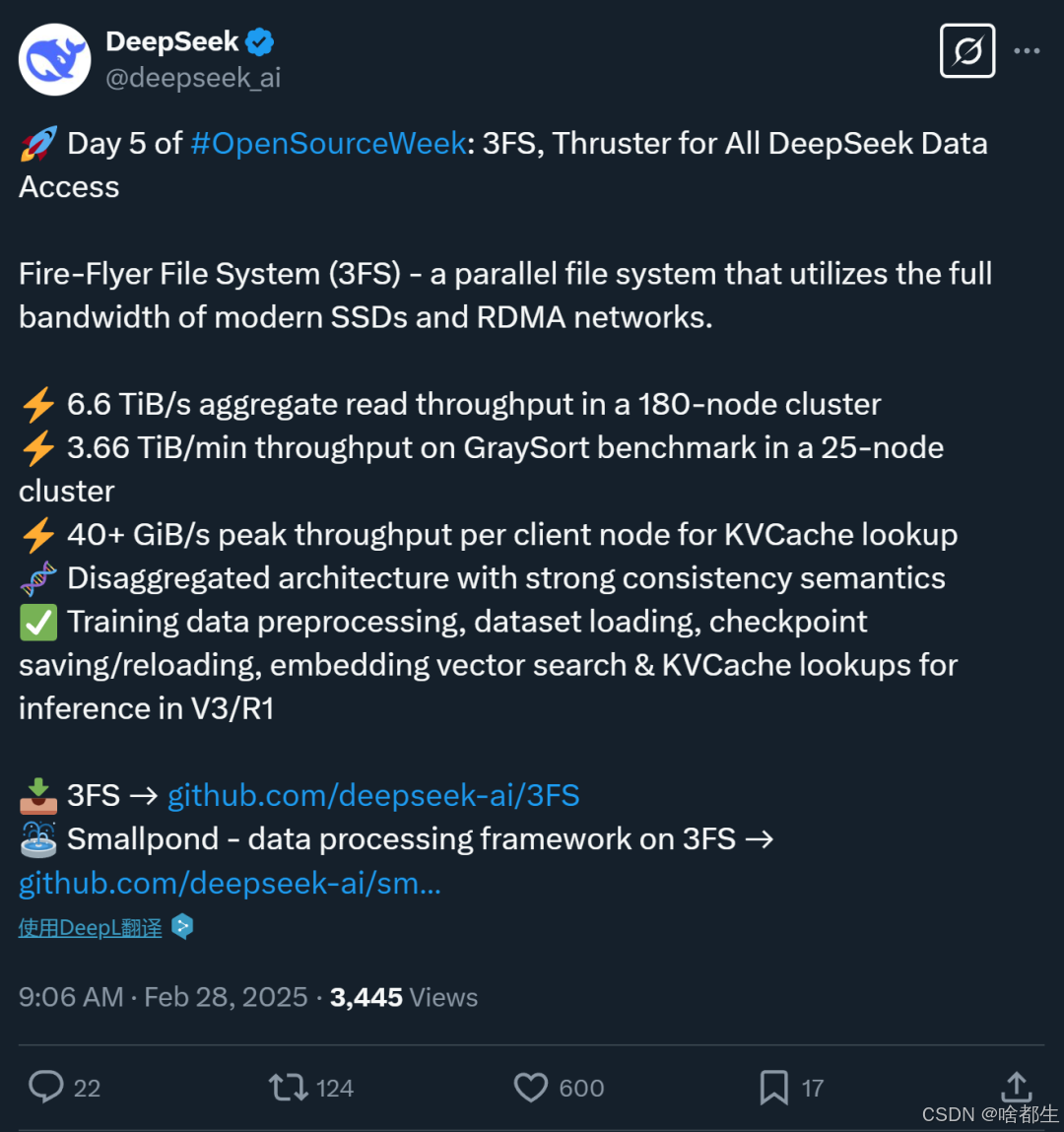

DeepSeek开源高性能文件系统3FS,数据处理速度大幅提升

在DeepSeek开源周的最后一天,其开源的3FS(Fire-Flyer File System)系统成为亮点。3FS是一种并行文件系统,利用现代固态硬盘和RDMA网络的带宽,显著提升了数据访问速度。它在180节点集群中实现了6.6 TiB/s的聚合读取吞吐量,在25节点集群的GraySort基准测试中达到3.66 TiB/min的吞吐量,且每个客户端节点在KVCache查找时可达到40+ GiB/s的峰值吞吐量。该系统采用分离式架构,具备强一致性语义,支持训练数据预处理、数据集加载等多种应用场景,为AI训练和推理工作负载提供了强大的支持,被早期使用者形容为“文件系统界的博尔特”

https://github.com/deepseek-ai/3FS

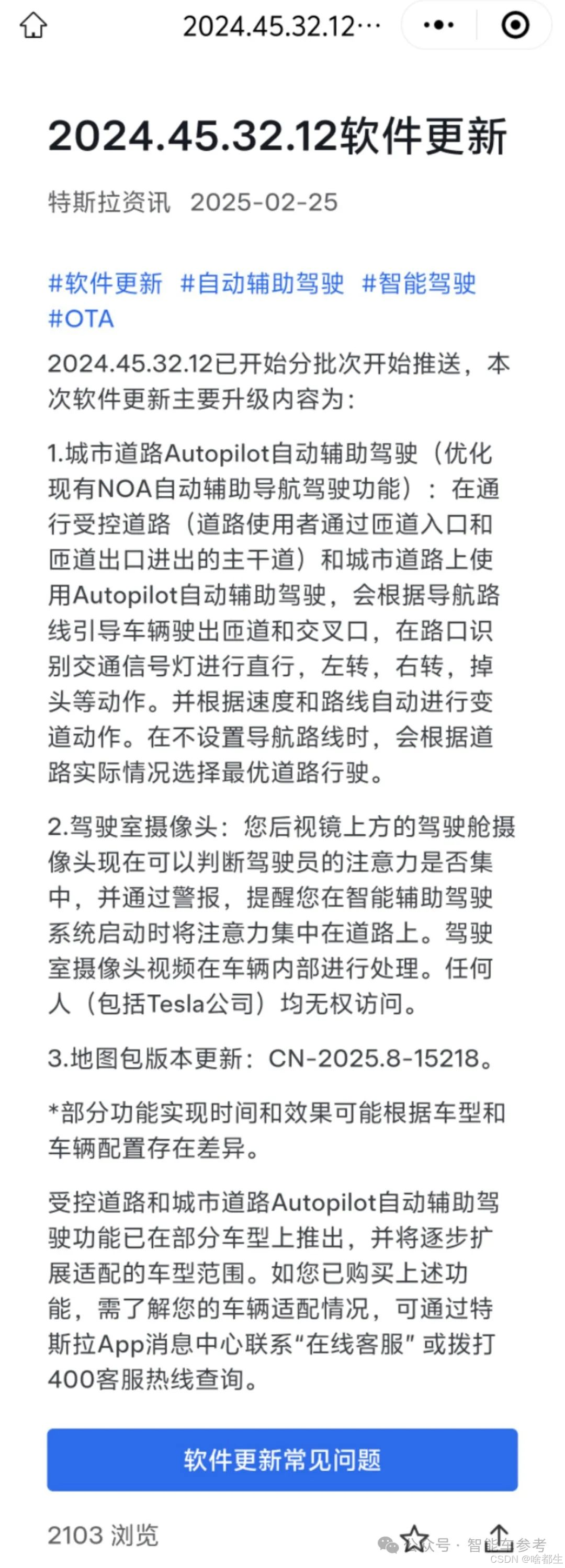

特斯拉FSD入华,城区道路Autopilot功能分批推送

特斯拉FSD(全自动驾驶)功能正式进入中国市场,将通过2024.45.32.12版本更新,分批推送给中国车主。此次更新包括城区道路Autopilot功能,支持自动驶出匝道、识别信号灯、自动变道等,售价6.4万元,可分期购买。FSD的入华将对国内智能驾驶市场产生重大影响,车主们对这一功能充满期待。目前FSD在中国的售价高于美国市场,且国内其他智能驾驶品牌如理想、小鹏等均提供免费或更低价的智驾服务,FSD的市场表现值得期待

https://www.qbitai.com/2025/02/258171.html

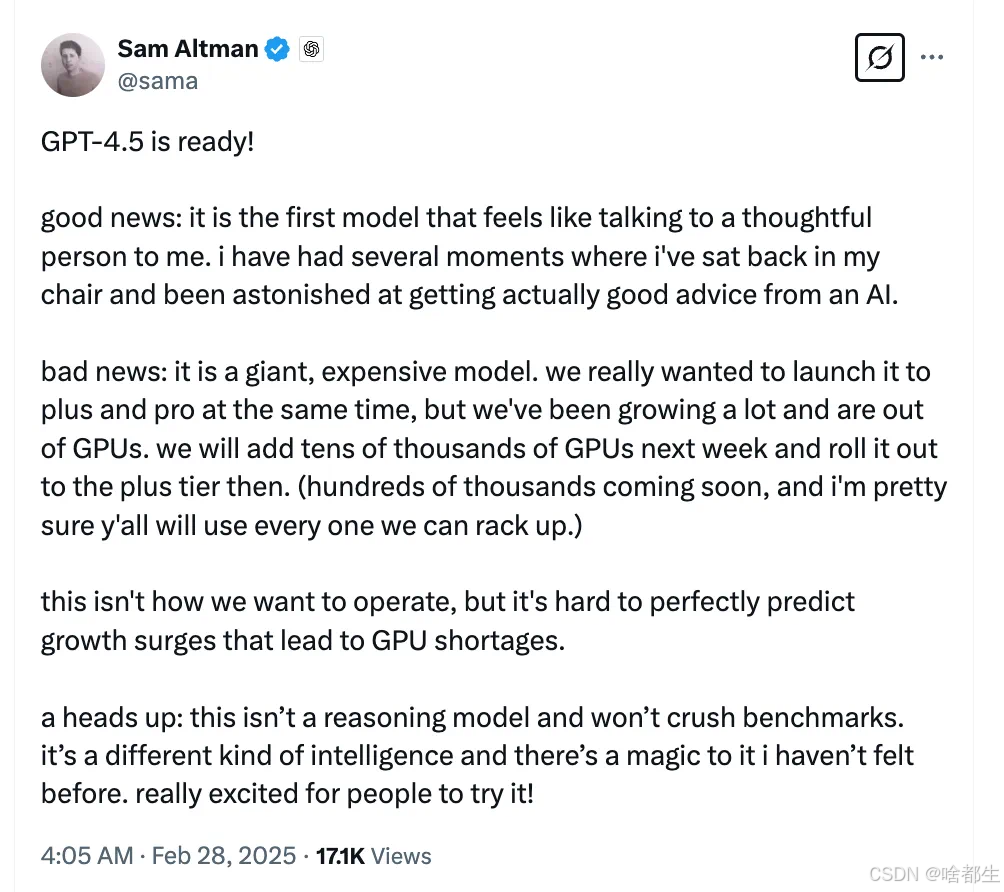

GPT-4.5问世:OpenAI发布迄今最大模型,情商与创造力大幅提升,API价格飞涨30倍

OpenAI正式发布GPT-4.5研究预览版本,这是其迄今为止最大、最强的聊天模型。GPT-4.5通过扩展无监督学习,提升了识别模式、建立联系和产生创造性见解的能力,更注重情商和自然对话体验。测试显示,GPT-4.5在世界知识、减少幻觉、理解人类意图等方面表现优异,尤其在写作、设计等需要高情商的任务中表现出色。然而,其API价格也大幅上涨,每1M token收费75美元,比前代GPT-4o上涨30倍。尽管如此,GPT-4.5仍不支持语音、视频等多模态功能,未来将持续更新优化

https://openai.com/index/introducing-gpt-4-5/

OpenAI Deep Research向所有付费用户开放,并发布系统卡

OpenAI宣布其强大的智能体Deep Research已向ChatGPT Plus、Team、Edu和Enterprise用户全面开放,并发布了Deep Research系统卡。Deep Research能够综合大量在线信息,完成多步骤研究任务,助力用户进行复杂的信息查询与分析。其基础模型为o3正式版,经过了严格的安全测试、风险评估和治理审查。在发布前,OpenAI通过外部红队测试和准备度框架评估,识别并缓解了关键风险,最终将Deep Research评为总体中等风险。缓解后的Deep Research模型在SWE-Lancer测试中表现优异,解决了约46%-51%的任务

https://www.jiqizhixin.com/articles/2025-02-26-8

何恺明团队提出「分形生成模型」,逐像素建模高分辨率图像,效率提升4000倍

何恺明团队最新研究提出了一种名为「分形生成模型」的新型生成架构,灵感来源于数学中的分形概念,通过递归调用同类生成模型构建复杂架构。该模型在逐像素图像生成任务中表现出色,尤其在高分辨率图像建模方面,计算效率相比传统方法提升了4000倍。实验结果显示,该模型在ImageNet数据集上实现了高保真度和多样性的图像生成,为生成建模领域带来了新的范式

https://mp.weixin.qq.com/s/h5awFz1LTG4q2kF0lsg-zQ

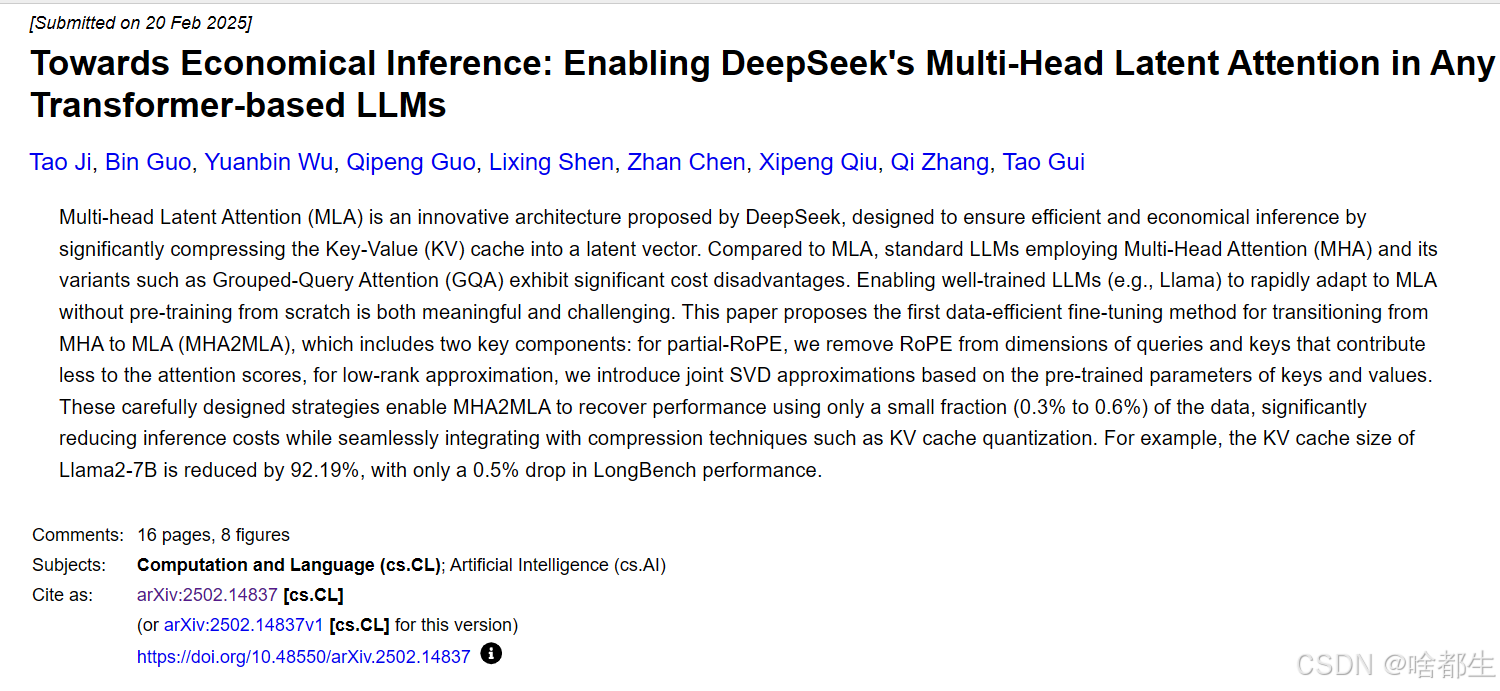

DeepSeek-R1核心机制可轻松迁移,邱锡鹏团队联合出品

复旦大学、华东师范大学及上海AI Lab联合提出了一种名为MHA2MLA的数据高效微调方法,可将基于多头注意力(MHA)的大语言模型转换为多头潜在注意力(MLA)架构,显著降低推理成本。以Llama2-7B为例,该方法在减少92.19%的KV缓存大小的同时,仅使LongBench性能下降0.5%。此外,微调过程仅需0.3%~0.6%的原始数据,展现了高效性和兼容性

https://arxiv.org/abs/2502.14837

Anthropic发布全球首个混合推理模型Claude 3.7 Sonnet,编码能力大幅提升

Anthropic发布了其最新旗舰模型Claude 3.7 Sonnet,全球首个混合推理模型,具备标准和扩展思考模式,用户可通过API细粒度控制思考时间。该模型在编码能力上表现卓越,特别是在SWE-bench Verified基准测试中,性能远超前代和其他竞争对手。同时,Anthropic推出了智能编码工具Claude Code,可帮助开发者从终端完成大量工程任务,显著减少开发时间和成本。Claude 3.7 Sonnet现已通过多个平台开放使用,其价格与前代相同,每百万输入token 3美元,输出token 15美元

https://mp.weixin.qq.com/s/RzdrxKbHKKqtN-FvbOQsZw

Anthropic 开放 Claude AI 的 GitHub 集成,赋能更多开发者

Anthropic 宣布全面开放 Claude AI 的 GitHub 集成,面向免费、Pro 和 Teams 用户。此前,该功能仅限于企业版用户。通过将 GitHub 代码库同步到 Claude,开发者可以利用其强大的代码理解和辅助能力,提升测试、调试和代码优化效率。免费账户使用该功能可能会消耗较多配额,而 Pro 用户则更容易控制配额。继 Google Drive 集成之后,GitHub 集成是 Claude 的又一重要功能拓展,未来还将支持 Google Calendar、Gmail、Salesforce 和 Slack 等服务

https://www.ithome.com/0/834/005.htm

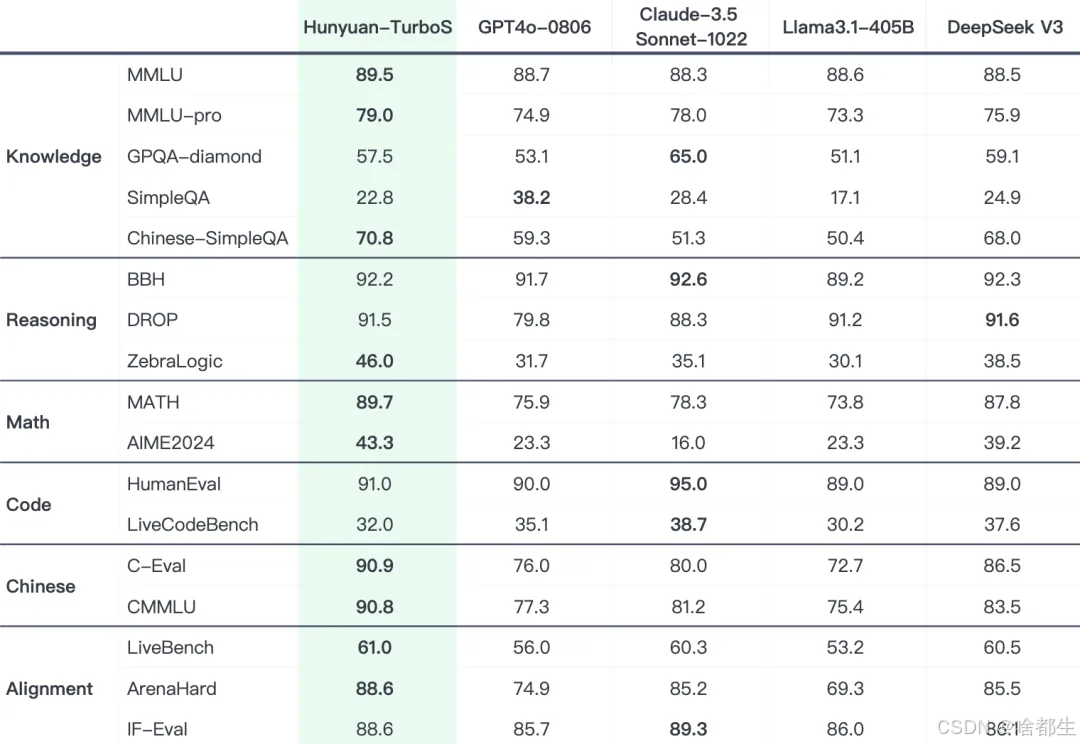

腾讯混元发布新一代快思考模型 Turbo S,性能与成本优化显著

腾讯混元新一代快思考模型 Turbo S 正式发布,区别于传统慢思考模型,Turbo S 能够实现秒回,首字时延降低 44%,吐字速度提升一倍。该模型通过长短思维链融合,显著改进了理科推理能力,并在多个公开 Benchmark 上展现出与业界领先模型相当的效果。架构上,Turbo S 采用创新的 Hybrid-Mamba-Transformer 模式,降低了计算复杂度和缓存占用,大幅降低了部署成本。目前,该模型已在腾讯云官网上架,开发者和企业用户可通过 API 调用,且一周内免费试用

https://mp.weixin.qq.com/s/BwQkXpEitOm1Piz60SE-4A

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)