基于MIXAPI实现DeepSeek大模型API转OpenAI格式:从原理到落地的全链路实践

企业场景中“单账号多成员共享”的核心需求,可通过MIXAPI的“令牌管理”功能实现,对应源码在 controller/token.go 与 model/token.go ,支持“额度限制”“IP白名单”“模型权限”三大控制维度。后台“数据看板”模块提供“总请求数”“成功率”“额度消耗”等核心指标,对应源码 controller/statistics.go ,支持按日期、令牌、模型分组查看,便于快速

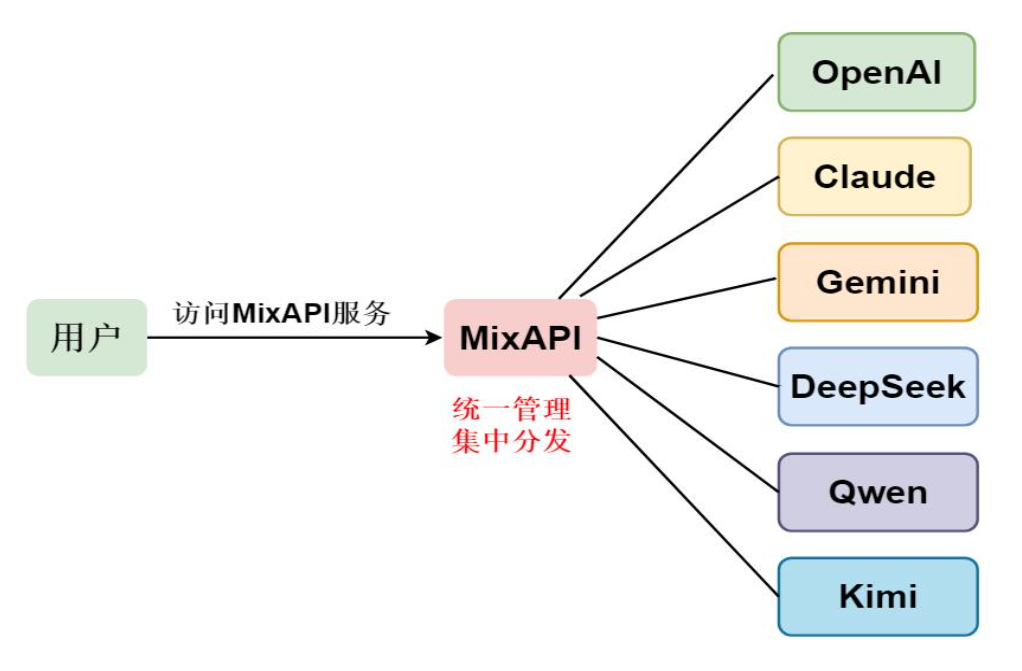

在大模型应用落地过程中,开发者常面临“模型接口碎片化”与“团队资源共享难”的双重困境。以DeepSeek v3.1为例,其卓越的代码理解与生成能力备受青睐,但大量编程工具(如Cursor、CodeGeeX IDE插件)仅原生支持OpenAI API格式;Claude系列模型同样存在类似兼容性问题。同时,企业级场景中“单账号多成员共享”的需求,也亟需一套安全、可审计的接口管理方案。

MIXAPI作为新一代大模型网关,凭借“多模型聚合”“标准接口转换”“精细化权限控制”三大核心能力,成为解决上述问题的最优解。本文将从源码层面深度解析如何基于MIXAPI实现DeepSeek API到OpenAI格式的转换,并拓展至Claude适配与团队共享配置,为技术团队提供可直接落地的实践指南。

一、MIXAPI核心架构与转换原理:为何能实现“一网关通多模型”

在动手配置前,需先理解MIXAPI实现接口转换的底层逻辑。其核心在于**“请求协议转换层”** 与**“模型渠道适配层”** 的解耦设计,通过标准化的中间数据结构,实现“入参-适配-转发-出参”的全链路兼容。

1.1 核心目录结构与职责划分

从MIXAPI项目源码(github.com/aiprodcoder/MIXAPI)的目录设计,可清晰看到其分层架构:

plaintext

MIXAPI/

├── controller/ # 接口请求入口(接收OpenAI格式请求)

│ ├── chat.go # 聊天接口控制器(核心转换入口)

│ └── completion.go # 文本补全接口控制器

├── service/ # 业务逻辑层(核心转换逻辑)

│ ├── adapter/ # 模型适配层(DeepSeek、Claude等适配逻辑)

│ │ ├── deepseek.go

│ │ └── claude.go

│ └── relay.go # 请求转发服务(统一调用适配层)

├── model/ # 数据模型层(标准化中间数据结构)

│ └── message.go # 统一消息格式(兼容OpenAI/Claude/DeepSeek)

└── router/ # 路由配置(映射OpenAI接口路径)

└── api.go # 注册/api/chat/completions等OpenAI标准路径

1.2 转换核心流程:从OpenAI请求到DeepSeek响应

以最常用的 /v1/chat/completions 接口为例,MIXAPI的转换流程可拆解为3步,核心源码集中在 service/adapter/deepseek.go 与 controller/chat.go 中:

步骤1:接收OpenAI格式请求(controller层)

controller/chat.go 中 CreateChatCompletion 函数负责接收客户端发送的OpenAI标准请求,将其解析为MIXAPI内部统一的 model.ChatRequest 结构:

go

// controller/chat.go

func CreateChatCompletion(c *gin.Context) {

// 1. 接收OpenAI格式请求

var req openai.ChatCompletionRequest

if err := c.ShouldBindJSON(&req); err != nil {

c.JSON(400, gin.H{"error": err.Error()})

return

}

// 2. 转换为内部统一请求格式

internalReq := &model.ChatRequest{

Model: req.Model,

Messages: convertOpenAIMessagesToInternal(req.Messages), // 消息格式转换

Stream: req.Stream,

MaxTokens: req.MaxTokens,

Temperature: req.Temperature,

}

// 3. 调用service层处理转换与转发

resp, err := service.CreateChatCompletion(internalReq, getAuthInfo(c))

if err != nil {

c.JSON(500, gin.H{"error": err.Error()})

return

}

// 4. 将DeepSeek响应转换为OpenAI格式返回

openaiResp := convertInternalToOpenAIResponse(resp)

c.JSON(200, openaiResp)

}

步骤2:DeepSeek适配与请求转发(service/adapter层)

service/adapter/deepseek.go 中的 DeepSeekAdapter 结构体实现了统一的 Adapter 接口,核心是 CreateChatCompletion 方法,负责将内部请求转换为DeepSeek API要求的格式:

go

// service/adapter/deepseek.go

type DeepSeekAdapter struct {

apiKey string // DeepSeek账号API Key

baseURL string // DeepSeek API基础地址(默认https://api.deepseek.com)

httpClient *http.Client

}

// 实现Adapter接口的CreateChatCompletion方法

func (a *DeepSeekAdapter) CreateChatCompletion(req *model.ChatRequest) (*model.ChatResponse, error) {

// 1. 转换内部消息格式为DeepSeek格式

deepSeekMsgs := make([]DeepSeekMessage, 0, len(req.Messages))

for _, msg := range req.Messages {

// DeepSeek消息角色与OpenAI一致(user/assistant/system),直接映射

deepSeekMsgs = append(deepSeekMsgs, DeepSeekMessage{

Role: msg.Role,

Content: msg.Content,

})

}

// 2. 构造DeepSeek API请求体

dsReq := DeepSeekChatRequest{

Model: "deepseek-chat", // 固定映射DeepSeek v3.1模型名

Messages: deepSeekMsgs,

MaxTokens: req.MaxTokens,

Temperature: req.Temperature,

Stream: req.Stream,

}

// 3. 发送请求到DeepSeek API

reqBody, _ := json.Marshal(dsReq)

httpReq, _ := http.NewRequest("POST", a.baseURL+"/v1/chat/completions", bytes.NewBuffer(reqBody))

httpReq.Header.Set("Authorization", "Bearer "+a.apiKey)

httpReq.Header.Set("Content-Type", "application/json")

// 4. 接收DeepSeek响应并转换为内部格式

resp, err := a.httpClient.Do(httpReq)

if err != nil {

return nil, fmt.Errorf("deepseek request failed: %v", err)

}

defer resp.Body.Close()

var dsResp DeepSeekChatResponse

if err := json.NewDecoder(resp.Body).Decode(&dsResp); err != nil {

return nil, fmt.Errorf("deepseek response decode failed: %v", err)

}

// 5. 转换DeepSeek响应为内部统一格式

internalResp := &model.ChatResponse{

ID: dsResp.ID,

Model: req.Model, // 回显客户端请求的模型名(如gpt-3.5-turbo)

Choices: []model.ChatChoice{

{

Message: model.Message{

Role: "assistant",

Content: dsResp.Choices[0].Message.Content,

},

FinishReason: dsResp.Choices[0].FinishReason,

},

},

Usage: model.Usage{

PromptTokens: dsResp.Usage.PromptTokens,

CompletionTokens: dsResp.Usage.CompletionTokens,

TotalTokens: dsResp.Usage.TotalTokens,

},

}

return internalResp, nil

}

步骤3:响应格式回显(controller层)

controller/chat.go 中的 convertInternalToOpenAIResponse 函数,将 model.ChatResponse 转换为OpenAI标准响应格式,确保客户端(如编程工具)能正常解析:

go

// controller/chat.go

func convertInternalToOpenAIResponse(internalResp *model.ChatResponse) *openai.ChatCompletionResponse {

choices := make([]openai.ChatCompletionChoice, 0, len(internalResp.Choices))

for _, choice := range internalResp.Choices {

choices = append(choices, openai.ChatCompletionChoice{

Message: openai.ChatCompletionMessage{

Role: choice.Message.Role,

Content: choice.Message.Content,

},

FinishReason: choice.FinishReason,

Index: choice.Index,

})

}

return &openai.ChatCompletionResponse{

ID: internalResp.ID,

Object: "chat.completion", // OpenAI固定字段

Created: time.Now().Unix(),

Model: internalResp.Model,

Choices: choices,

Usage: openai.Usage{

PromptTokens: internalResp.Usage.PromptTokens,

CompletionTokens: internalResp.Usage.CompletionTokens,

TotalTokens: internalResp.Usage.TotalTokens,

},

}

}

二、实战部署:从源码编译到DeepSeek渠道配置

理解原理后,进入实战环节。本节将基于MIXAPI源码,完成“环境准备-编译部署-渠道配置”全流程,最终实现通过OpenAI接口调用DeepSeek v3.1。

2.1 环境准备与源码编译

MIXAPI基于Go语言开发,需先安装Go 1.21+环境,编译过程仅需3步:

步骤1:拉取源码并进入项目目录

bash

git clone https://github.com/aiprodcoder/MIXAPI.git

cd MIXAPI

步骤2:修改配置文件(.env.example)

复制示例配置文件并修改核心参数(数据库、端口等):

bash

cp .env.example .env

打开 .env 文件,配置关键参数(其他参数默认即可):

ini

# 服务端口(默认3000)

PORT=3000

# 数据库配置(本地测试用SQLite,生产用MySQL)

DB_TYPE=sqlite3

DB_PATH=/data/mixapi.db

# 管理员账号密码(首次登录用)

ADMIN_USER=admin

ADMIN_PASSWORD=123456

步骤3:编译并运行

bash

# 编译(生成mixapi可执行文件)

go build -o mixapi main.go

# 运行

./mixapi

此时访问 http://localhost:3000 ,输入账号 admin 、密码 123456 ,即可进入MIXAPI管理后台。

2.2 配置DeepSeek渠道:实现API转换的关键一步

进入管理后台后,需先配置DeepSeek渠道(即接入DeepSeek账号的API Key),核心操作在“渠道管理”模块,对应源码中的 controller/channel.go 与 model/channel.go 。

步骤1:创建DeepSeek渠道

1. 登录MIXAPI后台,点击左侧“渠道管理”→“添加渠道”;

2. 填写渠道信息(关键参数对应源码 model/channel.go 的 Channel 结构体):

- 渠道名称:DeepSeek-v3.1(自定义)

- 渠道类型:选择“DeepSeek”(对应 service/adapter/deepseek.go 的适配器)

- API Key:填写你的DeepSeek账号API Key(从DeepSeek控制台获取)

- 基础URL:默认 https://api.deepseek.com (可留空,适配器会自动填充)

- 模型映射:添加“模型别名”(如将 gpt-3.5-turbo 映射到 deepseek-chat ,实现客户端用OpenAI模型名调用DeepSeek)

步骤2:源码层面理解渠道配置的存储与生效

渠道配置会存储到数据库(对应 model/channel.go 的 Channel 结构体),当客户端发送请求时, service/relay.go 会根据请求的模型名匹配对应的渠道:

go

// service/relay.go

func getMatchedChannel(model string) (*model.Channel, error) {

// 1. 查询所有启用的渠道

channels, err := model.GetEnabledChannels()

if err != nil {

return nil, err

}

// 2. 根据模型名匹配渠道(优先匹配模型别名)

for _, ch := range channels {

if ch.ModelAlias == model || ch.Model == model {

// 3. 返回匹配的渠道,并初始化对应的适配器(如DeepSeekAdapter)

adapter, err := adapter.NewAdapter(ch.Type, ch.APIKey, ch.BaseURL)

if err != nil {

continue

}

ch.Adapter = adapter

return ch, nil

}

}

return nil, fmt.Errorf("no channel matched for model: %s", model)

}

2.3 测试转换效果:用OpenAI客户端调用DeepSeek

配置完成后,可通过 curl 或Postman测试转换效果,客户端无需修改任何代码,仅需将OpenAI的API地址改为MIXAPI地址,API Key改为MIXAPI生成的令牌。

测试命令(curl示例)

bash

curl http://localhost:3000/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer sk-Wrok********0G7" \ # MIXAPI生成的令牌

-d '{

"model": "gpt-3.5-turbo", # 模型别名,已映射到DeepSeek

"messages": [{"role": "user", "content": "用Go写一个Hello World"}]

}'

预期响应(OpenAI格式)

json

{

"id": "ds-xxxxxx",

"object": "chat.completion",

"created": 1726000000,

"model": "gpt-3.5-turbo",

"choices": [

{

"message": {

"role": "assistant",

"content": "package main\n\nimport \"fmt\"\n\nfunc main() {\n fmt.Println(\"Hello World\")\n}"

},

"finish_reason": "stop",

"index": 0

}

],

"usage": {

"prompt_tokens": 15,

"completion_tokens": 30,

"total_tokens": 45

}

}

此时,MIXAPI已成功将OpenAI格式请求转发至DeepSeek,并将响应转换为OpenAI格式返回,客户端(如编程工具)可无缝兼容。

三、拓展场景:Claude适配与企业级团队共享配置

MIXAPI的适配能力不仅限于DeepSeek,对Claude系列模型(如Claude 3 Opus)同样支持;同时,其“令牌管理”功能可解决企业“单账号多成员共享”的需求,且支持精细化权限控制。

3.1 Claude模型适配:与DeepSeek的差异与配置

Claude API的消息格式与OpenAI略有不同(如支持 system 提示的单独字段),MIXAPI在 service/adapter/claude.go 中做了针对性适配:

Claude适配核心源码

go

// service/adapter/claude.go

func (a *ClaudeAdapter) CreateChatCompletion(req *model.ChatRequest) (*model.ChatResponse, error) {

// 1. 分离system消息(Claude要求system提示单独传入)

var systemPrompt string

var userMsgs []ClaudeMessage

for _, msg := range req.Messages {

if msg.Role == "system" {

systemPrompt = msg.Content

} else {

userMsgs = append(userMsgs, ClaudeMessage{

Role: msg.Role,

Content: msg.Content,

})

}

}

// 2. 构造Claude API请求体(与DeepSeek格式差异核心)

claudeReq := ClaudeChatRequest{

Model: "claude-3-opus-20240229",

System: systemPrompt, // 单独的system字段

Messages: userMsgs,

MaxTokens: req.MaxTokens,

Temperature: req.Temperature,

}

// 3. 发送请求并转换响应(后续流程与DeepSeek一致)

// ...(省略HTTP请求与响应转换代码,逻辑与DeepSeekAdapter类似)

}

Claude渠道配置步骤

与DeepSeek配置流程一致,仅需在“添加渠道”时选择“Claude”类型,填写Claude的API Key(从Anthropic控制台获取),并设置模型别名(如将 gpt-4 映射到 claude-3-opus-20240229 )。

3.2 企业级团队共享:令牌管理与权限控制

企业场景中“单账号多成员共享”的核心需求,可通过MIXAPI的“令牌管理”功能实现,对应源码在 controller/token.go 与 model/token.go ,支持“额度限制”“IP白名单”“模型权限”三大控制维度。

步骤1:创建团队共享令牌

1. 登录MIXAPI后台,点击左侧“API令牌”→“添加令牌”;

2. 配置共享权限(对应 model/token.go 的 Token 结构体字段):

- 令牌名称:前端团队-DeepSeek(自定义,便于区分)

- 额度限制:设置该令牌的总可用额度(如100美元,防止过度使用)

- 模型权限:仅勾选“DeepSeek-v3.1”(限制该令牌只能调用DeepSeek,无法访问Claude)

- IP白名单:填写公司内部网段(如192.168.31.0/24,防止令牌外泄后被外部使用)

- 访问频率限制:设置“1分钟访问次数限制=18”“1天访问次数限制=250”(避免单用户高频调用占用资源)

步骤2:令牌权限控制核心源码

MIXAPI在 middleware/auth.go 中对令牌权限进行前置校验,确保不符合权限的请求被拦截:

go

// middleware/auth.go

func AuthMiddleware() gin.HandlerFunc {

return func(c *gin.Context) {

// 1. 解析请求头中的令牌

tokenStr := c.GetHeader("Authorization")

tokenStr = strings.TrimPrefix(tokenStr, "Bearer ")

token, err := model.GetTokenByKey(tokenStr)

if err != nil {

c.JSON(401, gin.H{"error": "invalid token"})

c.Abort()

return

}

// 2. 校验IP白名单

clientIP := c.ClientIP()

if !isIPAllowed(clientIP, token.IPWhitelist) {

c.JSON(403, gin.H{"error": "IP not allowed"})

c.Abort()

return

}

// 3. 校验模型权限

modelName := c.Query("model")

if !isModelAllowed(modelName, token.AllowedModels) {

c.JSON(403, gin.H{"error": "model not allowed"})

c.Abort()

return

}

// 4. 校验访问频率(基于Redis实现限流)

if err := checkRateLimit(token.ID); err != nil {

c.JSON(429, gin.H{"error": "rate limit exceeded"})

c.Abort()

return

}

// 5. 校验额度(足够则继续,不足则拦截)

if err := checkTokenQuota(token.ID); err != nil {

c.JSON(402, gin.H{"error": "insufficient quota"})

c.Abort()

return

}

c.Next()

}

}

步骤3:团队成员使用方式

团队成员无需获取企业的DeepSeek/Claude主账号API Key,仅需在编程工具中配置:

- API地址: http://MIXAPI服务器IP:3000/v1

- API Key:管理员分配的共享令牌(如 sk-Wrok********0G7 )

- 模型名:使用管理员配置的别名(如 gpt-3.5-turbo 对应DeepSeek, gpt-4 对应Claude)

四、性能优化与问题排查:保障生产环境稳定运行

MIXAPI在源码层面做了大量性能优化,同时提供完善的日志与监控功能,确保生产环境下的高可用性。

4.1 性能优化:高并发场景下的关键设计

1. 请求缓存(基于Redis/Memory)

源码 service/cache.go 实现了请求缓存功能,开启后相同prompt的请求可直接返回缓存结果,减少重复调用模型的开销:

go

// service/cache.go

func GetCachedResponse(req *model.ChatRequest) (*model.ChatResponse, bool) {

if !setting.MemoryCacheEnabled && setting.RedisConnString == "" {

return nil, false

}

// 生成缓存Key(基于prompt、model、temperature等关键参数)

cacheKey := fmt.Sprintf("mixapi:cache:%s:%d",

hashString(req.Messages[0].Content+req.Model),

int(req.Temperature*100))

// 从Redis或内存中获取缓存

var cachedResp model.ChatResponse

if setting.RedisConnString != "" {

// Redis缓存逻辑

data, err := redisClient.Get(ctx, cacheKey).Result()

if err != nil {

return nil, false

}

json.Unmarshal([]byte(data), &cachedResp)

} else {

// 内存缓存逻辑(基于sync.Map)

if val, ok := memoryCache.Load(cacheKey); ok {

cachedResp = val.(model.ChatResponse)

} else {

return nil, false

}

}

return &cachedResp, true

}

开启方式:在 .env 文件中设置 MEMORY_CACHE_ENABLED=true 或 REDIS_CONN_STRING=redis://localhost:6379 。

2. 异步日志与批量统计

源码 service/log.go 采用异步日志写入(基于 go channel ),避免日志IO阻塞请求处理;同时 service/statistics.go 实现批量统计用量,减少数据库写入频率:

go

// service/log.go

var logChan = make(chan *model.RequestLog, 1000)

func init() {

// 启动异步日志写入协程

go func() {

for log := range logChan {

// 批量写入数据库(每100条写一次)

batchWriteLogs(log)

}

}()

}

func RecordRequestLog(log *model.RequestLog) {

// 非阻塞写入日志通道

select {

case logChan <- log:

default:

// 通道满时直接丢弃(避免阻塞主流程)

fmt.Println("log channel full, drop log")

}

}

4.2 问题排查:日志与监控工具

1. 详细请求日志

MIXAPI在 controller/chat.go 中记录每一次请求的详细信息(包括渠道、令牌、输入输出内容),可在后台“使用日志”模块查看,对应源码:

go

// controller/chat.go

func CreateChatCompletion(c *gin.Context) {

// ...(请求处理逻辑)

// 记录请求日志

service.RecordRequestLog(&model.RequestLog{

ChannelID: resp.ChannelID,

TokenID: authInfo.TokenID,

UserID: authInfo.UserID,

Model: req.Model,

Input: req.Messages[0].Content,

Output: openaiResp.Choices[0].Message.Content,

Usage: openaiResp.Usage,

Status: "success",

ClientIP: c.ClientIP(),

RequestTime: time.Now(),

})

}

2. 数据看板监控

后台“数据看板”模块提供“总请求数”“成功率”“额度消耗”等核心指标,对应源码 controller/statistics.go ,支持按日期、令牌、模型分组查看,便于快速定位问题(如某令牌成功率低,可能是IP白名单配置错误)。

五、总结:MIXAPI的价值与未来拓展

通过本文的源码解析与实战部署,我们实现了三大核心目标:

1. 接口兼容:将DeepSeek/Claude API转换为OpenAI格式,解决编程工具适配问题;

2. 资源共享:通过令牌管理实现企业单账号多成员安全共享,避免API Key泄露;

3. 高效可控:借助缓存、限流、日志等功能,保障生产环境稳定运行。

从技术选型角度,MIXAPI的优势在于“全开源+低侵入+高扩展性”:

- 全开源:所有转换逻辑与权限控制代码可查,企业可根据需求二次开发(如添加自定义模型适配器);

- 低侵入:客户端无需修改代码,仅需更换API地址与令牌;

- 高扩展性:源码 service/adapter 目录的适配器模式设计,新增模型(如Qwen、Kimi)仅需实现 Adapter 接口即可。

未来,可基于MIXAPI进一步拓展场景,如:

- 对接企业SSO系统(源码 middleware/auth.go 支持扩展OIDC登录);

- 实现模型自动降级(如DeepSeek不可用时,自动切换到Claude);

- 增加成本统计(按团队/项目维度统计模型调用开销)。

对于需要统一管理多模型API的企业与开发者,MIXAPI无疑是当前最成熟、最可落地的解决方案之一。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)