【大模型】DeepSeek本地部署+集成IDEA编程

DeepSeek 作为国产开源大模型,各行业企业、单位都在逐步推进本地化部署工程。作为个人开发者,为了更好地开启大模型学习之旅,当然少不了本地部署的过程。下面跟着本篇教程将实现借助Ollama本地部署DeepSeek,并在IDEA编程工具中使用本地部署模型。

·

引言

DeepSeek 作为国产开源大模型,各行业企业、单位都在逐步推进本地化部署工程。作为个人开发者,为了更好地开启大模型学习之旅,当然少不了本地部署的过程。下面跟着本篇教程将实现借助Ollama本地部署DeepSeek,并在IDEA编程工具中使用本地部署模型。

为什么本地部署?

- 隐私性高:数据都在本地运行,无需上传到云端,避免数据泄露风险。

- 稳定性强:不受网络波动影响,模型运行更加稳定。

- 可定制性强:可以根据需求调整模型参数,满足个性化需求。

硬件要求

| 硬件类型 | 最低配置 | 推荐配置 |

|---|---|---|

| 显卡 | NVIDIA GTX 1060 (6GB显存) | RTX 4080 (16GB显存) |

| 内存 | 16GB | 32 GB |

部署流程

安装Ollama

下载安装

官网下载地址,选择对应系统版本下载,下载后本地安装。

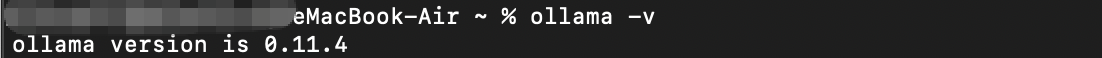

安装验证

通过命令ollama -v查看安装版本号,显示对应版本则表示安装成功。

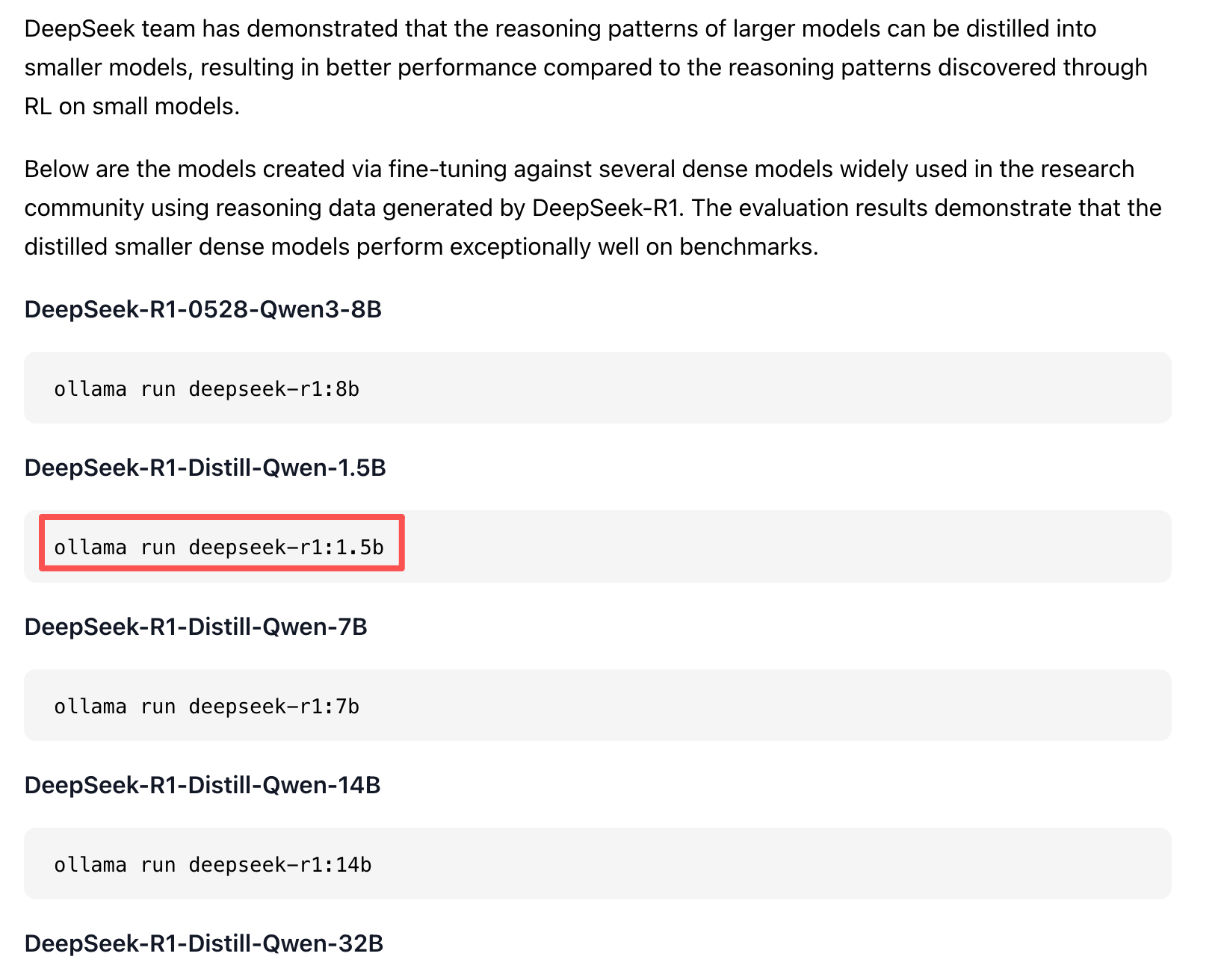

选择DeepSeek大模型

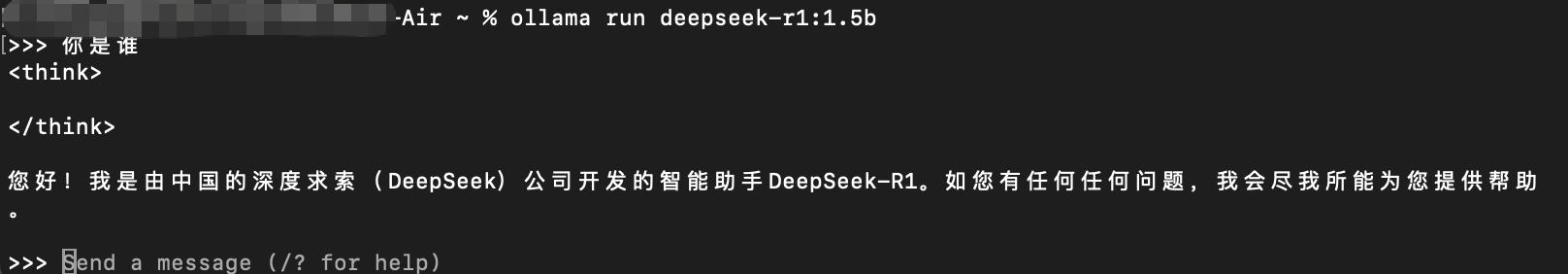

我这里选择使用的r1-1.5b规模

执行ollama run deepseek-r1:1.5b命令,等待下载完后就可以在本地使用大模型了。

集成IDEA

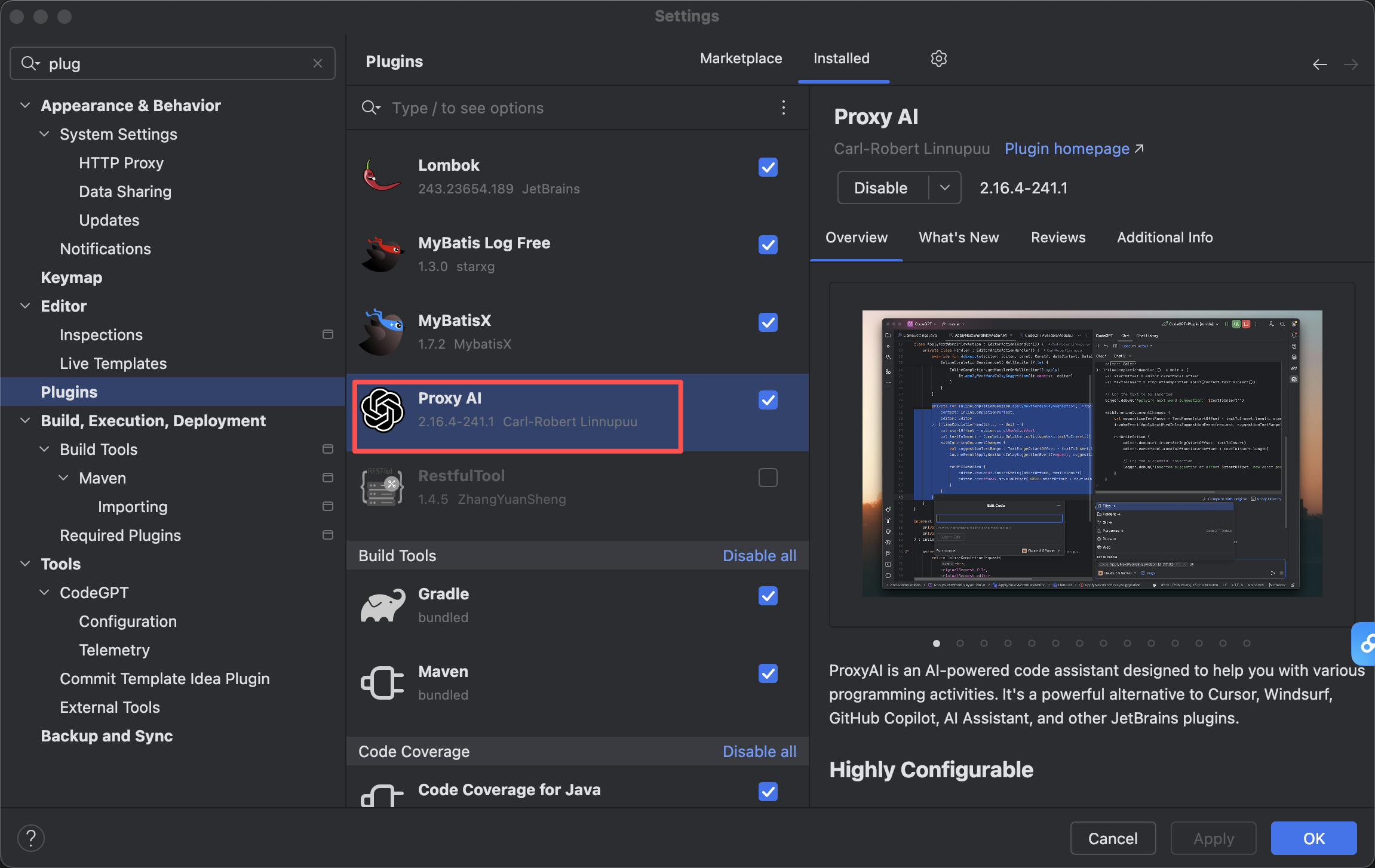

安装Proxy AI插件

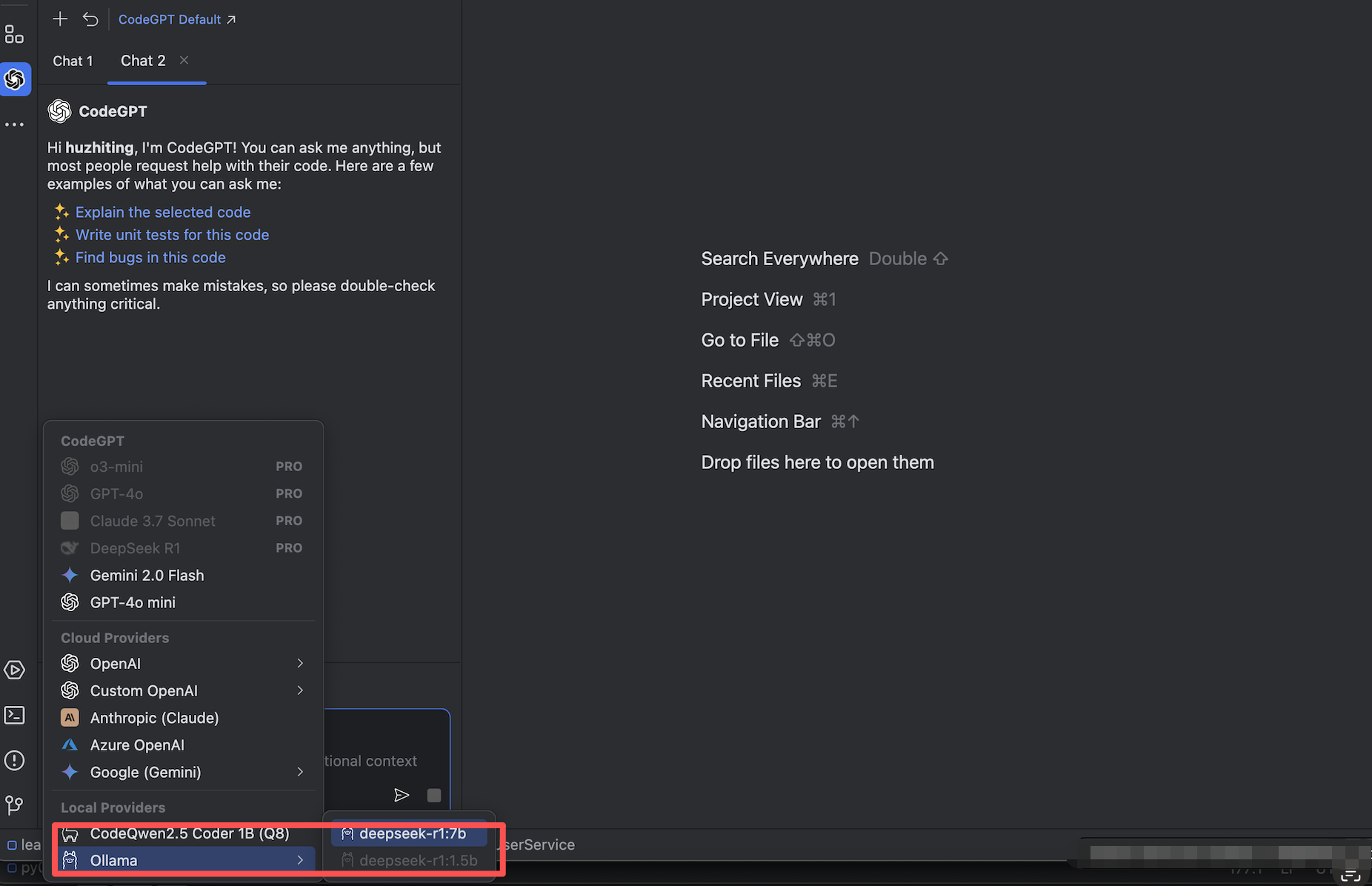

选择deepseek模型

使用示例

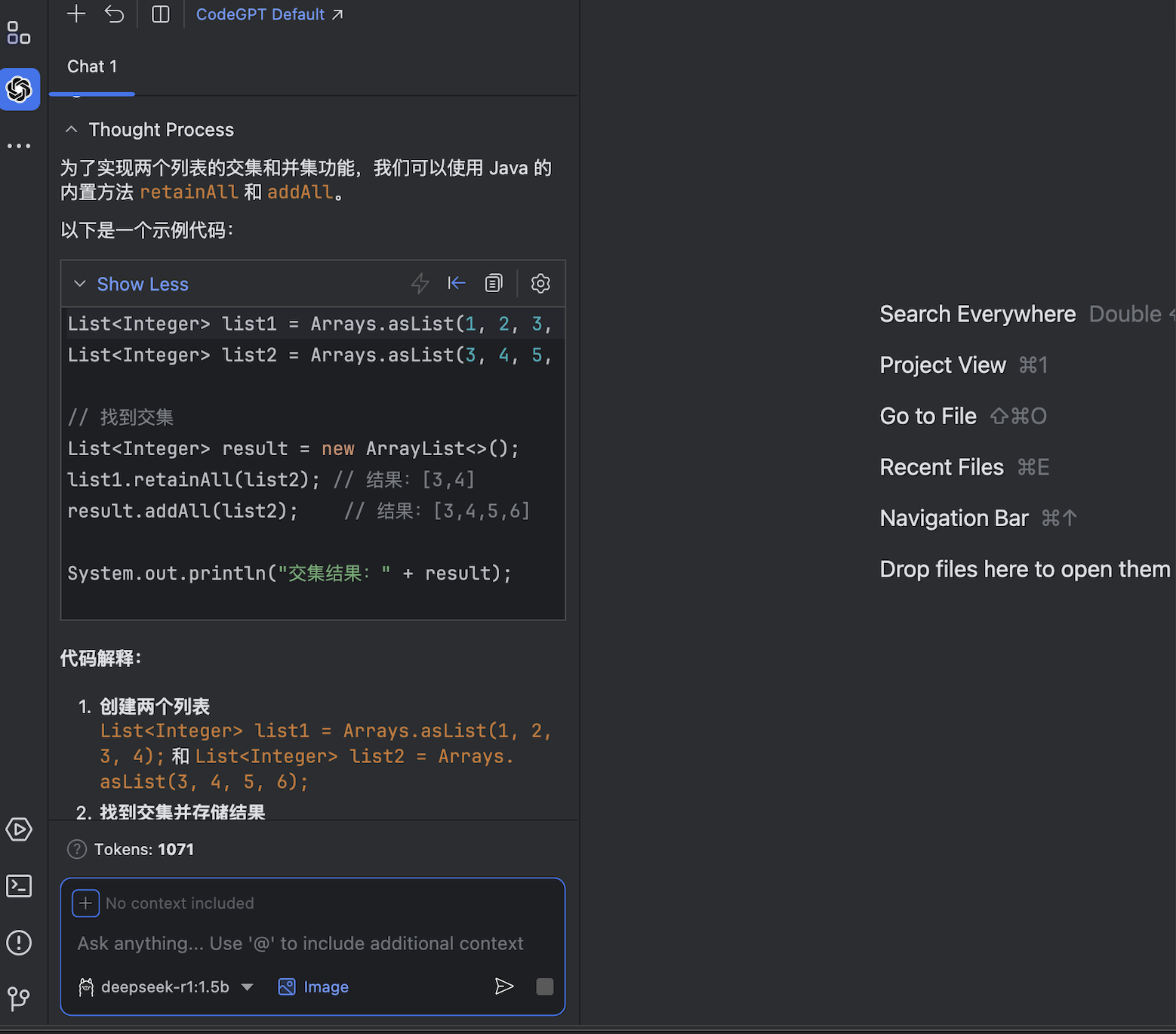

下面我输入的是让它帮我“用java实现取两个list的交集与并集”,以后开发更加高效了。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)