本地部署Ollama + DeepSeek 671b超大模型的安装与配置(一次失败的经历)

如何在一台配置较高的电脑上安装和配置大模型(671b),包括准备存储空间、选择合适的操作系统(AlmaLinux)、安装Docker及Docker Compose,并通过docker-compose文件配置相关服务(如Ollama、Redis、PGVector等)。

📕我是廖志伟,一名Java开发工程师、《Java项目实战——深入理解大型互联网企业通用技术》(基础篇)、(进阶篇)、(架构篇)清华大学出版社签约作家、Java领域优质创作者、CSDN博客专家、阿里云专家博主、51CTO专家博主、产品软文专业写手、技术文章评审老师、技术类问卷调查设计师、幕后大佬社区创始人、开源项目贡献者。

📘拥有多年一线研发和团队管理经验,研究过主流框架的底层源码(Spring、SpringBoot、SpringMVC、SpringCloud、Mybatis、Dubbo、Zookeeper),消息中间件底层架构原理(RabbitMQ、RocketMQ、Kafka)、Redis缓存、MySQL关系型数据库、 ElasticSearch全文搜索、MongoDB非关系型数据库、Apache ShardingSphere分库分表读写分离、设计模式、领域驱动DDD、Kubernetes容器编排等。不定期分享高并发、高可用、高性能、微服务、分布式、海量数据、性能调优、云原生、项目管理、产品思维、技术选型、架构设计、求职面试、副业思维、个人成长等内容。

🌾阅读前,快速浏览目录和章节概览可帮助了解文章结构、内容和作者的重点。了解自己希望从中获得什么样的知识或经验是非常重要的。建议在阅读时做笔记、思考问题、自我提问,以加深理解和吸收知识。阅读结束后,反思和总结所学内容,并尝试应用到现实中,有助于深化理解和应用知识。与朋友或同事分享所读内容,讨论细节并获得反馈,也有助于加深对知识的理解和吸收。💡在这个美好的时刻,笔者不再啰嗦废话,现在毫不拖延地进入文章所要讨论的主题。接下来,我将为大家呈现正文内容。

准备工作

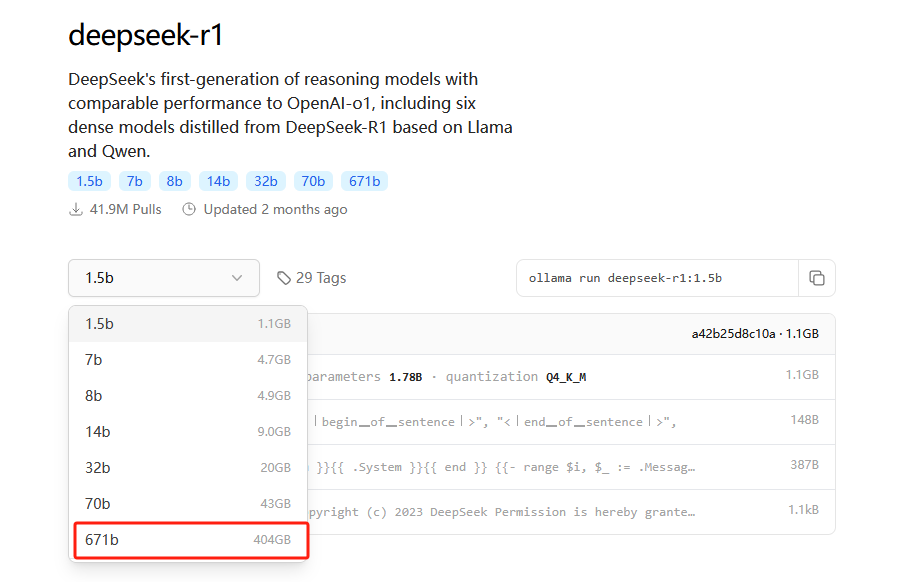

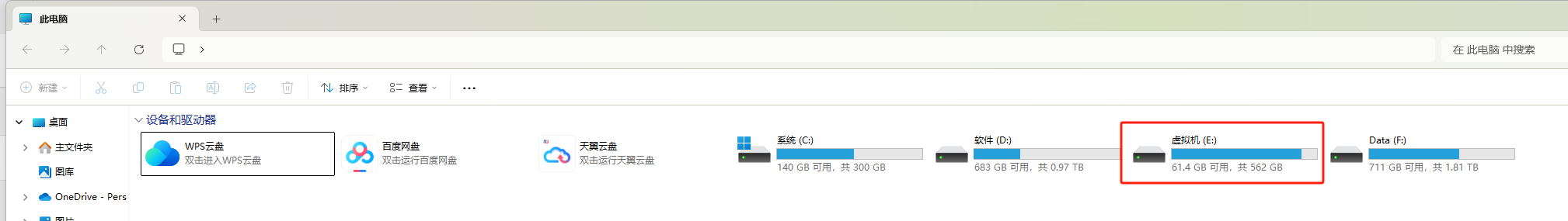

671b的大模型需要404GB的储存空间,如下图所示:

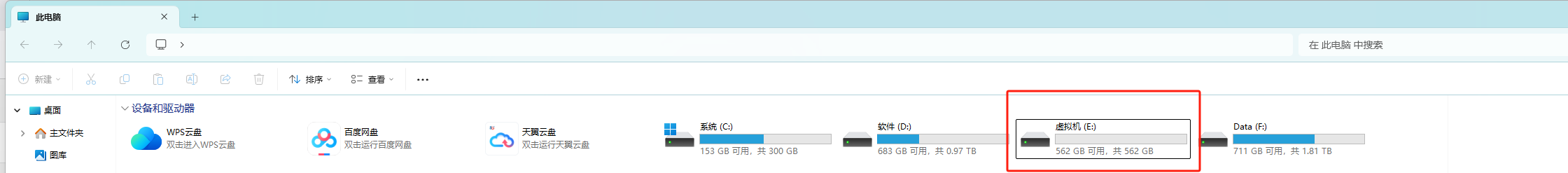

电脑上腾出一块空间500GB以上,用于储存671b的大模型

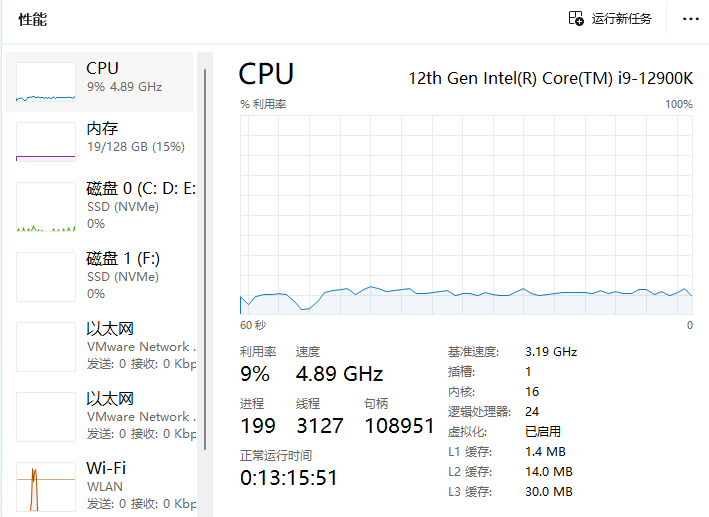

同时你本地的电脑配置不能太低,否则跑不起来这么大的模型。我电脑配置如下:

我主机电脑配置:内存128GB,cpu核心线程数16核24线程。

给虚拟机分配的不能超过本地电脑的配置,分配后不会立马使用到这么多的计算机资源,而是虚拟机里面跑的程序消耗的资源逐步增加才会占用你本地主机的资源。另外由于centos7和8已经不维护了,这里我使用AlmaLinux替代。

官网地址:https://almalinux.org/get-almalinux/,选择AlmaLinux OS 9.5 DVD ISO即可,这里我选择的是AlmaLinux_OS_9.4_DVD_ISO,我怕最新版本会不稳定,所以用后面一个版本靠谱点。这个文件比较大,有10G,如果从官网下载特别慢,这里我也提供百度网盘下载地址:https://pan.baidu.com/s/1VNhBShogWBPbIGw5F00KPg,提取码: 1234

另外百度网盘限速下载页很慢,如果平时不用的话,开个vip有点不划算,可以花9.9开通一个24小时的极速下载,网络稍微慢点的也就个把钟能下载下来。

安装配置教程我找了个博主的,按照他的步骤一步一步来就可以了,附上链接:https://blog.csdn.net/qq_37908302/article/details/142256034,由于是别人的博客链接,存在删除文章的风险,这里我弄了份本地文档,确保读者可以正常阅读。附上地址:https://download.csdn.net/download/java_wxid/90760028

VMware这里我分配了64GB内存,8核16线程(再调大一点就会有提示影响性能)。

安装docker

删除所有错误仓库配置

sudo rm -f /etc/yum.repos.d/docker*.repo

安装必要工具(纯净命令)

sudo dnf install -y dnf-plugins-core

配置清华大学镜像源,添加官方仓库后修改源地址

sudo dnf config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo

sudo sed -i 's#download.docker.com#mirrors.tuna.tsinghua.edu.cn/docker-ce#' /etc/yum.repos.d/docker-ce.repo

强制重建仓库缓存

sudo dnf clean all

sudo rm -rf /var/cache/dnf

sudo dnf makecache

安装兼容版本(AlmaLinux 9专用)

sudo dnf install -y docker-ce-24.0.7 docker-ce-cli-24.0.7 containerd.io

启动服务并验证

sudo systemctl start docker

systemctl restart docker

安装docker-compose

sudo curl -L "https://github.com/docker/compose/releases/download/v2.17.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

sudo chmod +x /usr/local/bin/docker-compose

创建docker-compose-environment.yml文件

vi docker-compose-environment.yml

version: '3'

services:

ollama:

image: registry.cn-shanghai.aliyuncs.com/ai-context-knowledge/ollama:v1.0

container_name: ollama

restart: unless-stopped

ports:

- "11434:11434"

redis:

image: registry.cn-shanghai.aliyuncs.com/ai-context-knowledge/redis:v1.0

container_name: redis

restart: always

hostname: redis

privileged: true

ports:

- 16379:6379

volumes:

- ./redis/redis.conf:/usr/local/etc/redis/redis.conf

command: redis-server /usr/local/etc/redis/redis.conf

networks:

- my-network

healthcheck:

test: [ "CMD", "redis-cli", "ping" ]

interval: 10s

timeout: 5s

retries: 3

# 账密 admin/admin

redis-admin:

image: registry.cn-shanghai.aliyuncs.com/ai-context-knowledge/redis-commander:v1.0

container_name: redis-admin

hostname: redis-commander

restart: always

ports:

- 8081:8081

environment:

- REDIS_HOSTS=local:redis:6379

- HTTP_USER=admin

- HTTP_PASSWORD=admin

- LANG=C.UTF-8

- LANGUAGE=C.UTF-8

- LC_ALL=C.UTF-8

networks:

- my-network

depends_on:

redis:

condition: service_healthy

vector_db:

image: registry.cn-shanghai.aliyuncs.com/ai-context-knowledge/pgvector:v1.0

container_name: vector_db

restart: always

environment:

- POSTGRES_USER=postgres

- POSTGRES_PASSWORD=postgres

- POSTGRES_DB=springai

- PGPASSWORD=postgres

volumes:

- ./pgvector/sql/init.sql:/docker-entrypoint-initdb.d/init.sql

logging:

options:

max-size: 10m

max-file: "3"

ports:

- '5432:5432'

healthcheck:

test: "pg_isready -U postgres -d vector_store"

interval: 2s

timeout: 20s

retries: 10

networks:

- my-network

networks:

my-network:

driver: bridge

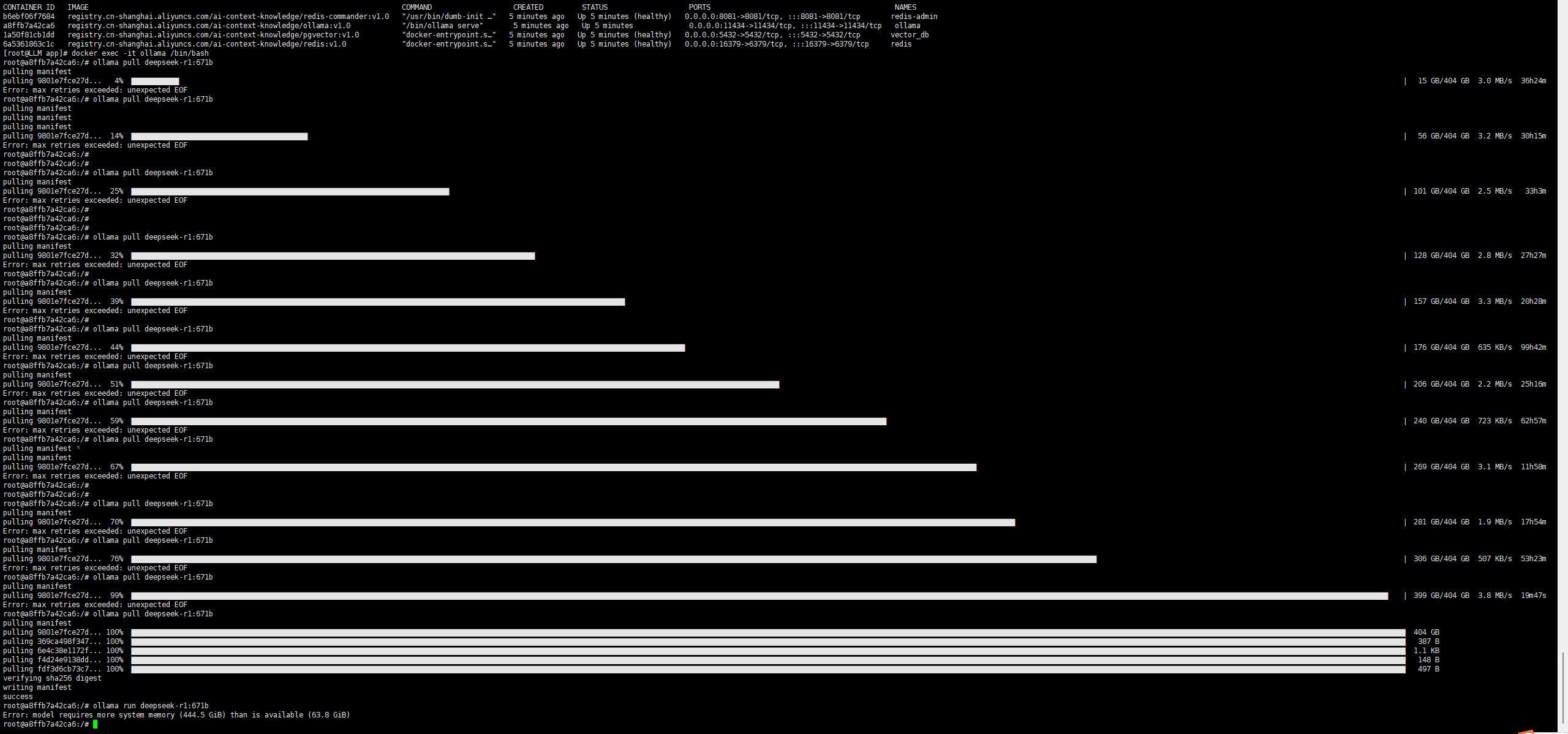

进入容器内部

docker exec -it ollama /bin/bash

执行 Ollama 安装

ollama pull deepseek-r1:671b

ollama run deepseek-r1:671b

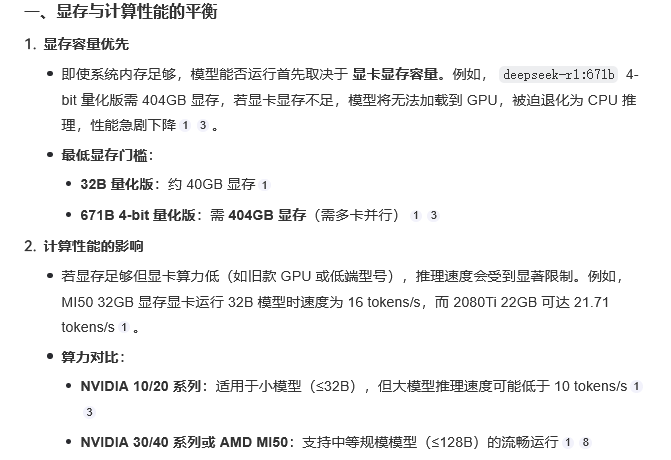

根据错误提示,系统内存不足(需 444.5 GiB,可用仅 63.8 GiB),我看了一下,分配的储存空间居然还跑不动,离了个大谱

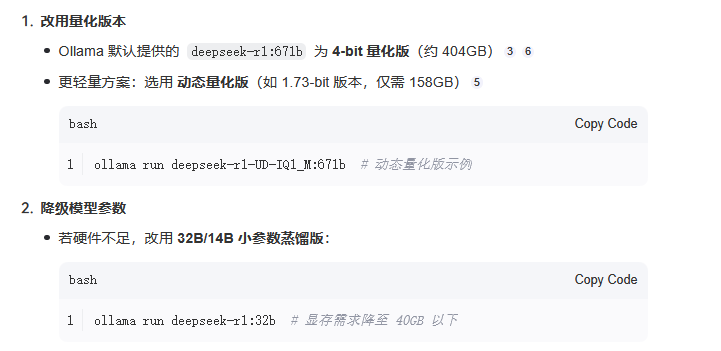

如何我又当心会有其他配置问题,问了一下大模型:

它给我的建议是

果然一下不能搞太高,容易扯到蛋,之前没细看这块,果然还是太天真了。先写到这,后面慢慢补充

ollama pull nomic-embed-text

📥博主的人生感悟和目标

希望各位读者大大多多支持用心写文章的博主,现在时代变了,信息爆炸,酒香也怕巷子深,博主真的需要大家的帮助才能在这片海洋中继续发光发热,所以,赶紧动动你的小手,点波关注❤️,点波赞👍,点波收藏⭐,甚至点波评论✍️,都是对博主最好的支持和鼓励!

- 💂 博客主页: Java程序员廖志伟

- 👉 开源项目:Java程序员廖志伟

- 🌥 哔哩哔哩:Java程序员廖志伟

- 🎏 个人社区:Java程序员廖志伟

- 🔖 个人微信号:

SeniorRD

📙经过多年在CSDN创作上千篇文章的经验积累,我已经拥有了不错的写作技巧。同时,我还与清华大学出版社签下了四本书籍的合约,并将陆续出版。这些书籍包括了基础篇、进阶篇、架构篇的📌《Java项目实战—深入理解大型互联网企业通用技术》📌,以及📚《解密程序员的思维密码–沟通、演讲、思考的实践》📚。具体出版计划会根据实际情况进行调整,希望各位读者朋友能够多多支持!

🔔如果您需要转载或者搬运这篇文章的话,非常欢迎您私信我哦~

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)