论文理解 【LLM-RL】——【EndoRM】Generalist Reward Models: Found Inside Large Language Models

本文指出,任何通过标准 “next token prediction” 训练得到的 LLM 内部已经隐含了一个通用奖励模型,其本质上等价于离线逆强化学习所得的奖励函数

- 文章链接:Generalist Reward Models: Found Inside Large Language Models

- 发表:2025年6月(arXiv 预印本)

- 领域:LLM-RL

- 一句话总结:在 LLM 对齐过程中,当前主流范式 RLHF 依赖昂贵且难以扩展的人类偏好数据来训练奖励模型,基于 AI 反馈的替代方案虽然降低了成本,却缺乏严格的理论基础。本文指出,事实上任何通过标准 “next token prediction” 训练得到的 LLM 内部已经隐含了一个通用奖励模型,其本质上等价于离线逆强化学习所得的奖励函数。基于这一发现,作者提出语言模型的 logits 可以直接解释为软Q函数,无需额外训练即可从中恢复 “内生奖励函数”,并进一步证明用该奖励进行强化学习不仅能避免传统模仿学习中的误差累积,还能带来更优的理论性能保证。实验表明,该方法在多项基准上超越了现有的 “LLM-as-a-judge” 及显式训练的奖励模型,揭示了对齐范式可由 “外部奖励构造” 转向 “内在奖励挖掘” 的可能

- 摘要:大型语言模型(LLMs)的对齐严重依赖于在昂贵的人类偏好数据上训练的奖励模型。尽管最近的研究探索了通过人工智能反馈来绕过这一成本,但这些方法通常缺乏严格的理论基础。在本文中,我们发现,通过标准的下一个标记预测训练的任何大型语言模型中,已经隐含地存在一个强大的通用奖励模型。我们证明,这种内生奖励并非一种启发式方法,而是理论上等同于通过离线逆强化学习(IRL)学习到的奖励函数。这种联系使我们能够直接从基础(预训练或监督微调)模型中提取高质量的奖励信号,而无需进一步训练。至关重要的是,我们还证明,使用这种内生奖励进行后续强化学习,会导致一个具有可证明的更优误差界限的策略,与基础模型相比。据我们所知,这是第一个关于强化学习对大型语言模型有效的理论证明。我们的实验验证了这一理论,表明我们的方法不仅优于现有的基于 LLM 的评判方法,甚至可以超越明确训练的奖励模型。这些发现表明,奖励建模阶段可以被一种原则化的方法所取代,即从预训练中已经捕获的知识中提取知识,预示着一种更高效、更强大、更可扩展的大型语言模型对齐范式,以及多模态模型的对齐

文章目录

1. 背景

1.1 LLM 的 MDP 表述

- 从强化学习的角度分析,LLM 本身可以视作文本生成策略 π ( ⋅ ∣ s ) \pi(\cdot|s) π(⋅∣s),生成文本的过程可以被自然地建模为具有确定性环境转移的 MDP < S , V , r , P , ρ , H > <\mathcal{S,V},r,P,\rho,H> <S,V,r,P,ρ,H>,其中:

- 状态空间 S \mathcal{S} S:有限长度 token 序列的集合

- 动作空间 V \mathcal{V} V: 词表

- 初始状态分布 ρ \rho ρ:从中采样得到作为初始状态的提示词 s 1 = ( x 1 , x 2 , ⋯ , x m ) , ∀ x i ∈ V s_{1}=\left(x_{1}, x_{2}, \cdots, x_{m}\right), \forall x_i\in \mathcal{V} s1=(x1,x2,⋯,xm),∀xi∈V

- 生成序列长度 H H H:为分析清晰起见,作者假设模型响应长度均匀且恰好为 H H H(需要在 <EOS> token 后进行适当的 Padding)

- 奖励函数 r r r:每个 timestep h ∈ [ H ] h\in [H] h∈[H] 的即时奖励 r h ∈ [ 0 , 1 ] r_h\in [0,1] rh∈[0,1]

- 环境转移 P P P:每个 timestep h ∈ [ H ] h\in [H] h∈[H],LLM 策略生成动作 a h ∼ π ( ⋅ ∣ s h ) a_h\sim \pi(\cdot|s_h) ah∼π(⋅∣sh),并确定性地转移到 s h + 1 = s h ⊕ a h s_{h+1}=s_h \oplus a_h sh+1=sh⊕ah

- 基于以上 MDP 设计,LLM 生成的文本可以看作 rollout 轨迹 τ \tau τ,定义价值函数 V π V^\pi Vπ 作为策略 π \pi π 的质量度量 V π = E τ ∼ π [ ∑ h = 1 H r ( s h , a h ) ] (1) V^\pi = \mathbb{E}_{\tau\sim \pi}\left[\sum_{h=1}^H r(s_h, a_h)\right]\tag{1} Vπ=Eτ∼π[h=1∑Hr(sh,ah)](1)

1.2 Next Token Prediction

- 当前 LLM 遵循 Next Token Prediction 范式进行预训练,即最大化模型在前驱 token 序列的条件下预测下一个 token 的概率。形式化地讲,给定数据集 D = { ( s 1 i , a 1 : H i ) } i = 1 n \mathcal{D}=\left\{\left(s_{1}^{i}, a_{1:H}^{i}\right)\right\}_{i=1}^{n} D={(s1i,a1:Hi)}i=1n,Next Token Prediction 解决以下优化问题 max π ∑ i = 1 n ∑ h = 1 H log ( π ( a h i ∣ s h i ) ) (2) \max _{\pi} \sum_{i=1}^{n} \sum_{h=1}^{H} \log \left(\pi\left(a_{h}^{i} \mid s_{h}^{i}\right)\right)\tag{2} πmaxi=1∑nh=1∑Hlog(π(ahi∣shi))(2) 值得注意的是,这可以被看作是一种行为克隆方法(BC),属于模仿学习

1.3 基于人类反馈的强化学习(RLHF)

- Next Token Prediction 是有效的模仿学习方案,但使 LLM 的行为对齐人类价值观需要更直接的反馈形式。人类反馈强化学习(RLHF)是这个任务的标准范式,其可分为两个步骤

- 训练奖励模型 R ϕ R_\phi Rϕ:奖励模型 RM 的训练目标是给予人类偏好回答更高的标量分数。给定偏好数据集 D pref = { ( x , y w , y l ) i } \mathcal{D}_{\text{pref}}=\{(x, y_w, y_l)_i\} Dpref={(x,yw,yl)i},其中 x x x 表示给定的提示(问题), y w , y l y_w, y_l yw,yl 分别表示人类标记者偏好和不偏好的回答。遵循 Bradley-Terry 模型, y w y_w yw 比 y l y_l yl 更被偏好的概率被建模为

P ( y w ≻ y l ∣ x ) = σ ( R ϕ ( x , y w ) − R ϕ ( x , y l ) ) = exp R ϕ ( x , y w ) exp R ϕ ( x , y w ) + exp R ϕ ( x , y l ) (3) \begin{aligned} P\left(y_{w} \succ y_{l} \mid x\right) &=\sigma\left(R_{\phi}\left(x, y_{w}\right)-R_{\phi}\left(x, y_{l}\right)\right) \\ &=\frac{\exp R_{\phi}\left(x, y_{w}\right)}{\exp R_{\phi}\left(x, y_{w}\right)+\exp R_{\phi}\left(x, y_{l}\right)} \end{aligned} \tag{3} P(yw≻yl∣x)=σ(Rϕ(x,yw)−Rϕ(x,yl))=expRϕ(x,yw)+expRϕ(x,yl)expRϕ(x,yw)(3) 其中 σ \sigma σ 是 Sigmoid 函数。通过最小化偏好的负对数似然来训练 RM,即

L R M ( ϕ ) = − E ( x , y w , y l ) ∼ D pref [ log σ ( R ϕ ( x , y w ) − R ϕ ( x , y l ) ) ] (4) \mathcal{L}_{R M}(\phi)=-\mathbb{E}_{\left(x, y_{w}, y_{l}\right) \sim \mathcal{D}_{\text {pref }}}\left[\log \sigma\left(R_{\phi}\left(x, y_{w}\right)-R_{\phi}\left(x, y_{l}\right)\right)\right] \tag{4} LRM(ϕ)=−E(x,yw,yl)∼Dpref [logσ(Rϕ(x,yw)−Rϕ(x,yl))](4) - 强化学习微调:最大化 RM 反馈的同时约束策略偏移以避免 reward hacking,如下 max θ E x ∼ ρ , y ∼ π θ ( ⋅ ∣ x ) [ R ϕ ( x , y ) − β ⋅ D K L ( π θ ( ⋅ ∣ x ) ∥ π S F T ( ⋅ ∣ x ) ) ] (5) \max _{\theta} \mathbb{E}_{x \sim \mathcal{\rho}, y \sim \pi_{\theta}(\cdot \mid x)}\left[R_{\phi}(x, y)-\beta \cdot D_{\mathrm{KL}}\left(\pi_{\theta}(\cdot \mid x) \| \pi_{\mathrm{SFT}}(\cdot \mid x)\right)\right]\tag{5} θmaxEx∼ρ,y∼πθ(⋅∣x)[Rϕ(x,y)−β⋅DKL(πθ(⋅∣x)∥πSFT(⋅∣x))](5)

- 训练奖励模型 R ϕ R_\phi Rϕ:奖励模型 RM 的训练目标是给予人类偏好回答更高的标量分数。给定偏好数据集 D pref = { ( x , y w , y l ) i } \mathcal{D}_{\text{pref}}=\{(x, y_w, y_l)_i\} Dpref={(x,yw,yl)i},其中 x x x 表示给定的提示(问题), y w , y l y_w, y_l yw,yl 分别表示人类标记者偏好和不偏好的回答。遵循 Bradley-Terry 模型, y w y_w yw 比 y l y_l yl 更被偏好的概率被建模为

- RLHF 最早被用于解决 RL 领域常见的控制问题,见 论文理解【IL - IRL】 —— Deep Reinforcement Learning from Human Preferences

1.4 逆强化学习(IRL)

- IRL 是 BC 以外的另一类模仿学习方法,它的目标是从给定的专家演示数据集 D \mathcal{D} D 中恢复奖励模型

模仿学习假设专家策略是最优的,IRL 学到的奖励函数要让 D \mathcal{D} D 看起来是最优策略生成的

- 一种突出且有理论支撑的 IRL 方法是最大熵逆强化学习(MaxEnt),这种方法恢复的奖励可以在解释专家演示的同时对数据中发现的行为保持最大的不确定性,这一原则导致了一个极小极大优化问题

max r min π ( E τ ∼ π E [ ∑ h = 1 H r ( s h , a h ) ] − E τ ∼ π [ ∑ h = 1 H r ( s h , a h ) + α H ( π ( ⋅ ∣ s h ) ) ] ) (6) \max _{r} \min _{\pi}\left(\mathbb{E}_{\tau \sim \pi^E}\left[\sum_{h=1}^{H} r\left(s_{h}, a_{h}\right)\right]-\mathbb{E}_{\tau \sim \pi}\left[\sum_{h=1}^{H} r\left(s_{h}, a_{h}\right)+\alpha H\left(\pi\left(\cdot \mid s_{h}\right)\right)\right]\right) \tag{6} rmaxπmin(Eτ∼πE[h=1∑Hr(sh,ah)]−Eτ∼π[h=1∑Hr(sh,ah)+αH(π(⋅∣sh))])(6) 其中 E τ ∼ π E \mathbb{E}_{\tau \sim \pi^E} Eτ∼πE 是对专家策略 π E \pi^E πE 诱导的轨迹取期望(通过数据集 D \mathcal{D} D 近似), E τ ∼ π \mathbb{E}_{\tau \sim \pi} Eτ∼π 是对学到的策略 π \pi π 诱导的轨迹取期望,熵项 H ( π ( ⋅ ∣ s h ) ) = E a h ∼ π ( ⋅ ∣ s h ) [ − log π ( a h ∣ s h ) ] H\left(\pi\left(\cdot \mid s_{h}\right)\right)=\mathbb{E}_{a_{h} \sim \pi\left(\cdot \mid s_{h}\right)}\left[-\log \pi\left(a_{h} \mid s_{h}\right)\right] H(π(⋅∣sh))=Eah∼π(⋅∣sh)[−logπ(ah∣sh)]上式可以理解为:

- 外层 max r \max_r maxr 希望找到一个奖励函数 𝑟 𝑟 r,使得它能最大化专家策略 π E \pi^E πE 与当前学习策略 π \pi π 之间的差距,这个差距越大越能体现专家策略的优势,因此这是要找到一个解释专家行为的奖励模型

- 内层 min π \min_\pi minπ 只对第二项有作用,它表示对于给定的奖励函数 r r r,找到最大化累计奖励并保持高探索性的策略 π \pi π( r r r 下的最优最优策略)。这保证了外层学到奖励函数 r r r 的解释强度,即该解释下专家策略即使面对很好的策略仍具有优势

- 将 EaxEnt IRL 和 RLHF 对比分析,显然 RLHF 可以视作 IRL 范式的一个实例,它没有直接进行上式内层的 min π \min_\pi minπ 最优策略求解,而是直接最大化偏好数据集中“胜者”与“败者”之间的奖励差距

- RLHF 中的奖励模型是通过 “样本对” 级别的比较学到的

- EaxEnt IRL 中的奖励模型是通过 “样本分布” 级别的比较学到的

2. 本文方法

2.1 利用 IRL 恢复奖励函数

- 本文的核心思想是通过 IRL 框架直接恢复能解释专家数据集 D \mathcal{D} D 的最优奖励函数。但直接应用公式 (6) 是困难的,因为通常需要高成本的 online rollout 来计算 E τ ∼ π \mathbb{E}_{\tau \sim \pi} Eτ∼π。为避免交互成本,作者使用了 offline IRL 方法 Inverse Soft Q-learning

- Inverse Soft Q-learning 和 Soft Q-Learning 是一对互为逆问题的方法,二者都基于最大熵思想,后者是经典 model-free RL 算法 SAC 的前身,详见 论文理解【RL经典】—— 【SQL】Reinforcement Learning with Deep Energy-Based Policies

- 最大熵 RL 里,对于任意策略 π \pi π 定义 Soft Bellman operator

Q π ( s , a ) = r ( s , a ) + γ E s ′ ∼ P ( ⋅ ∣ s , a ) [ V π ( s ′ ) ] V π ( s ) = E a ∼ π Q π ( s , a ) + α H ( π ( ⋅ ∣ s ) ) = E a ∼ π [ Q π ( s , a ) − α log π ( a ∣ s ) ] . \begin{aligned} Q^{\pi}(s, a)&=r(s, a)+\gamma \mathbb{E}_{s^{\prime} \sim P(\cdot \mid s, a)}\left[V^{\pi}\left(s^{\prime}\right)\right]\\ V^{\pi}(s)&=\mathbb{E}_{a \sim \pi}Q^{\pi}(s, a)+\alpha H(\pi(\cdot \mid s)) \\ &=\mathbb{E}_{a \sim \pi}\left[Q^{\pi}(s, a)-\alpha \log \pi(a \mid s)\right] . \end{aligned} Qπ(s,a)Vπ(s)=r(s,a)+γEs′∼P(⋅∣s,a)[Vπ(s′)]=Ea∼πQπ(s,a)+αH(π(⋅∣s))=Ea∼π[Qπ(s,a)−αlogπ(a∣s)]. 基于能量模型定义最优策略如下 π ⋆ ( a ∣ s ) = exp ( Q ∗ ( s , a ) / α ) ∑ a ′ exp ( Q ∗ ( s , a ′ ) / α ) \pi^{\star}(a \mid s)=\frac{\exp (Q^*(s, a) / \alpha)}{\sum_{a^{\prime}} \exp \left(Q^*\left(s, a^{\prime}\right) / \alpha\right)} π⋆(a∣s)=∑a′exp(Q∗(s,a′)/α)exp(Q∗(s,a)/α) 回代得到最优 Soft Q-value 和最优 Soft V-value 的闭式解:

Q ∗ ( s , a ) = r ( s , a ) + γ E s ′ ∼ P ( ⋅ ∣ s , a ) [ V ∗ ( s ′ ) ] V ∗ ( s ) = α log ∑ a ′ exp ( Q ∗ ( s , a ′ ) / α ) \begin{aligned} Q^*(s, a)&=r(s, a)+\gamma \mathbb{E}_{s^{\prime} \sim P(\cdot \mid s, a)}\left[V^*\left(s^{\prime}\right)\right]\\ V^*(s)&=\alpha \log \sum_{a^{\prime}} \exp \left(Q^*\left(s, a^{\prime}\right) / \alpha\right) \end{aligned} Q∗(s,a)V∗(s)=r(s,a)+γEs′∼P(⋅∣s,a)[V∗(s′)]=αloga′∑exp(Q∗(s,a′)/α)

- Inverse Soft Q-learning 旨在找到能解释 D = { ( s 1 i , a 1 : H i ) } i = 1 n \mathcal{D}=\left\{\left(s_{1}^{i}, a_{1:H}^{i}\right)\right\}_{i=1}^{n} D={(s1i,a1:Hi)}i=1n 的 Q ∗ Q^* Q∗ 函数,这需要求解

max Q ∗ 1 n ∑ i = 1 n ∑ h = 1 H [ Q ∗ ( s h i , a h i ) − α log ( ∑ a h ∈ V exp ( Q ∗ ( s h i , a h ) ) / α ) ] (7) \max_{Q^*} \frac{1}{n} \sum_{i=1}^{n} \sum_{h=1}^{H}\left[Q^*\left(s_{h}^{i}, a_{h}^{i}\right)-\alpha \log \left(\sum_{a_{h} \in \mathcal{V}} \exp \left(Q^*\left(s_{h}^{i}, a_{h}\right)\right) / \alpha\right)\right] \tag{7} Q∗maxn1i=1∑nh=1∑H[Q∗(shi,ahi)−αlog(ah∈V∑exp(Q∗(shi,ah))/α)](7) 这是把公式 (6) 和最大策略熵思想结合得到的具体地,把专家数据 D \mathcal{D} D 看作由最优策略 π ∗ \pi^* π∗ 生成,最大化其对数似然

max Q ∗ ∑ i = 1 n ∑ h = 1 H log π ∗ ( a h i ∣ s h i ) \max _{Q^{*}} \sum_{i=1}^{n} \sum_{h=1}^{H} \log \pi^{*}\left(a_{h}^{i} \mid s_{h}^{i}\right) Q∗maxi=1∑nh=1∑Hlogπ∗(ahi∣shi) 带入 π ⋆ ( a ∣ s ) = exp ( Q ∗ ( s , a ) / α ) ∑ a ′ exp ( Q ∗ ( s , a ′ ) / α ) \pi^{\star}(a \mid s)=\frac{\exp (Q^*(s, a) / \alpha)}{\sum_{a^{\prime}} \exp \left(Q^*\left(s, a^{\prime}\right) / \alpha\right)} π⋆(a∣s)=∑a′exp(Q∗(s,a′)/α)exp(Q∗(s,a)/α),得到

max Q ∗ ∑ i , h [ 1 α Q ∗ ( s h i , a h i ) − log ∑ a ′ exp ( Q ∗ ( s h i , a ′ ) / α ) ] \max _{Q^{*}} \sum_{i,h} \left[\frac{1}{\alpha}Q^*(s_h^i, a_h^i) -\log \sum_{a^{\prime}} \exp \left(Q^*\left(s_h^i, a^{\prime}\right) / \alpha\right) \right] Q∗maxi,h∑[α1Q∗(shi,ahi)−loga′∑exp(Q∗(shi,a′)/α)] 改成经验平均就得到式(7)了 - 一旦解得 Q ∗ Q^* Q∗,可以如下恢复奖励函数(令 γ = 1 \gamma=1 γ=1)

r ⋆ ( s h , a h ) = Q ⋆ ( s h , a h ) − γ E s h + 1 [ V ∗ ( s h + 1 ) ] = Q ⋆ ( s h , a h ) − α log ( ∑ a h + 1 ∈ V exp ( Q ⋆ ( s h + 1 , a h + 1 ) ) / α ) (8) \begin{aligned} r^{\star}\left(s_{h}, a_{h}\right) &=Q^{\star}\left(s_{h}, a_{h}\right)-\gamma \mathbb{E}_{s_{h+1}}\left[V^*\left(s_{h+1}\right)\right]\\ &=Q^{\star}\left(s_{h}, a_{h}\right)-\alpha \log \left(\sum_{a_{h+1} \in \mathcal{V}} \exp \left(Q^{\star}\left(s_{h+1}, a_{h+1}\right)\right) / \alpha\right) \end{aligned} \tag{8} r⋆(sh,ah)=Q⋆(sh,ah)−γEsh+1[V∗(sh+1)]=Q⋆(sh,ah)−αlog ah+1∈V∑exp(Q⋆(sh+1,ah+1))/α (8)

2.2 内生奖励

- 作者注意到,优化公式 (7) 得到的 Q ∗ Q^* Q∗ 实际无需重新训练,它已经蕴含在 Next-Token Prediction 训练的结果中。在 2.1 节的推理过程中,我们是从对 D \mathcal{D} D 做最大似然估计找到 π ∗ \pi^* π∗ 进而推出 Q ∗ Q^* Q∗ 的,其中 π ∗ \pi^* π∗ 又是一种源自能量模型的 softmax 策略 π ∗ ( ⋅ ∣ s h ) = softmax ( Q ∗ ( s h , ⋅ ) ; α ) (9) \pi^*(\cdot \mid s_{h})=\operatorname{softmax}\left(Q^*\left(s_{h}, \cdot\right) ; \alpha\right)\tag{9} π∗(⋅∣sh)=softmax(Q∗(sh,⋅);α)(9)

- 这恰好是 Next-Token Prediction 的训练目标,如式(2)所示,LLM 对训练语料做最大似然估计,得到的生成策略是在 logits 上做 softmax,设状态 s h s_h sh 的 logits 由 f ^ \hat{f} f^ 得到,LLM 可以表示为 π ^ ( ⋅ ∣ s h ) = softmax ( f ^ ( s h , ⋅ ) ; α ) (10) \widehat{\pi}\left(\cdot \mid s_{h}\right)=\operatorname{softmax}\left(\widehat{f}\left(s_{h}, \cdot\right) ; \alpha\right)\tag{10} π (⋅∣sh)=softmax(f (sh,⋅);α)(10) 这说明 LLM 的 logits 不仅仅是任意的分数,而是一种原则性的 Q Q Q 函数,隐含地代表了模型训练数据 D \mathcal{D} D 的最优奖励函数

- 基于以上观察,给定任何通过 Next-Token Prediction 训练的语言模型,无论在预训练还是微调阶段,都可以提取模型输出的 logits 作为 Soft Q 函数 Q ^ = f ^ \hat{Q}=\hat{f} Q^=f^,并从中恢复奖励值

r ^ ( s h , a h ) : = Q ^ ( s h , a h ) − α log ( ∑ a h + 1 ∈ V exp ( Q ^ ( s h + 1 , a h + 1 ) ) / α ) (11) \widehat{r}\left(s_{h}, a_{h}\right):=\widehat{Q}\left(s_{h}, a_{h}\right)-\alpha \log \left(\sum_{a_{h+1} \in \mathcal{V}} \exp \left(\widehat{Q}\left(s_{h+1}, a_{h+1}\right)\right) / \alpha\right) \tag{11} r (sh,ah):=Q (sh,ah)−αlog ah+1∈V∑exp(Q (sh+1,ah+1))/α (11) 进一步定义 Soft V 函数 V Q ^ ( s h ) : = α log ( ∑ a h ∈ V exp ( Q ^ ( s h , a h ) / α ) ) V_{\widehat{Q}}\left(s_{h}\right):=\alpha \log \left(\sum_{a_{h} \in \mathcal{V}} \exp \left(\widehat{Q}\left(s_{h}, a_{h}\right) / \alpha\right)\right) VQ (sh):=αlog(∑ah∈Vexp(Q (sh,ah)/α)),得到 LLM 的内生奖励为

r ^ ( s h , a h ) = α log ( π ^ ( a h ∣ s h ) ) + V Q ^ ( s h ) − V Q ^ ( s h + 1 ) (12) \widehat{r}\left(s_{h}, a_{h}\right)=\alpha \log \left(\widehat{\pi}\left(a_{h} \mid s_{h}\right)\right)+V_{\hat{Q}}\left(s_{h}\right)-V_{\hat{Q}}\left(s_{h+1}\right) \tag{12} r (sh,ah)=αlog(π (ah∣sh))+VQ^(sh)−VQ^(sh+1)(12) 内生奖励(Endogenous Reward)可以从三个方面理解- 内生奖励 r ^ \hat{r} r^ 可以和 log ( π ^ ( a h ∣ s h ) ) \log(\hat{\pi}(a_h|s_h)) log(π^(ah∣sh)) 在收敛位置上等价。根据奖励塑形理论, r ~ ( s h , a h ) \tilde{r}(s_h,a_h) r~(sh,ah) 可以被看作 log ( π ^ ( a h ∣ s h ) ) \log(\hat{\pi}(a_h|s_h)) log(π^(ah∣sh)) 基础上的塑形奖励,引入的 V V V 只是让学习更稳定,不影响收敛位置

- 内生奖励是 “统计驱动” 的,常见合理的序列 π ^ ( τ ∣ s 1 ) \hat{\pi}(\tau|s_1) π^(τ∣s1) 更大,会被赋予更高的奖励。对整个轨迹的内生奖励求和可见

r ^ ( τ ) = ∑ h = 1 H r ^ ( s h , a h ) = α ∑ h = 1 H log ( π ^ ( a h ∣ s h ) ) + V Q ^ ( s 1 ) = α log ( π ^ ( τ ∣ s 1 ) ) + V Q ^ ( s 1 ) \begin{aligned} \hat{r}(\tau) &= \sum_{h=1}^H \hat{r}(s_h, a_h) = \alpha \sum_{h=1}^H \log(\hat{\pi}(a_h|s_h)) + V_{\hat{Q}}(s_1)\\ &= \alpha \log(\hat{\pi}(\tau|s_1)) + V_{\hat{Q}}(s_1) \end{aligned} r^(τ)=h=1∑Hr^(sh,ah)=αh=1∑Hlog(π^(ah∣sh))+VQ^(s1)=αlog(π^(τ∣s1))+VQ^(s1) - 现有的生成式奖励模型(GenRM)是内生奖励的一种特例。以往的生成式奖励模型其实都是在用 LLM 内部的概率分布构造奖励,只是场景受限,内生奖励是一种更一般的形式

问答场景中,某些奖励模型用 LLM 去回答一个 “Verifier Prompt”(如:“Is the answer correct?”),然后取“是”的概率 π ( Yes ∣ x , y , P ) \pi(\text{Yes}|x, y, P) π(Yes∣x,y,P) 作为奖励,如果把初始状态设为 s 1 = ( x , y , P ) s_1=(x, y, P) s1=(x,y,P),动作为 a 1 = Yes a_1=\text{Yes} a1=Yes,那么奖励 r ^ ( τ ) = α log π ^ ( Yes ∣ x , y , P ) \hat{r}(\tau) = \alpha \log \hat{\pi}(\text{Yes}|x,y,P) r^(τ)=αlogπ^(Yes∣x,y,P) 和内生奖励定义完全相同

3. 内生奖励的理论论证

3.1 内生奖励的误差分析

- 现在考虑对内生奖励 r ^ \hat{r} r^ 的准确性进行分析,设 π E \pi^E πE 是关于未知真实奖励 r ∗ r^* r∗ 的熵正则化最优策略,即满足

r ∗ ( s h , a h ) = α log ( π E ( a h ∣ s h ) ) + V Q r ∗ ∗ ( s h ) − V Q r ∗ ∗ ( s h + 1 ) r^*\left(s_{h}, a_{h}\right)=\alpha \log \left(\pi_{E}\left(a_{h} \mid s_{h}\right)\right)+V_{Q^*_{r^*}}\left(s_{h}\right)-V_{Q^*_{r^*}}\left(s_{h+1}\right) r∗(sh,ah)=αlog(πE(ah∣sh))+VQr∗∗(sh)−VQr∗∗(sh+1) 其中 Q r ∗ ∗ Q^*_{r^*} Qr∗∗ 是基于 r ∗ r^* r∗ 的熵正则化最优动作状态价值函数。 - 由于奖励存在不唯一性(即不同的奖励函数可能导出相同的专家策略),我们无法对 ∣ r ^ ( s h , a h ) − r ∗ ( s h , a h ) ∣ |\hat{r}(s_h, a_h) − r^*(s_h, a_h)| ∣r^(sh,ah)−r∗(sh,ah)∣ 进行任何评估。然而,建立奖励模型的主要目标之一是执行成对比较,因此作者转而分析利用奖励模型比较两个响应时的表现。形式化地说,利用奖励模型评估一对响应 ( τ , τ ′ ) (\tau, \tau') (τ,τ′) 的偏好,其中 τ = ( s 1 , a 1 : H ) , τ ′ = ( s 1 , a 1 : H ′ ) \tau = (s_1, a_{1:H}),\tau' = (s_1, a'_{1:H}) τ=(s1,a1:H),τ′=(s1,a1:H′),根据 1.3 节的 Bradley-Terry 模型,奖励 r r r 诱导的偏好分布可以写为

P r ( τ ≻ τ ′ ∣ τ , τ ′ ) = σ ( r ( τ ) − r ( τ ′ ) ) (13) \mathbb{P}_{r}\left(\tau \succ \tau^{\prime} \mid \tau, \tau^{\prime}\right)=\sigma\left(r(\tau)-r\left(\tau^{\prime}\right)\right) \tag{13} Pr(τ≻τ′∣τ,τ′)=σ(r(τ)−r(τ′))(13) 其中 σ \sigma σ 是 sigmoid 函数。误差分析的目标是分析真实偏好分布 P r ∗ ( τ ≻ τ ′ ∣ τ , τ ′ ) \mathbb{P}_{r^*}\left(\tau \succ \tau^{\prime} \mid \tau, \tau^{\prime}\right) Pr∗(τ≻τ′∣τ,τ′) 与推断分布 P r ^ ( τ ≻ τ ′ ∣ τ , τ ′ ) \mathbb{P}_{\hat{r}}\left(\tau \succ \tau^{\prime} \mid \tau, \tau^{\prime}\right) Pr^(τ≻τ′∣τ,τ′) 之间的差异 - 作者通过定理1证明:如果用于提取奖励的 LLM π ^ \hat{\pi} π^ 在响应上的对数概率接近于潜在专家 π E \pi^E πE,那么 r ^ \hat{r} r^ 诱导的偏好分布也会接近于 r ∗ r^* r∗ 诱导的分布。这说明从 LLM 中提取的内生奖励可以在理论上继承其表现

定理1:在 token MDP 中,设未知真实奖励为 r ⋆ r^⋆ r⋆, π E π^E πE 是熵正则化的最优策略。考虑 π ^ \hat{\pi} π^是通过 next token prediction 训练得到的策略, r ^ \hat{r} r^ 是在式(12) 中定义的内生奖励,对于任意相应二元组 ( τ , τ ′ ) (\tau, \tau') (τ,τ′),有

D T V ( P r ⋆ ( ⋅ ∣ τ , τ ′ ) , P r ^ ( ⋅ ∣ τ , τ ′ ) ) ≤ α H 2 ε π D_{\mathrm{TV}}\left(\mathbb{P}_{r^{\star}}\left(\cdot \mid \tau, \tau^{\prime}\right), \mathbb{P}_{\widehat{r}}\left(\cdot \mid \tau, \tau^{\prime}\right)\right) \leq \frac{\alpha H}{2} \varepsilon_{\pi} DTV(Pr⋆(⋅∣τ,τ′),Pr (⋅∣τ,τ′))≤2αHεπ 其中 D T V ( p , q ) = ( 1 / 2 ) ∑ x ∈ X ∣ p ( x ) − q ( x ) ∣ D_{\mathrm{TV}}(p, q)=(1 / 2) \sum_{x \in \mathcal{X}}|p(x)-q(x)| DTV(p,q)=(1/2)∑x∈X∣p(x)−q(x)∣ 是分布 p , q ∈ △ ( X ) p,q\in \triangle(\mathcal{X}) p,q∈△(X) 之间的全变差距离,偏差值 ε π : = max h ∈ [ H ] max ( s h , a h ) ∣ log ( π E ( a h ∣ s h ) ) − log ( π ^ ( a h ∣ s h ) ) ∣ \varepsilon_{\pi}:=\max _{h \in[H]} \max _{\left(s_{h}, a_{h}\right)}\left|\log \left(\pi^{\mathrm{E}}\left(a_{h} \mid s_{h}\right)\right)-\log \left(\widehat{\pi}\left(a_{h} \mid s_{h}\right)\right)\right| επ:=maxh∈[H]max(sh,ah) log(πE(ah∣sh))−log(π (ah∣sh)) 。该定理可以理解为:

3.2 由内生奖励微调的 LLM 的误差分析

- 提取奖励函数的最终目标是通过 RL 训练更优的策略。本节分析新学到的策略的表现,对比以下策略在 r ∗ r^* r∗ 下的次优程度:

- 直接在 D \mathcal{D} D 上应用 Next-Token Prediction 得到基线策略 π ^ \hat{\pi} π^

- 先根据式(12) 构建内生奖励 r ^ \hat{r} r^,然后强化学习得到新策略 π R L = argmax π V r ^ π \pi^{\mathrm{RL}}=\operatorname{argmax}_{\pi} V_{\widehat{r}}^{\pi} πRL=argmaxπVr π,忽略求解优化误差

- 作者通过定理2证明: π R L \pi^{RL} πRL 在次优边界(sub-optimality bound)中对响应长度 H H H 呈线性依赖,而 π ^ \hat{\pi} π^ 则呈二次依赖,这反映了模仿学习的累积误差问题。而逆强化学习的根本优势在于它直接模仿专家动作,而是恢复底层奖励函数并在此奖励下执行 RL,从而消除了累积误差问题

定理2:在 token MDP 中,设未知真实奖励为 r ⋆ r^⋆ r⋆, π E π^E πE 是熵正则化的最优策略。考虑 π ^ \hat{\pi} π^ 是通过 next token prediction 训练得到的策略。 r ^ \hat{r} r^ 是在式(12) 中定义的内生奖励,基于其强化学习得到新策略 π R L = argmax π V r ^ π \pi^{\mathrm{RL}}=\operatorname{argmax}_{\pi} V_{\widehat{r}}^{\pi} πRL=argmaxπVr π,有:

V π E r ⋆ − V π ^ r ⋆ ⪯ H 2 ε π , V π E r ⋆ − V π R L r ⋆ ⪯ H ε π V_{\pi E}^{r \star}-V_{\hat{\pi}}^{r \star} \preceq H^{2} \varepsilon_{\pi}, \quad V_{\pi E}^{r \star}-V_{\pi R L}^{r \star} \preceq H \varepsilon_{\pi} VπEr⋆−Vπ^r⋆⪯H2επ,VπEr⋆−VπRLr⋆⪯Hεπ 其中 V r π V_r^\pi Vrπ 表示策略 π \pi π 在奖励 r r r 下的价值,偏差值 ε π : = max h ∈ [ H ] max ( s h , a h ) ∣ log ( π E ( a h ∣ s h ) ) − log ( π ^ ( a h ∣ s h ) ) ∣ \varepsilon_{\pi}:=\max _{h \in[H]} \max _{\left(s_{h}, a_{h}\right)}\left|\log \left(\pi^{\mathrm{E}}\left(a_{h} \mid s_{h}\right)\right)-\log \left(\widehat{\pi}\left(a_{h} \mid s_{h}\right)\right)\right| επ:=maxh∈[H]max(sh,ah) log(πE(ah∣sh))−log(π (ah∣sh)) ,该定理可以扩展到无限时域情形

3.3 迭代改进的无效性

- 我们基于预训练 LLM 得到内生奖励 r ^ \hat{r} r^,再利用内生奖励训练更好的 LLM π R L \pi^{RL} πRL,这种自我改进过程是不可重复的。这是因为 π R L \pi^{RL} πRL 已经是奖励 r ^ \hat{r} r^ 对应的最优策略,从 π R L \pi^{RL} πRL 提取的内生奖励依然是 r ^ \hat{r} r^

4. 实验

- 作者的实验主要考虑三个问题

- 与启发式基线和明确训练的 SOTA 奖励模型相比,免训练内生奖励模型(EndoRM)在基准测试上的表现如何?

- EndoRM 是否具有强大的指令遵循能力,作为一个可以提示的通用奖励模型?

- 使用 EndoRM 进行 RL 能否产生更好的策略,实现自我改进?

4.1 对上的奖励准确性(Q1)

- 在 RM-Bench 上评估奖励模型面对多样化任务响应二元组时预测偏好准确率(计算每个响应的 token 奖励总和,分数更高的被视为“chosen”)

上面四个方法是显示训练的奖励模型,下面四个是免训练方法。结果显示,EndoRM 不仅显著优于所有免训练基线,还在平均准确率上超过了 SOTA 的显式训练奖励模型

4.2 指令遵循能力(Q2)

- 使用 Multifaceted-Bench(涵盖多样化用户偏好)和领域特定偏好数据集 DSP(包含不同专业领域的偏好)测试内生奖励是否能根据提示进行 “定制”

- 将四个领域的系统提示作为输入,得到四个领域专属的 EndoRM,测试它们在四个领域测试集上的表现。

注意到出现了明显的 “对角线” 模式:每个 EndoRM 在其所属领域的准确率最高,说明 EndoRM 并不是固定评估器,而是一个 可提示的动态裁判,继承了 LLM 的指令遵循能力

4.3 通过强化学习实现自我改进(Q3)

- 使用 MATH-lighteval 验证定理2的核心结论:RL + EndoRM 能改进基线策略

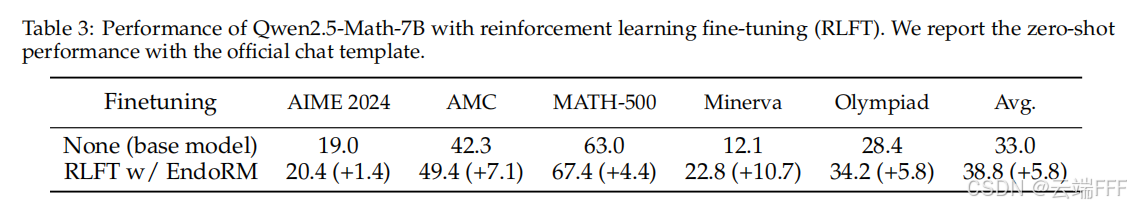

- 使用 Qwen2.5-Math-7B 作为基线模型和 EndoRM

- 在 MATH-lighteval 上进行 RL 微调,EndoRM 的参数保持固定,仅用于奖励

- 设置:PPO 算法,最大长度 1024,KL 系数 0.01

- 结果如下所示,RL + EndoRM 微调后在所有五个数学基准上全面优于基线模型。在附录中示例显示:基线模型在长推理时容易跑偏甚至输出 Python 代码,而 RL 优化后的模型则给出简洁清晰的解答

5. 讨论

- 内生奖励的概念对 LLM 对齐与发展有深远意义,作者进行了详细讨论,总结如下

- 对齐范式转变:

- 传统 三阶段对齐流程(SFT → 奖励建模 → RL 微调)被大幅简化:奖励建模阶段不再需要

- 偏好数据可以直接融入预训练或 SFT,增强模型的内生奖励能力

- 这种方式与 “强化预训练(Reinforcement Pre-training)” 的理念类似,但更有理论依据

- 好处:降低工程复杂度、计算成本和部署时间

- 个性化与可控性增强

- 外部奖励模型通常是“一刀切”,很难为特定用户或企业定制

- 内生奖励是动态的、可提示的:评价标准可以在推理时通过自然语言指令来改变

- 用户只需调整提示,即可引导 RL 训练更贴合自身价值观

- 这使得对齐过程从 “静态后处理” 变为 “动态交互式对话”

- 强化学习知识蒸馏

- 传统知识蒸馏:学生模型模仿教师的输出

- RLAIF:教师生成偏好标签,间接指导学生

- EndoRM:直接从教师模型的 logits 提取内生奖励,用 RL 优化学生策略。学生学到的是教师的“底层判断原则”,而不仅仅是表层输出,这意味着更强的蒸馏能力,小模型可能更有效继承大模型的能力

- 将强化学习扩展到文本之外

- RLHF 依赖人工偏好标签,在图像、视频、音频等模态更难收集

- 内生奖励机制不限于语言,只要模型是自回归生成式,就能适用,因此可以扩展到图像生成、视频合成、音乐创作 等领域

- 为多模态模型对齐提供了可扩展的解决方案

- 局限性与未来工作

- 潜在风险:内生奖励完全依赖模型的内部世界观,如果模型带有偏见或错误,它可能会自我强化这些问题。

- 可能后果:模型可能奖励自身生成的错误或有害输出。

- 未来方向:

- 融合混合方法:以内生奖励为主要稠密信号,同时用少量高质量人工反馈或规则进行矫正

- 研究更安全的 提示工程 技术,用于稳健地引导奖励信号。

- 对齐范式转变:

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)