深度学习入门:一文搞懂循环神经网络(RNN)原理与实战

深度学习入门:循环神经网络(RNN)原理与应用 摘要:本文介绍了循环神经网络(RNN)在处理序列数据中的核心作用,包括自然语言处理(NLP)基础、词嵌入技术、RNN原理及改进方案(LSTM/GRU)。文章首先解释了RNN在文本预测、机器翻译等任务中的必要性,然后详细讲解了词嵌入层如何将文字转化为向量表示。重点剖析了RNN的记忆机制和计算过程,指出其局限性并介绍了LSTM和GRU的改进方案。最后通过

深度学习入门:一文搞懂循环神经网络(RNN)原理与实战

关键词:RNN、循环神经网络、自然语言处理、文本生成、LSTM、GRU、PyTorch

引言:为什么需要RNN?RNN能做什么?

你是否好奇:

- 智能手机输入法如何预测你下一个想打的字?

- 机器翻译是如何将“Hello World”翻译成“你好世界”的?

- AI是如何写出周杰伦风格的歌词或古诗的?

这些处理序列数据的任务,背后都离不开一种强大的深度学习模型——循环神经网络(Recurrent Neural Network, RNN)。

与CNN处理图像不同,RNN专为处理具有时间或顺序依赖关系的数据而设计。无论是文字、语音、时间序列(如股票价格),还是DNA序列,它们的共同特点是:当前的输出依赖于之前的信息。

本文学习目标

学完本文,你将能够:

- 理解自然语言处理(NLP)的基本概念

- 掌握RNN的核心原理:记忆性与时间步

- 理解词嵌入层(Word Embedding)的作用

- 使用PyTorch搭建RNN模型实现文本生成

- 了解RNN的变体(LSTM/GRU)及现代NLP发展趋势

无论你是NLP初学者,还是想巩固RNN基础,本文都力求讲透每一个细节,让你真正“搞懂”RNN!

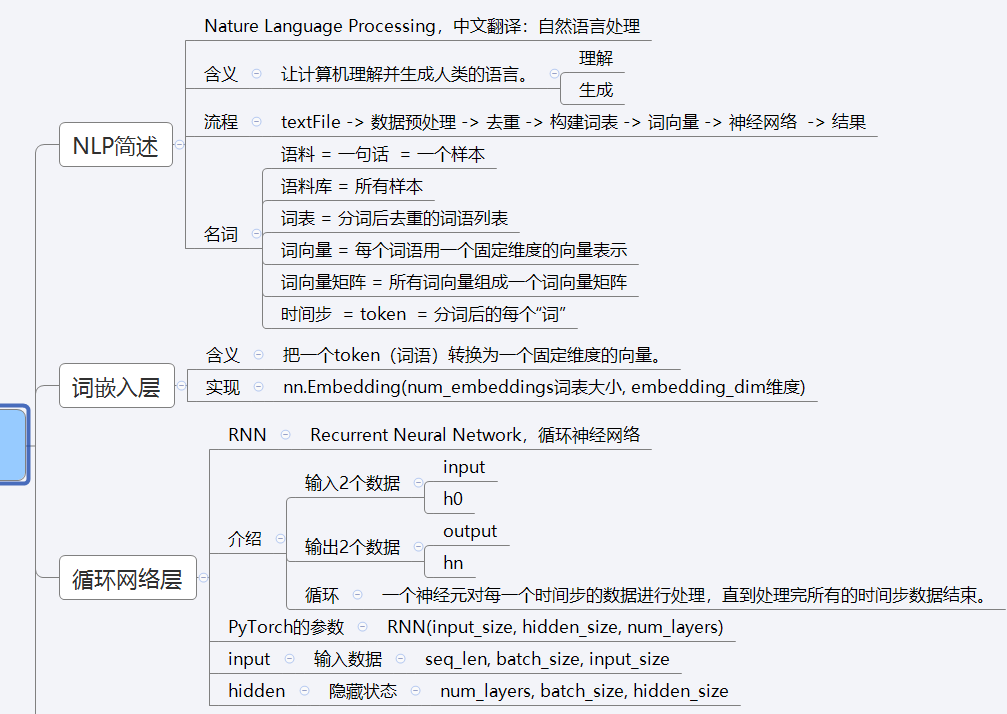

一、自然语言处理(NLP)基础

1. 什么是NLP?

自然语言处理(Natural Language Processing, NLP) 是人工智能的一个分支,研究如何让计算机能够“理解”和“生成”人类语言。

- 理解:情感分析、文本分类、问答系统

- 生成:机器翻译、文本摘要、歌词/诗歌生成

2. 文本数据的特点

与图像或结构化数据不同,文本是序列数据,顺序至关重要。

- “我爱你” ≠ “你爱我”

- “北京冬奥会” ≠ “会冬京北”

因此,我们需要一种能记住“历史信息”的网络——这就是RNN的用武之地。

3. 基本概念

| 术语 | 说明 |

|---|---|

| 样本(Sample) | 一条完整的语句,如“我爱你” |

| 语料库(Corpus) | 所有样本的集合 |

| 分词(Tokenization) | 将句子切分成词或字,如“我/爱/你” |

| 词表(Vocabulary) | 所有不重复词的集合 |

| 词索引(Word Index) | 每个词对应一个唯一编号 |

| 时间步(Time Step) | 每次输入一个词(或字)就是一个时间步 |

二、词嵌入层:将文字转化为向量

神经网络不能直接处理文字,必须将其转化为数值向量。词嵌入层(Word Embedding Layer)就是完成这一任务的关键。

1. 为什么不能用One-Hot?

传统方法如One-Hot编码存在严重问题:

- 高维稀疏:每个词都是一个很长的向量(如10000维),大部分为0。

- 无语义信息:无法表达词之间的相似性(如“猫”和“狗”很相似,但One-Hot向量完全正交)。

2. 词嵌入的优势

词嵌入将每个词映射为一个低维稠密向量(如128维),这些向量能捕捉词的语义:

- 语义相近的词在向量空间中距离较近

- 可以进行向量运算:“国王 - 男人 + 女人 ≈ 女王”

3. PyTorch实现词嵌入

import torch

import torch.nn as nn

import jieba

# 示例文本

text = "北京冬奥的进度条已经过半,不少外国运动员在完成自己的比赛后踏上归途。"

words = jieba.lcut(text) # 分词

unique_words = list(set(words)) # 去重

# 构建词嵌入层

embed = nn.Embedding(num_embeddings=len(unique_words), embedding_dim=4)

# 获取词向量

for i, word in enumerate(unique_words):

word_vec = embed(torch.tensor(i))

print(f"{word}: {word_vec}")

输出示例:

北京: tensor([-1.8043, 1.7860, -0.7821, -0.3167]) 冬奥: tensor([ 0.6969, -0.5615, 1.6524, -0.2651])

三、循环神经网络(RNN)原理

1. 为什么需要RNN?

普通神经网络无法处理序列依赖。例如:

- 输入“我爱”,希望预测“你”

- 但“爱”字的含义依赖于前面的“我”

RNN通过隐藏状态(Hidden State) 解决这个问题,它像一个“记忆体”,保存了之前时间步的信息。

2. RNN核心结构

h_t-1 x_t h_t y_t

... → [RNN] → [RNN] → [RNN] → ...

↑ ↑

上一时刻 当前输入

- h_t-1:上一时刻的隐藏状态(记忆)

- x_t:当前时刻的输入(词向量)

- h_t:当前时刻的隐藏状态

- y_t:当前时刻的输出(预测)

3. RNN计算过程

在每个时间步 t t t,RNN执行以下计算:

h t = tanh ( W i h x t + b i h + W h h h t − 1 + b h h ) h_t = \tanh(W_{ih} x_t + b_{ih} + W_{hh} h_{t-1} + b_{hh}) ht=tanh(Wihxt+bih+Whhht−1+bhh)

- W i h W_{ih} Wih:输入到隐藏的权重

- W h h W_{hh} Whh:隐藏到隐藏的权重(实现记忆)

- tanh \tanh tanh:激活函数

关键点: W h h h t − 1 W_{hh} h_{t-1} Whhht−1 使得网络能记住历史信息。

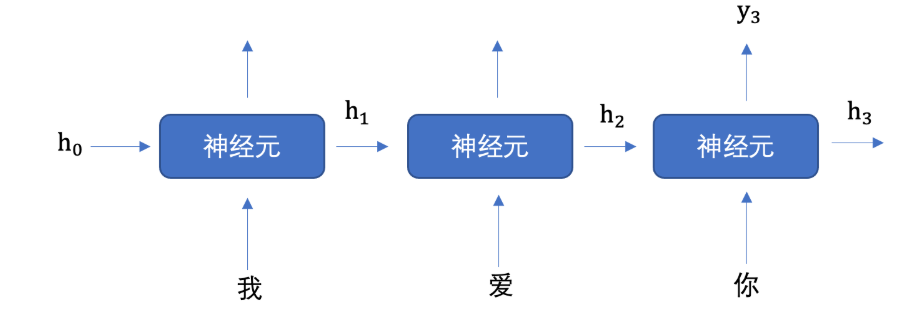

4. RNN的“展开”视图

虽然RNN只有一个神经元,但在时间上可以“展开”看:

时间步1: x1 → [RNN] → h1 → y1

时间步2: x2 → [RNN] → h2 → y2

时间步3: x3 → [RNN] → h3 → y3

隐藏状态 h 1 h1 h1 传给 h 2 h2 h2, h 2 h2 h2 传给 h 3 h3 h3,形成一条记忆链。

5. RNN的局限性与改进:LSTM & GRU

RNN的三大问题

- 梯度消失/爆炸:长序列中,早期信息难以传递到后期。

- 难以并行:必须按时间步顺序计算,训练慢。

- 记忆遗忘:长时间依赖信息容易丢失。

改进方案:LSTM(长短期记忆)

LSTM通过门控机制(Gate)控制信息流动:

- 遗忘门:决定丢弃哪些信息

- 输入门:决定更新哪些信息

- 输出门:决定输出哪些信息

[输入] → [遗忘门] → [细胞状态] ← [输入门]

↓

[输出门] → [输出]

LSTM能更好地处理长序列依赖,广泛应用于机器翻译、语音识别。

GRU(门控循环单元)

GRU是LSTM的简化版,合并了遗忘门和输入门,参数更少,训练更快。

6. PyTorch中RNN/LSTM/GRU的API

import torch

import torch.nn as nn

# RNN

rnn = nn.RNN(input_size=128, hidden_size=256, num_layers=1)

# LSTM

lstm = nn.LSTM(input_size=128, hidden_size=256, num_layers=1)

# GRU

gru = nn.GRU(input_size=128, hidden_size=256, num_layers=1)

实际项目中,建议优先使用 LSTM 或 GRU 替代基础RNN。

四、实战:用RNN生成周杰伦歌词

我们将使用RNN训练一个模型,输入一个起始词,生成一整段周杰伦风格的歌词。

环境配置说明

# 推荐环境

Python 3.8+

PyTorch 2.0+

jieba 0.42+

1. 数据准备

我们收集了周杰伦从《Jay》到《跨时代》的所有歌词,共5819行。

def build_vocab():

file_name = 'data/jaychou_lyrics.txt'

index_to_word = []

all_words = []

try:

for line in open(file_name, 'r', encoding='utf-8'):

words = jieba.lcut(line.strip()) + [' '] # 分词并加空格

all_words.append(words)

for word in words:

if word not in index_to_word:

index_to_word.append(word)

except FileNotFoundError:

print("数据文件未找到,请检查路径或下载数据集")

return None, None, 0, []

word_to_index = {word: idx for idx, word in enumerate(index_to_word)}

corpus_idx = [word_to_index[word] for words in all_words for word in words]

return index_to_word, word_to_index, len(index_to_word), corpus_idx

2. 构建数据集

class LyricsDataset(torch.utils.data.Dataset):

def __init__(self, corpus_idx, num_chars=32):

self.corpus_idx = corpus_idx

self.num_chars = num_chars

self.word_count = len(corpus_idx)

self.number = self.word_count // num_chars

def __len__(self):

return self.number

def __getitem__(self, idx):

start = min(max(idx, 0), self.word_count - self.num_chars - 1)

end = start + self.num_chars

x = self.corpus_idx[start: end] # 输入:前n个词

y = self.corpus_idx[start + 1: end + 1] # 输出:后n个词(错开一位)

return torch.tensor(x), torch.tensor(y)

关键点:输入

x和目标y错开一位,实现“根据前文预测下一个词”。

3. 构建RNN模型(支持LSTM/GRU)

class TextGenerator(nn.Module):

def __init__(self, vocab_size, model_type='rnn'):

super().__init__()

self.embed = nn.Embedding(vocab_size, 128)

self.model_type = model_type

if model_type == 'rnn':

self.rnn = nn.RNN(128, 256, 1)

elif model_type == 'lstm':

self.rnn = nn.LSTM(128, 256, 1)

elif model_type == 'gru':

self.rnn = nn.GRU(128, 256, 1)

self.out = nn.Linear(256, vocab_size)

def forward(self, inputs, hidden):

embed = self.embed(inputs)

output, hidden = self.rnn(embed.transpose(0,1), hidden)

output = self.out(output.reshape(-1, 256))

return output, hidden

def init_hidden(self, batch_size):

return torch.zeros(1, batch_size, 256)

4. 训练模型(增强版)

def train():

index_to_word, word_to_index, vocab_size, corpus_idx = build_vocab()

if vocab_size == 0: return

dataset = LyricsDataset(corpus_idx, 32)

dataloader = DataLoader(dataset, batch_size=5, shuffle=True)

model = TextGenerator(vocab_size, model_type='lstm') # 使用LSTM

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=1e-3)

# Early Stopping 设置

best_loss = float('inf')

patience = 5

patience_counter = 0

for epoch in range(50): # 增加训练轮数

total_loss = 0

for x, y in dataloader:

hidden = model.init_hidden(5)

output, hidden = model(x, hidden)

loss = criterion(output, y.transpose(0,1).reshape(-1))

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

avg_loss = total_loss / len(dataloader)

print(f"Epoch {epoch+1}, Loss: {avg_loss:.5f}")

# Early Stopping

if avg_loss < best_loss:

best_loss = avg_loss

patience_counter = 0

torch.save(model.state_dict(), 'model/best_model.pth')

else:

patience_counter += 1

if patience_counter >= patience:

print("Early stopping triggered")

break

print(f"训练完成,最佳损失: {best_loss:.5f}")

5. 生成歌词(支持temperature控制)

def predict(start_word, sentence_length=50, temperature=1.0):

index_to_word, word_to_index, vocab_size, _ = build_vocab()

if vocab_size == 0: return

model = TextGenerator(vocab_size, model_type='lstm')

model.load_state_dict(torch.load('model/best_model.pth'))

hidden = model.init_hidden(1)

word_idx = word_to_index.get(start_word, 0)

generated = [word_idx]

for _ in range(sentence_length):

output, hidden = model(torch.tensor([[word_idx]]), hidden)

# 添加temperature控制生成多样性

output = output / temperature

probs = torch.softmax(output, dim=-1)

word_idx = torch.multinomial(probs, 1).item()

generated.append(word_idx)

result = ''.join([index_to_word[idx] for idx in generated])

print(f"起始词: {start_word}")

print(f"生成结果: {result}")

# 生成不同temperature效果

predict('分手', temperature=0.5) # 更保守

predict('分手', temperature=1.5) # 更随机

temperature作用:

temperature < 1:输出更确定,倾向于高概率词temperature > 1:输出更随机,增加多样性

五、模型评估与可视化

1. 训练过程可视化

import matplotlib.pyplot as plt

# 记录loss

loss_history = []

for epoch in range(50):

# ...训练代码...

loss_history.append(avg_loss)

plt.plot(loss_history)

plt.title("Training Loss Curve")

plt.xlabel("Epoch")

plt.ylabel("Loss")

plt.show()

2. 评估指标:困惑度(Perplexity)

def calculate_perplexity(model, dataloader):

total_loss = 0

with torch.no_grad():

for x, y in dataloader:

hidden = model.init_hidden(x.size(0))

output, _ = model(x, hidden)

loss = nn.CrossEntropyLoss()(output, y.transpose(0,1).reshape(-1))

total_loss += loss.item()

return torch.exp(torch.tensor(total_loss / len(dataloader)))

困惑度越低,模型越好。

六、常见问题解答

Q1:如何选择超参数?

| 参数 | 推荐范围 | 说明 |

|---|---|---|

| 嵌入维度 | 64-256 | 词汇量大时用更高维度 |

| 隐藏层大小 | 128-512 | 影响模型容量 |

| 学习率 | 1e-4 ~ 1e-3 | Adam优化器常用值 |

| batch_size | 16-64 | GPU内存允许下越大越好 |

Q2:如何提升生成质量?

- 使用 LSTM/GRU 替代RNN

- 增加训练轮数和数据量

- 调整

temperature参数 - 使用更大的模型(更多层)

Q3:现代NLP发展趋势?

- Transformer:基于注意力机制,取代RNN成为主流

- BERT/GPT:预训练语言模型,极大提升NLP性能

- 大语言模型(LLM):如ChatGPT、Claude等

七、总结与建议

RNN 核心知识思维导图

练习

- 尝试用 古诗数据集 训练模型

- 将模型改为 情感分类任务

- 实现 中文文本纠错 功能

调试技巧

- 显存不足:减小

batch_size - 训练太慢:使用GPU或减小模型

- 生成重复:提高

temperature - 模型不收敛:检查学习率和数据预处理

学习建议:

- 动手实践:复现本文代码,尝试生成不同风格的文本

- 扩展数据集:尝试用小说、新闻训练模型

- 改进模型:

- 使用LSTM/GRU替代RNN

- 增加网络深度

- 调整超参数(学习率、隐藏层大小)

- 进阶学习:

- 学习注意力机制(Attention)

- 探索Transformer和BERT

参考资料

原创不易,如果觉得有收获,欢迎点赞、收藏、分享!

关注我,持续更新深度学习与AI实战内容。

评论区留下你的问题,我们一起讨论!

如需数据集,请留言获取

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)