Linux Logstash-7.17.0详细部署与应用指南

Logstash是一款开源的日志收集引擎,其核心功能是实时捕获和处理数据流,它可以在数据到达目的地之前进行处理和分析。作为ELK(Elasticsearch、Logstash、Kibana)栈的一部分,Logstash特别擅长于日志数据的收集、解析和传输。文件输入插件是Logstash中非常基础且应用广泛的插件之一,它能够监听指定路径下的文件变化,并将新的日志内容读取到Logstash中进行处理。

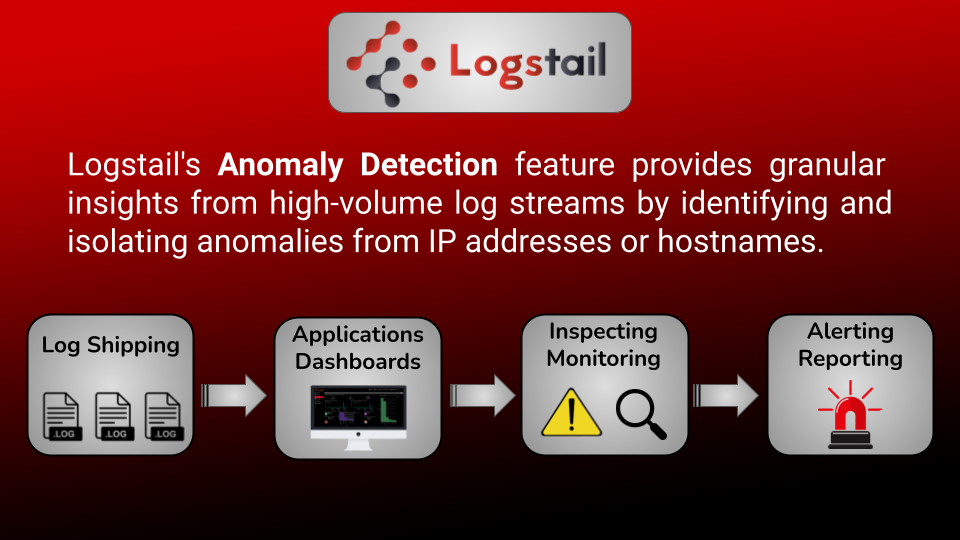

简介:Logstash 7.17.0是一个开源的数据处理工具,是ELK堆栈的重要组成部分,用于日志管理和大数据分析。它通过输入、过滤和输出三个阶段工作,支持多种输入和输出插件。本指南涵盖安装、配置、监控、安全性和性能优化等关键实践,旨在帮助用户有效部署和管理Logstash,以实现高效的数据处理和分析。

1. Logstash架构概述

1.1 Logstash基础

Logstash是一款开源的日志收集引擎,其核心功能是实时捕获和处理数据流,它可以在数据到达目的地之前进行处理和分析。作为ELK(Elasticsearch、Logstash、Kibana)栈的一部分,Logstash特别擅长于日志数据的收集、解析和传输。

1.2 架构组件

Logstash的架构由三个主要部分组成:输入(input)、过滤器(filter)和输出(output)。输入组件负责从不同来源收集数据,过滤器组件用于数据处理和转换,输出组件则负责将清洗后的数据发送到目标系统。

1.3 数据处理流程

数据处理流程从输入开始,数据经过过滤器处理后输出到一个或多个目的地。这一过程是动态和可配置的,允许用户定制化日志处理策略。Logstash利用强大的插件系统支持各种输入、过滤器和输出模块,极大地提高了日志处理的灵活性和效率。

2. 安装与配置指导

安装与配置指导是使用Logstash的第一步,本章节会详细介绍如何准备系统环境,进行Logstash的安装,以及如何配置基本的pipeline文件。

2.1 系统环境准备

2.1.1 操作系统兼容性要求

在开始安装之前,需要确保你的操作系统满足Logstash的兼容性要求。Logstash运行在Java虚拟机上,对Java的版本也有一定要求,不同版本的Logstash支持的Java版本可能会有差异。通常,较新版本的Logstash至少需要Java 8或更高版本。

2.1.2 Java环境的安装与配置

-

下载与安装Java:

为了安装Java,首先需要从官方网站(如Oracle官网或OpenJDK官网)下载适合你操作系统的Java版本。安装过程依赖于你的操作系统,一般遵循标准的软件安装流程。 -

验证Java安装:

安装完成后,通过命令行验证Java安装。打开终端并输入以下命令:

bash java -version

应该会看到Java的版本信息被打印到屏幕上。如果安装成功,你可以继续进行下一步操作。

- 设置环境变量:

在某些情况下,可能需要手动设置环境变量JAVA_HOME指向你的Java安装目录。这样,Logstash就可以自动找到Java环境。

bash export JAVA_HOME=/path/to/your/java/directory

根据你的操作系统和安装位置修改上述路径。之后,为使改动立即生效,执行命令:

bash source ~/.bashrc # 或者直接打开新的终端窗口

2.2 Logstash的安装过程

2.2.1 下载最新版的logstash-7.17.0-linux-x86_64.tar.gz

- 访问Logstash官方下载页面:

访问Elastic官网或通过其提供的命令行工具下载Logstash。例如,使用curl下载:

bash curl -L -O https://artifacts.elastic.co/downloads/logstash/logstash-7.17.0.tar.gz

- 解压安装包:

下载完成后,解压缩文件到指定目录。可以使用tar命令进行解压:

bash tar -xzvf logstash-7.17.0.tar.gz

这将创建一个名为 logstash-7.17.0 的新目录。

2.2.2 解压缩安装包并进行基本配置

- 配置Logstash:

Logstash的配置主要通过配置文件完成,其默认的配置文件目录为/path/to/logstash-7.17.0/config。在此目录下,你可以找到一个示例配置文件logstash.conf。

bash cd logstash-7.17.0 mkdir config cp /path/to/logstash.conf.example config/logstash.conf

-

编辑配置文件:

使用你喜欢的文本编辑器编辑logstash.conf文件,根据需要进行修改。配置文件由多个部分组成,包括输入(input)、过滤(filter)和输出(output)。 -

启动Logstash:

通过以下命令可以启动Logstash并应用你的配置文件:

bash bin/logstash -f config/logstash.conf

如果一切设置正确,你应该能在终端看到Logstash开始运行的信息。

2.3 配置文件解析

2.3.1 pipeline配置文件的结构和组成

- Logstash配置文件结构:

Logstash的配置文件由三个主要部分组成:输入(input)、过滤(filter)和输出(output)。以下是一个基本的配置文件结构:

```conf

input {

# 输入配置部分

}

filter {

# 过滤配置部分

}

output {

# 输出配置部分

}

```

每个部分都是可选的,但至少需要一个输入和一个输出。

- 输入(input):

输入部分定义了Logstash从哪里接收数据。支持多种输入方式,如文件、TCP端口、HTTP等。

conf input { file { path => "/var/log/syslog" start_position => "beginning" } }

上例配置了从 /var/log/syslog 文件接收数据。

- 过滤(filter):

过滤部分允许你对数据进行转换和处理。过滤器通常用于解析、条件判断等。

conf filter { grok { match => { "message" => "%{COMBINEDAPACHELOG}" } } }

例子中使用了 grok 过滤器来解析包含Apache日志的 message 字段。

- 输出(output):

输出部分定义了Logstash将数据发送到何处。支持输出到Elasticsearch、文件、消息队列等。

conf output { elasticsearch { hosts => ["localhost:9200"] } }

例子中将数据输出到本地运行的Elasticsearch实例。

2.3.2 配置文件的编写与验证方法

-

编写配置文件:

编写Logstash配置文件时,可以按照需求自由组合输入、过滤和输出组件。需要注意的是,输入和输出通常需要通过过滤来处理数据,确保数据格式正确。 -

配置文件格式验证:

Logstash提供了一个验证配置文件格式的命令,可以在启动前进行检查。

bash bin/logstash --config.test_and_exit -f config/logstash.conf

如果配置文件没有问题,该命令将输出 Configuration OK 的信息。

- 启动Logstash并监控:

在验证通过后,可以通过直接启动Logstash来运行配置文件,并监控日志输出确保一切正常运行。

bash bin/logstash -f config/logstash.conf

Logstash在运行过程中会打印出日志信息,你可以从中观察到数据处理的流程和可能出现的错误。

以上内容介绍了Logstash的安装和基本配置过程。在实际部署中,你可能还需要进行更细致的配置和优化,以满足特定的性能和功能需求。接下来的章节将详细讨论如何配置输入、过滤和输出插件,以实现更高级的数据处理功能。

3. 输入插件使用与配置

在日志处理的架构中,输入插件是数据流进入Logstash的第一步,它负责收集各种数据源的信息,并将其输送给后续的过滤和输出插件。了解和正确配置输入插件对于构建高效且可靠的日志处理管道至关重要。

3.1 常见输入插件介绍

3.1.1 文件输入(file)的使用和配置

文件输入插件是Logstash中非常基础且应用广泛的插件之一,它能够监听指定路径下的文件变化,并将新的日志内容读取到Logstash中进行处理。

配置示例 :

input {

file {

path => "/var/log/*.log"

start_position => "beginning"

sincedb_path => "/dev/null"

}

}

参数说明 :

path: 指定需要监听的文件路径,支持通配符。start_position: 指定Logstash开始读取文件的位置,可选项有”beginning”和”end”。sincedb_path: 用于存储记录的文件读取位置信息,如果设置为”/dev/null”则不记录。

操作步骤 :

- 打开Logstash的配置文件

logstash.yml。 - 将上面的配置部分添加到

input字段中。 - 确保文件路径中的通配符与实际日志文件匹配。

- 重启Logstash服务,使配置生效。

通过文件输入插件,Logstash可以将服务器上产生的日志文件实时地导入到日志处理流程中,从而实现对日志数据的统一管理和分析。

3.1.2 系统日志输入(syslog)的应用场景和配置

syslog输入插件用于监听系统日志,通常被用于Unix和类Unix系统中,它能够收集这些系统的syslog信息并进行处理。

配置示例 :

input {

syslog {

port => 514

type => "syslog"

codec => "plain"

# 其他参数配置

}

}

参数说明 :

port: 指定syslog服务监听的端口,默认为514。type: 指定事件类型,有助于后续的过滤和输出处理。codec: 指定解析syslog消息的编解码器,默认为plain。

操作步骤 :

- 在配置文件中添加syslog输入插件的相关配置。

- 配置防火墙规则,允许外部syslog消息通过514端口。

- 重启Logstash服务以加载新的配置。

syslog输入插件是监控系统健康状态、实时响应系统事件的重要手段,它能够将系统运行信息及时地传递给Logstash,确保管理员能够快速作出反应。

3.2 输入插件的高级配置技巧

3.2.1 多线路输入配置和处理

多线路配置允许Logstash同时监听多个端口或多个文件,这在处理复杂日志环境时非常有用。

配置示例 :

input {

tcp {

port => 5000

type => "multi-line-log"

}

udp {

port => 5001

type => "multi-line-log"

}

file {

path => "/var/logs/multi-*.log"

type => "multi-line-log"

}

}

参数说明 :

port: 为tcp和udp输入插件指定监听端口。path: 指定监听文件路径。

操作步骤 :

- 在配置文件中添加上述配置,确保各端口或文件不会相互冲突。

- 配置相应的防火墙和权限,以允许监听。

- 重启Logstash服务。

这种多线路输入的配置可以大幅提升日志收集的灵活性和效率,适用于大规模的日志监控系统。

3.2.2 自定义字段添加与动态数据捕获

在处理一些特定日志格式时,我们可能需要根据日志内容动态地添加或修改字段。

配置示例 :

input {

file {

path => "/var/log/example.log"

codec => "json"

add_field => { "custom_field" => "custom_value" }

}

}

参数说明 :

codec: 指定日志文件的内容编解码器,这里使用json编解码器。add_field: 自定义字段添加,适用于将非标准字段插入到事件中。

操作步骤 :

- 配置文件输入插件,设置正确的路径和编解码器。

- 使用

add_field指定需要添加的字段。 - 重启Logstash服务。

通过自定义字段的添加与动态数据捕获,我们能够对日志信息进行丰富和补充,从而获得更加丰富的上下文信息,这对后续的分析和处理非常重要。

在本章节中,我们详细探讨了Logstash输入插件的基本使用方法以及一些高级配置技巧。通过实际的配置示例和操作步骤,我们可以看到如何根据不同的需求场景进行配置,以便于高效地收集和处理日志数据。接下来的章节我们将深入讨论过滤插件,进一步了解如何对这些收集到的日志数据进行清洗和转换处理。

4. 过滤插件功能与应用

4.1 过滤插件概述

4.1.1 常用过滤插件分类和功能简介

过滤插件作为Logstash处理数据流中的关键环节,主要用于对输入的数据进行清洗、转换和格式化。它们的作用是确保数据质量和准确性,从而便于后续的分析和存储。Logstash提供了众多过滤插件,覆盖了从简单到复杂的各种数据处理需求。以下是一些常用的过滤插件分类及其功能简介:

- Grok :使用正则表达式将非结构化的日志数据转换为结构化的字段。

- Mutate :用于修改事件中的字段,如字段重命名、字段删除、字段添加或转换字段类型。

- Date :解析和转换事件时间戳字段。

- Drop/Keep :根据条件过滤掉(drop)或保留(keep)事件。

- GeoIP :添加有关IP地址的地理位置信息。

- Elasticsearch :对事件进行索引,可以与Elasticsearch进行无缝集成。

- Kafka :将事件发布到Kafka主题。

- Split/Clone :将事件拆分为多个事件或克隆事件。

4.1.2 过滤插件在日志处理中的重要性

日志数据往往是杂乱无章的,其中可能包含无用信息、不同格式的数据和错误记录。过滤插件的重要性在于其能够有效地筛选、转换和清洗这些数据,使它们变成结构化且有价值的日志信息。通过合理使用过滤插件,能够提升日志数据的质量,简化日志分析过程,并最终加速问题诊断和性能优化。

过滤插件的功能是任何日志管理方案中的核心组成部分,因为它们可以将原始的、未处理的输入数据转化为更加有用和可操作的输出数据。过滤过程还能帮助减少存储和计算的开销,因为无用或重复的数据可以被过滤掉,而相关数据则可以被进一步地细化和索引。

过滤插件的另一个重要作用是为日志数据应用格式化和标准化,这对于跨系统日志分析和监控是至关重要的。例如,可以将不同来源的日志时间戳统一转换成ISO格式,或者标准化IP地址格式,确保所有日志数据能够被统一地处理和分析。

4.2 过滤插件的应用实践

4.2.1 Grok插件的使用和正则表达式编写

Grok是一个非常强大的过滤插件,它使用正则表达式模式来解析复杂的文本数据。在处理非结构化的日志文件时,Grok能够将无意义的原始数据转化为有意义的、可查询的字段。下面是使用Grok插件的一个例子,以及如何编写正则表达式。

假设我们有一行日志如下:

May 15 08:34:45 server01 sshd[9448]: Invalid user admin from 192.168.2.112 port 59582

我们想要提取时间、用户名、IP地址等字段。

编写Grok模式:

%{SYSLOGTIMESTAMP:timestamp} %{WORD:service}[%{NUMBER:pid}]:\s(?:%{WORD:action}(?:\s+from %{IP:src_ip}\s+port %{NUMBER:src_port})?)

应用到Grok过滤器配置文件中:

filter {

grok {

match => { "message" => "%{SYSLOGTIMESTAMP:timestamp} %{WORD:service}[%{NUMBER:pid}]:\s(?:%{WORD:action}(?:\s+from %{IP:src_ip}\s+port %{NUMBER:src_port})?)" }

}

}

通过上述配置,当一条新的日志事件流经这个过滤器时,Grok插件会应用定义好的模式来匹配和提取相关字段。 match 参数指定了消息字段和Grok模式的映射关系。日志行经过Grok处理后,将增加几个新的字段,如 timestamp 、 service 、 pid 、 action 、 src_ip 和 src_port ,这些字段可以直接用于搜索和可视化。

4.2.2 Mutate插件的字段转换与数据清洗

Mutate插件可以用来修改事件中的字段,比如字段重命名、类型转换、字段删除等。以下是一个Mutate插件的示例,其中展示了如何进行字段转换和数据清洗。

假设我们有一组日志,我们想要将一些字段从字符串类型转换为整数类型,并且删除一些不需要的字段。

Mutate过滤器配置示例:

filter {

mutate {

convert => {

"user_id" => "integer"

"post_count" => "integer"

}

remove_field => ["aux_field", "temp_field"]

}

}

在上述示例中:

- convert 参数将 user_id 和 post_count 字段的值从字符串转换为整数。这在需要进行数值计算或数据聚合时特别有用。

- remove_field 参数会从事件中删除不需要的字段,比如 aux_field 和 temp_field 。

4.2.3 其他高级过滤技术与场景应用

除了Grok和Mutate之外,Logstash提供了许多其他过滤插件,用于满足各种复杂的日志处理需求。比如:

-

Date插件 :用于解析和转换事件的时间戳字段。

json filter { date { match => ["timestamp", "MMM d HH:mm:ss"] target => "@timestamp" } }

上述配置将事件中的timestamp字段按照指定的格式解析,并把解析结果存储到@timestamp字段中。 -

Drop/Keep插件 :用于根据特定的条件来过滤掉或保留事件。

json filter { if [level] == "debug" { drop {} } }

在此示例中,任何包含debug级别的日志都将被过滤掉。 -

GeoIP插件 :用于添加有关IP地址的地理位置信息。

json filter { geoip { source => "client_ip" } }

此配置会根据client_ip字段的值添加地理位置信息到事件中。

以上示例展示了过滤插件如何帮助我们在数据流中进行灵活处理,提高日志数据的质量,以及在不同的使用场景下应用高级过滤技术,实现数据的清洗、转换和优化。通过这些插件,我们能够构建出强大而动态的日志处理流水线,以满足各种复杂的业务需求。

5. 输出插件配置与数据推送

5.1 输出插件的种类和选择依据

5.1.1 Elasticsearch输出的配置和优化

Elasticsearch输出插件允许将经过处理的日志数据直接索引到Elasticsearch集群中,这在构建实时日志分析系统中非常常见。为了优化这一过程,配置中需要关注以下方面:

- 批量大小 :调整

batch.size参数以控制批量处理的数量,过大或过小都会影响索引性能。 - 间隔时间 :

idle_flush_time参数用于控制在空闲情况下多长时间将批次数据发送到Elasticsearch。 - 连接设置 :确保

hosts参数配置了正确的Elasticsearch集群地址,并设置合适的超时时间。

output {

elasticsearch {

hosts => ["127.0.0.1:9200"]

index => "logstash-%{+YYYY.MM.dd}"

document_type => "_doc"

template_overwrite => true

batch.size => 5000

idle_flush_time => 10

manage_template => false

}

}

5.1.2 文件输出(file)和消息队列输出的对比

当需要将数据持久化到文件系统中或利用消息队列系统分发数据时,文件输出和消息队列输出(如Kafka或RabbitMQ)成为可选的插件。它们的对比和选择依据主要包括:

- 持久性和可靠性 :文件输出提供简单的方式将数据写入文件,适用于不需要复杂消息处理的场景。而消息队列输出通过保证消息传递的可靠性、持久性和顺序性,适合分布式环境和高可用架构。

- 扩展性 :消息队列输出插件在处理大规模数据时,能够支持水平扩展,而文件输出则受到单台服务器文件系统性能的限制。

- 灵活性 :消息队列输出提供了更多可配置的参数,如消息确认、分区策略和消费组,用于适应不同的应用场景。

# File output example

output {

file {

path => "/var/log/logstash/%{+YYYY-MM-dd}/output-%{host}.log"

codec => json_lines

}

}

# Kafka output example

output {

kafka {

bootstrap_servers => "kafka1:9092,kafka2:9092,kafka3:9092"

topic_id => "logstash_output"

}

}

5.2 输出插件的高级配置

5.2.1 负载均衡与故障转移的配置方法

在高流量或高可用性的场景下,负载均衡和故障转移是关键的高级配置。在Logstash的输出插件中,可以通过以下方式配置:

- 负载均衡 :在Elasticsearch输出插件中,可以配置多个Elasticsearch节点来实现负载均衡。

- 故障转移 :配置

sniffing选项,使Logstash能够检测并响应集群中的节点失效,自动将请求重定向到可用的节点。

output {

elasticsearch {

hosts => ["elasticsearch1:9200", "elasticsearch2:9200", "elasticsearch3:9200"]

load_balance => true

.sniffing => true

}

}

5.2.2 动态模板和索引生命周期管理的整合应用

为了更精细地控制Elasticsearch索引的创建和管理,可以使用动态模板和索引生命周期管理策略(ILM)。动态模板允许根据数据类型来定义索引映射,而ILM可以定义索引的保留策略、滚动和删除。

output {

elasticsearch {

hosts => ["elasticsearch:9200"]

template => {

"template-name" => {

order => 0

mapping => {

dynamic_templates => [

{

strings => {

match_mapping_type => "string"

mapping => {

type => "keyword"

ignore_above => 1024

}

}

}

]

}

}

}

ilm_enabled => true

}

}

5.3 数据推送策略与优化

5.3.1 批量处理和缓冲机制

批量处理是提高日志收集系统效率的关键策略之一。通过合理配置 batch.size 和 flush_interval 参数,可以控制日志数据的批量推送行为。

- 批量大小 :

batch.size可以设置为事件数量或数据大小,这取决于处理能力。 - 缓冲时间 :

flush_interval指定多少时间间隔强制刷新缓冲区。

output {

elasticsearch {

# ... other configurations ...

batch.size => 5000

flush_interval => 10

}

}

5.3.2 效率分析与性能监控技巧

效率分析与性能监控对于发现瓶颈和优化日志处理流程至关重要。可以通过Logstash自带的监控接口或集成第三方监控工具来实现。

- 内部指标 :使用Logstash的监控插件或API来收集内部指标,如事件处理时间、队列状态和错误率。

- 外部监控 :集成如Prometheus、Grafana等外部监控工具,用于数据可视化和警报设置。

# Metric filter example

filter {

metrics {

meter => "logstash_speed"

add_tag => ["performance监控"]

}

}

为了确保监控数据的准确性和及时性,应定期检查和更新监控系统配置,同时对收集到的数据进行分析,以揭示潜在的性能问题,并进行相应的优化调整。

简介:Logstash 7.17.0是一个开源的数据处理工具,是ELK堆栈的重要组成部分,用于日志管理和大数据分析。它通过输入、过滤和输出三个阶段工作,支持多种输入和输出插件。本指南涵盖安装、配置、监控、安全性和性能优化等关键实践,旨在帮助用户有效部署和管理Logstash,以实现高效的数据处理和分析。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)