企业如何选择GPU云主机租赁平台?5090、H20、L40、A100选型解析

企业选择GPU云主机租赁平台,不仅是选硬件,更是选生态与服务。● H20:专为中国市场设计的合规AI加速卡,FP16算力约148 TFLOPS,显存96GB,适合大模型推理与中等规模训练,是当前国产化替代的主流选择。● A100/H100:80GB/94GB HBM显存,支持NVLink多卡互联,是千亿参数大模型训练的“黄金标准”,适用于头部科技企业与科研机构。● L40:48GB显存+全能架构,

在AI大模型、智能驾驶、工业仿真等技术驱动下,企业对高性能算力的需求呈指数级增长。然而,自建GPU集群面临采购周期长、运维复杂、资源闲置率高等痛点。此时,GPU云主机租赁平台成为企业实现“弹性算力+敏捷创新”的关键基础设施。

一、主流GPU型号企业适用场景对比

● RTX 5090:作为新一代消费级旗舰,预计配备32GB GDDR7显存,适合轻量级模型微调、AIGC内容生成。但受限于NVIDIA商业授权,多数GPU云主机租赁平台暂未大规模部署。

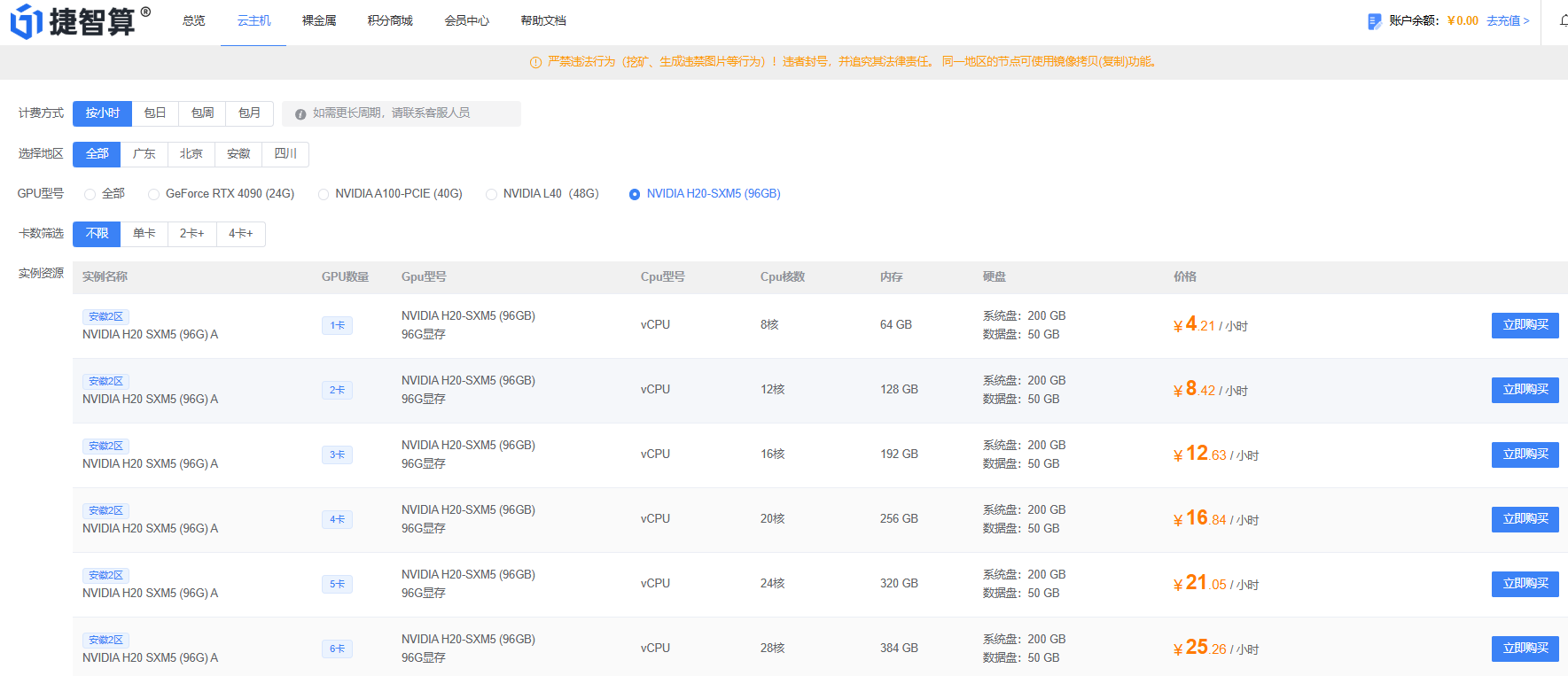

● H20:专为中国市场设计的合规AI加速卡,FP16算力约148 TFLOPS,显存96GB,适合大模型推理与中等规模训练,是当前国产化替代的主流选择。

● L40:48GB显存+全能架构,兼顾图形渲染与AI计算,适用于数字孪生、3D工业设计、视频生成等混合负载场景。

● A100/H100:80GB/94GB HBM显存,支持NVLink多卡互联,是千亿参数大模型训练的“黄金标准”,适用于头部科技企业与科研机构。

二、企业选型核心考量维度

● 任务类型:训练需高带宽显存(A100/H100),推理可选H20/L40。

● 合规要求:金融、政务类项目倾向H20等国产合规卡。

● 成本效率:A100单卡日租超¥800,H20约¥400,L40约¥120,需结合ROI评估。

● 扩展性:是否支持8卡并行?网络延迟是否<1ms?

三、平台服务能力决定落地效率

优质GPU云主机租赁平台应提供:

● 多卡NVLink高速互联

● 100Gbps RDMA网络

● 预置大模型训练环境(如DeepSpeed、Megatron-LM)

● 金融级安全合规(等保三级、ISO 27001)

企业选择GPU云主机租赁平台,不仅是选硬件,更是选生态与服务。面对5090尚未普及、H20合规受限、A100成本高昂的现实,L40与H20成为2025年企业级用户的务实之选。而捷智算算力租赁凭借全栈优化能力与灵活部署方案,正助力更多企业跨越算力鸿沟,加速AI落地。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)