模型部署与调用:ComfyUI和dify的模型调用,MoviiGen1.1或者Wan2.2等模型的fastAPI调用 || yum docker问题修复

模型部署与调用:ComfyUI和dify的模型调用,MoviiGen1.1或者Wan2.2等模型的fastAPI调用。

·

模型部署与调用:ComfyUI和dify的模型调用,MoviiGen1.1或者Wan2.2等模型的fastAPI调用

Wan 2.1 视频生成模型本地部署全攻略

部署dify的docker环境,修复CentOS7的yum源

# CentOS 7 已于 2024 年 6 月结束生命周期,部分镜像站已停止维护其资源路径, 163 镜像源的 CentOS 7 基础仓库路径已失效

# 删除备份原有配置

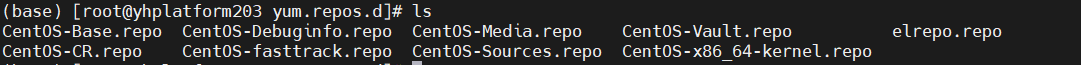

cd /etc/yum.repos.d/

rm -r *

# 下载新镜像源文件

sudo curl -o /etc/yum.repos.d/CentOS-Base.repo https://mirrors.aliyun.com/repo/Centos-7.repo

# 修正变量兼容性

sudo sed -i 's/\$releasever/7/g' /etc/yum.repos.d/CentOS-Base.repo

# 彻底清理旧缓存

sudo yum clean all

sudo rm -rf /var/cache/yum # 强制删除残留缓存

# 重建元数据缓存

sudo yum makecache

# 测试新源可用性

sudo yum repolist # 检查仓库列表是否正常加载

sudo yum update # 测试更新命令

安装docker-compose

# 下载二进制文件

# 使用阿里云镜像(国内加速)

sudo curl -L "https://mirrors.aliyun.com/docker-toolbox/linux/compose/v2.27.1/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

# 或官方 GitHub 源(需网络通畅)

sudo curl -L "https://github.com/docker/compose/releases/latest/download/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

# 设置权限与路径

# 赋予可执行权限

sudo chmod +x /usr/local/bin/docker-compose

# 创建软链接至标准路径

sudo ln -s /usr/local/bin/docker-compose /usr/bin/docker-compose

# 验证安装

docker-compose --version

# 成功输出:Docker Compose version v2.27.1

部署:https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/docker-compose

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

docker-compose up -d

http://your_server_ip

#手工拉取镜像

docker pull langgenius/dify-api:latest

docker pull langgenius/dify-web:latest

docker pull postgres:15-alpine

docker pull redis:6-alpine

docker pull langgenius/dify-sandbox:0.2.10

docker pull langgenius/dify-plugin-daemon:0.0.1-local

docker pull ubuntu/squid:latest

docker pull certbot/certbot

docker pull nginx:latest

docker pull semitechnologies/weaviate:1.19.0

docker pull langgenius/qdrant:v1.7.3

docker pull pgvector/pgvector:pg16

docker pull tensorchord/pgvecto-rs:pg16-v0.3.0

docker pull ghcr.io/chroma-core/chroma:0.5.20

docker pull quay.io/oceanbase/oceanbase-ce:4.3.3.0-100000142024101215

docker pull container-registry.oracle.com/database/free:latest

docker pull quay.io/coreos/etcd:v3.5.5

docker pull minio/minio:RELEASE.2023-03-20T20-16-18Z

docker pull milvusdb/milvus:v2.5.0-beta

docker pull opensearchproject/opensearch:latest

docker pull opensearchproject/opensearch-dashboards:latest

docker pull myscale/myscaledb:1.6.4

docker pull docker.elastic.co/elasticsearch/elasticsearch:8.14.3

docker pull docker.elastic.co/kibana/kibana:8.14.3

docker pull registry.cn-hangzhou.aliyuncs.com/kenwood-ai/unstructured-api:latest

docker tag registry.cn-hangzhou.aliyuncs.com/kenwood-ai/unstructured-api:latest downloads.unstructured.io/unstructured-io/unstructured-api:latest

docker tag langgenius/dify-api:latest langgenius/dify-api:1.0.0

docker tag langgenius/dify-web:latest langgenius/dify-web:1.0.0

dify部署到6001端口号

在 .env文件中修改以下变量

# Docker 容器内部 Nginx 监听端口(默认 80)

NGINX_PORT=6001

# 宿主机对外暴露的 HTTP 端口(必须与 NGINX_PORT 一致)

EXPOSE_NGINX_PORT=6001

# 如需 HTTPS,同步修改 SSL 端口(可选)

NGINX_SSL_PORT=6443

EXPOSE_NGINX_SSL_PORT=6443

# 在 .env中补充以下配置,确保 API 服务识别新端口

# 服务 API 基础 URL(替换 IP 为服务器实际地址)

SERVICE_API_URL=http://<服务器IP>:6001

APP_API_URL=http://<服务器IP>:6001

APP_WEB_URL=http://<服务器IP>:6001

重启服务生效

docker compose down

docker compose up -d

/etc/docker/daemon.json

{

"registry-mirrors": [

"https://docker-0.unsee.tech",

"https://docker-cf.registry.cyou",

"https://docker.1panel.live",

"https://mirror.azure.cn",

"https://docker.hpcloud.cloud",

"https://docker.m.daocloud.io",

"https://docker.mirrors.ustc.edu.cn"

],

"runtimes": {

"nvidia": {

"args": [],

"path": "nvidia-container-runtime"

}

},

"data-root": "/var/docker_new/"

}

自定义dify docker的端口号

打开.env文件

NGINX_PORT=6210

NGINX_SSL_PORT=6243

# 宿主机暴露端口

EXPOSE_NGINX_PORT=6210

EXPOSE_NGINX_SSL_PORT=6243

# 启用了HTTPS,可能还需要修改NGINX_SSL_PORT和EXPOSE_NGINX_SSL_PORT

# 应用发布页面的API基础URL

SERVICE_API_URL=http://172.31.187.203:6210

APP_API_URL=http://172.31.187.203:6210

APP_WEB_URL=http://172.31.187.203:6210

重启服务

docker compose down # 停止并移除旧容器

docker compose up -d # 重新构建并启动

零基础上手大模型(三)——dify配置本地Ollama模型

.env添加的内容

# 启用自定义模型

CUSTOM_MODEL_ENABLED=true

# 指定 Ollama 的 API 地址(根据部署环境调整 IP)

OLLAMA_API_BASE_URL=http://192.168.5.7:11434

需要重启服务

docker compose down # 停止服务

docker compose up -d # 重新启动

dify的web页面上:

点击右上角头像,选择"设置"->模型供应商->安装模型供应商里面安装ollama插件,添加ollama模型,并保存

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)