详细介绍ollama和open-webui的使用(带你一步步动手做)

本文介绍了大模型的本地部署、微调、提示词工程及扩展应用。首先讲解Ollama工具的本地安装与运行,支持通过命令快速部署开源大模型,并介绍相关管理命令及模型参数单位“B”(十亿)的含义。其次阐述大模型微调的显存需求,涉及全量微调、高效微调(PEFT:Lora)及QLora(参数降精度方法)。随后说明提示词工程的核心作用,即通过优化提示词提升AI生成效果。接着引入RAG(检索增强生成)技术,通过外部知

一.大模型介绍

1.大模型的本地安装

Ollama是一个开源的大型语言模型服务工具,它帮助用户快速在本地运行大模型。通过简单的安装指令,用户可以执行一条命令就在本地运行开源大型语言模型。

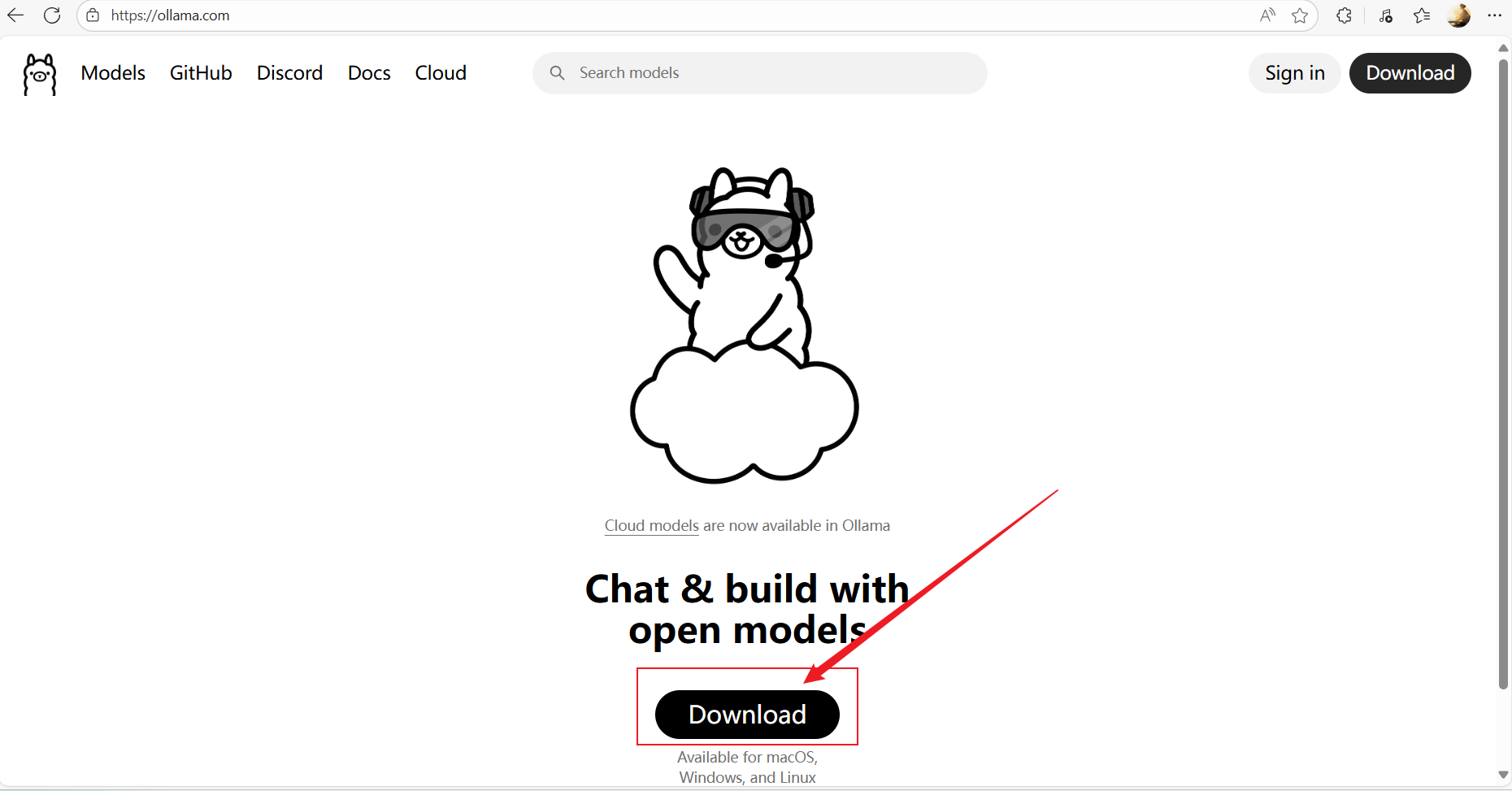

①安装ollama

ollama官网:https://ollama.com/

安装完成打开文件之后一直点击下一步即可。

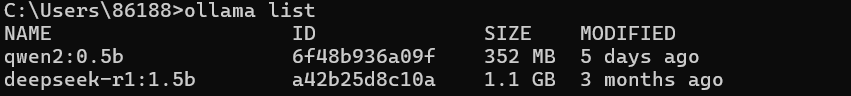

②运行ollama

ollama list:显示已经存在的大模型。

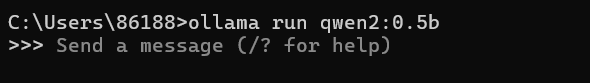

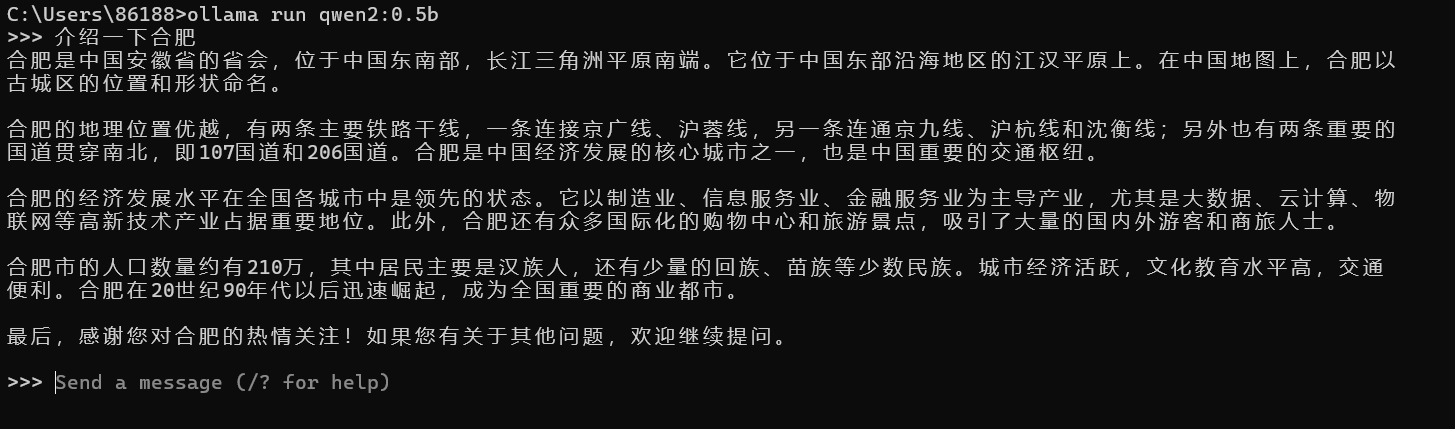

使用 ollama run 模型名称:大小 :下载模型(如果模型不存在)并运行。

输入问题后,大模型即可本地回答问题。

③ollama的一些命令

ollama serve # 启动

ollama create # 从模型文件创建模型

ollama show # 显示模型信息

ollama run # 运行模型,会先自动下载模型

ollama pull # 从注册仓库中拉取模型

ollama push # 将模型推送到注册仓库

ollama list # 列出已下载模型

ollama ps # 列出正在运行的模型

ollama cp # 复制模型

ollama rm # 删除模型

ollama serve # 启动

ollama create # 从模型文件创建模型

ollama show # 显示模型信息

ollama run # 运行模型,会先自动下载模型

ollama pull # 从注册仓库中拉取模型

ollama push # 将模型推送到注册仓库

ollama list # 列出已下载模型

ollama ps # 列出正在运行的模型

ollama cp # 复制模型

ollama rm # 删除模型2.在ollama中查看大模型

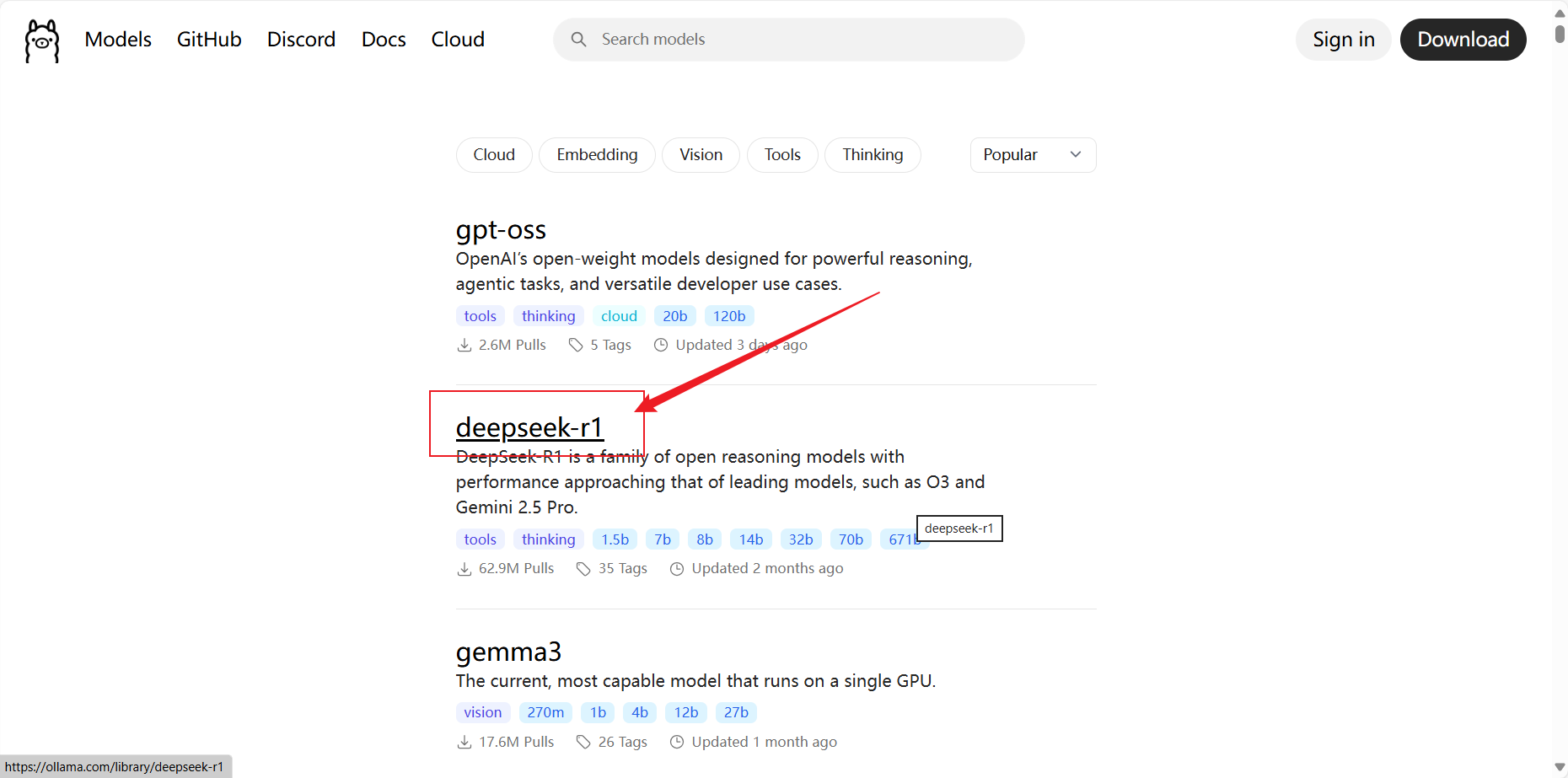

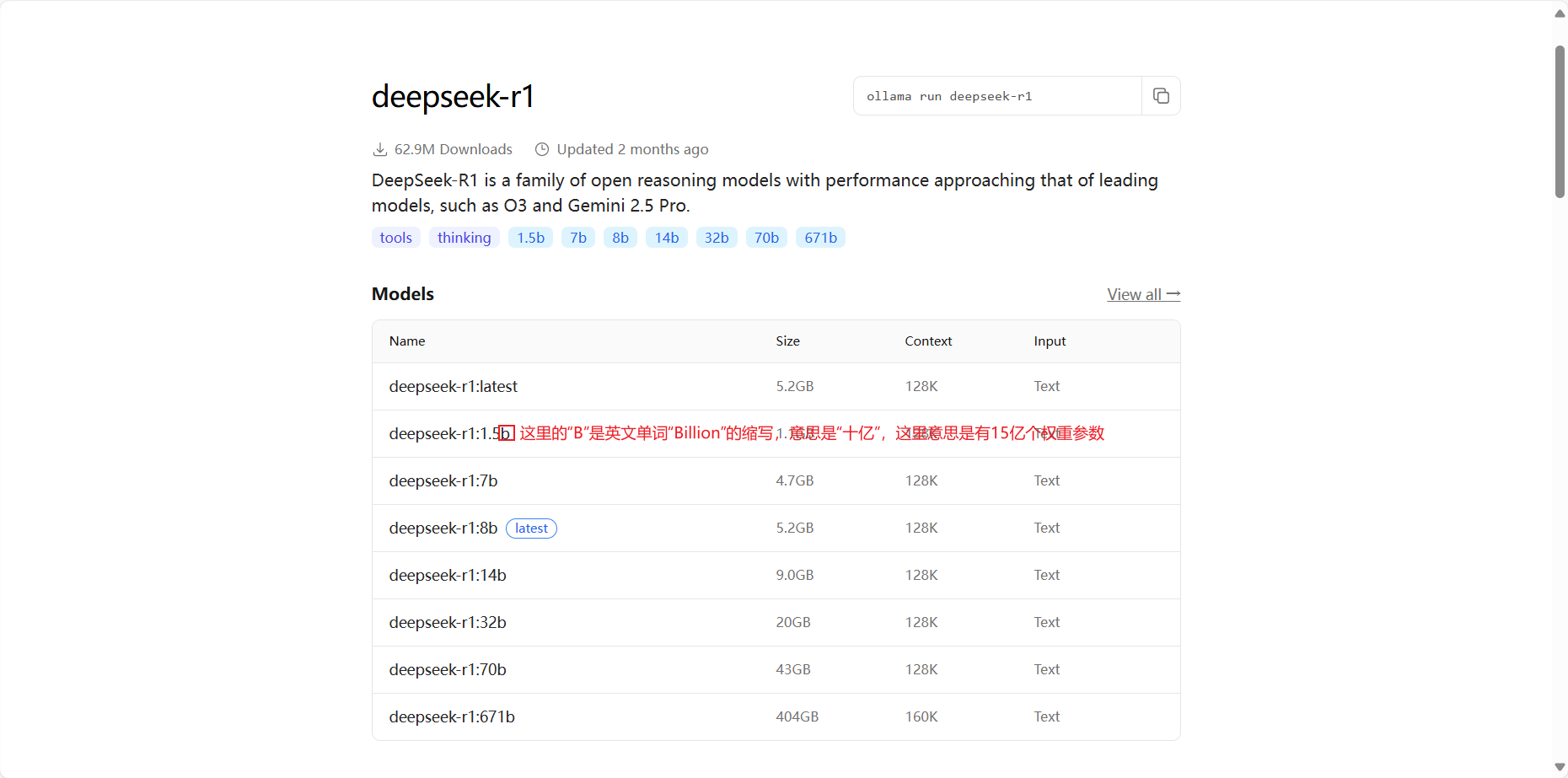

点击想要查看的大模型。

b单位的意思

在大模型(尤其是大型语言模型,LLMs)中,参数数量通常以“B”为单位进行表示,这里的“B”是英文单词“Billion”的缩写,意思是“十亿”。因此,当提到大模型中的“8B”时,它指的是模型具有80亿个参数。

具体来说,这些参数可以理解为模型内部的可训练“神经元的权重”,它们在模型训练过程中被不断调整和优化,以使得模型能够执行特定的任务,如理解和生成人类语言。这些参数的数量决定了模型的复杂度和能力,一般来说,参数数量越多,模型的表达能力和泛化能力通常越强,但同时也需要更多的计算资源和时间来进行训练和推理。

二.大模型微调

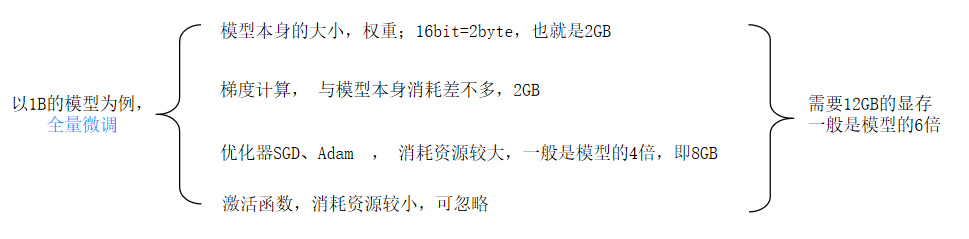

1.微调一个模型需要多少GPU显存?

①全量微调

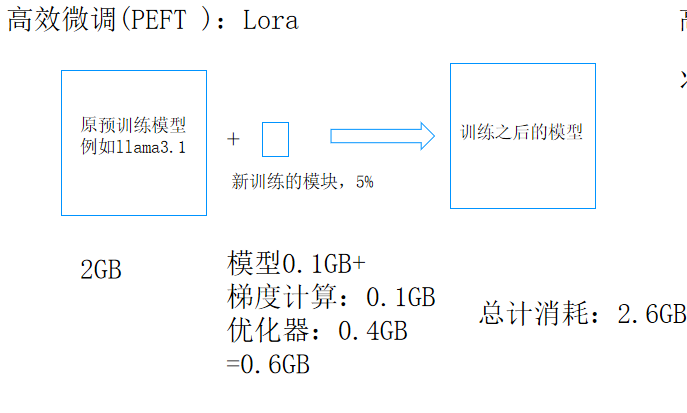

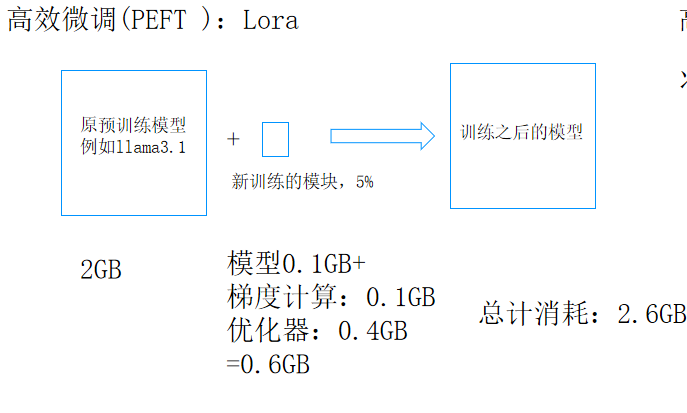

②高效微调(PEFT):Lora

③QLora

将一个权重参数数据的16bit转换为8bit来表示,消耗变小了但是准确率明显不高。

三.大模型提示词工程

1.提示词(prompt)

是一种指令、问题或语句,用于引导或指示AI语言模型生成特定的文本输出。它是用户与语言模型交互的起始点,告诉模型用户的意图,并期望模型以有意义且相关的方式回应。

2.提示词工程(Prompt Engineering)

则是指对提示词进行精心设计和优化的过程,以达到更好的AI生成效果。这包括了解如何准确地表达需求,使AI能够理解并提供相关的回答。

四.大模型扩展介绍RAG

1.什么是RAG(Retrieval-Augmented Generation)(检索增强生成)

Retrieval-Augmented Generation(检索增强生成)为大模型提供外部知识源的概念达到知识更新的效果,这使它们能够生成准确且符合上下文的答案,同时能够减少模型幻觉。

五.大模型部署实战 Open WebUI

1.什么是open webui

Open WebUI是一个可扩展、功能丰富、用户友好的自托管WebUI,专为大型语言模型(LLM)设计,旨在完全离线操作。它提供了直观且响应式的用户界面,使用户能够方便地加载、配置、运行和监控各种AI模型,而无需编写代码或使用命令行界面。

2.open webui的主要功能

-

支持多种LLM:Open WebUI支持多种大型语言模型运行器,包括Ollama和OpenAI兼容的API。

-

多模型对话:用户可以轻松地与多个模型同时互动,利用它们的独特优势获得最佳响应。

-

协作聊天:支持多用户协作聊天,利用多个模型的集体智能进行群聊。

-

再生历史访问记录:允许用户轻松回顾和探索整个再生历史记录。

-

导入/导出聊天历史:支持无缝地移入和移出聊天数据。

-

语音输入支持:提供语音输入功能,用户可以通过语音与模型互动。

-

高级参数微调:允许用户通过调整参数(如温度)并定义系统提示,以定制对话到特定偏好和需求。

-

图像生成集成:无缝集成图像生成功能,如AUTOMATIC1111 API和DALL-E,用动态视觉内容丰富聊天体验。

-

OpenAI API集成:无缝集成和定制各种兼容OpenAI的API,增强聊天互动的多功能性。

-

外部Ollama服务器连接:支持配置环境变量以连接到托管在不同地址的外部Ollama服务器。

-

多个Ollama实例负载均衡:支持将聊天请求分布在多个Ollama实例上,以提高性能和可靠性。

-

多用户管理:提供直观的管理面板以监督和管理用户。

-

基于角色的访问控制(RBAC):通过限制权限确保安全访问,只有授权的个人才能访问Ollama,管理员保留专属的模型创建/拉取权限。

3.部署与安装

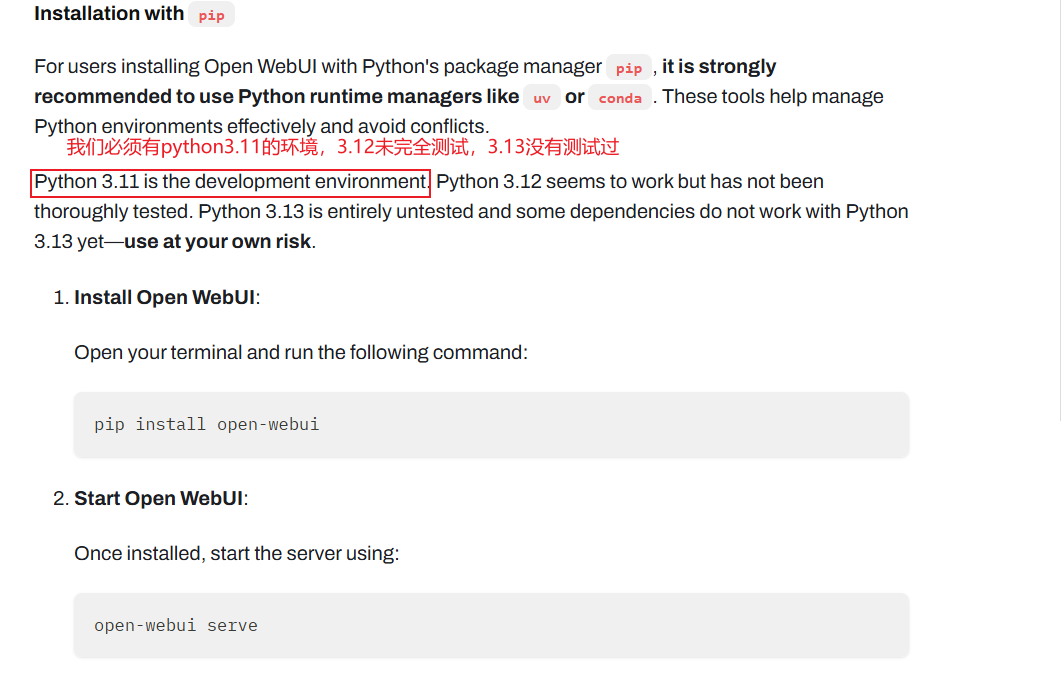

https://docs.openwebui.com/可以打开open webui官网查看,这里我们不用docker用pip来安装。

①安装

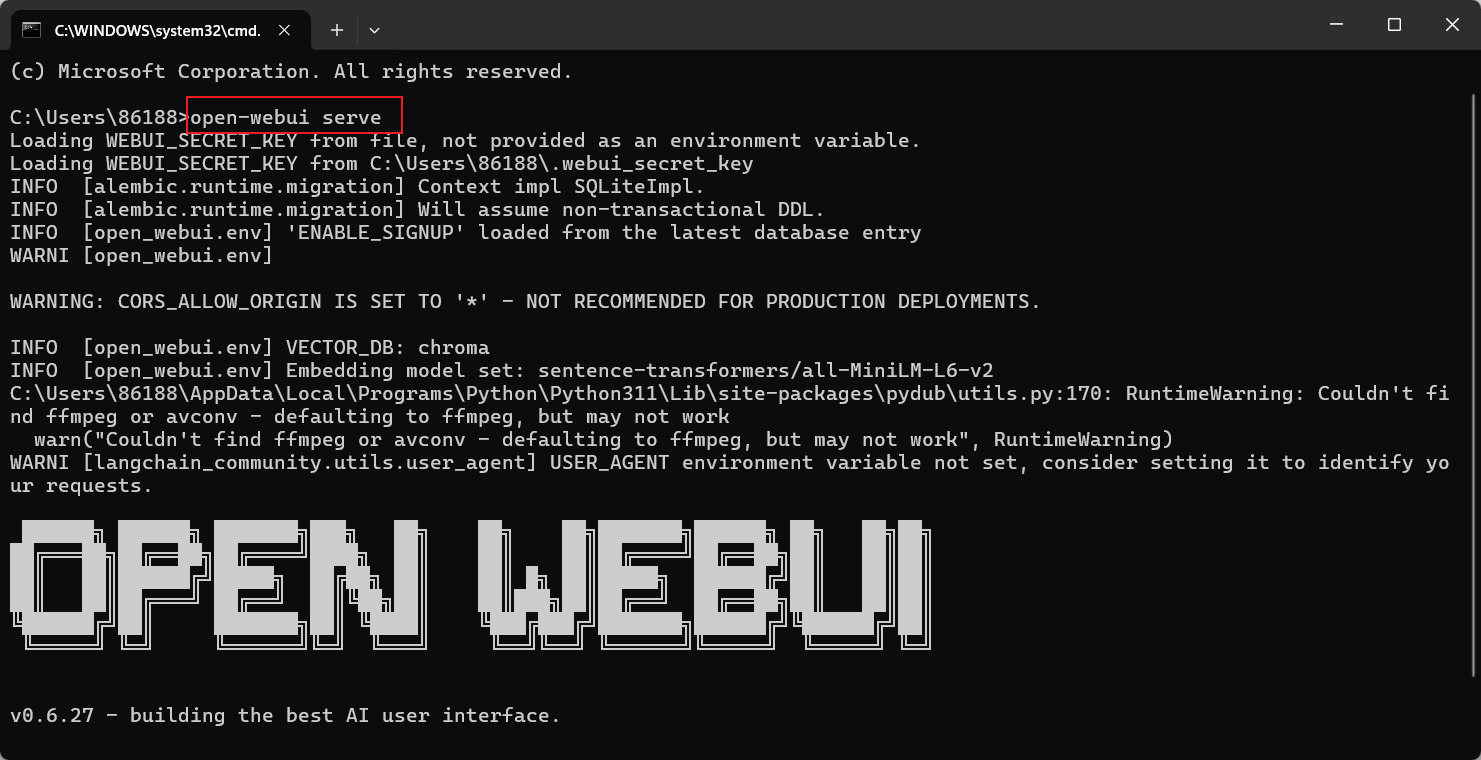

pip install open-webui②打开

open-webui serve

注意,第一次进入会要求注册用户,第一个注册的即为管理员身份。

出现类似画面则打开成功,然后我们使用自己的浏览器打开localhost:8080来打开用户界面。

4.使用

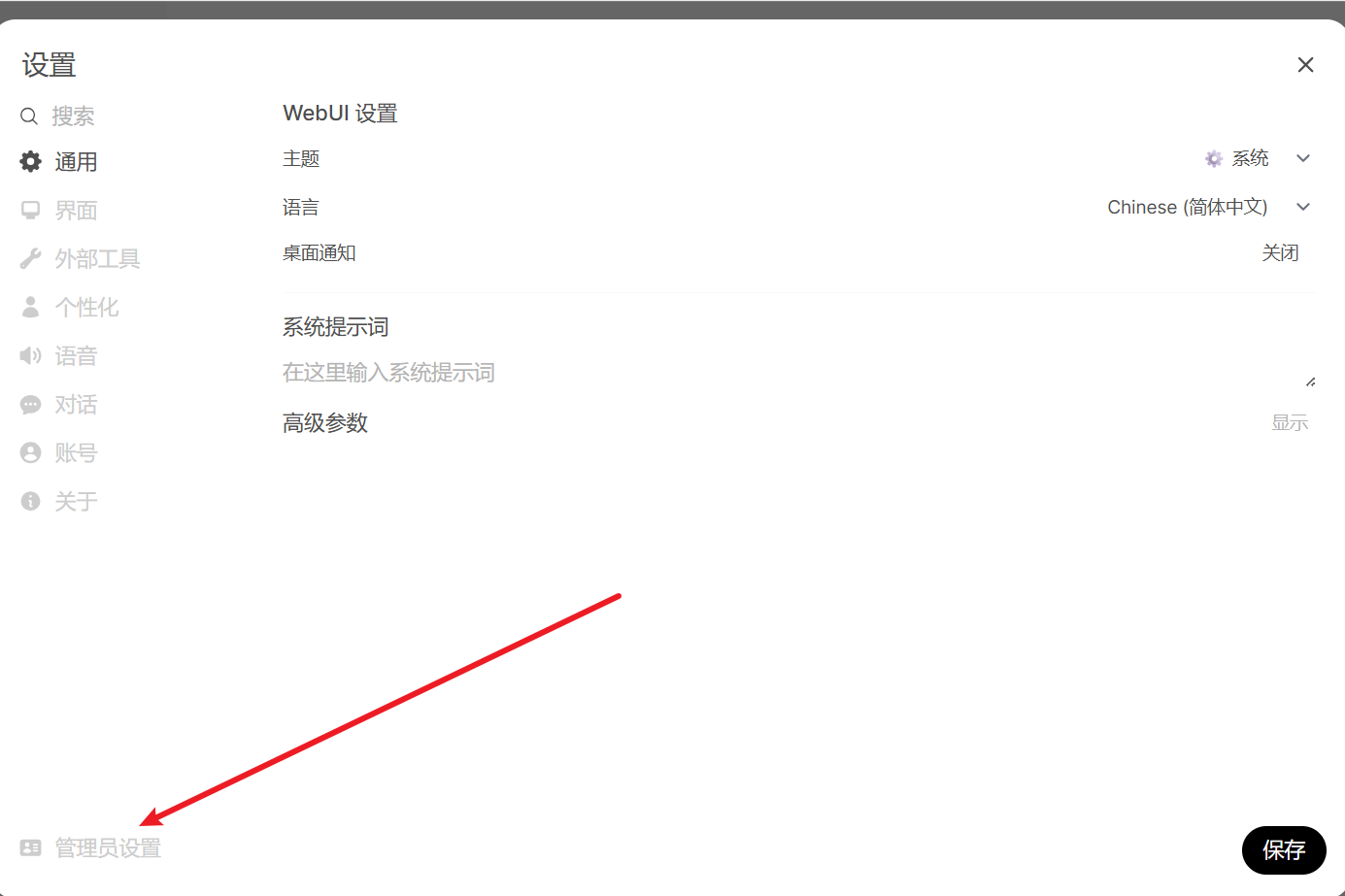

使用系统提示词,设为中文回答,实现提示词工程。

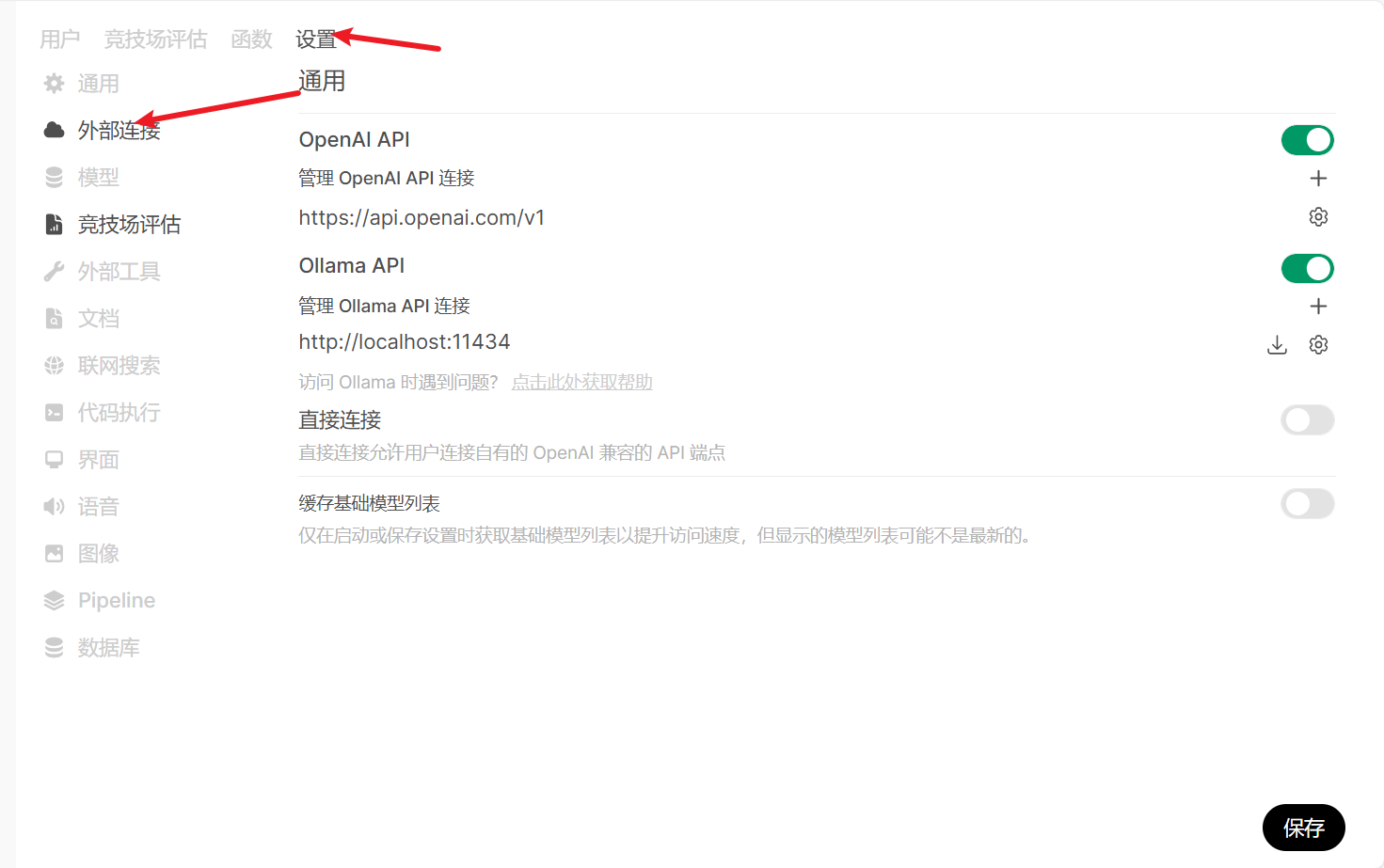

可以通过API密钥访问chatgpt等其他的在线大模型。

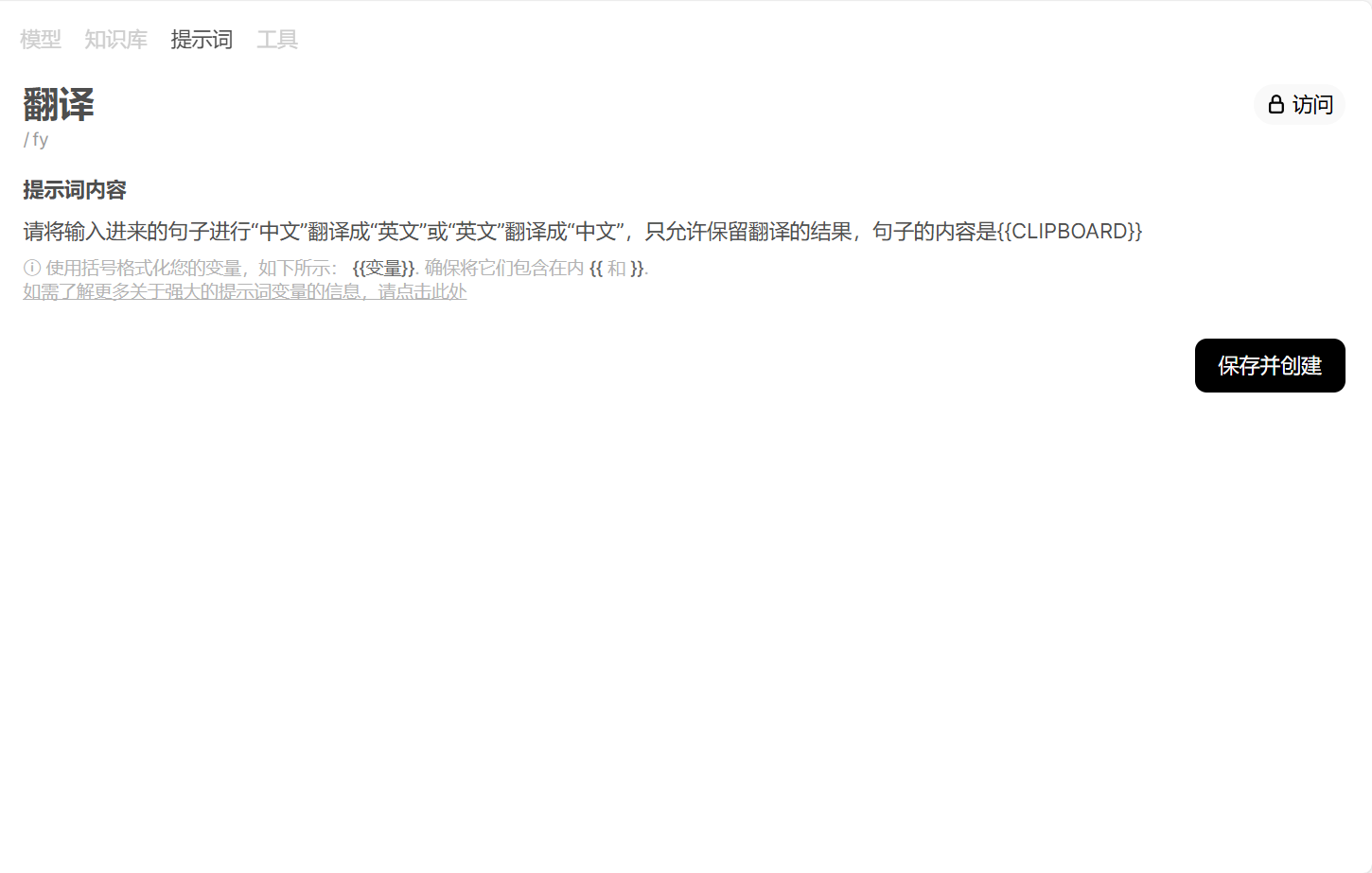

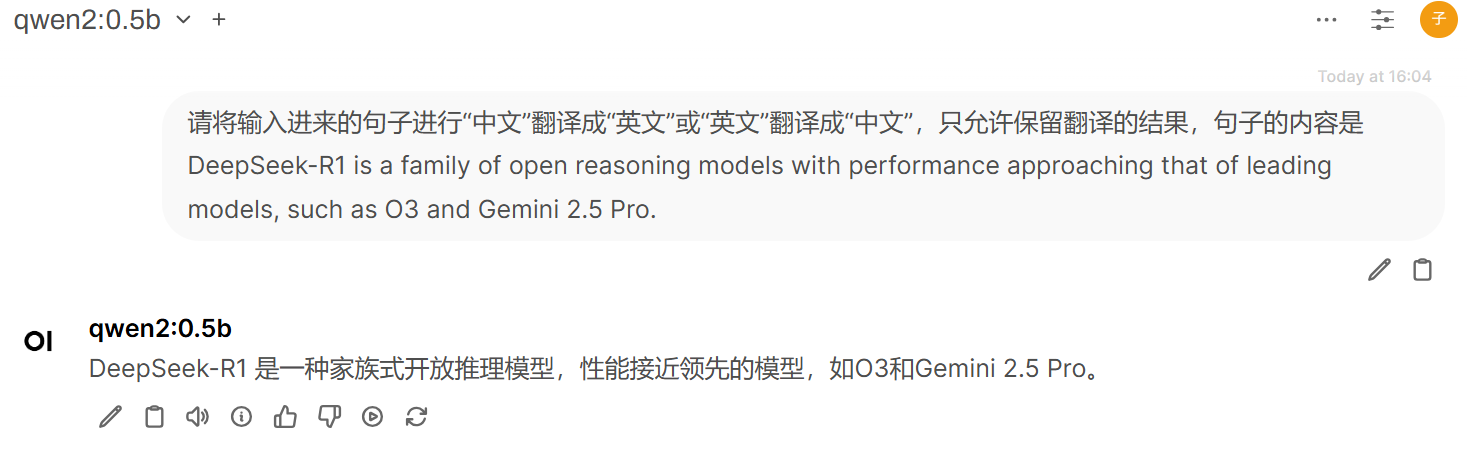

设置提示词

可以自己输入提示词内容,我这里是获取剪切板内容并翻译。

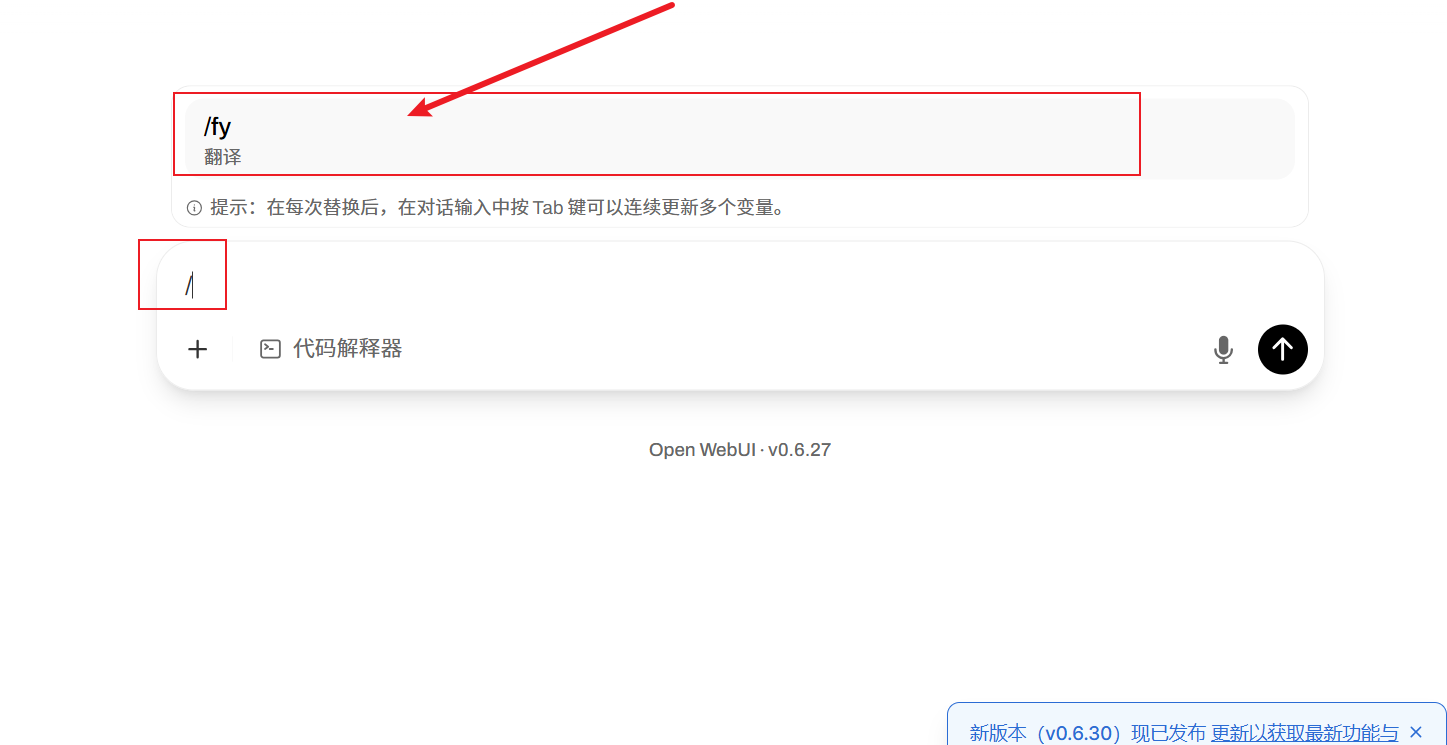

只需输入一个 /就可以调用了。

下面就是直接将我才复制的内容翻译成中文。

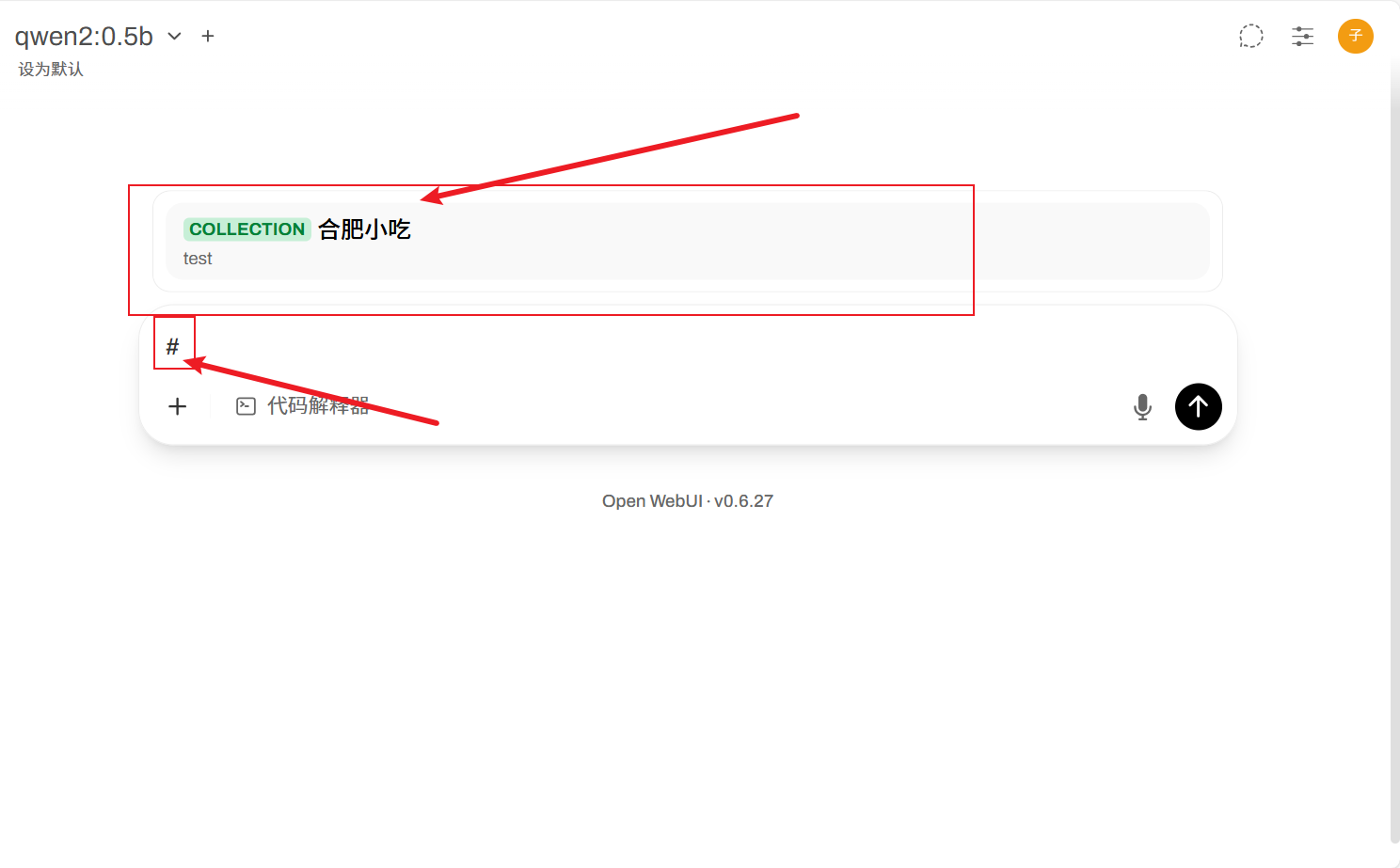

通过#获取指定文档

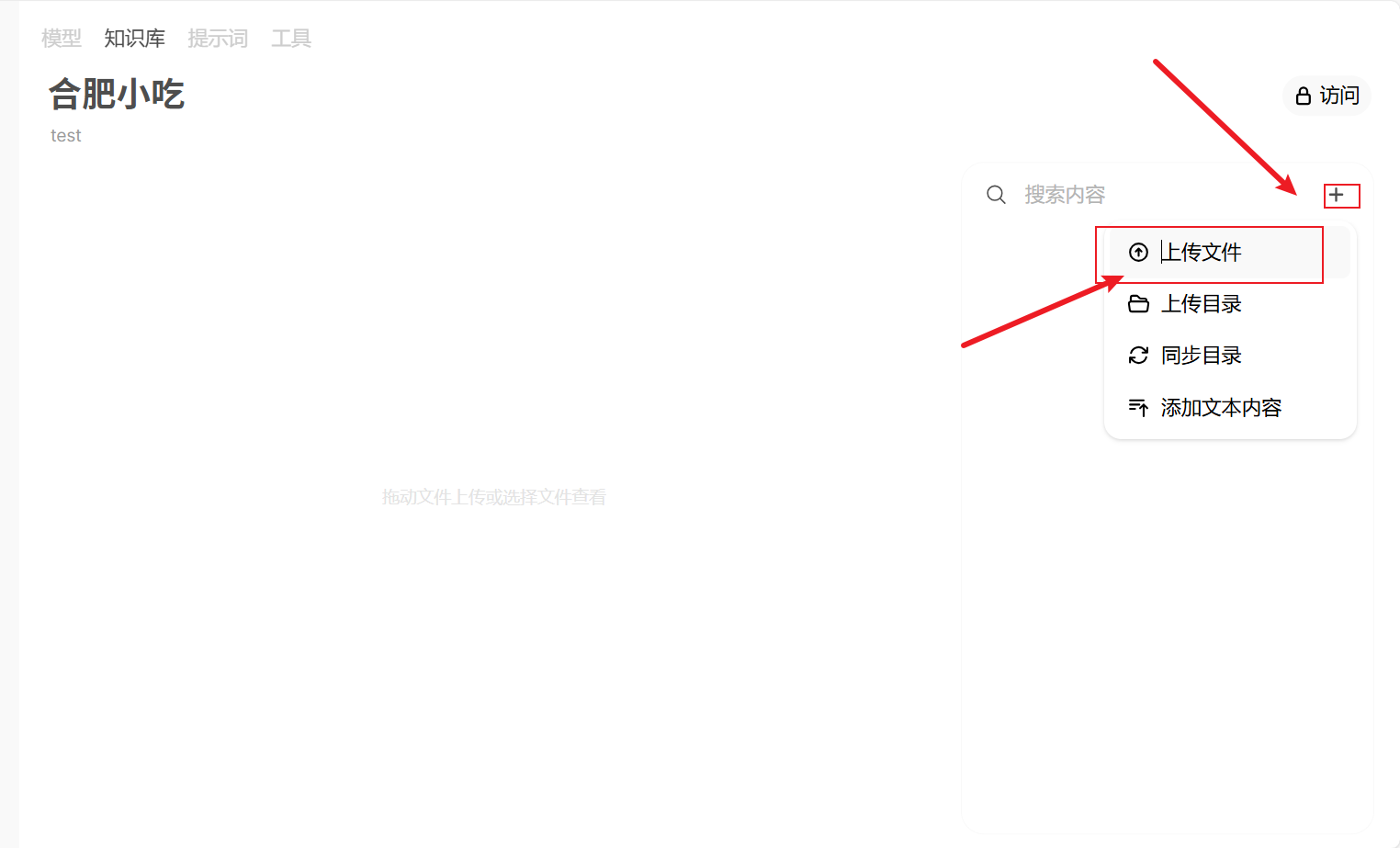

先创建知识库。

填入一些信息后点击创建知识。

点击加号上传文件即可。

输入 #号即可将此次问答关联该知识库。

5.开发

更多开发内容可以查询官网。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)