Transformer 模型详解:什么是 Transformer 模型框架?为什么 Transformer 会成功?与其他同类型的框架区别有哪些?

Transformer模型核心解析 Transformer是基于自注意力机制的序列建模框架,通过并行计算和全局依赖建模能力,在NLP和多模态领域占据主导地位。其成功源于三大优势:1)并行化训练;2)强大的长程依赖捕获能力;3)稳定的规模扩展性(Scaling Laws)。关键技术包括:RoPE/ALiBi位置编码、FlashAttention加速、MQA/GQA解码优化、RLHF对齐等。相比RNN

Transformer 模型详解:什么是 Transformer 模型框架?为什么 Transformer 会成功?与其他同类型的框架区别有哪些?

一文吃透 Transformer:从数理直觉、工程实现到训练/部署实战,对比 RNN/CNN/SSM 与稀疏/线性注意力家族,覆盖位置编码、长上下文、推理加速、对齐与微调的全链路最佳实践。

摘要

Transformer 是以==自注意力(Self-Attention)为核心、摒弃循环与卷积的通用序列建模框架。自 2017 年提出以来,它在机器翻译、理解式预训练(BERT 系列)、生成式预训练(GPT 系列)与多模态方向全面胜出,并通过扩展规模(Scaling Laws)与工程优化(FlashAttention、PagedAttention、MQA/GQA 等)==持续提升。在工程侧,它已形成从数据、预训练、对齐、推理到部署的完备产业化栈。本文将从原理(注意力与表示学习)、能力来源(并行、表达力、可扩展性)、关键技术(位置编码、长上下文、MoE、推理加速、RAG、对齐与微调)与与同类框架对比(RNN/LSTM、CNN、SSM/状态空间模型、稀疏/线性注意力变体)四条主线,系统拆解 Transformer 何以成功与如何落地。核心参考包括原始论文与后续里程碑(文内给出关键出处)。(arXiv)

文章目录

- Transformer 模型详解:什么是 Transformer 模型框架?为什么 Transformer 会成功?与其他同类型的框架区别有哪些?

一、Transformer 是什么:框架与基本组件

1.1 设计初衷与核心结构

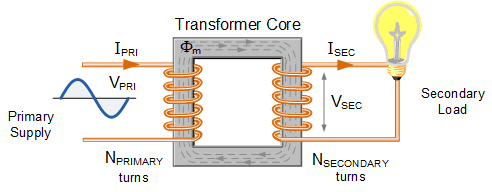

Transformer 由编码器-解码器堆叠的多头自注意力与前馈网络组成,取消了 RNN 的递归与 CNN 的局部卷积假设,依赖注意力在全局范围内建模依赖关系,从而天然可并行训练且长程依赖捕获能力强。原始工作 Attention Is All You Need 首次系统化定义了缩放点积注意力、多头注意力(MHA)、残差 + LayerNorm、位置编码、Noam 学习率日程等实现细节,奠定了今日大模型实现范式。(arXiv, NeurIPS Papers)

直觉:注意力就是“加权信息路由器”。Query(当前需求)去检索 Key/Value(上下文证据),点积得到相关性权重,再把 Value 按权重混合,形成“当前该看什么”的上下文表示。

1.2 自注意力计算(张量维度与复杂度)

- 输入张量形状:

[batch, seq_len, d_model] - 线性映射得到 Q/K/V:

Q = XW_Q, K = XW_K, V = XW_V - 单头注意力:

Attn(Q,K,V) = softmax(QK^T / sqrt(d_k)) V - 多头:将

d_model划分为h个子空间并行计算,再 concat +W_o投影 - 复杂度:标准注意力为

O(L^2·d)(L 为序列长度),是长上下文场景的瓶颈(后文详述 FlashAttention、稀疏/线性注意力、PagedAttention 等优化)。

1.3 编码器 vs 解码器

- 编码器:自注意力 + 前馈,常用于理解式任务(如 BERT)

- 解码器:带 因果掩码 的自注意力 + 交叉注意力(对编码器输出),或仅解码器自回归(如 GPT)

BERT 与 GPT 的成功使 “预训练 + 下游适配” 成为主流范式。(arXiv)

二、Transformer 为什么会成功:能力与扩展性

2.1 三大能力源泉

- 并行化:抛弃递归后,序列位置可并行计算,大幅提升吞吐;

- 表达力:全局注意力无感受野限制,长程依赖建模更直接;

- 可扩展性:在参数、数据、计算上呈现稳定的缩放规律(Scaling Laws),模型越大、数据越多、算力越足,困惑度/损失近似幂律下降,形成“规模红利”。(arXiv)

2.2 规模化与“计算最优训练”

DeepMind 的 Chinchilla 研究指出:在给定计算预算下,参数与训练 token 应按近 1:1 等比扩展,而不是只增参数不增数据,才能得到计算最优的泛化性能(Chinchilla 优于更大的 Gopher/MT-NLG 等)。这一点对当下“更小但训练更久/更多数据”的路线影响深远。(arXiv, NeurIPS 会议录)

三、关键技术模块与工程要点

3.1 位置编码(Positional Encoding/Embedding)

- 正弦位置编码(绝对):原始论文提出,简单可泛化;

- 相对位置(Shaw et al. 2018):通过建模相对距离改善长依赖;

- RoPE/旋转位置(RoFormer):将位置信息编码为复平面旋转,天然携带相对位移性质、利于长上下文与插值外推;

- ALiBi:不显式加嵌入,而是对注意力分数施加与距离成比例的线性偏置,显著提升“Train short, Test long”的外推能力。

实务中,RoPE 与 ALiBi 是长上下文 LLM 的主流选择。(arXiv)

3.2 长上下文与高效注意力

- Transformer-XL:引入段级递归与相对位置信息,可跨段复用缓存,推理更快、依赖更长;

- Longformer/BigBird:以窗口/稀疏/随机全局 token 设计将复杂度降至近线性;

- Reformer/Performer/Linformer:用 LSH 或核特征近似降低复杂度;

- FlashAttention/2:精确注意力的 I/O 感知实现,通过分块-tiling 与核融合,极大减少 HBM 访存、提升速度与可训练序列长度;

- vLLM PagedAttention:面向服务推理,以分页式 KV 缓存管理实现近零碎片的连续批处理与缓存复用。

工程上通常“训练用 FlashAttention + RoPE/ALiBi,推理用 MQA/GQA + PagedAttention + 连续批处理”。(arXiv)

3.3 解码与 KV-Cache 提效:MQA/GQA、KV 复用与量化

- MQA(Multi-Query Attention):多个 Query 共享单一 K/V 头,大幅降低解码时 KV 读带宽;

- GQA(Grouped-Query Attention):在 MHA 与 MQA 之间折中(每组共享 K/V),在接近 MQA 的速度下提供更高质量;

- vLLM PagedAttention:按页管理 KV,配合连续批处理与请求抢占,推理吞吐显著提升。

这些技术共同指向一个目标:把解码阶段的“内存带宽瓶颈”打碎。(arXiv)

3.4 训练技巧与对齐(Alignment)

- 预训练目标:自回归 LM、或掩码 LM(BERT);

- 优化与正则:AdamW、学习率 warmup/余弦退火、梯度裁剪、Label Smoothing(分类);

- 对齐方法:指令监督微调 + RLHF(基于人类偏好奖励)或 DPO(直接偏好优化,绕过显式奖励建模);

- 参数高效微调:LoRA(低秩适配)与 QLoRA(4-bit 权重量化 + LoRA 反向传播),显著降低显存与算力门槛。

BERT(双向编码器)与 GPT-3(超大自回归解码器)分别在理解与生成范式中奠定标杆;大模型对齐后(InstructGPT 等)显著提升可用性与安全性。(arXiv)

3.5 解码策略

- 贪心/Beam:确定性强,易“模式化”;

- Top-k/核采样(Top-p):通过截断尾部概率,缓解**文本退化(Degeneration)**与复读;

核采样被实证为更能避免“高似然但乏味”的文本。(arXiv)

四、与同类型框架的系统对比

下面的对比以“训练并行性 / 长依赖 / 数据/算力扩展性 / 推理时延 / 工程生态”五维评估。

| 框架 | 训练并行性 | 长依赖建模 | 扩展性(规模规律) | 推理延迟/吞吐 | 工程生态与代表作 |

|---|---|---|---|---|---|

| RNN/LSTM | 低(时序相关) | 难(梯度消失/爆炸) | 弱 | 低延迟、短序列友好 | 早期 NLP/ASR |

| CNN(1D) | 中(可并行) | 需扩大感受野 | 中 | 低 | 码流/关键词抽取 |

| Transformer(标准) | 高(序列可并行) | 强(全局注意力) | 强(Scaling Laws/Chinchilla) | 自回归时带宽受限 | BERT/GPT/ViT/DETR 等(arXiv) |

| 稀疏/线性注意力(Longformer/BigBird/Performer 等) | 高 | 强(近线性成本) | 强 | 更优的长序列成本 | 长文/检索/代码等长上下文(arXiv) |

| SSM/状态空间模型(如 Mamba 等) | 很高 | 强(递归 + 线性复杂度) | 潜力中 | 极优(流式) | 语音/时间序列/低延迟场景(非本文重点) |

五、从“原理”到“实操”的落地路线图

5.1 最小可用实现(PyTorch 伪代码)

# 仅示意:单层解码器自注意力(因果 Mask)+ 前馈

class TinyDecoderLayer(nn.Module):

def __init__(self, d_model=768, n_heads=12, d_ff=3072):

super().__init__()

self.attn = nn.MultiheadAttention(d_model, n_heads, batch_first=True)

self.ff = nn.Sequential(

nn.Linear(d_model, d_ff), nn.GELU(), nn.Linear(d_ff, d_model)

)

self.ln1 = nn.LayerNorm(d_model); self.ln2 = nn.LayerNorm(d_model)

def forward(self, x, attn_mask): # attn_mask: [L, L] with causal tri mask

h, _ = self.attn(x, x, x, attn_mask=attn_mask)

x = x + h; x = self.ln1(x)

x = self.ln2(x + self.ff(x))

return x

工程实战会用 FlashAttention 内核、混合精度、张量并行/流水并行、激活检查点等替换/增强以上基元。(arXiv)

5.2 训练配方(简表)

| 环节 | 实用做法 |

|---|---|

| 数据 | 多域多语言清洗去重(近似重复检测)、标注/合成平衡 |

| Tokenizer | BPE/SentencePiece,面向代码/多语种定制 |

| 位置 | RoPE 或 ALiBi(长上下文),必要时 Position Interp |

| 优化 | AdamW + Warmup + 余弦/逆平方衰减,梯度裁剪 |

| 正则 | Dropout、Label Smoothing(分类)、混合精度 |

| 对齐 | SFT(指令数据)→ RLHF 或 DPO(偏好对齐) |

| 微调 | LoRA/QLoRA(显存友好),必要时全参少轮数微调 |

| 评测 | 围绕目标任务自建集 + 标准基准(MMLU/GLUE/长文) |

| 部署 | MQA/GQA + KV-Cache + PagedAttention(vLLM) + 连续批处理 + 量化(INT8/4)(arXiv) |

5.3 推理加速“工具箱”

- 内核级:FlashAttention-2、算子融合、CUDA Graph;(arXiv)

- 架构级:MQA/GQA 缩 KV、分组注意力;(arXiv)

- 系统级:PagedAttention(vLLM)KV 页式管理、连续批处理;(arXiv)

- 算法级:推测解码(speculative decoding)、提示压缩、重复惩罚 + 核采样。(arXiv)

六、案例:为什么 BERT/GPT 能成为分水岭?

- BERT(2018) 通过大规模双向掩码预训练 + 任务头微调,刷新 N 项 NLP 榜单;

- GPT-3(2020) 展示“规模 + 纯生成预训练”带来的 In-Context Learning(少样本/零样本) 能力;

- 后续 LLaMA 等开放模型推动了社区复现与产业落地。

这些里程碑共同证明了:统一架构 + 规模化 + 强工程 能在不同任务/模态上取得统治性优势。(arXiv)

七、常见变体/增强:面向更长、更快、更强

- 长上下文:Transformer-XL、Longformer、BigBird(稀疏/递归/全局 token 设计);(arXiv)

- 线性/近似注意力:Performer(FAVOR+)、Reformer(LSH + 可逆层);(arXiv)

- 高效内核:FlashAttention/2 提升精确注意力训练/推理效率;(arXiv)

- 解码提速:MQA/GQA + vLLM(PagedAttention);(arXiv)

- MoE(Mixture-of-Experts):Switch Transformer/GShard 以稀疏激活扩容参数、保留计算常数级增长;(训练/负载均衡/通信更复杂,推理服务需路由/缓存策略)(arXiv)

- 位置外推:RoPE 插值、ALiBi 线性偏置,支持“训练短序列、推理超长”。(arXiv)

八、与 SSM(状态空间模型)等新路线的关系

近两年 SSM(如 Mamba)凭借线性时空复杂度与流式低延迟在语音、时序、长上下文等场景崭露头角。两者并非“此消彼长”,而是任务分工:

- Transformer:通用性强、生态成熟、预训练资产丰富;

- SSM:流式/长时序/超低时延友好;

- 混合架构:将注意力与状态空间结合,以取长补短(研究活跃中)。

(SSM 细节不展开,本文聚焦 Transformer 主线。)

九、从零到一:你该如何选型与落地?

- 任务画像:输入长度、延迟目标、预算(显存/成本)、数据可得性;

- 基座选择:理解/抽取→编码器系(BERT/DeBERTa/长文变体);生成→解码器系(LLaMA/Mistral 等);

- 上下文长度:>8K 考虑 RoPE/ALiBi + FlashAttention + PagedAttention,必要时 Longformer/BigBird;

- 吞吐与成本:MQA/GQA、连续批处理、INT8/4 量化;

- 对齐与安全:SFT + RLHF/DPO;

- 迭代策略:先小规模验证→再扩数据/算力至“计算最优”(Chinchilla 思路);(arXiv)

- 评测与灰度:构建闭环指标(准备度、幻觉率、延迟/吞吐/成本)与上线监控。

十、FAQ:工程与研究中的高频问题

Q1:为什么我的长上下文效果不稳定?

A:检查位置方案(RoPE/ALiBi 配置)、插值策略、KV-Cache 一致性、是否使用 FlashAttention-2 的长序列稳态配置;必要时 Longformer/BigBird。(arXiv)

Q2:推理时延高、吞吐低?

A:优先采用 MQA/GQA + PagedAttention(vLLM),并开启连续批处理;必要时合并小请求、控制最大生成步数。(arXiv)

Q3:小显存如何微调大模型?

A:QLoRA(4-bit 权重 + LoRA 反传)是主流解法,单卡 48GB 可微调 65B 量级模型。(arXiv)

Q4:为什么核采样(Top-p)经常比 Beam 更“像人写的”?

A:核采样截断了“长尾低质 token”,避免高似然但单调的输出,是缓解文本退化的实证方法。(OpenReview)

Q5:只“堆规模”是否还能持续带来收益?

A:缩放规律仍有效,但数据质量、训练时长与对齐同等关键;遵循 Chinchilla 的“计算最优”原则更可持续。(arXiv)

结语:Transformer 的“统一场”与未来

Transformer 成功的本质是:统一的计算基元(注意力) + 可并行的训练范式 + 清晰的缩放规律 + 强大的工程化。随着 FlashAttention、PagedAttention、MQA/GQA 等技术成熟,以及 LoRA/QLoRA、RLHF/DPO 的普及,它已演化为一种平台级方法论。面向未来,长上下文、工具使用、检索增强、跨模态与推理能力仍是演进方向;与此同时,SSM 与稀疏/线性注意力等分支将与 Transformer 长期并存、互补共进。

参考里程碑

- Transformer 原始论文与 Noam 调度。(arXiv)

- BERT / GPT-3。(arXiv)

- 缩放规律 / Chinchilla。(arXiv)

- 位置编码(相对/ALiBi/RoPE)。(arXiv)

- 长上下文(Transformer-XL/Longformer/BigBird)。(arXiv)

- 高效注意力与推理(FlashAttention/2、MQA/GQA、vLLM PagedAttention、核采样)。(arXiv)

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)